瞰白云

2023-07-10 05:34:46

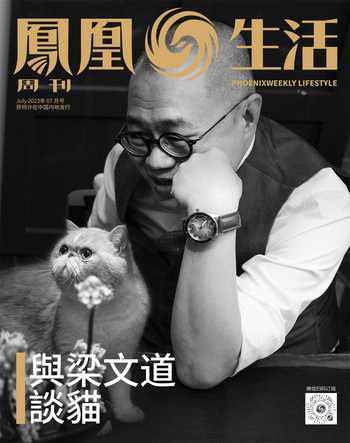

鳳凰生活 2023年7期

PIAGET伯爵品牌代言人王俊凱

透過飛機的窗戶去“瞰”白云,心情也會變幻無窮,當你以為定格住了一朵棉花糖,隨即煙消云散,但下一朵棉花糖又會立馬塞進你的心口,失去與獲得總是接踵而至,你是“瞰”到了失去?還是獲得?

PIAGET伯爵Possession時來運轉系列項鏈

Giorgio Armani 金絲眼鏡

Delvaux ?Brillant L'XXL Dream Leather Buckle Vegetal

BRUNELLO CUCINELLI 亞麻,羊毛與真絲西裝

From Mytheresa

BYREDO Rose of No Man's Land無人之境淡香精