基于全局與滑動窗口結合的Attention機制的非侵入式負荷分解算法

董哲,陳玉梁,薛同來,邵若琦

(北方工業大學,北京 100043)

0 引 言

有專家學者提出非侵入式負荷監測[1-2],目的是將整體能耗分解為單個設備的能耗。由此可以通過幫助家庭了解具體單個設備的能耗情況,從而合理規劃家庭的整體能源使用[3-6],文獻[7]研究表明,分類信息可以幫助家庭減少多達5%~15%的能源消耗。除此以外,非侵入式負荷分解是配電網需求側精細化管理的關鍵技術,同時也是人工智能技術在配電領域的重要應用方向之一。相較于傳統的侵入式負荷分解,利用信號處理或人工智能等方法的非侵入式負荷分解成本更加低廉,也更加安全可靠。

NILM是從一個監測的整體能耗中提取單個能耗信息,這屬于單通道盲源分離(a single-channel blind source separation,BSS)問題。通常人們可以從用電總負荷數據中識別出包含哪種具有豐富特征的用電設備,例如,冰箱的工作狀態(見圖1),但在分解過程中,還存在著一些不確定因素的干擾,包括采集功率數據中的噪聲,或多種相似工作狀態,以及多個設備同時開啟或同時關閉的情況,所以僅憑經驗來對負荷進行分解是很不可靠的。

圖1 冰箱的工作狀態

文獻[8-10]提出了加性階乘隱式馬爾可夫模型(AFHMM)是可以構造NILM模型的自然方法,在此基礎上使用推理算法來預測設備信號,但效果并不理想。為了解決可識別性問題,文獻[11]提出加入數據的本地信息(例如,設備功率水平,開關狀態變化和持續時間),文獻[12]在模型中納入了全局信息(例如循環總數和總能耗)。但是,這些方法所需的標注需要手動提取,這使得這些方法難以應用。因此,使用深度學習在訓練過程中自動提取這些特征信息更為有效。

文獻[13]將深度學習方法應用于NILM,文章中提出了三種深度學習方案,分別是卷積神經網絡(CNN),長短期記憶網絡(LSTM)和堆疊式降噪自動編碼器,并在UK-DALE[14]數據集上驗證了深度學習方法應用在NILM的。文獻[15]在提取單個負荷激活特征時,采用了具有兩層的雙向長短期記憶(LSTM)單元的遞歸神經網絡架構,并在數據集(REDD)上測試了其模型[16]。這些方法學習具有相同時間戳的總負荷功率和單個負荷功率之間的非線性回歸,但是這些方法存在著分解功率滯后,變化速度較慢,沒有對于真實功率保持良好的跟蹤性的問題。

為此,本文采用深度學習框架,提出一種基于全局與滑動窗口結合的Attention機制的負荷分解的方法,利用文獻[17]發布的 REFIT數據集進行模型的訓練與測試,并與文獻[13]提出的基于CNN 和長短時記憶模型 (Long Short Term Memory,LSTM)的模型進行對比,驗證本文所提模型的優越性。

1 非侵入式負荷分解模型

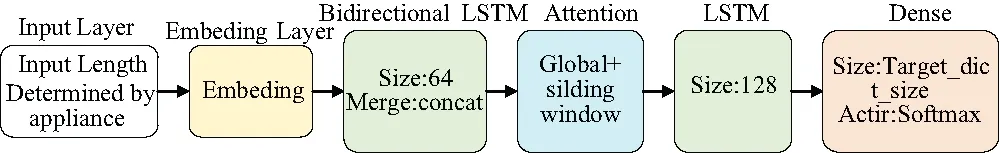

模型由6個部分組成,分別是輸入層、功率嵌入層、雙向LSTM組成的編碼層、Attention層、單向LSTM的解碼層、和輸出層(見圖2)。并加入Dropout等方法以解決可能出現的過擬合問題。

圖2 系統結構框圖

1.1 功率嵌入

低頻數據集采樣的總用電功率數據可能記錄了幾個月甚至幾年的時間,而一整天的采樣點就成千上萬條,模型的輸入長度是有限的且固定,所以對數據進行分段是必不可少的。對于m種用電負荷設定其輸入深度學習模型的長度分別為N1,N2…Nm。

(1)

相較于自然語言處理中的詞嵌入,通過捕捉不同的語言信息或依靠語法語義以及相似度的方法來構造詞嵌入矩陣,本文采用均勻分布的初始化矩陣作為功率嵌入矩陣E=[v_s×e_s],v_s的大小取決于可能出現的總功率最大值,若取值不夠大則可能會導致某些功率值沒有對應映射向量的情況。e_s為單類功率值經由功率嵌入矩陣映射后的序列長度。

(2)

從功率序列到功率矩陣的映射保證了功率與高維向量的對應關系,有利于編碼器抽取功率序列的時序信息,且可以有效降低深度學習模型的運算量以及提高分解功率的準確性。

1.2 基于Attention的Seq2seq模型

序列到序列(sequence to sequence,Seq2seq)是一種編碼-解碼(encoder-decoder)結構的模型,模型結構如圖3所示,其中,Encoder部分是將輸入的序列壓縮成指定長度的向量,稱其為向量C,Decoder部分負責將向量C解碼成輸出序列。

圖3 Seq2seq模型

但隨著輸入序列長度的增加,編碼器難以將所有輸入信息編碼為單一向量,編碼信息缺失,難以完成高質量的解碼。Bahdanau attention是一種加性Attention機制,如圖4所示,將Decoder的隱藏狀態和Encoder所有位置輸出通過線性組合對齊,并計算相關權重得到向量C,進而保證用于解碼的信息的完整性。

(3)

將每一時刻的ai與前一時刻解碼層的隱藏狀態st-1拼接,然后將其輸入到全連接層并采用Softmax激活函數得到對于當前時刻的權重,計算公式如下:

et,i=Softmax(tanh(st-1Wdecoder+XWencoder)Wdense)

(4)

(5)

在解碼過程中,在時間步t時,將語義向量C、前一時刻的隱藏狀態st-1和輸出yt-1作為輸入,計算公式如下:

st=f(C,st-1,yt-1),t=1,2,…,Nm

(6)

再得到從d1到dNm的分解功率概率分布序列:

dt=g(st),t=1,2,…,Nm

(7)

式中g為從隱藏狀態st到dt=[v_s*1]的分解功率概率密度分布的映射函數。由功率嵌入可得,v_s代表可能出現的總功率大值,那么dt即為分解功率在各個整數功率值的概率密度分布,選取其中概率大的功率值作為t時刻分解功率輸出yt。

yt=ArgMax(dt)

(8)

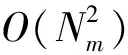

1.3 全局與滑動窗口相結合的Attention機制

Attention的計算方法時間和空間復雜度都是O(n2),這使得難以在長序列上進行訓練。比如洗衣機,洗碗機等電器負荷激活時間一般較長,在訓練模型的時候會有較大的計算量。因此本文采用全局注意力機制結合滑動窗口注意力機制(GSWA,global+sliding window attention)的方法來降低模型的運算量。

1.3.1 滑動窗口注意力機制

局部注意力機制(local attention)是一種介于soft attention和hard attention之間的一種attention方式,可以將注意力定位在關鍵數據附近,進而減少attention機制的運算量。local attention首先會為decoder端當前的詞,預測一個Encoder端對齊位置(aligned position)pt,然后基于pt選擇一個窗口,用于計算向量C。其中位置向量pt預測的準確率直接影響到最終結果。然而在功率預測模型中,輸入和輸出是在相同時間戳下的總負荷功率和單負荷功率,其中位置向量pt就是當前t時刻的位置,故采用滑動窗口注意力機制(SWA,sliding window attention)可以在保證結果準確率的情況下提升attention 機制的運算效率。選擇滑動窗口的范圍(見圖5)。

圖5 滑動窗口的選取

計算公式如下:

(9)

1.3.2 空洞滑動窗口注意力機制

為了進一步增加提取特征的范圍而不增加計算量,可以將滑動窗口“擴大”。本文在滑動窗口上加入空洞以此來增加提取功率變化特征的范圍,即空洞滑動窗口注意力機制(DSWA,dilated sliding window attention),類似于空洞卷積神經網絡(dilated/atrous convolution)[18-20],是在標準的卷積層(convolution map)里注入空洞,以此來增加感受野(reception field)。相比原來的正常卷積層,dilated convolution 多了一個超參數,稱之為空洞率,指的是卷積核之間的間隔數量。本文在滑動窗口上加入擴張大小為d=1的間隙,窗口范圍選擇計算公式如下:

(10)

式中在范圍內每個點相隔d個點,則每一層注意力區域約為d×w,即使d的值很小,也可以讓提取信息的區域成倍增加。

1.3.3 全局與滑動窗口結合的注意力機制

DSWA相較于SWA雖然擴大了信息提取的區域,但不夠靈活,空洞的加入也可能會漏掉功率變化的特征信息。因此,本文提出全局注意力機制與滑動窗口注意力機制相結合的方法,對功率輸入序列進行處理,在功率值變化較大的地方加上標簽,標簽處采用全局注意力機制(global Attention)用于更好的關注功率序列的整體信息。其中標簽的數量與電器的工作狀態有關,而與輸入序列的長度無關,故全局和滑動窗口組合的注意力機制在計算復雜度上仍為O(Nm)。

2 損失函數

由于本文模型將分解功率的值回歸問題轉換為了求取功率分解值在各個離散整數功率值下概率的多分類問題,故采用多分類交叉熵作為模型的損失函數,其定義如下:

(11)

式中Nm是單個用電負荷序列長度;v_s代表總負荷功率可能出現的類數;yt,i為t時刻真實功率為j的概率,該概率僅在j與t時刻真實功率相等時為 1,其余時刻為 0;ft,i(x) 為t時刻模型輸出分解功率為j的概率。

3 實驗結果與分析

3.1 數據集的選取

本文選取了文獻[17]于2015 年發布的REFIT (Cleaned)數據集進行模型的訓練與測試,其中包含20戶家庭的單個負荷有功功率及家庭總負荷有功功率信息,有功功率的采樣間隔為8 s。數據集的采集時間跨度從2013年持續到2015年,并對其中的數據進行了清洗:對于重復的時間戳進行合并,單個設備出現超過4 000 W的功率置零,對于缺失的數據進行填充。

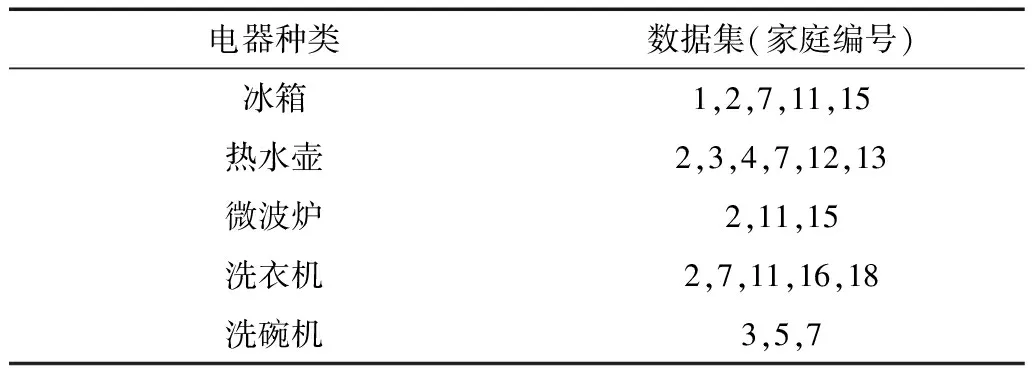

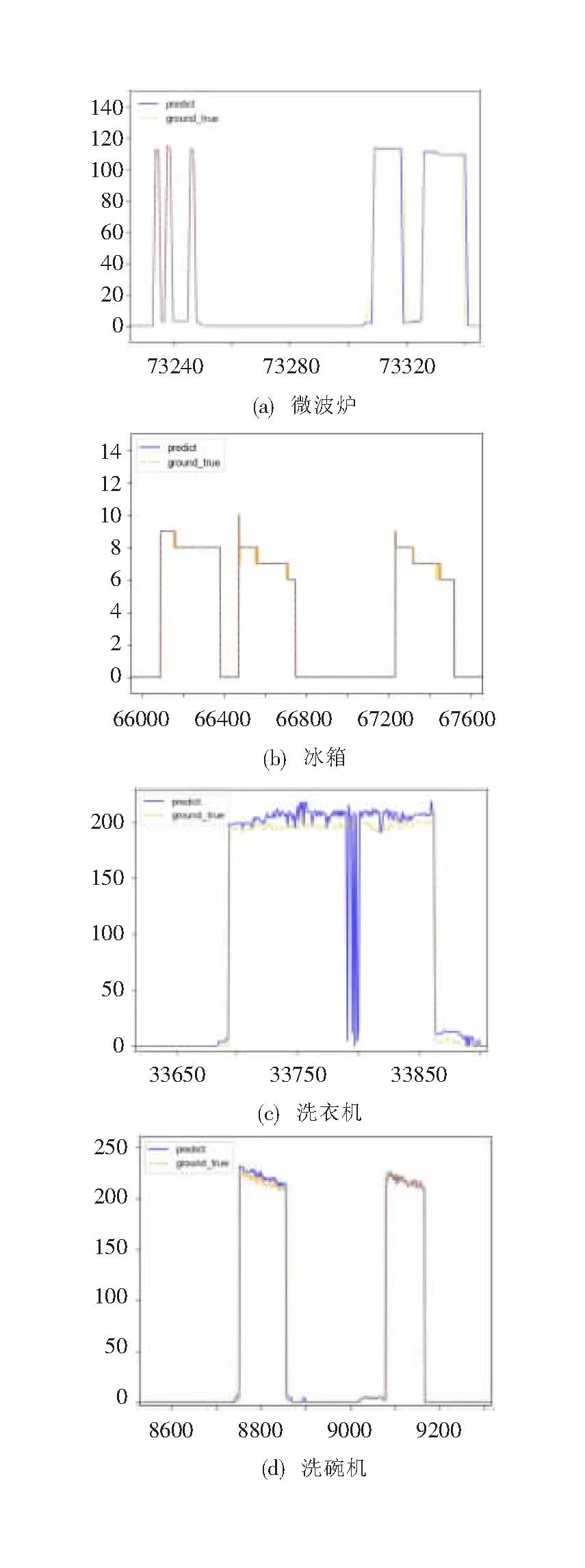

3.2 用電器的選取

本文選取冰箱、熱水壺、微波爐、洗衣機及洗碗機這5種常見用電器作為研究對象(見表1)。這5種用電器具有不同的工作狀態,其中冰箱是周期性運行用電器,熱水壺是大功率用電器,微波爐運行時間短且功率變化頻率高,洗衣機和洗碗機是的長時間多狀態用電器,可以全面驗證本文所提模型的負荷分解性能。

表1 電器數據選擇

3.3 提取負荷激活特征

根據每種用電電器的實際工作狀態,從數據集中提取它們在運行時的功率數據,稱為提取負荷激活特征,負荷激活特征參數與數量如表2所示。

表2 負荷激活特征提取的參數

3.4 構造均衡數據集

在提取負荷激活特征后,構造訓練數據集。在本文模型中,每種負荷模型的輸入為固定長度的序列,其輸入的序列長度如表2所示。對于5種用電器,分別按照下列步驟構造其對應訓練數據:

1)根據該用電器模型的輸入序列長度Nm創建兩個全零序列,一個用作存儲輸入的總用電功率,一個用作存儲模型輸出的單負荷功率;

2)在50%概率下,從該用電器的負荷激活特征中隨機選取,即某次運行階段的功率消耗數據,并在保證該段負荷激活可以完全放入序列的前提下,隨機選取起點將放入序列中;在另外50%概率下,保持全零序列不變;

3)將其它四個用電器作為干擾電器,均以25%的概率隨機選取一次負荷激活(無需保證序列的完整),隨機選擇起點放入序列中。

根據實際多種用電器同時工作的情況,調整訓練集中干擾電器的選取概率,使得模型更符合實際的負荷分解情境。本文對于每種電器構造400萬條數據用作訓練數據集。

3.5 實驗評估指標

本文選擇準確率、召回率、F1值、平均絕對誤差作為評價模型的指標,計算方法如下:

(12)

式中Precision為準確率;Recll為召回率;F1代表F1分數,又稱平衡F分數;TP表示用電器實際處于工作狀態且模型分解結果也為工作狀態的序列點總數;FP表示用電器實際處于工作狀態但模型分解結果為非工作狀態的序列點總數;FN表示用電器實際未工作但模型分解結果為在工作狀態的序列點總數;yt為時刻用電器真實功率;ft(x)為t時刻模型分解功率,MAE為時間段T0到T1內功率分解值的平均絕對誤差。Precision反映了模型預測用電器處于工作狀態的精確度;Recall代表著正確召回用電器處于工作狀態的概率;F1分數綜合Precision和Recall反映模型判斷用電器是否處于工作狀態的準確度,是負荷分解的基本指標,前人的研究已經將其做到了較高的水平。MAE可以反映模型每時刻分解功率值的準確性,其值越低,則功率分解值的準確性越高。

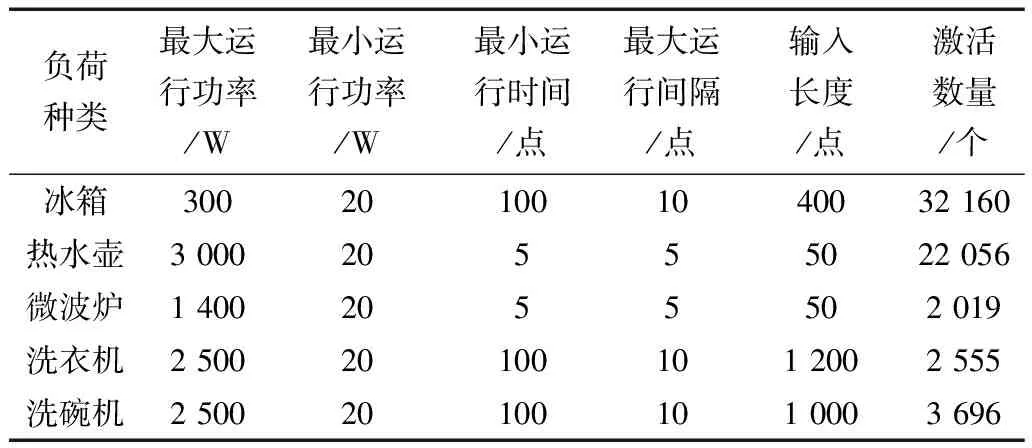

3.6 實驗評估指標

總功率經模型預測輸出的分解功率與真實功率如圖6所示,對于功率的跟蹤效果比較好,僅在起始點與終止點的定位有所偏差,故分解功率值仍是非常高的。這也說明對于不同工作狀態的電器具有良好的負荷分解能力。

圖6 各電器真實功率與模型分解功率對比

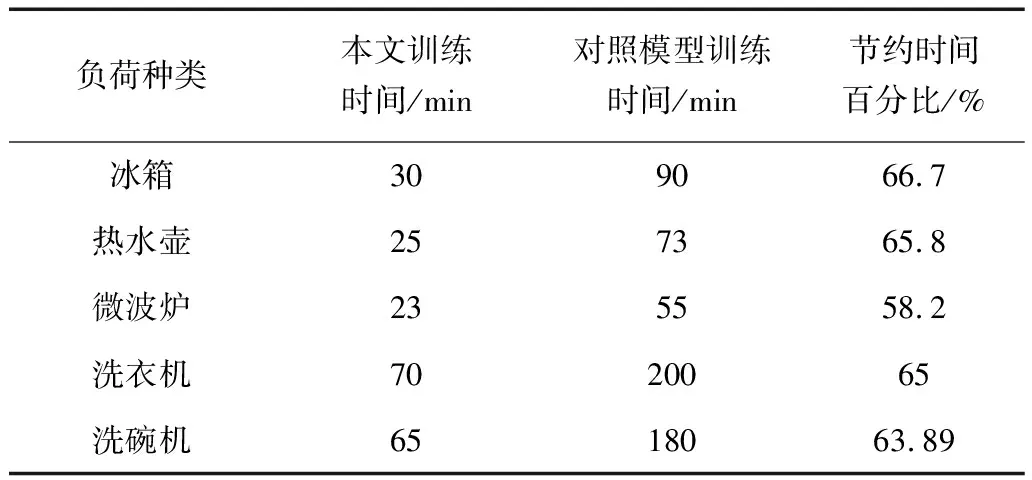

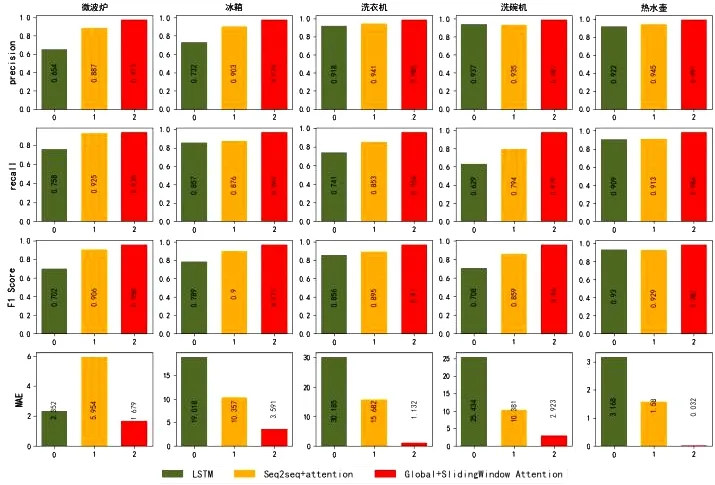

選取文獻[13]所提出的LSTM模型與本文模型做訓練時間上的對比,如表3所示,可以看出本文模型可以大幅度降低模型的訓練時間測試結果總體如圖7所示。

表3 模型訓練耗時

圖7 測試結果

本文與文獻[13]所提出的LSTM模型對比,準確率上有著較大的提高,可見本文所提模型對于多種工作狀態的電器均有著優秀的建模能力。從滑動窗口,空洞滑動窗口,全局與滑動窗口結合的三種注意力機制來看,雖均有著較好的提升,但在全局與滑動窗口相結合的注意力機制更能全面而有效的提取長序列信息。

4 結束語

本文采用基于GSWA和Seq2seq的非侵入式負荷分解模型。該模型對Attention機制進行改善,將解碼集中注意在與當前時刻相關度最高的編碼層隱藏狀態,在大幅提高模型分解功率準確值的同時,降低了模型計算量,加快了訓練網絡的速率。本文模型在準確率,召回率,F1值等指標上較前人均有提升,并顯著降低訓練時間。未來在對于提升網絡的泛化能力以及對于小功率噪聲的處理能力上開展研究。