面向多姿態點云目標的在線類增量學習

張潤江,郭杰龍,俞 輝,蘭 海,王希豪,魏 憲*

(1.福州大學 電氣工程與自動化學院,福建 福州 350108;2.中國科學院 福建物質結構研究所,福建 福州 350002;3.中國科學院 海西研究院 泉州裝備制造研究中心,福建 泉州 362000)

1 引 言

深度神經網絡(Deep Neural Networks,DNN)已經在許多機器學習任務中取得了巨大的成功[1-3],這些任務都是基于獨立同分布(Independent Identically Distributed,IID)數據。這一設定違反了實際應用中所面臨的非平穩數據分布,如自動駕駛、智能對話系統、智慧醫療和其他實時應用。面對非IID 數據,當DNN 對新任務進行再訓練時,神經網絡在過去任務中的性能表現會迅速下降,這被稱為災難性遺忘[4]。增量學習(Incremental Learning,IL)[5]的出現 使DNN 能夠在 學習新知識的同時保留先前獲得的知識,使模型具有可塑性-穩定性[6]。

傳統的增量學習大都是以離線的方式訓練模型,即通過重復訓練多批次當前任務的數據來增加模型的擬合效果。然而,由于隱私問題或者內存限制,離線的設定不再適用。本文考慮了一項具有挑戰性的單次數據流任務,即在線類增量學 習(Online Class-Incremental Learning,OCIL)[7]。OCIL 限制每個訓練任務的樣本流只能看到一次,并且是非IID 的。

以往IL 和OCIL 的研究對象都是具有固定姿態的樣本流,即每個樣本都預先進行了矯正。這種設定對自動駕駛等實時應用是不負責任的,它們在真實情況中所面臨的數據流是各個姿態的,即樣本特征存在平移、旋轉對稱變換[8]。常用的數據擴充方法[9]在面對OCIL 這種單次數據流時也變得不再適用,特別是3D 目標姿態的高復雜性對網絡提出了更嚴格的要求。傳統的神經網絡只具有平移等變性[10]而不具備旋轉等變性。在IL 任務中,除了新任務帶來的影響外,造成遺忘的另一個重要原因是網絡沒能提取到目標足夠的幾何信息,而更多地關注到了一些無關特征,如固定的位置信息而不是目標本身之間的結構信息。保證遺忘率盡可能低首先要保證能夠學到更豐富的幾何特征,為此,我們基于李群引入旋轉等變機制[11-13]降低網絡受目標姿態的影響。同時,使用點云數據以坐標和特征值的形式出現,即,此設定可以方便網絡提取目標的幾何信息,且通用于2D 和3D 的數據。

常見的類增量學習方法大致分為3 大類:參數隔離方法[14-16]、正則化方法[17-19]和記憶重放方法[20-22]。參數隔離方法是通過擴展網絡模型為代價提高網絡的可塑性,以適應新的學習任務。隨著新類別的增加,該方法將會導致參數量線性增長,從而變得不可持續。正則化方法通過添加正則項,在學習新的別類時約束參數的更新方向來避免災難性遺忘。但正則化通常以犧牲可塑性為代價,不僅會降低對新知識的接納程度,還增加了先前知識的遺忘率,往往表現不佳[23]。相比之下,記憶重放的方法已經比較成熟,將舊任務數據流中的少量樣本存儲在存儲器中,并在新任務的訓練中重放它們。該方法在許多具有挑戰性的場景中都具有最優的表現,在IL 中發揮著關鍵的作用。本文在研究中采用基于記憶重放的方法。

基于以上問題,本文提出無視姿態重放方法,主要工作有:

(1)考慮更符合現實情況的復雜設定,即面向多姿態目標的在線類增量學習。

(2)提出一個通用于2D 和3D 數據的OCIL模型。基于李群引入旋轉平移等變機制,使網絡能夠提取更豐富的幾何信息,減弱目標姿態的影響,從而緩解災難性遺忘。

(3)提出基于損失變化的記憶重放策略,在圖像分類基準數據集MNIST、RotMNIST、CIFAR-10 和trCIFAR-10,3D 點云基準數據集ModelNet40 和trModelNet40 上進行了實驗。本文方法在目標多姿態的設定下顯著優于對比方法。

2 相關基礎

2.1 類增量學習

一般情況下,類增量學習是涉及T個任務的順序學習,這些任務由不同的類集組成,在不同學習階段逐漸增加,且須在任何一個訓練任務t中對前t-1 個任務中所看到過的類能夠準確分類[24-27],可以按以下方式設定:

其中:C表示所有類別的集合;Tt表示C中分配給任務t的子集,其由分配函數Ψ決定表示類別c的樣本集;則表示任務t的樣本集,且=?。值得注意的是,不同類別c的樣本集數量Mc可以相同也可以不同,本文考慮Mc相同情況下的場景。

2.2 等變性和不變性

等變性:當一個函數f:X→Y的定義域X被對稱群G作用,然后計算函數f所得到的結果等同于先計算函數f,然后計算應用群G作用得到的結果一樣時,我們稱函數f關于變換G是等變的,如公式(2)所示:

其中,g∈G是對稱群G的一個群元素。

不變性:同理,當一個函數f:X→Y的定義域X被對稱群G作用,然后計算函數f所得到的結果同直接計算函數f得到的結果一樣時,我們稱函數f關于變換G是不變的,如公式(3)所示:

在分類任務中,我們期待的是對輸入進行任何對稱變換,最終得到的結果不發生變化,即不變性。通常的解決辦法是將具有不變性的函數f與等變函數fk組合在一起,最終達到不變性。證明過程如式(4)所示[28]:

其中:群表示π1,…,πK分別作用于函數f1,…,fK上,且fk關 于πk,πk-1等 變,即fk°πk-1=πk°fk,k∈{1,2,…,K},函數f關于πk不變,即f°πk=f,因此f°fK°…°f1是不變函數。

群等變:深度學習中最常見的等變是卷積層的平移等變性,即Lt f(x)=f(x+t),然而卻不具備旋轉等變性,即Lr f(x)≠f(r°x)。為了能處理多姿態數據,最初的辦法是數據擴充[29-30]。2016 年,文獻[8]基于p4 群和p4m 群首次提出了具有旋轉對稱性的群等變卷積神經網絡。從此,關于群等變性的研究吸引了許多學者的注意。例如文獻[11,31-32]提出基于SO(3)的三維旋轉群,文獻[33-34]提出基于SE(d)的平移旋轉群,文獻[35]提出基于R*×T(2)的平移放縮群等。

2.3 點卷積

本文使用通用于圖像和點云的點卷積網絡[36-37],其定義如公式(5)所示:

其中:gθ:Rd→為卷積濾波器,f(·):Rd→為輸入特征圖,h(·):Rd→為輸出。

離散化后如公式(6)所示:

其中:V為積分空間體積,n為正交點的數量。在例如圖像的3×3 卷積層中,gθ對每個落在3×3網格上的點:(-1,-1),(-1,0),…,(1,1)都有獨立的參數。

3 無視姿態重放的在線類增量學習

我們考慮一個單次數據流的類增量場景,它模擬了一個實際的設置,模型必須對每個傳入的示例執行在線更新,而無需重復多次訓練。在每個任務t到來時,系統從數據流中接收一組新的樣本:其 中,bs 為每組 的樣本 個數,xi為原輸入樣本,yi為樣本的標簽。考慮到目標的多姿態時,其輸入表示為Tg xi,意為原樣本發生幾何變換(旋轉、平移)后的結果;g為SE(d)(d=2,3)群的一個群元素,是對應幾何變換的群表示。

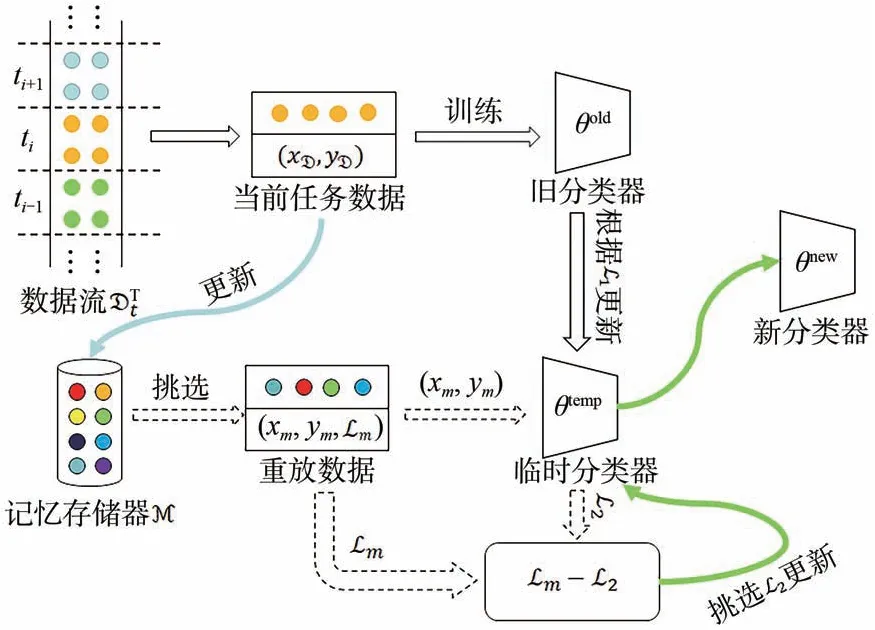

模型結構如圖1 所示,主要包含兩部分:(1)可以提取豐富的幾何特征的分類器θ;(2)基于損失變化的記憶重放。

圖1 模型結構圖Fig.1 Model structure diagram

3.1 具有多姿態識別能力的分類器θ

為了降低OCIL 任務中網絡受目標姿態的影響,同時提取更豐富的幾何特征,減少災難性遺忘,我們提出具有抗旋轉平移幾何變換能力的分類器,即圖1 中的θ。分類器為在骨干網絡PointNet++[38]上進行的改造,主要加入3 部分:點云化處理、群等變點卷積層和群全局池化層。

點云化處理負責將原輸入轉換成點云數據,其過程如公式(7)所示:

其中:x是原始輸入,當輸入是圖像數據時d=2,當輸入是3D 數據時d=3;y是原始輸入映射到高維空間后的點云化結果,即,xi是點云坐標,其原點為輸入樣本的幾何中心,fi為每個點所對應的特征值。例如,在CIFAR-10 數據集中,xi為(-16,16),(-15,16),…,(16,-16),對應原樣本圖片從左上角到右下角的坐標;fi是為原樣本圖片從左上角到右下角每個像素點所對應的特征值。點云化處理后的高維信息同時包含了幾何位置和每個點的特征信息,使得數據特征更加豐富,從而能夠更好地提取幾何特征。

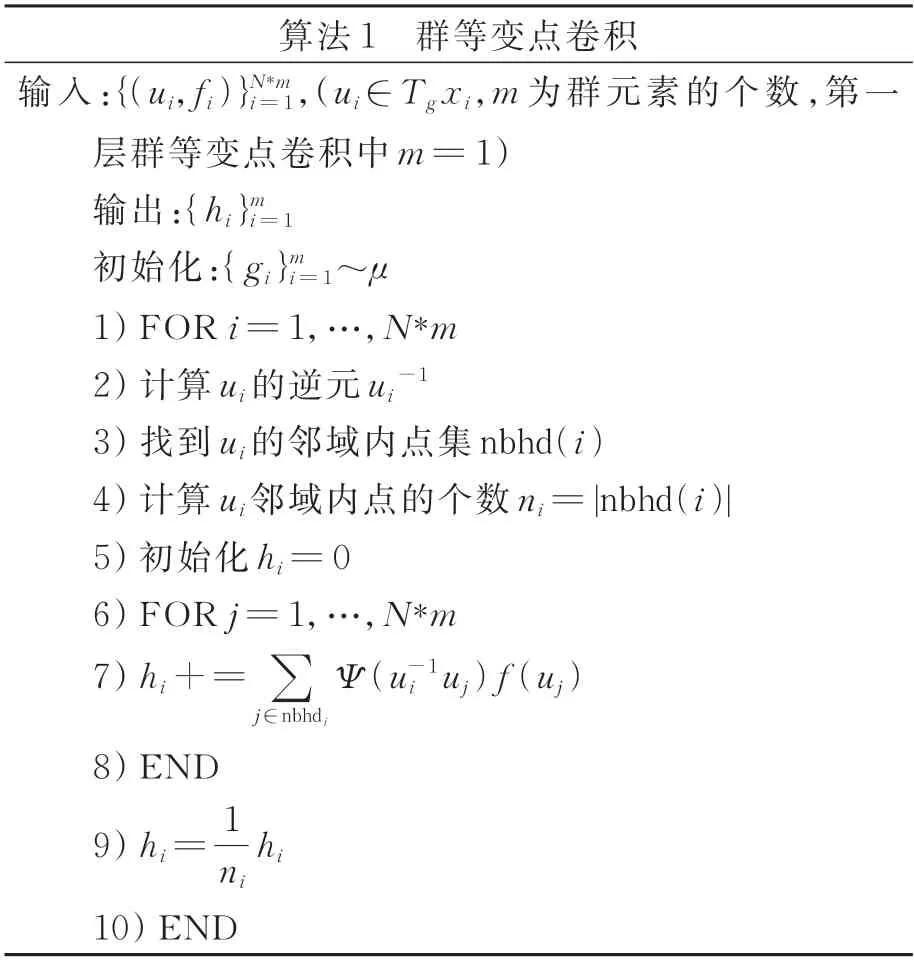

群等變點卷積層負責對網絡進行平移旋轉等變性改進。將點云化信息映射到更高維的空間以提取特征,是使網絡抗旋轉平移幾何變換的關鍵,其定義由公式(8)和公式(9)給出:

其 中:g∈SE(d),d=2 適用于xi∈R2,d=3 適用 于xi∈R3,{ui∈SE(d):u0=x},ni=|nbhd(i)|為每個點鄰域中的點數。公式(8)只適用于點卷積的第一層,其將輸入從歐式空間映射到了SE(d)所在的李代數空間,即:Z2?SE(d);公式(9)適用于除第一層以外的所有點卷積層,其在李代數空間進行映射,即SE(d)?SE(d)。值得注意的是,在考慮姿態的在線類增量學習設定下,xi在不同時刻表現為不同的Tg xi,即同一個樣本每次出現都會表現為不同的姿態(發生了不同的平移和旋轉)。另外,由于SE(d)群是連續群,并不能窮舉g的所有的情況,我們使用哈爾測度μ進行均勻采樣。

點云化處理后,顯式地蘊含了位置信息和特征信息。而群等變點卷積層則能夠將輸入映射到SE(d)所在的李代數空間,該空間融合了樣本不同位置和角度的特征,能夠使網絡不受目標姿態的影響。同時,點卷積能夠使每個點鄰域范圍內的特征進行聚合,表征一定范圍內的幾何信息,從而使網絡能夠提取更豐富的幾何特征。

群等變點卷積層的具體實現算法流程如算法1 所示,其關于旋轉和平移變換是等變的,證明過程如式(10)所示:

其中:Lt f表示對輸入進行t(旋轉平移)變換,第一行到第二行令x=tx。證明結果滿足公式(2)中等變性的定義。

群全局池化層與普通的池化層類似,包括最大池化和平均池化等,本文使用了全局最大池化(GlobalMaxPooling,GP),其定義如公式(11)所示:

其中,gU是SE(d)的子群U上的一個g變換。對GP 層的輸入進行對稱變化,其輸出總是不變的,即GP 具有不變性,滿足公式(3),放在網絡的最后用來使模型整體達到不變性的效果,相當于公式(4)中的f,其示意圖如圖2 所示,ki∈gU。

圖2 全局最大池化層Fig.2 Global maximum pooling layer

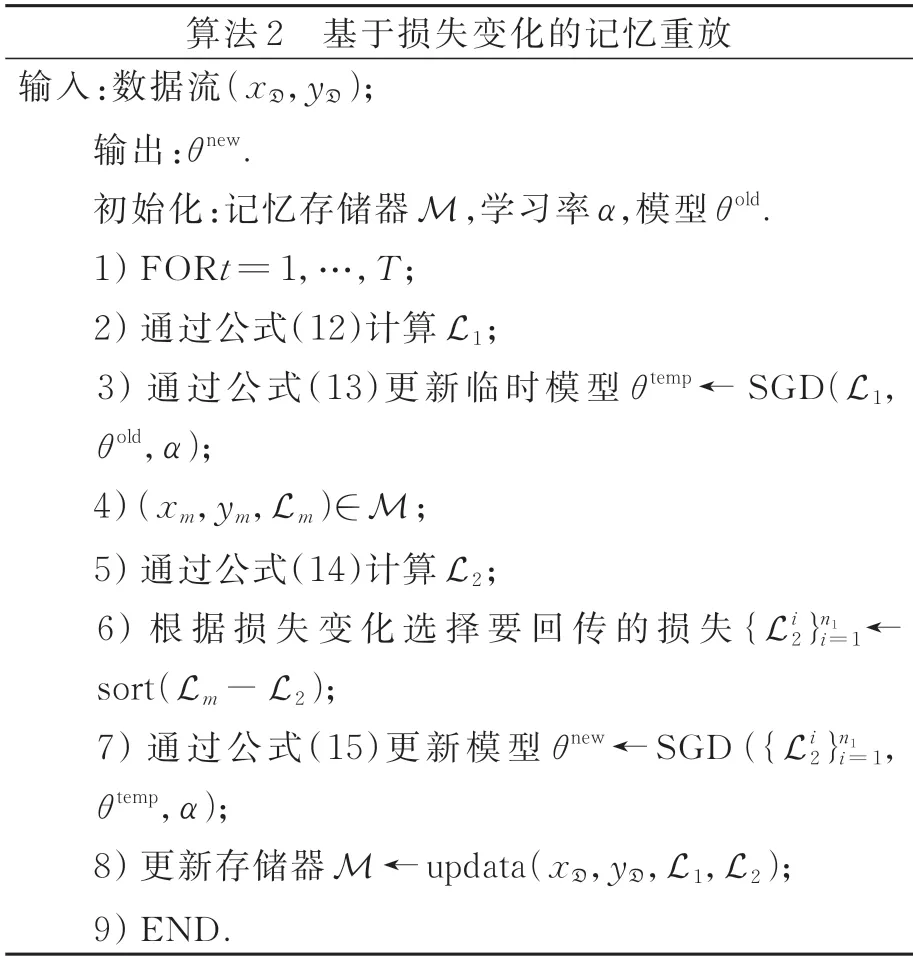

3.2 基于損失變化的記憶重放

為了應對OCIL 挑戰,基于記憶重放的方法在固定內存中儲存少量訪問過的數據,并在未來的任務中進行回放,都取得了很好的成效[7,39-40]。我們分配一個固定內存大小的記憶存儲器M(容量為M),當樣本流到達時,使用隨機采樣[41]來保證記憶的多樣性,同時,儲存了每個樣本最近一次的損失L,即存儲器中為為了保證M 中的樣本均衡,在每個新類到達時舍棄一部分舊樣本來儲存新樣本,并保證每個類別的數量相同。

記憶重放涉及的關鍵一步是回放樣本的選擇,我們采用與[7,42]類似的假設,即模型應該優先回放被忘記的樣本,以減少對早期任務類別的災難性遺忘。算法2 描述了具體的重放過程。在時刻t,舊模型θold從數據流D中接收一批數據,根據損失L1執行更新產生臨時模型θtemp,如公式(12)和公式(13)所示:

其中:?為交叉熵損失函數,α為學習率。接著從存儲器中抽取n2≥n1組數據,根據臨時模型θtemp計算損失L2,并與Lm進行比較,挑出損失變化最大的n1組L2用于更新θtemp,從而產生新模型θnew,如公式(14)和公式(15)所示:

4 實驗結果與分析

4.1 實驗數據集

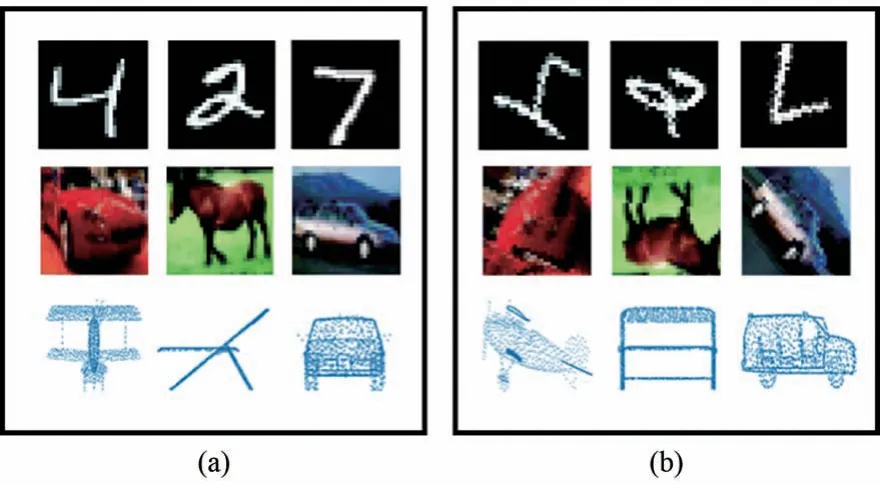

我們使用MNIST[43]、RotMNIST[44]、CIFAR-10[45]、trCIFAR-10、ModelNet40[46]和trModel-Net40 數據集來評估本文提出的方法。其中,Rot-MNIST 數據集由62 000個隨機旋轉的MNIST 數字組成,旋轉角度從SO(2)中均勻采樣。trCIFAR-10 和trModelNet40 為我們對CIFAR-10 和Model-Net40 進行隨機的平移和旋轉的幾何變換,模擬真實多姿態場景。MNIST、CIFAR-10、Model-Net40 用于固定姿態目標實驗,如圖3(a)所示。RotMNIST、trCIFAR-10、trModelNet40 用于多姿態目標的實驗,如圖3(b)所示。我們列出了每個數據集的實驗設置:

圖3 固定姿態目標(a)與多姿態目標(b)Fig.3 Fixed posture target(a)and multi-posture target(b)

(1)MNIST 和RotMNIST:按照每2 類為一個任務,分為5 個不同的任務;將圖片轉為特征值為像素值的2D 點云輸入,即,其中xi∈R2,fi∈R。遵從文獻[7]的設定,每項任務分配1 000 個樣本用于訓練。

(2)CIFAR-10 和trCIFAR-10:按照每2 類為一個任務,分為5 個不同的任務。將圖片轉為特征值為像素值的2D 點云輸入,即其中xi∈R2,fi∈R3。遵從文獻[7]的設定,每項任務分配9 500 個樣本用于訓練。

(3)ModelNet40 和trModelNet40:按照每4 類為一個任務,分為10 個不同的任務;點云輸入為其 中xi∈R3,fi=1。由 于Model-Net40 數據集不同類的樣本數量不同,故取每類的80%用于訓練,即共有9 843 個數據流用于訓練。

4.2 實驗環境

本文所有實驗都在同一學習環境下進行,如表1 所示。

表1 實驗環境Tab.1 Experimental environment

4.3 基線和評價指標

對于固定姿態目標和多姿態目標的實驗,我們考慮了以下設定作為評價基線:

(1)finte-tuning:微調,在新任務到達時連續訓練,不采用任何防遺忘策略,作為實驗對照下限;

(2)iid online:所有任務數據同時出現并訓練一次;

(3)iid offline:允許數據多次出現重復訓練,作為實驗的上限。

這些基線所使用的分類器都是3.1 節中具有多姿態識別能力的分類器。為了評估不同方法的效果,我們引入兩個評價指標:最終平均準確率(AvgACC)和平均遺忘率(AvgF)[41]。

4.4 實驗分析

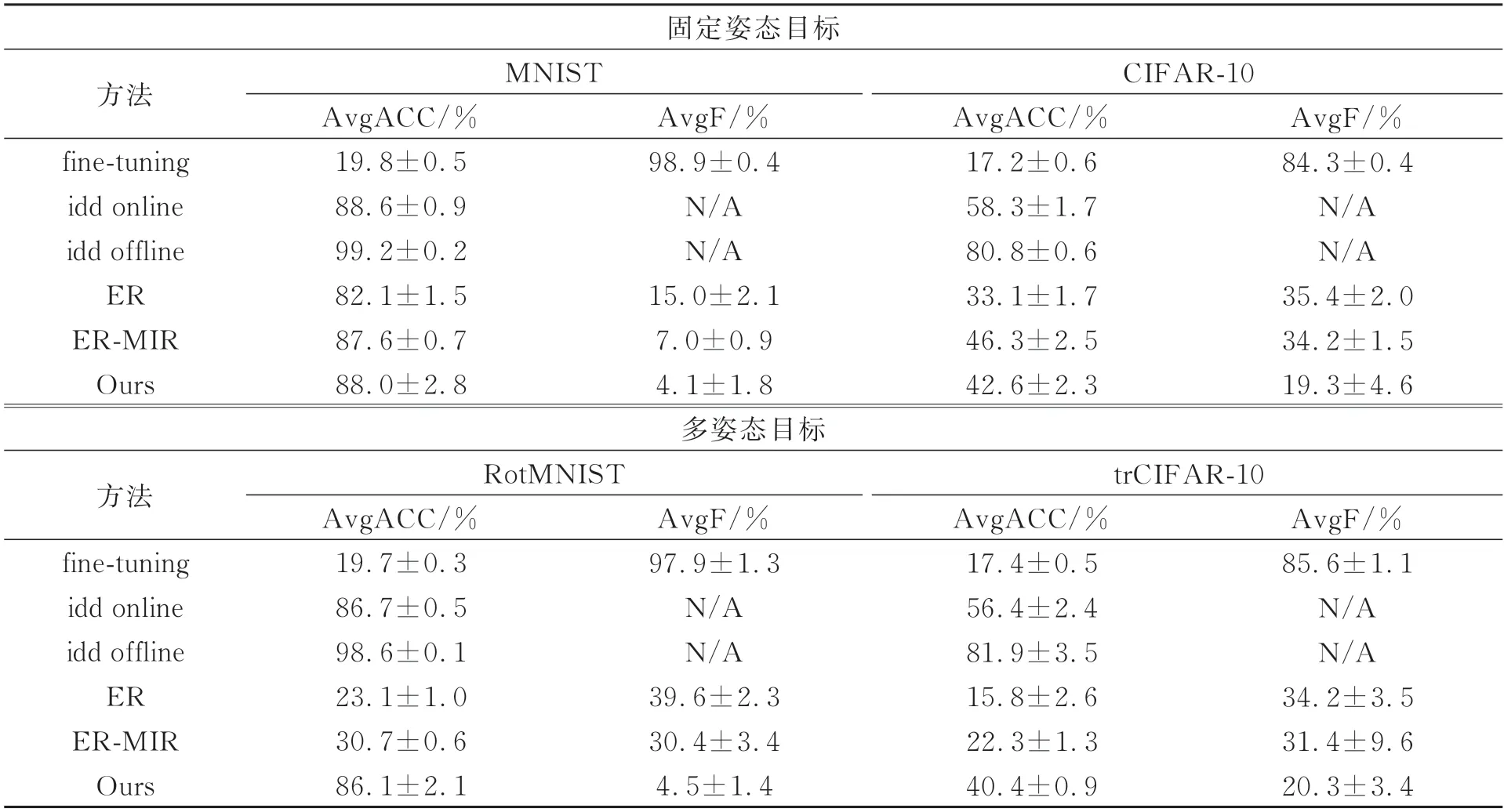

我們在2D 數據集上進行了評估,即MNIST、RotMNIST、CIFAR-10 和trCIFAR-10。除 了4.3 節中提到的基線外,本節還使用了其他兩種基于記憶重放的類增量學習方法作為面向2D 數據的對照實驗:ER[41]和ER-MIR[7]。我們統一了記憶存儲器的容量M=500,且每批數據只迭代1 次。每組實驗進行了20 次并取平均值,結果如表2 所示。

表2 2D 圖像數據上的實驗結果Tab.2 Experimental results on 2D image data

可以看到,當面對固定姿態目標MNIST 時,本文方法的AvgACC 和AvgF 分別為88.0%和4.1%,均優于ER 和ER-MIR 方法,且AvgACC 與基線iid online 接近,說明本文方法可以有效緩解災難性遺忘,實現任務之間的穩定性。當面對固定姿態目標CIFAR-10時,本文方法的AvgACC 明顯優于ER,與ER-MIR 相比也僅差3.7%,但AvgF明顯優于ER 和ER-MIR,證明本文方法可以很大程度緩解災難性遺忘。

而當面對多目標姿態RotMNIST 時,ER 和ER-MIR 與它們在MNIST 中的表現相比具有顯著的變化,AvgACC分別下降了59.0%和56.9%,AvgF 也分別增加了24.6%和23.4%,說明ER和ER-MIR 在面對多姿態目標時均不能學習到有效信息,且遺忘率明顯增加,并不適用于真實場景。而本文方法與在MNIST 中的表現相比,AvgACC只下降了約1.9%,AvgF只增加了0.4%。在20 次的實驗中,本文方法的AvgACC 均保持在85%以上,證明本文方法可以有效抵抗目標姿態所帶來的影響,且對災難遺忘有明顯的緩解作用。當面對多目標姿態trCIFAR-10 時,本文方法的表現與上面所述一致,受目標姿態影響很小,AvgACC 只降低了約2.2%,AvgF 只增加了1%。而ER 和ER-MIR 在面對多姿態目標trCIFAR-10時的AvgACC 不及它們在固定姿態目標CIFAR-10 中表現的1/2。雖然AvgF 并沒有很大變化,甚至ER 在trCIFAR-10 中的AvgF 要略低于在CIFAR-10 中的AvgF,但這是由于ER 本身在學習中的最高準確率很低所導致。

圖4中列出了本文方法和ER-MIR方法中每個任務在不同時期的分類精度對比。如圖4(a~d)所示,當面對數據集MNIST 時,本文方法和ERMIR 的表現不相上下,每類任務的最終準確率都與最初的準確率相比并沒有太大變化,說明本文方法和ER-MIR 在面對固定姿態目標時都能提取有效的特征,并對災難性遺忘有很好的抵抗力,面對OCIL 這種嚴格的設定能保證穩定性。而當面對RotMNIST 時,ER-MIR 變得不再穩定,在后續任務中發生了災難性遺忘,每類任務的最終準確率與初始準確率相比有明顯的差距,下降到了20%~45%,遠不及它在MNIST 中的表現。相比之下,本文方法在面對RotMNIST 時仍能保證最終準確率與初始準確率很小的差距,維持在76%~97%,且與在MNIST 中的表現相差無幾,證明本文方法并不受目標姿態的影響,在OCIL 任務中有效緩解災難性遺忘,具有很好的穩定性。

如圖4(e~h)所示,當面對CIFAR-10 這種更有挑戰的數據集時,本文方法和ER-MIR 雖然都有一定的遺忘,但它們的最終準確率也都能保持在33%以上。而當面對trCIFAR-10 時,ERMIR 的第一個任務和第二個任務的最終準確率下降至10%以下,第三個任務的準確率也下降到了20%以下,均發生了嚴重的遺忘。相比之下,本文方法依舊能和在CIFAR-10 中的表現一樣,有效地消除了目標姿態所帶來的影響,具有相對較好的穩定性。

從圖4 中還可以看到,本文方法在這4 種數據集中每類任務的最終準確率相差不超過22%(分別為12%,22%,19%,18%),并沒有出現由于單任務準確率高而提高平均準確率的現象,說明本文方法在OCIL 任務中不僅不受目標姿態的影響,還有很好的平衡性。

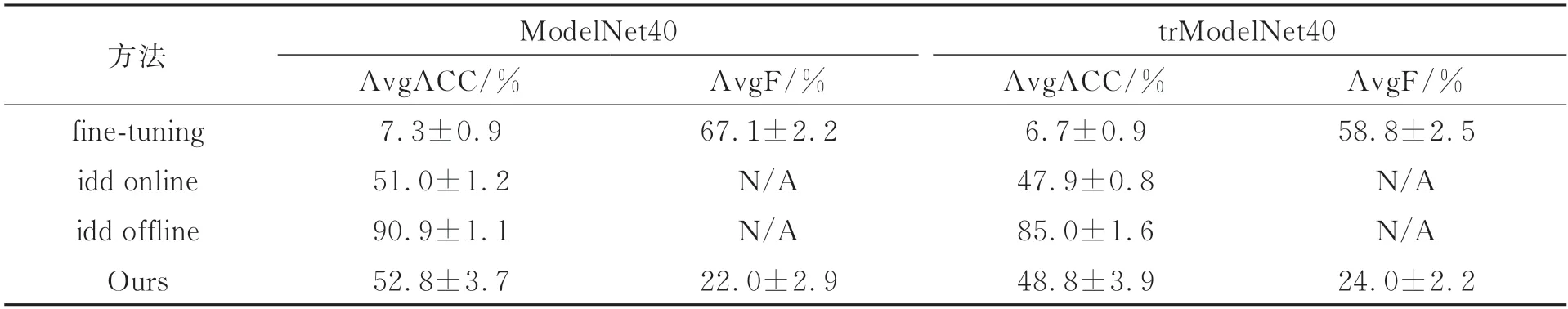

為了驗證本文方法性能,我們進一步在3D數據集ModelNet40 上進行了實驗。在我們的了解中,并沒有發現面向3D 數據的OCIL 的相關研究,因此,本部分的對照實驗只采用3.3 節中所提到的基線實驗。同時,設定記憶存儲器的容量M=4 000,即每個任務存儲200 個樣本,且每批數據依舊只迭代1 次來保持online 的設定。每組實驗進行了20 次并取平均值,結果如表3 所示。可以看到,本文方法在面對多姿態目標trModel-Net40 時的性能與固定姿態目標ModelNet40 的AvgACC 和AvgF 都相差不大,分別約為4%和2%,且AvgACC 超過了基線idd online 的結果,證明本文方法在面對3D 目標時也可以做到無視目標的姿態,同時對災難性遺忘有很大程度的緩解。

表3 3D 數據上的實驗結果對比Tab.3 Experimental results on 3D data

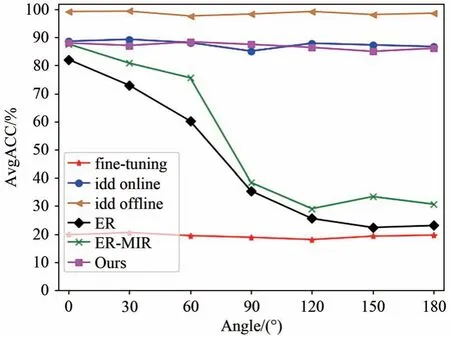

為了評估不同姿態對OCIL 任務的影響,我們在MNIST 數據集上進行了補充實驗,如圖5 所示。其中,橫軸表示樣本的姿態變化范圍,如“60”表示數據流在[-60°,60°]范圍內隨機旋轉,以此類推,來模擬樣本姿態的豐富程度。從圖5 可以明顯看到,隨著角度變化范圍的增大,ER 方法和ER-MIR 方法的AvgACC 逐漸下降,尤其在60°后有顯著的下降,并最終下降到基線fine-tuning附近,可見樣本姿態對傳統方法有較大的影響。相比之下,本文方法的AvgACC 隨著角度變化范圍的增大只有較小的波動,波動范圍保持在3%以內,證明本文方法可以在很大程度上降低目標姿態的影響,有很好的穩定性。

圖5 MNIST 不同姿態的結果Fig.5 Results of MNIST with different postures

5 結 論

與傳統增量學習不同,本文考慮了更切合實際的復雜場景,即面向多姿態目標的在線類增量學習,該設定加劇了災難性遺忘。為了解決這個問題,本文提出了通用于2D 和3D 數據的在線類增量學習方法。該算法的網絡框架基于SE(d)李群引入旋轉平移等變機制,使網絡可以更好地提取目標的幾何信息,從而使模型不受目標姿態的影響,增加模型的可塑性。本文還提出了基于損失變化的記憶重放方法,能夠配合我們的分類器緩解災難性遺忘,在穩定性和可塑性直接得到很好的權衡。本文方法在MNIST、RotMNIST、CIFAR-10、trCIFAR-10、ModelNet40 和trModel-Net40 數據集上進行多次實驗并獲得了有競爭力的結果,其中AvgACC 除了在CIFAR-10 表現略低于ER-MIR 外,其余都取得了最好的結果,分別為88.0%,86.1%,42.6%,40.4%,52.8%,48.8%;AvgF 則在所有情況下都為最優,分別為4.1%,4.5%,19.3%,20.3%,22.0%,24.0%。實驗結果驗證了本文方法的有效性,能夠同時做到不受目標姿態的影響并緩解災難性遺忘。