結合特征融合與物理校正的水下圖像增強方法

王德興,楊鈺銳,袁紅春,高 凱

(上海海洋大學 信息學院,上海 201306)

1 引 言

隨著社會和科學的發展,有著豐富資源和眾多未知生物的海洋吸引著各個國家的探索和研究[1-2]。深海環境的圖像通常通過電子攝像設備獲取,然而水下拍攝得到的圖像存在色偏、能見度低、邊緣細節缺失等嚴重問題。呈現色偏的主要原因是水對不同的波長的光具有不同的吸收能力。隨著水深增加,紅色長波最先被吸收,藍色和綠色的短波穿透力弱,易擴散分散,因此拍攝的圖像呈現了藍綠色[3]。由于海水是一種相當復雜的混合介質,海水中分布著不均勻的懸浮物質,比如微型浮游植物和非藻類顆粒[4],所以水下圖像還會呈現色彩失真、對比度低、細節特征模糊等問題。同時人工光源的使用也是造成圖像低質量的重要原因之一。在現實中,水下圖像具有重要的理論價值和實際應用意義[5],增強和復原低質量的水下圖像是一項有價值且具有挑戰性的任務。提供高質量水下圖像能為海洋勘探、資源開發、海洋救援等眾多工程帶來工作效率的提升。

水下圖像增強和復原的方法按其原理可分為3 類:基于物理模型的方法、基于物理的方法和基于的深度學習的方法。基于物理模型的方法依據物理成像模型,將水下圖像增強看作是水下成像的反向問題,通過反向求解水下成像模型以復原高質量的水下圖像。該方法需要依據水下成像原理、大氣散射模型[6-9]等。暗通道先驗[10]的提出對水下圖像增強領域的研究具有重要的意義[11-12]。Xu 等人[13]提出新的基于視網膜的光估計方法。Zhou等[14]提出基于多尺度Retinex算法的色彩校正模塊恢復水下圖像的色偏。基于物理的方法是直接修改圖像的像素值來改善水下圖像的顏色和對比度。基于直方圖統計的方法在細節增強方面表現出色[15-17]。Ulutas 等人[18]根據相鄰元素的空間關系提出全局對比度校正和局部顏色校正模塊,能夠提高水下圖像的視覺質量。Wang 等人[19]分析圖像直方圖位置關系提出了還原圖像自然顏色和細節方法。融合方法被認為是一種不錯的策略[20]。Zhu 等人[21]提出使用小波變換融合兩張分別被經典白平衡和改進先驗方法預處理過的水下圖像來改善圖像的自然表達的方法。Gao 等人[22]提出使用不同物理方法預處理的兩張圖像根據權重不同進行多尺度特征融合的方法。基于深度學習的方法依托于強大的建模工程和大量的訓練數據。深度學習在圖像處理和一些高級視覺任務上顯示出卓越的性能,根據模型主體結構可將其進一步分為基于卷積神經網絡(CNN)和基于生成對抗神經網絡(GAN)的方法。Wang 等人[23]提出基于兩種顏色空間的端到端的CNN 方法。Li等人[24]提出了門控融合網絡方法,將3 個輸入圖像組合實現水下圖像的增強。Li等人[25]提出基于GAN 的算法,其核心是提高整個水下圖像的感知質量。Wang 等人[26]提出的基于Inception-Residual 的GAN 算法,把殘差思想和Inception 模塊嵌入到GAN 中去增強水下圖像。

物理方法操作簡單且易于應用,能夠根據像素之間的位置關系和像素統計策略來恢復圖像的細節,提高圖像對比度和亮度,但在嚴重失真的圖像和大量相同色偏風格的圖像中很難做到。深度學習是基于大量的數據驅動并由人工神經網絡研究升級得到的方法。人工神經網絡通常包括反向傳播的思想,能夠把正向傳播的結果作為反饋信息對網絡的最終輸出結果進行優化。在水下圖像處理中,基于深度學習的方法能夠靈活地學習處理多變的水下環境,泛化能力強,訓練優秀的模型能夠應用在相同類型的其他場景,然而模型龐大的深度學習方法需要大量的參數,對計算機配置的要求較高,因此在實際應用中受到限制。

由于單一的方法處理復雜的水下圖像相對困難,受文獻[26-31]的啟發,為了有效提高水下圖像的質量,本文提出結合輕量級特征融合網絡和多顏色模型校正的水下圖像增強方法。該方法采用模塊化設計,可減少代碼的冗余,降低方法的理解難度。在輕量級特征融合網絡部分,改進的特征融合模塊不僅能夠更好地保護圖像的空間細節特征,而且能在不降低特征信息提取能力的前提下減少模塊的參數量。改進的注意力模塊采用兩種池化方式分別對中間特征圖權重再分配,再將兩個新特征圖融合,既能提取重要特征紋理又能保留特征圖背景信息。該部分的輕量級體現在參數量的大幅度減少。與改進前的算法相比,參數量由0.15M 減少到0.03M(減少約80%),模型訓練速度提高。多顏色模型校正部分是基于物理方法對RGB 和HIS顏色空間中各顏色通道和重要參數進行校正,均衡圖像顏色,最終得到色彩自然真實、質量更高的圖像。本文方法不僅解決了深度學習網絡的計算機高配置要求和參數量龐大等問題,還具備了神經網絡的強泛化能力和物理方法增強圖像細節、提高圖像對比度和亮度的能力。

2 基本原理和分析

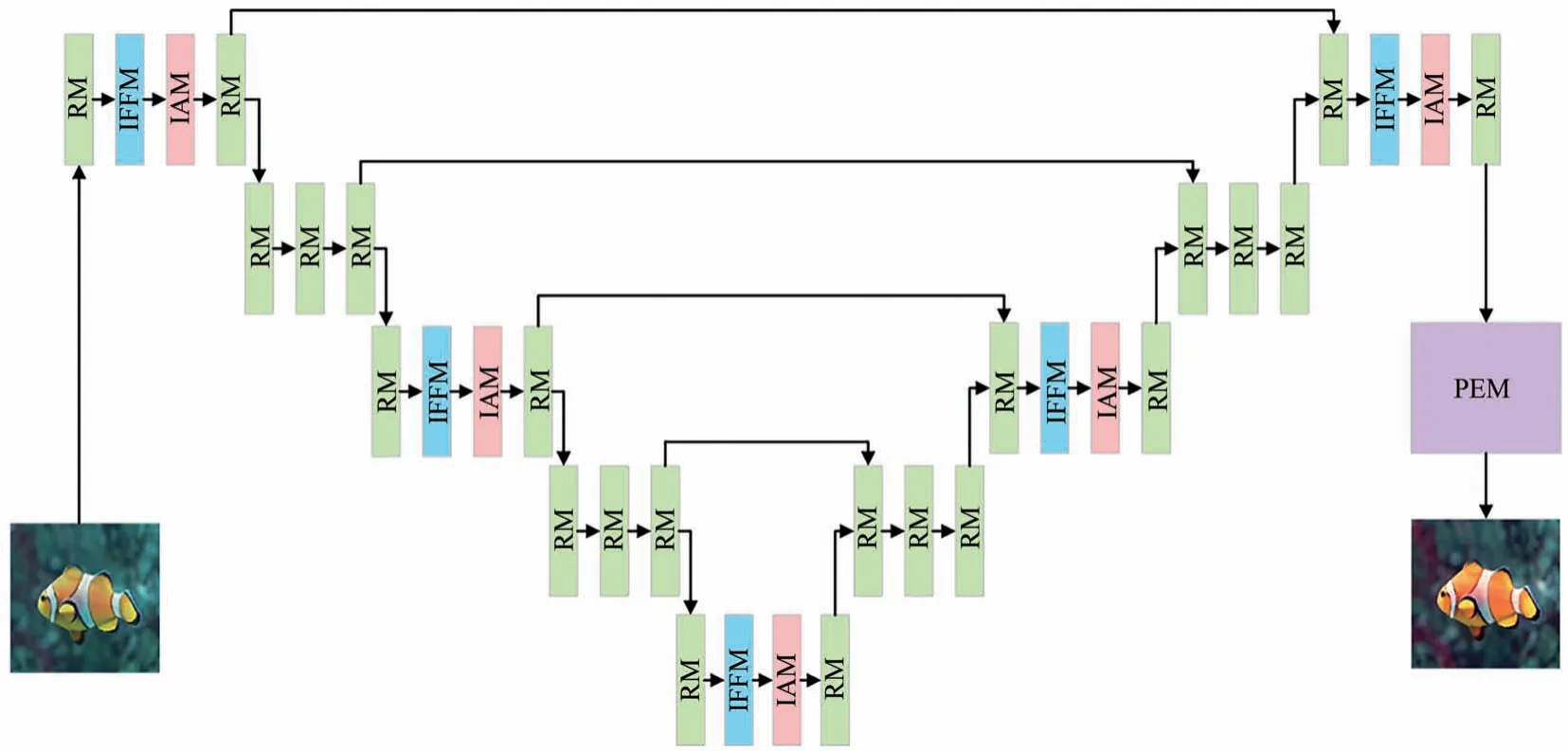

本文提出的方法由輕量級特征融合網絡和多顏色模型校正兩部分組成。輕量級特征融合網絡部分的主體架構采用類似于U-Net 的網絡模型。本文提出自構建模塊代替U-Net 中的卷積層以提高網絡的特征提取能力。多顏色模型校正部分在RGB 顏色模型和HIS 顏色模型中通過拉伸像素值和重要參數的范圍來實現對圖像質量的提升。總體架構圖如圖1 所示。

圖1 網絡總體架構Fig.1 Overall network architecture

本文設計4 種類型的自構建模塊,包括改進的特征融合模塊(Improved Feature Fusion Module,IFFM)、殘差模塊(Residual Module,RM)、改進的注意力模塊(Improved Attention Module,IAM)和物理增強模塊(Physical Enhancement Module,PEM)。按照自構建模塊的組合順序的不同,將其組合成4 種類型,共計10 個局部塊。前9 個局部塊屬于輕量級特征融合網絡,第10 個局部塊屬于多顏色模型校正。按從左到右的順序,第1、3、5、7 和第9 個局部塊是按照RM、IFFM、IAM 和RM 的順序連接而成,第2、4、6 和第8 個局部塊由3 個RM連續拼接而成,第10個局部塊是單獨的PEM。

2.1 改進的特征融合模塊

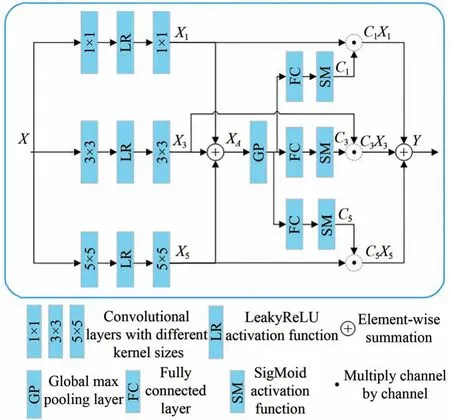

傳統U-Net 網絡的卷積層通過上采樣和下采樣的方式實現。但是上采樣計算量和參數量呈正相關,參數量越多計算量越大;下采樣方法會因為參數量少而丟失特征圖中某些重要的信息。為了解決上述問題,提出了改進的特征融合模塊來代替卷積層。該模塊采用不同大小卷積核生成不同比例的特征圖,再與相匹配的通道特征融合得到具有多尺度語義信息的特征圖。特征融合能夠減輕多層網絡的訓練難度,提高網絡的魯棒性和準確性。與改進前的模塊相比,模塊中使用SigMoid 激活函數代替全連接層,一方面降低全連接層對圖像空間結構的破壞程度,更好地保護圖像空間特征,保留了更多的細節紋理;另一方面減少模塊中的訓練參數量,加快訓練速度。模塊結構如圖2 所示。

圖2 改進的特征融合模塊Fig.2 Improved feature fusion module

該模塊將輸入的特征圖X變換為特征圖Y,實現多尺度的語義信息特征的提取。在該模塊中,首先分別用1×1、3×3 和5×5 的卷積核對特征圖X進行卷積運算,然后經過激活函數,最后再使用同樣大小的卷積核再次卷積運算,得到3 種不同尺度的特征圖Xi,Xi的計算如式(1)所示:

其中:i∈(1,3,5),Convi×i表示使用i×i大小的卷積核進行的卷積運算,LR 表示 LeakyReLU 激活函數。使用逐元素求和的方式將特征圖X1、X3和X5融合為XA,XA的計算方式如式(2)所示:

式中,+表示逐元素求和計算。對特征圖XA使用全局最大池化和全連接層計算,再由函數激活獲得張量Ci。其計算公式如式(3)所示:

其中:i∈(1,3,5),公式(3)可得到自適應選擇的通道張量C1、C3和C5,GP 為全局最大池化計算,FC 為全連接計算,SM 為SigMoid 激活函數。最終該模塊輸出的特征圖Y是由特征圖Xi與之相適應的Ci逐通道相乘再融合得到:

其中:Y是該模塊最終輸出的特征圖,·表示逐通道相乘操作,+表示特征圖逐元素求和。

2.2 殘差模塊

殘差模塊不僅能夠解決深度神經網絡退化問題而且還能加快其收斂速度,保持數據保真度[32],學習更深層次的特征。模塊結構如圖3 所示。

圖3 殘差模塊Fig.3 Residual module

圖中X為輸入的特征圖,Y為輸出的特征圖。Y的計算公式如式(5)所示:

式中使用兩個卷積層Conv 對特征圖X卷積運算,然后再與X逐元素相加得到Y。

2.3 改進的注意力模型

注意力機制是對權重資源重新分配的機制,將原本平均分配的資源根據注意力對象的程度高低實現再分配。在該模塊中,使用兩種池化策略關注圖像在通道方面的權重分配,首先使用具有不同池化效果的分支對該模塊的輸入特征圖計算,然后將兩個分支得到的中間特征圖融合,最后融合圖像與該模塊的輸入特征圖逐元素相乘得到包含有重要信息特征的輸出特征圖。圖4是改進的注意力模型。

圖4 改進的注意力模型Fig.4 Improved attention module

該模塊的輸入特征圖為X,輸出的特征圖是Y。第一個分支對特征圖采用全局最大池化計算,全局最大池化能夠提取特征紋理,減少無用信息的影響,然后對16 通道的特征圖進行卷積映射為4 通道的特征圖,并由激活函數激活重要特征,最后再將4 通道特征圖轉換為16 通道特征圖得到Sh。另一個分支是采用全局平均池化計算,全局平均池化能夠保留背景信息,減少過擬合現象,后續操作同第一分支一樣,得到Bh。Sh和Bh的計算公式如式(6)所示:

式中:MP 為全局最大池化計算,AP 為全局平均池化計 算,Conv 為1×1 大小的 卷積層,LR 為LeakyReLU 激活函數。最終輸出的特征圖Y是由Sh和Bh逐元素相加后與特征圖X逐元素相乘得到。特征圖Y的計算公式如式(7)所示:

其中:+表示逐元素求和計算,SM 是SigMoid 激活函數,?表示逐元素相乘操作。

2.4 物理增強模塊

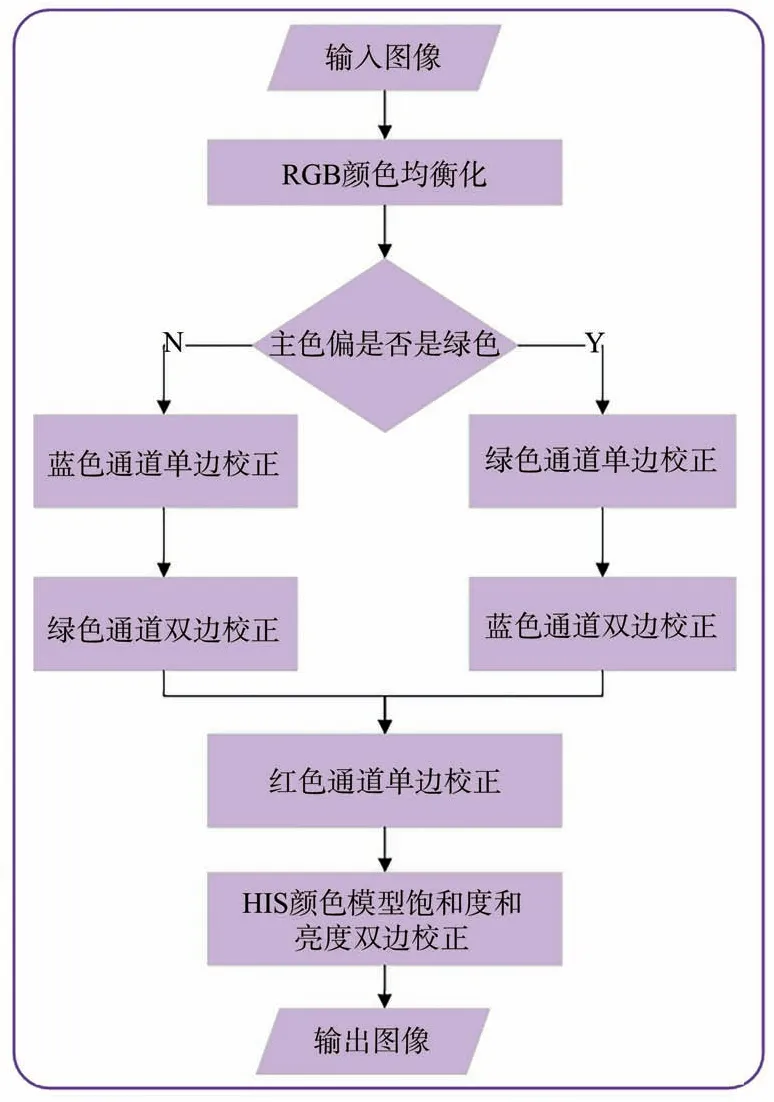

特征融合網絡在RGB 顏色空間中能夠解決紋理細節不足、背景色偏不能還原等問題,但也會伴隨有色彩不均衡、對比度低等問題,因此設計物理增強模塊解決這個問題。首先在RGB 顏色模型中對各顏色通道做顏色均衡化,對各顏色通道的像素在合適范圍調整來增加對比度。由于RGB顏色空間不能直接反應一些重要參數,如飽和度、色調和亮度,因此需要將圖像再轉換到HIS 顏色模型并對這些參數進行校正,以進一步增強圖像的自然表現力。在該模塊中,分別使用RGB 和HIS 顏色模型對各顏色通道、亮度和飽和度在適度的范圍內拉伸以達到增強圖像效果的目的。物理增強模塊的流程圖如圖5 所示。

圖5 物理增強模塊的流程圖Fig.5 Flowchart of the physical enhancement module

輸入圖像后,首先進行RGB 顏色均衡化處理,其次判斷圖像的主色偏是否為綠色。如果為綠色,則進行綠色通道單邊校正和藍色通道雙邊校正,否則進行藍色通道單邊校正和綠色通道雙邊校正,然后對圖像的紅色通道單邊校正,最后在HIS 顏色模型中對飽和度和亮度進行雙邊校正并輸出圖像。

2.4.1 RGB 顏色均衡化

水下圖像的主色偏通常為綠色或者藍色兩類。經過上一步特征融合網絡的處理能夠解決大部分的色偏,可能還會留有輕微色偏問題,這一步可對圖像顏色做均衡化,消除輕微色偏。首先計算圖像在RGB 模型中各個顏色通道中像素最大值Rmax、Gmax和Bmax,三者中值最大就代表該圖像的色偏通道。其計算公式如式(8)所示:

其中:輸入圖像X的尺寸為M×N,i∈(0,M),j∈(0,N),(i,j)為圖像的像素點位置坐標,IR(i,j)、IG(i,j)和IB(i,j)分別代表圖像的紅色通道像素值、綠色通道像素值和藍色通道像素值。

本文以綠色為圖像的主色偏為例詳細描述均衡化計算過程。保持主色偏通道不變,需要調整藍色和紅色通道的像素值使圖像顏色均衡,因此需要計算基于主色偏在其他兩個顏色通道的增益因子。首先計算三顏色通道上像素值的平均值,計算公式如式(9)所示:

其中:IR(i,j)、IG(i,j)和IB(i,j)分別代表圖像在各顏色通道(i,j)位置的像素值,Ravg、Gavg和Bavg表示紅綠藍三顏色通道上像素值的平均值。增益因子是基于3 個像素平均值得到:

其中:a表示紅色通道的增益因子,b表示藍色通道增益因子。新的藍色和綠色通道的像素值由乘數來確定,由公式(11)計算得出:

其中:R和B為原來圖像的紅色和藍色像素值,R*和B*是圖像均衡化后的紅色和藍色像素值。

2.4.2 RGB 顏色模型對比度校正

整體顏色做均衡化能解決輕微色偏問題,圖像的對比度需要進一步增強。這一部分主要是在RGB 顏色模型中采用拉伸強度值范圍的方式校正對比度。

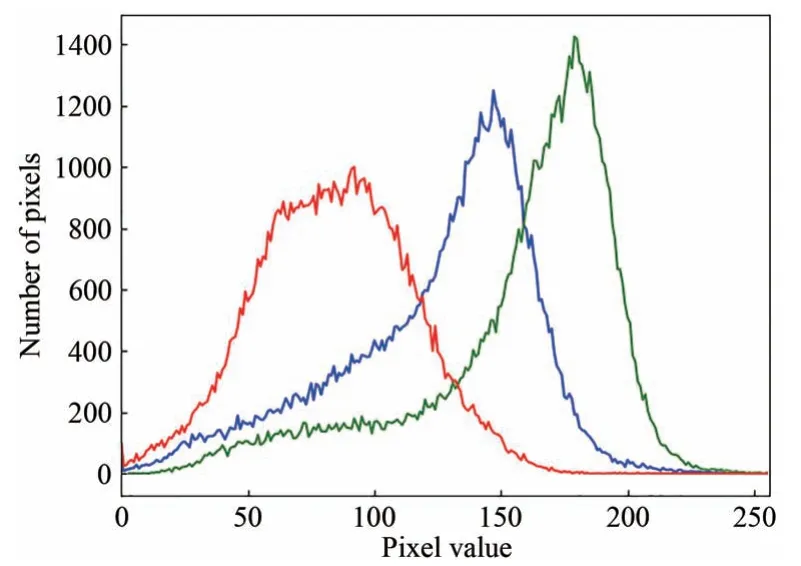

RGB 顏色模型中各顏色通道的像素取值范圍為0~255,統計各個顏色通道的不同像素值出現的次數并畫出像素分布折線圖,如圖6 所示。圖6 中橫坐標表示像素點的像素值,縱坐標表示像素點個數,其中紅色折線代表紅色通道,藍色代表藍色通道,綠色代表綠色通道。

圖6 RGB 像素分布折線圖Fig.6 RGB pixel distribution line diagram

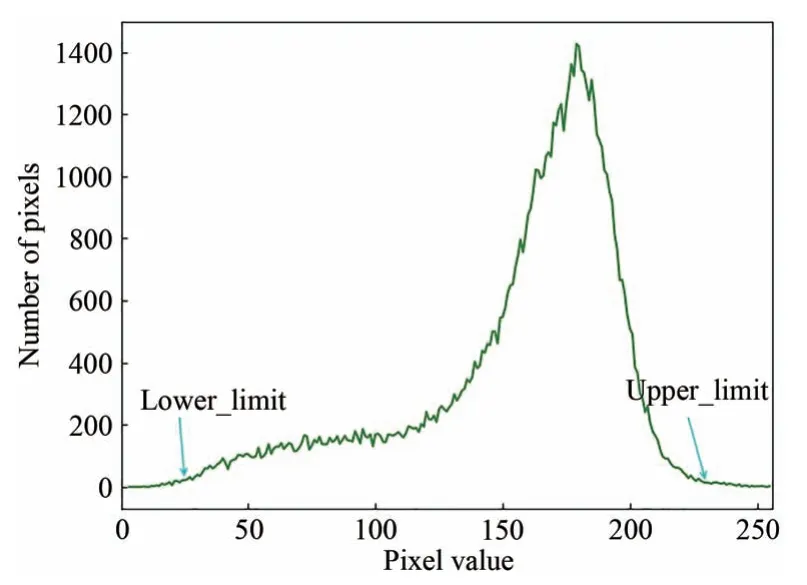

對比度的增強采用拉伸特定范圍內的像素值實現。該方法先確定拉伸后圖像的上下限,通常用歸一化的方式確定折線圖中的最小和最大像素值,將不同通道的像素點按照值從小到大排序,在排序后的兩端分別舍棄總像素點總數的0.2%的像素點,僅保留中間的0.2%~99.8%的像素點。圖7 是綠色通道標有裁剪點像素分布的折線圖。

圖7 綠色通道的像素分布折線圖Fig.7 Pixel distribution line diagram of the green channel

通常過高或者過低的像素值會嚴重影響圖像的質量,導致不具代表性的縮放,因此圖7 中標注lower_limit 箭頭所指左邊的所有點都將被舍棄,upper_limit 右側的點也將舍棄,僅選在0.2%和99.8%范圍內的像素點,并將其應用在校正公式中,對圖像分3 個步驟進行校正。校正公式如式(12)所示:

其中:Po是對比度校正后圖像的像素值;Pi為參考像素值;a表示下限值,其最小為0;b是上限值,其最大為255;c表示當前顏色通道中最小像素值;d表示當前顏色通道中最大像素值。

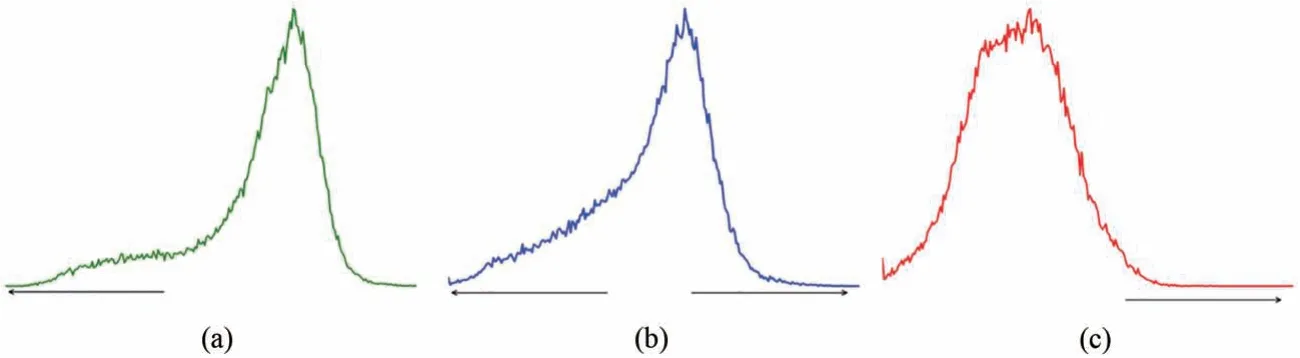

如果顏色均衡化時確定主色偏為綠色,那么第一步進行綠色的單邊校正,第二步進行藍色雙邊校正,第三步進行紅色單邊校正。否則按照藍色單邊校正,綠色雙邊校正,紅色單邊校正的順序校正。以綠色色偏為例,各顏色通道校正方式和方向如圖8 所示。

圖8 各顏色通道像素分布圖。(a)綠色通道像素分布圖;(b)藍色通道像素分布圖;(c)紅色通道像素分布圖。Fig.8 Pixel distribution of each color channel.(a)Green channel pixel distribution map;(b)Blue channel pixel distribution map;(c)Red channel pixel distribution map.

第一步,圖8(a)為綠色通道像素分布圖,校正方式為單邊校正,校正方向是朝向像素值最小側,通過向像素值最小側來解決偏綠問題,校正公式如式(13)所示:

公式(13)與公式(12)對比,b為Gup,Gup代表綠色通道中upper_limit 指向的像素點的像素值,該像素值作為上限。a為0,把0 作為下限。c為Min 表示當前圖像中最小像素值。d為Max,表示當前圖像中最大像素值。

第二步,圖8(b)為藍色通道像素分布圖,校正方式為雙邊校正,朝向像素值最大和最小兩側。校正公式如式(14)所示:

公式(14)與公式(12)對比,b為255,255 作為藍色像素值的上限代表藍色通道的最大像素值。a為0,0 作為藍色像素值的下限。c為Min 表示當前圖像中最小像素值。d為Max,表示當前圖像中最大像素值。

第三步,圖8(c)為紅色通道像素分布圖,校正方式為單邊校正,校正方向是朝向像素值最大側。校正公式如式(15)所示:

該公式與公式(12)對比,b為255,因為要向像素值最大側拉伸,把255 作為上限。a為Rlo,Rlo代表紅色通道中lower_limit 指向的像素點的像素值,該像素值作為下限。c為Min 表示當前圖像中最小像素值。d為Max,表示當前圖像中最大像素值。

2.4.3 HIS 顏色模型

將圖像的RGB 顏色模型轉換為HIS 顏色模型,在HIS 顏色模型中繼續提高圖像的質量。HIS 顏色模型即色調(H)、飽和度(S)和亮度(I),色調是純色成分,飽和度是顏色的純正度,亮度是照明成分[25]。對飽和度和亮度兩個參數用校正公式(12)來獲得新的值,校正方向朝向亮度暗側和亮側兩個方向,這種調整有助于具體的數據分布圖更好地擴展到兩個方向,使其可見度增大且更加清晰。

本文方法在輕量級特征融合網絡部分,因為主體架構與U-NET 網絡相似,所以前5 個局部塊充當的特征提取器的編碼器部分,第6 到第9個局部塊是融合信息重建清晰圖像的解碼器部分。原始水下圖像通過該網絡能夠提升圖像的質量,既能夠解決水下圖像色偏的主要問題,又能夠不破壞圖像空間結構,盡可能多地保留圖像的紋理細節。水下圖像增強不同于高級機器視覺任務,如目標檢測、目標識別等,因此不需要高維度的信息特征,故減少卷積中的通道數能減少特征融合網絡的訓練時間,同時也能降低網絡的復雜性。該網絡把相鄰兩個模塊間的通道設置為16,再加上對特征融合模塊的改進,因此特征融合網絡的參數量進一步地減少,由0.15M 減小到0.03M,約減少了80%。在多顏色模型校正部分,對前一部分的圖像先進行顏色均衡化處理,然后在適度的范圍內拉伸RGB 顏色模型中各個顏色通道和HIS 顏色模型中飽和度和亮度參數,最后得到自然清晰、色彩豐富的無色偏圖像。

3 實驗結果及分析

3.1 實驗環境

所有實驗均使用PyCharm 編譯器,運行在Win10 PC,AMD Ryzen Threadripper 1950X 16-Core Processor 3.40 GHz 處理器,NVIDIA GeForce GTX 1080Ti GPU,使 用Tensorflow1.4 作為深度學習框架。輸入圖像大小為256×256 像素值,優化器選用Adam 優化器,學習速率設為0.01,批量大小設置為5,訓練周期設置為100。

因為現實世界中獲取真實的水下圖像的高質量的參考圖像是困難的,因此Islam 等人[33]提出了真實世界水下圖像及可參考的高質量圖像的數據集EUVP。從該數據集中組合選用3 235 組成對的水下生物圖像,其中一張是具有偏色、低對比度和霧狀效果等問題的水下真實圖像,另一張是可供參考的圖像,該圖像是利用域遷移技術CycleGAN 方法獲得的具有參考意義的低色偏的高質量圖像。本文將3 235 組圖像分成訓練集和A 組測試集。訓練集包含3 150 組圖像,用于本文方法訓練出模型;A 測試集有85 組圖像,用于模型的測試。數據集EUVP 中包含了無參考的真實水下圖像。為了驗證方法的泛化性和有效性,從中隨機選出350 張用作B 組測試數據,測試數據中包含了水下生物和水下環境等內容。

在評價指標方面,水下圖像增強的目的是直觀地改善圖像的顏色,去除色偏,增強對比度,提高整體的視覺效果。根據有無參考圖像,本文采用兩套指標對本文算法進行客觀評價。

A 組測試數據包含可參考的圖像,因此采用全參考圖像質量評估:計算預測圖像和參考圖像各個通道的像素位置的標準均方根誤差檢驗值(NRMSE),NRMSE 的值越小代表兩張圖像在同一像素點的值越接近,即空間細節信息越相似;峰值信噪比(PSNR)是最常用的用于反應圖像是否失真的客觀評價指標,PSNR 的值越大表示圖像的質量越好,失真度越小;結構相似性(SSIM)衡量增強后的圖像和可供參考的圖像在亮度、結構和相似度方面的差異,其值越大代表增強后的圖像與參考圖像越相似。

由于B 組測試集是無參考圖像的水下圖像,采用無參考的水下圖像度量評估:水下彩色圖像質量度量(UCIQE)表示圖像在色度、亮度和飽和度3 方面的平衡程度,其值越大圖像質量越高;信息熵(IE)表示圖像信息豐富程度的度量,信息越豐富的圖像則該值越高;自然圖像質量評價器(NIQE)表示圖像中觀察到的信息是否自然,該值越低代表圖像整體表現更自然。

3.2 消融實驗

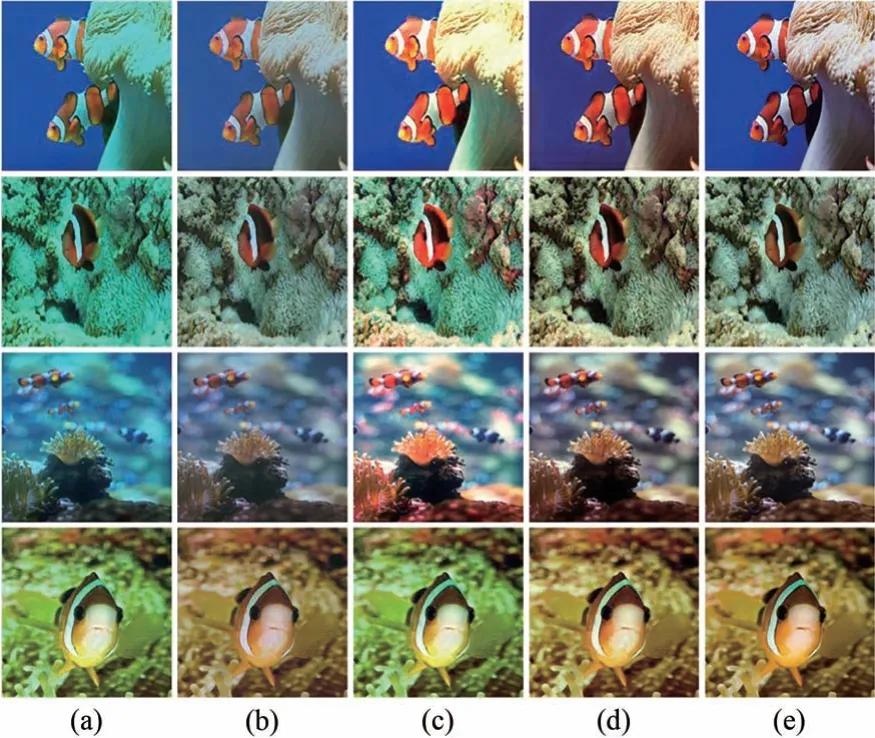

為了驗證所提出方法的可行性和創新性,本文設計了消融實驗來證明:第一個實驗僅使用特征融合網絡增強水下圖像;第二個實驗把原始水下圖像只進行多顏色模型校正方法增強;第三個實驗使用特征融合網絡和多顏色模型校正相結合的方法。3 個實驗均在A 組測試數據上進行,最后對實驗增強后的結果進行定性和定量的分析。實驗結果部分圖像展示如圖9 所示。

圖9 消融實驗定性比較。(a)水下圖像;(b)第一個實驗;(c)第二個實驗;(d)第三個實驗;(e)參考圖像。Fig.9 Qualitative comparison of ablation experiments.(a)Underwater image;(b)First experiment;(c)Second experiment;(d)Third experiment;(e)Reference image.

首先對圖9 的實驗結果做定性分析。第一個實驗的結果顯示,增強后的水下圖像本身存在的色偏問題得到解決,可以消除圖像中大部分區域的色偏,圖像紋理和細節較大程度上得到了保留。但是增強后的圖像存在明顯的模糊感,整體的亮度和對比度表現不佳。第二個實驗的結果顯示,校正后的水下圖像在對比度和亮度方面得到很大的提升,但是對水下圖像存在的色偏問題沒有得到完全解決。第三組實驗的結果顯示,增強后的圖像色偏問題被解決,整體色彩顯示與參考圖像一致;圖像的對比度、飽和度和亮度方面的視覺呈現更好,圖像表現清晰自然,色彩豐富。

定量分析結果如表1 所示。通過數據分析,第3 個實驗在NRMSE 取得的平均值為0.203 6,小于前兩個實驗結果,說明第三個實驗得到的增強圖像和參考圖像在像素位置關系上相似,空間細節信息更接近。PSNR 和SSIM 的均值分別是22.140 7 和0.797 8,數值上都超過前兩個實驗,說明增強后的水下圖像在亮度、結構和相似度方面與參考圖像更相似,細節紋理方面表現得更好。UCIQE、IE 和NIQE 分別取得0.479 1、7.381 9 和13.121 3 的平均值,均優于前兩組實驗,說明本文方法增強后的圖像包含的信息更豐富,圖像質量更高,圖像表現更自然。

表1 消融實驗數據表Tab.1 Ablation experiment data table

無論是主觀分析還是客觀分析,第三個實驗結果要優于前兩個實驗結果,說明本文提出的特征融合網絡和多顏色模型校正相結合的方法是可行的且具有創新性,能夠更好地解決水下圖像出現的嚴重色偏、對比度低等質量問題。

3.3 實驗對比

本文提出的圖像增強方法與現有的水下圖像增強方法做對比分析,對比方法包括基于物理模型的方法(UDCP[12])、基于物理的方法(DBFusion[21])和 基于深度學習的方法(Water-Net[24],Global-Local Net[2],Ucolor[25],LAFFNet[27])。具 體實驗操作如下:首先分別在A 組測試集和B 組測試集中對水下圖像做增強處理,然后將各方法的實驗結果進行定性和定量的分析,最后對各方法的復雜度進行比較。

3.3.1 A 組測試集對比實驗

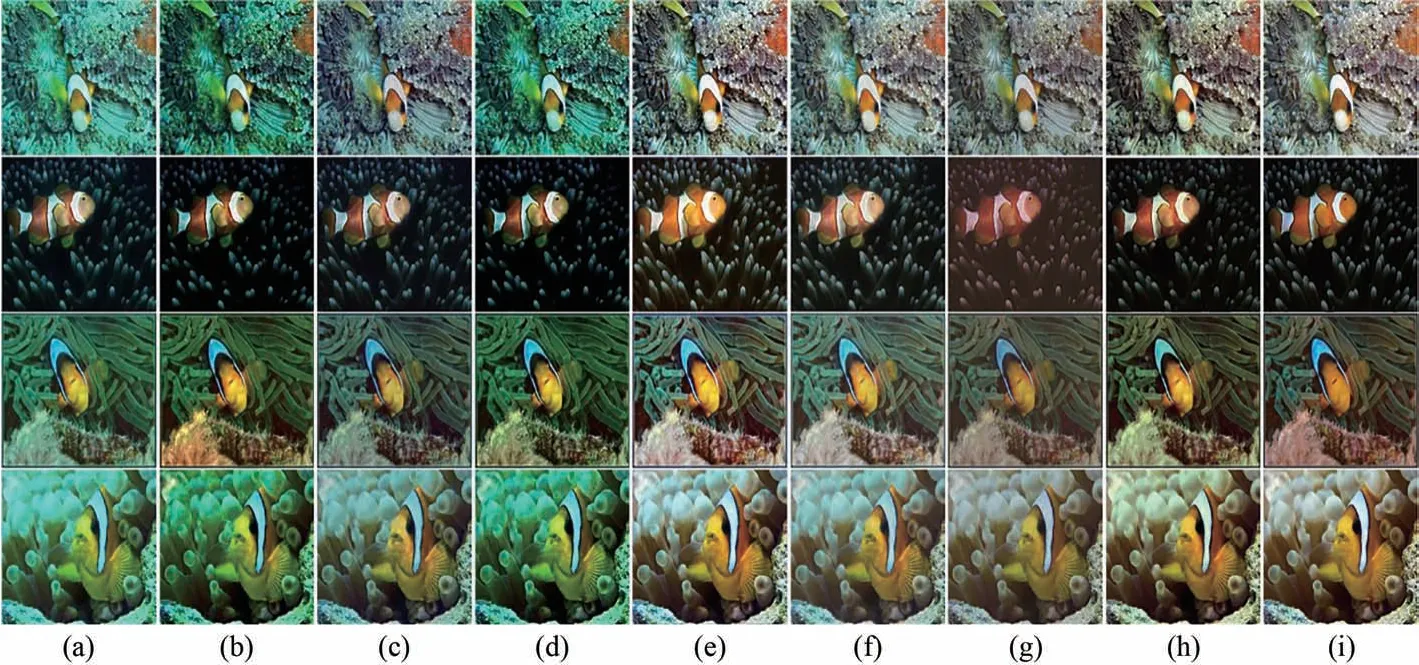

圖10為含有參考圖像的A 組測試集定性分析對比圖,圖10(a)顯示了具有偏色、低對比度、模糊和噪音的水下退化圖像,圖10(b~h)展示了7 種比較方法的增強水下圖像后的效果圖,圖10(i)是提供的高質量的參考圖像。圖10(b)是UDCP增強結果,該方法不能還原圖像,沒有解決最基本的色偏問題,反而加重了綠色色偏,另外整體顏色表現暗淡。圖10(c)是Water-Net 方法增強結果,該方法能夠對水下圖像的色偏進行校正,清晰度有所提升,但是與給出的參考圖像相比,表現出輕微暗色調,亮度和飽和度敏感度低。圖10(d)是DBFusion 方法,其增強結果和UDCP 相似,不僅沒有對色偏進行校正,而且對比度表現得也不佳,整體色彩表現暗淡無光,細節表達欠缺。從Global-Local Net的結果(圖10(e))來看,雖然有效地改善了水下圖像的色偏問題,但是圖像部分區域色調偏白,過度曝光顯得圖像不夠自然。與提供的參考圖像對比,圖像亮度僅在部分區域得到提升。圖10(f)為Ucolor 方法的結果,其能夠有效改善水下圖像的色偏問題,對比度也有所提升,但是亮度方面僅在部分區域提升,與參考圖像相比,整體圖像的色調偏白,增加了圖像的模糊感。圖10(g)為LAFFNet 方法的結果,圖像整體得到了改善,能夠解決基本的色偏問題,但是部分圖像表層出現了類似黃色煙霧,嚴重影響到視覺體驗。圖10(h)為本文提出方法的結果,一方面能夠解決水下圖像色偏問題,整體色調更加接近提供的參考圖像;另一方面整體保持顏色豐富,增強了對比度和亮度,色彩自然豐富,紋理細節清晰,進一步提升了圖像視覺感知,更接近于真實的參考圖像。

圖10 A 組測試集上不同方法的定性比較。(a)水下圖像;(b)UDCP;(c)Water-Net;(d)DBFusion;(e)Global-Local Net;(f)Ucolor;(g)LAFFNet;(h)本文方法;(i)參考圖像。Fig.10 Qualitative comparison of different methods in group A test set.(a)Underwater image;(b)UDCP;(c)Water-Net;(d)DBFusion;(e)Global-Local Net;(f)Ucolor;(g)LAFFNet;(h)Our method;(i)Reference images.

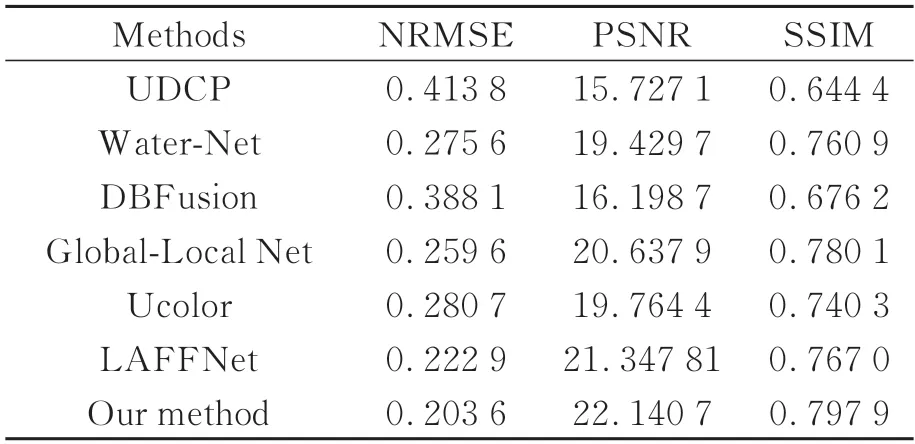

為了客觀分析各個方法在A 組測試集的表現,采用全參考評價指標對增強后的圖像進行定量分析,7 種方法的定量分析結果如表2 所示。從表2 可以看出,本文提出的方法在3 個評價指標的平均值上均優于其他的對比算法,其中NRMSE的平均值為0.203 6,說明本文方法的增強效果在像素級別上接近真實參考的圖像。PSNR 的均值為22.140 9,說明本文方法失真更少,圖像質量更好。SSIM 取得0.797 9,表示輸出圖像在細節和紋理上更接近參考圖像,在圖像結構層面上與參考圖像更相似。3 個指標的表現說明本文提出的方法增強后的圖像質量更好且更接近于參考圖像。

表2 A 組測試集增強圖像的指標對比Tab.2 Index comparison of enhanced images in group A test set

3.3.2 B 組測試集對比實驗

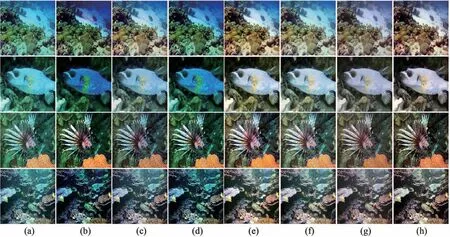

事實上水下獲取到的圖像往往沒有真實的陸地對照圖像,因此為了驗證本文方法的泛化性,在B 組測試集上分別進行主觀分析和客觀分析。7 種對比方法在B 組測試集上的定性對比分析圖如圖11 所示。UDCP(圖11(b))和DBFusion(圖11(d))不僅不能對圖像做到最基礎的色偏校正,還進一步加深了綠色色偏,出現了暗色的偽影,對比度和亮度方面不如原始的水下圖像。在UDCP圖像集中,部分圖像還出現局部泛紅和顏色失真等情況,DBFusion 方法的表現好于UDCP。Water-Net(圖11(c))和Ucolor(圖11(f))能夠很好地對基礎色偏進行校正,但是校正的力度不夠,部分區域還會有色偏,近景表現正常,遠景會出現色偏,在亮度和對比度方面表現出色,Ucolor 方法表現要優于Water-Net方法。Global-Local Net(圖11(e))和LAFFNet(圖11(g))這兩種方法能夠解決基本的色偏問題,但是圖像中在遠景部分還是會有綠色的色偏。Global-Local Net 局部區域亮度過亮,因此圖像亮度不夠柔和,自然表現有些欠缺。LAFFNet 結果在亮度和對比度上有很好的改進,但是在圖像表層出現了霧狀噪音,表現為圖像模糊不清晰。與其他方法相比,本文方法無論是在遠景還是近景部分都能解決色偏,在圖像亮度、對比度和飽和度方面均優于前6 種方法,圖像由遠到近顏色均衡自然,圖像中近處生物和環境細節紋理清晰,圖像全局對比度高,自然真實,視覺感知效果更好。

圖11 B 組測試集的不同方法的定性比較。(a)水下圖像;(b)UDCP;(c)Water-Net;(d)DBFusion;(e)Global-Local Net;(f)Ucolor;(g)LAFFNet;(h)本文方法。Fig.11 Qualitative comparison of different methods for group B test set.(a)Underwater image;(b)UDCP;(c)Water-Net;(d)DBFusion ;(e)Global-Local Net ;(f)Ucolor ;(g)LAFFNet;(h)Our method.

對沒有參考圖像的B 組測試集數據,我們采用無參考的水下圖像質量評價指標UCIQE、IE 和NIQE,7 種方法在各評價指標上的平均得分如表3 所示。UCIQE 取得高于其他方法的平均分值0.584 3,表明色度、亮度和飽和度3 個指標較平衡,圖像質量更高。IE 平均值7.485 3 表明圖像信息豐富度高,在細節紋理上表現更好、更清晰。NIQE 得分31.494 6 低于其他對比方法,說明圖像中的信息更加自然真實。

表3 B 組測試集增強圖像的指標對比Tab.3 Index comparison of enhanced images in group B test set

3.3.3 各方法復雜度的比較

深度學習算法用參數數量(Parameters)和浮點運算 數(Floating point operations,FLOPs)指標來衡量其復雜度。參數數量用來形容模型大小程度,模型中包含的參數的總數量越多說明模型越大,單位為M(106)。FLOPs也是理論計算量,用于衡量算法的運算速度,該值越小說明模型的運算速度越快,單位為G(109)。由于UDCP 和DBFusion 方法不屬于深度學習,無法計算其指標,最后得到其他算法的參數數量和FLOPs 如表4 所示。由表4 可知,本文提出的算法在參數數量和浮點運算數指標上僅次于Global-Local Net算法,與改進前的LAFFNet 算法相比,參數數量由0.15M 減少到0.03M(減少約80%),浮點運算數由9.77G 減少到5.95G(減少約39%)。說明本文算法得到的模型在參數量方面更小,運算速度有一定的提升,滿足在低配置設備部署的要求。

表4 各方法復雜度的比較Tab.4 Comparison of the complexity of each method

4 結 論

針對低質量(存在嚴重色偏、能見度低和低對比度等問題)的水下圖像,本文提出一種輕量級特征融合網絡與多顏色模型校正相結合的水下圖像增強方法。該方法屬于模塊化設計,使用自構建模塊可減少代碼的冗余,提高其可閱讀性,提升網絡的性能。改進的特征融合模塊減少了全連接層帶來的圖像空間結構的破壞,而且能在不降低圖像特征信息提取能力的前提下減少模塊的參數量,減輕多層網絡的訓練難度。增加的改進的注意力模型對水下圖像既能提取特征紋理又能保住背景信息。物理增強模塊能在多顏色模型中對各顏色通道、亮度和對比度的值在合適的范圍內進行校正,進一步減少色偏,增強對比度和亮度,使圖像自然真實。本文方法為輕量級水下圖像增強方法,一方面改進的特征融合模塊能夠減少參數量,另一方面模塊間通道數降低為16,使本文方法的參數量從0.15M 下降到0.03M(降低約80%),有效提升訓練速度。實驗結果表明,同最新的圖像增強方法對比,在有參考圖像數據集上,NRMSE、PSNR 和SSIM 評價指標的平均值分別是0.203 6、22.140 7和0.797 9,比第二名對比算法提升了9.3%、3.7%和2.3%。在無參考圖像的數據集上,UCIQE、IE 和NIQE 評價指標的平均值分別是0.584 3、7.485 3 和31.494 6,比第二名對比算法提升了6%、2.9%和4.5%。本文提出的方法可以有效校正色偏,同時提升亮度、飽和度和對比度,使增強后的圖像色彩更自然豐富。