基于特征協同交互網絡的商品點擊率預測

鄒雨菲 楊欣 胡陳陳

摘? 要:隨著用戶行為數據和商品數據呈指數級增長,互聯網平臺面臨嚴重的信息過載問題。可以在推薦算法中引入點擊率預測模型,有效提升用戶的購物體驗。將特征協同交互網絡(Co-Action Network, CAN)與深度興趣演化模型(Deep Interest Network, DIN)相融合,挖掘用戶與商品的深層次關系,模擬真實場景下用戶與商品的交互情況,得到商品點擊率預估模型CAN-DIN。在公開數據集Amazon-beauty上的實驗表明,與相關基模型相比,CAN-DIN算法的準確率有一定的提升,可以應用于電商推薦場景。

關鍵詞:特征交互;點擊率預估;深度神經網絡

中圖分類號:TP391.3? 文獻標識碼:A? 文章編號:2096-4706(2023)19-0145-06

Product Click-through Rate Prediction Based on Co-Action Network

ZOU Yufei, YANG Xin, HU Chenchen

(Lanzhou Jiaotong University, Lanzhou 730070,China)

Abstract: With the exponential growth of user behavior data and goods data, internet platforms are facing serious information overload issues. A click-through rate prediction model can be introduced into recommendation algorithms to effectively improve users' shopping experience. By integrating the Co-Action Network (CAN) with the Deep Interest Network (DIN), explore the deep relationships between users and goods, simulate the interaction between users and goods in real scenarios, and obtain the goods click-through rate prediction model CAN-DIN. Experiments on the publicly available dataset Amazon-beauty have shown that the CAN-DIN algorithm has a certain improvement in accuracy compared to relevant base models and can be applied to E-commerce recommendation scenarios.

Keywords: feature interaction; click-through rate estimation; deep neural network

0? 引? 言

點擊率預測模型廣泛應用于推薦系統中,為用戶推薦符合其興趣和需求的商品或服務。采用基于機器學習、深度學習的算法,通過學習用戶歷史行為、偏好和隱式反饋數據,預測用戶對尚未看到商品或服務的興趣程度,并將推薦結果按照吸引用戶的程度大小進行降序排列。通過對不同推薦結果進行不同權重的排序,提高滿足用戶需求推薦結果的展示率,對于提升電商平臺的客戶滿意度和企業盈利能力具有重要意義。

點擊率預測模型的一個核心問題是如何更好地學習用戶和表示商品[1]。推薦技術從遞歸神經網絡[2]、注意力機制[3]發展到圖神經網絡,這些技術通常根據用戶的歷史反饋為用戶推薦物品。

因式分解機(FM)[4]是淺層模型時代的代表性方法。在FM中,特征的交互被建模為特征潛在向量的內積。FM在不同類型的相互作用下,使用相同的潛向量。DeepFM[5]不再需要手動構建笛卡爾積特征。PNN模型[6]提出一種Product Layer的思想,以捕捉特征的互動以及鄰域間的互動。DCN模型[7]中的Cross網絡是FM過程在高階特征組合的推廣,Cross部分在增強高階特征組合的同時減少了參數的個數,并省去了非線性激活函數。ONN模型[8]通過一些不同的操作來學習特征間互動。盡管上述方法與普通DNN相比性能上有所提高,但每個ID的嵌入都承擔了表示學習和交互建模的責任。同時,它們之間的相互干擾可能損害各自的性能。

本文將特征協同交互網絡(Co-Action Network, CAN)[9]與深度興趣演化模型(Deep Interest Network, DIN)[10]相結合,得到融合特征協同網絡的深度興趣演化模型(CAN-DIN)。通過實驗對比分析,找到最優的模型和參數組合,實現了提升推薦準確率的目的。

1? 算法概述與模型建立

1.1? 算法概述

1.1.1? DIN算法

DIN模型是推薦算法中的一種深度興趣網絡模型,它通過引入注意力機制來捕捉用戶對某個商品的歷史行為的興趣,并隨著候選商品的變化而變化,從而有效提升模型的表達能力。

1)輸入層。輸入x:K維高維稀疏二值型向量通常是由多個group特征拼接而成的。假設有M個group,每個group特征ti的維度為Ki,ti每個元素取值為0或1,i的個數大于等于1。

2)模型設計。相比于DNN,DIN引入了local activation unit,用以學習用戶興趣和當前候選商品的關聯程度。在DNN中,假設ti有k個元素值為1,則需要將這k個元素對應的k個embedding特征進行pooling,使得不同樣本之間group拼接完的特征長度是一致的,即:

其中,E(s)和Var(s)分別表示每個mini-batch中激活函數輸入的均值和方差。

1.1.2? CAN算法

特征協同交互網絡(Co-Action Network, CAN)是一種新的特征交互方法,主要是利用共現網絡來學習物品和用戶之間的特征關聯,并將其應用于個性化推薦和CTR預測。

CAN通過采用協同作用單元(Co-Action Unit)和多階增強等技術,有效處理用戶和物品特征的拼接和互動,提升模型的非線性擬合能力和表達能力。

1)架構概述。用戶和目標物品的特征U和M以兩種方式輸入CAN。在第一種方式下,它們使用的embedding編碼為稠密向量{E(u1),L,E(u1)}和{E(m1),L,E(mJ)},進一步拼接為eitem和euser。在第二種方式下,從U和M中選擇一個子集Ufeed和Minduction,使用co-action unit來建模特征交互 ,mj ∈ Minduction。CAN的計算式為:

其中, 表示矩陣乘法,σ表示激活函數,H表示具有向量輸入的共同作用單元。對于像用戶歷史行為? 這樣的順序特征,共同作用單元應用于每個點擊行為,然后對序列進行求和池化:

Pinduction從商品特征中獲取信息,而Pfeed從用戶特征中獲取信息,Pfeed也可作為micro-MLP的參數,反之亦然。

3)多階增強。上述特征是基于一階特征形成的,特征的交互可以通過高階來估計。雖然共同作用單元可以隱式地學習高階特征交互,但考慮到特征交互的稀疏性,學習過程可能會更加困難。為此,在模型中引入多階信息,以獲得多項式輸入。其通過將micro-MLP應用于不同階數的Pfeed來實現:

其中,C表示階數。利用Tanh函數來避免高階項引起的數值問題。多次元增強大大提升了模型的非線性擬合能力,并且不會帶來額外的計算和存儲成本。

4)多層次的獨立性。學習的獨立性是交互建模特征的主要特征之一。為了保證學習的獨立性,模型從不同方面提出了策略。第一,參數獨立。通過將表示學習和特征交互建模的更新分離開來,使得參數獨立性是CAN的基礎。第二,組合獨立。隨著特征組合數量的增加,特征間的相互作用呈線性增長。該方法使模型的表達能力呈指數級放大。特征交互的組合應滿足:

1.2? 模型建立

CAN-DIN模型是將co-action模塊輸出的向量和DIN模塊輸出的向量以及其他特征通過embedding層,轉化為稠密向量的特征拼接,再通過3層MLP獲取目標item的CTR預測值。對于Pinduction,使用兩層MLP,輸入/輸出維度設置為16/8和8/4,Pfeed的最高階數為3。模型參數以高斯分布(平均值為0,標準差為0.01)初始化。模型訓練的優化器為Adam,batch_size設置為128,初始學習率設置為0.002,每個epoch學習率折半。co-action模塊輸出的向量和其他特征通過embedding層轉得到的稠密向量進行拼接后通過3層MLP獲取目標item的CTR預測值。三層MLP的神經元大小分別設置為200、80、1。模型訓練過程中,使用Logloss計算損失,為避免梯度爆炸和梯度消失現象的發生,約束模型輸出y值的取值范圍設置為[1×10-10,1.0]。

2? 實驗驗證

2.1? 數據集

本文選用公開數據集Amazon Review Data的Luxury Beauty子類(簡稱Amazon-beauty)。當一個用戶對某個物品進行評價時,我們將其認定為正樣本,并從當前物品列表中隨機選擇一個其他商品作為負樣本,然后將它與當前評價的正樣本一起寫入文件中,并創建相應的用戶行為序列。對于有兩次以上點擊行為的用戶,選擇其最后一次點擊存入測試集,其余存入訓練集;對于只有一次點擊行為的用戶默認存入訓練集。將訓練集內數據按照9:1隨機劃分成模型訓練集和驗證集,并對訓練集和驗證集數據進行隨機打散。將數據集劃分為訓練集、驗證集、測試集的數據量如表1所示。

深度神經網絡模型在擬合高階復雜特征時有不錯的表現。因此,深度學習模型的輸入數據不需要過于復雜。本文的研究重點是提取和挖掘用戶的歷史行為特征,從用戶行為歷史信息和物品特征等角度考慮,篩選部分缺失率相對較低的特征輸入模型。輸入數據各字段說明如表2所示。

2.2? 評價指標

本文選用AUC、ACC、Logloss三種常用評價標準對CTR排序模型進行評估[11]。

分類準確度是評價推薦算法在分類商品方面準確度的重要指標[12],根據用戶對商品的喜好與否和商品是否被推薦,商品分類情況如表3所示。

AUC(Area Under the Curve)代表ROC(Receiver Operating Characteristic)曲線下的面積,表示預測的正樣本在負樣本之前的概率。AUC的值不受正負樣本比例的影響,能夠有效評價各種二分類任務的模型。AUC取值的范圍通常在0.5到1之間,AUC越高表示模型性能越好。AUC的計算式為:

(18)

其中, 表示正樣本預測概率大于負樣本預測概率的個數,positiveNum表示正樣本數,negativeNum表示負樣本數。

推薦結果的準確率(Accuracy, ACC)表示模型預測準確性的比例。ACC值越高,表示模型預測的準確率越高,模型效果越好。ACC的計算式為:

(19)

其中,TP、FP、TN、FN的含義如表3所示。

對數似然損失Logloss(Log-likelihood Loss, Logloss)也被稱為交叉熵損失。Logloss反映了預測結果的平均偏差,體現模型的分類能力,通常用于評估分類器性能的優劣。Logloss越低說明模型性能越好。Logloss的計算式為:

(20)

其中,yj表示商品j的真實標簽值, 表示商品j的預測值。

2.3? 實驗結果分析

2.3.1? 與經典模型對比實驗

本實驗的操作系統為Windows 11,編程語言為Python 3.7.16,深度學習框架為TensorFlow-gpu 2.6,GPU加速庫為CUDA 11.8。

為評價模型在預測方面的準確性,將融合特征交互的深度神經網絡模型與現有效果較好的CTR預測模型(包括經典的FM模型和DNN模型,以及DIN模型)進行對比。

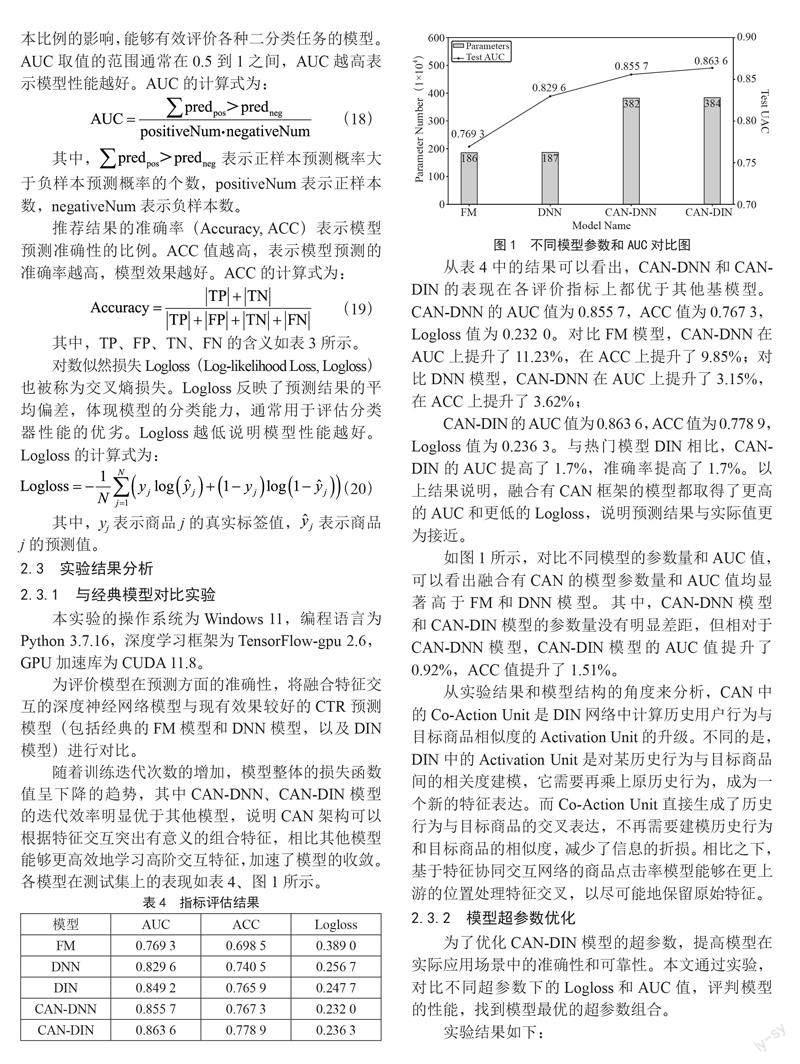

隨著訓練迭代次數的增加,模型整體的損失函數值呈下降的趨勢,其中CAN-DNN、CAN-DIN模型的迭代效率明顯優于其他模型,說明CAN架構可以根據特征交互突出有意義的組合特征,相比其他模型能夠更高效地學習高階交互特征,加速了模型的收斂。各模型在測試集上的表現如表4、圖1所示。

從表4中的結果可以看出,CAN-DNN和CAN-DIN的表現在各評價指標上都優于其他基模型。CAN-DNN的AUC值為0.855 7,ACC值為0.767 3,Logloss值為0.232 0。對比FM模型,CAN-DNN在AUC上提升了11.23%,在ACC上提升了9.85%;對比DNN模型,CAN-DNN在AUC上提升了3.15%,在ACC上提升了3.62%;

CAN-DIN的AUC值為0.863 6,ACC值為0.778 9,Logloss值為0.236 3。與熱門模型DIN相比,CAN-DIN的AUC提高了1.7%,準確率提高了1.7%。以上結果說明,融合有CAN框架的模型都取得了更高的AUC和更低的Logloss,說明預測結果與實際值更為接近。

如圖1所示,對比不同模型的參數量和AUC值,可以看出融合有CAN的模型參數量和AUC值均顯著高于FM和DNN模型。其中,CAN-DNN模型和CAN-DIN模型的參數量沒有明顯差距,但相對于CAN-DNN模型,CAN-DIN模型的AUC值提升了0.92%,ACC值提升了1.51%。

從實驗結果和模型結構的角度來分析,CAN中的Co-Action Unit是DIN網絡中計算歷史用戶行為與目標商品相似度的Activation Unit的升級。不同的是,DIN中的Activation Unit是對某歷史行為與目標商品間的相關度建模,它需要再乘上原歷史行為,成為一個新的特征表達。而Co-Action Unit直接生成了歷史行為與目標商品的交叉表達,不再需要建模歷史行為和目標商品的相似度,減少了信息的折損。相比之下,基于特征協同交互網絡的商品點擊率模型能夠在更上游的位置處理特征交叉,以盡可能地保留原始特征。

2.3.2? 模型超參數優化

為了優化CAN-DIN模型的超參數,提高模型在實際應用場景中的準確性和可靠性。本文通過實驗,對比不同超參數下的Logloss和AUC值,評判模型的性能,找到模型最優的超參數組合。

實驗結果如下:

1)Embedding維度。在表5中,當Embedding向量的維度從8開始增加時,模型的AUC值逐漸增大,這表明Embedding向量中蘊含了更多的特征信息,從而使得模型能夠更好地學習到輸入數據的特征表示。但是,當Embedding向量的維度增加到12之后,模型的AUC值逐漸下降,這是因為Embedding向量的表達能力也是十分有限的,維度增加到一定程度后就無法繼續提高模型的性能。這種情況也稱為維度災難,當Embedding向量的維度過高時,模型需要學習的參數數量會急劇增加,從而導致模型過于復雜,難以訓練,并且容易過擬合。因此,通過本次實驗,確定Embedding向量的最佳維度為12,此時模型性能最佳。

2)激活函數。在表6中,當使用Tanh作為激活函數時,模型的預測效果明顯優于使用Sigmoid和ReLU激活函數的預測效果。這是因為Tanh函數在0附近的導數值更大,因此在輸入數據絕對值較小的區域,Tanh函數能夠更快地將輸入映射到輸出,從而加快了模型的收斂速度。與Sigmiod函數相比,Tanh函數的輸出范圍更廣,包含從-1—1區間,因此可以更好地保留輸入數據的范圍信息,減少了信息損失。與ReLU函數相比,Tanh函數在輸入數據為負數時能夠提供非零的輸出,這樣能夠更好地處理輸入數據中存在的負值信息,使模型具有更好的表達能力。

3)優化器。在表7中,使用Adam優化器時,模型的AUC最大,其次是Momentum和Adagrad。Adam優化器是一種基于梯度的優化器,借鑒了動量和自適應學習率的思想。在Adam優化器中,動量項可以幫助優化器更快地逃離局部最優解,自適應學習率可以使優化器在不同參數和數據的情況下自適應地調整學習率,從而更好地控制參數更新的步長。因此,Adam優化器通常能夠更快地收斂,并在較短的時間內達到較高的精度。Momentum和Adagrad優化器也是常用的優化器之一。但Momentum可能會引入振蕩,即當優化器在梯度方向上來回擺動時,參數更新的幅度可能會變得非常大,導致訓練過程不夠穩定。Adagrad在訓練過程中,學習率會不斷衰減,并可能會逐漸趨于零。這意味著隨著訓練的推進,Adagrad優化器可能會疏忽一些重要的參數變化信息,從而導致訓練結果不佳。

4)學習率。如表8所示,隨著學習率的不斷減小,模型的預測效果越來越好,學習率為0.000 2時,達到峰值,當學習率繼續減小時,模型的預測效果反而下降。這是因為模型參數更新的步長變小,模型能夠更準確地探索最優值附近的區域。但學習率過小時,模型的參數更新步長變得非常小,導致模型在最優值附近振蕩,很難再進一步優化模型的性能。此時,模型可能會停滯在一個局部最優解中,而無法找到全局最優解。

通過以上實驗,最終確定CAN-DIN模型的emdedding維度為12,激活函數為Tanh,優化器為Adam,學習率為0.000 2。最終,CAN-DIN在Amazon-beauty數據集上的AUC值為0.869 9,accuracy值為0.782 2。

3? 結? 論

綜上所述,融合特征交互的深度神經網絡模型因其融合了Co-Action Unit結構,將通過點積獲得的標量交叉特征轉換為向量形式,同時通過確保參數獨立性避免了單特征嵌入訓練對交叉特征性能的負面影響。使得其在原有結構的基礎上將不同特征送入新設計的算子得到特征交互的表達向量,再額外送入全連接層中作為信息補充。因此在與其他模型的對比實驗中,能夠擁有更快的收斂速度和更高的精度。此外,相比于與DNN的融合,將CAN與DIN融合能夠在保證參數量沒有明顯增加的情況下獲得更高的AUC值。實驗結果表明,基于特征協同交互網絡的商品點擊率預測模型CAN-DIN能夠應用在推薦算法中,可以有效提升推薦的準確性。

參考文獻:

[1] HU L M,XU S Y,LI C,et al. Graph neural news recommendation with unsupervised preference disentanglement [C]//Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics. [S.l.]:Association for Computational Linguistics,2020:4255-4264.

[2] OKURA S,TAGAMI Y,ONO S,et al. Embedding-based news recommendation for millions of users [C]//Proceedings of the 23rd ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. HalifaxNS:ACM,2017:1933-1942.

[3] ZHU Q N,ZHOU X F,SONG Z L,et al. Dan: Deep attention neural network for news recommendation [C]//Proceedings of the AAAI Conference on Artificial Intelligence. [S.l.]:Open Journal Systems,2019:5973-5980.

[4] RENDLE S. Factorization machines [C]//2010 IEEE International Conference on Data Mining. Sydney:IEEE,2010:995-1000.

[5] GUO H F,TANG R M,YE Y M,et al. DeepFM: a factorization-machine based neural network for CTR prediction [C]//Proceedings of the 26th International Joint Conference on Artificial Intelligence. [S.l.]:AAAI Press,2017:1725-1731.

[6] QU Y R,CAI H,REN K,et al. Product-based neural networks for user response prediction [C]//2016 IEEE 16th International Conference on Data Mining (ICDM).Barcelona:IEEE,2016:1149-1154.

[7] WANG R X,FU B,FU G,et al. Deep & cross network for ad click predictions [J/OL].arXiv:1708.05123v1.[2023-02-16].https://arxiv.org/abs/1708.05123.

[8] YANG Y,XU B L,SHEN S F,et al. Operation-aware neural networks for user response prediction [J]. Neural Networks,2020,121:161-168.

[9] BIAN W J,WU K L,Ren L J,et al. CAN: feature co-action network for click-through rate prediction [C]//Proceedings of the fifteenth ACM international conference on Web Search and Data Mining. New York:ACM,2022:57-65.

[10] ZHOU G R,SONG C R,ZHU X Q,et al. Deep interest network for click-through rate prediction [R/OL].arXiv:1706.06978v3.[2023-02-06].https://arxiv.org/abs/1706.06978v3.

[11] 陳一洲.基于注意力機制的用戶點擊率預測方法研究[D].上海:東華大學,2022.

[12] 朱彤.基于多種策略的商品推薦系統研究與實現[D].咸陽:西北農林科技大學,2022.

作者簡介:鄒雨菲(1997—),女,漢族,湖北荊州人,碩士研究生在讀,研究方向:深度學習;楊欣(1997—),女,漢族,甘肅天水人,碩士研究生,研究方向:經濟統計;胡陳陳(1997—),女,漢族,山東濟寧人,碩士研究生在讀,研究方向:機器學習。

收稿日期:2023-04-10