基于語義分割深度學習的地基云圖分割方法

王敏, 李晟, 莊志豪, 王康, 孫碩, 吳佳

(南京信息工程大學電子與信息工程學院, 南京 210044)

云是大氣中的水汽經過凝結作用而形成的多形態可見聚合物[1],其組成的云層覆蓋了大部分地球表面[2]。云作為重要的氣象要素,在即時天氣預報、即時降水預測、人工增雨、云層覆蓋預測、輻照度預測、航空管制、衛星地空通信優化[3-4]等諸多方面得到廣泛的研究和應用。云圖是分析云相關信息的主要工具,主要包括衛星遙感云圖和地基云圖[5]。衛星遙感云圖缺乏詳細的地面信息[6]。利用地基云圖的高時空間分辨率,可準確地獲取局部的云條件[7-9]。

云圖分割是獲取云的諸多參數的基礎,但由于云的邊界模糊、紋理復雜,傳統圖像分割算法已不能適用于地基云圖的分割領域[10]。傳統的云圖分割方法主要是基于閾值分割技術[11-15]、神經網絡模型[16-17]以及更復雜的方法,包括馬爾科夫隨機場模型[18]、高斯混合模型[19]和歸一化切割法[20]。Long等[21]提出一種固定閾值算法,根據RGB顏色空間中R和B通道閾值的強弱來提取云區域。Heinle等[22]在前者基礎上添加使用紅藍通道的差值提取云圖的紋理特征,并使用K最近鄰法(Knearest neighbors,KNN)算法實現云圖的分割。類似地有自適應閾值方法和超像素分割方法被Liu等[23]應用于云圖分割。Taravat等[24]拓展了支持向量機(support vector machines,SVM)和神經網絡等機器學習算法在云圖分割領域的應用。孫勁光等[25]提出一種改進近鄰傳播的聚類的圖像分割算法。但是基于閾值的分割算法很少利用到空間信息,且嚴重依賴于天氣條件、光譜特征等因素,性能會在源域和目標域之間存在大量的誤分割。機器學習算法則對參數的選取較為敏感,自適應能力差,針對上述問題和限制有必要開發一種穩定準確、魯棒性強、泛化能力強的自適應地基云圖分割算法。

語義分割作為計算機視覺的基本任務之一[26-27],其可以預測圖像以生成相應的掩碼,但由于缺乏大規模的地基云圖云注釋數據,僅少數方法是基于地基云圖數據集,所以值得進行深入研究以探索模型的云分割性能。卷積神經網絡(convolutional neural network,CNN)應用于云圖分析任務中取得了突破性進展,這得益于在云特征表示和高級云特征提取方面的強大能力[28-30]。

現先總結介紹國內外現有的標簽置信度高標準地基云圖數據集,接著闡述最近的基于語義分割模型的地基云圖分割研究進展和效果,介紹基礎理論并選取八種典型的語義分割模型分析的分割效果,再在云圖數據集上驗證模型的泛化能力和魯棒性,最后對地基云圖像素級自適應分割技術的研究做出總結和展望。

1 地基云圖分割數據集

標準的地基云圖分割數據集是后續云天分割等云信息獲取的重要基礎。數據集的質量將直接影響云圖分割模型的性能,研究人員需要挑選出噪聲干擾項因素較小、云特征信息明顯的云圖,對云天進行精準的標注,此外為提高云圖數據樣本的置信度,需要專業氣象專家對相似度極高、云體邊緣不明顯、云天交融問題等云圖進行標注。考慮到標準大規模分割數據集的制作成本較高,耗時長,研究學者們一直使用小樣本數據集進行地基云圖分割和識別研究,除了數據擴充等技術外,學者依托深度學習技術來制作數據集,先將捕獲到的云圖數據使用預訓練模型進行分割,再將云圖顏色通道分量進行閾值分割,再將二者圖像矩陣進行將與操作,最后對將與后的結果圖進行人工校準和標注。如圖1所示,展示SWIMSEG數據集部分樣圖。

(1)BENCHMARK數據集。BENCHMARK數據集是UTILITY數據集的子集[31],從其中選取32幅包含有積云、卷云和層云不同形式的云圖,再使用Voronoi多邊形區域生成器生成二值掩膜圖像做真值(ground truth,GT)圖像。但由于該數據集的云圖樣本數據量有限,因此在使用深度學習技術時可能會導致過擬合問題。

(2)SWIMSEG數據集。SWIMSEG數據集全稱是新加坡全天圖像分割數據集,由Dev等[32]部署在新加坡南洋理工大學的天空成像系統WAHRSIS獲得云圖像。該數據集中的云掩碼相當高的準確性。其具有統一性和組織性,但對于薄云等區域存在標簽精準度不足的問題。

(3)WSISEG數據集。WSISEG數據集全稱是全天空圖像分割數據集,由Fa等[33]提出的半球天空圖像數據集。該數據集包括有各種云層覆蓋、全天時間以及太陽的方位角和仰角,因此其反映了完整的全天條件。

(4)CCSN數據集。CCSN數據集全稱為卷云積云層云雨云數據集,由中國學者Zhang等[34-35]所構建,其數據量為SWIMCAT數據集[36]的3倍,其最大特點就是將尾跡云[37]納入該數據集中,但是該數據集沒有相應的云掩碼標簽。

其余的公共數據集還有HYTA數據集,全稱為混合閾值算法數據集[31],新加坡南洋理工大學陸續發布了SWINSEG[38]、SWINySEG[39]、SHWIMSEG[40]等高質量數據集,中國學者Zhou等[41]針對云圖數據量小標簽不足等問題所制作的CBCS數據集,Zhang等[42-43]制作了TJNU云探測數據集TCDD和TJNU大規模云探測數據集TLCDD,如表1所示,羅列了各類地基云圖數據集基本信息,都為研究語義分割網絡在地基云圖分割技術方面奠定了有力的基礎。

2 語義分割模型在地基云圖分割研究回顧

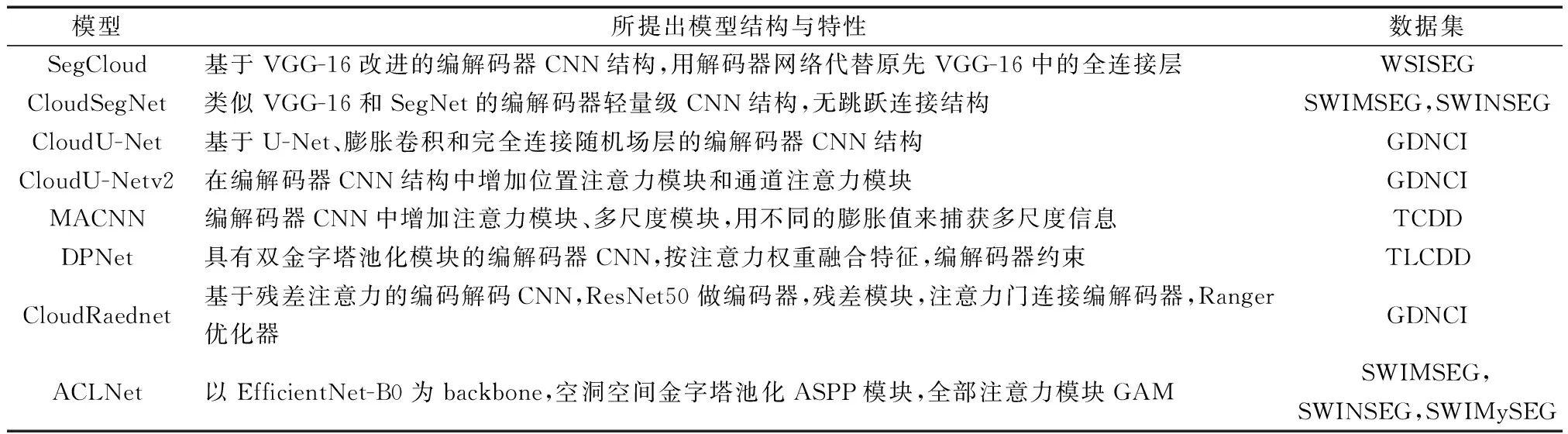

深度學習技術因AlexNet[44]在大規模圖像識別大賽上的杰出表現而備受關注,在云探測領域中使用基于深度學習云圖分割方法可以使計算機自動提取云特征和分割云圖中云的部分[45],學者們不斷拓新提出更多新模型范式。毋立方等[46]提出了一種基于超像素分析聚類的全卷積網絡(fully convolutional networks,FCN)和卷積神經網絡聯合的FCN-CNN云圖分割方法,該方法的局限性在于無法對云圖分割實現端到端的訓練,需要預先對云圖進行聚類。沈慧想等[47]提出了一種基于對稱式密集連接CNN模型的地基云圖分割方法,特點是通過密集連接塊和上采樣模塊并聯融合淺層和深層特征,最終實現對地面云圖像的精準分割。該方法存在模型參數量較大,嚴重影響了訓練速度的問題。Dev等[48]基于Encoder-Decoder模型設計一種名為CloudSegNet的輕量級深度學習模型,云圖分割準確率達到94%,可以有效解決薄云出現從而導致標簽錯誤的問題,并史無前例地實現了白天和夜間的云圖分割。Xie等[49]提出了SegCloud模型,該模型在400幅帶有手動標記標簽的全天圖像上訓練,實現了云圖像的有效且精準的分割,該模型通過計算云圖像中云像素占所有像素的百分比,提供了可靠的云量信息。在證明其準確性和實用性的同時,仍需進一步模型優化以提高在薄云的識別與分割精度。Shi等[50-51]對U-Net進行優化提出了CloudU-Net、CloudU-Netv2對晝夜圖像進行了有效地分割。其中CloudU-Netv2采用雙線性上采樣、位置和通道注意力模塊,優化了原先CloudU-Net的分割性能。Zhang等[52-53]提出了多尺度注意力卷積神經網絡(multiscale attention convolutional neural network,MACNN)模型,添加了多尺度模塊,以及用于學習注意力系數的注意力模塊。隨后提出了具有雙金字塔池化模塊的DPNet,在大數據集上取得了較好的分割效果。Shi等[54]繼續深入研究云分割,提出了CloudRaednet模型,編碼器中添加了殘差模塊,采用注意門連接解碼器,可實現在不不增加時間復雜度的條件下,更好地分割地基云圖中的局部細節。Makwana等[55]提出基于注意力和聚類的輕量級云分割網絡ACLNet,實現了較好的云圖預測性能。如表2所示,詳細介紹了近年來地基云圖檢測領域研究學者所提出的分割模型,使用的數據集不盡相同。 其中CloudU-Net、CloudU-Netv2、MACNN、CloudRaednet、DPNet、ACLNet等網絡都取得不錯的效果。

表2 地基云圖分割主要模型和訓練數據集介紹Table 2 Main segmentation models and training data sets of ground-based cloud images

綜上所述,可知深度學習技術在云檢測任務中通過對海量數據的訓練,挖掘精細的云體特征,達到良好分割效果,研究學者們嘗試更多類型的分割模型范式和算法來實現地基云圖分割任務。

3 基于深度學習語義分割的地基云圖分割模型評估

為對語義分割網絡模型在地基云圖分割任務上的性能表現做出詳細的評估,現先對基礎理論簡單介紹,然后選取現階段性能較好的幾種語義分割網絡在地基云圖數據集上進行實驗,對分割結果數據做指標性評估,并對分割效果進行可視化操作,最后驗證泛化能力。

3.1 卷積神經網絡理論

卷積神經網絡(CNN)[56]因其具有強大的自適應特征提取和學習能力可挖掘地基云圖中云體精細邊緣和紋理等不明顯特征信息,CNN可以利用共享權值、局部連接等特性來大幅度減少網絡復雜度[57]。CNN是一種端到端的高效網絡,可避免前期復雜煩瑣的源數據預處理工作。

CNN結構主要包括卷積層、池化層、全連接層等,卷積層使用卷積核對輸入圖像進行卷積運算提取特征,如圖2所示,展示了經典CNN模型結構圖。CNN模型訓練時,前層權重參數影響后層輸入數據分布,因此通常在卷積層加入批標準化方法(batch normalization,BN)[58],以加快模型的收斂速度,使各層之間有合適的廣度。BN作為參數優化方法,可使分散的參數變化為符合高斯分布,使得訓練的模型穩定性更高。池化作用是對特征圖(feature map)做消除冗余特征的下采樣操作[59],在降低空間不變性的同時僅保留重要的特征信息,可以調節網絡模型的復雜性。全連接層作用是整合CNN學習提取到的特征信息,將多維特征輸入映射為二維特征輸出。

3.2 語義分割網絡模型

圖像語義分割的本質是對圖像像素的分類,語義分割技術對實現云圖的自動化、高效率、高精度的精準檢測與分割有重要作用。早期的語義分割方法主要是基于機器學習方法[60-63],為語義分割技術發展奠定了基礎。基于深度學習技術的發展和CNN模型不斷地改良與創新,涌現一批優秀的CNN語義分割方法, 比有FCN、SegNet、U-Net、DeepLabV3+等在地基云圖分割領域取得了出色的效果。

本文中云檢測所述的地基云圖分割任務本質上就是深度學習中的語義分割任務,用于語義分割的CNN模型通常為編碼器-解碼器結構(encoder-decoder),淺層網絡由于其感受野(receptive field)較小,主要學習局部的細節特征表示,捕獲云圖像的紋理信息,而深層網絡則學習整體的抽象特征,反映云圖像高級語義信息。

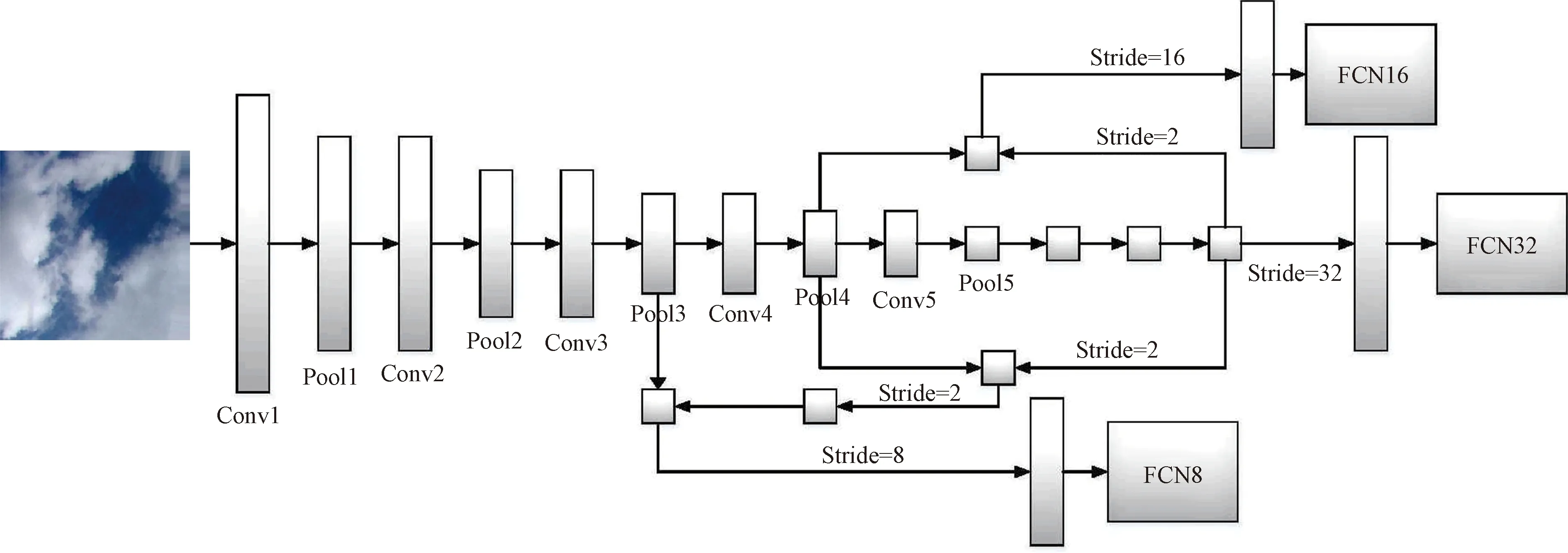

(1)FCN。全卷積網絡(FCN)是Long等[64]將CNN中的全連接層改成卷積層,利用反卷積(DeConv)操作將特征圖上采樣,不影響輸入圖像空間位置信息,最終在上采樣的特征圖上進行像素分類。此外使用跳躍連接可以融合不同層次的語義信息,起到了提高分割精度的效果。在上采樣過程中融合不同的大小的特征即可得到不同的FCN,改進的FCN網絡結構如圖3所示。

(2)SegNet。SegNet由Badrinarayanan等[65]基于Caffe框架實現的語義分割深度網絡,其結構于FCN相似,在Decoder部分做出改進。SegNet模型結構如圖4所示,其在解碼器部分的backbone主干特征提取網絡為VGG16的前13層卷積網絡,且解編碼器網絡層一一對應,最終經由Softmax分類器為每個像素預測概率。SegNet相比于前者全卷積網絡有更高的分割精度,模型擬合速度較快,網絡的訓練速度有所提升。

圖2 經典CNN模型結構圖Fig.2 Structural diagram of the classic CNN model

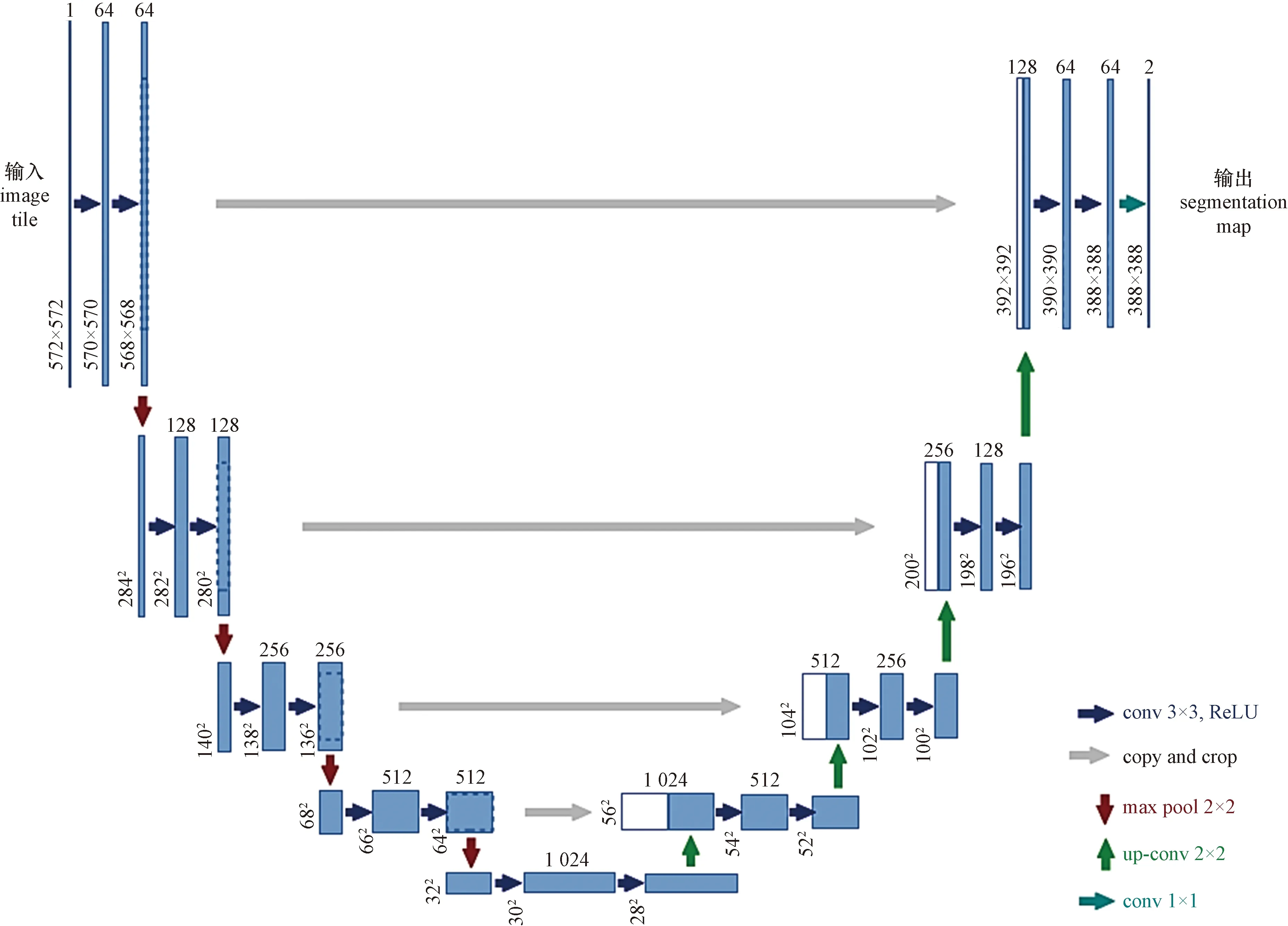

(3)U-Net。U-Net是由Ronneberger等[66]提出的一種網絡結構呈現“U”字形的編碼器-解碼器模型,因此稱之為U-Net,適合小樣本數據集。如圖5所示,其網絡模型包括左半邊的編碼器路徑、中間層和右半邊的解碼器路徑。編碼器壓縮特征路徑使得特征圖的分辨率依平方倍降低,逐步展現各像素點的空間位置信息。相似地,解碼器擴展特征路徑與之相反,將池化得到的各網絡層和上采樣輸入層相結合來恢復圖像。同時在不同層級特征圖之間加入跳躍連接,可在一定程度上有更好的分割效果。與FCN相比,U-Net的編碼器-解碼器之間存在信息連接,有助于恢復編碼器路徑中丟失的空間信息。

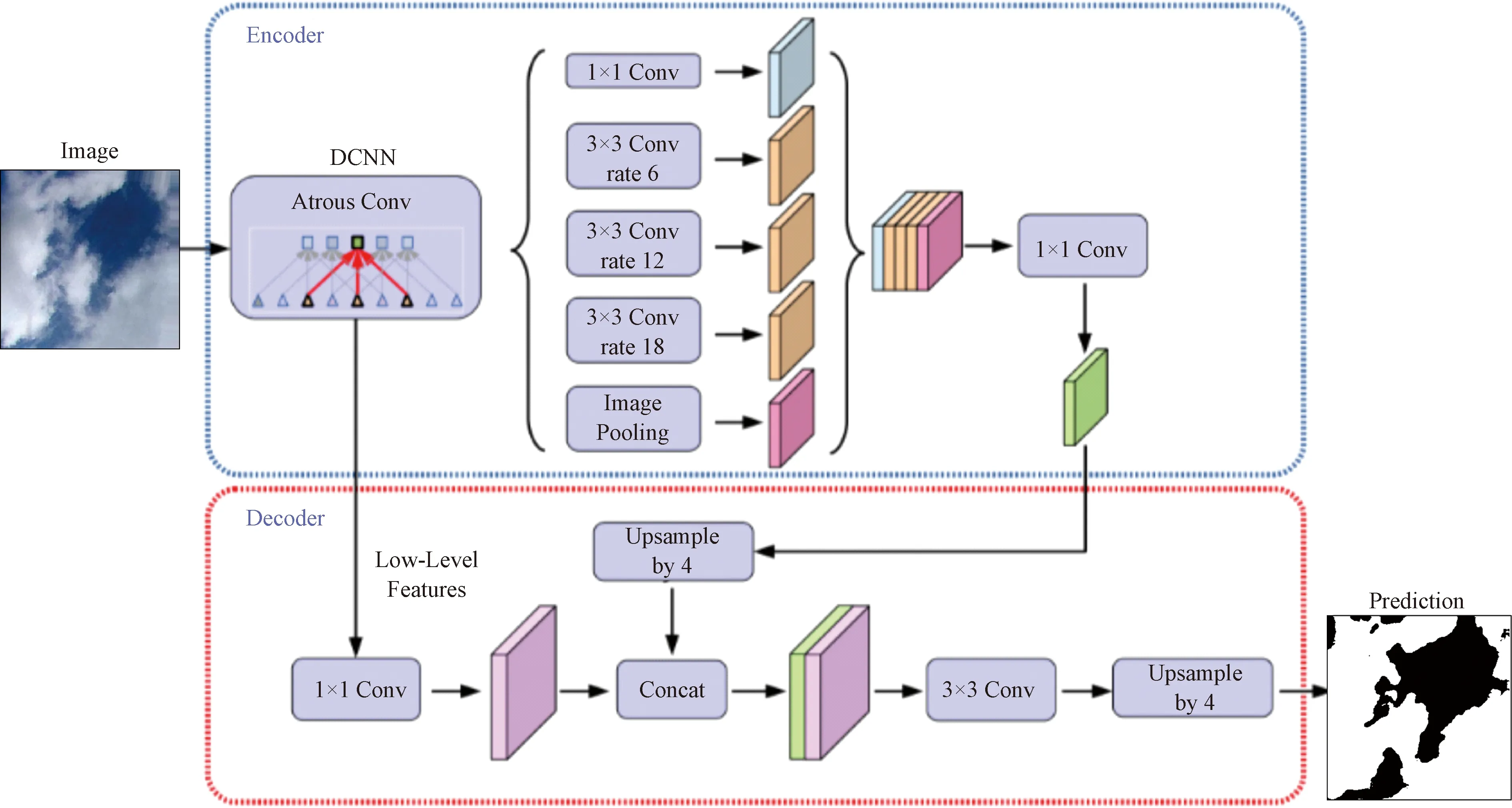

(4)DeepLab V3+。DeepLab V3+模型由Chen等[67]提出的基于編碼器-解碼器結構的CNN模型,是DeepLab系列的最新模型,如圖6所示。其編碼器部分采用Xception網絡[68]或者輕量級Mobilenetv2[69]作為主干網絡,有效地減少了計算復雜度,提高了網絡的收斂速度。同時引入空洞空間金字塔池化(atrous spatial pyramid pooling,ASPP)模塊,空洞卷積具有增加感受野面積同時保持特征圖大小恒定的優點,有效解決特征圖尺寸減小的問題[70-71],提升了融合多尺度特征信息能力。

3.3 實驗設計與參數設置

眾多學者提出了諸多改進型CNN模型用于地基云圖的分割任務,均取得了優異的分割效果。現選取上述CNN模型及其變體、部分在圖像分割領域表現出色的模型共計八種,在標準地基云圖數據集SWIMSEG上進行性能評估,實驗的CNN模型分別是:FCN-8s、UNet、SegNet、PSPNet[72]、RefineNet[73]、PAN[74]、DeepLab V3、DeepLab V3+。

3.3.1 評估指標

為定量評估上述不同模型的提取和解碼云特征的性能,評估指標有像素準確率(pixel accuracy,PA)、平均像素準確率(mean pixel accuracy,MPA)、F1評分,以及在分割任務中最為關鍵的聯合平均交并比(mean intersection over union,MIOU),實驗采用多種評估度量指標來全面評估上述CNN模型準確性[75],MIOU的計算公式為

圖3 改進的FCN網絡結構圖Fig.3 Structural diagram of the improved FCN network

圖5 U-Net模型結構圖Fig.5 Structural diagram of the U-Net model

圖6 DeepLabV3+模型結構圖Fig.6 Structure diagram of DeepLabV3+ model

(1)

式(1)中:q+1為包含背景天空在內的類比個數;pij為真實值為i類像素卻被預測判定為j類像素的數量。

3.3.2 實驗設置和數據集準備

實驗引入了遷移學習(transfer learning, TL),遷移學習的優點在于可將MobileNetV2、Xception、ResNet50等預訓練模型用作特征提取主干用于地基云圖分割任務中,大大加快了訓練速度和準確率,同時使用微調(fine-tuning)的方法使參數適應本次實驗的SWIMSEG數據集,實現正遷移。

本實驗利用數據增強技術來擴充SWIMSEG數據集,達到6 078張云圖圖像。隨后按照9∶0.5∶0.5的比例分別分為訓練集、驗證集和測試集。在處理器為Intel Core i7 11代,GPU為Nvidia GeForce GTX-2080TI的硬件環境Tensorflow框架下實現網絡的訓練、驗證和測試。基于遷移學習思想,將訓練模型進行凍結訓練,在凍結階段將模型backbone凍結,使得特征提取網絡保持不變,對網絡進行微調,可以有效防止權值被破壞,同時占用GPU的顯存較小。本實驗模型訓練過程中,將凍結階段批量大小(batch size)設置為8,解凍階段減小為4。總訓練世代epoch為100,將前50個epoch稱為凍結階段,后50個epoch稱為解凍階段。

3.3.3 參數設置

隨后模型參數采取Adam優化器以0.001的初始學習率更新。同時使用了Momentum優化器和Poly學習策略,表達式為

(2)

式(2)中:lr表示訓練過程中的學習率;epoch表示當前迭代周期;epochmax表示最大迭代次數;power表示動量,實驗中設置為0.9。

訓練階段選擇交叉熵損失(cross entropy loss)作為loss函數,來衡量訓練后模型地預測結果與真實標簽之間的相似性,定義為

(3)

式(3)中:yi表示真實標簽值;y′i表示模型預測值。

同時引入Dice loss函數,其為一種基于區域的損失,計算公式為

(4)

式(4)中:X為預測結果的分割區域;Y為真實值區域;X∩Y為二者的重合部分。

3.4 實驗結果與評估

如表3所示,使用評估度量指標在八種CNN實驗模型的得分情況。經各評估矩陣度量指標數值對比,其中U-Net、PSPNet、DeepLabV3和DeepLabV3+基本高于其他分割模型,其中,U-Net和PSPNet的分割性能相近,還有DeepLabV3和DeepLabV3+的像素準確率都超過了90%,U-Net、PSPNet、DeepLabV3+的PA、MPA、F1都領先于其他模型,所以斷定上述三種模型是效果最優的,而且DeepLabV3+ MIOU達到87.88%,其無疑是為八種實驗模型中效果最優的。選用DeepLabV3+為基礎做結構性改進是后續做地基云圖分割的最優選擇。

表3 主要語義分割模型在SWIMSEG上的 評估指標數據Table 3 Evaluation index data of main semantic segmentation models on SWIMSEG

選擇U-Net、PSPNet、DeepLabV3+三種模型訓練中的MIOU精度曲線圖和loss損失曲線圖, 如圖7所示,三種模型訓練過程的MIOU曲線都在5個epoch內很快地達到了70%,隨后曲線趨于平整,呈現微弱的上升趨勢。由于實驗中設置了凍結訓練和解凍訓練,U-Net在解凍階段開始時MIOU出現輕微的下降,隨即回升,另外三種模型訓練損失函數曲線也在在解凍階段開始時出現loss損失函數的陡增,隨即下降,在訓練到80個epoch后趨于平穩,無明顯下降趨勢,說明模型趨于擬合。

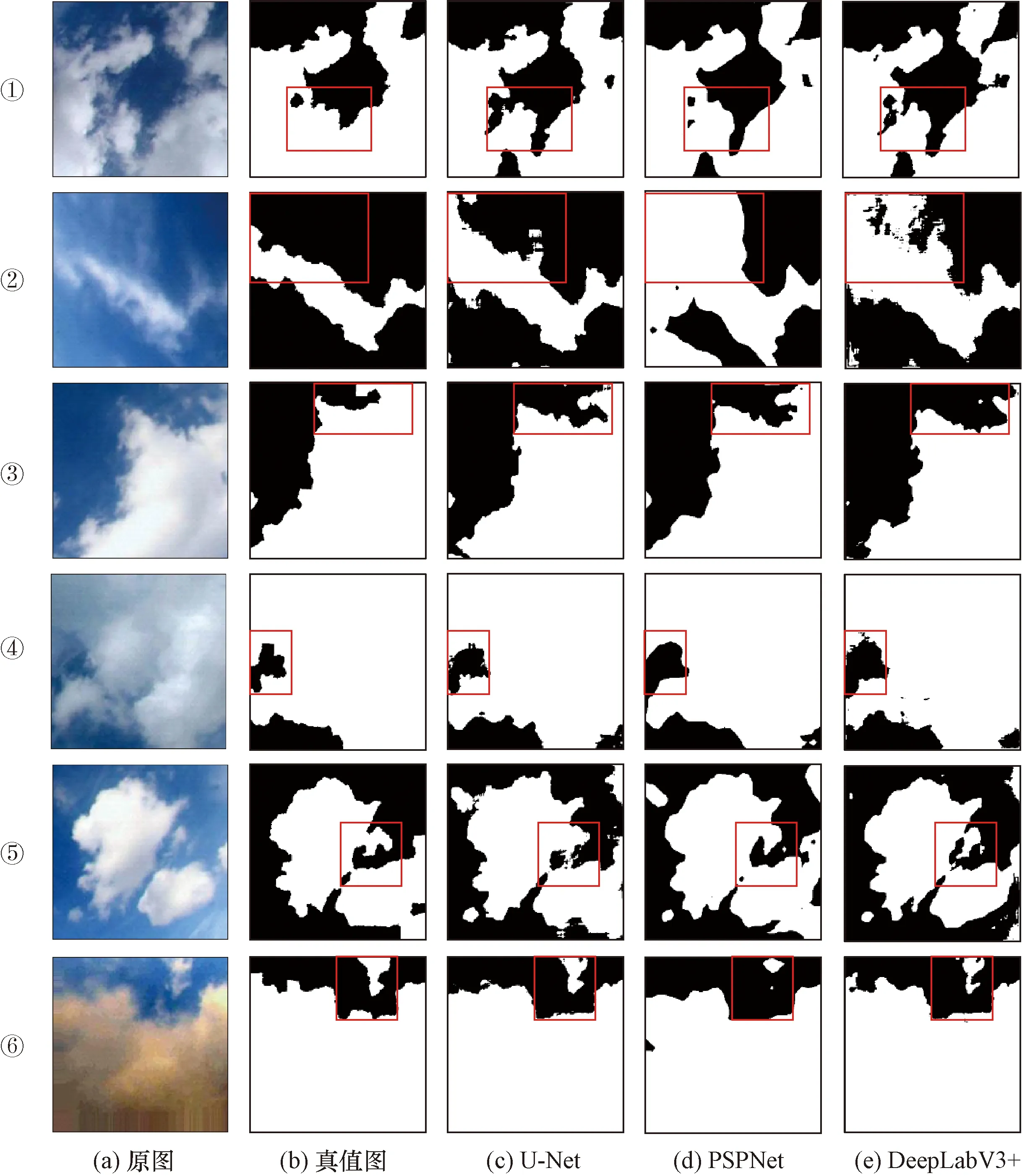

本實驗可視化了三種經典的語義分割模型U-Net、PSPNet和DeepLabV3+的部分云圖分割輸出結果圖,如圖8所示,以直觀地比較三種模型的提取和解碼云特征的性能。

觀察圖8可以很明顯地看出,以上三種模型均可以實現對數據增強后的SWIMSEG測試集中云圖的邊緣和陰影較為精準分割。針對薄云區域的顏色信息不夠明顯,與天空背景存在交融情況,各類模型檢測與分割效果不盡相同,如圖8②,PSPNet和DeepLabV3+在云體上部的檢測結果與數據集GroundTruth圖存在偏差,但是在通過與原圖進行視覺校對后發現,語義分割模型將薄云部分檢測出來,說明可以較準確的反映深度和薄云形狀,可見上述兩種云圖分割模型性能更加可靠,并且接近與實際圖像。

3.5 模型泛化能力評估

此外泛化能力和魯棒性是判定優秀語義分割模型的重要因素。將經SWIMSEG訓練后的DeepLabV3+應用到CCSN數據集,并生成相應的云掩碼,選取部分典型的云圖圖像和對應云掩碼分割圖來觀察比較,如圖9所示。

觀察圖9生成的預測圖并結合目視比對可知,DeepLabV3+可以準確地檢測出CCSN數據集中大多數云,云的邊緣與天空分割得較為細致。如圖9中第一列的積云、第二列的卷云和層云輪廓都實現了幾乎完美的分割效果,零散云體、碎狀云體也可以有效分割,另外圖9⑤⑦兩幅圖呈現紅色的云體也被有效的檢測出,圖9⑧背景為暗色調,云體呈白色的夜間云圖也可以完美且精準地識別。由此斷定,云圖圖像中的顏色差異性信息對最終的云天分割結果具有極大的影響力。

所以這類高精度高置信度的預測結果圖可以處理為這類為未注釋原始云圖的真實標簽,可有效增加帶標簽的地基云圖檢測分割數據集的數量。

對于該數據中新納入的尾跡云,該模型能夠實現很精準的分割出云掩碼和清晰的邊界,此外飛機也會被識別為云體,如圖10所示。因此對DeepLabV3+模型的泛化能力和魯棒性的可視化系統性評估驗證了其優異的分割性能。

圖8 三種模型可視化分割效果對比圖Fig.8 Comparison of segmentation effects of three models

仍存在以下關鍵問題值得關注:

(1)云圖存在的光照條件、云體深暗顏色信息會對分割造成不利影響。如圖10所示,圖②中紅色夕陽背景下顏色相對較深的晚霞云部分被誤判為天空,背景天空呈現紅色,卻被識別為云體。圖④卷層云分割效果收到光照的影響較大,圖像中光暈部分也被誤分割為云體。第二列圖⑤圖⑥積雨云中底部顏色較深的云體部分會被誤分割為天空。所以對于顏色較暗或者較亮、云體較為稀薄、云塊較不明顯的部分,模型不能有效的捕捉到其相應的云特征,亦或者是該區域云特征相較于其他特征顯得較不明顯,模型在訓練過程中未能充分學習到此類細致的云特征。

(2)分割模型會誤判地基云圖中水體、山脈、草地植被等元素,例如圖10中圖⑦圖⑧最后積雨云圖像,模型將圖中下方的湖面和草地均識別為云體,存在嚴重的誤判。原因可能是DeepLabV3+模型采用了僅包含云體與天空的SWIMSEG數據集進行訓練,只對云和天空有較高的分割準確率。

因此,在未來的數據集中添加不同光照條件、顏色差異性大、存在干擾因素、存在噪聲、分辨率較低的地基云圖像是不可或缺的,有助于分割模型能夠充分學習云圖細節信息及干擾因素特征,提高自適應云圖分割模型的泛化性和魯棒性。

4 總結與展望

針對最新基于語義分割深度學習的地基云圖自適應分割研究進行介紹,對近年來的地基云圖分割任務研究進展做出了詳細的概括。隨后介紹了國內外認可度很高的幾類適用于語義分割的地基云圖公共數據集,此類數據集與性能更復雜的語義分割模型在地基云圖檢測分割領域得到評估和應用,也解決了之前因數據集匱乏、數據量小等問題造成的困擾。然后介紹了卷積神經網絡的基本理論,以及經典的語義分割模型,隨后基于遷移學習思想對語義分割模型在地基云圖分割任務上的性能進行定性分析和綜合性評估,實驗中使用SWIMSEG數據集對八種經典的語義分割模型進行訓練和預測,具體分析了三種性能較為優異的模型MIOU和損失函數曲線圖,并可視化了三種高效模型的云圖預測分割圖后進行細節對比,分析其提取云特征并解碼預測的能力,最終選擇出云圖自適應分割性能較為優異的DeepLabV3+模型,最后無標簽注釋在CCSN數據上生成相應的預測分割圖,經細節部分比對來評估其泛化能力和魯棒性。

現階段的地基云圖數據集日益擴展,語義分割模型日漸改進發展,本文對地基云圖自適應分割技術發展提出以下展望。

(1)目前的研究學者已經開發出很多標簽置信度較高的數據集,受到了眾多研究學者的認可,期待有更多數據量充足,云圖種類齊全,包含不同光照條件,顏色差異性大,可有效區分干擾因素的優秀帶注釋的地基云圖數據集的發布。

(2)學者們把很多新的語義分割模型應用于地基云圖分割領域,期待有更適合地基云圖檢測分割模型的出現。現階段的語義分割模型范式多采用編碼器-解碼器構型,另外生成對抗網絡、注意力機制等都在圖像識別領域取得良好表現,可以與編碼器-解碼器結構相結合,提出更多優異的分割模型,實現對地基云圖有效檢測。

(3)近期熱門模型Transformer[76-77]興起于自然語言處理NLP領域,由于其依賴于自注意力機制(self attention,SA)[78]來學習判別特征,已經有學者將其引入至計算機視覺領域,可以有效避免基于卷積神經網絡CNN學習特征表示時由于感受野較小而導致的全局信息丟失問題,取得了矚目的效果。可以嘗試將Vison Transformer[79]應用于地基云圖分割任務中,實現對云天的高效分割。

4.此外當前基于深度學習的地基云圖檢測分割技術的研究較少的在預測算法上的創新,普遍在模型改進上驗證評估,希冀涌現更多更新穎更適用的地基云圖檢測和預測算法,推到地基云圖分割任務領域發展和進步。