基于手部姿態識別的MIDI體感交互系統設計

周祺 張帥

[收稿日期]2022-0119

[第一作者]周祺(1990-),湖北武漢人,湖北工業大學教授,研究方向為產品創新設計

[通信作者]張帥(1996-),河北唐山人,湖北工業大學碩士研究生,研究方向為體感交互設計

[文章編號]1003-4684(2023)02-0027-06

[摘要]為擺脫MIDI音樂設備在交互方式上的限制,同時針對目前體感交互系統便攜性差、價格昂貴等問題,將邊緣計算設備與輕量級網絡結合,提出了一種基于手部姿態識別的音樂體感交互系統。系統上位機依托于樹莓派 4b,通過單目攝像頭獲取數據進而識別手部關鍵點,調用舵機追蹤目標,并通過nRF24L01通信模塊將動作指令發送給下位機,從而實現中遠距離控制音樂演奏。通過在輕量級網絡ShuffleNet v2中嵌入SENet通道注意力機制并進行網絡瘦身操作,系統可在200 ms內完成體感控制任務,能滿足用戶手勢控制、設備協同等需求。

[關鍵詞]MIDI; 樹莓派; 手勢識別; ShuffleNet v2; 體感交互

[中圖分類號]TP 271? [文獻標識碼]A

人機交互領域如今把交互行為的相關問題作為評價設計資源、情感性、體驗感受和美學的重要指標[1]。交互系統設計的靈感也越來越多地來自于以身體設計和空間設計為基礎的體感動作,在姿態識別、手勢識別等技術應用中尤其明顯。但相關系統在MIDI音樂控制這類日常活動中并未得到廣泛應用,且多數應用需要特定的輔助設備,如動捕手套、深度攝像頭等。隨著深度神經網絡在計算機視覺領域研究的深入,平面圖像的特征提取和手勢識別的能力越來越強,使用廉價易用限制更少的單目攝像頭搭建體感交互系統逐漸成為可能。Juan C.Núez等[2]就提出了一種基于卷積神經網絡(CNN)和LSTM循環網絡組合,采用兩階段培訓策略的手部關鍵點識別方法。雖然處理關鍵點識別的模型發展很快,也越來越準確,但也可以看到多數模型需要大量的計算和內存資源,無法快速部署在樹莓派等邊緣計算設備上,無法滿足體感交互應用的便攜性需求,限制了在小型設備上的應用。

對嵌入式設備的需求刺激了高效網絡結構的發展,近年來出現了一系列輕量化卷積網絡模型。GoogleNet[3]通過引入初始空間模塊,以更低的計算成本更好地提取特征。MobileNets[4]中,Andrew等人使用深度可分離卷積策略,將標準卷積分解為深度卷積和點態卷積,有效地減少了計算負荷。其中,ShuffleNet v2[5]使用分組卷積模式,引入通道分割和通道混洗操作,在較小模型規模的同時仍具有較強的泛化性,可以用比傳統網絡更少的參數保持相似的精度。因此,本文根據改進的ShuffleNet v2手部關鍵點回歸模型,搭建了一個用于控制MIDI音樂設備的體感交互系統。系統以樹莓派4b為搭載平臺,加入二自由度舵機、無線通信等模塊,實現了交互識別、動態跟蹤、遠程控制等功能,讓MIDI設備控制更加直觀自然、方便高效,使得體感交互系統易便攜、低功耗、反應迅速。

1??? 基于改進ShuffleNet v2實現輕量化手勢識別算法

手部關鍵點檢測,也稱為手部姿態識別,旨在定位手部關鍵區域,包括指尖、指關節等部位。為了在低成本的小型設備上完成體感交互的MIDI設備控制,以手部關鍵點檢測為目標,從兩個研究方向對模型進行改進:第一個方向是優化模型結構,強調圖像中最重要的特征信息;另一個方向傾向于壓縮模型,旨在以合理的精度損失減小模型。因此,本文以ShuffleNet v2為基礎,增加SENet通道注意力機制從而提高精度,引入網絡瘦身來降低計算消耗,搭建了一種輕量高效的手部姿態識別模型。

1.1??? ShuffleNet v2輕量級網絡

ShuffleNet v2是曠世在2018 年提出的一種輕量級卷積神經網絡,其設計遵循四個基本原則[5]:1)為了最小化內存訪問成本,輸入通道的數量和輸出通道的數量應該盡可能相等;2)為了降低內存訪問成本,組卷積要盡可能小;3)為了提高網絡并行度,網絡結構要盡可能簡單;4)為了減少運算消耗,激活等運算的次數要盡可能少。

為遵循其設計原則,ShuffleNet v2網絡采取了分組卷積的方式,在保證精度的情況下減少網絡參數量。網絡主要由兩個類型單元構成:a類型單元(圖1a)和b類型單元(圖1b),分別對應運算中步長為2和1的兩種情況。

a類型單元為下采樣單元,兩個分支分別進行步長為2的3×3深度卷積(Depthwise convolution,DWConv)和1×1單元卷積操作。在卷積之后,兩個分支通過級聯操作(Concat) 進行通道拼接合并,特征圖維度大小減半,輸出通道數加倍,最后進行通道混洗操作(Channel Shuffle)進行特征融合。

b類型單元首先將輸入特征通道c平均拆分為兩個分支c-c′和c′,即進行通道分割操作(Channel Split)。為減少碎片化程度,在左分支c-c′保持結構不變直接同等映射,右邊分支c′則按順序進行1×1單元卷積、3×3深度卷積和1×1單元卷積操作。通過級聯操作拼接合并后,單元通道數保持不變,最后也需進行通道混洗操作。經過通道分割操作后,每次卷積計算都是在部分特征通道上進行的,計算量和參數相應減少,網絡單元可以容納更多的特征通道,提高了網絡的準確率。

兩個單元后的通道混洗就是在不同的組之后交換一些通道,從而交換信息,解決了分組卷積導致的信息丟失問題,使得各個組的信息更豐富,有利于提取到更多更好的特征(圖2)。通道混洗操作過程為:將輸入層分為 g 組,總通道數為 g × n ,首先將通道維度重塑為 (g,n),然后將這輸出特征轉置變成 (n,g),最后重塑為 g × n 進行輸出。

1.2??? SENet通道注意機制

SENet(Squeeze-and-Excitation Networks)通道注意機制是由Hu等[6]在2018年提出的,其核心思想在于通過學習特征通道的權重,使得有效的特征權重增大,無效或效果小的特征權重減小,能夠達到更好的結果同時僅增加了可接受的少量計算代價。SENet單元結構(圖3)主要有兩部分,分別稱為擠壓(Squeeze)和激勵(Excitation)。

對于卷積操作Ftr:X→U,X∈H′×W′×C′,U∈H×W×C,設V=[v1,v2,…,vC]表示卷積核集,其中vC表示第C個卷積核的參數;輸出特征圖有C個通道,即

U=[u1,u2,…,uC]

輸入特征圖有C′個通道,即

X=[x1,x2,…,x′C]

其中uC可表示為:

uC=vC*X=∑C′s=1vsC*xs

其中“*”意為卷積操作。

Ftr可通過SENet單元如下操作來校準特征:原始特征圖X首先進行擠壓操作,通過全局池化(Global pooling)壓縮到1×1×C,將每個二維的特征通道變成一個特征標識符,在這種情況下1×1 部分仍具有原始H×W 感應野,并且將跨空間維度H×W的特征映射聚合了起來。全局池化操作生成的通道向量z∈C是由X的空間維度H×W通過收縮生成,其中z的第c個元素計算方法見式(1)。

zC=Fsq(uC)=1H×W∑Hi=1∑Wj=1uC(i,j)(1)

接下來進行激勵操作,充分捕獲通道依賴性,學習每個通道樣本的特定激活,控制通道激活。激勵層將擠壓結果交由兩個全連接層(FC)預測,對特征映射進行重新加權,通過Sigmoid函數的門機制把權值歸一化,公式如下:

s=Fex(z,W)=σ(g(z,W))=σ(W2δ(W1z))(2)

式中,δ為ReLU函數,W1∈Cr×C和W2∈C×Cr表示兩個全連接層生成的權重值,通過在非線性周圍形成一個具有兩個全連接層的瓶頸來參數化門控機制:W1中進行維度縮減,將z的維度從C縮減為C/r,縮減后進入ReLU激活,之后在W2中將維度再增擴回C。

單元最終輸入通過對參數的重新縮放轉換獲得,表示如下:

C=Fscale(uC,sC)=sC·uC

其中C=[1,2,…,C]和Fscale(uC,sC)指的是特征圖中的uC與激勵操作產生的sC之間的通道相乘。

1.3??? 輕量級關鍵點識別網絡

手部關鍵點檢測就是定位手部的關鍵點坐標序列,其中手部定位點序列(圖4)包括指尖,各節指骨連接處等21處關鍵點。以手部21處關鍵點序列為依據,由Large-scale Multiview 3D Hand Pose數據集和網絡抓取的共11200張圖片制作了訓練圖集。

訓練中,為更好地模擬實際應用中的情況,在[-30, 30]度之間隨機旋轉訓練圖像,將隨機平移應用于邊界框15%內進行了中心擾動并進行了隨機翻轉。將大小為256×256的圖像及關鍵點坐標輸入調參后的ShuffleNet v2網絡模型后,直接返回手部21個關鍵點坐標,調參后的網絡結構見表1。

為了在保證模型準確性的同時降低模型復雜度,提高泛化能力,在Shufflenet v2網絡b類型單元右側的最后一個單元卷積層之后添加SENet層,更改后的模塊結構見圖5。ShuffleNet v2網絡結構加入的SENet單元,對提取的深度特征圖進行重新校準,能夠添加更豐富和更高級別的信息源,從而更好地引導模型的深度學習過程。

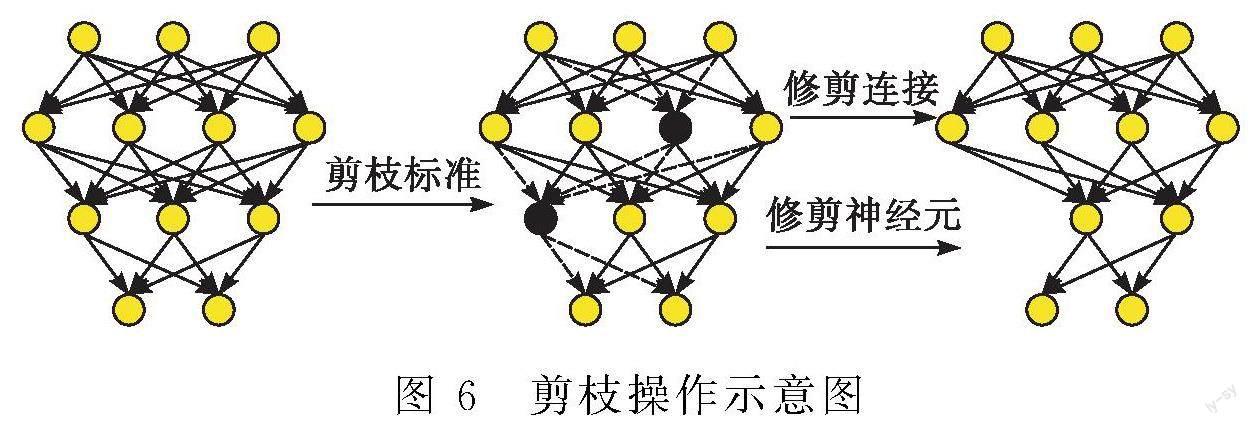

1.4??? 模型剪枝與重構

雖然使用ShuffleNet v2構建的模型比較精巧,但仍然考慮進一步壓縮模型以實現更快的推理速度,因此有必要對模型進行剪枝操作(圖6)。剪枝是一種常見的模型壓縮方法,使用剪枝去除不重要的通道,可以減少神經網絡的計算和內存需求[7]。

本文選用的網絡瘦身操作是一種通道級剪枝方案,其基本思想是聯合訓練權重和引入的比例因子γ衡量每個通道的重要性[8]。網絡瘦身根據BN(Batch Normalization)層中的比例因子γ來衡量通道的重要性,可以指導模型在訓練過程中將不重要的通道剪除,即γ較小時對應的通道。具體的網絡瘦身流程為:首先在原始模型的BN層中加入比例因子γ,將模型訓練后通過系數γ的L1正則化約束項來誘導BN層稀疏。然后通過比例因子γ的權重衡量通道的權重,找到可以丟棄的通道。最終訓練修剪后的模型并將準確性恢復,構建更小的模型來移植參數。

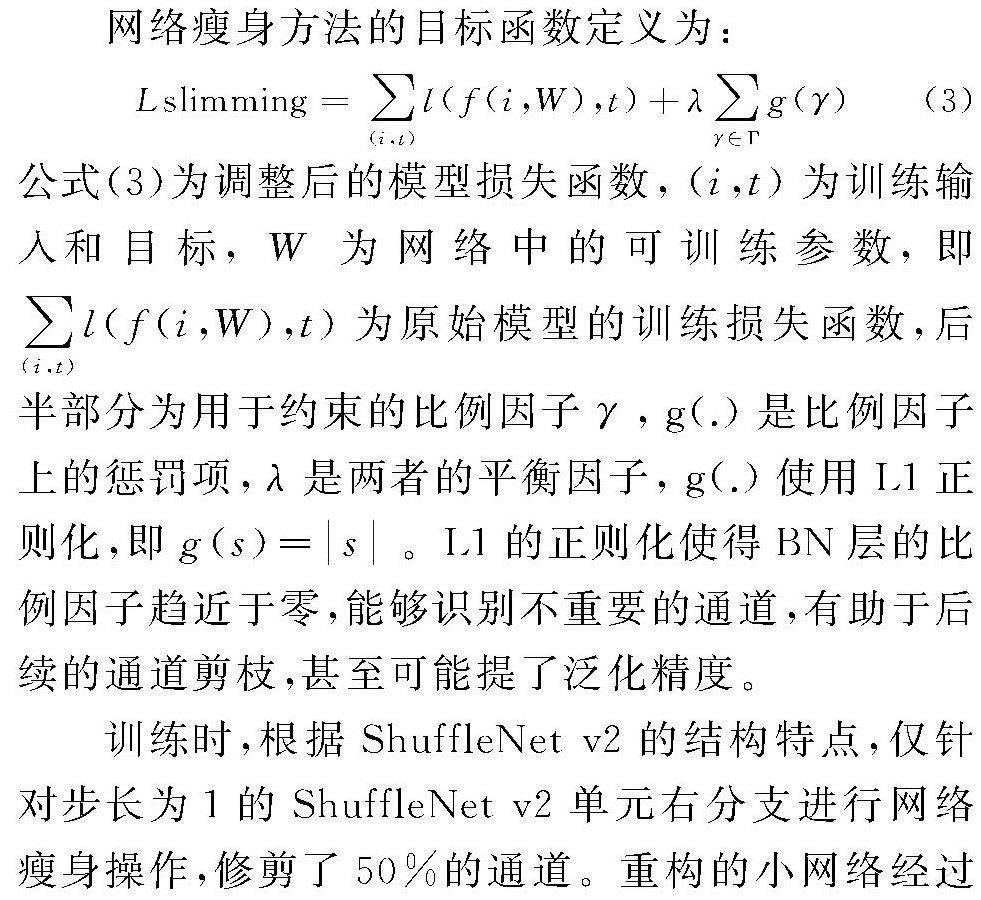

網絡瘦身方法的目標函數定義為:

Lslimming=∑(i,t)l(f(i,W),t)+λ∑γ∈Γg(γ)(3)

公式(3)為調整后的模型損失函數,(i,t) 為訓練輸入和目標,W為網絡中的可訓練參數,即∑(i,t)l(f(i,W),t)為原始模型的訓練損失函數,后半部分為用于約束的比例因子γ,g(.)是比例因子上的懲罰項,λ是兩者的平衡因子,g(.) 使用L1正則化,即g(s)=s。L1的正則化使得BN層的比例因子趨近于零,能夠識別不重要的通道,有助于后續的通道剪枝,甚至可能提了泛化精度。

訓練時,根據ShuffleNet v2的結構特點,僅針對步長為1的ShuffleNet v2單元右分支進行網絡瘦身操作,修剪了50%的通道。重構的小網絡經過微調步驟移植模型參數,最終模型大小從原始模型的5.4 MB降至3.9 MB,用于衡量模型復雜度的浮點運算次數(Floating point of operations,FLOPs)從2.36×107降至1.77×107,參數量減少25%。當手部關鍵點訓練集在經過修剪后的關鍵點檢測模型上將實現較好的識別準確度,即經損失函數計算所得準確率大于90%后,將其部署至樹莓派設備上。

2??? 體感交互系統設計

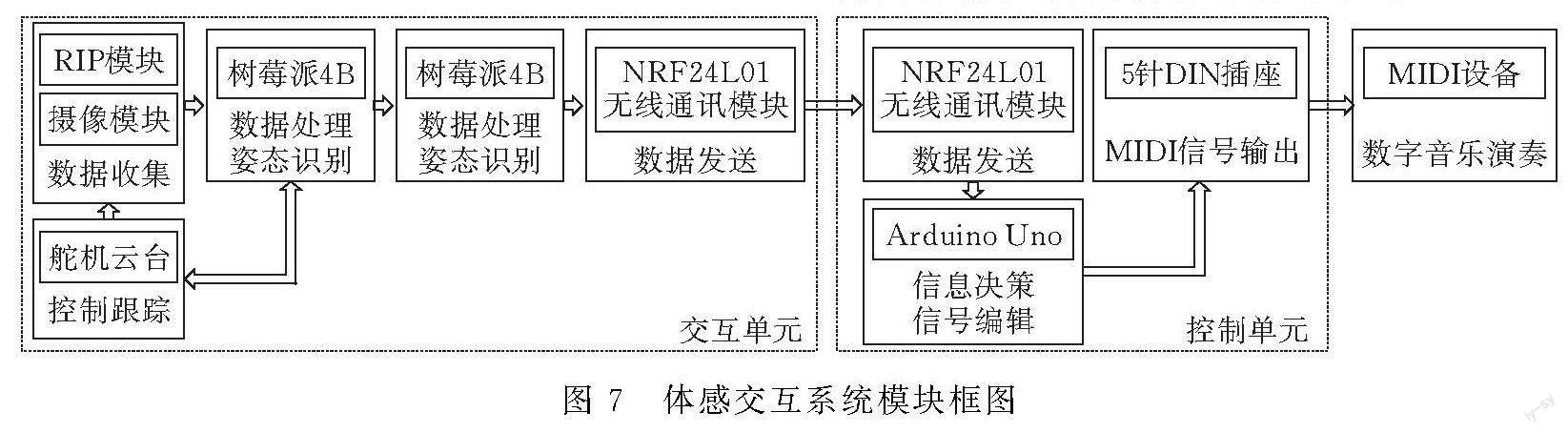

用于MIDI設備控制的體感交互系統由樹莓派、攝像頭、二自由度云臺、Arduino、紅外傳感模塊、nRF24L01通信模塊和5針DIN插座組成。系統分為兩個部分,以樹莓派4b作為數據處理端,Arduino uno作為數據接收端。樹莓派作為上位機,通過攝像頭獲取的圖像計算分析關鍵點位置,控制二自由度云臺追蹤手部,并將手部姿態信息通過通信模塊傳遞給下位機Arduino uno,從而實現對MIDI設備的體感控制,模塊框圖見圖7。

2.1??? 舵機追蹤模塊

為了讓用戶在交互時手掌處于攝像頭中心位置,使用二自由度云臺對手部中點進行追蹤。為實現舵機角度的平滑調整,采取了PID 控制,即比例(proportional)-微分(integral)-積分(derivative)控制修正系統偏差。追蹤控制以離散形式實現,需要采用后向歐拉方法對控制器方程進行數值積分[9],計算公式為:

u(k)=KPe(k)+KI∑i=0e(i)+KD[e(k)-e(k-1)]

其中KP、KI和KD分別是比例系數、積分系數和微分系數。

根據手部識別模型返回手部21個關鍵點的坐標集,可得手部中心坐標為(xh,yh) ,圖像中心點坐標為(xc,yc),則第i張圖片圖像中心點與手部中心點縱向和橫向偏差分別為:

Δxi=xh-xc, Δyi=yh-yc

橫向舵機方位角有效范圍為0~180°,縱向舵機方位角有效范圍為0~90°,因此追蹤模塊中最終所用的舵機移動角度計算公式為:

ax=KPΔxi+KD(Δxi-Δxi-1),

ay=(KPΔyi+KD(Δyi-Δyi-1))/2

舵機的控制部分需要使用PWM(脈沖寬度調制技術),利用占空比來控制脈沖信號的輸出大小,靠脈沖信號的持續時間來定位舵機輸出軸的旋轉角度。系統選用舵機的PWM頻率為50 Hz,轉動范圍為0~180 °,對應的PWM周期T為20 ms,其脈沖長度t、占空比D和轉動角度之間的對應關系如圖8所示。

為防止舵機追蹤抖動造成鏡頭不穩,模塊中設置一個24×24的死區,并使用多線程進行橫滾軸和俯仰軸的PID角度修正運算,從而達到及時穩定的手部跟隨效果。系統檢測到交互區域內有紅外信號時初始化舵機和攝像頭,舵機轉至初始位置;在時限內監測區域未識別到目標手勢信息時,舵機回歸初始位置并在待機時間結束后釋放相關端口以節約算力,控制流程見圖9。

2.2??? 無線通信與控制模塊

上位機通過nRF24L01單片射頻收發芯片將識別到的動作信息傳遞給同樣配備nRF24L01通信模塊的下位機,實現中遠距離的無線通信。對nRF24L01通信模塊的地址、通信頻道等在收發端進行配置,實現多機的數據傳輸,可以組建星狀控制網絡,方便用戶同時控制多個MIDI設備。

控制端主要完成以下流程(圖10):1)接受手部姿態信號;2)識別姿態編號并轉換為MIDI消息;3)通過5針DIN插座輸出信號控制MIDI設備。

5針DIN接線傳遞的MIDI控制消息由十六進制符號表示,由控制器號和數據字節共同組成。控制器號大于128,間于0x80到0xFF(十六進制);數據字節小于127,間于0x00到0x7F(十六進制),控制端組合發送給MIDI設備后可實現音量更改或音高變化等功能[10]。

3??? 實驗測試與結果分析

進行系統測試時,數據處理端樹莓派4b運行姿態識別模型及傳達指令,攝像頭Camera V2實時采集用戶圖像信息。Thonny Python作為開發環境運行手勢識別模型文件,在識別出手部關鍵坐標后,通過計算其二維角度關系識別手勢。Arduino uno作為控制端,通過USB-MIDI接線與PC 機相連,使用MIDI-OX程序監控傳入的MIDI數據,測試對應MIDI音色的演奏情況(圖11)。

在測試時,共定義了10種手部控制姿勢,包含4個簡單方向手勢(SG),4個簡單手指手勢(FG)和2個精細復雜手勢(CG)(圖12),分別對應不同的MIDI信號。每個動作分別在ShuffleNet V2網絡在網絡瘦身前后的模型上進行測試,獲取得到識別準確率、幀率及響應時間(表2)。

手勢交互實測中,識別準確率在原模型上的平均準確率為81.4%,網絡瘦身后模型的平均準確率79.5%。與原模型相比,其準確率只下降了1.9%,在簡單方向手勢上其相差僅為0.8%,手勢識別的準確率在前后并未大幅下降。在響應時間上,原模型和剪枝模型都實現 8 幀/s以上的運算幀率,并且剪枝后的模型速度提高了14.3%,對比原模型能更及時地完成信息反饋,有利于用戶實時控制MIDI設備的演奏。總體來說,修建后的模型,在基本不影響準確性的情況下,其響應速度和模型大小都優于原模型,能夠及時完成MIDI音樂的體感交互操作。

4??? 結論

改進的ShuffleNet v2模型實現了對更小、更快的追求,基本能夠同步完成MIDI設備的體感交互任務。針對具有精度要求和時間敏感的體感交互應用,本系統為在小型化設備上進行關鍵點推理提供了一個解決方案。結合無線通訊技術和MIDI音樂標準,實現了遠程無接觸手勢控制數字音樂演奏的相關功能。系統如果更新關鍵點二維角度算法,還可增加及修改交互動作,擴展其手勢識別庫。研究結果為體感交互和關鍵點識別的實時連續識別和縱向擴展開辟了一個有趣的實踐方向,為MIDI音樂創作者提供了多樣化的交互方式,且便于攜帶、成本不高、易于拓展。

[參考文獻]

[1]LUTHER L, TIBERIUS V, BREM A. User Experience (UX) in business, management, and psychology: A bibliometric mapping of the current state of research[J]. Multimodal Technologies and Interaction, 2020, 4(02): 18.

[2]NUNEZ J C, CABIDO R, PANTRIGO J J, et al. Convolutional neural networks and long short-term memory for skeleton-based human activity and hand gesture recognition[J]. Pattern Recognition, 2018, 76: 80-94.

[3]SZEGEDY C, LIU W, JIA Y, et al. Going deeper with convolutions[C].∥Proceedings of the IEEE conference on computer vision and pattern recognition, 2015:1-9.

[4]Howard A G, Zhu M, Chen B, et al. Mobilenets: Efficient convolutional neural networks for mobile vision applications[EB/OL]. (2017-04-17)[2021-12-30]. https://arxiv.53yu.com/abs/1704.04861.

[5]MA N, ZHANG X, ZHENG H T, et al. Shufflenet v2: Practical guidelines for efficient cnn architecture design[C].∥Proceedings of the European conference on computer vision (ECCV), 2018: 116-131.

[6]HU J, SHEN L, SUN G. Squeeze-and-excitation networks[C].∥Proceedings of the IEEE conference on computer vision and pattern recognition,2018: 7132-7141.

[7]林景棟,吳欣怡,柴毅,等.卷積神經網絡結構優化綜述[J].自動化學報,2020,46(01):24-37.

[8]LIU Z, LI J, SHEN Z, et al. Learning efficient convolutional networks through network slimming[C].∥Proceedings of the IEEE international conference on computer vision,2017: 2736-2744.

[9]BALAJI V, BALAJI M, CHANDRASEKARAN M, et al. Optimization of PID control for high speed line tracking robots[J]. Procedia Computer Science, 2015, 76: 147-154.

[10] DE OLIVEIRA H M,DE OLIVEIRA R C. Understanding MIDI: A Painless Tutorial on Midi Format[EB/OL]. (2017-05-15)[2021-12-30]. https:∥arxiv.53yu.com/abs/1705.05322.

Design of MIDI Somatosensory Interaction Systembased on Hand Posture Recognition

ZHOU Qi, ZHANG Shuai

(School of Industrial Design, Hubei Univ. of Tech., Wuhan? 430068, China)

Abstract:In order to get rid of the limitation of MIDI music equipment in the way of interaction, and to solve the problems of poor portability and high price of the current somatosensory interaction system, combining edge computing equipment with a lightweight network, a music somatosensory interaction system based on hand gesture recognition is proposed. The host computer of the system relies on the Raspberry Pi 4b, obtains data through the monocular camera to identify the key points of the hand, calls the steering gear to track the target, and sends the action command to the lower computer through the nRF24L01 communication module, so as to realize the medium and long-distance control of music performance. By embedding the SENet channel attention mechanism in the lightweight network ShuffleNet v2 and performing the network slimming operation, the system can complete the somatosensory control task within 200ms, which can meet the needs of user gesture control, device coordination, etc., and the system is convenient and efficient. It provides a reference for deploying somatosensory interactive applications on mobile devices.

Keywords:MIDI; Raspberry Pi; gesture recognition; ShuffleNet v2; somatosensory interaction

[責任編校: 張巖芳]