深度學習實時視頻超分辨率重建實驗設計

彭智勇, 黃揚鈚, 秦祖軍, 梁紅珍

(1.桂林電子科技大學光電工程學院,廣西桂林 541004;2.桂林生命與健康職業技術學院,廣西桂林 541001)

0 引 言

影像超分辨率重建是指通過軟件算法從低分辨率的圖像、視頻中恢復出紋理清晰的高分辨率圖像或視頻,最早由Harris[1]和Goodman[2]提出。超分辨率重建是后期圖像識別、處理、測量的基礎,是圖像處理領域中的基礎熱點問題,特別是基于深度學習的影像超分辨率重建技術由于其高性能,近年很多學者進行了深入的研究。基于深度學習的視頻超分辨率重建技術可以分為基于單幀圖像的幀內超分辨率重建和基于多幀視頻的幀間超分辨率重建。

基于單幀圖像的幀內超分辨率重建,有很多學者基于深度學習提出了超分辨率重建模型,如:VDSR[3]、ESPCN[4]、ClassSR[5]等。基于幀內圖像的超分辨率重建算法由于僅考慮幀內特征信息,忽略了視頻序列的幀間相關,性能較好的超分辨率重建算法計算量和內存損耗過大;結構簡單算法則特征信息不能充分利用,重建效果不好。基于多幀視頻的幀間超分辨率重建,有VESPCN[6]、FRVSR[7]、RBPN[8]等,此類算法往往將已經完成超分辨率重建的幀作為后續特征提取的輸入,當連續幀之間存在較大變化時,往往存在嚴重偽影及誤差累積,并且現有深度學習超分辨率重建算法運算復雜,還不能實現實時超分辨率重建。

本文設計了基于深度學習的實時視頻超分辨率重建研究型實驗。針對視頻特點,在利用幀內特征的同時也利用幀間特征,解決處理速度慢的問題,實現實時超分辨率重建。該實驗將GhostModule 結構應用于循環遞歸神經網絡并結合殘差結構設計一個快速的視頻超分辨率網絡,采用具有多級跳躍連接殘差映射,以解決循環卷積神經網絡中存在梯度消失的風險,從而能長時間保存高頻紋理信息,在取得較好重建效果的情況下實現實時視頻超分辨率重建。

1 實驗設計

1.1 實驗算法原理

1.1.1 整體結構設計

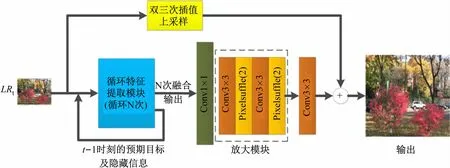

循環卷積神經網絡(RCNN)[9]可以對時域特征進行很好的建模,廣泛應用于自然語言處理的研究,并可用于提煉視頻幀間時域特征。Kim等[3]提出的殘差結構超分辨率重建網絡VDSR,該結構加深了卷積神經網絡的深度,具有較好的超分辨率重建性能,VDSR 采用的全局的殘差結構,盡管有效地把低層特征傳遞到高層,但沒有充分利用中間層的特征,導致重建的圖像紋理細節不夠清晰。本文在傳統RCNN 的基礎上,受到VDSR的啟發,設計了結合殘差結構的RCNN,實時視頻超分辨率重建網絡整體結構(見圖1)。

圖1 實時視頻超分辨率重建網絡整體結構示意圖

新的網絡結構與VDSR 處理方法相似,網絡分為兩條支路。在初始階段,上面的支路對視頻當前幀LRt進行雙三次方線線性插值得到初始的高分辨率圖像;下面的支路進行殘差學習,對輸入進行循環特征提取,并把得到的高頻特征信息輸入到亞像素卷積層對殘差圖像放大。最后通過殘差圖像和初始的高分辨率圖像相加,得到最后的當前幀超分辨率圖像SRt。其中,PixelShuffler(2)是一放大2 倍的上采樣模塊,在圖1結構中以放大4 倍為例通過2 個PixelShuffler(2)共放大到4 倍。在整體結構上,新網絡與VDSR 不同的是,VDSR在當前圖像輸入的特征行提取模塊之前就進行放大,因此后面的特征提取是在高分辨率圖像上進行運算,這無疑增加了計算量。而本文實驗針對低分辨率影像通過RNN網絡循環進行特征提取,最后才對殘差圖像進行放大,能有效減少計算量并保證處理效果。算法實現的重點為循環特征提取模型的設計。

1.1.2 循環特征提取模塊設計

GhostModule[10]網絡基于一組原始的特征圖,結合一系列線性變換,以很小的計算代價生成許多從原始特征發掘所需信息的“幻影”特征圖,從而通過低的計算成本生成了更多的特征圖。GhostModule 網絡結構與傳統結構參數量對比如下式表示:

式中:p1為傳統結構的參數量;p2為GhostModule 網絡的參數量;假設特征提取模塊的輸入和輸出通道數量均為f;k為卷積核的大小(這里取3 × 3);r為GhostModule的比例參數。由式(1)2 個參數之比得

當k取值較大時,分母后半部分可忽略不計,此時c≈r,即相比于傳統網絡。GhostModule 具有更深的網絡結構,更大的感受野,且參數量是普通卷積層的1/r,從而GhostModule網絡具有強的特征提取能力及小的算法量。

圖2 所示為運用GhostModule 設計循環特征提取模塊示意圖,其中圖2(b)為本文特征提取模塊內部結構,與傳統的循環塊[見圖2(a)]相比,設計的循環塊由GhostModule和隱藏信息與輸出分支結構兩部分組成。該循環塊采用具有多級跳躍連接層之間的殘差映射,解決了循環卷積神經網絡中存在梯度消失的缺陷,同時確保了流暢的信息流,并能夠長時間的保存高頻紋理信息,從而網絡更容易地處理更長的視頻幀序列。

圖2 循環特征提取模塊示意圖

由圖2(b)可知,新的循環特征提取模塊把當前幀It、前一幀It-1(t為影像幀編號,t=0,1,…n-1),它們之間的隱藏信息和上一個循環特征提取模塊的輸出作為輸入,得到循環塊前部分(GhostModule)的輸出;同時,將GhostModule的輸出分別輸入到2 條支路:左邊的支路作為本模塊的預期目標輸出Ot(RGB三通道);右邊支路作為本模塊的隱藏(遺留)信息Ht。把每次通過循環塊得到的預期目標輸出融合到n-1 個歷史預期目標中,即

式中:n為循環塊執行的次數;St為n次循環塊預期目標輸出的融合后的結果,其通道數為n×3。進一步把融合后的結果St輸入到放大模塊,即可得到放大后的殘差圖像HRES。最后把HRES與初始雙三次插值放大的高分辨率HBICUBIC相加即可得到最終的超分辨率圖像

1.2 實驗環境及設置

1.2.1 系統環境

實驗采用的硬件環境為:CPU 型號為英特爾i9-10900K,內存:32GB;系統:Win 7;GPU 為NVIDIA RTX2080TI,GPU主要用于對算法并行加速計算。實驗軟件環境為:ubuntu16.04、NVIDIA-3090、pytorch1.7.1、CUDA11.0 等。

1.2.2 測試數據及參數設置

本實驗使用的訓練數據集為Vidmeo-90K[11],該數據集大約包含90 000 個視頻序列,每個視頻序列包含7 幀視頻剪輯與各種運動和不同的場景圖像,其中隨機抽取8 000 個視頻序列用于訓練,其余用于測試;實驗的驗證集為Vid4(包含4 個視頻序列)和UDM10(包含10 個視頻序列)。由于Vidmeo-90K 只提供高分辨率的目標圖像,通過對高分辨率圖像進行高斯模糊(均方差σ =1.6)下采樣到1/4 像素得到64 ×64 大小的低分辨率輸入塊。經順時針隨機旋轉0°、90°、180°、270°,左右與上下翻轉得到8 倍于原始數據集的增強數據集。本文以Y 通道下重建高分辨率圖像的PSNR與SSIM作為實驗的評價指標,同時評估模型的參數量、計算復雜度和運算速度。

在訓練循環卷積神經網絡時,學習速率最初被設置為0.000 1,經過每20 個epoch學習率降低0.1 倍,共訓練了60 個epoch。本文實驗選用的優化器為Adam,優化器的相關參數設置:β1=0.9,β2=0.999 和權重衰減為0.000 5,以L1 作為損失函數進行監督訓練,訓練的批量數據大小為4。

2 實驗結果與分析

2.1 峰值信噪比(PSNR)與結構相似性(SSIM)性能對比

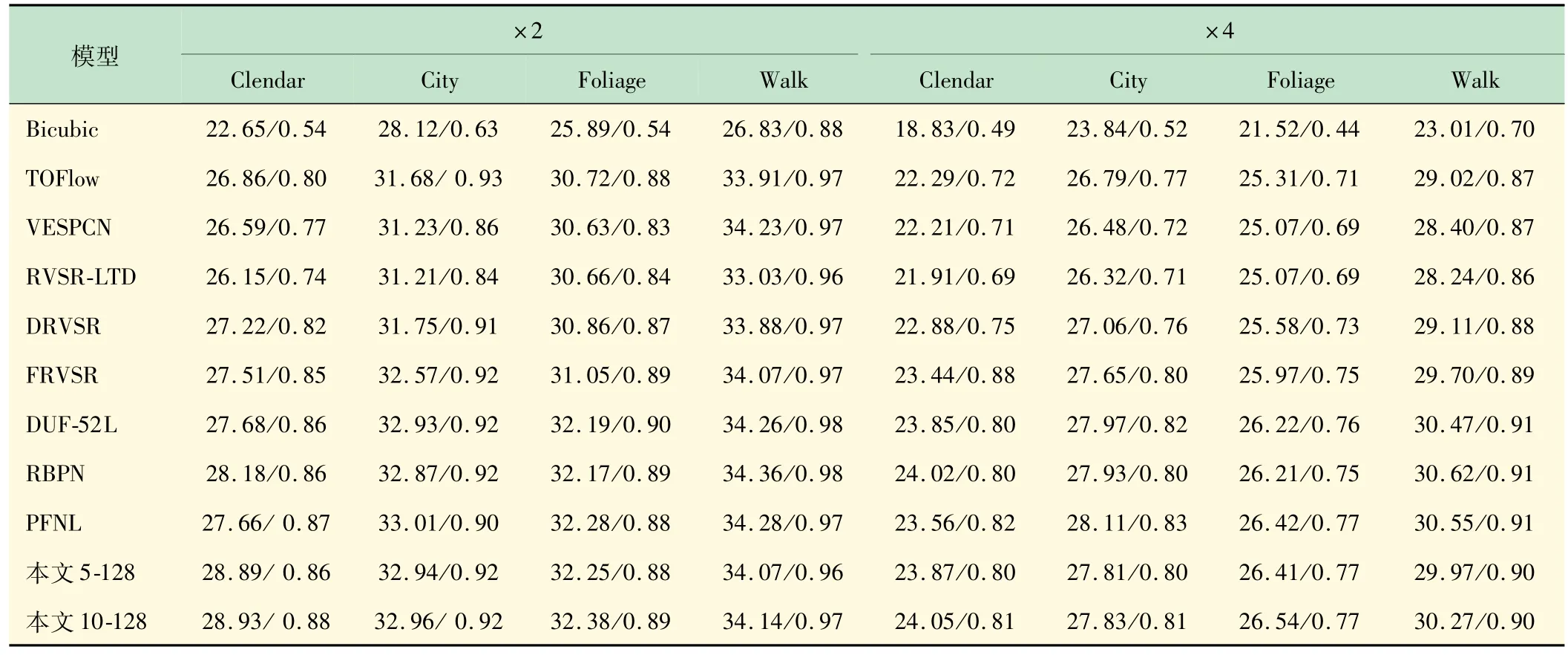

本文以通道數C=128,循環特征提取模塊數量分別取B=5 和B=10 兩種網絡結構與目前主流視頻超分辨率重建網絡VESPCN,FRVSR,RBPN、RVSRLTD[12],DRVSR[13],DUF-52L[14],PFNL[15]在VID4 數據集上進行了PSNR與SSIM評價指標對比測試,結果如表1 所示。由表1 可見,本文算法在VID4 數據集4個場景的測試中,本文5-128 和10-128 比大多數傳統算法有更高的評價指標。

表1 在VID4 上關于PSNR/SSIM性能的對比

2.2 速度對比

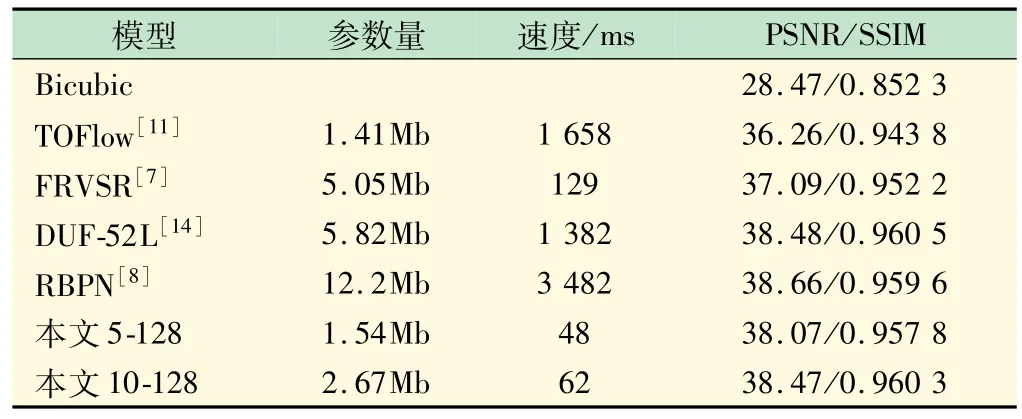

與TOFlow,FRVSR 10-128,DUF-52L,RBPN 在UDM10 數據集上進行參數量、速度對比測試,結果如表2 所示。由表2 可見,本文5-128 的方法在參數量和計算量較小的前提下,測試指標PSNR比TOFlow高1.81 dB,比FRVSR高0.98 dB;與較大的模型相比,本文10-128 結構在PSNR 上比DUF-52L 低0.01 dB,比RBPN低0.19 dB。

表2 在UDM10 上關于速度的對比測試(×4)

以320 ×180 的低分辨率視頻序列為輸入進行4倍放大輸入1280 ×720 的高分辨率視頻序列。與傳統較快速的FRVSR模型相比,FRVSR速度為129 ms/幀,本文5-128 速度為24 ms/幀,故本文的重建速度為FRVSR 的5.4 倍。本文的模型參數為FRVSR 的30.5%,在參數量上與TOFlow(1.41Mb)相近的基礎下,運行速度是TOFlow(1 658 ms/幀)模型的34.5 倍,是高性能算法DUF-52L的28.8 倍。將本文算法應用于超分辨率系統,以1 920 ×1 080 作為高分辨率圖像,取B=5,C=128 的網絡結構,可以達到24 f/s的速度實現視頻超分辨率重建。

2.3 真實效果對比

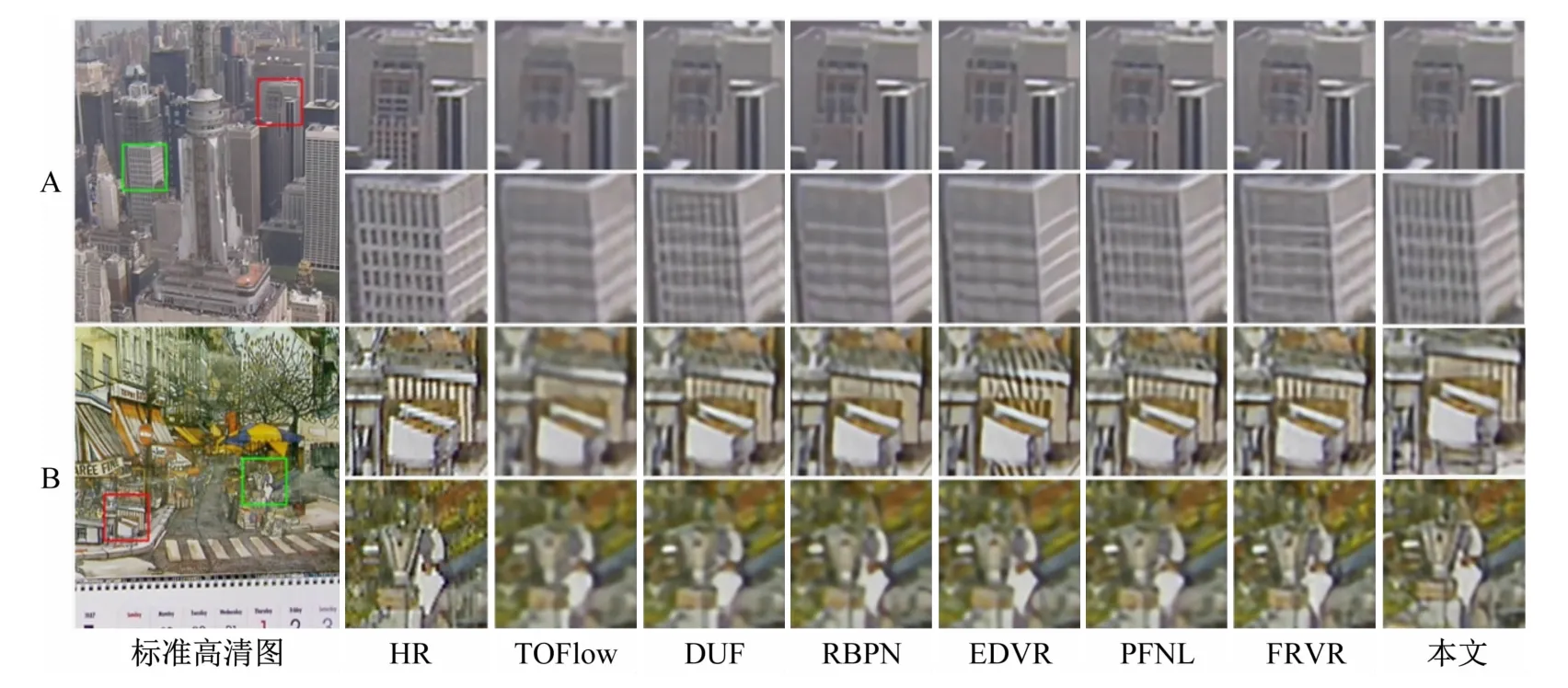

本文在效果圖上進行了對比測試,在VID4 上對幾種經典算法與本文算法的2 幅圖(共4 個場景)實際視覺效果對比,如圖3 所示。

圖3 VID4數據測試效果圖(A:第1幅圖,B:第2幅圖)

由第1、2 幅效果圖的綠框場景可見,本文算法紋理明顯比其他的算法更清晰;在第2 幅圖的紅色場景區域,所有算法相比于原始的高清圖像,均存在一定的紋理丟失。

3 結 語

本文基于RCNN,引入GhostModule代替傳統的卷積層,改進了傳統的殘差結構,并搭建一個輕量級的循環卷積神經網絡進行視頻的超分辨率重建,實現視頻的實時超分辨率重建。實驗結果表明:本新網絡的重建速度為FRVSR 的5.4 倍;在參數量上與TOFlow 相近的基礎下,運行速度是TOFlow模型的34.5 倍;是高性能算法DUF-52L的28.8 倍。

同時,本文基于前沿技術與工程應用角度,將科研項目與教育教學結合,積極探索和開設研究型教學實驗[16-17],開展了基于深度學習的實時視頻超分辨率重建研究型實驗項目設計,很好地鍛煉了學生的探索精神,培養學生運用理論知識和實踐技能探索解決復雜問題的能力,鍛煉學生積極探索精神與工程創新能力。