基于改進DeepLab v3+模型和遷移學習的高分遙感耕地提取方法

毛星 金晶 張欣 戴佩玉 任妮

摘要: 針對實際遙感耕地信息提取工作中,多源數據特征復雜、樣本標注工作繁重等導致高空間分辨率影像解譯精度不高、自動化程度不夠的問題,本研究基于DeepLab v3+模型,提出一種融合鄰域邊緣加權模塊(NEWM)和軸向注意力機制模塊(CBAM-s)的卷積網絡模型DEA-Net,結合遷移學習方法進行高分辨率遙感影像耕地信息提取。首先,在淺層網絡結構中加入鄰域邊緣加權模塊,提升高分辨率下地物的連續性,細化邊緣分割粒度;其次,在深層網絡結構中添加軸向注意力機制模塊,增加細小地物的關注權重,減少深度卷積導致地物丟失的情況;最后,采用遷移學習的思想,降低樣本標注工作量,提高模型學習能力。利用高分衛星土地覆蓋數據集(GID)數據構建源域數據集進行模型預訓練,將獲取的模型參數及權重信息遷移至大數據與計算智能大賽(BDCI)遙感影像地塊分割競賽數據集和全國人工智能大賽(NAIC)遙感影像數據集制作的2種不同目標域數據集中,微調訓練后應用于耕地信息提取研究。結果表明,本研究構建方法能夠增強模型的空間細節學習能力,提高耕地語義分割精度的同時,降低2/3以上的訓練樣本數量,為遙感耕地信息提取及農業數據智能化利用提供新的思路和方法。

關鍵詞: 耕地信息提取;遷移學習;DEA-Net;高分遙感

中圖分類號: S126?? 文獻標識碼: A?? 文章編號: 1000-4440(2023)07-1519-11

High-resolution remote sensing arable land information extraction method based on improved DeepLab v3+ model and transfer learning

MAO Xing1,2, JIN Jing1,2, ZHANG Xin1,2, DAI Pei-yu1,2, REN Ni1,2

(1.Institute of Agricultural Information, Jiangsu Academy of Agricultural Sciences, Nanjing 210014, China;2.Key Laboratory of Intelligent Agricultural Technology (Changjiang Delta), Ministry of Agriculture and Rural Affairs, Nanjing 210014, China)

Abstract: ?The complex multi-source data features and heavy sample annotation work in the practical remote sensing arable land information extraction work will lead to low accuracy and insufficient automation of high spatial resolution image interpretation. In view of the above problems, based on DeepLab v3+, we proposed a convolutional network model DEA-Net that incorporated the neighborhood edge weighting module (NEWM) and the axial attention mechanism (CBAM-s), and combined the transfer learning method to extract arable land information of high-resolution remote sensing images. First, the NEWM was added to the shallow network structure to improve the continuity of features under high resolution and refine the granularity of edge segmentation. Then, the CBAM-s was added to the deep network structure to increase the attention weight of fine features and reduce the loss of features due to deep convolution. Finally, the idea of transfer learning was adopted to reduce the sample annotation workload and improve the learning ability of the model. The source domain dataset was constructed using the Gaofen image dataset (GID) for model pre-training, and the acquired model parameters and weight information were migrated to two different target domain datasets produced by big data & computing intelligence contest (BDCI) and national artificial intelligence challenge (NAIC), and fine-tuned and trained for arable land information extraction. The results showed that the method constructed in this study could enhance the spatial detail learning ability of the model, improve the semantic segmentation accuracy of arable land, and reduce the number of training samples by more than 2/3. It can provide new ideas and methods for remote sensing arable land information extraction and intelligent utilization of agricultural data.

Key words: arable land information extraction;transfer learning;DEA-Net;high resolution remote sensing

及時、準確獲取耕地信息對于國家糧食安全、農業生產管理、農業資源保護等具有重要意義[1]。隨著農業現代化的不斷發展,中低分辨率耕地影像已無法滿足精準農業對數據質量的要求。雖然遙感影像的分辨率越來越高,但隨之而來的復雜空間特征信息對遙感影像的解譯技術提出了更高要求。

卷積神經網絡出現之前,遙感地物分類提取方法多依賴于分類特征設計和機器學習模型[2]。光譜信息和植被指數是耕地識別中最常見的特征參數[3],但不同波段組合、不同植被指數組成的分類特征使耕地識別結果具有很大隨機性。基于支持向量機(SVM)[4]、決策樹[5]、隨機森林[6]等分類器構建的機器學習模型雖然降低了分類特征設計過程中人為因素的影響,但模型的魯棒性和靈活性存在一定限制,改選數據源或者切換應用區域,均需對模型的參數及輸入特征做出調整。

近年來,深度學習技術的快速發展推動了遙感語義分割的廣泛應用。Long等[7]提出了FCN網絡,用卷積層替換最后一層全連接層,實現了像素級的圖像分類,但FCN在上采樣過程中忽略了像素之間的關系。UNet模型采用編碼器—解碼器結構,并在上采樣過程中充分利用下采樣提取的特征信息,提高了語義分割精度[8],但沒有考慮圖像的上下文信息。Chen等[9]引入了空洞金字塔池化模塊來增加網絡的上下文信息感受野,但空洞卷積會丟失部分空間信息,導致影像分割不夠精細。Yao等[10]在DeepLab v3+的基礎上引入了注意力機制,增強了特征提取能力,降低了環境信息的影響。Wang等[11]基于DeepLab v3+提出了一種名為CFAMNet的網絡模型,使用類特征注意模塊增強了類與類之間的相關性,采用多并行空洞金字塔池化結構增強了空間相關性。劉文祥等[12]采用雙注意力機制,從位置和通道2個角度增強特征信息的關注度,提升了模型的訓練速度。葉沅鑫等[13]采用R-MCN網絡結構,增大訓練的感受野,增加了淺層網絡特征權重,進一步細化了地物邊界。雖然,基于DeepLab v3+的遙感影像語義分割技術已經有了一定提高,但大多數研究針對的目標數據都是具有相同參數的少量遙感影像,模型泛化能力有限。多源遙感數據不同的成像方式、成像時間、空間分辨率、光譜波段范圍等對模型的魯棒性提出了較高要求,作物類型、灌溉方式、地形地貌、休耕輪作等也是遙感耕地自動化提取中不可避免的難點問題。

基于此,本研究擬提出一種融合鄰域邊緣加權模塊(NEWM)和軸向注意力機制模塊(CBAM-s)的高分辨率遙感耕地信息提取方法,利用鄰域邊緣加權模塊改善淺層網絡中地物的連續性,用軸向注意力機制模塊提高深層網絡中細小地物的關注度,基于遷移學習的方法優化模型參數,以期在增強語義分割效果的同時,能夠進一步提高模型的泛化能力。

1 材料與方法

1.1 數據集制作

本研究試驗數據包括兩部分,第一部分為源域數據集,用于模型的預訓練,該數據集來自于武漢大學公布的高分衛星土地覆蓋數據集(GID),包含了150張像素為7 200×6 800的高分2號衛星影像,涵蓋了5種地物類別:水域、農田、建筑、草地和林地,具體見圖1。因為研究對象是耕地,所以選擇與之相似的農田地塊作為模型預訓練對象。為方便模型的訓練,使用像素為256×256的隨機窗口從原始影像中裁剪出30 000張包含農田地塊的樣本圖像,將分類標注數據二值化為農田和其他類別,作為源域數據集,并按照8∶1∶1的比例隨機劃分為訓練數據、驗證數據和測試數據。第二部分為目標域數據集,數據來源于大數據與計算智能大賽(BDCI)遙感影像地塊分割競賽數據集(后文統稱為BDCI數據集)和全國人工智能大賽(NAIC)遙感影像數據集(后文統稱為NAIC數據集),這2個數據集的圖像大小均為256×256(圖2)。BDCI數據集是分辨率為2.0 m的遙感圖像,包含7類地物:建筑、耕地、林地、水體、道路、草地和其他地物。NAIC數據集由分辨率0.1 m至4.0 m的多種衛星及航空數據組成,包含8類地物:水體、道路、建筑、耕地、草地、林地、裸土和其他地物。分別從2個數據集中隨機選取8 000張包含耕地的圖像,將分類標注數據二值化為耕地和其他類別,作為目標域數據集,并按照2∶1∶1的比例隨機劃分為訓練數據、驗證數據和測試數據。

1.2 DeepLab v3+模型改進

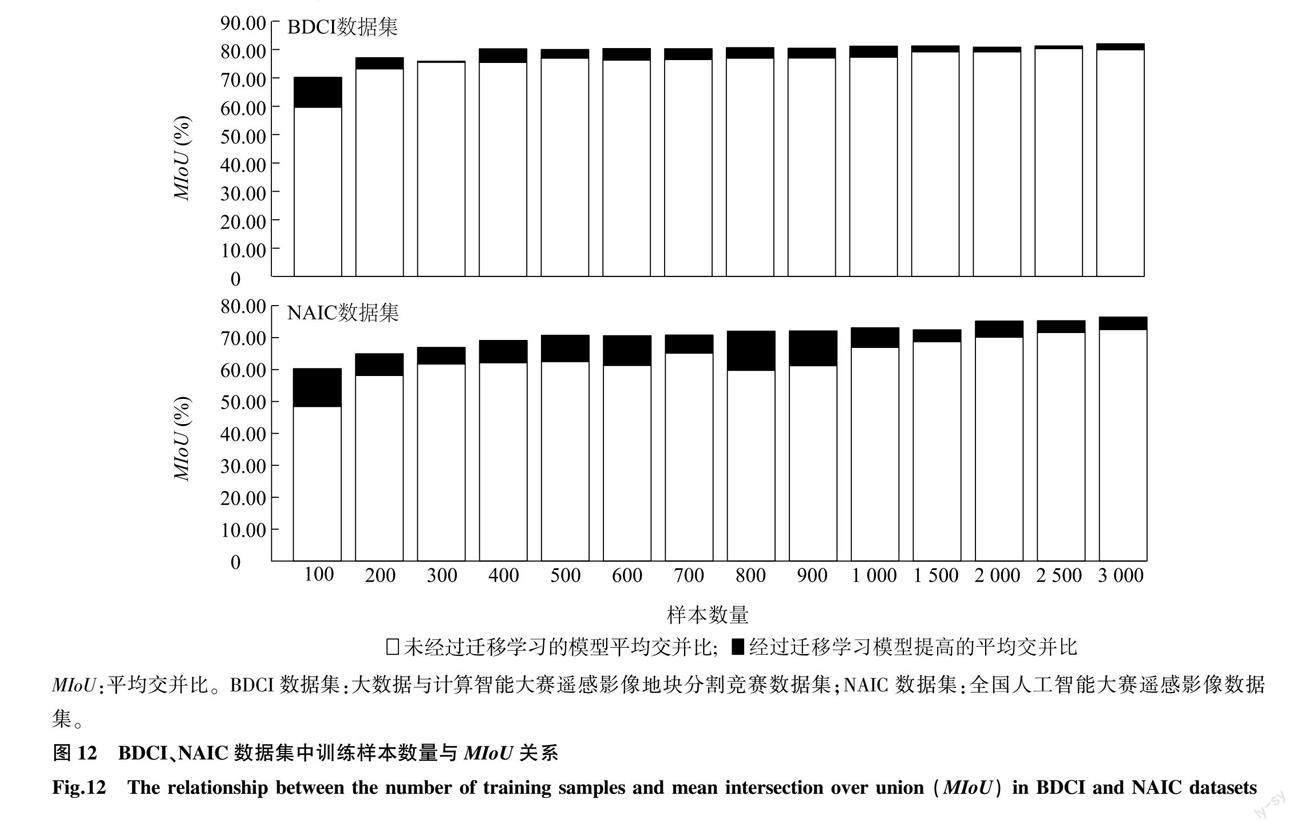

本研究提出了一種改進的DeepLab v3+模型,名為DEA-Net模型,整體采用編碼器—解碼器結構。圖3顯示,編碼器部分主要包含Xception特征提取網絡和空洞金字塔池化(ASPP)模塊,解碼器通過2次4倍上采樣得到地物的分割形狀。ASPP模塊包含1個1×1卷積和3個擴張率分別為6、12、18的3×3卷積以及1個全局平均池化層。不同擴張率的空洞卷積可以有效捕獲影像上下文特征信息,提高地物不同尺度的識別效果[14]。不同尺度影像特征包含不同的空間信息,高分辨率對應的淺層特征具有豐富的空間細節信息,有利于耕地邊界細化,但是面對遙感影像同物異譜的情況,容易出現噪聲點[15]。低分辨率對應的深層特征包含豐富的全局語義信息[16],能夠有效識別耕地的大致范圍,但下采樣過程中容易導致溝壑、田埂等信息的丟失。因此,本研究設計了鄰域邊緣加權模塊和軸向注意力機制模塊,對模型的ASPP模塊進行改進,增強模型特征提取能力,提高遙感影像的耕地信息提取精度。NEWM位于ASPP模塊前兩層卷積之后,主要用于改善高分辨率情況下地物的連續性,CBAM-s則嵌入ASPP中擴張率為12、18的3×3卷積之后,以增加深層特征對周邊要素的考慮。

1.2.1 鄰域邊緣加權模塊 卷積神經網絡中的低級特征容易忽略空間細節[17],導致語義分割的邊緣模糊不清。為此,本研究設計了鄰域邊緣加權模塊,增強耕地邊緣權重,提高空間特征關注度,改善耕地邊緣識別效果。圖4顯示,首先按照柵格圖像8鄰域規則,創建8個不同方向的卷積核,卷積核當前方向值為1,其余位置為0,然后對輸入特征進行8鄰域二維卷積,卷積結果與輸入特征相減后疊加,最后經過非線性激活生成鄰域邊緣權重特征。NEWM的計算公式可表示為:

Ne(M)=σ∑7i=0[Ei(M)-M]M(1)

其中,M表示輸入特征;Ne(M)表示鄰域邊緣加權后的輸出特征;Ei表示8鄰域二維卷積;σ表示Sigmoid函數;表示矩陣的元素乘法運算。

1.3 遷移學習

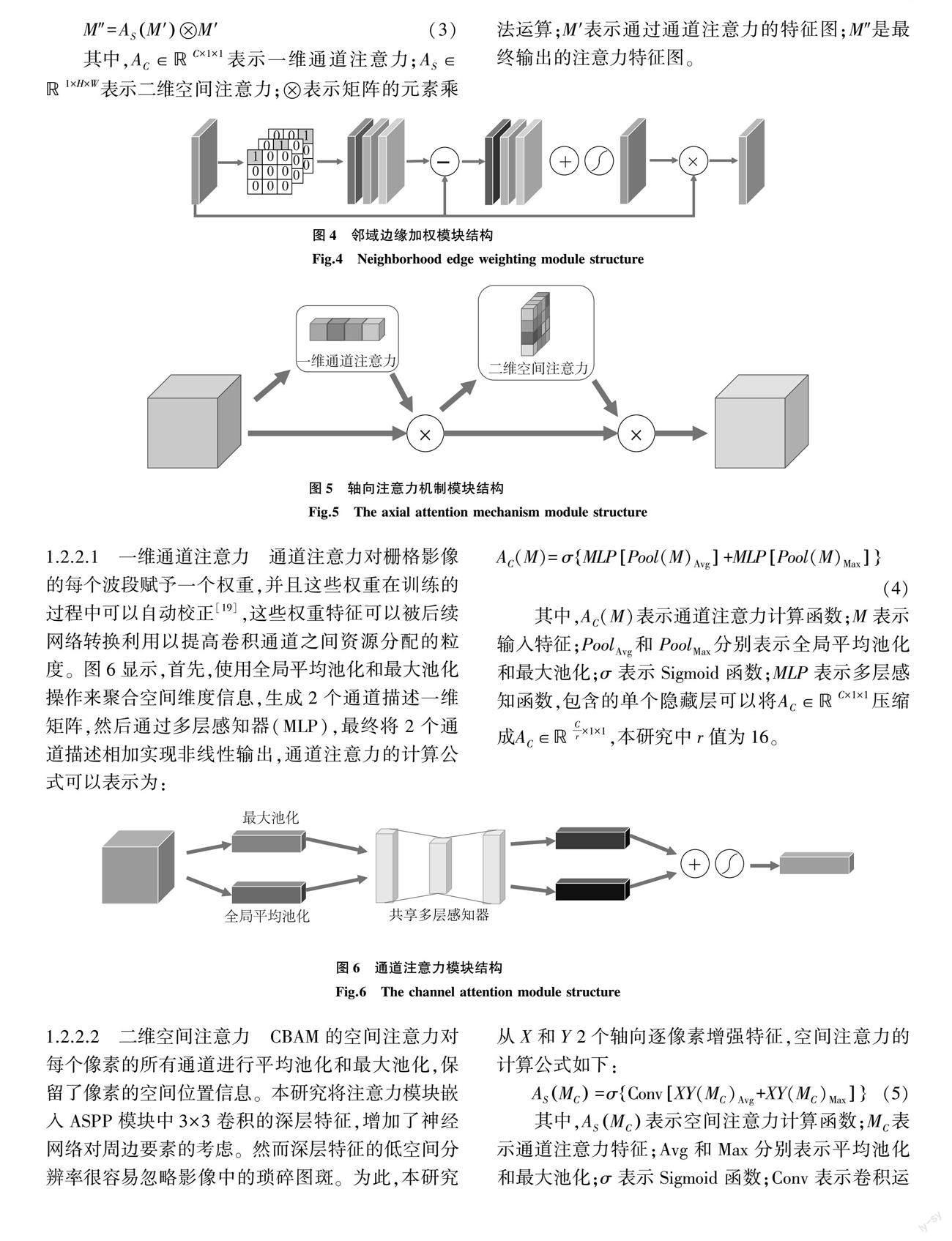

針對樣本數量有限的條件下,高分辨率遙感耕地信息提取模型存在收斂緩慢、極易過擬合等問題,遷移學習可以使用少量訓練樣本創建特征學習能力更強的深度學習模型,最大限度減少目標領域學習成本[20]。對于給定源域(DS)和學習任務(TS)以及目標域(DT)和學習任務(TT),遷移學習能夠利用在DS和TS中學習的知識幫助改進目標預測函數(FT)在DT中的使用。圖8顯示,本研究將源域數據集上預訓練獲得的特征權重和參數信息遷移至新的網絡模型,新模型最大程度復用預訓練模型的網絡結構和權重參數,通過目標域數據集微調訓練模型參數學習隱含特征,進而提高模型性能。

1.4 精度評價方法

采用像素準確率(PA)、類別平均像素準確率(MPA)、平均交并比(MIoU)和Kappa系數作為精度評價標準。PA、MPA和MIoU是圖像分割評價的重要指標,計算公式如下:

PA=∑ki=1pii∑ki=1∑kj=1pij(6)

MPA=1k∑ki=1pii∑kj=1pij(7)

MIoU=1k∑ki=1pii∑kj=1pij+∑kj=1(pji-pii)(8)

其中,PA表示像素準確率;MPA表示類別平均像素準確率;MIoU表示平均交并比;k表示類別數量;pii表示預測正確的像素數量;pij表示將i類預測為j類的像素數量;pji表示將j類預測為i類的像素數量。

Kappa系數是遙感分類中最常用的評價指標,計算公式如下:

Kappa=N∑ki=1Nii-∑ki=1Ni+N+iN2-∑ki=1Ni+N+i(9)

其中,Kappa表示Kappa系數;N表示樣本像素總數;k為類別數量;Ni+表示第i類的真實樣本像素數量;N+i表示預測為第i類的樣本像素數量;Nii表示第i類真實值和預測值一致的樣本像素數量。

1.5 試驗配置

本研究的試驗在Linux操作系統中運行,深度學習框架采用Pytorch 1.11,處理器為Intel(R) Xeon(R) Gold 5218R CPU @ 2.10 GHz,顯卡為NVIDIA A100-PCIE-40 GB。Python版本為3.8,CUDA版本為11.0。使用Adam函數作為網絡優化器,初始學習率為0.001,單次訓練的樣本個數為64。

2 結果與分析

2.1 不同網絡在源域數據集上的對比

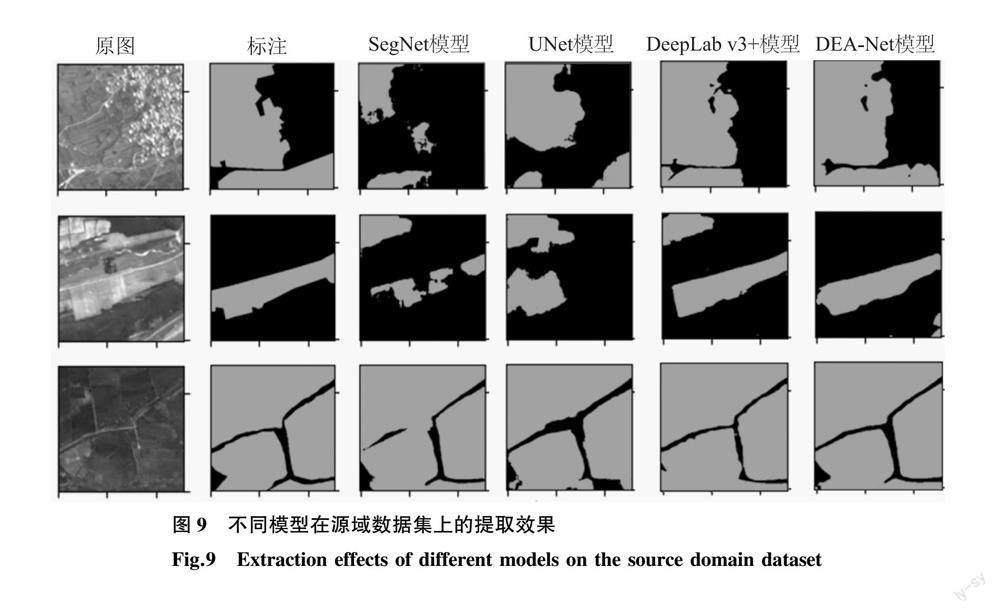

為了對比模型的特征學習能力,本研究選擇SegNet、UNet、DeepLab v3+網絡模型進行對比試驗。每種模型均利用源域數據集的訓練數據和驗證數據進行特征學習,并在測試數據上對其進行語義分割試驗以及精度評價。結果(表1)表明,DEA-Net模型相比其他網絡模型的PA、MPA、MIoU和Kappa系數均有所提高,PA、MPA、MIoU分別為88.49%、86.44%、80.11%,Kappa系數為0.833 7。與DeepLab v3+模型相比,DEA-Net模型的PA提高了1.59個百分點,MPA提高了0.87個百分點,MIoU提高了1.61個百分點,Kappa系數提高了0.013 8,說明本研究提出的DEA-Net模型在農田遙感影像語義分割中具有一定優勢。

圖9展示了不同模型的語義分割情況,SegNet模型在上采樣和下采樣過程中未曾關聯上下文信息,容易丟失空間特征,造成大片農田無法識別。UNet模型融合了編碼、解碼過程的特征,其精度有所提高,但對相似區域仍存在大量錯分、漏分情況。DeepLab v3+模型中ASPP模塊的不同空洞卷積增加了多尺度特征關聯,其結果與本研究提出的DEA-Net模型最接近。DEA-Net模型提取的農田邊界信息比其他網絡模型更加清晰,結果更接近真實標注。

2.2 模型在源域數據集上的消融分析

為了研究NEWM和CMAM-s對DEA-Net模型的影響,本研究在源域數據集上進行了消融試驗。采用DeepLab v3+模型為基準模型,逐步添加NEWM和CMAM-s,驗證各模塊的效果。從表2可以看出各模塊對模型精度的貢獻程度,CMAM-s對模型學習能力的提升效果優于NEWM。從提取結果中選取了3張代表性影像說明各模塊發揮的作用,圖10顯示,第一張影像引入NEWM后,細條狀農田被清晰識別出,且農田的邊界輪廓鮮明;第二張影像提取結果顯示,CMAM-s能夠精準確定農田的大致分布范圍;第三張影像的提取結果可以看出NEWM提高了田埂、道路的識別精度,但有部分非農田被誤認為是農田。CMAM-s可以提高連片農田分割效果,但無法區分農田中細長的其他地物,融合NEWM和CMAM-s 2個模塊的DEA-Net模型提取的農田信息基本接近實際標注范圍。消融試驗結果表明NEWM和CMAM-s均能有效提高模型的農田識別精度,但部分場景下2個獨立模塊的提取結果并不理想,而DEA-Net模型能夠融合2個模塊的優勢,提高模型精度。

2.3 目標域數據集中的耕地信息提取結果

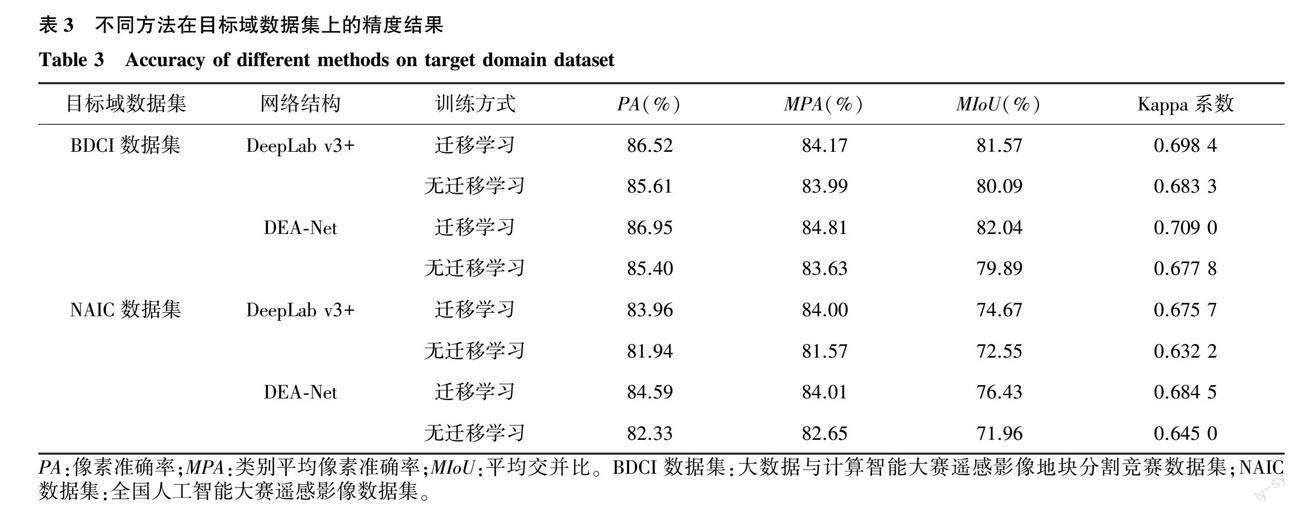

本研究利用2種目標域數據集分別進行耕地信息提取試驗,將源域數據集上訓練得到的模型遷移到目標域數據集上,通過20次迭代訓練并在目標域數據集的測試數據中進行模型效果驗證。本研究對比了DEA-Net模型和DeepLab v3+模型在目標域數據集上的精度,結果(表3)表明,BDCI數據集中DEA-Net模型遷移學習效果優于DeepLab v3+模型,經過遷移學習DEA-Net模型的PA、MPA、MIoU、Kappa系數分別提高了1.55個百分點、1.18個百分點、2.15個百分點和0.031 2。NAIC數據集中2種模型經過遷移學習后的精度提升效果更加明顯,DeepLab v3+模型的PA、MPA、MIoU、Kappa系數分別提高了2.02個百分點、2.43個百分點、2.12個百分點和0.043 5,DEA-Net模型的PA、MPA、MIoU、Kappa系數分別提高了2.26個百分點、1.36個百分點、4.47個百分點和0.039 5,DEA-Net模型的PA和MIoU提升效果更明顯,說明DEA-Net模型對于目標耕地信息的提取效果更好。

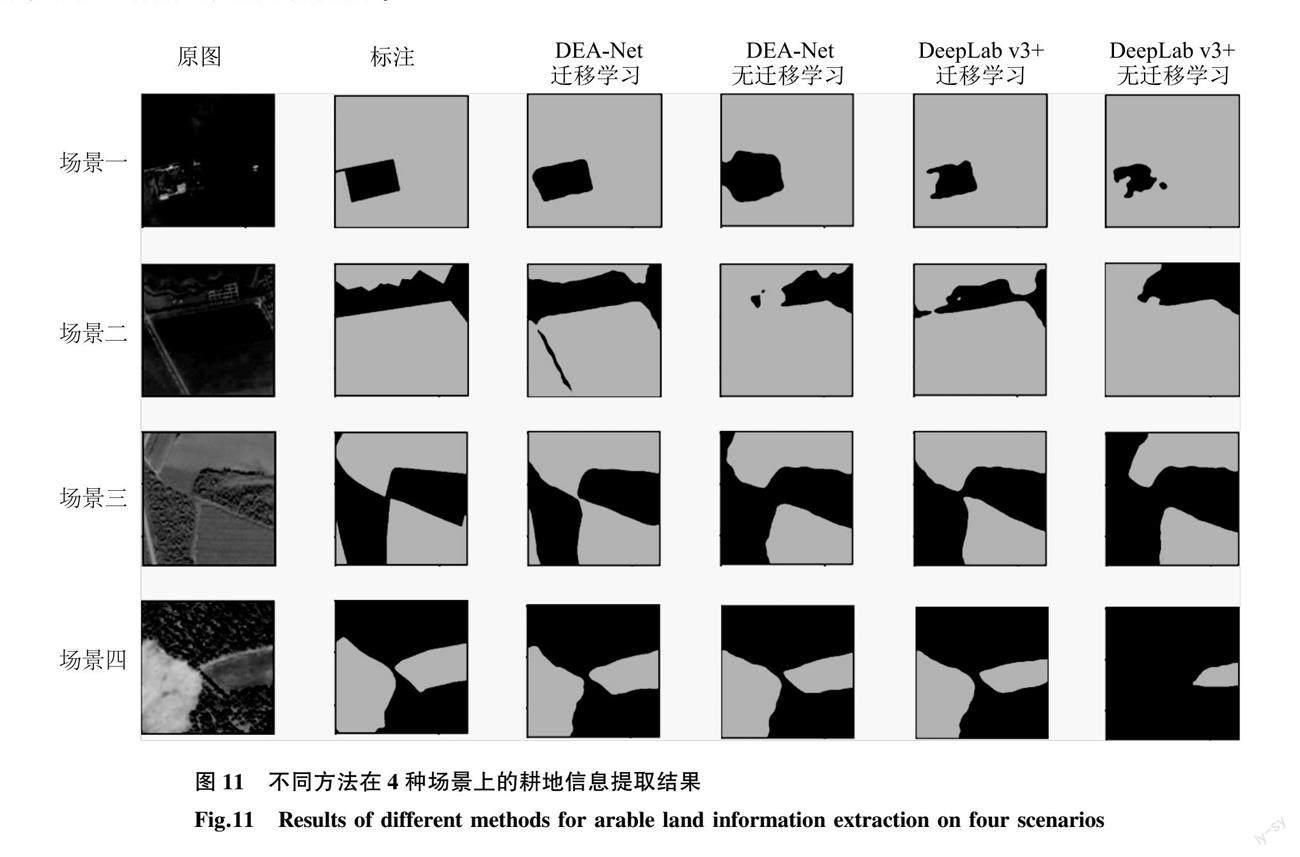

為了更直觀地展示不同方法的耕地信息提取效果,從目標域數據集中選取4個代表性場景,場景一、場景二來自NAIC數據集,場景三、場景四來自BDCI數據集。圖11顯示,場景一的耕地中間分布了一片規則房區,場景二中耕地被不規則地物隔開,場景三由耕地和林地環繞分布,場景四擁有2塊不同形態的耕地。DEA-Net模型的鄰域邊緣加權模塊能夠有效提高邊緣精度,不論是針對規則邊緣還是不規則邊緣都能較好地展示細節信息。注意力機制可以加速不同特征信息學習,提高“異物同譜、同物異譜”地物的分類準確性。此外,經過遷移學習的DEA-Net模型和DeepLab v3+模型的識別效果均明顯提高,但DEA-Net模型的耕地分割結果與實際情況更為接近。

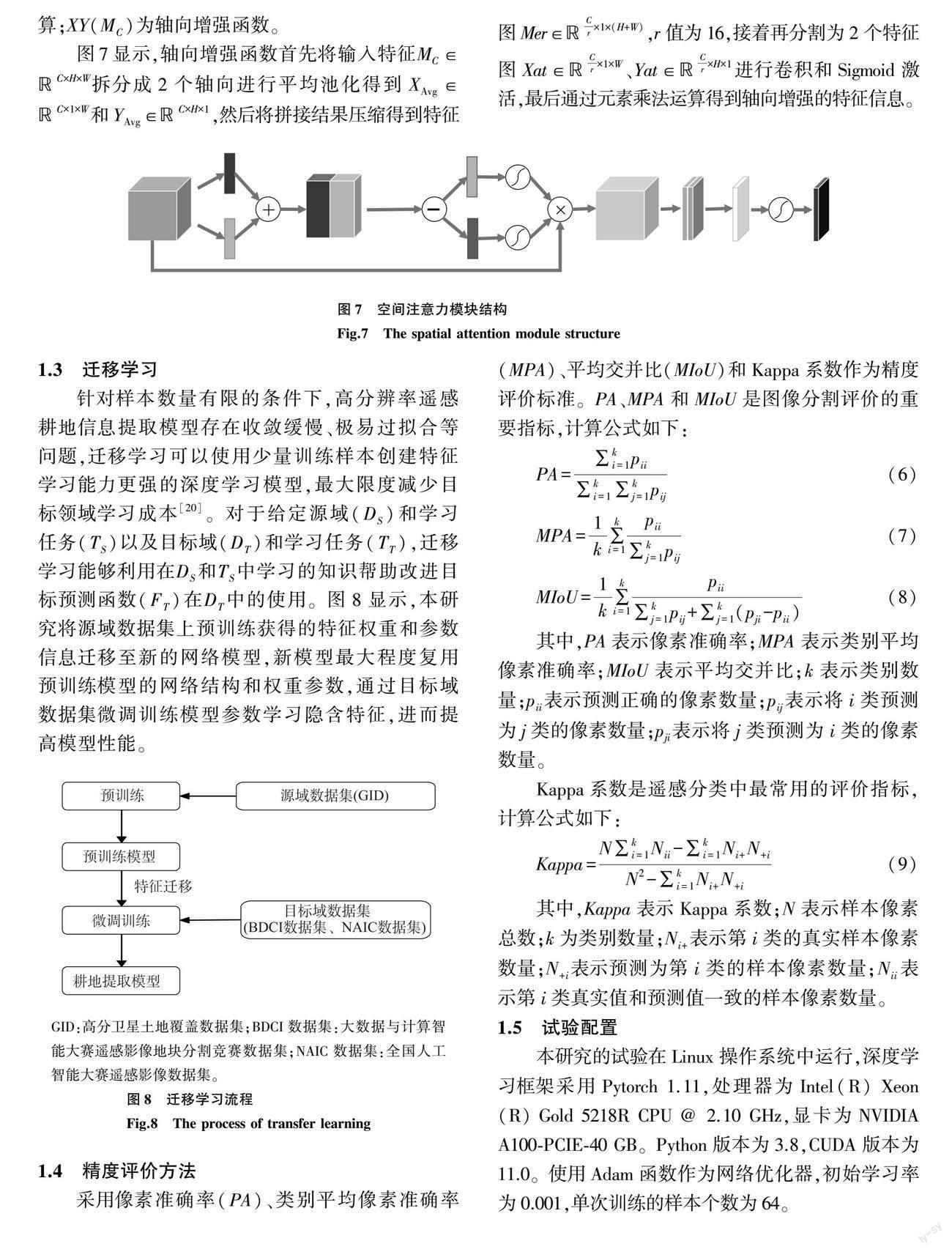

2.4 訓練樣本數量分析

為了進一步驗證DEA-Net模型在目標域數據集中的適用性,將目標域訓練數據從100張逐步增加至3 000張,驗證數據和測試數據不變,訓練迭代次數設為20次。圖12展示了BDCI數據集和NAIC數據集中DEA-Net模型的MIoU隨訓練樣本數量的變化。隨著樣本數量的增加,模型的精度整體呈增加趨勢。在BDCI數據集中,經過遷移學習后模型的MIoU達到80%時,樣本為400張影像,而未經過遷移學習的模型在1 500張樣本以后MIoU才超過79%。在NAIC數據集中,經過遷移學習的模型在樣本超過500張后MIoU達70%以上,未經過遷移學習的模型則需要2 000張樣本。因此,本研究提出的方法可以有效減少高分辨率遙感耕地分割的樣本數量。

此外,在BDCI數據集中,樣本數量超過400張以后,模型精度的提升幅度總體呈減小趨勢。在NAIC數據集中,模型精度隨訓練樣本數量的增加總體呈增加趨勢。主要原因是BDCI數據集都是分辨率相同的遙感圖像,只需少量訓練樣本就能覆蓋大部分樣本類型。NAIC數據集包含了高分一號、高分二號、高分六號、高景二號、北京二號以及航空遙感等多源影像,其空間分辨率、光譜載荷、成像方式等差異性較大,樣本類型更加豐富,少量的樣本難以覆蓋全部樣本類型。因此,遷移學習雖然能夠降低訓練樣本數量,但面對復雜多樣的實際應用仍然需要一定規模的樣本數據以擴大模型的適用范圍。

3 結論

本研究以DeepLab v3+模型為基礎,引入鄰域邊緣加權模塊和軸向注意力機制模塊,提出了一種DEA-Net網絡結構,有效提高了多尺度影像特征信息提取能力,并借助遷移學習的思想,在提高模型精度的同時,降低樣本標注成本。研究結果表明,本研究提出的DEA-Net模型在源域數據集的語義分割中相比其他幾種主流網絡模型表現更好,PA、MPA、MIoU分別為88.49%、86.44%、80.11%,Kappa系數為0.833 7。NEWM可以提高邊緣細節關注度,CBAM-s可以為深層網絡提供更加豐富的空間特征,能夠為耕地信息提取提供更多的語義信息。本研究提出的方法能夠有效解決遙感耕地信息提取中樣本數量不足的問題,減少2/3以上的樣本標注工作。

雖然本研究提出的方法可以有效應用于遙感影像耕地信息提取工作,但仍有改進的空間。首先,本研究僅利用紅、綠、藍3個波段數據,并未完全發揮遙感影像的多光譜、高光譜優勢,未來可從光譜維度方面考慮如何進一步提高模型精度。其次,本研究并未對耕地種植類型開展細化分類,未來可圍繞作物種植類型識別進行相關研究。

參考文獻:

[1] 唐華俊. 農業遙感研究進展與展望[J]. 農學學報, 2018, 8(1): 167-171.

[2] 馮權瀧,牛博文,朱德海,等. 土地利用/覆被深度學習遙感分類研究綜述[J]. 農業機械學報, 2022, 53(3): 1-17.

[3] ARANGO R B, DAZ I, CAMPOS A, et al. Automatic arable land detection with supervised machine learning[J]. Earth Science Informatics, 2016, 9: 535-545.

[4] 陳 杰,陳鐵橋,劉慧敏,等. 高分辨率遙感影像耕地分層提取方法[J]. 農業工程學報, 2015, 31(3): 190-198.

[5] 朱江洪,李江風,葉 菁. 利用決策樹工具的土地利用類型遙感識別方法研究[J]. 武漢大學學報(信息科學版), 2011, 36(3): 301-305.

[6] NITZE I, BARRETT B, CAWKWELL F. Temporal optimisation of image acquisition for land cover classification with random forest and MODIS time-series[J]. International Journal of Applied Earth Observation and Geoinformation, 2015, 34: 136-146.

[7] LONG J, SHELHAMER E, DARRELL T. Fully convolutional networks for semantic segmentation[C]. New York: IEEE Press, 2015.

[8] RONNEBERGER O, FISCHER P, BROX T. U-Net: convolutional networks for biomedical image segmentation[C]. Munich: Springer International Publishing, 2015.

[9] CHEN L, PAPANDREOU G, KOKKINOS I, et al. DeepLab: semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(4): 834-848.

[10]YAO X, GUO Q, LI A. Light-weight cloud detection network for optical remote sensing images with attention-based DeepLab v3+ architecture[J]. Remote Sensing, 2021, 13. DOI:org/10.3390/rs13183617.

[11]WANG Z, WANG J, YANG K, et al. Semantic segmentation of high-resolution remote sensing images based on a class feature attention mechanism fused with DeepLab v3+[J]. Computers & Geosciences, 2022, 158. DOI:org/10.1016/j.cageo.2021.104969.

[12]劉文祥,舒遠仲,唐小敏,等. 采用雙注意力機制 DeepLab v3+算法的遙感影像語義分割[J]. 熱帶地理, 2020, 40(2): 303-313.

[13]葉沅鑫,譚 鑫,孫苗苗,等. 基于增強 DeepLab v3網絡的高分辨率遙感影像分類[J]. 測繪通報,2021(4): 40-44.

[14]WANG Y, GAO L, HONG D, et al. Mask DeepLab: end-to-end image segmentation for change detection in high-resolution remote sensing images[J]. International Journal of Applied Earth Observation and Geoinformation, 2021, 104. DOI:org/10.1016/j.jag.2021.102582.

[15]GUO H, DU B, ZHANG L, et al. A coarse-to-fine boundary refinement network for building footprint extraction from remote sensing imagery[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2022, 183: 240-252.

[16]HUANG J, ZHANG X, SUN Y, et al. Attention-guided label refinement network for semantic segmentation of very high resolution aerial orthoimages[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2021, 14: 4490-4503.

[17]ZHU Q, LIAO C, HU H, et al. MAP-Net: multiple attending path neural network for building footprint extraction from remote sensed imagery[J]. IEEE Transactions on Geoscience and Remote Sensing, 2020, 59(7): 6169-6181.

[18]WOO S, PARK J, LEE J Y, et al. CBAM : convolutional block attention module[C]. Munich: Springer International Publishing, 2018.

[19]WANG D, CHEN X, JIANG M, et al. ADS-Net: an attention-based deeply supervised network for remote sensing image change detection[J]. International Journal of Applied Earth Observation and Geoinformation, 2021, 101. DOI:org/10.1016/j.jag.2021.102348.

[20]RIBANI R, MARENGONI M. A survey of transfer learning for convolutional neural networks[C]. Rio de Janeiro: IEEE, 2019.

(責任編輯:王 妮)