基于多尺度卷積神經(jīng)網(wǎng)絡(luò)的顯著性檢測方法

劉鑫松 孫勁光

摘要:在顯著性檢測技術(shù)迅速發(fā)展的今天,傳統(tǒng)的顯著性檢測技術(shù)對圖片提取顯著性目標(biāo)區(qū)域時常常遇到難以在復(fù)雜的圖片中準(zhǔn)確地區(qū)分物體的內(nèi)部區(qū)域和邊界,造成邊界模糊、提取精度不佳等問題。針對以上問題,根據(jù)卷積神經(jīng)網(wǎng)絡(luò)特征提取時會同時產(chǎn)生多個尺度特征的特點,提出了一種基于多尺度卷積神經(jīng)網(wǎng)絡(luò)的顯著性檢測方法。首先,圖片經(jīng)過特征提取模塊產(chǎn)生分辨率不同的特征圖;其次,由上至下建立多尺度特征連接;然后,采用降維、上采樣等方式進(jìn)行融合特征;最后,提取圖片顯著目標(biāo)區(qū)域。實驗在HKU數(shù)據(jù)集、ECSSD數(shù)據(jù)集以及PASCAL-S數(shù)據(jù)集上設(shè)計,結(jié)果表明,基于多尺度卷積神經(jīng)網(wǎng)絡(luò)的顯著性檢測網(wǎng)絡(luò)模型具有較好的顯著性檢測能力,并具有較高的執(zhí)行效率。

關(guān)鍵詞: 多尺度;卷積神經(jīng)網(wǎng)絡(luò);顯著性檢測;特征提取;特征融合

中圖分類號:TP389.1? ? ? ? 文獻(xiàn)標(biāo)識碼:A

文章編號:1009-3044(2023)31-0028-03

開放科學(xué)(資源服務(wù))標(biāo)識碼(OSID) :

0 引言

在當(dāng)今互聯(lián)網(wǎng)飛速發(fā)展的時代,計算機(jī)視覺在電影、動畫、游戲創(chuàng)作、時裝設(shè)計等方面也快速發(fā)展,數(shù)字圖像已經(jīng)成為人們重要的溝通橋梁。圖片顯著性目標(biāo)檢測作為計算機(jī)視覺領(lǐng)域的重要組成部分,被廣泛應(yīng)用在當(dāng)今社會的各個方面。例如,圖片自動剪裁[1]、圖片重定位[2]、目標(biāo)識別[3]、人體跟蹤等方面均有重要應(yīng)用。

隨著圖像處理器的發(fā)展,深度學(xué)習(xí)技術(shù)在顯著性檢測領(lǐng)域得到了越來越多的應(yīng)用。2015年,Li等人[4]最先在顯著性檢測中使用深度神經(jīng)網(wǎng)絡(luò),提出一種基于卷積神經(jīng)網(wǎng)絡(luò)的多尺度特征的顯著性檢測方法。該方法利用3個子網(wǎng)絡(luò)分別提取3個不同尺度的特征,將特征輸入網(wǎng)絡(luò)模型中進(jìn)行訓(xùn)練測試,最后將不同尺度的圖片進(jìn)行融合,得到最終結(jié)果。由于基于深度學(xué)習(xí)的檢測算法大多放棄了中心先驗、背景先驗等先驗方式,只采用卷積神經(jīng)網(wǎng)絡(luò)提取圖片特征,最終導(dǎo)致輸出圖片存在邊界模糊等問題。為了解決這一問題,Lee等人[5]在顯著性檢測算法中結(jié)合了先驗信息,低級特征對高級特征進(jìn)行補(bǔ)充,通過全聯(lián)接的神經(jīng)網(wǎng)絡(luò)融合,進(jìn)而得到最終結(jié)果。而上述研究均忽略了不同卷積層提取的特征信息之間可能存在的相互聯(lián)系對顯著性檢測的重要作用,容易出現(xiàn)不能將顯著性目標(biāo)區(qū)域從主體中分離出來、檢測結(jié)果邊界模糊等問題。

為此,本文提出一種基于多尺度卷積神經(jīng)網(wǎng)絡(luò)的顯著性檢測方法,該方法在卷積神經(jīng)網(wǎng)絡(luò)的基礎(chǔ)上進(jìn)行改進(jìn),在網(wǎng)絡(luò)結(jié)構(gòu)中增添了多尺度特征連接,能夠提取足夠且豐富的特征用于檢測,防止因為缺少足夠特征而造成檢測區(qū)域邊界模糊等問題。同時,面對過多引入全連接層造成模型復(fù)雜度和參數(shù)量增多的問題,在該方法中去掉了卷積神經(jīng)網(wǎng)絡(luò)的全連接層。這樣既可以提取更多的特征信息,又能減少計算量、加快運算速度,從而更快更精準(zhǔn)地獲取圖片顯著性目標(biāo)區(qū)域。

1 方法模型建立

1.1 方法思路

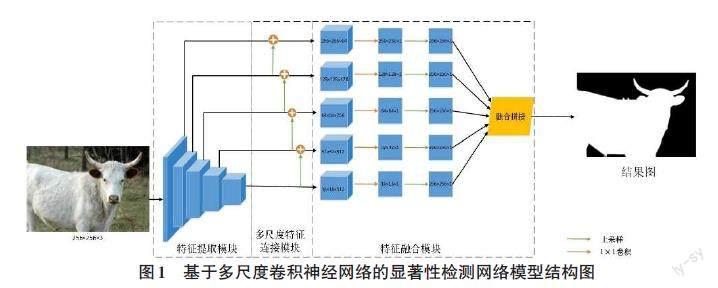

本文提出的基于多尺度卷積神經(jīng)網(wǎng)絡(luò)的顯著性檢測網(wǎng)絡(luò)模型如圖1所示,主體由特征提取模塊、多尺度特征連接模塊、特征融合模塊組成。

1) 特征提取模塊,記作:FA。特征提取模塊作為網(wǎng)絡(luò)結(jié)構(gòu)的第一部分,由13個卷積層和5個最大池化層組成。將圖片輸入網(wǎng)絡(luò)中,由特征提取模塊進(jìn)行自下而上的特征提取操作,獲得5個尺度的特征圖,表示為[{F1,F(xiàn)2,F(xiàn)3,F(xiàn)4,F(xiàn)5}]。這5個特征圖的空間分辨率按照步長2遞減,進(jìn)行下采樣操作。這些特征圖越靠近淺層卷積層,空間分辨率越高,越能較好地保留結(jié)構(gòu)和細(xì)節(jié)信息;但包含的高級語義信息也越少,例如[F2]。相反地,[F5]擁有最小的空間分辨率和最強(qiáng)的語義性,卻也具有最少的結(jié)構(gòu)和細(xì)節(jié)信息。此特征提取過程可定義為:

[Fi=f(i=1nwixi+b),i=1,2,3,4,5]? ? (1)

其中,[Fi]是圖片經(jīng)卷積池化操作后,使用ReLU激活函數(shù)進(jìn)行非線性映射操作得到該層的輸出值;[xi]為該層的輸入值;[wi]是卷積過程中的權(quán)重參數(shù);[b]是偏置值。

2) 多尺度特征連接模塊,記作:FC。為了使特征提取模塊所提取的多尺度特征圖具有更優(yōu)秀的表示能力,模型將低層特征和與其相鄰的上層特征相連接,如圖2所示,以實現(xiàn)不同層特征在一定程度上可以互相彌補(bǔ),由此,低層特征擁有上層特征的高級語義特征,上層特征也擁有了低層特征所包含的豐富細(xì)節(jié)信息。整個過程從[F5]開始迭代,直到最低層特征圖[F1]為止,依次產(chǎn)生[{F'4,F(xiàn)'3,F(xiàn)'2,F(xiàn)'1}],由此產(chǎn)生的4個特征圖不僅包含結(jié)構(gòu)和細(xì)節(jié)信息,也包含了高級語義信息,具有更強(qiáng)的表示能力。此多尺度特征連接過程定義如下:

[F'i-1=f'i(Fi)+fi(Fi-1),i=5,4,3,2]? ? (2)

其中,[F'i-1]為經(jīng)過多尺度連接操作后的輸出值;[f'i]是卷積核大小為[3×3],步長為2的反卷積層,采用雙線性插值的方式對特征圖[Fi]進(jìn)行上采樣操作,以獲得和[Fi-1]相同尺寸的特征圖;[fi]是進(jìn)行以[Fi-1]為輸入值的、卷積核大小為[1×1]的卷積操作。

3) 特征融合模塊,記作:FM。對于每個經(jīng)過多尺度特征連接的特征圖[F'i(i∈{1,2,3,4})]和[F5],均通過一個[3×3]的卷積層生成特征圖[f'i]。再經(jīng)過一個[1×1]的卷積層進(jìn)行降維操作,得到5個大小分別為[16×16]、[32×32]、[64×64]、[128×128]和[256×256]像素的特征圖。采用反卷積和雙線性插值的方法對這些特征圖進(jìn)行上采樣操作,目的是使這些特征圖與輸入的圖片具有相同的尺寸大小。因此,設(shè)置反卷積的步長分別為16、8、4、2和1,將這些相同尺寸的特征圖進(jìn)行融合拼接。最后在生成預(yù)測圖階段采用[1×1]的卷積層進(jìn)行操作,并使用Sigmoid函數(shù)將結(jié)果歸一化為[0,1]。

1.2 具體實施

完成網(wǎng)絡(luò)模型的構(gòu)建后,如何提高網(wǎng)絡(luò)模型對訓(xùn)練樣本集的學(xué)習(xí)能力成為首要任務(wù),可以通過調(diào)整超參數(shù)的方法來完成這項工作,然后再通過驗證樣本集測試生成結(jié)果、觀察網(wǎng)絡(luò)模型檢測準(zhǔn)確率。可調(diào)整的超參數(shù)主要包括:學(xué)習(xí)速率、迭代次數(shù)、數(shù)據(jù)批量大小等。

在網(wǎng)絡(luò)模型的訓(xùn)練階段,引入多尺度特征顯著性檢測損失函數(shù)來衡量顯著性預(yù)測結(jié)果與對應(yīng)的真實二值標(biāo)注圖之間的誤差。損失函數(shù)是作用在全部訓(xùn)練數(shù)據(jù)上的,取所有樣本誤差的平均值,而本文多尺度特征顯著性檢測損失函數(shù)由單邊損失和融合損失組成,所以最終的損失函數(shù)指的是單邊損失和融合損失的平均值。在預(yù)測任務(wù)中交叉熵?fù)p失函數(shù)是最有效且最常用的損失函數(shù),降低交叉熵?fù)p失就是提高網(wǎng)絡(luò)模型的預(yù)測精度,單邊損失定義為:

[L(n)side(W,w(n))=-yi∈YyilogPr(yj=1|X;W,w(n))-yi∈Y(1-yi)logPr(yj=0|X;W,w(n))]? ?(3)

其中,[X]作為訓(xùn)練數(shù)據(jù),且[X={xj,j=1…X}];[Y]為對應(yīng)的真實二值標(biāo)注圖,[Y={yj,j=1…Y},y(n)j∈0,1];[Pr]表示第N個階段i像素點處的預(yù)測值,[Pr={yj=1X;W,w(n)}];[W]為其他權(quán)重,[w]為第N個階段輸出特征的權(quán)重。

在網(wǎng)絡(luò)模型中添加了融合層去連接每個單邊,融合損失被定義為:

[Lfuse(W,w,f)=d(Y,Yfuse)]? ? ? ? (4)

其中,[d]表示預(yù)測圖與真實二值標(biāo)注圖之間的距離;[Yfuse]被定義為:

[Yfuse=n=1NfnA(n)side]? ? ? ? (5)

其中,[A(n)side] 為第N階段的輸出值,[A(n)side={a(n)j,j=1…X}];[f]為融合權(quán)重,[f={f1…fN}]。

最終采用反向傳播和隨機(jī)梯度下降算法進(jìn)行網(wǎng)絡(luò)訓(xùn)練的優(yōu)化,這也是使基于多尺度卷積神經(jīng)網(wǎng)絡(luò)的顯著性檢測網(wǎng)絡(luò)模型的總損失達(dá)到最小值的過程。模型總損失定義為:

[Ltotal=argmin(Lside(W,w)+Lfuse(W,w,f))]? ? ?(6)

通過訓(xùn)練,最終選定最佳的網(wǎng)絡(luò)參數(shù)設(shè)置。本文采用Adam[6]優(yōu)化器來訓(xùn)練網(wǎng)絡(luò)模型,學(xué)習(xí)率初值設(shè)為[10-6],動量為0.9,權(quán)重衰減為0.000 2,融合權(quán)重初始化為0.2,每一批樣本數(shù)設(shè)為20個,訓(xùn)練迭代次數(shù)設(shè)為10? 000次。

2 實驗結(jié)果分析

2.1 實驗環(huán)境設(shè)置

本文訓(xùn)練模型時所設(shè)置的實驗環(huán)境如表1所示。

2.2 實驗數(shù)據(jù)集

通過構(gòu)建基于多尺度卷積神經(jīng)網(wǎng)絡(luò)的顯著性檢測網(wǎng)絡(luò)模型來驗證本文方法的有效性,在HKU數(shù)據(jù)集、ECSSD數(shù)據(jù)集以及PASCAL-S數(shù)據(jù)集上進(jìn)行訓(xùn)練實驗,通過比較實驗進(jìn)行性能評估。其中,HKU數(shù)據(jù)集包含超過 4 447張圖像的大型數(shù)據(jù)集,且大多數(shù)圖像具有低對比度并且有多個顯著性物體。ECSSD數(shù)據(jù)集包含1 000張語義上有意義但結(jié)構(gòu)復(fù)雜的圖像。PASCAL-S數(shù)據(jù)集[7]包含從PASCAL-VOC[8]分割數(shù)據(jù)集中選擇的850幅真實世界的圖像。

2.3 評估指標(biāo)

為了評估基于多尺度卷積神經(jīng)網(wǎng)絡(luò)的顯著性檢測網(wǎng)絡(luò)的性能,本文采用2種評估度量方法:F值(F-Measure) 和平均絕對誤差(MAE) [9]。

F值是利用準(zhǔn)確率和召回率確定的綜合定量指標(biāo),其計算公式為:

[Fβ=1+β2·P·Rβ2·P+R]? ? ?(7)

其中,[β]為平衡參數(shù)、[P]為準(zhǔn)確率、[R]為召回率,同時將[β2]設(shè)置為0.3來提高準(zhǔn)確度。

平均絕對誤差是用來計算模型輸出的顯著圖與真值圖之間平均像素的絕對誤差,其計算公式為:

[MAE=1h·wi=1hj=1wS(x,y)-G(x,y)]? ? (8)

其中,[h]和[w]分別代表長和高,[S(x,y)]代表顯著圖,[G(x,y)]代表真實值,[(x,y)]則代表像素點的具體位置。

2.4 實驗結(jié)果及分析

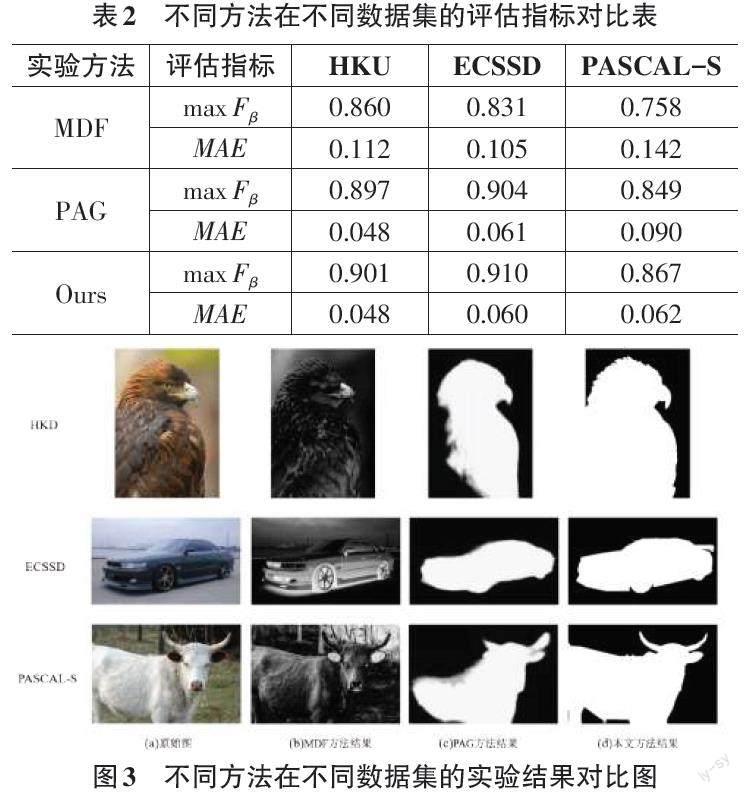

將本文方法與現(xiàn)有的顯著性檢測方法進(jìn)行對比,以評價指標(biāo)表、視覺效果圖以及運行時間表的形式展示對比實驗結(jié)果,對比方法有:MDF[10]、PAG[11]。

評估指標(biāo)對比結(jié)果如表2所示,其中[maxFβ]值越高代表顯著性檢測越精確,[MAE]值則是越小越好。從表2中可以看出本文模型的[maxFβ]值均高于其他算法,且[MAE]值均低于其他算法。綜上,本文模型的性能最優(yōu)。

圖3中給出了3種不同實驗方法,在3種數(shù)據(jù)集上進(jìn)行對比實驗的實驗結(jié)果。其中,(a)是在數(shù)據(jù)集中挑選的原始圖;(b)是MDF方法結(jié)果;(c)是PAG方法結(jié)果;(d)是本文方法結(jié)果。通過這些實驗結(jié)果可以看出,基于多尺度卷積神經(jīng)網(wǎng)絡(luò)的顯著性檢測網(wǎng)絡(luò)模型可以很好地完成對顯著性區(qū)域的檢測,且檢測結(jié)果具有更清晰的邊界。

將本文方法與PAG、MDF方法在運行時間方面進(jìn)行了比較,結(jié)果如表3所示。可以看出,本文方法相比于其他方法更高效,每幅圖片的運行時間僅需0.03s。

3 結(jié)論

本文在卷積神經(jīng)網(wǎng)絡(luò)中加入多尺度特征連接,同時去掉卷積神經(jīng)網(wǎng)絡(luò)的全連接層,提出基于多尺度卷積神經(jīng)網(wǎng)絡(luò)的顯著性檢測方法,使用多尺度特征顯著性檢測損失函數(shù)來訓(xùn)練網(wǎng)絡(luò)。對提取圖片的顯著性區(qū)域應(yīng)用此方法,可以精準(zhǔn)地生成圖片顯著性目標(biāo)區(qū)域,并能減少生成時間,提升效率。在未來的工作中,筆者將加強(qiáng)對目標(biāo)區(qū)域邊緣的優(yōu)化,加快生成速度,并期望把基于多尺度卷積神經(jīng)網(wǎng)絡(luò)的顯著性檢測網(wǎng)絡(luò)模型應(yīng)用在更多其他的目標(biāo)檢測工作中,如多樣性目標(biāo)自由提取,滿足用戶的自由選擇多樣化需求等。

參考文獻(xiàn):

[1] 郭迎春,梁云鶴,于明,等.基于圖像分塊和優(yōu)化累積能量圖的線裁剪算法[J].電子與信息學(xué)報,2018,40(2):331-337.

[2] 李恬,柴雄力,呂曉文,等.基于深層特征學(xué)習(xí)的可壓縮感知及縫雕刻的圖像重定向[J].光電子·激光,2020,31(5):519-530.

[3] REN Z X,GAO S H,CHIA L T,et al.Region-based saliency detection and its application in object recognition[J].IEEE Transactions on Circuits and Systems for Video Technology,2014,24(5):769-779.

[4] LI G B,YU Y Z.Visual saliency based on multiscale deep features[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).IEEE,2015:5455-5463.

[5] LEE G,TAI Y W,KIM J.Deep saliency with encoded low level distance map and high level features[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).IEEE,2016:660-668.

[6] DIEDERIK P. KINGMA, JIMMY B A.A Method for Stochastic Optimization[C]//Proceedings of International Conference on Learning Representations San Diego,CA,USA.2015.

[7] LI Y,HOU X D,KOCH C,et al.The secrets of salient object segmentation[C]//2014 IEEE Conference on Computer Vision and Pattern Recognition.IEEE,2014:280-287.

[8] EVERINGHAM M,GOOL L,WILLIAMS C K,et al.The pascal visual object classes (VOC) challenge[J].International Journal of Computer Vision,2010,88(2):303-338.

[9] BORJI A,CHENG M M,JIANG H Z,et al.Salient object detection:a benchmark[J].IEEE Transactions on Image Processing,2015,24(12):5706-5722.

[10] LI G B,YU Y Z.Visual saliency based on multiscale deep features[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).IEEE,2015:5455-5463.

[11] ZHANG X N,WANG T T,QI J Q,et al.Progressive attention guided recurrent network for salient object detection[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.IEEE,2018:714-722.

【通聯(lián)編輯:唐一東】