改進(jìn)U-Net模型的無人機(jī)影像在建道路分類

胡榮明,魏青博,競霞,廖雨欣,任樂寬

(西安科技大學(xué) 測繪科學(xué)與技術(shù)學(xué)院,西安 710054)

0 引言

道路作為一種基礎(chǔ)性設(shè)施,是我國交通系統(tǒng)的重要組成部分[1],獲取及時而完備的道路數(shù)據(jù)信息在數(shù)字城市建設(shè)、經(jīng)濟(jì)城市發(fā)展和無人自動駕駛等領(lǐng)域發(fā)揮著重要作用[2]。無人機(jī)遙感技術(shù)的出現(xiàn)在道路等地表附著物精細(xì)化量測的發(fā)展中至關(guān)重要[3],當(dāng)前,國家在道路建設(shè)上不斷加大投資力度,呈現(xiàn)出逐年增長狀態(tài)。在道路工程建設(shè)中,項目進(jìn)度的管理是一個非常重要的環(huán)節(jié),它直接關(guān)系到項目建設(shè)工期、成本控制以及質(zhì)量目標(biāo)的具體實(shí)現(xiàn)[4]。在道路建設(shè)項目的施工過程中,施工進(jìn)度與實(shí)際管理進(jìn)度間的不協(xié)調(diào)會影響工程的建設(shè)和效益。為了滿足城市道路建設(shè)項目精細(xì)化管理的需要,利用無人機(jī)影像分類提取城市在建道路信息和檢測分析道路建設(shè)情況,可以提高道路建設(shè)和管理的質(zhì)量,為在建道路項目的施工進(jìn)度監(jiān)測提供參考依據(jù),促進(jìn)項目高效實(shí)施與完成,從而實(shí)現(xiàn)更好的社會效益和經(jīng)濟(jì)效益。

近年來,隨著學(xué)者們采用深度學(xué)習(xí)方法實(shí)現(xiàn)遙感影像信息提取的研究不斷深入[5],深度學(xué)習(xí)模型針對遙感影像道路信息提取領(lǐng)域產(chǎn)生了越來越多的應(yīng)用研究[6]。目前,用于遙感影像語義分割的最佳架構(gòu)之一是U-Net模型[7]。U-Net網(wǎng)絡(luò)在編碼部分借助兩卷積層完成特征提取,之后使用一個平均池化層進(jìn)行下采樣操作[8]。ResNet網(wǎng)絡(luò)則采用添加快捷機(jī)制的手段進(jìn)而提升網(wǎng)絡(luò)訓(xùn)練的深度,有效解決了梯度消失問題,同時加速了網(wǎng)絡(luò)的收斂[9]。Zhang等[10]提取ResNet和U-Net模型的優(yōu)勢,提出針對道路提取應(yīng)用的深度殘差U-Net模型,優(yōu)化了深層模型的訓(xùn)練,但該方法受訓(xùn)練數(shù)據(jù)集的影響較大,且單一模型提升的精度有限。王卓等[11]提出基于U-Net改進(jìn)的深度神經(jīng)網(wǎng)絡(luò),借助Batch Normalization與Dropout解決訓(xùn)練中過擬合現(xiàn)象,但對建筑密集、陰影及樹木遮擋區(qū)域的提取效果欠佳。葛小三等[12]提出基于DeeplabV3+語義分割的深度學(xué)習(xí)提取道路的方法,借助融合多孔空間金字塔池化的方法,提高了道路邊界的劃分性能,提取結(jié)果F1分?jǐn)?shù)達(dá)到87.27%,但模型結(jié)構(gòu)精度提升有限。楊佳林等[13]提出結(jié)合上下文信息與注意力機(jī)制的U-Net道路分割模型,提升網(wǎng)絡(luò)對于道路邊緣區(qū)域的分割效果,但召回率僅84.72%,模型泛化能力需要提高。何哲等[14]提出采用混合尺度注意力的U-Net網(wǎng)絡(luò)提取道路方法,增強(qiáng)對跨度大、狹窄道路的分割效果,但模型交并比為65.60%,仍有待研究提高。綜上,盡管深度學(xué)習(xí)具有極強(qiáng)的局部信息提取能力,但在遙感影像道路提取領(lǐng)域中,當(dāng)前的特征提取結(jié)構(gòu)、注意力機(jī)制與空間金字塔池化模塊仍有改進(jìn)的余地,而在建道路往往還具有背景復(fù)雜、道路遮擋多、變化程度大等特點(diǎn),因此建設(shè)完成的道路提取模型在無人機(jī)影像中提取在建道路適用性較差,不可直接遷移,需要進(jìn)一步研究與改善。

針對以上問題,本文提出一種基于改進(jìn)的U-Net無人機(jī)影像在建道路提取方法,該方法以U-Net模型為基礎(chǔ),在下采樣階段逐層用多尺度骨干網(wǎng)絡(luò)結(jié)構(gòu)(Res2net)模塊保存細(xì)節(jié)信息及更深層次的特征信息;同時,引入輕量級雙注意力機(jī)制(convolutional block attention module,CBAM)并聯(lián)結(jié)至解碼各層次階段,沿著淺層特征的通道維度和空間維度,并行對輸入的特征圖進(jìn)行重新校準(zhǔn),在抑制背景信息的同時,增強(qiáng)在建道路信息的關(guān)注程度。另外,加入改進(jìn)的密集空洞空間金字塔池化模塊(Dense ASPP),獲取多尺度特征進(jìn)而增強(qiáng)局部模糊特征的識別能力。本文改進(jìn)方法有效將在建道路高維度與低維度信息融合,提升道路邊緣區(qū)域的分割效果。

1 數(shù)據(jù)來源與預(yù)處理

1.1 數(shù)據(jù)來源

本文使用的無人機(jī)影像采集于陜西省西安市歐亞三路至歐亞六路區(qū)間的廣運(yùn)潭大道。采集數(shù)據(jù)時,歐亞三路至歐亞六路區(qū)間的道路處于施工階段,無人機(jī)的兩個飛行時段分別為2021年7月25日和8月1日,數(shù)據(jù)采集平臺為大疆精靈4型旋翼無人機(jī),獲取數(shù)據(jù)期間天氣晴朗,地面風(fēng)速小于3級,陽光充足,適于無人機(jī)航拍。無人機(jī)飛行參數(shù)設(shè)置為高度150 m,航向重疊度和旁向重疊度均為80%。

1.2 在建道路結(jié)構(gòu)層分類

城市道路工程中,依據(jù)道路工藝結(jié)構(gòu)與建設(shè)階段,在建道路結(jié)構(gòu)層主要可劃分為3層:土基層、基層、面層[15]。面層位于整個路面結(jié)構(gòu)的最上層,其表面具有良好的抗滑性和平整度。路基層位于面層之下,土基之上,強(qiáng)度較高,剛度較大,并有足夠水穩(wěn)性。土基層是道路的基礎(chǔ),位于基層之下,是經(jīng)過開挖或填筑而形成的土工構(gòu)筑物。同時,在道路影像中,工程材料堆放往往會導(dǎo)致在建道路面層、基層和土基分類錯誤,導(dǎo)致提取結(jié)果出現(xiàn)較大誤差,因此,將其分類作為單獨(dú)類別進(jìn)行提取分析。各道路階段類別對應(yīng)的建設(shè)材料及影像特征如表1所示。

表1 城市道路各建設(shè)階段類別對應(yīng)材料及影像特征

1.3 數(shù)據(jù)處理與數(shù)據(jù)集創(chuàng)建

將無人機(jī)采集數(shù)據(jù)整理后,使用Agisoft Metashape Professional數(shù)據(jù)處理軟件,對原始的航拍數(shù)據(jù)進(jìn)行處理得到研究區(qū)DOM數(shù)據(jù)。兩期影像的空間分辨率分別為3 cm、4 cm,有紅、綠、藍(lán)3個通道。處理獲取的影像表明,研究期間包括道路土層、基層、面層各階段的施工情況,同時,在建道路部分道路形狀復(fù)雜,包括工程用料、施工器械、建設(shè)廢料等的遮蓋干擾,較好地反映了真實(shí)工程環(huán)境下在建道路的特點(diǎn)。

本文在建道路分類模型屬于監(jiān)督學(xué)習(xí)類型,訓(xùn)練樣本為人工標(biāo)注的語義圖像,采集生成影像不具有標(biāo)簽和語義特征,借助ArcGIS工具進(jìn)行分類影像語義標(biāo)注,將影像裁為512像素×512像素的圖像塊,標(biāo)注0代表背景值,1代表道路面層,2代表在建基層,3代表在建土層,4代表工程材料,制成與之一一對應(yīng)的真實(shí)道路標(biāo)簽,獲得共3 360幅影像數(shù)據(jù),根據(jù)8∶1∶1比例劃分為訓(xùn)練集、驗(yàn)證集與測試集。

2 模型構(gòu)成

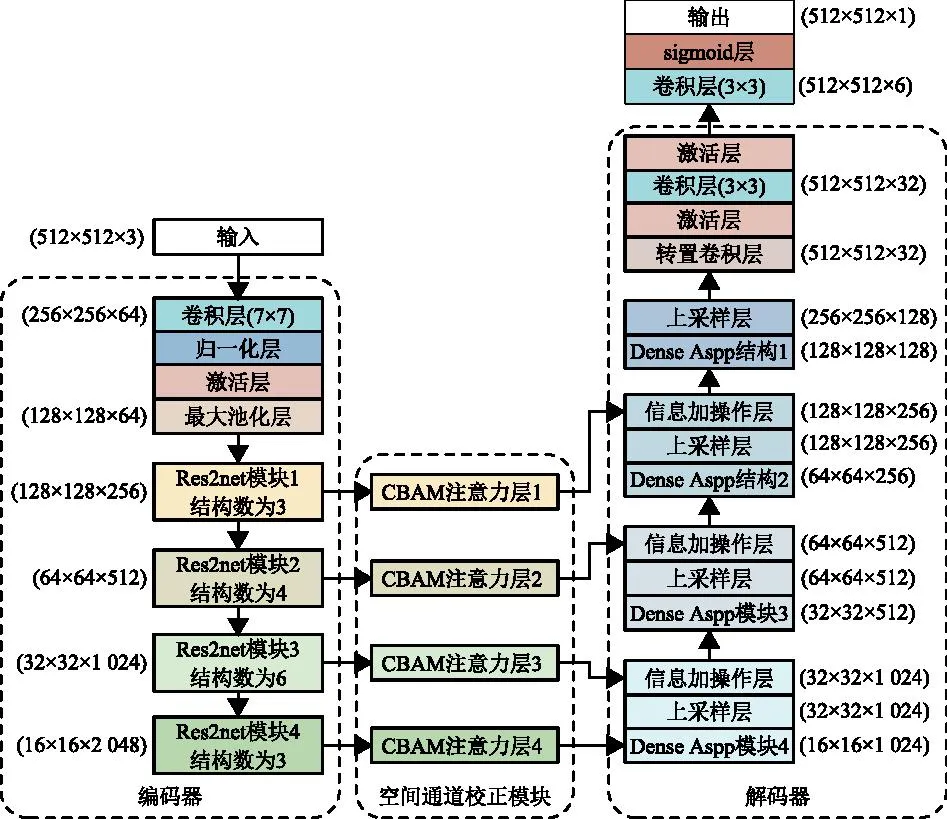

本文模型的編碼器單元采用Res2net網(wǎng)絡(luò)獲取圖像特征,引入CBAM雙注意力機(jī)制,實(shí)現(xiàn)特征通道維度和空間維度的平衡。利用Dense Aspp模塊融合不同區(qū)域特征,獲取更加豐富的上下文信息,增強(qiáng)模型的分割性能,將注意力機(jī)制模塊的輸出特征進(jìn)行上采樣并與特征提取網(wǎng)絡(luò)最后階段特征信息拼接,采用卷積操作進(jìn)行特征融合與通道調(diào)整,最后經(jīng)過上采樣操作和像素分類運(yùn)算獲取預(yù)測圖像,對圖像進(jìn)行分類。圖1為改進(jìn)U-Net在建道路提取分類模型結(jié)構(gòu)示意圖。

圖1 改進(jìn)U-Net城市在建道路提取分類模型結(jié)構(gòu)

2.1 特征編碼模塊

由于建設(shè)道路地物種類較多且數(shù)量龐大,在建道路無人機(jī)影像整體與局部特征信息結(jié)構(gòu)繁雜,傳統(tǒng)U-Net模型借助23層卷積結(jié)構(gòu),不能充分提取在建道路無人機(jī)影像中的地類間深度信息,而Res2net結(jié)構(gòu)可以在更細(xì)粒度級別上提取捕捉多尺度特征,提取建設(shè)道路的深度語義信息。為了提取保存每層次細(xì)節(jié)信息及更深層次的特征信息,在模型下采樣階段,本文使用Res2net模塊逐層替換U-Net編碼層,進(jìn)而基于50層卷積結(jié)構(gòu)將最深層特征圖下采樣倍率加深至32。同時,用更小的濾波器組替換原有通道的3×3卷積層,以類殘差的層次化方式連接增加輸出特征所能代表的尺度的數(shù)量,使感受野能夠在更細(xì)粒度級別上的變化捕獲細(xì)節(jié)和全局特性。

2.2 卷積注意力模塊

為了保證模型的運(yùn)行速度和防止計算機(jī)顯存溢出,如圖1所示,本文將CBAM模塊橋接與Res2net各階段層數(shù)據(jù)模塊,按序于通道和空間維度借助分派計算權(quán)重的方法強(qiáng)調(diào)在建道路特征,在減輕背景數(shù)據(jù)影響的同時,提高網(wǎng)絡(luò)提取分類預(yù)測能力,保障模型運(yùn)行的穩(wěn)定性。CBAM結(jié)構(gòu)最初于通道維度對表層特征數(shù)據(jù)同時采用全局最大池化及全局平均池化操作,針對特征矢量借助全連接層分配權(quán)重數(shù)據(jù),增強(qiáng)通道維度特征信息,之后于空間維度針對通道域獲取的特征矢量完成最大池化和平均池化壓縮,獲得二維特征矢量,采用卷積分配權(quán)重,進(jìn)行空間維度在建道路特征信息數(shù)據(jù)增強(qiáng)。CBAM結(jié)構(gòu)內(nèi)部運(yùn)行與變化見圖2。

圖2 CBAM注意力機(jī)制

2.3 金字塔池化模塊

無人機(jī)影像中建設(shè)道路不同階段間的邊界情況復(fù)雜零散,同時模型編碼器增加了提取特征信息深度,原U-Net解碼器無法有效滿足特征信息上采樣計算與拼接要求,不能充分獲取建設(shè)道路邊界細(xì)節(jié)信息。本文在特征解碼部分加入密集空洞空間金字塔池化結(jié)構(gòu),見圖3,為滿足編碼器第4層Res2net結(jié)構(gòu)數(shù)為6的情況,將擴(kuò)張卷積塊增至5個,每個擴(kuò)張卷積塊結(jié)構(gòu)一致,膨脹率不同。擴(kuò)張卷積塊均具有兩層卷積,首層是普通卷積層,針對輸入數(shù)據(jù)完成卷積獲取特征信息,可保證輸出通道數(shù)恒定,有效控制網(wǎng)絡(luò)模型大小。第2層卷積是擴(kuò)張卷積層,本文擴(kuò)張率增加,選取3、6、12、18、24,對影像進(jìn)行特征提取,擴(kuò)張卷積塊的擴(kuò)張率為逐層提高,見圖3。前層擴(kuò)張卷積塊的輸出特征信息皆與預(yù)特征信息堆疊后進(jìn)入下層卷積塊,最終獲取覆蓋范圍更廣且信息密集的在建道路特征。

圖3 密集空洞空間金字塔池化結(jié)構(gòu)

2.4 交叉熵?fù)p失函數(shù)

損失函數(shù)用于量度預(yù)測值與真實(shí)值之間的差異程度,本文改進(jìn)U-Net的道路提取模型采用交叉熵?fù)p失函數(shù)(cross entropy loss)進(jìn)行訓(xùn)練,表達(dá)如式(1)所示。

(1)

在遙感影像在建道路語義分割中存在一個問題,在建道路像素數(shù)量遠(yuǎn)小于背景像素數(shù)量,就會使得模型嚴(yán)重偏向于背景,導(dǎo)致分割效果較差。針對這種情況,本文采用交叉熵?fù)p失函數(shù)加入正則化懲罰項作為損失函數(shù)來解決樣本分布不均衡的問題。

3 實(shí)驗(yàn)與分析

3.1 實(shí)驗(yàn)環(huán)境與參數(shù)設(shè)置

為驗(yàn)證該算法對無人機(jī)影像城市在建道路提取的有效性,利用所制作的標(biāo)簽數(shù)據(jù)集對網(wǎng)絡(luò)進(jìn)行訓(xùn)練。實(shí)驗(yàn)硬件CPU為12核Intel(R) Xeon(R) Platinum 8255C CPU @ 2.50 GHz,GPU為NVIDIA GeForce RTX 2080Ti,11 GB顯存,開發(fā)環(huán)境為Windows下pytorch1.10.0、cuda11.3、python3.8。在模型訓(xùn)練中,初始學(xué)習(xí)率設(shè)置為0.001,最大迭代次數(shù)150次,參數(shù)在逐層優(yōu)化中達(dá)到最優(yōu),損失值降為0.05,此時完成訓(xùn)練,通過訓(xùn)練計算的模型參數(shù)進(jìn)行預(yù)測,獲取分類結(jié)果圖。

3.2 精度評價指標(biāo)

為定量分析模型提取在建道路的性能,選取總體分類精度(OA)、F1分?jǐn)?shù)(F1-score)、交并比(IoU)、宏F1均值(Macro-F1)、平均交并比(MIoU)和Kappa系數(shù)來評估改進(jìn)的U-Net模型與其他主流語義分割模型的特性。IoU為每類上真實(shí)值和預(yù)測值兩個集合交集與并集的比值,MIoU用于評價預(yù)測對象與目標(biāo)對象的匹配比例[16]。OA為所有像素分類結(jié)果與其對應(yīng)標(biāo)簽的實(shí)際類型相同的概率。F1-score是衡量各類別精確度(precision)與召回率(recall)的綜合評價指標(biāo),反映模型對正負(fù)樣本的識別和區(qū)分能力[17]。Macro-F1是對各類別F1-score的平均,用于評價多分類問題精度,不受數(shù)據(jù)不平衡影響[18]。Kappa系數(shù)為分類與完全隨機(jī)分類產(chǎn)生錯誤減少的比例。

3.3 實(shí)驗(yàn)結(jié)果及分析

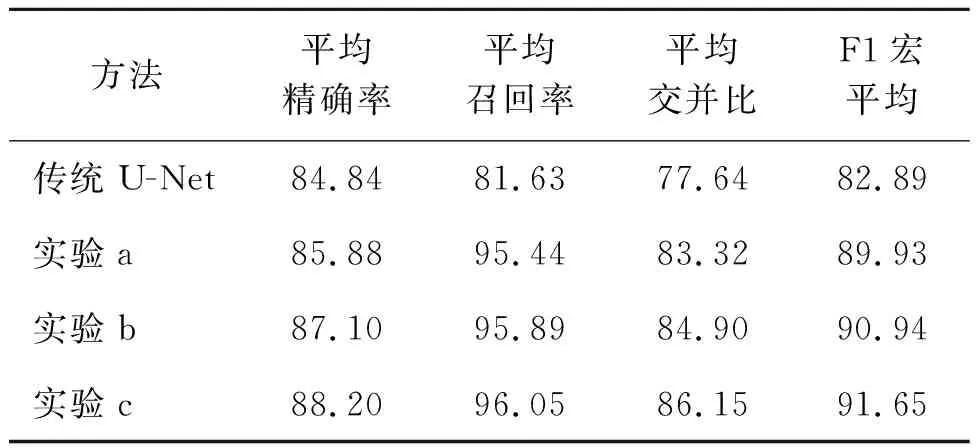

1)消融實(shí)驗(yàn)。為驗(yàn)證本文所設(shè)計改進(jìn)U-Net模型的有效性,以傳統(tǒng)的U-Net模型為基礎(chǔ),設(shè)計了將U-Net模型特征編碼模塊逐層更換為Res2net結(jié)構(gòu)的實(shí)驗(yàn)a,進(jìn)而設(shè)計在實(shí)驗(yàn)a編碼器與解碼器間橋接CBAM注意力機(jī)制的實(shí)驗(yàn)b,最后設(shè)計了在實(shí)驗(yàn)b的解碼模塊引入密集連接的Dense ASPP結(jié)構(gòu)的實(shí)驗(yàn)c,借助常用語義分割指標(biāo)進(jìn)行評價分析,消融實(shí)驗(yàn)結(jié)果見表2。

表2 消融實(shí)驗(yàn)結(jié)果分析 %

根據(jù)表2中數(shù)據(jù)可知,相較于傳統(tǒng)U-Net,實(shí)驗(yàn)a模型的平均召回率、平均交并比及F1宏平均分別提高了13.81%、5.68%和7.04%,模型精度提升效果顯著,表明采用Res2net結(jié)構(gòu)替換傳統(tǒng)U-Net模型編碼階段能夠更有效,更深層次提取影像中在建道路整體與局部特征,提升分類結(jié)果的準(zhǔn)確性。相對于實(shí)驗(yàn)a,實(shí)驗(yàn)b的平均精確率與F1宏平均分別提高了1.22%和1.01%,表明橋接CBAM模塊于編碼器和解碼器突出了在建道路特征,抑制背景數(shù)據(jù)影響,增強(qiáng)了網(wǎng)絡(luò)分類預(yù)測能力。實(shí)驗(yàn)c各項評價指標(biāo)均優(yōu)于實(shí)驗(yàn)b,說明解碼部分引入Dense ASPP增強(qiáng)了在建道路復(fù)雜邊界的分割能力,將模型提取特征有效地保存并表征,同時實(shí)驗(yàn)c較其他實(shí)驗(yàn)指標(biāo)均為最優(yōu),表明了本文改進(jìn)U-Net模型的先進(jìn)性。

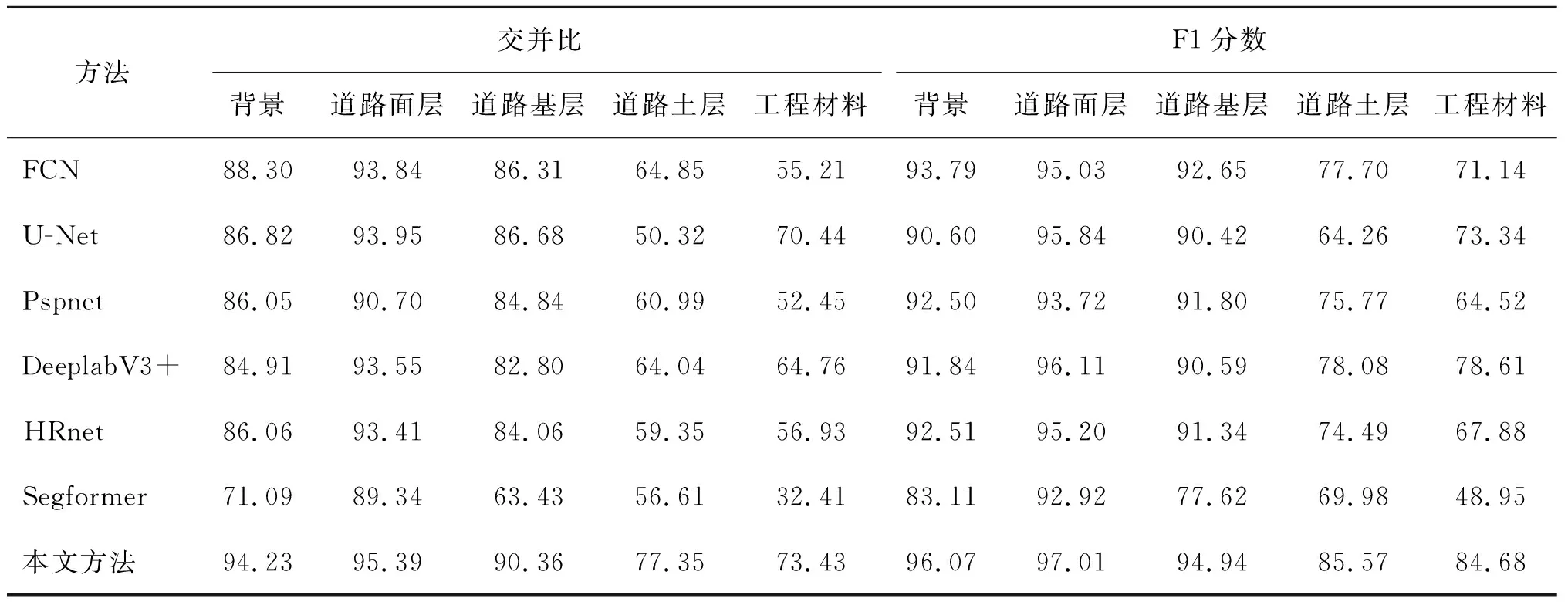

2)不同分割方法性能分析。為了進(jìn)一步驗(yàn)證改進(jìn)U-Net模型對在建道路各階段分類效果,將本文方法與經(jīng)典U-Net、FCN、DeeplabV3+等網(wǎng)絡(luò)進(jìn)行訓(xùn)練比較,訓(xùn)練成果的各項參數(shù)評價見表3。

表3 在建道路分割方法對比

由表3可知,在MIoU方面,傳統(tǒng)U-Net算法的平均交并比為77.64%,對比模型中平均交并比較高的有DeeplabV3+(78.01%)、FCN(77.70%)、HRnet(75.96%),本文改進(jìn)U-Net模型的平均交并比為86.15%,較傳統(tǒng)U-Net、DeeplabV3+、FCN和HRnet模型分別提高了8.51、8.14、8.45和10.19個百分點(diǎn)。在Macro-F1方面,傳統(tǒng)U-Net算法F1宏平均為82.89%,對比模型中F1宏平均較高的有DeeplabV3+(87.05%)、FCN(86.06%)、HRnet(84.28%),本文改進(jìn)U-Net模型的平均交并比為91.65%,較傳統(tǒng)U-Net、DeeplabV3+、FCN和HRnet模型分別提高了8.76、4.6、5.59和7.37個百分點(diǎn)。同時,在平均召回率和Kappa系數(shù)方面,本文改進(jìn)模型均優(yōu)于傳統(tǒng)U-Net、FCN、HRnet和DeeplabV3+等模型。總體來說,本文改進(jìn)U-Net模型對在建道路各階段分割精度更高,模型的可靠性和穩(wěn)定性得到提升。

選擇7種模型在測試集隨機(jī)選取部分影像進(jìn)行可視化展示,見圖4。根據(jù)不同網(wǎng)絡(luò)分割結(jié)構(gòu)比較可以看到,第1列影像中,本文模型對在建道路面層、小部分基層與土層及工程材料識別清晰,沒有出現(xiàn)其他模型的空洞情況,第2列、第3列影像表明針對大面積的在建道路面層、基層、土層,本文模型分割邊緣規(guī)整,沒有出現(xiàn)其他模型的較大凸出或凹陷現(xiàn)象。

圖4 在建道路模型分類結(jié)果可視化

第4列至第6列影像表明本文模型對工整、零散、復(fù)雜堆放的工程材料的分割上沒有出現(xiàn)其他模型的漏分錯分現(xiàn)象。可視化結(jié)果進(jìn)一步表明,本文改進(jìn)的U-Net模型能有效均衡空間通道兩維度,捕捉信息間的總體相關(guān)情況,抓取上下文特征數(shù)據(jù),增強(qiáng)了特征信息表現(xiàn)力,加強(qiáng)了模型學(xué)習(xí)性能和摒除干擾能力,提高了網(wǎng)絡(luò)的精度和可靠性。

為了更準(zhǔn)確定量分析本文改進(jìn)的U-Net模型的性能,對本文模型及對比模型在道路面層、基層、土層、工程材料和背景數(shù)據(jù)的分割能力進(jìn)行對比分析,結(jié)果見表4。

表4 在建道路各類別對象分割結(jié)果 %

對比表4中道路面層、基層、土層、工程材料及背景在各方法的IoU及F1分?jǐn)?shù)可以看出,道路面層的交并比及F1分?jǐn)?shù)最高,背景、道路基層、土層次之,工程材料最低。同時,雖然整體遙感影像中背景占比最大,但損失函數(shù)正則化懲罰項有效抑制了面積對類別分類精度的影響,保證了模型對道路類別分割的準(zhǔn)確性。從實(shí)驗(yàn)結(jié)果整體比較分析可得,本文模型在道路面層、基層、土層、工程材料和背景數(shù)據(jù)的交并比、F1分?jǐn)?shù)皆優(yōu)于其他對比網(wǎng)絡(luò),說明了本文模型對提升在建道路各工藝階段的分類精度具有良好的效果。

根據(jù)不同模型的分割效果對比可知,本文改進(jìn)的U-Net方法相較于FCN、DeeplabV3+、Segformer等方法來說,對道路各工藝層邊界的識別分割程度更高,對不同尺寸的同類對象的辨識力更強(qiáng),有效捕捉獲取多層次維度信息特征,將地物邊緣信息恢復(fù)得更加詳細(xì)完整。同時,本文模型相較于傳統(tǒng)U-Net網(wǎng)絡(luò),存在的漏分及錯分現(xiàn)象更少,對道路各層的分割效果更佳。總體的比較進(jìn)一步證明了加入CBAM注意力機(jī)制,引入特征提取Res2net模塊、Dense Aspp結(jié)構(gòu)及加權(quán)損失函數(shù)的必要性。

4 結(jié)束語

本文將深度學(xué)習(xí)卷積神經(jīng)網(wǎng)絡(luò)應(yīng)用于無人機(jī)影像在建道路分類提取,為解決無人機(jī)影像背景駁雜,城市在建道路分類易被相似目標(biāo)、建設(shè)設(shè)施等信息干擾的問題,設(shè)計了改進(jìn)的U-Net網(wǎng)絡(luò)架構(gòu)。在此基礎(chǔ)上,選取道路面層、道路基層、道路土層和工程材料共4類典型在建道路工藝層,進(jìn)行7組不同分類模型的實(shí)驗(yàn)對比。本文改進(jìn)的U-Net模型的平均召回率為96.05%,平均準(zhǔn)確率為88.20%,平均交并比為86.15%,F1宏平均分?jǐn)?shù)為91.65%。通過對比實(shí)驗(yàn)證明,本文改進(jìn)的U-Net深度學(xué)習(xí)網(wǎng)絡(luò)在高分辨率無人機(jī)影像分類提取中具有較強(qiáng)的可行性和準(zhǔn)確性,可自動化提取建設(shè)道路各階段信息,為開展無人機(jī)影像在建道路施工進(jìn)度監(jiān)測提供了一種高效的智能解譯方法。同時,由于本文采用無人機(jī)影像波段數(shù)有限,特征學(xué)習(xí)豐富度受到了一定的限制,且道路進(jìn)度監(jiān)測應(yīng)用需進(jìn)一步加深量化分析等研究,后續(xù)會嘗試補(bǔ)充多通道或多源數(shù)據(jù)增加信息特征,提高模型對在建道路各階段分類效果以及提升模型在道路進(jìn)度監(jiān)測項目中的精度和可靠性。