結合密度圖回歸與檢測的密集計數研究

高 潔,趙心馨,于 健,徐天一,潘 麗,楊 珺,喻 梅,李雪威+

1.天津大學 智能與計算學部,天津 300350

2.天津大學 天津市認知計算與應用重點實驗室,天津 300350

3.天津大學 天津市先進網絡技術與應用重點實驗室,天津 300350

4.天津大學 未來技術學院,天津 300350

密集計數是視覺目標計數的一個分支,旨在通過圖像或視頻分析密集分布目標的數量及空間分布,用于人群、物料計數、動物計數等眾多場景。目前關于密集計數的研究主要分為基于檢測[1-2]以及基于密度圖[3-5]兩類方法。

基于檢測的方法有兩個分支,即傳統機器學習方法和深度學習方法。傳統方法依賴于結合人類先驗知識設計的特征工程,可解釋性好,但過程復雜,易受無關背景、陰影以及截面重疊等影響。深度學習方法依賴大量帶有邊框標注信息的數據建模,整體效果優于傳統方法,但標注信息成本極高,且仍存在漏檢率高的問題[6]。近年來局部檢測思路[7]被用于該領域,通過針對特定區域的分析,檢測和計數準確率有所提升,但物體的尺寸變化和形狀多樣限制了此類方法。如圖1所示,由左至右分別展示了深度學習方法受尺度變化、拍攝角度傾斜、遮擋導致漏檢的場景。整體上,目標檢測技術是密集技術的基礎,但把密集計數問題等價于目標檢測仍存在很多問題[8-10]。

圖1 小物體遮擋檢測效果Fig.1 Detection effect of small object occlusion

基于密度圖的方法以回歸思路為基礎,計算圖像中物體分布的密度圖,進而將密度圖映射至計數結果[11]。密度圖蘊含空間信息,且可根據密度大小反映數量,因此方法原理清晰,易于實現,被廣泛使用。但是,由于缺乏目標精確的具體位置信息,基于密度圖的方法在一些熱點領域的應用受限。

本文提出結合密度圖回歸與檢測的密集計數方法,在同一網絡結構中同時實現密度圖估計和目標定位。利用密度圖所提供的位置信息降低對標注框的依賴,利用物體檢測確定目標具體位置,二者結合可以有效提高準確率,實現優勢互補。同時,該方法不局限于截面對齊的圖像計數,有效地避免特殊位置的漏檢情況,與人工計數條件相同,具有良好的普適性。

論文的主要貢獻概括如下:

(1)提出融合密度圖回歸與目標檢測的密集計數方法,在保持計數效果穩定的條件下,提高召回率,同時自動標注目標的位置信息。

(2)提出優化的特征金字塔結構(feature pyramid networks plus,FPN-Plus),縱向融合底層高分辨特征與頂層抽象語義特征,橫向融合同尺寸的特征,豐富整體語義表達,利于密集目標檢測。

(3)提出融合注意力機制的損失函數,增強網絡對小目標物體的注意力,緩解陰影、遮擋等問題,提高對小目標的檢測能力,從而提升整體檢測效果。

1 相關工作

1.1 基于檢測的計數方法

傳統基于圖像目標檢測的計數方法依賴特征工程,即先通過融合人為先驗預設計的方法提取圖像全局或局部特征,再使用滑動窗口定位圖像中的實例。特征工程是此類方法的重點,常用的有小波、梯度方向直方圖、邊緣等特征[12]。

近年來的研究集中于消除背景、遮擋、陰影等的影響。景林等人[13]提出利用物料端面的色彩特征進行計數,該方法可濾除類似天空、綠樹等背景,但對于與物料顏色相近的背景濾除則不理想。王昱棠[14]根據物料堆放規律先驗,即由下至上物料堆放具有逐層減少的特點,通過聚類分析對計數結果進行修正,能夠避免因被其他物料包圍而導致邊緣不突出的物料被漏檢。但根據物料堆放規律計數的方法主要適用于自然擺放的物料,對于借助外力存放的物料不具有普適性。龍德帆等人[15]結合數學形態學中的骨架提取算法,利用動態規劃的方法來獲得能量泛函的全局極值,從而實現了精確提取端面輪廓,但對于成像效果較差的端面處理效果不佳。文獻[16-17]利用從行人全身提取的小波、梯度方向直方圖、邊緣等特征去檢測行人,主要學習算法有支持向量機(support vector machine,SVM)[18]、Boosting[19]和隨機森林(random forest,RF)[20]等。

近年來隨著深度學習的迅速發展,基于深度學習的目標檢測算法展現了優異的效果,兩階段的Mask RCNN(mask region-based convolutional neural network)[21],單階段的SSD(single shot multibox detector)[22]、YOLO(you only look once)[23]、RetinaNet[24]、EfficientDet[25]和基于anchor-free 的CenterNet[26]、FCOS[27]、Transformbased[28]、Swin Transformer[29]類 等在公開數據集Pascal[30]和COCO[31]上取得較大突破,并且已運用在實際的工業場景中。

目前,基于檢測的計數方法進步很大,但消除遮擋、背景等因素的干擾始終是研究熱點[32-33]。

1.2 基于密度圖估計的計數方法

基于密度圖估計的計數方法主要通過學習密度圖回歸來更新網絡模型參數,最終對密度圖進行積分從而得到密集計數結果,密度圖所提供的物體空間分布信息可用于粗定位目標。密度圖本質上是一種表示目標在某一位置存在概率的方法,在前向傳播過程中,通過比較真實密度圖和預測的密度圖之間的差異來計算損失,更新網絡參數。

基于密度圖[34]的計數模型首先需要通過分類網絡提取物體的特征。得益于卷積神經網絡(convolutional neural networks,CNN)強大的特征提取能力,此類方法的準確率也在不斷提升,其中基于全卷積網絡(fully convolutional networks,FCN)[35]的模型已成為密度估計的主流特征提取結構。研究者根據不同區域視角及密度的變化,設計了許多網絡模型如MCNN(multi-scale convolutional neural network)[36]、switch-CNN[37]、CSRNet[38]等,均有良好性能,根據不同的尺度[39],細化密度圖[40-42]。

Zhang等人提出的MCN(multi-column convolutional neural network)[43]將多列卷積神經網絡應用于單張圖像人群計數問題上,利用卷積神經網絡建立人群密度圖與人群圖像之間的非線性映射,通過獲取人群密度圖得到人群計數結果。

Laradji 等人的工作[44]提出了一個新穎的損失函數,使模型在僅有點標注的情況下學習輸出實例掩膜,這種方法由于不需要輸出物體的形狀,計算效率較高。

Idrees 等人提出的CL(composition loss)[45]同時實現對密集圖像中的人群計數、密度圖估計和定位。基于三個問題之間存在的內在聯系,CL 使優化深層卷積神經網絡的損失函數可分解,即計數可以在沒有任何有關位置信息的前提下估計物體數量,密度圖可以提供有關每個物體位置的弱信息,定位可以提供位置信息,但由于數據的標注稀疏,直接定位較難實現。

基于密度圖回歸的密集計數方法通常會獲得比檢測計數方法更好的效果,但無法精確定位目標位置。

1.3 特征金字塔網絡

目標檢測計數通常面臨遮擋、光照不均以及物體尺度變化等問題,尤其密集計數場景通常包含較多的小目標,對特征提取網絡表達語義的豐富性要求較高。特征金字塔網絡(feature pyramid networks,FPN)由Lin等人提出[46],是一種用于多尺度特征提取的有效方法。引入特征金字塔結構的網絡模型,通常具有更好的魯棒性。

特征金字塔網絡可以用于構建各種尺度的高級語義特征圖,將相同尺寸輸出的特征圖視作一個等級,多個等級堆疊形成金字塔結構。網絡訓練時,自底向上的路徑即為網絡前向傳播,自頂向下的路徑通過從較高的金字塔等級對空間上較粗糙但具有更強語義的特征圖進行上采樣,從而展現出更高分辨率的特征。

2 結合密度圖回歸與檢測的密集計數方法

本文提出一種結合密度圖回歸與檢測的密集計數方法(detection and counting method based on density map estimation,DCDM),在基于密度圖估計的密集計數網絡基礎上添加檢測定位方法實現對密集物體的檢測計數與定位。方法設計過程中,考慮到密度圖保留物體位置信息較少,提出FPN-Plus 模塊,縱向融合底層高分辨特征與頂層抽象語義特征,橫向融合同尺寸的特征,增強特征語義。同時,為進一步提升對小尺度目標的檢測效果,本文提出融合注意力機制的損失函數,實現對各個層級特征信息進行充分利用,從而加強網絡對目標物體的注意力。

2.1 基于密度圖估計的目標檢測計數模型架構

2.1.1 特征提取網絡

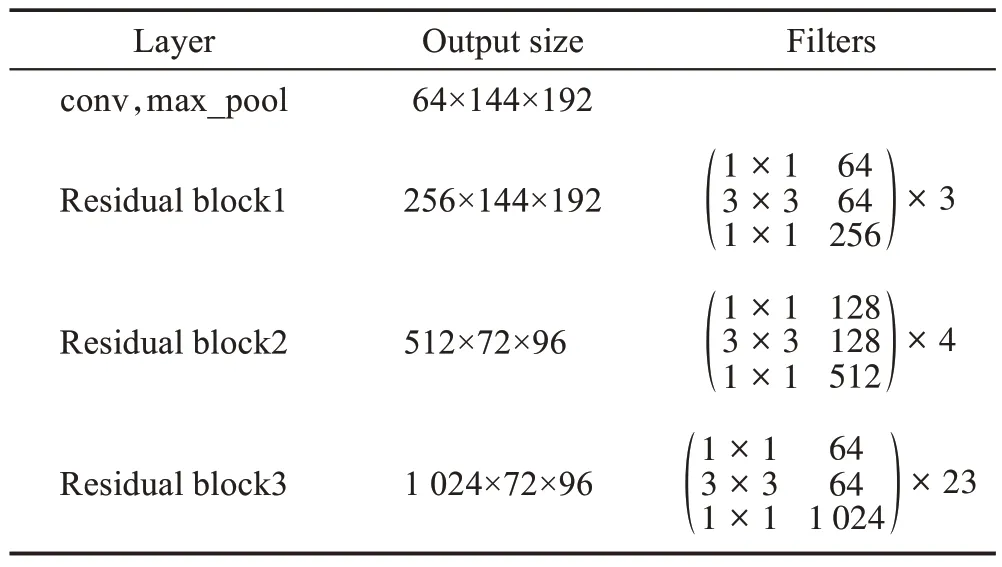

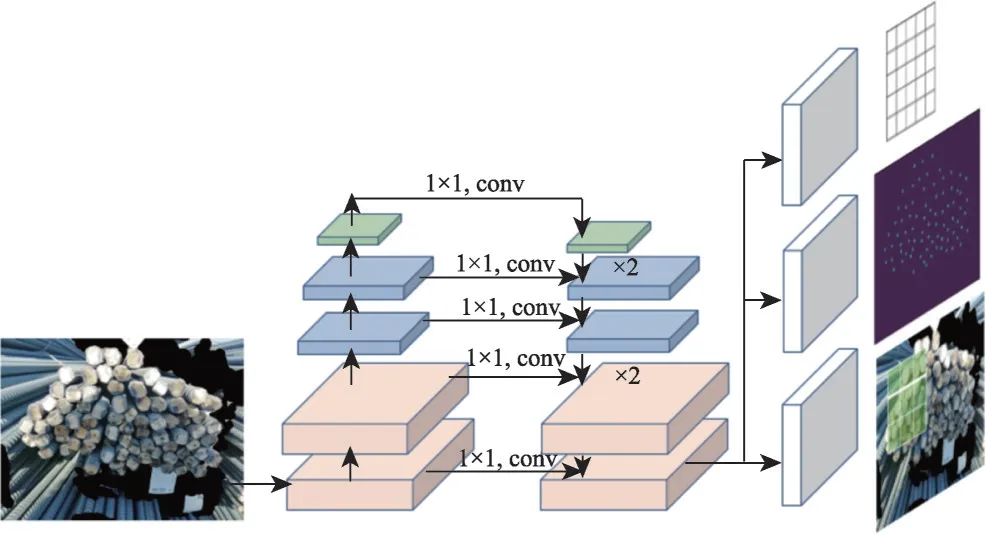

本文所提出方法基于C-3-Framework 密集計數框架[47],該框架是西北工業大學高君宇等人開發的開源計數算法框架,提供常見的六個主流數據庫的預處理代碼、處理好的數據集,以及一些主流的密集計數模型。本文在C-3-Framework 上增添檢測分支(見圖2 中右下角部分),根據密度圖所保留物體的空間位置信息實現物體定位,整體架構如圖2所示。圖像中由左至右首先基于ResNet101 網絡進行原始圖像的特征提取,完成特征提取后對w×h末端特征圖進行上采樣得到密度圖和目標定位信息。特征提取網絡整體為全卷積模式,以保留更準確的空間信息,具體結構如表1所示。

表1 殘差網絡結構Table 1 ResNet structure

圖2 密度圖估計結合檢測定位網絡結構圖Fig.2 Structure maps of density map estimation combined with detection of localization network

C-3-Framework 對ResNet101 網絡結構進行優化,修改下采樣層stride參數,使得最后一個特征圖輸出大小為1 024×72×48,修改后的ResNet101 所輸出特征圖尺寸大小不再滿足通道數依次變為原來的2倍、特征圖長、寬依次縮小50%的規則。此外,添加1×1 卷積核以改變通道數目,在特征圖尺寸不變的情況下增加非線性映射。

特征提取網絡中,由上到下各層輸出特征圖分別記為C1、C2、C3、C4。C4作為特征提取輸出的最后一個特征圖,大小為1 024×72×96,同時作為結合密度圖的檢測計數網絡的輸入數據。為適應較小目標的尺寸,本文在C-3-Framework 框架基礎之上對主干網絡ResNet101 繼續下采樣。下采樣層采用kernel size=3、stride=2 的卷積層,并將這一層輸出的特征圖記為C5。最終得到主干網絡提取出的特征為C1、C2、C3、C4、C5,尺寸分別為64×144×192、256×144×192、512×72×96、1 024×72×96、2 048×36×48,其中C1、C2和C3、C4分別為相同大小的特征圖。

2.1.2 目標檢測定位

為實現目標檢測定位,首先輸出密度圖求得局部極大值所得到圖像中所有物體的中心點坐標,再根據中心點坐標構建目標物體檢測邊框。

根據中心點坐標值,計算圖像索引向量如式(3)所示,即可得到該物體中心點位置信息,從而進行物體檢測框的信息轉換。

考慮到索引取整計算存在誤差,論文引入偏移分支修正模型輸出框的寬度和高度,用分別表示第i個目標檢測框寬度w和高度h與取整后索引值的偏差量,如式(4)、式(5)所示:

根據偏移分支的輸出可以修正定位分支輸出的目標定位信息,從而提高物體檢測的準確率。添加偏移分支后,網絡結構圖如圖3所示。

圖3 添加偏移分支后網絡結構圖Fig.3 Network structure diagram after adding offset branches

本文采用固定核的高斯函數生成密度圖,根據輸出的密度圖找到中心點的坐標,利用式(1)~式(3)將密度圖轉換為索引即可得到對應物體的寬度和高度。檢測定位分支輸出以每一個像素點為目標中心點所對應的寬度和高度,通過引入檢測分支頭進行物體定位,從而實現定位分支和密度圖估計共享網絡結構。密度圖保留了物體的空間信息,同時無需引入基于檢測框的目標檢測模型,因此網絡可以靈活地學習各種尺寸的目標物體,具有較好的普適性。

2.2 優化的FPN模塊

本文需要根據密度圖恢復物體空間位置信息,因此密度圖回歸任務分支需要豐富的語義信息。但是FPN 將相同尺寸的特征圖視為一個層級,對同一層級特征圖的信息融合不足。為了充分利用本文中特征提取網絡的結構特性,本文改進FPN 中同層級特征間的關聯,提出優化的FPN,稱之為FPN-Plus。

FPN-Plus的核心網絡結構如圖4 所示,不僅利用特征提取網絡不同尺度特征圖的語義信息,而且還充分利用多個層級的語義信息,對于相同尺寸的層級采用逐像素相加的方式,以獲得更加豐富的語義信息。在本文實驗中,C1、C2具有相同尺寸,C3、C4具有相同尺寸。FPN-Plus 首先對C5執行1×1 卷積操作生成特征圖P1,同時改變通道數為128。通過雙線性插值對P1執行兩倍上采樣,并和C4相加形成橫向連接輸出為P2。由于P2和C3具有相同尺寸的特征圖,對C3執行1×1 卷積以改變通道數,最終與P2直接相加形成P3,從而使得特征提取網絡結構的多個特征圖信息均被包含在最后一層的特征圖中,語義信息更加完整,從而提升計數的準確性。

圖4 FPN-Plus核心結構圖Fig.4 FPN-Plus core structure diagram

添加FPN-plus 網絡結構后,形成完整的DCDM網絡結構,如圖5 所示,具有相同顏色部分表示相同大小的特征圖。圖像輸入至DCDM 網絡后,先經自底向上的前向傳播,通過自頂向下以及橫向連接的結構生成具有豐富語義信息的特征圖。然后,通過檢測分支、偏移分支以及密度圖估計分支共享最后一層特征圖作為輸入數據,參考C-3-Framework 密集計數網絡框架添加檢測分支形成多任務網絡模型,分別輸出目標位置信息、偏移信息以及密度圖,實現基于密度圖估計的目標檢測計數算法。

圖5 DCDM完整網絡結構圖Fig.5 Structure diagram of complete DCDM network

2.3 注意力損失函數

本文采用多任務損失函數,將目標檢測定位分支、偏移分支以及密度圖估計分支的損失函數與注意力損失函數相結合,同時學習多個任務以實現端到端的檢測計數。損失函數如式(6)所示:

其中,Loffset、Ldet、Ldm、Latt分別表示偏移分支、定位分支、密度圖估計分支以及注意力損失函數。Ldm采用密集計數方法中常用損失函數MSE(mean squared error),計算方法如式(7)所示:

其中,Ei表示的是模型預測圖像i的密度圖,Gi表示圖像i的真實密度圖,N是訓練圖像總數。由于定位分支和偏移分支輸出以實現定位物體,損失函數均選用計算兩個坐標對應的歐式距離。

損失函數Ldm對圖像中的每一個像素計算其與真實值的偏差,但是由于圖像中背景等無關像素點占據比例較高,即正樣本數目遠小于負樣本數目,對每一個像素點計算與真實值之間的偏差會導致正負樣本失衡的問題。除此之外,對像素點均勻計算回歸密度,導致網絡在訓練過程中不會將注意力集中在目標物體上。

為促進模型準確率提高,本文提出注意力損失函數Latt。首先,對輸入圖像生成一個掩膜。掩膜的生成過程同密度圖生成過程相同,但是將高斯核函數用固定值1 代替。通過此注意力實現網絡注意力集中于目標物體上。

基于上述思路構造注意力損失函數,如式(8)所示:

其中,Mi表示第i張圖生產的掩膜。通過式(8)可得,注意力損失函數僅對正樣本進行了損失計數,通過掩膜去除負樣本對損失函數的影響。在密度圖估計損失函數的基礎上結合注意力損失函數,得到密度估計損失函數公式如式(9)所示。注意力機制有利于提高對小目標等的檢測效果,從而提升網絡對目標的整體檢測能力。

3 結果與分析

完成DCDM 模型構建后,本文將該模型應用于現有數據集進行實驗測試,同時與其他目標檢測方法進行比較分析。除此之外,本文進行充分的消融實驗以驗證所提出網絡結構的有效性。

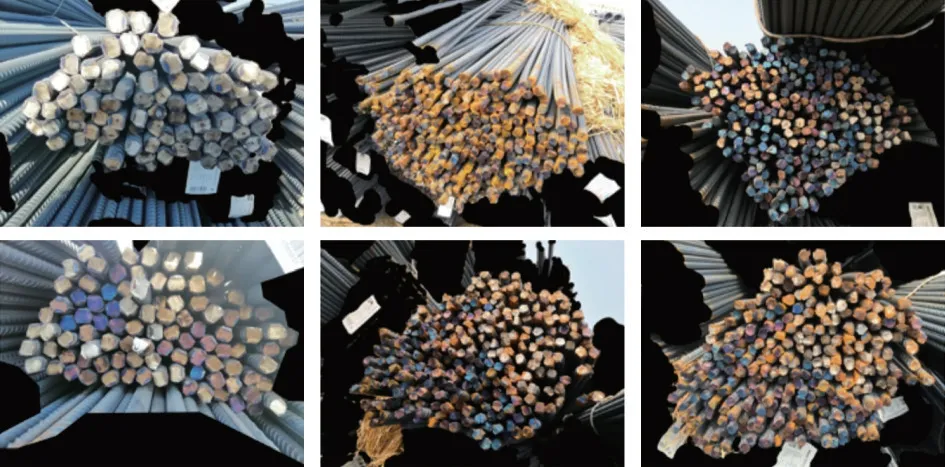

3.1 實驗數據

本文測試數據集來自“智能盤點——鋼筋數量AI 識別”人工智能比賽,拍攝于工地現場,通過手機進行采集,數據包含直徑12~32 mm 等不同規格的鋼筋圖片。數據集由訓練集和測試集組成,其中訓練集一共250 張圖片,測試集一共200 張圖片。為使得實驗結果有效,利用圖像處理進行數據集擴充,部分數據集如圖6所示。

圖6 鋼筋數據樣例圖Fig.6 Example diagram of rebar data

3.2 評價指標

本文采用多個指標定量評估DCDM 檢測計數性能,分別是F1-score、MAE(mean absolute error)以及MSE。F1-score 可由召回率和準確率計算可得,如式(10)所示:

其中,召回率表示所有樣本中預測為正樣本部分的比例,準確率為所有預測正樣本中正確預測的正樣本比例。召回率的計算涉及到TP(true positive)和FN(false negative),TP 表示被正確劃分為正樣本的實例個數,FN 表示被錯誤劃分為負樣本的正樣本實例個數。召回率表示網絡能夠找到目標物體的能力,計算公式見式(11):

準確率的計算涉及到TP和FP(false positive),其中FP 表示被錯誤劃分為正樣本的實例個數,準確率計算公式見式(12):

其中,TP和FP可以通過計算真實框和預測框的交并比IoU(intersection over union)得到。當IoU>0.5時,則認為該目標檢測框是正樣例,否則為負樣例。

MAE 和MSE 常被密集計數領域用來衡量計數的性能。MAE計算方法如式(13)所示:

其中,N表示訓練樣本中圖像的總數目,Mi表示第i幅圖像中物體的真實數目,表示模型對第i幅圖像中物體的預測數目,即用真實值減去預測值后取絕對值,然后求和取平均值。MSE 稱為均方誤差,計算方法如式(14)所示:

3.3 實現細節描述

考慮到收集得到數據量較少,為增加訓練階段模型的魯棒性,采用隨機水平翻轉和隨機垂直翻轉進行數據增強。在訓練初期,使用ImageNet 預訓練網絡初始化網絡權重。優化器采用Adam,其中weight decay 為1×10-4,采用動態學習率,初始學習率為1×10-5,10個epoch內損失函數值沒有下降,則將學習率降低10%,最低可降低到1×10-8。

3.4 對比實驗

論文將DCDM 模型與基于anchor 的目標檢測模型Mask RCNN 以及基于anchor-free的目標檢測模型CenterNet進行對比,實驗結果如表2所示。

表2 鋼筋數據集實驗結果對比數據Table 2 Data comparison of experimental results of rebar dataset

對于F1-score 指標,DCDM 在測試集達到0.923,比Mask RCNN 方法提升0.082,比CenterNet 方法提升0.075。同時,Mask RCNN 和CenterNet 的召回率均在0.70 左右,而DCDM 達到0.91,從而證明DCDM模型能夠在實現定位物體的同時獲得較高召回率。此外,DCDM 方法的MAE 和MSE 指標遠低于Mask RCNN 和CenterNet 相應指標,由此說明DCDM 方法計數準確率比通用目標檢測方法準確率高。綜上所述,通過實驗證明,本文提出的DCDM 模型能夠獲得比通用檢測計數方法更加準確的計數結果,并且對于復雜的遮擋和傾斜場景具有強魯棒性。

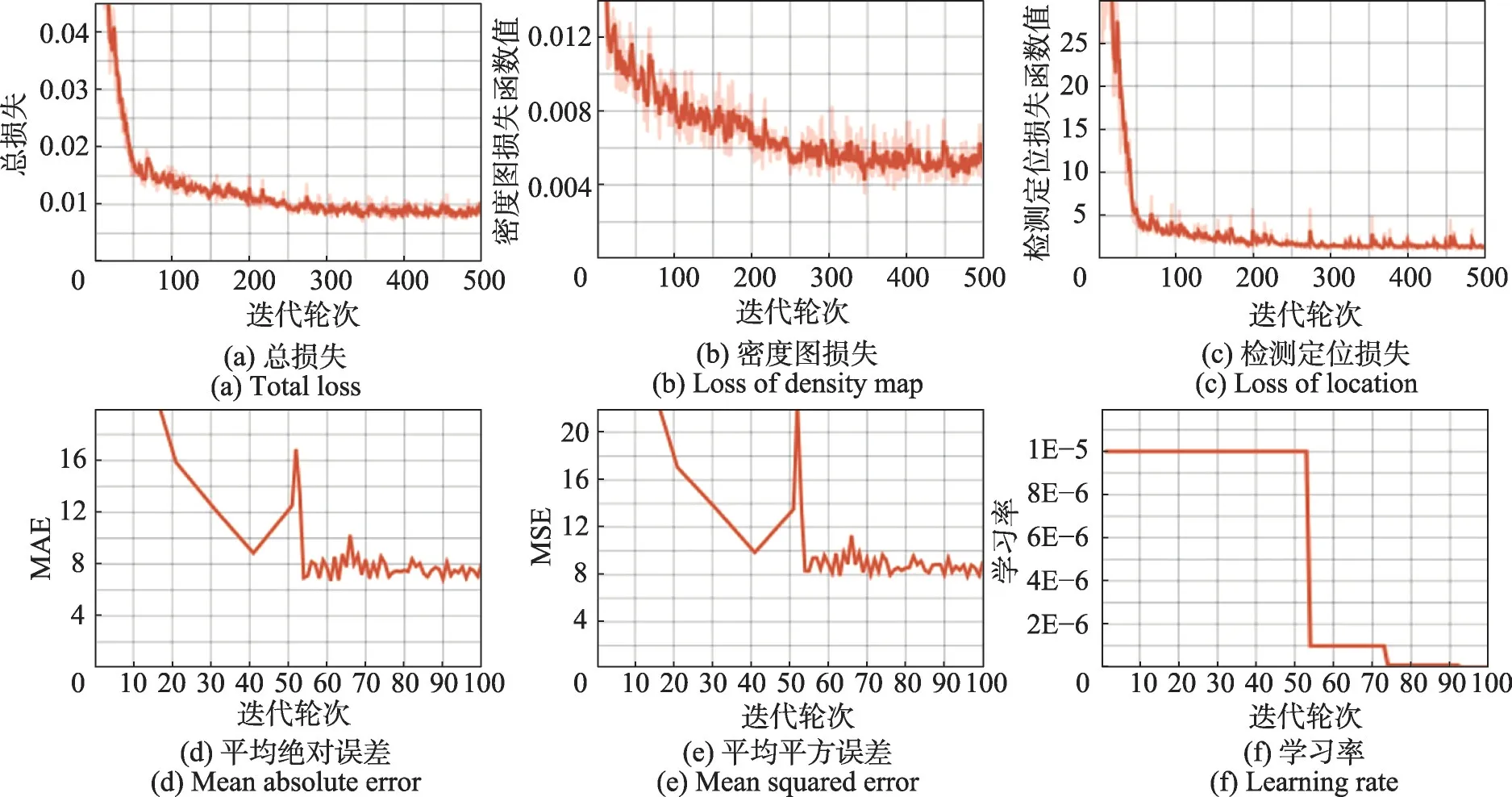

基于3.3節所描述的參數設置,圖7所示為DCDM在鋼筋數據集上的訓練過程中各指標的變化圖。其中圖7(a)為訓練過程中訓練集的總損失變化情況,其由密度估計損失和檢測定位損失加權和所得,反映模型整體訓練過程中損失函數的收斂情況,從圖中可以看出經過迭代后,損失函數值已經正常收斂。圖7(b)及圖7(c)所示分別為訓練集密度圖及檢測定位損失函數值變化情況,比較兩者可得檢測定位損失函數值收斂較快,而密度估計損失函數呈現緩慢下降趨勢,說明檢測定位學習的回歸任務比密度估計的回歸任務更加容易學習。圖7(d)~圖7(f)分別為訓練過程中MAE、MSE 指標的變化情況以及學習率的動態變化過程,在40 到50 輪次的訓練過程中指標出現異常上升情況,通過動態調節學習率使得指標穩定下降,說明動態調整學習率有助于模型收斂。

圖7 DCDM訓練過程中參數指標變化Fig.7 Changes of parameter value during DCDM training

圖8 所示為DCDM 在鋼筋數據集上的檢測計數效果圖。檢測的結果依賴于密度圖提供的中心點,第一行展示DCDM 模型輸出的密度圖疊加在原圖上的實驗結果,可以看出每個物體的中心點都對應著密度點分布,越靠近中心點像素值越高。第二行是經過后處理的檢測計數結果圖,根據輸出結果可以看出計數準確度較高。同時在左圖中對于右下角被強光照射的鋼筋,DCDM 也能夠實現準確檢測,對于右圖出現自上而下的尺寸變形,DCDM 檢測結果不受其影響。但是對于中間圖像,由于存在一些嚴重遮擋導致模型存在一定誤差。

圖8 DCDM測試輸出圖Fig.8 DCDM test output graph

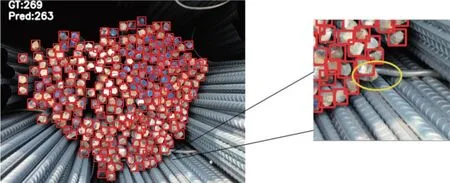

如圖9所示將產生誤差部分進行局部放大,可以看出右下角的鋼筋被疊放在其上面的鋼筋遮擋住了多半部分,從而造成誤差。

圖9 DCDM測試局部放大圖Fig.9 DCDM test local enlargement

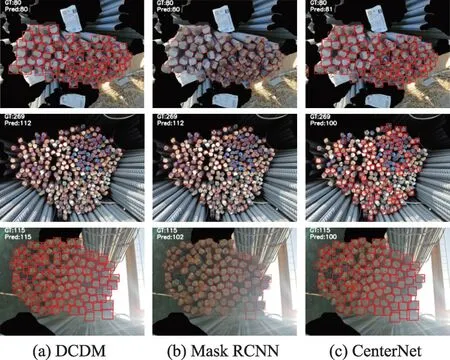

除此之外,本文對Mask RCNN 及CenterNet網絡在鋼筋數據集上的實驗效果可視化并與DCDM 形成對比,對比效果如圖10 所示,其中圖10(a)~(c)列分別表示DCDM、Mask RCNN、CenterNet 測試樣例輸出結果,其中第二行實驗結果中,Mask RCNN 和CenterNet 實驗結果較為相近,召回率都不到50%,而DCDM 可以實現近98%的召回率。由此說明對于比較復雜的數據,Mask RCNN 和CenterNet 檢測計數結果均遠小于其真實值,DCDM檢測效果較好。

圖10 DCDM、Mask RCNN、CenterNet測試樣例圖Fig.10 Test sample diagram of DCDM,Mask RCNN and CenterNet

3.5 消融實驗

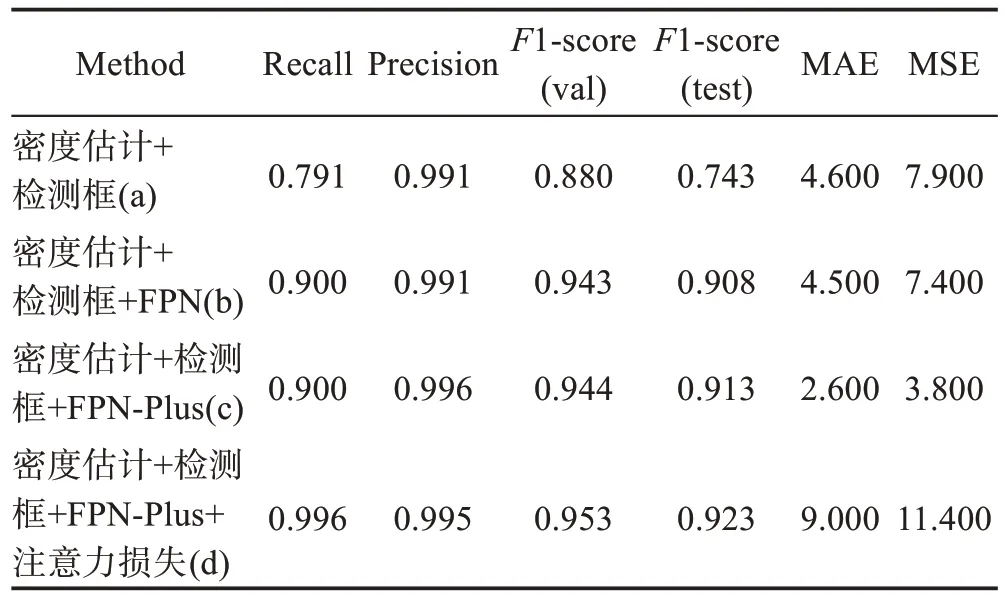

如表3所示為消融實驗結果,用以驗證本文所提出方法中各模塊的有效性。其中,基線方法選用C-3-Framework中的密度估計方法,backbone為ResNet101。

表3 鋼筋數據集消融實驗結果對比Table 3 Comparison of ablation experiment results of rebar dataset

如表3 所示,實驗(a)作為基準,實驗(c)相較于實驗(b)中Recall、Precision 及F1-score 指標均有提升,說明FPN-Plus 改進結構能夠提高物體的檢測能力并增加召回率。同時,根據實驗(d)可得在網絡中加入注意力損失函數使得模型在測試集上的F1-score 指標從0.913 提升到0.923,從而表明注意力損失函數可以增加DCDM 對物體的注意力,進一步提高網絡的檢測計數能力。

上述各部分實驗的結果說明充分利用密度圖的空間信息使得基于密度圖估計的檢測計數網絡DCDM 比通用目標檢測網絡具有更高的召回率以及更加準確的密集計數能力。為充分利用各層級語義信息,本文提出FPN-Plus 網絡結構。此外,注意力損失函數通過將注意力集中在物體上從而減少背景對模型的影響,增強魯棒性。但由于本文在計數網絡基礎上引入定位任務,形成一種多任務訓練模型,計數效果相較于基于密度估計網絡存在一定差距。但是定位任務的引入使得DCDM 檢測計數結果可靠,同時獲得比通用目標檢測更好的檢測計數效果。

4 結束語

密集計數可應用于估計人群密度、野生動物計數,且在安全、防空領域具有廣大的應用前景。基于檢測的計數方法雖然能夠定位物體,但是其計數值遠小于真實計數值;基于密度估計的計數方法雖然能夠實現較為接近真實值的計數結果,但由于缺少物體的位置信息,其計數結果存在局部不一致的問題。

基于以上觀察,本文提出基于密集計數的檢測算法DCDM,同時實現檢測和密度圖估計任務,適用于截面非對齊條件下的密集計數。DCDM 在基于密度估計的網絡結構上添加物體定位結構,利用密度圖的弱空間信息以提供物體中心點信息。為使得網絡模型能夠應對物體的多種尺度變化,本文同時提出FPN-Plus 網絡結構,充分利用DCDM 中特征提取網絡的結構特性,使得輸出特征圖具有豐富的語義信息。此外,為使得模型將注意力集中在感興趣的物體上,提出注意力損失函數,通過掩膜來提取正樣本的損失值。通過對比實驗,驗證得到DCDM 模型相較于通用目標檢測算法準確性較高,同時消融實驗說明本文提出的各模塊都是有效的。