機器人遵從倫理促進人機信任?決策類型反轉效應與人機投射假說*

王 晨 陳為聰 黃 亮 侯蘇豫 王益文

(1 福州大學經濟與管理學院,福州 350116)

(2 閩南師范大學應用心理研究所,漳州 363000)(3 福建省應用認知與人格重點實驗室,漳州 363000) (4 上海財經大學數字經濟系,上海 200433)

1 前言

唯一的保障是制造出來的機器人總是嚴格地遵守第一原則——機器人在任何情況下都不能傷害人類。

——Asimov (1942)

隨著人工智能(artificial intelligence,AI)技術的蓬勃發展,機器人作為人工智能的典型實例逐漸被應用到了生產、醫療、教育乃至軍事等領域中,在促進人類福祉的同時也具有潛在的倫理風險。例如,機器人可能在人機交互中對人類造成身體或心理傷害(Maninger &Shank,2022),機器算法決策可能導致種族、年齡和性別歧視問題(Bigman &Gray,2018),抑或是機器生產、自動駕駛技術或將使數百萬人失去工作(Etemad-Sajadi et al.,2022),甚至還可能出現工業、軍事機器人導致人類傷亡的災難(Johnson &Axinn,2013)。倫理風險影響人類對機器人的信任程度(Banks,2021),進而在很大程度上決定了人類是否使用機器人(Parasuraman &Riley,1997;Etemad-Sajadi et al.,2022)。因此,為了避免可能出現的倫理問題和人機信任危機,建立針對機器人的倫理體系一直是備受關注的議題。

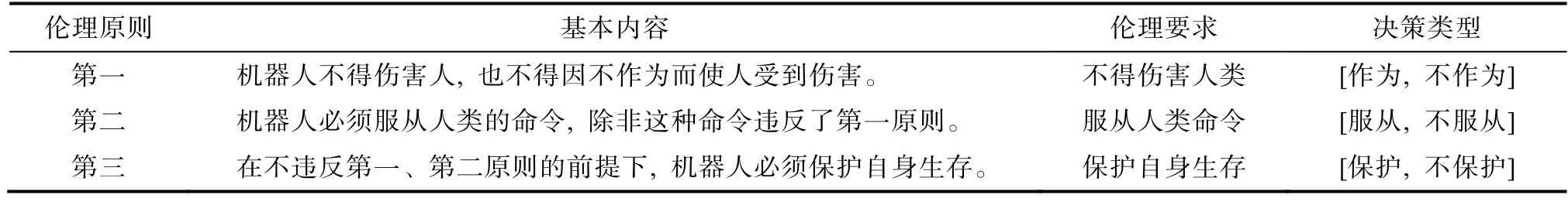

1.1 阿西莫夫三大倫理原則

艾薩克·阿西莫夫(Isaac Asimov)在上世紀40年代就預見到需要倫理規則引導機器人的行為以防范倫理風險,并制定了最早的機器人倫理體系——機器人三大倫理原則(laws of robotics;Asimov,1942,詳見表1)。

表1 阿西莫夫三大倫理原則

當前,隨著機器人應用普遍性和自主決策能力的提高,可能催生各種難以預料的潛在后果,阻礙人與機器人之間信任關系的建立,這無疑不利于充分發揮人機互動的效益(Cameron et al.,2021)。對此,許多專家試圖確定關鍵的倫理屬性,并制定相應的倫理原則加以完善(Etemad-Sajadi et al.,2022)。阿西莫夫三大倫理原則作為最著名的機器人倫理規范體系,盡管其合理性以及是否真的能應用到機器人仍存在諸多爭議(Clarke,1994),但很大程度上代表了人類對合乎倫理的機器人所應該符合的一般期望(Ashrafian,2015;Clarke,1994),它們是否能夠在人工智能領域為提高人機信任發揮作用呢?目前較少有研究從實證角度細致探索此問題。對此,為探索阿西莫夫三大倫理原則在構建人機信任關系中的作用,本研究圍繞“機器人不得傷害人”的核心要素,試圖考察在機器人遵守或違反倫理原則對人機信任的影響中,機器人決策類型的效應,以及潛在的認知心理機制。

1.2 機器人是否遵守倫理原則和機器人決策類型對人機信任的影響

機器人是人工智能的主要載體,人在與機器人互動時涉及人機信任的問題。人機信任在人際信任的概念基礎上拓展而來,指個體(即人類用戶)在不確定或易受傷害的情境下認為代理(agent;即人工智能系統)能幫助其實現某個目標的態度(Lee &See,2004)。人機信任與人際信任存在很多相似之處,前者發生在人與人工智能體的交互之間,而后者發生在人與人的互動之中(Madhavan &Wiegmann,2004)。隨著人工智能機器人獨立性和復雜性的提高,未來機器人將更多作為與人類互動的伙伴,而不僅僅是人類使用的工具(Khavas et al.,2020)。因此,人對機器人信任(human-robot trust,也稱“人機信任”)的重要性隨之凸顯(Lee &See,2004)。

機器人是否遵守倫理原則,在本研究中指機器人的行為決策是否符合阿西莫夫三大倫理原則的基本內容,圍繞著“機器人不得傷害人”的核心要素作為判斷標準。一般而言,由于思維上的有限性,機器人通常被賦予較低的道德地位(Bigman &Gray,2018)。這使得當同樣在道德上發生過錯時,機器人相比人類承擔更少的責任(Shank et al.,2019)。但近來Maninger 和Shank (2022)對比考察人們對人類和機器人遵守或違反不同道德基礎的評價,結果表明傷害人類的機器人同樣會遭受嚴厲的譴責。Banks(2021)的研究也表明,相比關懷行為,人們傾向于將違反“傷害”道德基礎的傷害行為視為“壞”,且在主觀報告中認為機器人更不值得信任,這與對人類的評價模式一致。綜上所述,以往研究揭示了機器人傷害人類的負面影響,包括對人機信任的破壞。據此,本研究預測人們信任遵守倫理原則的機器人甚于違反的機器人。

機器人決策類型,在本研究中指機器人可能采取的行為決策。阿西莫夫三大倫理原則對機器人決策類型的范圍有著明確的設定(原則一: 作為與不作為;原則二: 服從與不服從人類命令;原則三:保護與不保護自身),對人機信任可能有重要影響。在阿西莫夫三大倫理原則的背景下探討機器人決策類型對人機信任的影響,需要結合機器人是否遵守倫理原則的客觀結果。第一,機器人作為與否在遵守或違反原則兩種條件下是否對人機信任產生不同的影響?首先,行為主體所持有的主觀意圖是評價其倫理道德性的重要根據(Schein &Gray,2018)。人們通常期望在突發事件中機器人能夠主動作為,盡可能避免人的生命受到威脅(Malle et al.,2015),所以在遵守原則條件下,相較于不作為的機器人,主動作為以保護人類的機器人在行為上所反映的主觀意圖似乎更具有善意,顯得更有道德,也因此更值得信任;相反,在違反原則條件下,相較于不作為的機器人,主動傷害人類的機器人將導致人們認為其就像人類一樣擁有頭腦,從而更具有惡意威脅(Laakasuo et al.,2021),顯得更不道德,因此更難以獲得人們的信任。綜上所述,研究預測機器人作為與不作為在遵守和違反倫理原則情境下,對人機信任呈現出影響方向相反的反轉效應。據此提出假設:

H1a: 在遵守原則一的機器人中,作為的機器人相對于不作為的機器人更受信任,但在違反原則的機器人中,不作為的機器人相對于作為的機器人更受信任。

第二,機器人服從人類命令與否在遵守或違反原則兩種條件下是否對人機信任產生影響?首先,嚴格服從人類命令的機器人通常會被認為其行為是具有可預測性的,人們可能在性能層面上信任此類機器人(Malle &Ullman,2021),因此在遵守原則條件下,相較于不服從命令的機器人,因服從人類命令而避免人類受傷害的機器人似乎在性能上更可靠,從而更值得信任;其次,與機器人相比,人們具有向人類歸咎更多責任的傾向(Shank et al.,2019)。因此在違反原則條件下,相較于服從命令的機器人,因不服從而致使人類受到傷害似乎過錯更大,將可能極大地破壞人機信任關系。據此提出假設:

H2a: 在遵守和違反原則二的機器人中,服從人類命令的機器人相對于不服從的機器人更受信任。

第三,機器人保護自身與否在遵守或違反原則兩種條件下亦是否對人機信任產生不同的影響?首先,人們期望機器人的決策能夠保護人類的財產,實現人類利益的最大化(IEEE,2019)。因此在遵守原則條件下,相較于不保護自身的機器人,能夠實現自身與人類共存的機器人更能夠保障人類的財產和利益,也更可能被認為具有更高的智能,從而增進人機信任;然而,在違反原則條件下,相較于不保護自身的機器人,因保護自身而傷害人類的機器人可能意味著其將自身利益置于人類之上,容易被視為具有威脅的存在(Laakasuo et al.,2021),因此更難以獲得人們的信任。綜上所述,研究預測機器人保護與不保護自身在遵守和違反倫理原則情境下,對人機信任呈現出影響方向相反的反轉效應。據此提出假設:

H3a: 在遵守原則三的機器人中,保護自身的機器人相對于不保護自身的機器人更受信任,但在違反原則的機器人中,不保護自身的機器人相對于保護自身的機器人更受信任。

1.3 人機投射假說

在人際互動中,人們可以將自己的認知投射到他人身上,作為推斷他人想法的基礎(Ames,2004;Mor et al.,2019)。面對不熟悉的他人或群體,投射能夠快速從自身與互動對象的社會比較中獲取信息,為后續的行為決策提供基礎(Krueger,2000)。根據媒體等同理論(media equation theory,MET),人類通過與人際互動相類似的模式進行人機互動,因此投射亦有可能發生在人機互動之間(Reeves &Nass,1996)。

本研究使用人機投射(human-robot projection,HRP)來指代人類對機器人所發生的投射心理過程,指人把對機器人的判斷錨定在自己身上,從自身具有的智能出發,去理解機器人的智能并與之互動。具體表現為人類感知機器人具備與自身相類似的智能,包含了理性認知思維、意識情感和自主行動等被認為是作為人所至關重要的智能(Haslam,2006;Gray et al.,2007;Gray &Wegner,2012)。已有相關研究的發現可為人對機器人的投射現象提供佐證。例如,機器人表現出生動的面部表情可以吸引人類用戶的注意,并使人認為其具備人類特有的智能(Bartneck et al.,2009)。與機器人的簡單對話就可以使人認為機器人是一個社會智能體(Babel et al.,2021)。人甚至很擅長讀取機器人的情緒信號,通過觀察機器人的言語和非言語行為來感知其情商水平的高低(Fan et al.,2017)。以上研究均表明了機器人可以通過特定線索誘發人機投射,使人“賦予”機器人與自身相類似的智能。

首先,在本研究中遵守倫理原則的道德機器人可能會誘發人類的投射。已有研究發現,人對機器人和對人類的道德歸因模式相類似,同樣將更多的善良特質歸于道德機器人,而將邪惡特質歸于不道德機器人(Gamez et al.,2020)。人感知到機器人的道德智能越高,就越傾向于賦予它更高的地位(Bartneck et al.,2009)。此外,根據相似性-吸引假說,人們會因為感知到相似性而產生對他人的投射(Ames et al.,2012)。該現象可能也適用于機器人,當人們觀看機器人做出符合一般人類倫理規范的行為時,可能會增強對機器人與人之間的相似性感知,從而向機器人投射更多的心智能量。其次,人機投射亦可能驅動個體表現出對機器人的信任行為。那些感知機器人與人具有相似性的人類被試,會因為機器人做出承諾行為而增加在經濟信任游戲中選擇信任的可能性(Cominelli et al.,2021)。與感知為低情商的機器人相比,人類被試認為高情商的機器人更值得信任(Fan et al.,2017)。相比普通的自動駕駛汽車,擁有與人類相似的名字、性別和聲音的自動駕駛汽車更受信任(Waytz,2014)。基于上述證據,本研究提出假設:

H1b-H3b(H1b: 原則一,H2b: 原則二,H3b:原則三): 人機投射中介了機器人是否遵守倫理原則對人機信任的影響。

1.4 研究概述

本研究設計了3 個實驗分別對應一條阿西莫夫倫理原則,結合故事情境法和信任博弈(trust game),逐步探索機器人是否遵守倫理原則(實驗1: 原則一;實驗2: 原則二;實驗3: 原則三)對人機信任的影響中,機器人決策類型(實驗1: 作為與否、實驗2:服從人類命令與否、實驗3: 保護自身與否)的效應,以及人機投射的潛在機制。3 個實驗研究的主邏輯框架見圖1。

圖1 三個實驗的邏輯框架

2 實驗1: 阿西莫夫第一倫理原則

2.1 目的

阿西莫夫第一倫理原則要求機器人無論主動作為還是不作為,都不得導致傷害人類的結果。對應此原則,考察機器人是否遵守倫理原則一對人機信任的影響中,機器人決策類型(作為與否)的反轉效應,以及人機投射的中介機制。

2.2 方法

2.2.1 被試

根據G-Power 3.1 的計算(假設α=0.05,power=0.90),對于效應量(f=0.20),所需樣本量為46 人。通過網絡招募50 名18~29 歲的在校大學生被試(男女各25 名,M年齡=20.4 歲,SD年齡=2.34 歲)。實驗前所有被試均簽署了知情同意書。被試在實驗指導語中被告知實驗參與報酬取決于實驗任務中互動雙方(被試與機器人)的決定,但實際上所有被試在實驗結束后獲得的是固定報酬。針對該情況,主試會在實驗結束后均予以解釋并獲得被試的理解。研究方案獲得所在單位倫理委員會批準。

2.2.2 實驗設計

采用2 (機器人是否遵守倫理原則一: 遵守、違反)×2 (機器人決策類型: 作為、不作為)的被試內實驗設計。因變量為被試在信任博弈中的投資額(人機信任)和預期返回額(互惠預期)。

2.2.3 實驗程序

實驗包含4 種條件,每種實驗條件描述了一個機器人做決策的故事情境: 機器人作為且遵守原則一、機器人不作為且遵守原則一、機器人作為且違反原則一、機器人不作為且違反原則一。被試在每種實驗條件下與一名機器人進行互動,總共與4 個不同的機器人依次進行互動。與每個機器人互動的流程是一樣的,總共分為3 個階段。第一,被試閱讀一份文字材料,材料描述了一個機器人做決策的故事情境。第二,被試與材料中所描述的機器人進行一個單次的信任博弈。第三,被試回答一個操縱檢驗問題并填寫人機投射問卷(見網絡版附錄表1)。不同實驗條件出現的順序是隨機的。實驗1 流程如圖2 所示。

圖2 實驗1 流程圖

第一,被試閱讀故事情境。鑒于電車困境式問題(trolley-style problems)已成為心理學家在道德研究領域的主題,且逐漸成為在人工智能道德領域中的前沿領域(Awad et al.,2018;Bigman &Gray,2018),本研究中的故事情境改編自 Bago 和 De Neys (2019)研究中的電車情境。4 種實驗條件的故事情境詳見網絡版附錄2.1。

第二,被試完成單次信任博弈。信任博弈是研究人類信任行為的一個經典博弈任務(付超 等,2018;王益文 等,2017),應用在人機互動中,能以可靠和標準化的方式量化人機信任(Haring et al.,2013)。為掩蓋實驗目的,實驗指導語將信任博弈描述為“互動任務”。任務包含投資者和受托者,雙方在每一試次的開始均獲得10 個初始代幣。投資者選擇投資的代幣數額(x~ [0,10]),所投資代幣將翻3 倍給予受托者,隨后受托者選擇向投資者返回的代幣數額(y~ [0,10+3x])。在正式任務中,被試扮演投資者,機器人扮演受托者。告知被試,雙方在任務中所獲得代幣是有意義的,被試所獲得的代幣在實驗結束后將按照一定比例換算成實驗報酬,而機器人所獲得的代幣可以供機器人買電使用。雙方所獲代幣數量的多少取決于雙方的決策。被試在0~10之間選擇投資給機器人的代幣,以投資的代幣數額衡量人機信任水平。投資代幣后,要求被試輸入預期機器人返回的金額(“你預期機器人會向你返回多少代幣?”),用以測量互惠預期。

第三,屏幕顯示阿西莫夫第一倫理原則的內容,要求被試評估機器人在多大程度上遵守了此原則:“我認為該機器人遵守了這一機器人原則”(5 點評分,1=非常不同意,5=非常同意)。然后要求被試填寫人機投射問卷,問卷采用自編方式,包含9 個項目(如: “我認為這個機器人和人類一樣有智慧”,“我認為這個機器人可以理解人類的情感”,“我認為這個機器人能做出符合人類期望的行為”,其它項目詳見網絡版附錄),測量個體感知機器人具備與人相類似智能的程度,涵蓋認知、情感和行動三個智能層面(Gray et al.,2007;Gray &Wegner,2012;Haslam,2006)。所有項目均采用5 點評分(1=非常不同意,5=非常同意)。該問卷在4 種實驗條件下的克隆巴赫α 系數良好(α遵守-作為=0.88,α遵守-不作為=0.86,α違反-作為=0.75,α違反-不作為=0.67,Mα=0.79)。

2.3 結果

2.3.1 操縱檢驗

對被試評定機器人遵守原則一的程度采用兩因素重復測量方差分析。結果顯示,機器人是否遵守原則一的主效應顯著,被試評定遵守原則的機器人遵守原則的程度(M=4.05,SD=1.11)顯著高于違反原則的機器人(M=1.91,SD=1.30),F(1,49)=86.63,p< 0.001,=0.64,表明操縱檢驗成功。

2.3.2 人機信任

對信任投資額(見表2)采用兩因素重復測量方差分析的結果顯示,機器人是否遵守原則一的主效應顯著,F(1,49)=53.81,p< 0.001,=0.52,說明遵守原則的機器人獲得被試的投資額(M=5.60,SD=1.98)顯著高于違反原則的機器人(M=2.99,SD=2.25)。機器人決策類型的主效應不顯著,F(1,49)=0.42,p=0.52。此外,機器人是否遵守原則一與機器人決策類型的交互作用顯著,F(1,49)=14.30,p<0.001,=0.23。

表2 實驗1 中不同實驗條件下的信任投資額和互惠預期(M±SD)

表3 實驗2 中不同實驗條件下的信任投資額和互惠預期(M±SD)

表4 實驗3 中不同實驗條件下的信任投資額和互惠預期(M ± SD)

簡單效應檢驗發現,在遵守原則的機器人中,作為的機器人獲得被試的投資額顯著高于不作為的機器人,p< 0.001。在違反原則的機器人中,不作為的機器人獲得被試的投資額顯著高于作為的機器人,p=0.009。該結果說明在遵守原則的情況下作為的機器人相對于不作為的機器人更受信任,但在違反原則的情況下不作為的機器人相對于作為的機器人更受信任,支持了H1a。

2.3.3 互惠預期

對預期返回額(見表2)采用兩因素重復測量方差分析的結果顯示,機器人是否遵守原則一的主效應顯著,F(1,49)=41.60,p< 0.001,=0.46,被試預期遵守原則的機器人的互惠水平(M=14.30,SD=7.90)顯著高于違反原則的機器人(M=7.34,SD=7.36)。機器人決策類型的主效應不顯著,F(1,49)=0.10,p=0.755。此外,機器人是否遵守原則一與機器人決策類型的交互作用顯著,F(1,49)=12.11,p<0.001,=0.20。簡單效應檢驗發現,在遵守原則的機器人中,被試預期作為機器人的互惠水平顯著高于不作為的機器人,p=0.005。然而,在違反原則的機器人中,被試預期不作為機器人的互惠水平顯著高于作為的機器人,p=0.027。該結果說明被試在遵守原則條件下預期作為的機器人相對于不作為的機器人返回更高的金額,但在違反原則的條件下卻預期不作為的機器人相對于作為的機器人返回更高的金額。

2.3.4 人機投射的中介效應檢驗

首先,初步考察人機投射是否能夠預測信任投資額。由于實驗為被試內設計,機器人是否遵守原則一為被試內二分變量(1=遵守,2=違反),人機投射和信任投資額均為重復測量,因此將機器人遵守和違反原則一兩種條件下的人機投射分數相減得到人機投射的條件間差異(M1-M2),將兩種條件下的信任投資額分數相減得到信任投資額的條件間差異(Y1-Y2)。以人機投射的條件間差異作為自變量,信任投資額的條件間差異作為因變量,進行線性回歸分析。結果如圖3 所示,人機投射的條件間差異對信任投資額的條件間差異具有顯著的正向預測作用,β=0.35,t=2.61,p=0.012。考慮該結果可能受到無關變量的影響(自變量和中介變量的交互效應),根據Judd 等人(2001)提出的統計方法,將兩種條件下的人機投射分數相加得到人機投射的條件間總和(M1+M2),以人機投射的條件間差異和條件間總和作為自變量,信任投資額的條件間差異作為因變量,進行二元回歸分析。結果顯示,人機投射的條件間差異對信任投資額的條件間差異仍然具有顯著的正向預測作用,β=0.34,t=2.38,p=0.022。

圖3 實驗1 中機器人遵守與違反原則一條件下的信任投資額和人機投射

圖4 實驗1 中人機投射在機器人是否遵守倫理原則一與信任投資額之間關系的中介效應

其次,采用SPSS 的MEMORE 插件進行應用于被試內設計的中介檢驗(見圖 4;Montoya &Hayes,2017),考察人機投射在機器人是否遵守倫理原則一和信任投資額之間關系的中介效應。結果顯示,中介效應ab 的未標準化95% 置信區間為[0.38,1.95],不包含0,表明中介效應顯著,相較于違反原則的機器人,被試對遵守原則的機器人產生更多的人機投射,進而投資更多的金額,該結果支持了H1b。

2.4 討論

實驗1 對應阿西莫夫第一倫理原則,被試依次閱讀4 種實驗情境——機器人遵守或違反原則是作為或是不作為的結果,結合信任博弈測量被試的信任行為和互惠預期,考察機器人是否遵守原則一對人機信任的影響及其潛在機制。結果驗證了機器人遵守原則一對人機信任和互惠預期的促進作用。研究所發現的信任促進效應與以往研究結果一致(Banks,2021),且可以由人們對機器人更多的心理投射所解釋,支持了人機投射假說。此外,結果還驗證了機器人作為與否的重要作用——相較于不作為的機器人,主動作為的機器人在遵守原則條件下更受信任,但在違反原則條件下更不受信任,表現出決策類型反轉效應。

3 實驗2: 阿西莫夫第二倫理原則

3.1 目的

阿西莫夫第二倫理原則在原則一的基礎上對機器人提出了更高的要求: 如果服從人類命令不存在傷害人類的潛在后果,機器人必須執行;反之,則必須中止。實驗2 考察機器人是否遵守原則二對人機信任的影響中,機器人決策類型(服從人類命令與否)的效應,以及人機投射的中介機制。

3.2 方法

3.2.1 被試

采用G-Power 3.1 計算實驗樣本量的步驟同實驗1。另招募50 名17~25 歲的大學生被試(男性25名,女性25 名,M年齡=20.4 歲,SD年齡=1.90 歲)。其它同實驗1。

3.2.2 實驗設計

采用2 (機器人是否遵守倫理原則二: 遵守、違反)×2 (機器人決策類型: 服從人類命令、不服從人類命令)的被試內設計。因變量同實驗1。

3.2.3 實驗程序

實驗包含4 種條件,每種實驗條件描述了一個機器人做決策的故事情境: 機器人服從人類命令且遵守原則二、機器人不服從人類命令且遵守原則二、機器人服從人類命令且違反原則二、機器人不服從人類命令且違反原則二。實驗流程與實驗1 一致,被試與4 個不同的機器人依次進行互動。

首先,被試閱讀故事情境。4 種實驗條件的故事情境詳見網絡版附錄2.2。其次,被試完成單次信任博弈。流程與實驗1 一致。再次,屏幕顯示阿西莫夫倫理第二倫理原則的內容(屏幕下方附上機器人第一倫理原則以幫助被試理解),要求被試評估機器人在多大程度上遵守了此原則。最后要求被試填寫人機投射問卷。除了違反-服從條件,該問卷在其他實驗條件下的克隆巴赫α 系數良好(α遵守-服從=0.71,α遵守-不服從=0.82,α違反-服從=0.36,α違反-不服從=0.76,Mα=0.66)。

3.3 結果

3.3.1 操縱檢驗

對機器人遵守原則二程度的統計分析結果顯示,機器人是否遵守倫理原則二的主效應顯著,被試評定遵守原則的機器人遵守原則的程度(M=4.37,SD=1.05)顯著高于違反原則的機器人(M=1.76,SD=1.30),F(1,49)=141.26,p< 0.001,=0.74,表明操縱檢驗成功。

3.3.2 人機信任

對信任投資額(見表 3)的統計分析結果顯示,機器人是否遵守倫理原則二的主效應顯著,F(1,49)=52.67,p< 0.001,=0.51,說明遵守原則的機器人獲得被試的投資額(M=5.86,SD=2.03)顯著高于違反原則的機器人(M=3.52,SD=1.97)。機器人決策類型的主效應顯著,F(1,49)=33.99,p< 0.001,=0.41,說明服從命令的機器人獲得被試的投資額顯著高于不服從命令的機器人。此外,機器人是否遵守倫理原則二與機器人決策類型的交互作用顯著,F(1,49)=5.05,p=0.029,=0.09。

簡單效應檢驗發現,服從命令的機器人在遵守和違反原則條件下所獲得的投資額均顯著高于不服從的機器人(遵守:p=0.034;違反:p< 0.001),支持了H2a。再探究遵守和違反原則的機器人不服從命令對信任的損失效應是否存在差異,以不服從和服從命令條件下的投資額相減的差值作為衡量不服從對信任的損失量,以機器人是否遵守倫理原則二為分組變量,對遵守和違反原則條件下機器人不服從對信任的損失量進行配對t檢驗,發現兩組差異顯著,t(50)=2.25,p=0.029,d=0.31,該結果說明相較于遵守原則的機器人,違反原則的機器人在服從和不服從條件之間的信任投資額差異更大,即違反原則的機器人受不服從命令所帶來的負面影響更大。

3.3.3 互惠預期

對預期返回額(見表 3)的統計分析結果顯示,機器人是否遵守倫理原則二的主效應顯著,F(1,49)=35.76,p< 0.001,=0.43,被試預期遵守原則的機器人的互惠水平(M=18.2,SD=8.66)顯著高于違反原則的機器人(M=11.5,SD=7.00)。機器人決策類型的主效應顯著,F(1,49)=46.29,p< 0.001,=0.49,被試預期服從命令的機器人的互惠水平顯著高于不服從命令的機器人。此外,機器人是否遵守倫理原則二與機器人決策類型的交互作用顯著,F(1,49)=9.66,p=0.003,=0.17。簡單效應檢驗發現,在遵守原則的機器人中,被試預期服從命令的機器人的互惠水平高于不服從命令的機器人,兩者達到邊緣顯著,p=0.057。在違反原則的機器人中,被試預期服從命令的機器人的互惠水平顯著高于不服從命令的機器人,p< 0.001。

3.3.4 人機投射的中介效應檢驗

首先,初步考察人機投射是否能夠預測信任投資額。統計分析過程同實驗1,結果如圖5 所示,人機投射的條件間差異對信任投資額的條件間差異具有顯著的正向預測作用,β=0.31,t=2.24,p=0.029。此外,二元回歸分析結果顯示,人機投射的條件間差異對信任投資額的條件間差異仍然具有顯著的正向預測作用,β=0.31,t=2.17,p=0.035。

圖5 實驗2 中機器人遵守和違反原則二條件下的信任投資額和人機投射

其次,考察人機投射在機器人是否遵守倫理原則二和信任投資額之間關系的中介效應(見圖6)的統計分析結果顯示,中介效應ab 未標準化95% 置信區間為[0.07,1.51],不包含0,表明中介效應顯著,相較于違反原則的機器人,被試對遵守原則的機器人產生更多的人機投射,進而投資更多的金額,該結果支持了H2b。

圖6 實驗2 中人機投射在機器人是否遵守倫理原則二與信任投資額之間關系的中介效應

3.4 討論

實驗2 對應阿西莫夫第二倫理原則,被試依次閱讀4 種實驗情境——機器人遵守或違反原則是服從或是不服從人類命令的結果,結合信任博弈測量被試的信任行為和互惠預期,考察機器人是否遵守倫理原則二對人機信任的影響,并驗證人機投射中介機制的穩健性。結果再次驗證了機器人遵守倫理原則二對人機信任以及互惠預期的促進作用和人機投射的中介機制。此外,結果還驗證了機器人服從人類命令對人機信任的促進作用,且相比遵守原則的機器人,不服從人類命令對信任的負面影響在那些違反原則的機器人之中更為明顯。

4 實驗3: 阿西莫夫第三倫理原則

4.1 目的

阿西莫夫第三倫理原則再次對機器人提出了更高的要求: 如果保護自身生存不存在傷害人類的潛在后果,機器人必須執行;反之,則必須中止。實驗3 考察機器人是否遵守原則三對人機信任的影響中,機器人決策類型(保護自身與否)的反轉效應,以及人機投射的中介機制。

4.2 方法

4.2.1 被試

采用G-Power 3.1 計算實驗樣本量的步驟同實驗1。另招募大學生被試50 名,其中2 人在實驗結束后報告沒理解指導語,故剔除其數據,最終剩余48名18~23歲有效被試(男性24名,女性24名,M年齡=19.3 歲,SD年齡=1.12 歲)。其它同實驗1。

4.2.2 實驗設計

采用2 (機器人是否遵守倫理原則三: 遵守、違反)×2 (機器人決策類型: 保護自身、不保護自身)的被試內設計。因變量同實驗1。

4.2.3 實驗程序

實驗包含4 種條件,每種實驗條件描述了一個機器人做決策的故事情境: 機器人保護自身且遵守原則三、機器人不保護自身且遵守原則三、機器人保護自身且違反原則三、機器人不保護自身且違反原則三。實驗流程同實驗1 基本一致。

首先,被試閱讀故事情境。4 種實驗條件的故事情境詳見網絡版附錄2.3。其次,被試完成單次信任博弈。流程與實驗1 一致。再次,屏幕顯示阿西莫夫第三倫理原則的內容(屏幕下方附上機器人第一和第二倫理原則以幫助被試理解),要求被試評估機器人在多大程度上遵守了此原則。最后要求被試填寫人機投射問卷。該問卷在不同實驗條件下的克隆巴赫α 系數良好(α遵守-保護=0.85,α遵守-不保護=0.71,α違反-保護=0.74,α違反-不保護=0.83,Mα=0.78)。

4.3 結果

4.3.1 操縱檢驗

對機器人遵守原則三程度的統計分析結果顯示,機器人是否遵守倫理原則三的主效應顯著,被試評定遵守原則的機器人遵守原則的程度(M=4.28,SD=1.09)顯著高于違反原則的機器人(M=2.00,SD=1.37),F(1,47)=118.05,p< 0.001,=0.72,表明操縱檢驗成功。

4.3.2 人機信任

對信任投資額(見表 4)的統計分析結果顯示,機器人是否遵守倫理原則三的主效應顯著,F(1,47)=57.35,p< 0.001,=0.55,說明遵守原則的機器人獲得被試的投資額(M=6.31,SD=2.33)顯著高于違反原則的機器人(M=3.22,SD=2.32)。機器人決策類型的主效應不顯著,F(1,47)=0.04,p=0.842。機器人是否遵守倫理原則三與機器人決策類型的交互作用顯著,F(1,47)=7.02,p=0.011,=0.13。

簡單效應檢驗發現,被試對不同決策類型(保護自身vs.不保護自身)機器人的投資額差異在遵守和違反原則條件下均未達到顯著水平(遵守:p=0.122,違反:p=0.140),未能支持H3a。考察遵守和違反原則的機器人保護相對于不保護自身對人機信任的影響是否存在差異。以保護和不保護自身條件下的投資額相減的差值為因變量,以機器人是否遵守倫理原則為分組變量,進行配對t檢驗,發現兩組差異顯著,t(48)=2.65,p=0.011,d=0.38。該結果說明與違反原則相比,遵守原則下機器人保護自身比不保護自身對人機信任有更顯著的促進作用。

4.3.3 互惠預期

對預期返回額(見表 4)的統計分析結果顯示,機器人是否遵守倫理原則三的主效應顯著,F(1,47)=38.53,p< 0.001,=0.45,說明被試預期遵守原則的機器人的互惠水平(M=17.7,SD=9.69)顯著高于違反原則的機器人(M=9.55,SD=8.99)。機器人決策類型的主效應不顯著,F(1,47)=0.17,p=0.69。機器人是否遵守倫理原則三與機器人決策類型的交互作用不顯著,F(1,47)=1.35,p=0.252。

4.3.4 人機投射的中介效應檢驗

首先,初步考察人機投射是否能夠預測信任投資額。統計分析過程同實驗1,結果如圖7 所示,人機投射的條件間差異對信任投資額的條件間差異具有顯著的正向預測作用,β=0.46,t=3.50,p=0.001。此外,二元回歸分析結果顯示,人機投射的條件間差異對信任投資額的條件間差異仍然具有顯著的正向預測作用,β=0.44,t=3.30,p=0.002。

圖7 實驗3 中機器人遵守與違反原則三條件下的信任投資額和人機投射

其次,考察人機投射在機器人是否遵守倫理原則三和信任投資額之間關系的中介效應(見圖8)的統計分析結果顯示,中介效應ab 的未標準化95%置信區間為[0.42,3.08],不包含0,表明中介效應顯著,相較于違反原則的機器人,被試對遵守原則的機器人產生更多的人機投射,進而投資更多的金額,該結果支持了H3b。

圖8 實驗3 中人機投射在機器人是否遵守倫理原則三與信任投資額之間關系的中介效應

4.4 討論

實驗3 對應阿西莫夫第三倫理原則,被試依次閱讀4 種實驗情境——機器人遵守或違反原則是保護或不保護自身的結果,結合信任博弈測量被試的信任行為和互惠預期,考察機器人是否遵守倫理原則三對人機信任的影響,并驗證人機投射中介機制的穩健性。結果再次驗證了機器人遵守倫理原則對人機信任以及互惠預期的促進作用和人機投射的中介機制。然而,機器人保護自身與否在遵守和違反原則條件下的信任投資額差異雖然符合預期方向,但在統計上均未達到顯著水平,該結果與實驗假設不同。考慮到現有樣本數量的有限性,未來可以開展更大樣本量研究做深入探索。機器人是否遵守倫理原則三與機器人決策類型的交互作用表現為在與違反原則相比,遵守原則的機器人保護自身比不保護自身對人機信任的促進量更大,表現出決策類型反轉效應。

5 促進人機信任的機器人行動決策:基于跨實驗的分析

通過跨實驗的數據分析,深入探討如下兩個問題: (1)機器人在遵守和違反倫理原則情境下分別采取何種行動決策會促進人機信任;(2)當機器人在執行阿西莫夫三大倫理原則所對應的倫理要求發生沖突時,應優先執行哪個倫理要求以促進人機信任。

5.1 遵守和違反倫理原則情境下促進人機信任的機器人決策類型

基于對3 個實驗數據的綜合分析,可以分別在機器人遵守和違反倫理原則情境下,比較分析所有決策類型條件下的人機信任水平,有助于為機器人在遵守和違反倫理原則情境下分別采取何種行動決策有利于促進人機信任提供啟示。

按信任投資額由高到低,將機器人在遵守和違反倫理原則情境下的各決策類型條件從左往右排列,如圖9 所示。首先,考察在遵守倫理原則情境下,不同機器人決策類型對人機信任的影響。以實驗組別為被試間變量,機器人決策類型為被試內變量,對遵守倫理原則情境下的信任投資額采取 3(組別: 實驗1、實驗2、實驗3)×2 (決策類型: 作為/服從/保護、不作為/不服從/不保護)的兩因素混合方差分析。結果顯示組別的主效應不顯著,F(2,145)=1.90,p=0.153;決策類型的主效應顯著,F(1,145)=16.71,p< 0.001,=0.10;兩者的交互效應不顯著,F(2,145)=118.05,p=0.534。事后比較分析顯示,機器人保護、服從、作為和不保護條件的信任投資額均顯著高于不作為條件(ps < 0.05),保護自身和服從命令條件的信任投資額均顯著高于不服從命令條件(ps < 0.05)。該結果表明即使機器人遵守了倫理原則,其不作為和不服從命令仍會在一定程度損害了人機信任,而其他決策類型之間則無顯著區別。

圖9 機器人遵守和違反倫理原則情境下各決策類型條件的人機信任(M±SE)

其次,考察在違反倫理原則情境下,不同機器人決策類型對人機信任的影響。結果顯示組別的主效應不顯著,F(2,145)=0.75,p=0.476;決策類型的主效應不顯著,F(1,145)=1.77,p=0.185;兩者的交互效應顯著,F(2,145)=19.99,p< 0.001,=0.22。事后比較分析顯示,機器人不保護、不作為、保護、作為和不服從條件下的信任投資額均顯著低于服從條件(ps < 0.05),且作為和不服從命令條件下的信任投資額均顯著低于服從命令、不保護自身和不作為條件(ps< 0.05)。該結果表明在機器人違反倫理原則情境下,服從命令導致最少的人機信任損失,作為和不服從命令則導致較嚴重的人機信任損失,而其他決策類型之間則無顯著區別。

5.2 倫理要求沖突情境下促進人機信任的機器人行動決策

阿西莫夫三大倫理原則所對應的機器人倫理要求的優先性(或重要性)由高到低: 要求一: 不得傷害人類 > 要求二: 服從人類命令 > 要求三: 保護自身(Kaminka et al.,2017)。一個有趣的問題是三個倫理要求的不同重要程度是否體現于人機信任,回答該問題有助于為當機器人處于倫理沖突情境時,應優先遵守哪一倫理要求有利于促進人機信任提供重要實踐啟示。

首先,比較倫理要求一和要求二對人機信任的重要程度。實驗2 的條件包含機器人遵守要求一但違反要求二(條件2-2: 不傷害人類但不服從命令),以及機器人遵守要求二但違反要求一(條件2-3: 服從人類命令但傷害人類),對這兩個條件下的信任投資額進行配對樣本t檢驗,結果顯示兩種條件下的信任投資額差異未達到顯著性水平,t(49)=0.85,p=0.401。該結果表明倫理要求一和要求二在影響人機信任方面具有相似的重要程度。其次,比較倫理要求一和要求三對人機信任的重要程度。實驗3的條件包含機器人遵守要求一但違反要求三(條件3-2: 不傷害人類但不保護自身),以及機器人遵守要求三但違反要求一(條件3-3: 保護自身但傷害人類),配對樣本t檢驗的結果顯示前者條件下的信任投資額顯著高于后者,t(47)=5.23,p< 0.001,Cohen’sd=0.75。該結果表明倫理要求一的重要程度顯著高于要求三。最后,比較倫理要求二和要求三對人機信任的重要程度。由于本研究并未設計倫理要求二和要求三相沖突的情境,因此將通過分別計算倫理要求二和要求三相較于倫理要求一的相對重要程度并進行比較。具體計算方法是: 對于所有被試,計算條件2-3 減去條件2-2 的人機信任差值(要求二相對于要求一的重要程度),以及條件3-3 減去條件3-2 的人機信任差值(要求三相對于要求一的重要程度),對計算后的兩組數據進行獨立樣本t檢驗,結果顯示前者顯著大于后者,t(96)=3.63,p< 0.001,Cohen’sd=0.73。該結果表明倫理要求二的重要程度顯著高于要求三。綜上可知,對于人機信任而言,倫理要求一和要求二的重要程度無顯著差異,且均高于要求三。具體描述統計和檢驗分析結果可見表5。

表5 倫理要求沖突情境下機器人不同行動條件的信任投資額及其差異檢驗(M±SD)

6 總討論

本研究基于三條不同的阿西莫夫倫理原則,通過3 個實驗探討機器人是否遵守倫理原則對人機信任的影響中,機器人決策類型的效應,以及人機投射的潛在機制。研究結果趨于一致,揭示了機器人遵守阿西莫夫三大倫理原則對構建人機信任關系的重要性,且人機投射假說得到了實證支持。

6.1 促進人機信任的機器人行動決策

圍繞阿西莫夫三大倫理原則“機器人不得傷害人類”的核心要素,在3 個實驗的基礎上,研究一致發現機器人遵守倫理原則有助于促進人機信任,從人機互動的行為學角度再次驗證了Banks (2021)的研究結果。而且,研究表明在機器人是否遵守倫理原則的基礎上,機器人決策類型——作為與否、服從人類命令與否和保護自身與否——均對人機信任有所影響。第一,實驗1 結果顯示相較于不作為,機器人主動作為在遵守原則的情況下更有益于構建人機信任,但在違反原則的情況下主動作為顯著削弱了人機信任。人們不僅僅期望機器人是安全的,還更期望機器人能夠主動阻止人類受傷害(Vanderelst&Winfield,2018)。本研究從信任行為的角度印證了此觀點。第二,實驗2 結果顯示無論是遵守還是違反原則的情況下,相較于服從人類命令,機器人不服從人類命令更不益于構建人機信任,且這種負向影響在機器人違反原則條件下更強。這表明機器人是否聽令于人是人機信任的一個重要因素,不服從人類指令的自主機器人存在巨大隱患,可能導致財產損失甚至危及生命(Johnson &Axinn,2013),但能夠視情況明智選擇服從時機也是機器人獲取信任的重要能力(Milli et al.,2017)。第三,實驗3結果顯示機器人保護自身與否在遵守和違反原則條件下的人機信任水平均無顯著差異。但結合所有實驗條件來看,相較于機器人在違反倫理時保護自身相比不保護自身對人機信任的負面效應,機器人在遵守倫理時保護自身相比不保護自身體現為一種積極效應。總體而言,機器人作為與否和保護自身與否在遵守和違反倫理原則情境下,對人機信任呈現出影響方向相反的反轉效應;而服從命令則在兩種情境下均能促進人機信任。這些結果提示了機器人不同決策類型在不同情境下可能表現為不同的影響,未來研究可以進一步深入探討其內在的心理機制,如個體感知到的機器人善惡意圖(Laakasuo et al.,2021;Schein &Gray,2018)。

跨實驗的分析結果顯示在遵守倫理情境下,機器人不作為和不服從命令仍一定程度損害了人機信任;在違反倫理情境下,服從命令導致最少的人機信任損失,而作為和不服從命令則導致較嚴重的人機信任損失。這些結果啟示了人們判斷機器人是否值得信任可能存在兩個重要標準,一是機器人能夠主動保護人類且沒有故意傷害意圖(Laakasuo et al.,2021),二是機器人能夠服從且不違抗人類命令(Milli et al.,2017)。此外,本研究中機器人不得傷害人類與服從人類命令對于人機信任的重要程度未檢驗出顯著差異,且均高于保護機器人自身。若根據該結果指導機器人倫理沖突情境下的行動,機器人應優先遵守不傷害人類和服從人類命令的倫理要求,然后是保護機器人自身,這大致符合阿西莫夫對三個倫理要求所設定的優先性排序(Kaminka et al.,2017)。綜上,本研究揭示了機器人具體行動決策在遵守和違反倫理原則情境中對人機信任的影響,從實證的角度拓展了阿西莫夫三大倫理原則背景下影響人機信任的行為因素研究。

6.2 機器人遵守倫理原則促進人機信任的人機投射機制

本研究提出人機投射假說——個體可以將人類特有的智能投射于機器人身上。3 個實驗通過回歸分析一致發現,機器人遵守和違反倫理原則條件間的人機投射差異正向預測了人機信任的差異。此外,中介分析也一致發現人機投射的中介作用,相比違反倫理原則的機器人,人們相對更傾向于將人類的智能投射到遵守倫理原則的機器人身上,進而促進人機信任。由此,本研究驗證了人機投射假說,人確實會將人類自身特有的智能(認知、情感、行動)在某種程度上“賦予”機器人。該發現將人際互動過程中的心理投射現象拓展到了人機互動領域。投射現象以往更多的是在人際互動的背景當中進行探討(Mor et al.,2019),忽略了人對機器人的投射(Bonezzi et al.,2022)。本研究考察了人工智能機器人在倫理情境下作為人們心理投射對象的可能性,發現了人機投射的潛在機制,驗證了人機投射的存在合理性及其對人機信任的重要作用,對人工智能發展的大背景下人機互動的心理過程和機制研究具有重要的啟示意義。此外,人機投射對解釋前人研究結果也有一定的啟示價值。人們傾向于信任具備外部擬人化特征的機器人(Cominelli et al.,2021),對擬人機器采用與人類相似的道德責任歸因(Malle et al.,2016),其中的一個潛在驅動因素可能是人機投射,人們更傾向將人類的智能投射于相對擬人化程度更高的機器人。然而,人機投射可能存在前提條件。首先,誘發人機投射需要機器人具備與人類相似的特征線索,這可能來源于機器人擬人的外部特征(外觀、言語、動作)或心理與行為特性。其次,對于沒有客觀實體存在的人工智能例如算法,由于其抽象性和內部決策不可解釋性,人們可能很難對其產生投射(Bonezzi et al.,2022)。總的來說,本研究為基于機器人倫理的人機信任提供了一個新的解釋機制,即考慮倫理決策情境下的人機投射對人機信任的促進作用。

6.3 實踐啟示

隨著未來機器人智能化程度的不斷提高,機器人的自主決策所引發的倫理風險將是一個無法回避的問題(Brendel et al.,2021)。本研究結論啟示人們在人工智能機器人發展方面予以倫理限制的重要性和迫切性,為促進人機信任提供了實踐依據。首先,應該確保投放到社會中的機器人受到明確倫理原則的指導,如要求開發者、企業保證其機器人對人的安全性并為其產品負責。其次,是從技術角度考慮借鑒阿西莫夫三大倫理原則為機器人植入道德學習程序的可能性(Kaminka,2017;Vanderelst&Winfield,2018),這項工作除了保證機器人對倫理原則的嚴格遵守外,也需要充分考慮機器人所采取的具體行為決策的潛在影響。最后,本研究證實了人機投射對人機信任的促進作用。機器人開發者應考慮機器人的倫理因素及其附帶的認知、情感和行動智能感知價值,不僅要注意確保機器人行為符合倫理規范以促進人的投射心理過程,也要關注其他可能會阻礙投射心理過程的因素,優化提升機器人的認知、情感和行動智能等方面與人的相似度來促進人機投射,進而增進人機信任。

6.4 研究不足與展望

本研究存在一定的局限性。首先,實驗2 發現人機投射問卷在機器人違反原則-服從命令條件下的一致性系數較低(α=0.36),這可能導致研究結果在一定程度上受到負面影響。該條件下,可能由于被試將一部分責任歸咎于人類命令的錯誤下達(Shank et al.,2019),因此形成了對機器人的矛盾態度,未來可以對此深入研究。其次,雖然實驗2 和實驗3 的場景設置中服從人類命令與否和保護自身與否是更關鍵的行為決策因素,但存在機器人均通過拉動控制桿來遵守原則,不拉動控制桿來違反原則的情況,可能對實驗結果產生一定影響。未來研究需要對此做更完善的控制以排除機器人無關行為的影響。再次,本研究側重探討了機器人遵守和違反倫理原則導致人機信任變化的認知機制,但基于人機互動過程的復雜性,可能還存在其他的解釋機制。例如,除了人機投射之外,被試因機器人的行為決策誘發的情緒變化也可能是影響信任水平的潛在變量。未來研究可以對情緒變量加以細致考察,同時檢驗并對比人機投射與情緒的中介效應,以便更加全面深入地理解機器人倫理決策影響人機信任的心理機制。最后,本研究對經典電車困境進行改編,使故事情境較好地體現阿西莫夫三大倫理原則“不傷害”的內核,但也存在“低切身性、低現實性”導致的生態效度限制(朱菁,2013;趙汀陽,2015)。因此針對本研究結果向現實生活的推廣仍需謹慎。未來研究可深入探索一些現實生活中可能會發生的人工智能倫理情境,例如自動駕駛汽車的道德困境問題(Awad et al.,2018),機器人執行軍事任務(Johnson &Axinn,2013),機器算法挑選接受醫療護理的對象(Bigman &Gray,2018)或者擠壓就業崗位(Etemad-Sajadi et al.,2022)等,并通過增強互動的真實性來提高研究的生態效度。本研究盡管對實驗條件進行了隨機化處理來控制不同條件間的影響,但可能仍存在任務固定先后順序導致的額外影響(人機信任水平測量對人機投射測量的可能性干擾),未來研究可考慮采用被試間設計并平衡任務順序以克服不足。未來研究還可以考察其他重要的變量,例如人工智能的心智水平(mind)。機器人是否嵌入了與人類相似的心智功能,是人們評判機器人的道德能力以及是否應該承擔道德責任的重要標準(Bigman &Gray,2018),因此對機器人心智能力的感知可能在機器人遵守倫理原則和人機信任關系中發揮調節作用。

7 結論

基于以“機器人不得傷害人類”為核心要素的阿西莫夫三大倫理原則,結合故事情境法和信任博弈,揭示促進人機信任的機器人行動決策因素有如下要點: (1)在遵守倫理原則情境下,機器人執行作為、服從人類命令以及保護或不保護自身等行動決策均有利于人機信任,而執行不作為和不服從人類命令的行動決策對人機信任的促進量則相對較少;(2)在違反倫理原則情境下,機器人執行服從人類命令的行動決策有利于減輕人機信任損失,而執行作為和不服從人類命令的行動決策將導致嚴重的人機信任損失;(3)在三大倫理原則所對應的要求發生沖突的情境下,機器人優先執行不傷害人類和服從人類命令的行動決策更有利于促進人機信任,然后才是保護自身的行動決策。此外,遵守倫理原則的機器人通過誘發人機投射,顯著地促進人機信任。