基于深度學(xué)習(xí)的金屬表面缺陷檢測(cè)

李濤,劉俊江,張聰,朱磊

基于深度學(xué)習(xí)的金屬表面缺陷檢測(cè)

李濤,劉俊江,張聰,朱磊

(齊齊哈爾大學(xué) 通信與電子工程學(xué)院,黑龍江 齊齊哈爾 161006)

由于金屬產(chǎn)品生產(chǎn)過程中各種因素的影響,金屬工件可能會(huì)存在一些表面缺陷.這會(huì)降低材料強(qiáng)度,縮短工件壽命,并且增加安全風(fēng)險(xiǎn).因此,需要對(duì)金屬產(chǎn)品表面進(jìn)行質(zhì)量檢測(cè),這也是保證工業(yè)生產(chǎn)質(zhì)量的關(guān)鍵環(huán)節(jié).與傳統(tǒng)人工檢測(cè)相比,基于機(jī)器視覺的表面缺陷檢測(cè)方法具有速度快、精度高等優(yōu)點(diǎn).提出了一種改進(jìn)的YOLOv5算法,用于金屬表面缺陷檢測(cè)研究,在原YOLOv5算法的基礎(chǔ)上將空間金字塔池化結(jié)構(gòu)SPP替換成SPPCSPC,提高模型對(duì)金屬表面缺陷的檢測(cè)能力.為了驗(yàn)證算法的有效性,分別采用YOLOv3,YOLOv4,YOLOv5及改進(jìn)的YOLOv5算法對(duì)1 800張金屬表面缺陷樣本圖像進(jìn)行對(duì)比測(cè)試.結(jié)果表明,與YOLOv3,YOLOv4,YOLOv5原算法相比,改進(jìn)的YOLOv5算法平均目標(biāo)檢測(cè)精度均值分別提高了4.3%,3.3%,2%.通過大量圖片的學(xué)習(xí),可以獲得更好的精確率.

金屬表面缺陷;空間金字塔池化;機(jī)器視覺;目標(biāo)檢測(cè)

近年來,金屬表面缺陷檢測(cè)在工業(yè)生產(chǎn)和制造領(lǐng)域中越來越受到關(guān)注.金屬表面缺陷不僅會(huì)影響產(chǎn)品的外觀質(zhì)量,還可能導(dǎo)致其在使用過程中發(fā)生失效,從而給生產(chǎn)企業(yè)帶來嚴(yán)重的經(jīng)濟(jì)損失和聲譽(yù)損害.傳統(tǒng)的金屬表面缺陷檢測(cè)方法主要依靠人工目視檢查,但是這種方法不僅效率低下,而且存在主觀性和疲勞度等問題.為了提高金屬表面缺陷檢測(cè)的準(zhǔn)確性和效率,越來越多的研究者探索基于深度學(xué)習(xí)[1]的方法.深度學(xué)習(xí)作為一種機(jī)器學(xué)習(xí)的分支,其優(yōu)勢(shì)在于可以自動(dòng)地從大量數(shù)據(jù)中學(xué)習(xí)并提取特征.因此,基于深度學(xué)習(xí)的金屬表面缺陷檢測(cè)方法可以通過對(duì)大量圖像數(shù)據(jù)的學(xué)習(xí)和訓(xùn)練,實(shí)現(xiàn)對(duì)金屬表面缺陷的自動(dòng)識(shí)別和分類.相比傳統(tǒng)的金屬表面缺陷檢測(cè)方法,基于深度學(xué)習(xí)的方法具有更高的準(zhǔn)確性和效率,并且可以實(shí)現(xiàn)自動(dòng)化及無損檢測(cè).

本文旨在探究基于深度學(xué)習(xí)的金屬表面缺陷檢測(cè)方法,并以NEU-DET數(shù)據(jù)集(東北大學(xué)鋼材表面缺陷檢測(cè)數(shù)據(jù)集)為例進(jìn)行實(shí)驗(yàn)研究.首先,采用卷積神經(jīng)網(wǎng)絡(luò)(CNN)對(duì)金屬表面缺陷進(jìn)行特征提取和分類,然后,通過實(shí)驗(yàn)對(duì)比YOLOv3[2],YOLOv4[3],YOLOv5[4]和改進(jìn)后的YOLOv5,并對(duì)該方法的準(zhǔn)確性和效率進(jìn)行評(píng)估.結(jié)果表明,改進(jìn)后的基于深度學(xué)習(xí)的金屬表面缺陷檢測(cè)方法可以取得較高的準(zhǔn)確性和效率,具有廣泛的應(yīng)用前景.未來,將進(jìn)一步完善基于深度學(xué)習(xí)的金屬表面缺陷檢測(cè)方法,以提高其在實(shí)際應(yīng)用中的準(zhǔn)確性和效率,并且將其應(yīng)用于更廣泛的金屬制造領(lǐng)域.隨著深度學(xué)習(xí)技術(shù)的不斷發(fā)展和應(yīng)用,基于深度學(xué)習(xí)的金屬表面缺陷檢測(cè)方法將在未來得到更廣泛的推廣和應(yīng)用,為工業(yè)生產(chǎn)和制造領(lǐng)域的發(fā)展做出更大的貢獻(xiàn).

1 實(shí)驗(yàn)說明

1.1 算法

卷積神經(jīng)網(wǎng)絡(luò)[5](Convolutional Neural Networks,CNN)近年來在圖像分類、目標(biāo)檢測(cè)、圖像語義分割等領(lǐng)域得到了廣泛的應(yīng)用,對(duì)于大型圖像的處理有出色的表現(xiàn),經(jīng)典的卷積神經(jīng)網(wǎng)絡(luò)主要由輸入層、卷積層、池化層、全連接層組成.其中卷積層主要的作用是特征提取,卷積核的權(quán)重是可以學(xué)習(xí)的,可根據(jù)目標(biāo)函數(shù)最優(yōu)化得出合適的參數(shù);池化層的主要作用是下采樣[6],用于有效地減少特征圖的維度大小,同時(shí)不損壞識(shí)別的結(jié)果;全連接層的作用主要是特征組合及分類,提供特征的復(fù)雜非線性變換.CNN由一層或多層隱藏層組成,多層的隱含層可以通過低級(jí)特征組合從而形成高級(jí)的特征,第一層卷積層可能只能提取一些低級(jí)的特征,如邊緣、線條和角等層級(jí),更多層的網(wǎng)路能從低級(jí)特征中迭代提取更復(fù)雜的特征,創(chuàng)建層級(jí)結(jié)構(gòu)可以提升性能和計(jì)算效率.

神經(jīng)網(wǎng)絡(luò)[7]是通過對(duì)人的大腦神經(jīng)網(wǎng)絡(luò)研究,信息處理后抽象簡(jiǎn)化得來的,激活函數(shù)是非線性的,它們將非線性特性引入到網(wǎng)絡(luò)中.在神經(jīng)元中,輸入的inputs通過加權(quán)求和后,還被作用了一個(gè)函數(shù),這個(gè)函數(shù)就是激活函數(shù).激活函數(shù)是非線性的,它們將非線性特性引入到神經(jīng)網(wǎng)絡(luò)中,常用的激活函數(shù)有sigmoid,tanh,relu等.

損失函數(shù)[8]是用于計(jì)算預(yù)測(cè)值與目標(biāo)值誤差的函數(shù).反向傳播過程中需要對(duì)網(wǎng)絡(luò)中的每一個(gè)權(quán)重都計(jì)算損失函數(shù)的梯度,并通過梯度下降來更新權(quán)重使得損失函數(shù)達(dá)到最小.

1.2 YOLOv5 算法概述

深度學(xué)習(xí)與機(jī)器視覺領(lǐng)域的發(fā)展為金屬表面缺陷檢測(cè)任務(wù)提供了智能、便捷的缺陷檢測(cè)方法,該類方法主要是將算法部署在移動(dòng)端對(duì)金屬表面缺陷進(jìn)行實(shí)時(shí)、精準(zhǔn)檢測(cè),要求選取的算法具有較強(qiáng)的檢測(cè)能力和抗干擾能力.本文在YOLOv5算法的基礎(chǔ)上對(duì)金屬表面缺陷檢測(cè)任務(wù)進(jìn)行了有針對(duì)性的改進(jìn).YOLOv5算法由骨干網(wǎng)絡(luò)、頸網(wǎng)絡(luò)、預(yù)測(cè)網(wǎng)絡(luò)三部分構(gòu)成.骨干網(wǎng)絡(luò)主要采用帶有殘差結(jié)構(gòu)的C3模塊對(duì)圖片進(jìn)行特征提取;頸網(wǎng)絡(luò)由特征金字塔網(wǎng)絡(luò)[9](Feature Pyramid Networks,F(xiàn)PN)和金字塔注意力網(wǎng)絡(luò)[10](Pyramid Attention Network,PAN)組成,實(shí)現(xiàn)了特征增強(qiáng)與上下信息流融合;預(yù)測(cè)網(wǎng)絡(luò)擁有三層檢測(cè)層,每個(gè)檢測(cè)層的損失由定位、分類和置信度三類損失組成,其中分類和置信度損失通過二元交叉熵?fù)p失函數(shù)進(jìn)行計(jì)算,而定位損失采用的是完全重疊度(Complete Intersection over Union,CIoU)損失函數(shù).最后通過預(yù)設(shè)的置信度閾值對(duì)預(yù)測(cè)框進(jìn)行篩選,實(shí)現(xiàn)對(duì)檢測(cè)目標(biāo)的定位與分類.YOLOv5的整體結(jié)構(gòu)見圖1.輸入端為經(jīng)過處理后的640×640×3的輸入圖像;C3為特征提取模塊;P1至P5為網(wǎng)絡(luò)層數(shù);SPPF為快速空間金字塔池化層;20×20×255,40×40×255,80×80×255為輸出特征圖的長(zhǎng)、寬和維度,分別對(duì)應(yīng)網(wǎng)絡(luò)對(duì)大、中、小不同尺度目標(biāo)的檢測(cè)任務(wù).

圖1 YOLOv5 網(wǎng)絡(luò)結(jié)構(gòu)

1.3 改進(jìn) YOLOv5 網(wǎng)絡(luò)結(jié)構(gòu)——空間金字塔池化

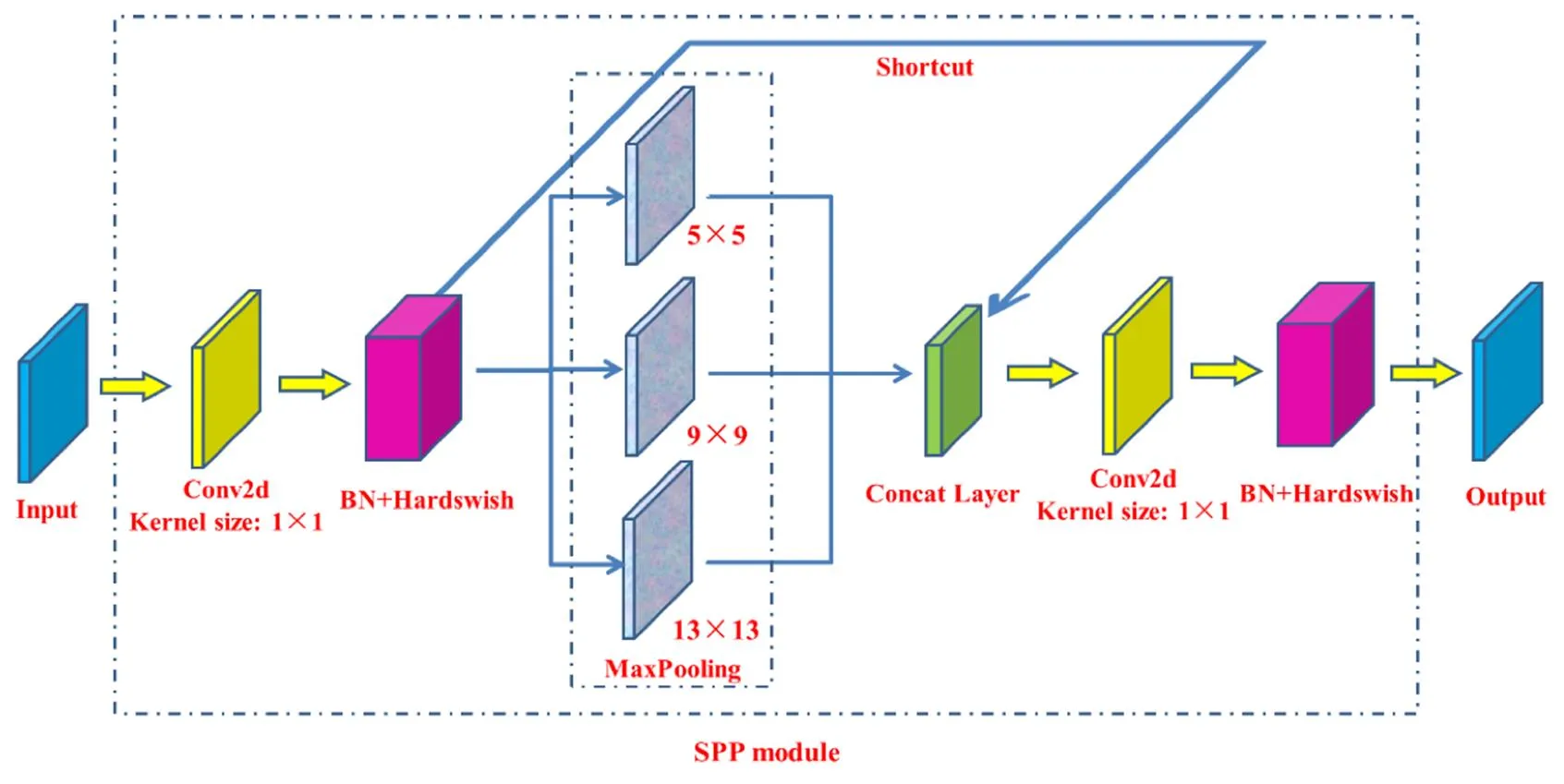

考慮到金屬表面缺陷識(shí)別精度對(duì)工業(yè)生產(chǎn)的重要性,本文將使用SPPCSPC來替換SPP.SPPCSPC的網(wǎng)絡(luò)結(jié)構(gòu)見圖2.它通過卷積、批歸一化、激活函數(shù)以及池化操作等來提升模型對(duì)金屬表面缺陷檢測(cè)的識(shí)別能力,能夠在增加少量參數(shù)的前提下提高對(duì)金屬表面缺陷數(shù)據(jù)集的特征提取能力.

圖2 SPPCSPC 模塊結(jié)構(gòu)

2 實(shí)驗(yàn)評(píng)估指標(biāo)

3 實(shí)驗(yàn)驗(yàn)證

3.1 數(shù)據(jù)集

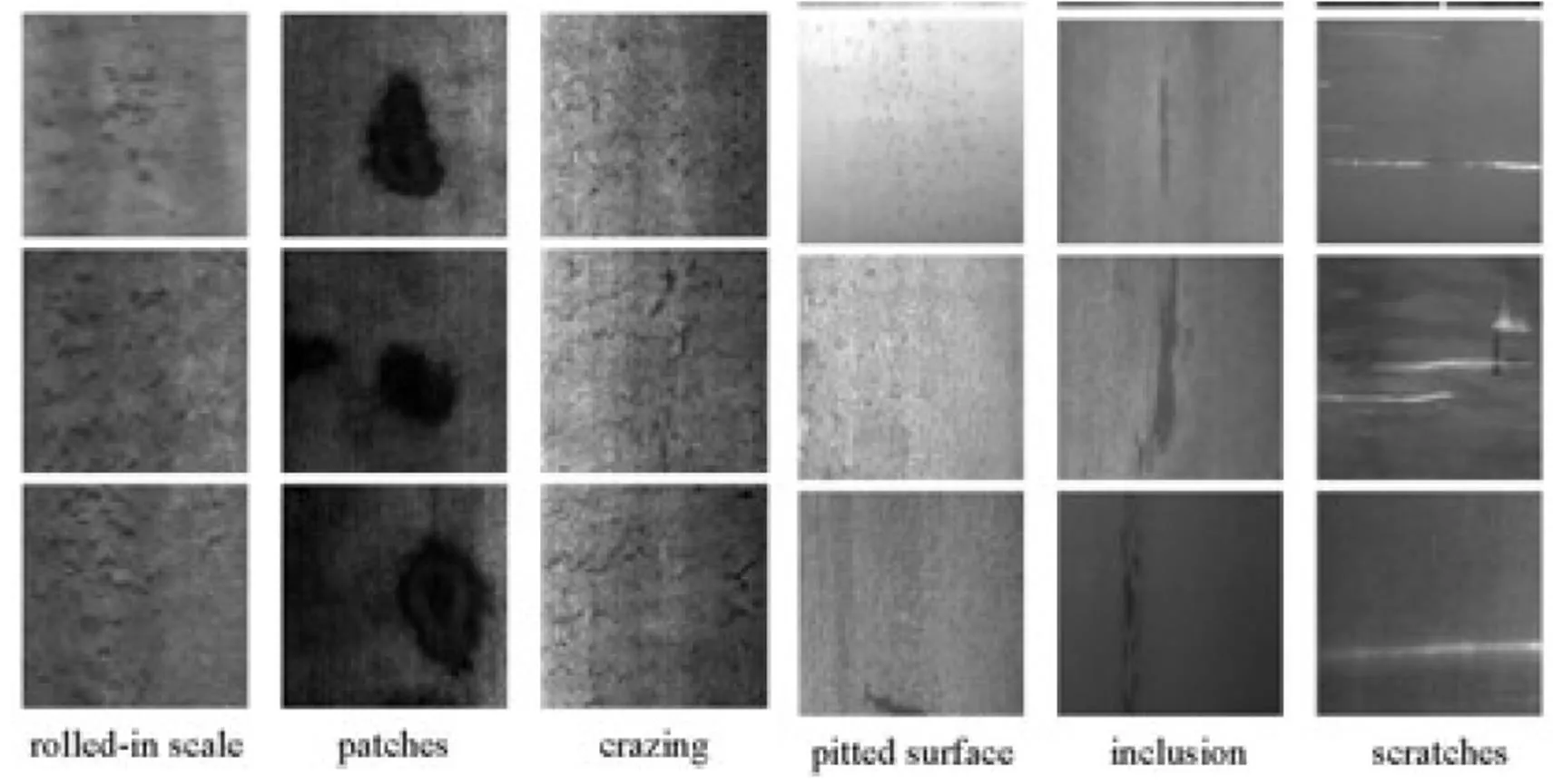

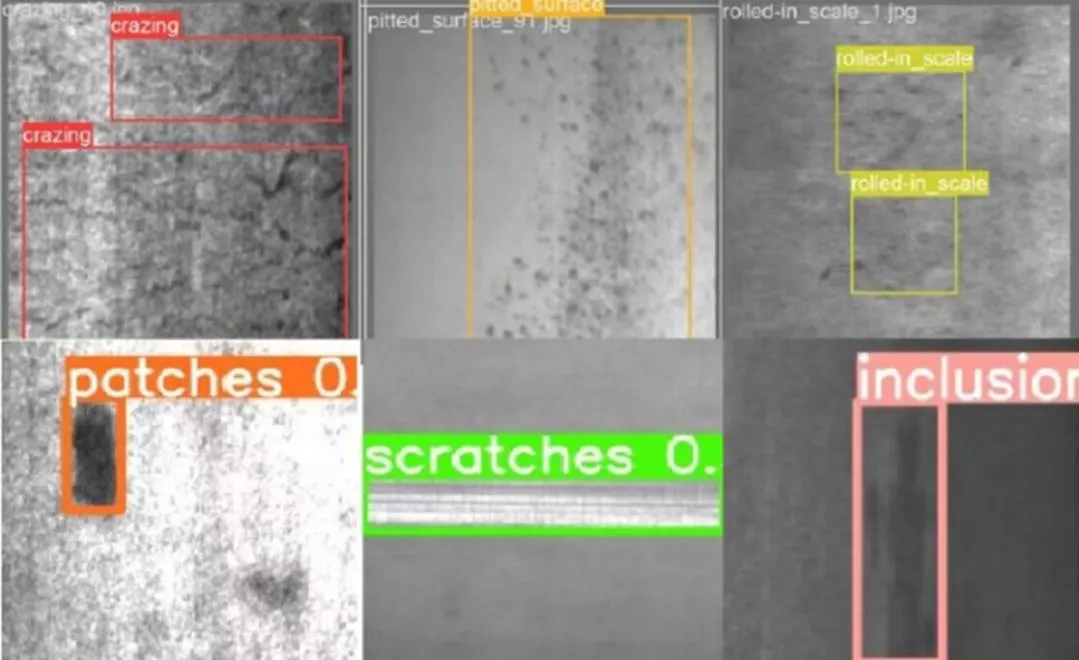

在東北大學(xué)(NEU)的表面缺陷數(shù)據(jù)庫中,收集了六種典型的熱軋鋼帶表面缺陷,即軋痕(RS)、斑塊(Pa)、裂紋(Cr)、凹陷面(PS)、包容(In)和劃痕(Sc).該數(shù)據(jù)庫包括1 800張灰度圖像:六種不同類型的典型表面缺陷各300張樣本.

六種典型表面缺陷的樣本圖像見圖3,每張圖像的原始分辨率為200×200像素.從圖3中可以清楚地看到,類內(nèi)缺陷在外觀上存在較大的差異,如劃痕(最后一列)可能是水平劃痕、垂直劃痕和斜向劃痕等.同時(shí),類內(nèi)缺陷也有類似的方面,如軋痕、裂紋和凹陷的表面.此外,由于光照和材料變化的影響,類內(nèi)缺陷圖像的灰度是不同的.簡(jiǎn)而言之,NEU表面缺陷數(shù)據(jù)庫包括兩個(gè)難題,即類內(nèi)缺陷在外觀上存在較大差異,而類間缺陷具有相似的方面,缺陷圖像受到光照和材料變化的影響.

圖3 NEU-CLS

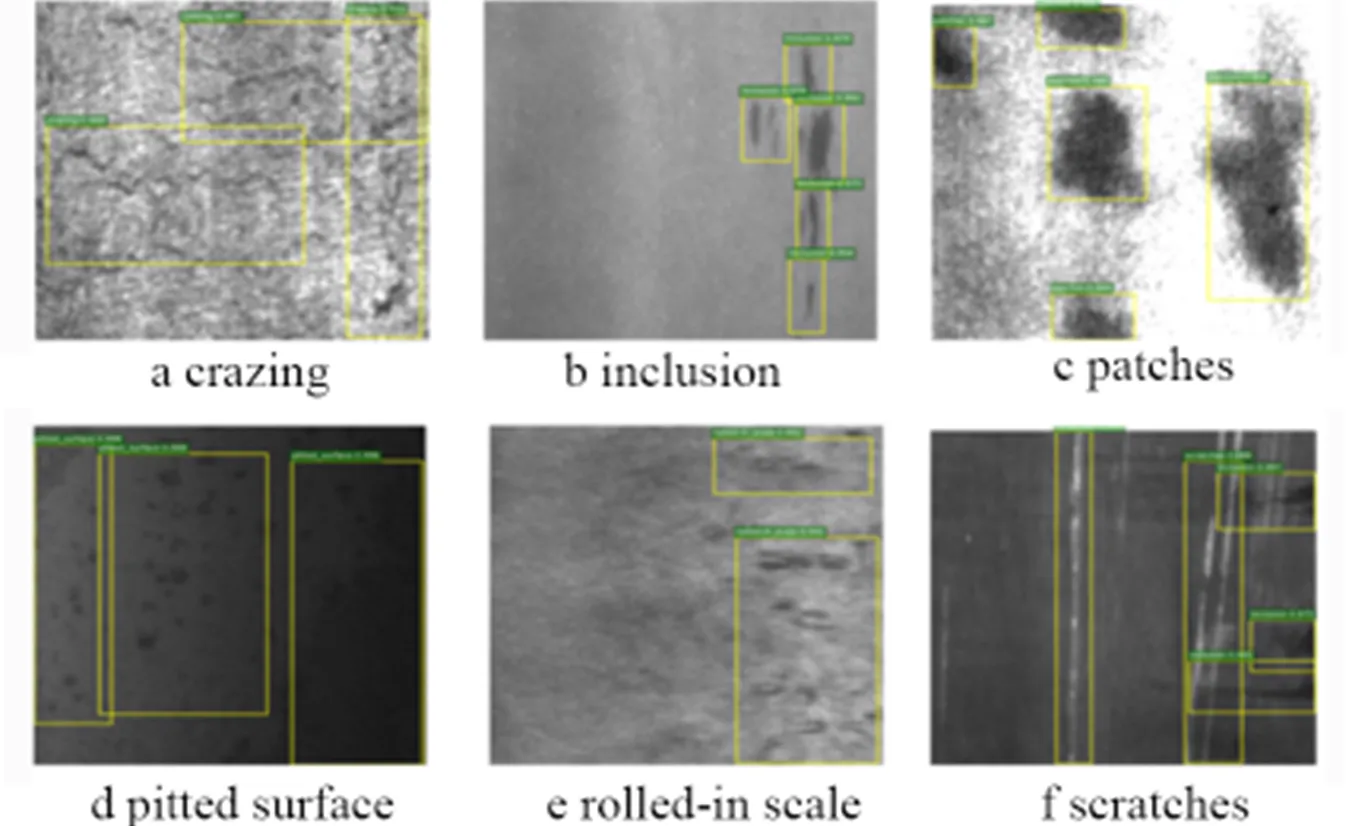

對(duì)于缺陷檢測(cè)任務(wù),此數(shù)據(jù)集提供了注釋,表明每張圖像中缺陷的類別和位置.NEU-DET的一些檢測(cè)結(jié)果的實(shí)例見圖4.對(duì)于每個(gè)缺陷,黃色框表示其位置的邊界框,綠色標(biāo)簽是類別得分.

圖4 NEU-DET

3.2 數(shù)據(jù)預(yù)處理

3.2.1 Mosaic數(shù)據(jù)增強(qiáng) Mosaic數(shù)據(jù)增強(qiáng)的方式參考了CutMix[12]數(shù)據(jù)增強(qiáng)思想.CutMix數(shù)據(jù)增強(qiáng)將2張圖片進(jìn)行拼接,而Mosaic采用4張圖片的拼接,增加數(shù)據(jù)量的同時(shí)可以豐富檢測(cè)物體的背景.

3.2.2 自適應(yīng)錨框 在YOLO系列算法中,通常對(duì)不同的數(shù)據(jù)集都會(huì)設(shè)定初始長(zhǎng)寬的錨框.在YOLOv3,YOLOv4中,初始錨框都是通過單獨(dú)算法得到的,常用的是K-means算法.本文將這種功能嵌入至代碼中,實(shí)現(xiàn)了每次訓(xùn)練可以自適應(yīng)地計(jì)算不同訓(xùn)練集中的最佳初始錨框.初始錨框?yàn)閇10,13,16,30,33,23]、[30,61,62,45,59,119]、[116,90,156,198,373,326],經(jīng)過計(jì)算本文最佳初始錨框?yàn)閇111,114,141,121,127,141]、[150,149,159,169,195,212]、[256,173,173,292,326,298].

3.2.3 自適應(yīng)縮放圖片 數(shù)據(jù)集的大小往往都是大小不一,需要對(duì)其尺寸歸一化.然而,實(shí)際項(xiàng)目中的很多圖片長(zhǎng)寬比不一致,縮放并填充后,兩端填充部分較多,存在很多冗余信息,影響模型速度及效果.本文方法對(duì)原始圖像進(jìn)行自適應(yīng)填充最少的灰度值,使得圖像高度或?qū)挾葍啥说幕叶戎底钌伲?jì)算量也會(huì)隨之減少,速度也得到提升,具體步驟為:

(1)圖像縮放比例.假設(shè)原始圖像為1 000×800,縮放至416×416.將416×416除以原始圖像相應(yīng)寬高,得到系數(shù)分別為0.416,0.52,取其較小值0.416.

(2)縮放后的尺寸.將原始圖片寬高乘以較小的系數(shù)0.416,則寬為416,高為332.

(3)灰邊的填充值.先將416-332=84,并采用取余的方式得需要填充的像素值84%32=20(32是由于網(wǎng)絡(luò)經(jīng)過了5次下采樣,2的5次方為32,兩端各10個(gè)像素.在測(cè)試過程中采用灰色填充,訓(xùn)練過程依舊使用原始的resize操作以提高物體的檢測(cè)、計(jì)算速度.

3.3 對(duì)比實(shí)驗(yàn)

為了能夠判斷改進(jìn)后的模型對(duì)于金屬表面缺陷的檢測(cè)性能是否優(yōu)于其他網(wǎng)絡(luò)模型,本文用改進(jìn)后的YOLOv5s模型與YOLOv3,YOLOv4,YOLOv5系列進(jìn)行對(duì)比試驗(yàn).這些模型的不同是:首先,YOLOv4在輸入端使用了Mosaic數(shù)據(jù)增強(qiáng),而YOLOv5在其基礎(chǔ)上還使用了自適應(yīng)錨框計(jì)算、自適應(yīng)圖片縮放.其次,YOLOv3的Backbone都采用了Darknet53,其借鑒了ResNet[13]的殘差結(jié)構(gòu),使其網(wǎng)絡(luò)結(jié)構(gòu)更深.而YOLOv4則是將各種新的結(jié)構(gòu)結(jié)合起來,其中就包括了CSPDarknet53[14]、Mish激活函數(shù)、Dropblock等.與YOLOv4不同的是,YOLOv5添加了Focus結(jié)構(gòu)、CSP結(jié)構(gòu),并且設(shè)計(jì)了兩種CSP結(jié)構(gòu),一種應(yīng)用于Backbone,一種應(yīng)用于Neck中.再次,在Neck中,YOLOv3只使用了FPN結(jié)構(gòu);YOLOv4則是使用了SPP模塊、FPN+PAN結(jié)構(gòu);YOLOv5在YOLOv4的基礎(chǔ)上將一些普通卷積替換成了CSP結(jié)構(gòu),加強(qiáng)網(wǎng)絡(luò)特征融合能力.最后,在Prediction中,YOLOv3的損失函數(shù)使用的是BCE(Binary Cross Entropy)Loss以及MSE(Mean Squared Error)Loss;YOLOv4使用的是CIoU Loss和DIoU NMS[15];YOLOv5使用CIoU Loss和加權(quán)NMS[16-17].對(duì)比試驗(yàn)的結(jié)果見表1.本文改進(jìn)方法與YOLOv3相比,mAP(Mean Average Precision)提升了4.2個(gè)百分點(diǎn),檢測(cè)速度也較快;與YOLOv4相比,mAP提升了3.3個(gè)百分點(diǎn),召回率與FPS低于YOLOv4的原因是本文著重于mAP與參數(shù)量大小的改進(jìn);與原YOLOv5的兩個(gè)大小不同的模型相比,評(píng)價(jià)指標(biāo)基本上都占優(yōu),檢測(cè)速度也滿足實(shí)時(shí)檢測(cè)的要求.綜上所述,改進(jìn)后的模型在mAP、參數(shù)量都是最優(yōu)的,基本上在性能上全面領(lǐng)先其他模型,能夠更好地部署到嵌入式設(shè)備中,滿足實(shí)時(shí)檢測(cè)的要求.因此,更加適合用于金屬表面缺陷的檢測(cè).

表1 對(duì)比試驗(yàn)結(jié)果

3.4 SPP 模塊的結(jié)構(gòu)

SPP 模塊的結(jié)構(gòu)見圖5.頸部網(wǎng)絡(luò)是一系列混合組合圖像特征的特征聚合層,主要用于生成FPN(feature pyramid networks),然后將輸出的特征圖傳給預(yù)測(cè)網(wǎng)絡(luò).由于該網(wǎng)絡(luò)的特征提取器采用了一種新的增強(qiáng)自下而上路徑的FPN結(jié)構(gòu),改善了低層特征的傳遞,增強(qiáng)了對(duì)不同尺度物體的檢測(cè).因此,可以準(zhǔn)確識(shí)別不同大小和尺度的同一目標(biāo)物體.

預(yù)測(cè)網(wǎng)絡(luò)主要用于模型最后的檢測(cè)部分,對(duì)上一層輸出的特征圖應(yīng)用錨框,輸出一個(gè)向量,包含目標(biāo)物體的類別概率、物體得分、位置、對(duì)象周圍的邊界框.YOLOv5s架構(gòu)的檢測(cè)網(wǎng)絡(luò)由三個(gè)檢測(cè)層組成,其輸入是尺寸分別為 80×80,40×40,20×20 的特征圖,用于檢測(cè)不同大小的圖像對(duì)象.每個(gè)檢測(cè)層最終輸出一個(gè)21通道的向量((2類+1類概率+4個(gè)周圍框位置坐標(biāo))×3個(gè)錨框),然后生成預(yù)測(cè)的邊界框和原圖中目標(biāo)的類別并標(biāo)注,實(shí)現(xiàn)圖像中金屬目標(biāo)的檢測(cè).

圖5 SPP 模塊的結(jié)構(gòu)

3.5 實(shí)驗(yàn)與分析

本文算法的實(shí)驗(yàn)環(huán)境——操作系統(tǒng):Windows10;GPU:RTX 2080ti;內(nèi)存:476G;深度學(xué)習(xí)框架:pytorch;編程語言:Python3.7.

目標(biāo)檢測(cè)中的改進(jìn)技巧對(duì)模型是否有用,與模型規(guī)模、網(wǎng)絡(luò)結(jié)構(gòu)、數(shù)據(jù)集分布等情況有關(guān).YOLOv5模型及其添加了改進(jìn)技巧的模型在NEU-DET數(shù)據(jù)集上相關(guān)的訓(xùn)練設(shè)置描述.

采用YOLOv5模型在COCO數(shù)據(jù)集上的預(yù)訓(xùn)練權(quán)重,設(shè)置批次大小為8,訓(xùn)練的最大次數(shù)為150.以改進(jìn)實(shí)驗(yàn)中mAP指標(biāo)最高的模型即采用SPPCSPC來替換SPP改進(jìn)的YOLOv5為例,在NEU-DET測(cè)試集上的曲線見圖6,圖像預(yù)測(cè)樣本見圖7.

圖6 改進(jìn)YOLOv5后的P-R曲線

圖7 預(yù)測(cè)結(jié)果樣本

首先,由采用SPPCSPC來替換SPP改進(jìn)的YOLOV5模型在測(cè)試集上的曲線可以看出,此時(shí)的目標(biāo)檢測(cè)模型在NEU-DET數(shù)據(jù)集上mAP達(dá)到了72.90%.這說明,采用SPPCSPC來替換SPP有效地提高了在NEU-DET數(shù)據(jù)集上的識(shí)別能力.

其次,對(duì)照NEU-DET數(shù)據(jù)集中測(cè)試集樣本的預(yù)測(cè)結(jié)果樣本可以看出,目標(biāo)檢測(cè)模型在缺陷類別識(shí)別方面未出現(xiàn)錯(cuò)誤,整體識(shí)別效果較好.

實(shí)驗(yàn)測(cè)試結(jié)果表明,分類識(shí)別與目標(biāo)檢測(cè)功能基本滿足準(zhǔn)確性與實(shí)時(shí)性的要求,為實(shí)際生產(chǎn)現(xiàn)場(chǎng)的應(yīng)用提供了理論支持與技術(shù)支撐.但是,本文研究的內(nèi)容仍然存在一些不足,有待進(jìn)一步的改進(jìn)與完善.

(1)與實(shí)際生產(chǎn)加工過程中的金屬產(chǎn)品表面缺陷種類的數(shù)量和同種缺陷不同表現(xiàn)的數(shù)量相比,本文中引入的公共數(shù)據(jù)集的缺陷數(shù)據(jù)是較少的,且不全面.可以考慮結(jié)合生產(chǎn)一線更多的數(shù)據(jù),擴(kuò)展數(shù)據(jù)集內(nèi)容,加強(qiáng)模型的識(shí)別性能.(2)可以考慮對(duì)目標(biāo)檢測(cè)模型的主干網(wǎng)絡(luò)做輕量化的處理,在保證檢測(cè)精度的情況下加快缺陷檢測(cè)速度,降低對(duì)計(jì)算機(jī)硬件參數(shù)的要求.(3)在金屬表面缺陷檢測(cè)系統(tǒng)的實(shí)現(xiàn)中,未對(duì)深度學(xué)習(xí)的網(wǎng)絡(luò)做模型加速部署,可以考慮優(yōu)化模型部署方式,提高系統(tǒng)識(shí)別性能與可靠性.

4 結(jié)論

本文基于YOLOv5網(wǎng)絡(luò)模型改進(jìn)了一種工業(yè)生產(chǎn)場(chǎng)景下適用于不同的金屬表面缺陷檢測(cè)的算法模型,改進(jìn)的模型在檢測(cè)任務(wù)中提高了目標(biāo)檢測(cè)精度,這符合工業(yè)生產(chǎn)場(chǎng)景下目標(biāo)檢測(cè)需要較高檢測(cè)精度的工作需求.本文模型在原YOLOv5模型的基礎(chǔ)上將空間金字塔池化結(jié)構(gòu)SPP替換成SPPCSPC,顯著提升了整體網(wǎng)絡(luò)模型對(duì)小目標(biāo)的檢測(cè)性能.改進(jìn)的YOLOv5提高了檢測(cè)精度,通過這一系列的改進(jìn)使得整體網(wǎng)絡(luò)模型更滿足于金屬表面缺陷檢測(cè)的工作環(huán)境需求.從最后的檢測(cè)結(jié)果來看,本文模型相較于YOLOv5網(wǎng)絡(luò)檢測(cè)精度有著顯著提升,并且也提高了整體網(wǎng)絡(luò)的魯棒性,具有更好的檢測(cè)性能和目標(biāo)分辨能力,這也是金屬表面缺陷檢測(cè)領(lǐng)域的重要發(fā)展方向之一.

[1] Le Cun Y,Bengio Y,Hinton G.Deep learning[J].Nature,2015,521(7553):436-444.

[2] Redmon J,F(xiàn)arhadi A.Yolov3:An incremental improvement[J].a(chǎn)rXiv preprint arXiv:2018,1804.02767.

[3] BOCHKOVSKIY A,WANG C Y,LIAO H Y M.Yolov4:Optimal speed and accuracy of object detection[J].a(chǎn)rXiv preprint arXiv:2020,2004.10934.

[4] ZHU X,LYU S,WANG X,et al.TPH-YOLOv5:Improved YOLOv5 based on transformer prediction head for object detection on drone-captured scenarios[C]//Proceedings of the IEEE/CVF international conference on computer vision.2021:2778-2788.

[5] Albawi S,Mohammed T A,Al-Zawi S.Understanding of a convolutional neural network[C]//2017 international conference on engineering and technology(ICET).Antalya,Turkey,2017:1-6.

[6] 劉穎,劉紅燕, 范九倫, 等. 基于深度學(xué)習(xí)的小目標(biāo)檢測(cè)研究與應(yīng)用綜述[J].電子學(xué)報(bào), 2020,48(3): 590-601.

[7] 周飛燕, 金林鵬,董軍.卷積神經(jīng)網(wǎng)絡(luò)研究綜述[J].計(jì)算機(jī)學(xué)報(bào),2017, 40(6):1229-1251.

[8] Schorfheide F.Loss functionbased evaluation of DSGE models[J].Journal of Applied Econometrics,2000,15(6):645-670.

[9] LIN T Y,DOLLáR P,GIRSHICK R,et al.Feature pyramid networks for object detection[C]//Proceedings of the IEEE conference on computer vision and pattern recognition.2017:2117-2125.

[10] LI H,XIONG P,AN J,et al.Pyramid attention network for semantic segmentation[J].a(chǎn)rXiv preprint arXiv:2018,1805.10180 .

[11] 楊斌,李成華,江小平,等.一種用于提升深度學(xué)習(xí)分類模型準(zhǔn)確率的正則化損失函數(shù)[J].中南民族大學(xué)學(xué)報(bào)(自然科學(xué)版),2020,39(1):74-78.

[12] YUN S,HAN D,OhS J,et al.Cutmix:Regularization strategy to train strong classifiers with localizable features[C]//Proceedings of the IEEE/CVF international conference on computer vision.2019:6023-6032.

[13] WU Z,SHEN C,Van Den HENGEL A.Wider or deeper:Revisiting the resnet model for visual recognition[J].Pattern Recognition,2019,90:119-133.

[14] Misra D.Mish:A self regularized non-monotonic activation function[J].a(chǎn)rXiv preprint arXiv:2019,1908.08681.

[15] ZHENG Z,WANG P,LIU W,et al.Distance-IoU loss:Faster and better learning for bounding box regression[C]//Proceedings of the AAAI conference on artificial intelligence,2020,34(7):12993-13000.

[16] Bodla N,Singh B,Chellappa R,et al.Soft-NMS——improving object detection with one line of code[C]//Proceedings of the IEEE international conference on computer vision.2017:5561-5569.

[17] ZHANG H,LI F,LIU S,et al.Dino:Detr with improved denoising anchor boxes for end-to-end object detection[J].a(chǎn)rXiv preprint arXiv:2022,2203.03605 .

Metal surface defect detection based on deep learning

LI Tao,LIU Junjiang,ZHANG Cong,ZHU Lei

(School of Communication and Electronic Engineering,Qiqihar University,Qiqihar 161006,China)

Due to various factors in the production of metal products,some surface defects may exist on metal workpieces.This can reduce the strength of the material,shorten the life of the workpiece,and increase the safety risk.Therefore,it is necessary to carry out quality inspection on the surface of metal products,which is also a key link to ensure the quality of industrial production.Compared with the traditional manual inspection,the machine vision-based surface defect detection method has the advantages of high speed and high accuracy.An improved YOLOv5 algorithm is proposed for metal surface defect detection research,which replaces the spatial pyramid pooling structure SPP with SPPCSPC on the basis of the original YOLOv5 algorithm to improve the model′s ability to detect defects on metal surfaces.In order to verify the effectiveness of the algorithm,a comparative test is conducted on 1 800 samples of metal surface defects using YOLOv3,YOLOv4,YOLOv5,and an enhanced YOLOv5 algorithm.The results show that compared with the original algorithms of YOLOv3,YOLOv4,and YOLOv5,the mean average target detection accuracy of the improved YOLOv5 algorithm has been improved by 4.3%,3.3%,and 2%,respectively.A better accuracy rate can be obtained by learning from a large number of images.

metal surface defects;spatial pyramidal pooling structure;machine vision;target detection

TP391.41∶TG11

A

10.3969/j.issn.1007-9831.2024.01.008

1007-9831(2024)01-0036-07

2023-06-21

2022年度黑龍江省大學(xué)生創(chuàng)新創(chuàng)業(yè)訓(xùn)練計(jì)劃項(xiàng)目(S202210232132); 黑龍江省教育科學(xué)“十四五”規(guī)劃重點(diǎn)課題(GJB1422319)

李濤(2001-),男,山西大同人,在讀本科生.E-mail:2471539653@qq.com

朱磊(1982-),女,吉林敦化人,教授,博士,從事機(jī)器學(xué)習(xí)與電磁超表面研究.E-mail:zhuzhubutterfly@163.com