基于多分支特征融合的密集人群計數網絡

孫 爽,何立風,朱 紛,張夢穎

(陜西科技大學 電子信息與人工智能學院,陜西 西安 710021)

0 引 言

人群計數可以用于預測擁擠場景中人群數量和密度分布,有助于在人群擁擠場所下的人群管理和控制,在視頻監控領域和公共安全管理領域都具有十分重要的應用價值[1]。

近年來,卷積神經網絡被廣泛應用于計數任務。MCNN[2]多列網絡通過使用3個不同大小的卷積核來捕獲不同的感受野以提取不同的尺度特征,得了不錯的計數結果。但是當網絡較深時,多列網絡會導致更多的參數量和計算量,網絡的訓練難度較大。因此,Li等[3]提出了一種單列深層網絡CSRNet,使用多個空洞卷積來提取多尺度上下文信息,在保留原圖分辨率的情況下擴大模型的感受野,大大提高了人群計數精度。

然而,人頭尺度多樣性與復雜背景干擾等問題仍是人群計數任務的主要挑戰[4]。以往方法在提取特征時,大多采用特征單向流動,并未充分利用網絡淺層的細節信息與深層的語義信息,為了進一步學習到圖像的尺度特征,同時排除復雜背景的干擾,本文提出了一種基于多分支特征融合的人群計數網絡(multi-branch feature fusion network,MFNet),主要工作可以分為以下幾個方面:

(1)提出一種多尺度特征增強模塊(multi-scale feature enhancement module,MFEM)來提取連續變化的尺度特征,解決人群計數中的多尺度變化問題。

(2)提出一種多分支上下文注意模塊(multi-branch context attention module,MCAM)來融合網絡淺層和深層的特征,并使用注意力機制抑制背景噪聲干擾。

(3)在3個公開數據集上進行訓練和測試,本文提出的計數網絡模型都表現出了良好的計數性能,驗證了該模型的有效性。

1 相關工作

傳統的人群計數算法可以分為基于檢測和回歸的計數方法[5]。基于檢測的方法主要通過檢測出圖像中的單個個體并相加得到人群數量。該類算法在稀疏場景下的計數精度高,在密集的人群場景下性能較差。基于回歸的方法可以分為基于數量回歸和基于密度圖回歸[6]。基于數量的回歸方法需要先從擁擠的圖像中提取手工繪制的特征,然后利用回歸函數來學習這些特征與人數之間的映射關系。提取的圖像特征包括形狀、大小、邊緣等信息。使用回歸函數如高斯過程回歸、貝葉斯回歸和線性回歸等函數來回歸擁擠圖像中的總人數。然而,大多數基于回歸的方法只提供了人群的數量而忽略了圖像中人群分布的空間信息。針對上述問題,研究者提出基于密度圖回歸[7]的方法,通過使用人群密度圖來表示圖像中人群的分布信息,學習圖像和密度圖之間的映射關系。密度圖既可以反映出人群分布情況,也可以得到人群數量,幫助我們獲得更準確、更全面的信息,并大幅度提升了相關性能。

伴隨著深度學習技術的進步,卷積神經網絡(convolutional neural networks,CNN)也被應用于人群計數任務[8]。在人群計數領域,利用CNN生成人群密度圖,密度中的每個像素表示該點周圍區域內預測出現人物的密度估計值,然后對密度圖進行逐像素求和獲得圖像中人群的數量。為了解決尺度變化問題,MCNN[2]網絡通過設置多列不同大小的感受野來提取多尺度特征,計數準確性明顯提高。在MCNN的基礎上,研究者設計了一種多列計數網絡Switch-CNN[9],該網絡用一個密度分類器來為輸入圖像選擇一個最優分支進行訓練。由于多列網絡中各列之間互相獨立,缺乏關聯,導致最終生成密度圖質量不高。CP-CNN[10]通過融合從圖像中學習全局和局部的上下文信息來獲得高質量的人群密度圖。Hossain等[11]提出的SAAN使用注意力機制自動選擇全局和局部的上下文信息,人群計數精度進一步得到提升。然而使用多列網絡存在參數量多、訓練困難等問題,相比之下使用單列網絡結構更簡單,模型更容易訓練。Li等[3]提出了一種單列深層網絡CSRNet,該網絡的特征提取部分采用VGG16的前10層,后端使用多個空洞卷積來提取多尺度信息,在保留原圖分辨率的情況下擴大模型的感受野,提升了計數的準確性。Liu等[12]提出了一個上下文感知網絡CAN,該網絡可以自適應的預測人群密度所需要的上下文信息,減少了人頭多尺度問題帶來的干擾。Cao等[13]提出了一種尺度聚合網絡SANet,它將多個不同尺寸的卷積核并聯用于提取圖尺度特征,并利用轉置卷積來恢復圖像的分辨率,從而生成高分辨率密度圖。Gao等[14]提出的SCAR網絡采用注意力機制來提取圖像的像素級上下文信息和不同通道之間的特征信息,使模型在像素級水平上精確預測密度圖。Shi等[15]提出的PA-CNN采用透視圖和密度圖相結合的方法生成高質量的密度圖。PDD-CNN[16]通過金字塔空洞卷積模塊來提取圖像的多尺度信息生成密度圖。這些方法都有著優秀的計數性能,但是在實際應用場景中,行人分布不均、復雜背景干擾、多尺度變化等問題仍是當前人群計數任務面臨的挑戰。

2 基于多分支特征融合的密集人群計數

2.1 網絡整體結構

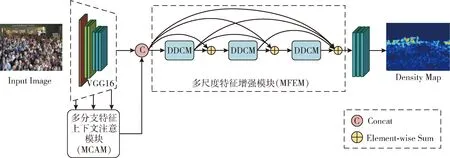

本文提出的基于多分支特征融合的密集人群計數網絡(MFNet)的結構如圖1所示。VGG-16[17]結構簡單高效并且具有強大的特征提取能力,適用于準確快速的人群計數,本文采取VGG-16的前10層作為骨干網絡,表1列出了VGG-16前10層的相關參數。同時本文在網絡前端構建多分支上下文注意模塊MCAM,使用一個自頂向下和自底向上的雙向特征融合路徑來提取網絡不同深度的特征。在網絡后端采用多尺度特征增強模塊MFEM,通過密集殘差連接的空洞卷積來應對人頭尺度連續變化問題,提高網絡多尺度特征信息提取能力,最后輸出人群密度估計圖,實現人群計數。

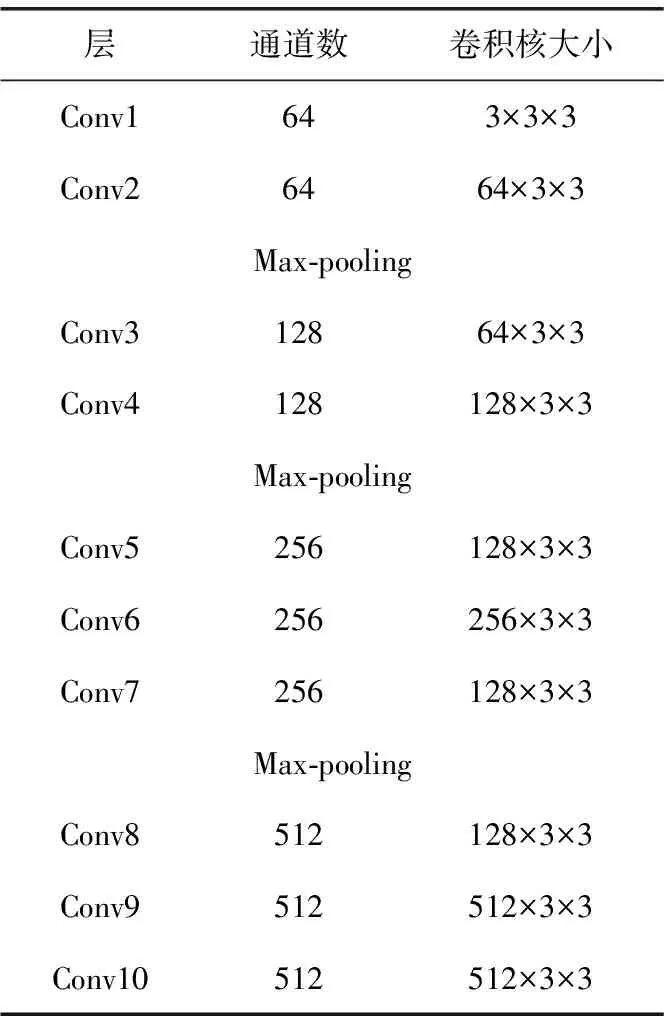

表1 VGG-16前10層相關參數

圖1 MFNet網絡結構

2.2 多分支上下文注意模塊

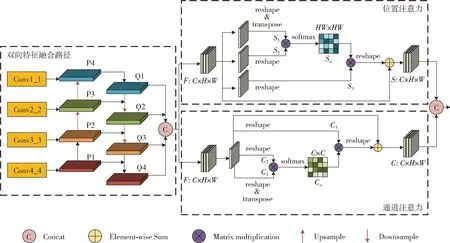

網絡淺層可以提取到圖片的低級特征,例如邊緣信息等;而網絡深層則可以更好的提取高級語義信息[18]。此前多數研究進行特征融合時多采用單向特征流動的方式進行,這導致網絡淺層與深層的特征不能被很好的利用起來。使用雙向特征流動的方式進行特征提取,可以更充分地融合淺層與深層的特征,從而有效提高模型的性能表現。在目標檢測領域中,研究者提出了一種自頂向下的特征融合策略即特征金字塔結構(feature pyramid network,FPN)[18],它能夠整合不同尺度的特征圖,使其同時具有深層的語義信息和淺層的紋理信息。受FPN啟發,本文引入多分支特征注意模塊,使用一個自頂向下和自底向上的雙向特征融合路徑來提取前端網絡的特征。為了對多尺度變化的人頭特征進行有選擇性的加強,使用通道注意力和位置注意力來優化融合后的特征。如圖2所示,MCAM模塊將網絡的淺層和深層特征結合起來,并分別通過位置注意力機制(position attention module,PAM)和通道注意力機制(channel attention module,CAM)進行特征加權,使得網絡能夠更好地注意到人頭位置,以從主干網絡中獲取并融合足夠多的特征。

圖2 MCAM模塊結構

2.2.1 雙向特征融合路徑

雙向特征融合路徑如圖2所示。本文根據VGG16前十層的池化層位置將其劃分為4個子模塊,在文中分別用Conv1_1、Conv2_2、Conv3_3、Conv4_4來表示。為將網絡深層的語義信息傳遞到網絡淺層特征層,首先由Conv1_1、Conv2_2、Conv3_3、Conv4_4這4個特征層構造一個自頂向下的融合路徑,由于經過最大池化后的4個特征圖尺寸大小不一,Conv1_1、Conv2_2、Conv3_3、Conv4_4大小分別為原圖的1/2、1/4、1/8、1/8,所以在構建融合路徑時需要統一特征圖尺寸。將Conv4_4與Conv3_3進行特征拼接融合得到特征圖P2。將融合后的特征圖P2采用雙線性插值法進行上采樣并與Conv2_2進行特征拼接融合得到特征圖P3。同理,將P3進行上采樣并與Conv1_1進行特征拼接融合得到特征圖P4。

隨后將網絡淺層的空間信息傳遞到網絡深層。將特征圖P4進行下采樣并與P3進行特征融合得到新的特征圖Q2。將Q2下采樣并與P2進行特征融合得到特征圖Q3,將Q3與P1進行特征拼接融合得到特征圖Q4,由此構造出一條自底向上的特征融合路徑。將得到的特征圖Q1、Q2、Q3、Q4進行特征拼接融合后最終得到一個同時具有高級語義和空間細節的特征圖。

2.2.2 混合注意力模塊

在實際的密度圖估計過程中,往往會將一些雜亂的背景誤識別為人群,影響了模型預測的準確性。在人群計數過程中,可以通過引入注意力機制幫助網絡更加準確地關注圖片重要區域和關鍵通道,增強特征表示,從而提高計數準確性[19]。Liu等[20]采用注意力機制獲取特征圖中的局部位置信息,但是忽略了特征通道之間的全局相關性。Sindagi等[21]通過注意力機制將前景和背景分割信息注入到計數網絡中,但是沒有考慮到圖像中各個位置之間的關系。針對上述問題,我們提出了一個融合位置注意力和通道注意機制的混合注意力模塊。

混合注意力模塊如圖2所示。首先將雙向特征融合路徑提取到的特征輸入到位置注意力模塊,經過3個1×1卷積層,然后通過重置或轉置操作得到3個特征映射S1,S2和S3,其中 {S1,S2,S3}∈RC×H×W,C為特征映射的通道數,H×W表示空間維度。對S1和S2進行矩陣乘法和Softmax運算得到一個大小為HW×HW的空間注意力圖Sa,其計算公式如式(1)所示

(1)

將得到的空間注意力圖Sa和S3進行矩陣乘法操作,并將得到的特征圖還原為原始輸入特征大小C×H×W。最后用一個尺度參數λ對輸出進行縮放,得到最終輸出特征S,其計算公式如式(2)所示

(2)

式中:λ是可學習參數,其初始化為0并逐漸學習一個權值。

上述公式表明,輸出特征S是注意力圖和原始局部特征圖的加權和,其中包含全局上下文特征,并且能夠根據空間注意力圖有選擇的聚合語境。

同樣,將雙向特征融合路徑提取到的特征輸入到通道注意力模塊。通道注意力的主要操作與位置注意力基本相同,不同的是通道注意力不需要通過卷積重新生成新的特征圖,而是直接通過輸入特征圖F來計算通道注意力圖Ca,其定義如式(3)所示

(3)

(4)

式中:μ為可學習參數,其初始化為0并逐漸學習一個權值。

位置注意力可以捕捉圖像的全局位置的相關性,感知更廣泛的上下文信息,從而增強局部特征表示。而通道注意力可以關注特征映射中不同通道之間的相關性,減少背景噪聲引起的無用特征映射的影響。同時使用通道注意力機制和位置注意力機制,能夠反映出通道和位置之間的依賴關系,提高模型的魯棒性。

2.3 多尺度特征增強模塊

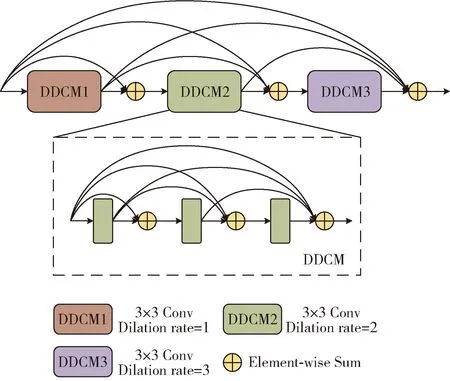

上文所述的MCAM模塊融合了網絡的淺層和深層特征,在此基礎上,本文通過設計多尺度特征增強模塊(multi-scale feature enhancement module,MFEM)來提取密集人群的多尺度特征。該模塊主要由3個具有不同空洞率的密集空洞卷積塊(dense dilated convolution module,DDCM)組成,每個DDCM模塊又由3個密集殘差連接的空洞卷積組成。

MFEM模塊結構如圖3所示。多列的CNN方法由于列數有限,只能處理幾種不同尺度的人群特征,本文針對多尺度變化問題采取一種盡可能密集的連接方式來捕獲連續變化的尺度特征。DenseNet[22]中使用密集殘差連接的方式將所有的網絡層連接起來。網絡的每一層都會接收前面所有層的輸入,并將其進行串聯,形成了一個多通道特征圖,在每個層之間相互傳遞特征信息,這種方式可以使得不同層之間的信息傳遞更加充分,同時能避免梯度消失和參數過多的問題,提高模型的準確性。本文通過采用密集殘差連接的方式來連接具有不同空洞率的空洞卷積以捕獲更多的尺度特征,使得后續層的輸入特征更加豐富,促進信息的連續傳遞,有助于網絡更大限度的提取人頭信息。

圖3 MFEM模塊結構

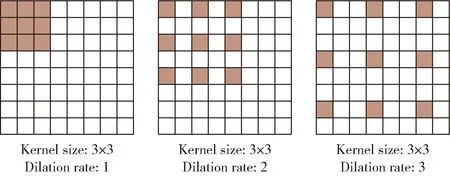

普通卷積使用池化層來增大感受野,同時也縮小了特征圖尺寸,再利用上采樣還原圖像尺寸。而特征圖在先縮小后放大的過程中會丟失一些細節信息,容易造成精度上的損失,從而導致還原的圖像質量下降。相較于普通卷積,空洞卷積可以在不引入額外參數的前提下擴大感受野,同時又不丟失圖像信息[24],因此空洞卷積更適用于人群計數。圖4展示了空洞率分別為1、2、3的空洞卷積。

圖4 空洞卷積

然而較大的空洞率可能會導致感受野增加過快,從而在人群密集區域出現網格效應,導致原始特征映射的局部信息缺失,對計數精度造成影響。為解決上述問題,同時考慮到密集場景下人頭的連續尺度變化問題,本文選取3個空洞率分別為1、2、3的空洞卷積進行特征提取。為了讓3個DDCM模塊之間的特征被充分利用,產生更連續的信息傳遞,本文再次使用密集殘差連接將DDCM模塊連接起來,提取的特征尺度多樣性進一步擴大。最后將MFEM模塊提取的特征輸入到由兩個3×3卷積和一個1×1卷積組成的密度圖生成模塊來得到最終的人群密度圖。

3 實驗與結果分析

3.1 訓練細節

實驗基于Pytorch框架,在windows10系統下進行,訓練時使用的GPU為NVIDIA GeForce GTX 3090。實驗中使用Adam優化器對網絡模型進行優化,用標準差為0.01的高斯函數隨機初始化其它層,網絡的初始學習率為0.000 01,衰減率為0.995,迭代次數為800,batchsize設置為1。

3.1.1 人群密度圖的生成

為了生成高質量密度圖,提高計數精度,本文采用自適應高斯核的方法生成標簽密度圖,自適應高斯核可以根據人頭的尺度自適應的改變高斯核大小。對于人群相對稀疏的數據集如ShanghaiTech Part_B則采用固定高斯核來處理人群場景生成密度圖。使用自適應高斯核的方法計算出真實人群密度圖Yi,其表示為

(5)

式中:Gσi為高斯核濾波器,σi為高斯核大小,由k最鄰近算法得出,δ(x-xi) 表示在像素點xi處的人頭標注,di表示點xi和k個頭部之間的平均距離,本文將k設置為3,β為0.3。最終生成的人群密度圖標簽如圖5所示,從左到右依次為原圖、人頭位置標注圖、人群密度圖。

圖5 人群密度圖示例

3.1.2 損失函數

損失函數用于衡量網絡輸出與真實標簽之間的誤差。本文采用歐幾里距離損失,其計算公式如式(6)所示

(6)

3.1.3 評價指標

本文采用平均絕對誤差(MAE)和均方誤差(MSE)來評估網絡模型的性能,MAE反映計數模型的準確性,MSE反映模型的魯棒性,其計算公式如下

(7)

(8)

其中,N為測試集中的圖像數,yi為輸入圖像的預測人數,Yi為輸入圖片的真實人數。

3.2 實驗結果分析

3.2.1 實驗數據集

本文在常用的大規模數據集ShanghaiTech,UCF_CC_50和UCF-QNRF上進行實驗。

ShanghaiTech數據集[23]分為Part_A和Part_B兩個子集。該數據集共有1198張圖片,330 165個注釋頭。其中Part_A由482張圖片構成,這些圖片是從網絡上隨機下載得到的,圖片分辨率不統一。其中訓練集有300張圖片,測試集有182張圖片。Part_B共有716張圖片,圖片來源于上海某街道的監控錄像,圖片分辨率為768×1024。其中訓練集有400張圖片,測試集有316張圖片。其中Part_A數據集人群密度相對較高,Part_B部分人群密度相對稀疏。

UCF_CC_50數據集[24]是一個小樣本數據集,其來源于網絡上的圖片,場景類型包含了音樂會、體育場等多個場所的圖片。該數據集共有50張圖片,圖片分辨率大小不一,標記總人數達到63 075人,如片中的人群密度變化極大,人群數量從94到4543不等。實驗過程中隨機抽取其中40張圖片進行訓練,10張圖片進行測試。由于該數據集樣本數量較少,我們采用五折交叉驗證的方法來評估模型。

UCF-QNRF數據集[25]由1535張高分辨率圖片組成,包含多個視角、多種光線及多種密度變化的大規模場景。圖片分辨率不統一,平均分辨率為2013×2902。該數據集人群密度變化較大,單張圖片最大人數可達到12 865。其中訓練集1201張,測試集334張。

3.2.2 結果分析

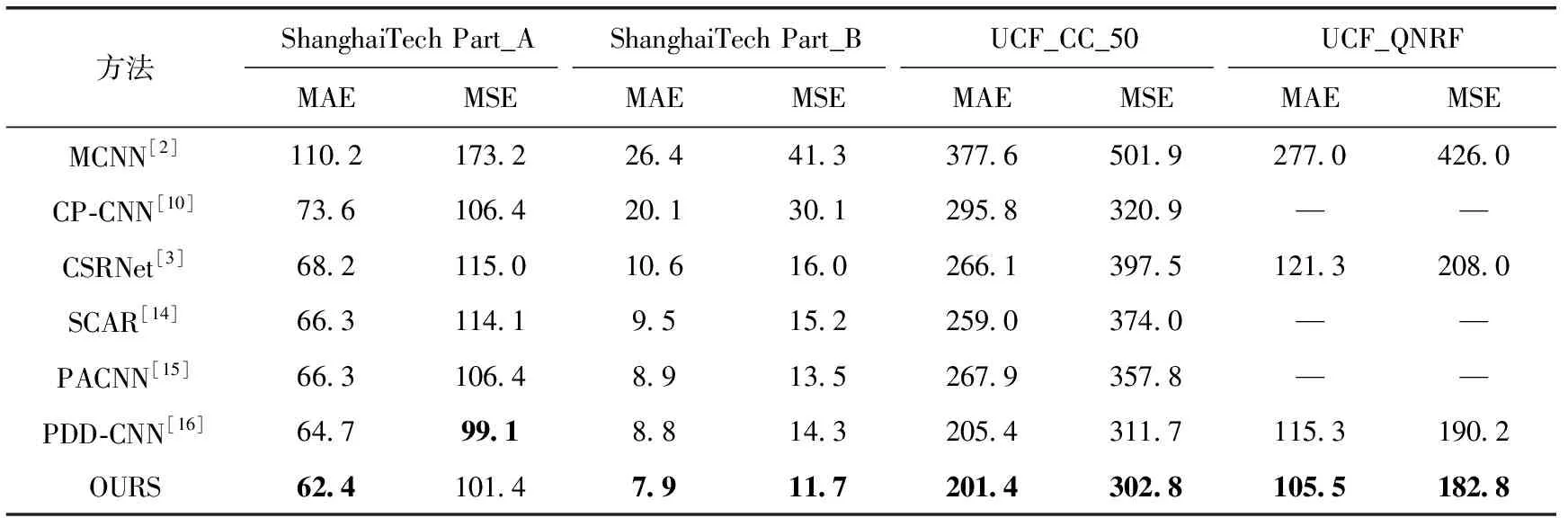

為了驗證MFNet在人群計數任務上的有效性,本文在3個公開的人群計數數據集ShanghaiTech、UC_CC_50以及UCF_QNRF上進行了訓練和測試,通過與近幾年的先進算法進行對比,驗證了MFNet計數性能的優越性,對比結果見表2。

表2 不同方法在多個數據集上的結果對比

由表2可知,本文提出的MFNet在3個數據集上都表現出了優秀的計數性能。在ShanghaTech數據集中,在人群密度較高的Part_A子集上實現了較低的MAE和MSE,分別達到了62.4和101.4。與經典的多列網絡MCNN相比,MFNet的MAE和MSE分別降低了43.4%和41.5%,與經典的單列網絡CSRNet相比MAE和MSE分別下降了8.5%和11.8%,但MSE比PD-CNN稍差。同時在人群相對稀疏的Part_B子集上也達到了最低的MAE和MSE,分別為7.9和11.7,與MCNN相比MAE下降了70.1%,MSE下降了71.7%,與CSRNet相比MAE下降了25.5%,MSE下降了26.7%。

在小樣本數據集UCF_CC_50中,MFNet達到了與先前方法相比最低的MAE和MSE,分別為201.4和302.8。與MCNN相比MAE下降了46.7%,MSE下降了39.7%,與CSRNet相比MAE下降了24.3%,MAE下降了23.8%。

在場景豐富,人群數量差異較大的UCF_QNRF數據集上,本文提出的MFNet達到了最低的誤差,其中MAE為105.5,MSE為182.8。與MCNN相比MAE下降了61.9%,MSE下降了57.1%,與CSRNet相比MAE下降了13.0%,MAE下降了12.1%。

上述實驗結果表明本文提出的網絡MFNet在人群不同擁擠程度的場景下均表現出優秀的計數準確率,并且在尺度變化較大、背景噪聲干擾嚴重的情況下,MFNet也能夠保持較高的計數精度。

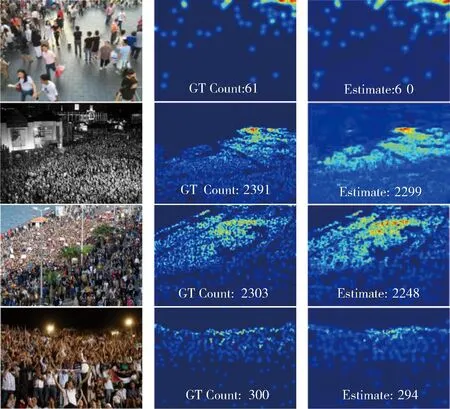

圖6展示了在不同數據集上的部分可視化結果。圖中展示的4個場景包括了人群稀疏場景、人群密集場景和具有復雜背景干擾的場景,可以看出,在這些不同的場景下使用MFNet生成的人群密度圖均能夠估計出與標簽人數接近的人群數量,再一次驗證了MFNet的有效性。

圖6 不同數據集生成的密度圖

3.3 消融實驗

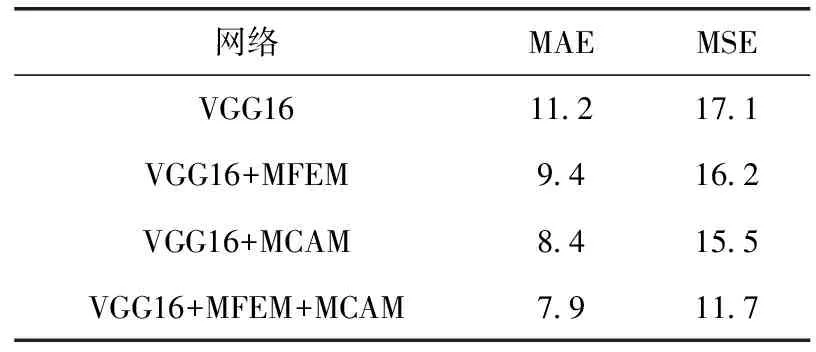

為了驗證MFNet中每個模塊的有效性,本文在ShanghaiTech Part_B數據集上進行了消融實驗,并將其對比結果列于表3中。

表3 Shanghai Part_B數據集的消融實驗

首先在基線網絡VGG-16上進行了訓練和測試,并在其基礎上分別增加MFEM模塊和MCAM模塊來驗證兩個模塊的有效性。由表3可知,基線網絡VGG16在ShanghaiTech Part_B上的MAE和MSE分別為11.2和17.1。在VGG16網絡基礎上增加了MFEM模塊后,MAE和MSE分別為9.4和16.2,其中MAE較基線網絡下降了16.1%,MSE較基線網絡下降了5.3%,該實驗驗證了MFEM模塊的有效性。在VGG16網絡基礎上增加了MCAM模塊后,MAE為8.4,較基線網絡下降了25%;MSE為15.5,較基線網絡下降了9.3%,該實驗驗證了MCAM模塊的有效性。最后在VGG16上同時增加MFEM模塊和MCAM模塊,最終的MAE和MSE下降了29.5%和30.4%,驗證了本文所提的兩個模塊的有效性。其中,在加入MCAM模塊進行訓練之后,MSE明顯降低,表明了該模塊很好的提升了模型的魯棒性。

上述消融實驗驗證了本文提出的兩個模塊都對網絡性能有一定的提升,驗證了MFNet合理性和有效性。

4 結束語

本文提出了一種基于多分支特征融合的人群計數網絡,在網絡前端利用自頂向下和自底向上的雙向特征融合路徑來促進淺層和深層特征之間的融合,并結合位置注意力和空間注意力加強人頭信息的權重,增強網絡的表征能力。在網絡后端建立密集殘差連接來提高多尺度信息傳遞能力。在3個公開數據集上的實驗結果表明,與其它主流算法相比,所提方法具有更高的準確性和魯棒性。但是在實驗過程中發現該模型存在參數較多、計算量過大的問題,導致計數效率偏低,后續可引入輕量化的網絡模型進行研究,以降低模型的復雜度和提高計數準確度。