基于CLIP與注意力機制的跨模態哈希檢索算法

黨張敏,喻崇仁,殷雙飛,張宏娟,陜 振+,馬連志

(1.中國航天科工集團第二研究院 七〇六所,北京 100854;2.中國航天科工集團第二研究院 軍代室,北京 100854)

0 引 言

跨模態數據所具有的高維、異構等特點使得檢索過程耗費大量的時間和存儲空間。如何提升跨模態檢索[1]的檢索效率并降低其存儲消耗成為了目前學術界和工業界研究的重點。其中基于哈希碼的跨模態檢索方法由于其較低的存儲消耗和快速的檢索速度,成為了解決大規模跨模態數據檢索的有效手段。

跨模態哈希檢索[2]方法通過學習哈希函數將原始特征空間映射到低維的漢明空間,同時保持原始特征空間數據之間的相似性不變。跨模態哈希檢索方法主要分為有監督的跨模態哈希檢索與無監督跨模態哈希檢索方法。現有的無監督跨模態哈希[3]方法更多關注哈希碼的生成階段,忽略特征提取階段,導致檢索性能受到影響。為解決上述問題,提出基于多模態預訓練模型CLIP[4]與注意力融合機制[5]的無監督跨模態哈希檢索算法CAFM_Net(CLIP-based attention fusion mechanism network)。

CAFM_Net主要貢獻如下:

(1)使用CLIP提取原始樣本特征,引入注意力機制加強顯著區域的權重,弱化非顯著區域的影響。

(2)設置模態分類器與特征提取器進行對抗學習,提取更豐富的語義特征,使不同模態特征與所生成哈希碼語義趨于一致。

1 背景與相關工作

1.1 無監督跨模態哈希算法

現有的跨模態哈希方法主要有兩大類:利用多模態數據已有標簽的有監督方法和針對成對多模態數據的無監督方法。無監督方法因其標簽的獨立性而更具研究價值和應用前景。與以往的淺層哈希方法相比,基于深度學習的哈希方法[6]不僅提升了跨模態檢索的效率和準確率,同時也提升了所生成哈希碼的質量。因此深度無監督跨模態哈希檢索吸引了廣大學者的關注和研究。最具代表性的工作是深度聯合語義重構哈希方法[7](DJSRH),此方法通過設計一種聯合語義親和矩陣來統一不同模態之間的相似性關系來重構多模態哈希矩陣。高階非本地散列方法[8](HNH)則通過本地和非本地兩個角度來考慮多模態數據之間的相似性關系,構建一個更全面的相似性矩陣。Hoang等提出了通過Transformer的無監督跨模態哈希檢索方法[9]。使用Transformer提取模態特征挖掘模態內部的語義信息。盡管以上的方法都取得了不錯的檢索表現,但大多數方法不能有效的捕捉到不同模態之間的異質關聯,忽視了模態內部的高階語義相似性。

1.2 注意力機制

近年來,隨著注意力機制在機器翻譯和圖像處理等方面取得的良好表現,注意力機制在工業界和學術界都得到了廣泛的關注。注意力機制[10]通過關注大量輸入中對于當前目標更關鍵的信息,減少對于其它信息的關注,過濾掉不相關的信息來解決信息冗余的問題,從而提高處理任務的效率和準確性。基于注意力機制的深度對抗性哈希網絡[11]提出了一個帶有注意力機制的對抗性哈希網絡。該網絡通過有選擇地關注多模態數據中相關部分來提高內容相似性監測性能。自我約束的基于注意力的散列網絡[12]提出了一種用于比特級跨模式哈希的方法。注意力引導的語義哈希采用了一種注意機制,該方法只關注相關的特征特性。它可以通過注意力模塊保留不同模式特征中的語義信息,從而構建一個注意力感知的語義親和矩陣。然而,無監督跨模態哈希檢索[13]方面基于注意力機制的研究,仍然未廣泛開展。

1.3 對比文本-圖像預訓練模型CLIP

CLIP(contrastive language-image pre-training)是一個采用圖像-文本對進行訓練的神經網絡。CLIP采用對比學習的方式將圖像和對應描述文本進行對比訓練,最大化圖像文本正樣本的語義相似度以達到模態匹配的目的。CLIP模型普遍用于跨模態領域的數據預訓練與特征提取。在CLIP模型出現后,一系列基于CLIP的下游任務都在相關領域取得了很好的實驗效果。有學者提出了利用文字表述來對圖像進行編輯的styleCLIP模型[14]。該模型借助CLIP模型“文本-圖像”相關性能力和StyleGAN的圖像生成能力,通過文本驅動生成圖像。谷歌的研究人員提出了通過視覺和語言知識蒸餾方法建立ViLD模型[15],該模型將CLIP的圖像分類模型應用到目標檢測上。騰訊研究人員提出了CLIP2Video[16]模型,將CLIP模型從文本-圖像拓展到文本-視頻對,解決了視頻文本檢索問題。

2 CAFM_Net算法設計與優化

在本部分將詳細介紹CAFM_Net設計的相關細節,包括以下幾個方面:問題定義和符號、模型框架概述、目標函數與模型的優化。

2.1 問題定義與符號

(1)

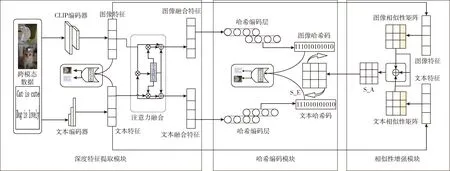

2.2 模型框架

本文所提出的方法框架如圖1所示,整體的模型由3個主要部分組成,分別是:深度特征提取模塊、模態相似性增強模塊以及哈希編碼模塊。

圖1 CAFM_Net框架結構

2.2.1 深度特征提取模塊

特征提取模塊主要包括兩個主要的網絡:圖像特征提取網絡與文本特征提取網絡。在本文中,對于圖像采用CLIP編碼器進行特征提取,其輸出結果為Fv。對于文本模態,用Transformer編碼器進行特征提取,其輸出結果為Ft。同時設計模態分類器、特征提取器作為生成器,與特征模態分類器作為判別器進行對抗學習,使得公共特征空間中提取的不同模態特征趨于一致。v,t分別表示圖像和文本的訓練樣本,θv和θt表示圖像和文本特征編碼的參數,用Ev和Et分別表示圖像編碼器和文本編碼器,則Fv=Ev(V,θv),Ft=Et(T,θt)。

接著把提取到的圖像與文本特征輸入到注意力融合模塊。計算模態間相關特征向量F=Fv·Ft。將相關特征向量F輸入到以ReLU為激活函數的全連接層中得到注意力概率向量P=relu(F),分別計算得到注意力關聯特征向量Z*=P·F*,其中*∈{v,t}。最后即可計算出注意力融合圖像特征與文本特征

(2)

式中:μ為超參數。

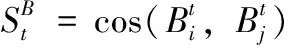

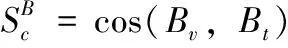

2.2.2 模態相似性增強模塊

2.2.3 哈希編碼模塊

(3)

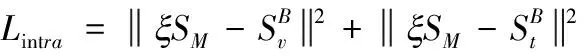

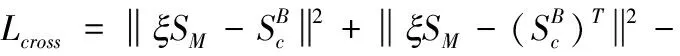

使用哈希相似度矩陣與模態相似性增強模塊構造的矩陣SM構建損失函數

Lintra表示模態內的損失函數,Lcross表示模態間的損失函數,?表示矩陣之間的點積計算,ξ是調節增強矩陣量化范圍的超參數,m為每次訓練的mini-batch中樣本數。

2.3 目標函數與模型優化

在訓練過程中,使用反向傳播來迭代更新整個網絡的參數,當整個網絡趨于收斂,哈希重構階段也將結束。整個過程中總的損失函數為

(4)

其中,超參數α和β分別起到調節模態內部和模態之間語義一致性的作用。在迭代過程中最小化損失函數即可以使得具有語義相似性的數據生成更加一致的哈希碼。本文提出的方法通過注意力融合機制與對抗學習結合的方法有效捕捉原始數據中的共有信息,從而生成更高質量的哈希碼。

由于二進制的哈希碼不能直接通過深度神經網絡進行優化。為了解決常見的梯度消失的問題,本文在生成哈希碼的過程中使用了tanh函數,可以在反向傳播的過程中能夠很好地避免梯度為零的情況。在訓練的過程中整個網絡模型使用SGD算法和Adam算法進行優化。

算法1:CAFM_Net算法

輸入:訓練集Q,迭代次數σ,mini-batch數目m,哈希碼長度K,超參數α,β,μ,ξ,γ,ε

輸出:CAFM_Net的各項參數:θv,θt,θHv,θHt

(1)初始化迭代次數n=0

(2)重復

(4)隨機選取數目m的圖像-文本對作為訓練數據。在圖像上進行數據增強與歸一化

(5)通過圖像和文本特征提取網絡提取Fv,Ft,計算相似度矩陣Sv,St

(6)通過模態相似性增強模塊計算語義親和矩陣SA與相似度增強矩陣SM

(8)使用Adam算法進行隨機梯度下降

(9)直到網絡收斂

(10)返回網絡參數:θv,θt,θHv,θHt

3 實驗與分析

為了驗證CAFM_Net的有效性,本章選擇3個典型的基于圖像與文本的跨模態檢索數據集,即MIRFlickr25k、NUS-WIDE和MSCOCO,來進行實驗對比。本章節的所有實驗均在一臺主機(Ubuntu 14.04,Python 3.8,Pytorch 1.13)上完成。

3.1 數據集

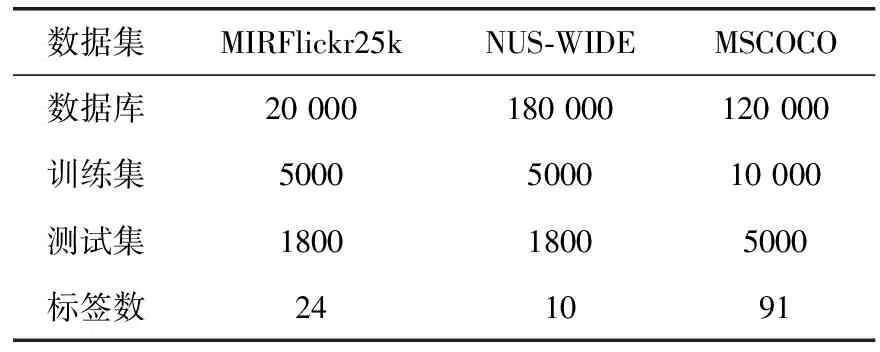

3個數據集的對比見表1。MIRFlickr25k包含從Flickr網站收集的25 000個圖像-文本對。該數據集每個圖像-文本對使用38個類別標簽進行標注,每幅圖像具有多個類別標簽。在本文中選取20 000對作為實驗數據,選取其中2000對作為查詢數據集,其余的用作檢索數據集,訓練數據需要再從檢索數據集中選取10 000對。

表1 跨模態數據集對比

NUS-WIDE包含了從真實場景中收集的269 648個圖像-文本對,該數據集總共包含了81個類別。選擇了10個使用最廣泛的標簽和對應的180 000對數據。隨機選取2000個樣本作為測試集和5000個樣本作為訓練集。

MSCOCO包含訓練集中約80 000個圖像-文本對和驗證集中40 000個圖像-文本對。這些數據分屬于80個類別。在本實驗模型中選取120 000個作為實驗數據集。并從中隨機選擇5000對作為查詢數據集,其余的用作檢索數據集。

3.2 評價標準

在本文中,通過兩種常用的評價準則來評估本文模型的優劣:Top-N準確率曲線(topN-Precision,Top-N)以及平均準確率均值(MAP)。前一種方法基于漢明距離排序,后一種基于哈希表查找的方式。對于Top-N準確率曲線越高,檢索方法性能越好。平均準確率均值是用來衡量每個查詢樣本在進行檢索后的準確率平均值。

CAFM_Net的對照方法有傳統淺層哈希方法和深度學習的哈希方法。并在多個哈希編碼長度上與以往的算法進行比較。

3.3 實驗設置

在實驗中,使用CLIP與Transformer對圖像和文本特征進行提取,構建不同模態的相似度矩陣。實驗中將batch-size設置為32,使用動量為0.8,權重為0.0005的Adam優化器進行算法優化。對于3個數據集MIRFlickr25k、NUS-WIDE、MSCOCO,分別將μ設置為0.4,0.5,0.3,γ設置為0.3,ε設置為0.5,0.6,0.9。通過交叉實驗驗證將α設置為0.15,β分別設置為0.3,0.5,0.6。

3.4 實驗結果與分析

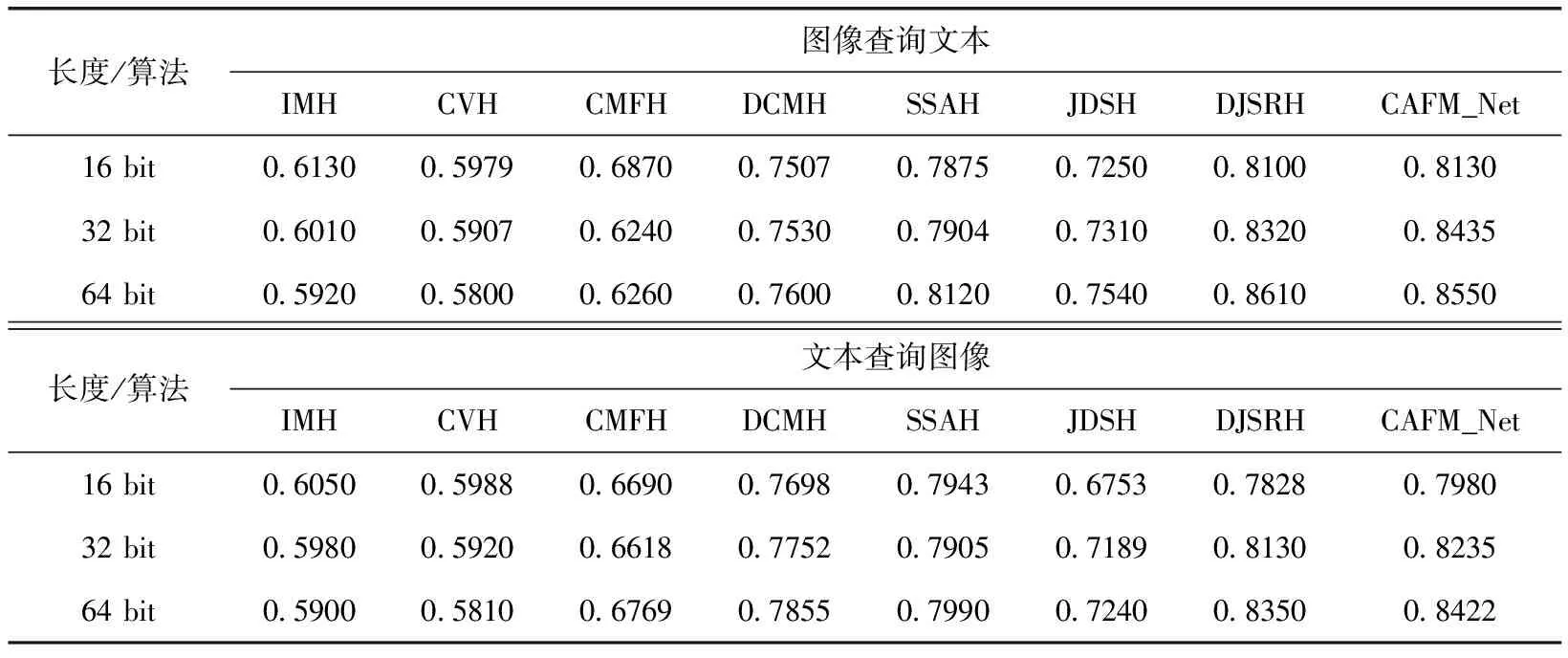

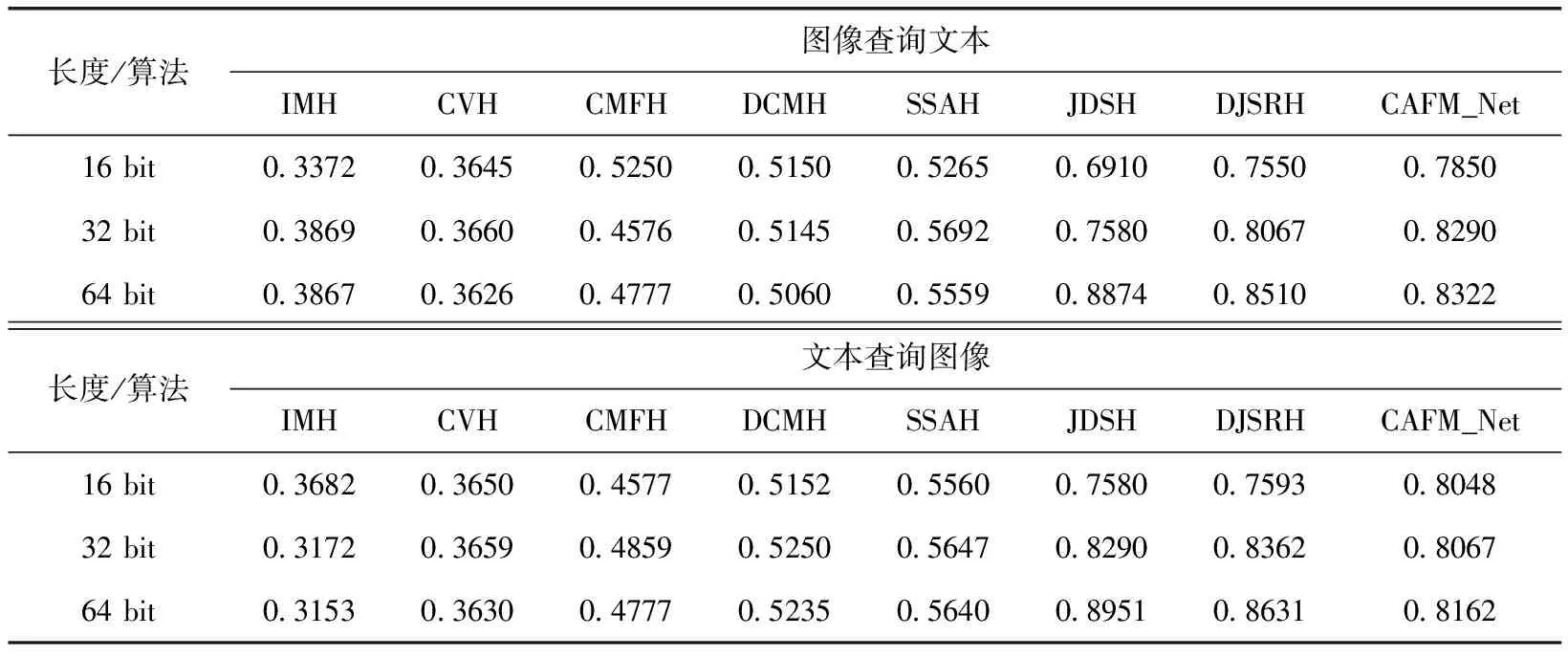

表2展示了CAFM_Net與其它方法在MIRFlickr25k數據集上MAP值的對比。

表2 不同模型在MIRFlickr25k數據集上MAP值

由表2可知,隨著哈希碼長度的不斷增加,在圖像檢索文本和文本檢索圖像的兩個任務上,本文所提出的CAFM_Net相較于傳統的非深度哈希方法IMH準確率分別至少提升16%與9%。與以往的深度哈希方法相比較性能提升較少。這是由于在訓練過程中本文所選取的查詢樣本個數較少導致的。

表3展示了CAFM_Net與其它方法在NUS-WIDE數據集上MAP值的對比。

表3 不同模型在NUS-WIDE數據集上MAP值

由表3可知,在NUS-WIDE數據集上,CAFM_Net相比其它非深度哈希方法與深度哈希方法在MAP值上均有提升。在圖像檢索文本任務上CAFM_Net比性能最好的DJSRH方法MAP值在16,32,64比特上分別高出12.43%,10.75%,12.3%。在文本檢索圖像任務上,MAP值在16,32,64比特上分別高出11.12%,10.04%,12.50%。

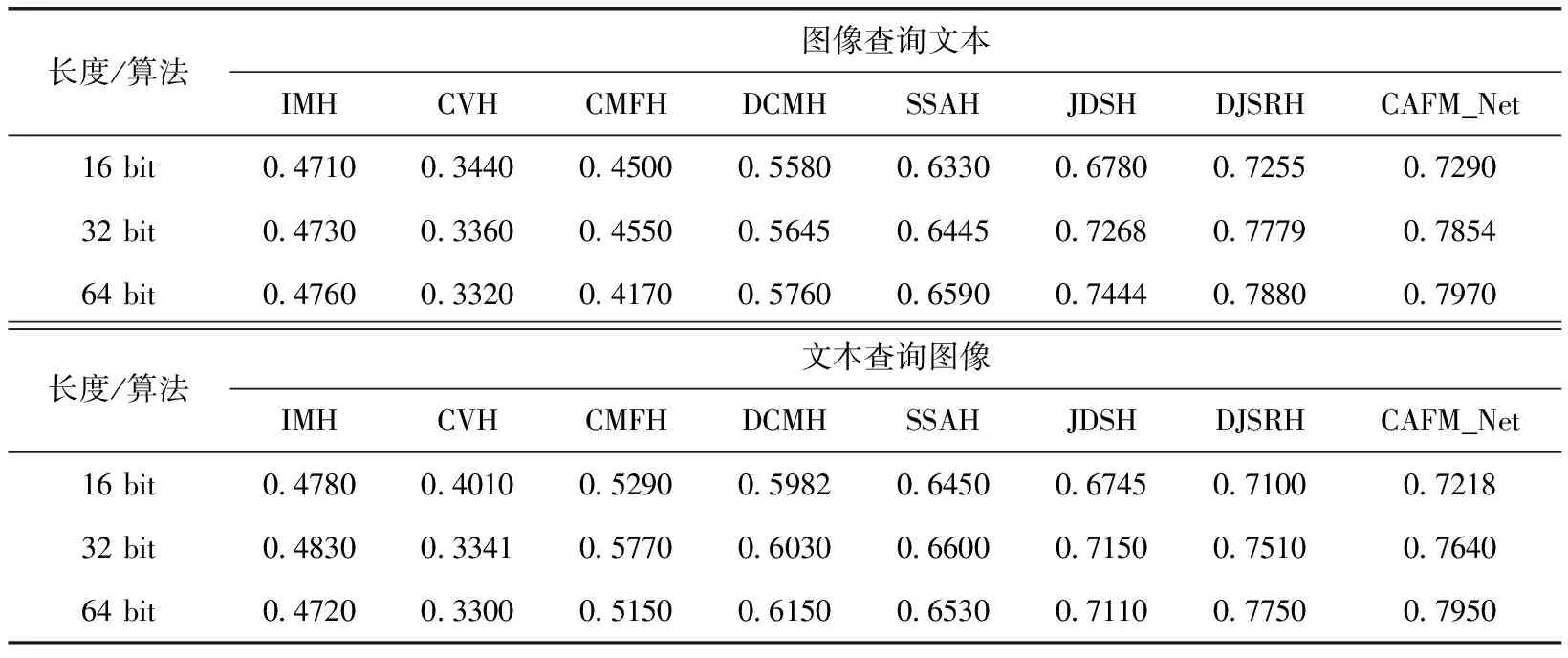

表4展示了CAFM_Net與其它方法在MSCOCO數據集上MAP值的對比。

表4 不同模型在MSCOCO數據集上MAP值

由表4可知,在MSCOCO數據集上CAFM_Net相比于所有方法均取得了最佳的MAP值。

上述實驗結果表明,在跨模態檢索任務中深度方法的檢索效果往往優于非深度方法。同時,隨著哈希碼長度的增長,檢索的精確率也會更高。本文所提出的CAFM_Net算法在3個數據集上精確率均有所提升,說明了使用CLIP與Transformer分別對圖像和文本進行特征提取并通過注意力融合機制后生成的哈希碼能夠更好挖掘原始樣本的語義信息。其檢索效率優于傳統使用CNN和文本編碼器進行特征提取的方法。

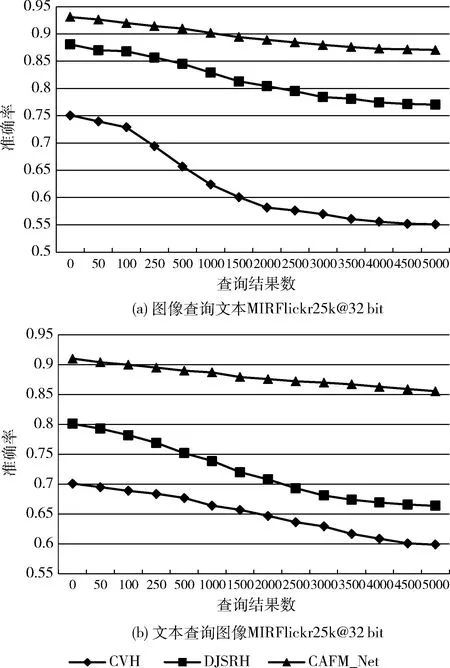

在數據集上對CAFM_Net與CVH、DJSRH的Top-N曲線進行對比,采用的哈希編碼長度為32位。Top-N曲線檢索樣本數目從1~5000,反映了隨著檢索數量的增加,模型檢索精度波動的情況。在兩個查詢任務上的結果如圖2所示。

圖2 CAFM_Net與其它方法Top-N曲線對比

從圖中可以看出CAFM_Net方法在MIRFlickr25k數據集上的Top-N曲線明顯高于其它的對比方法。

4 結束語

為解決無監督跨模態數據檢索準確率低等問題,提出一個有效的基于CLIP模型與注意力融合機制的跨模態哈希檢索算法CAFM_Net。使用CLIP和Transformer對圖像和文本進行特征提取。使用注意力融合機制對模態間的樣本特征進行融合找出模態間的共有語義特征,引入對抗學習的思想設計模態分類器,使公共特征中不同模態語義更趨于一致。相關實驗結果表明,與現有的代表性哈希方法相比,CAFM_Net在3個數據集上檢索效果均取得明顯的提升。有效驗證了該算法的準確性和魯棒性。