基于改進(jìn)的YOLOv3農(nóng)作物目標(biāo)檢測算法

郭蓓,王貝貝,張志紅,吳蘇,李鵬,胡莉婷

摘要:農(nóng)作物圖像在進(jìn)行目標(biāo)檢測時,由于作物種植較密集、成像質(zhì)量不佳等原因嚴(yán)重影響目標(biāo)檢測算法的檢測精度。針對存在的問題,提出一種基于YOLOv3的改進(jìn)算法優(yōu)化在農(nóng)作物目標(biāo)檢測的檢測性能:對YOLOv3的主干特征提取網(wǎng)絡(luò)進(jìn)行優(yōu)化,利用原網(wǎng)絡(luò)中輸出的4倍降采樣特征圖對目標(biāo)進(jìn)行檢測,并且在算法原網(wǎng)絡(luò)殘差塊的基礎(chǔ)上增加殘差單元,以檢測目標(biāo)較小的農(nóng)作物位置信息;提出高斯衰減函數(shù),對圖像中高度重疊的農(nóng)作物候選框的衰減較強(qiáng),在有效抑制冗余框的同時也可以有效地降低漏檢率;對回歸損失函數(shù)進(jìn)行優(yōu)化改進(jìn),用CIOU Loss作為損失函數(shù),使得目標(biāo)檢測過程中最終的目標(biāo)定位更加精確。將改進(jìn)的 YOLOv3算法和原 YOLOv3 算法、Faster R-CNN 算法在實(shí)拍的玉米作物圖像數(shù)據(jù)集上進(jìn)行對比實(shí)驗(yàn),結(jié)果表明改進(jìn)后的YOLOv3算法能有效檢測農(nóng)作物小目標(biāo),算法檢測的平均準(zhǔn)確率均值和檢測速度都有明顯的提升。

關(guān)鍵詞:目標(biāo)檢測;YOLOv3算法;特征提取網(wǎng)絡(luò);損失函數(shù)

1? 引言

物候觀測是對生態(tài)物候現(xiàn)象按統(tǒng)一的標(biāo)準(zhǔn)進(jìn)行觀察和記載,是生態(tài)氣象業(yè)務(wù)和科研的基礎(chǔ),更是氣候多圈層生態(tài)氣象業(yè)務(wù)觀測體系的重要組成部分。隨著我國現(xiàn)代化智慧農(nóng)業(yè)的普及,智能化設(shè)備監(jiān)測田間作物逐漸替代人工觀測,物候自動觀測儀包含了采集器、傳感器和通信單元等設(shè)備,保證物候觀測的準(zhǔn)確性與高效性。

隨著物聯(lián)網(wǎng)和人工智能等技術(shù)的發(fā)展,植被生態(tài)的觀測方法正在發(fā)生變革,計(jì)算機(jī)視覺技術(shù)逐漸被應(yīng)用到植被物候觀測中。計(jì)算機(jī)視覺不僅是工程研究領(lǐng)域更是計(jì)算機(jī)科學(xué)中具有重大意義和挑戰(zhàn)性的研究領(lǐng)域,目標(biāo)檢測作為其主要的研究方向逐漸成為當(dāng)下的熱門研究內(nèi)容。目標(biāo)檢測的主要任務(wù)是在圖像中找到符合要求的目標(biāo)信息,并標(biāo)記目標(biāo)所屬類別,分析所處的位置信息[1]。農(nóng)作物目標(biāo)檢測是基于目標(biāo)檢測的方法對圖中的農(nóng)作物進(jìn)行目標(biāo)識別檢測,輸出作物類別,能更好地觀察作物生長狀況是否良好,及時監(jiān)測田間雜草的生長信息,為農(nóng)事活動提供判斷依據(jù),保障作物生長狀況持續(xù)向好。利用算法判斷相應(yīng)類別數(shù)量,是后期統(tǒng)計(jì)作物生長情況、種植密度和產(chǎn)量信息的重要依據(jù),為國家糧食安全保駕護(hù)航。

目前比較熱門的目標(biāo)檢測算法大多是基于深度學(xué)習(xí)構(gòu)建識別模型,自動提取目標(biāo)識別過程中的特征信息,具有強(qiáng)大的魯棒性和泛化能力,算法根據(jù)識別階段主要分為兩大類:two-stage與one-stage目標(biāo)檢測算法。two-stage目標(biāo)檢測算法檢測速度較慢一些,但檢測精確度很高,而one-stage目標(biāo)檢測算法的檢測時間會顯著提升,對于實(shí)時檢測有更好的適用性,但檢測精度較低[2],常見的算法有SSD、YOLO、RetinaNet、RefineDet、YOLOv3等。

于博文等提出改變網(wǎng)絡(luò)結(jié)構(gòu)利用可形變卷積優(yōu)化的殘差單元結(jié)構(gòu)加入到特征提取網(wǎng)路,提高檢測目標(biāo)的效率和精確度[3]。陳禹蒲等提出將深度學(xué)習(xí)骨干網(wǎng)絡(luò)拆分為兩個子網(wǎng)絡(luò)分支,通過降低子網(wǎng)絡(luò)的層數(shù)和通道數(shù)以降低網(wǎng)絡(luò)結(jié)構(gòu)的總參數(shù)量。提高網(wǎng)絡(luò)結(jié)構(gòu)的特征提取能力[4]。王瀟等提出通過降低重疊部分較大的目標(biāo)框的置信度引入了Soft-NMS,提高目標(biāo)二次檢測可能,增強(qiáng)網(wǎng)絡(luò)的召回率[5]。王陽等提出利用WIoU損失函數(shù)優(yōu)化回歸損失,通過恰當(dāng)?shù)奶荻确峙浞绞剑岣呔W(wǎng)絡(luò)結(jié)構(gòu)的精確度[6];申志超對卷積核與感受野的定量關(guān)系進(jìn)行分析,設(shè)計(jì)了基于三級可控感受野結(jié)構(gòu)和特征圖降采樣結(jié)構(gòu)的農(nóng)作物檢測網(wǎng)絡(luò),實(shí)現(xiàn)了卷積層拓?fù)浣Y(jié)構(gòu)的改進(jìn),提高了模型的檢測性能[7];張穎超引入DropBlock正則化技術(shù),降低模型的內(nèi)存需求,使用PANet對特征信息去除噪聲,定位特征網(wǎng)絡(luò)像素點(diǎn),能更快更準(zhǔn)確地完成農(nóng)作物葉片病蟲害檢測[8];金沙沙將NAM注意力機(jī)制加入到Y(jié)OLOv5s主干網(wǎng)絡(luò)上,并參考Bi FPN的思想修改YOLOv5s的頸部網(wǎng)絡(luò),提高YOLOv5s的特征融合能力,大大提高農(nóng)作物種子檢測性能[9]。

在自然條件下,農(nóng)作物圖像在采集過程中光照、抖動、遮擋等外界因素會造成成像質(zhì)量不佳,圖像在分辨率、特征信息等有一定的差異,嚴(yán)重干擾目標(biāo)檢測算法的定位精度,導(dǎo)致產(chǎn)生較高的漏檢率,上述研究算法在農(nóng)作物識別檢測效果不盡理想,因此本文基于one-stage目標(biāo)檢測YOLOv3算法,提出改進(jìn)的YOLOv3農(nóng)作物目標(biāo)檢測算法。它通過優(yōu)化調(diào)整主干特征提取網(wǎng)絡(luò)、調(diào)整NMS重疊框置信度、引入新的損失函數(shù)以及有效的數(shù)據(jù)處理與訓(xùn)練方法,實(shí)現(xiàn)了在不影響實(shí)時性能的前提下,大幅提高農(nóng)作物目標(biāo)檢測的平均精度和檢測速度。

2? 基于改進(jìn)的YOLOv3目標(biāo)檢測算法

2.1? 加強(qiáng)特征提取網(wǎng)絡(luò)

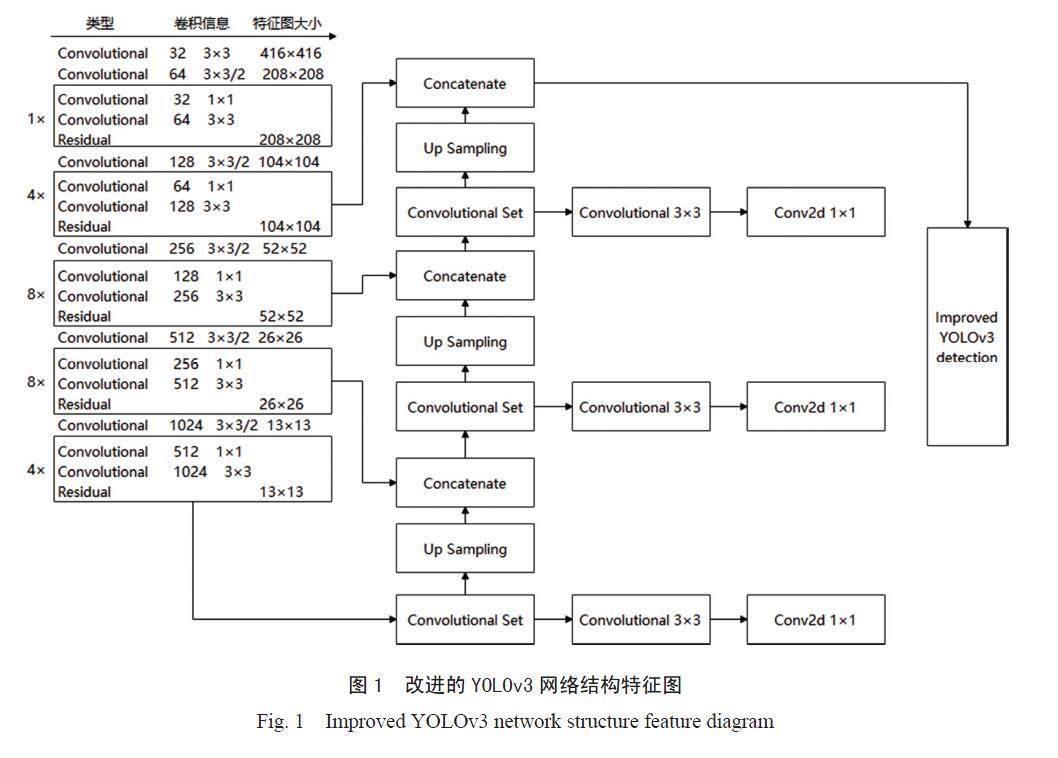

YOLOv3算法主干網(wǎng)絡(luò)結(jié)構(gòu)為Dark Net53,包含53個卷積網(wǎng)絡(luò)層,算法利用殘差網(wǎng)絡(luò)建立了5個殘差塊,通過殘差塊的累積,實(shí)現(xiàn)網(wǎng)絡(luò)深度的增加。YOLOv3網(wǎng)絡(luò)對小目標(biāo)檢測時,采用的是8倍降采樣輸出特征圖,而對處于早期生長期的農(nóng)作物目標(biāo)一般像素比較小,直接影響目標(biāo)識別模型對于小目標(biāo)作物的檢測精度,目標(biāo)檢測層為8倍降采樣特征圖對目標(biāo)較小的農(nóng)作物位置信息的檢測能力是有一定局限性的,為了加強(qiáng)對于小目標(biāo)農(nóng)作物的檢測精度,獲取更多的小作物目標(biāo)位置信息,將原算法網(wǎng)絡(luò)模型輸出的8倍降采樣特征圖經(jīng)過2倍上采樣后與Darknet 53中第2個殘差塊輸出的4倍降采樣特征圖進(jìn)行連接,建立輸出為4倍降采樣的特征融合目標(biāo)檢測層,以更好地檢測小目標(biāo)農(nóng)作物信息[10]。同時,原網(wǎng)絡(luò)的第2個殘差塊中增加2個殘差單元以獲取更豐富的低層小目標(biāo)作物的位置信息,改進(jìn)的YOLOv3網(wǎng)絡(luò)結(jié)構(gòu)如圖1所示。

2.2? 調(diào)整NMS重疊框置信度

農(nóng)作物實(shí)際種植過程中易出現(xiàn)作物生長過密,作物之間生長間距過小的情況,作物進(jìn)行目標(biāo)檢測時,會因?yàn)楹蜻x框重疊度較大進(jìn)而影響一部分作物識別的置信度,造成誤檢,影響識別精確度。因此本論文對重疊框置信度的規(guī)則作出調(diào)整。

標(biāo)準(zhǔn)的NMS的抑制函數(shù)如下所示,IOU超過閾值的檢測框的得分直接設(shè)置為0。

(1)

本文提出高斯懲罰函數(shù),具體公式如下:

(2)

高斯衰減函數(shù)對沒有重疊的檢測框的原有檢測分?jǐn)?shù)的衰減相對較弱,同時對高度重疊的候選框的衰減較強(qiáng),與農(nóng)作物檢測對于重疊框衰減函數(shù)的需求一致,在實(shí)驗(yàn)中,動態(tài)閾值的設(shè)計(jì)導(dǎo)致閾值中斷,對檢測結(jié)果造成影響的概率很低,檢測精度幾乎不受影響,這樣可以避免閾值設(shè)置大小的問題。所以高斯衰減函數(shù)可以作為重疊框調(diào)整函數(shù)來使用[11]。

2.3? 損失函數(shù)

YOLOv3的損失函數(shù)主要包含三部分:置信度損失、分類損失和回歸損失,其中置信度損失和分類損失上采用的是交叉熵?fù)p失,回歸損失使用誤差平方和的方式,最后對三個損失求和[12],損失函數(shù)公式如下:

(3)

其中:

S2表示特征圖大小

B表示該網(wǎng)格對應(yīng)的預(yù)測框個數(shù)

表示置信度概率預(yù)測

表示類別概率預(yù)測

λcoord表示回歸損失權(quán)重

λnobj表示不包含目標(biāo)的置信度損失權(quán)重

本文算法主要針對回歸損失函數(shù)進(jìn)行優(yōu)化改進(jìn),用CIOU Loss作為損失函數(shù),更有效實(shí)現(xiàn)了預(yù)測框與真值框之間的損失計(jì)算,使得目標(biāo)檢測過程中最終的目標(biāo)定位更加精確。

在目標(biāo)檢測過程中,一般將bounding box表示交并比IoU(Interest over Union),IoU主要指的是預(yù)測邊界框與真實(shí)邊界框的交集與并集的比值。計(jì)算公式為如下所示:

(4)

IoU值相同的情況下,真實(shí)框與預(yù)測框的重合度情況差別很大。因此本文將CIOU作為損失函數(shù),考慮到提高目標(biāo)框回歸的穩(wěn)定性,將目標(biāo)框與預(yù)測框的距離,重疊率以及尺度都包含在內(nèi),避免IOU在迭代訓(xùn)練過程中發(fā)散,其收斂精度更高[13],表達(dá)式為:

(5)

其中:

b和bgt表示預(yù)測框中心點(diǎn)與目標(biāo)框中心點(diǎn)

ρ2(b,bgt)表示歐式距離

c表示預(yù)測框與目標(biāo)框的最小外接矩形的對角線長度。

3? 實(shí)驗(yàn)及分析

3.1? 數(shù)據(jù)集

本文基于YOLOv3的改進(jìn)算法主要用于玉米的密度檢測,目前的高標(biāo)準(zhǔn)現(xiàn)代化農(nóng)業(yè)建設(shè)過程中,利用觀測設(shè)備觀測到的作物圖像進(jìn)行農(nóng)作物目標(biāo)檢測,檢測出作物種植類別,并能給出當(dāng)前范圍該作物的植株數(shù)目,對于估算作物密度情況有重要借鑒意義,并對后續(xù)的農(nóng)事活動(補(bǔ)苗、間苗、施肥)等具有重要參考價值,是發(fā)展智慧農(nóng)業(yè)的主要研究方向。

物候自動觀測儀主要由傳感器、采集器、通信單元等部分組成,系統(tǒng)框圖如圖2所示,本論文利用自動觀測設(shè)備單反相機(jī)拍攝的玉米實(shí)景圖片作為分析對象,通過4G無線網(wǎng)絡(luò)將拍攝圖像數(shù)據(jù)上傳到云平臺,當(dāng)圖片滿足處理要求時,進(jìn)入識別模塊,通過相應(yīng)的識別算法對圖片進(jìn)行處理獲取我們所需要的特征參數(shù)。

玉米圖像拍攝站點(diǎn)位于北京延慶物候植被觀測站,拍攝2023年6月1日至2023年7月15日玉米的生長期圖像,玉米的發(fā)育期生長狀態(tài)包括出苗期、三葉期、七葉期,玉米數(shù)據(jù)集共包含1200張圖像,圖像格式為JPG格式,像素大小為2992×2000,平均每張圖像上有120個目標(biāo),利用 LabelImg 軟件人工標(biāo)定標(biāo)簽,生成 xml 格式文件記錄所有目標(biāo)的位置、大小和類別信息。將數(shù)據(jù)按7:2:1 隨機(jī)分為訓(xùn)練集、驗(yàn)證集、測試集。模型開始訓(xùn)練時,輸入圖像大小調(diào)整為 416×416,依據(jù)PASCAL VOC 數(shù)據(jù)集格式標(biāo)準(zhǔn),對圖像標(biāo)注信息的邊界框?qū)挕⒏吆椭行狞c(diǎn)坐標(biāo)進(jìn)行歸一化處理,以減少異常樣本對數(shù)據(jù)的影響。

3.2? 網(wǎng)絡(luò)訓(xùn)練

實(shí)驗(yàn)使用的硬件配置為Inter(R) Core i7-9700K CPU,NVIDIA Geforce RTX 2080 Ti顯卡,Windows 10 企業(yè)版操作系統(tǒng),軟件環(huán)境是基于 Anaconda平臺搭建TensorFlow-GPU環(huán)境,版本號為TensorFlow-GPU 2.1.0,CUDA 10.1,Cudnn 7.4,通過 Python 語言編程實(shí)現(xiàn)搭建和復(fù)現(xiàn)實(shí)驗(yàn)中的所有網(wǎng)絡(luò)模型。

基于人工標(biāo)記的玉米數(shù)據(jù)集,分別用Faster R-CNN算法、YOLOv3算法和改進(jìn)的YOLOv3算法進(jìn)行模型訓(xùn)練,算法模型訓(xùn)練過程中初始學(xué)習(xí)率為0.001,衰減系數(shù)為0.005,模型訓(xùn)練迭代次數(shù)為10000次。三種算法的網(wǎng)絡(luò)訓(xùn)練曲線如圖3、圖4、圖5所示。

算法訓(xùn)練曲線包含訓(xùn)練精度曲線和訓(xùn)練損失曲線,由模型訓(xùn)練曲線圖可知,改進(jìn)的YOLOv3算法模型大約經(jīng)過7000次迭代后,各參數(shù)輸出逐漸趨于穩(wěn)定,訓(xùn)練精度達(dá)到0.92,明顯高于YOLOv3算法和Faster R-CNN算法的訓(xùn)練精度;模型的訓(xùn)練損失為0.2,較YOLOv3算法和Faster R-CNN算法的訓(xùn)練損失明顯降低。經(jīng)驗(yàn)證對比實(shí)驗(yàn)分析,改進(jìn)的YOLOv3算法對于玉米數(shù)據(jù)集的訓(xùn)練模型有明顯的提升,效果優(yōu)于YOLOv3算法和Faster R-CNN算法。

3.3? 訓(xùn)練結(jié)果定量評估

3.3.1? 改進(jìn)算法性能測試

本文改進(jìn)的YOLOv3算法主要從三個方面的改進(jìn)

優(yōu)化,基于不同方式的算法優(yōu)化在測試集上的目標(biāo)檢測性能如表1所示,相比于原YOLOv3算法,表 中 Algorithm-1 模塊調(diào)整NMS重疊框置信度,mAP(平均準(zhǔn)確度均值,Mean Average Precision)提升 3.2%,單張圖檢測耗時降低 0.03 s;Algorithm-2模塊加強(qiáng)特征提取網(wǎng)絡(luò),mAP提升 2.3%,單張圖檢測耗時減少 0.05s;Algorithm-3模塊優(yōu)化損失函數(shù), mAP提升 4.1%,單張圖檢測耗時增加 0.03 s。由表1網(wǎng)絡(luò)模型目標(biāo)檢測性能分析可知,不同方式的算法模型優(yōu)化方式都會提高目標(biāo)檢測模型性能,并且這些增益是互補(bǔ)的,將三種模式結(jié)合在一起能使網(wǎng)絡(luò)檢測性能進(jìn)一步提升。

3.3.2? 算法對比實(shí)驗(yàn)分析

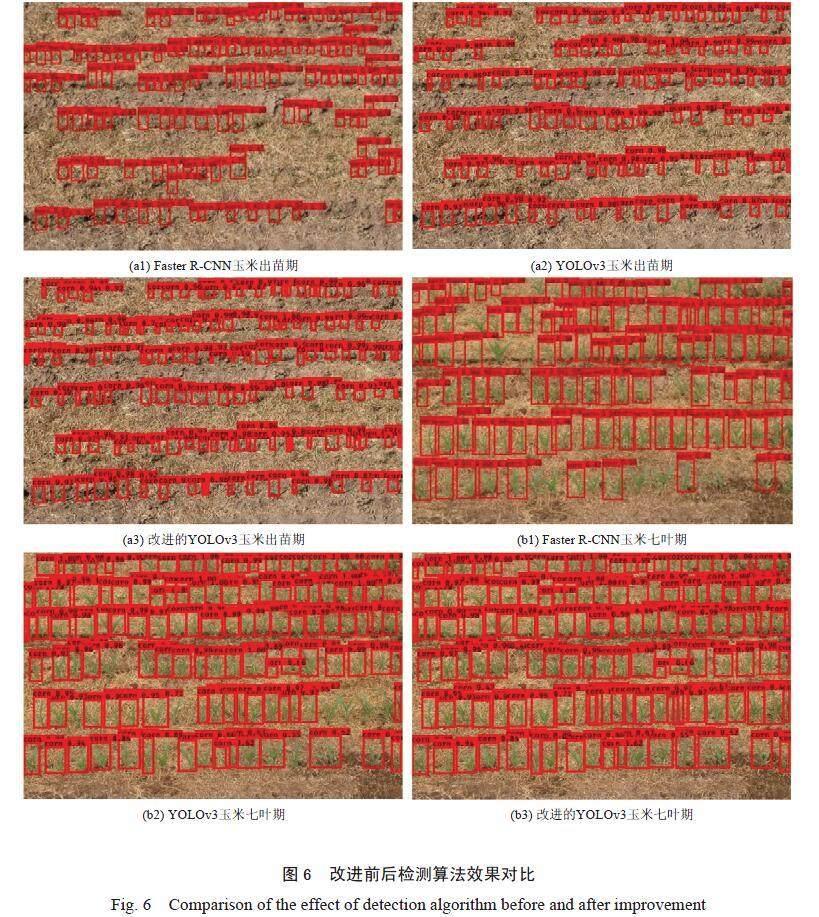

本文改進(jìn)算法主要是對置信度、特征提取網(wǎng)絡(luò)、損失函數(shù)三個方面做出優(yōu)化改進(jìn),改進(jìn)后的YOLOv3算法對比原算法網(wǎng)絡(luò)模型在測試集上的目標(biāo)檢測性能測試如表2所示。改進(jìn)后的算法對比其他算法網(wǎng)絡(luò)模型對玉米作物植株檢測結(jié)果輸出圖像如圖6所示。

基于改進(jìn)的YOLOv3網(wǎng)絡(luò)的玉米識別模型對玉米圖像檢測的平均準(zhǔn)確度均值(mAP)為91.2%,單張圖像檢測時間為0.22 s,較Faster R-CNN算法網(wǎng)絡(luò)模型和原YOLOv3算法網(wǎng)絡(luò)模型,mAP值分別提高了11%和8.8%,改進(jìn)的YOLOv3檢測速度比Faster R-CNN算法模型快0.08 s,比YOLOv3網(wǎng)絡(luò)模型快0.03 s,改進(jìn)網(wǎng)絡(luò)模型的檢測精度和檢測速度明顯提升。另外,改進(jìn)后的YOLOv3網(wǎng)絡(luò)模型檢測輸出圖像中,檢測框的位置偏差更小,優(yōu)于原網(wǎng)絡(luò)模型。

從圖6可以看出,F(xiàn)aster R-CNN網(wǎng)絡(luò)模型和原YOLOv3網(wǎng)絡(luò)模型對圖像中的小目標(biāo)植株存在漏檢情況,對圖像中的其他農(nóng)作物存在錯檢情況,不能完全檢測出圖像中的玉米植株,而改進(jìn)的YOLOv3網(wǎng)絡(luò)模型可以有效地檢測出場景中的小目標(biāo)信息,檢測的準(zhǔn)確性較高,并且有效避免錯檢情況發(fā)生,保證田間作物目標(biāo)檢測與識別。

4? 結(jié)論

為了有效地檢測農(nóng)作物小目標(biāo),以實(shí)時監(jiān)測田間作物生長狀態(tài)是否良好為目的,本文提出的改進(jìn)YOLOv3檢測算法用于農(nóng)作物目標(biāo)檢測,對YOLOv3的主干特征提取網(wǎng)絡(luò)進(jìn)行優(yōu)化;采用高斯衰減函數(shù)調(diào)整NMS重疊框置信度;對回歸損失函數(shù)進(jìn)行優(yōu)化改進(jìn),用CIOU Loss作為損失函數(shù),使得目標(biāo)檢測過程中最終的目標(biāo)定位更加精確。將改進(jìn)的 YOLOv3算法與Faster R-CNN算法、原 YOLOv3 算法在實(shí)拍的玉米作物拍攝數(shù)據(jù)集上進(jìn)行對比實(shí)驗(yàn),改進(jìn)的YOLOv3網(wǎng)絡(luò)的玉米識別模型對玉米圖像檢測的mAP值為91.2%,較Faster R-CNN算法網(wǎng)絡(luò)模型和原YOLOv3算法網(wǎng)絡(luò)模型,mAP值分別提高了11%和8.8%,結(jié)果表明改進(jìn)后改進(jìn)的YOLOv3網(wǎng)絡(luò)算法檢測的平均準(zhǔn)確率均值和檢測速度都有較大的提升,改進(jìn)模型的檢測性能明顯提高,對于小目標(biāo)作物的生長檢測有較好的應(yīng)用效果,能順利保證田間物候自動觀測儀的識別效果,為農(nóng)事活動提供判斷依據(jù),保障作物生長狀況持續(xù)向好。但是該優(yōu)化算法檢測精度的提升在一定程度上抑制了圖像的檢測速度,在實(shí)際田間大規(guī)模圖像進(jìn)行目標(biāo)檢測時,會影響設(shè)備的整體監(jiān)測速度,后續(xù)研究工作將致力于對網(wǎng)絡(luò)模型結(jié)構(gòu)與參數(shù)進(jìn)行優(yōu)化,通過降低參數(shù)達(dá)到提高模型檢測速度的目的。

參考文獻(xiàn)

[1] 耿創(chuàng),宋品德,曹立佳.YOLO算法在目標(biāo)檢測中的研究進(jìn)展[J].兵器裝備工程學(xué)報(bào),2022,43(9):162-173.

[2] 李維剛,楊潮,蔣林,等.基于改進(jìn)YOLOv4算法的室內(nèi)場景目標(biāo)檢測[J].激光與光電子學(xué)進(jìn)展,2022,59(18):251-260.

[3] 于博文,呂明.改進(jìn)的YOLOv3算法及其在軍事目標(biāo)檢測中的應(yīng)用[J].兵工學(xué)報(bào),2022,43(2):345-354.

[4] 陳禹蒲,馬曉川,李璇.基于YOLOv3錨框優(yōu)化的側(cè)掃聲吶圖像目標(biāo)檢測[J].信號處理,2022,38(11):2359-2371.

[5] 王瀟,李子琦,高濤,等.基于無損跨尺度特征融合的交通目標(biāo)檢測算法[J].中國公路學(xué)報(bào),2023,36(9):315-325.

[6] 王陽,袁國武,瞿睿,等.基于改進(jìn)YOLOv3的機(jī)場停機(jī)坪目標(biāo)檢測方法[J].鄭州大學(xué)學(xué)報(bào)(理學(xué)版),2022,54(5):22-28.

[7] 申志超.基于YOLO的顆粒狀農(nóng)作物檢測算法研究[D].哈爾濱:哈爾濱工業(yè)大學(xué),2022.

[8] 張穎超.基于深度學(xué)習(xí)的農(nóng)作物葉片病害檢測識別方法及其應(yīng)用研究[D].石家莊:河北科技大學(xué),2022.

[9] 金沙沙.圖像分割與目標(biāo)檢測在農(nóng)業(yè)場景中的應(yīng)用研究[D].浙江湖州:湖州師范學(xué)院,2022.

[10] 賈世娜.基于改進(jìn)YOLOv5的小目標(biāo)檢測算法研究[D].南昌:南昌大學(xué),2022.

[11] 潘昕暉,邵清,盧軍國.基于CBD-YOLOv3的小目標(biāo)檢測算法[J].小型微型計(jì)算機(jī)系統(tǒng),2022,43(10):2143-2149.

[12] 鞠默然,羅海波,王仲博,等.改進(jìn)的YOLO V3算法及其在小目標(biāo)檢測中的應(yīng)用[J].光學(xué)學(xué)報(bào),2019,39(7):253-260.

[13] 阮激揚(yáng). 基于YOLO的目標(biāo)檢測算法設(shè)計(jì)與實(shí)現(xiàn)[D].北京:北京郵電大學(xué),2019.

[14] 潘語豪,危疆樹,曾令鵬.基于YOLOv3的農(nóng)田鳥類目標(biāo)檢測算法[J].激光與光電子學(xué)進(jìn)展,2022,59(2):510-518.

[15] 王楊,曹鐵勇,楊吉斌,等.基于YOLO v5算法的迷彩偽裝目標(biāo)檢測技術(shù)研究[J].計(jì)算機(jī)科學(xué),2021,48(10):226-232.

[16] 王佩. 基于特征融合與信息增強(qiáng)的目標(biāo)檢測算法研究[D].江西贛州:江西理工大學(xué),2022.

[17] 王英立,史肖波.一種基于多尺度yolo算法的車輛目標(biāo)識別方法:CN202210806937.2[P].CN202210806937.2[2023-07-06].

[18] 孫景蘭, 張志紅, 余衛(wèi)東,等. 中國農(nóng)業(yè)氣象觀測自動化技術(shù)研究進(jìn)展[J]. 氣象科技進(jìn)展, 2022, 12 (4): 7-13.

[19] 王少博,張成,蘇迪,等.基于改進(jìn)YOLOv3和核相關(guān)濾波算法的旋轉(zhuǎn)彈目標(biāo)探測算法[J].兵工學(xué)報(bào),2022,43(5):1032-1045.

[20] 楊富強(qiáng),余波,趙嘉彬,等.基于改進(jìn)YOLOv3的橋梁底部裂縫目標(biāo)檢測方法[J].中國科技論文,2022,17(3):252-259.

[21] Lin T Y , Goyal P , Girshick R , et al. Focal loss for dense object detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, PP(99):2999-3007. https://doi.org/10.48550/arXiv. 1708.02002.

[22] Law H, Deng J. Cornernet: Detecting objects as paired keypoints[C]// European Conference on Computer Vision. Springer, Cham, 2018. https://doi.org/10.1007/s11263-019-01204-1

[23] Tian Z, Shen C, Chen H, et al. FCOS: Fully convolutional one-stage object detection[C]// CVF International Conference on Computer Vision (ICCV). IEEE, 2019. https://doi.org/10.1109/ICCV.2019. 00972.

[24] Cai Z, Vasconcelos N. Cascade R-CNN: Delving into high quality object detection[C]// Computer Vision and Pattern Recognition (cs.CV), IEEE, 2017. https://doi.org/10.48550/arXiv.1712.00726.

[25] Pang J, Chen K, Shi J, et al. Libra R-CNN: Towards balanced learning for object detection[C]// CVF Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2020. https://doi.org/10.48550/ arXiv.1904.02701.

[26] Lu X, Li B, Yue Y, et al. Grid R-CNN[C]// CVF Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2019. DOI: 10.1109/CVPR.2019.00754.

[27] Redmon J, Divvala S, Girshick R, et al. You Only Look Once: Unified, Real-Time Object Detection[C]// Conference on Computer Vision and Pattern Recognition (CVPR), IEEE, 2019. https://doi.org/10.1109/ CVPR.2016.91.

[28] Redmon J, Farhadi A. YOLO9000: Better, Faster, Stronger[C]// Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2017:6517-6525. https://doi.org/ 10.1109/CVPR.2017.690.

引用格式:郭蓓,王貝貝,張志紅,吳蘇,李鵬,胡莉婷.基于改進(jìn)的YOLOv3農(nóng)作物目標(biāo)檢測算法[J].農(nóng)業(yè)大數(shù)據(jù)學(xué)報(bào),2024,6(1): 40-47. DOI:10.19788/j. issn.2096-6369.000006.

CITATION: GUO Bei, WANG BeiBei, ZHANG ZhiHong, WU Su, LI Peng, HU LiTing. Improved YOLOv3 Crop Target Detection Algorithm[J]. Journal of Agricultural Big Data, 2024,6(1): 40-47. DOI: 10.19788/j.issn.2096-6369.000006.

Improved YOLOv3 Crop Target Detection Algorithm

GUO Bei1,2*, WANG BeiBei2, ZHANG ZhiHong1, WU Su2, LI Peng2, HU LiTing1

1. CMA·Henan Key Open Laboratory of Agrometeorological Support and Application Technology, Zhengzhou 450003, China;? ? ? ?2. Henan Zhongyuan Photolectric Meassurement and Control Technology Co.,LTD, Zhengzhou 450047, China

Abstract: When detecting targets in crop images, the detection accuracy of target detection algorithms can be seriously affected due to factors such as dense crop planting and poor imaging quality. In order to optimize the detection performance of crop object detection in YOLOv3, an improved algorithm based on YOLOv3 is proposed. Firstly, the backbone feature extraction network of YOLOv3 is optimized by utilizing the downsampling feature maps outputted by the original network to detect targets, and residual units are added on the basis of the residual blocks in the original network to detect the position information of small crop objects. Moreover, a Gaussian decay function is introduced to attenuate highly overlapping crop candidate boxes in the image, effectively suppressing redundant boxes and reducing false negative rate. Furthermore, the regression loss function is optimized by using CIOU Loss, making the final object localization more accurate during the object detection process. To evaluate the improved YOLOv3 algorithm, a comparative experiment is conducted on a real-world dataset of maize crop images, comparing it with the original YOLOv3 algorithm and the Faster R-CNN algorithm. The results demonstrate that the improved YOLOv3 algorithm can effectively detect small crop targets, exhibiting significantly improved mean average precision and detection speed.

Keywords: target detection;YOLOv3 algorithm; feature extraction network; loss function