基于圖像間的語(yǔ)義感知協(xié)同目標(biāo)檢測(cè)算法

葛延良 張靜 畢洪波 張林 田鴻鵬 賀敏 李德鑫

摘 要 提出了一個(gè)基于圖像間的語(yǔ)義感知協(xié)同目標(biāo)檢測(cè)算法,以高效的方式檢索整個(gè)圖像組的共識(shí)線索。對(duì)每個(gè)像素用語(yǔ)義感知協(xié)同模塊(SPCM)獲取其交叉路徑上所有像素的上下文信息。通過進(jìn)一步的操作,最終可以捕獲整個(gè)圖像的共識(shí)信息。輔助分類融合模塊(ACFM)可使網(wǎng)絡(luò)以自上而下的方式突出協(xié)同區(qū)域。協(xié)同顯著性檢測(cè)實(shí)驗(yàn)結(jié)果表明,文中的算法在3種常用的iCoseg、Cosal2015和CoSOD3k數(shù)據(jù)集中表現(xiàn)良好,4個(gè)指標(biāo)性能優(yōu)異,驗(yàn)證了該方法的有效性。

關(guān)鍵詞 協(xié)同顯著性檢測(cè) 圖像識(shí)別 語(yǔ)義感知協(xié)同模塊 輔助分類融合模塊

中圖分類號(hào) TP391.41? ?文獻(xiàn)標(biāo)志碼 A? ?文章編號(hào) 1000?3932(2024)01?0056?07

圖像協(xié)同顯著性檢測(cè)是通過探索多個(gè)相關(guān)圖片之間的內(nèi)在關(guān)系來發(fā)現(xiàn)圖像的重要目標(biāo),其在諸多領(lǐng)域中已經(jīng)引起了廣泛關(guān)注,包括弱監(jiān)督語(yǔ)義分割[1,2]、圖像檢索[3]及視頻前景檢測(cè)[4]等。傳統(tǒng)的協(xié)同顯著性檢測(cè)方法通常使用淺層特征作為常規(guī)特征,例如顏色直方圖[5]、多線索融合及SIFT描述符[6]等。然而,這些模型僅適用于檢測(cè)淺層特征,無法識(shí)別場(chǎng)景中的協(xié)同重要對(duì)象,限制了模型的性能。近年來,研究學(xué)者們通過基于深度學(xué)習(xí)的方法來改善協(xié)同顯著性檢測(cè),例如基于深度學(xué)習(xí)的模型探討了圖像內(nèi)和圖像間的一致性,并通過不同方法的監(jiān)督方式來強(qiáng)化特征,如圖卷積網(wǎng)絡(luò)(GCN)[7]、自學(xué)習(xí)方法[8]、具有PCA投影的圖像間共同關(guān)注或重復(fù)單元[9]、相關(guān)技術(shù)、質(zhì)量測(cè)量和共同聚類[10]。還有一些方法是利用多任務(wù)學(xué)習(xí)來同時(shí)優(yōu)化共顯著性檢測(cè)、共分割或共峰值搜索[11],并幫助提取更豐富的視覺代表的協(xié)同重要信息,探索圖像間的語(yǔ)義相關(guān)性。雖然這些方法已經(jīng)得到驗(yàn)證并取得了先進(jìn)結(jié)果,但是在弱光、復(fù)雜背景等困難場(chǎng)景下仍然無法準(zhǔn)確提取協(xié)同信息。為此,筆者提出一種深度網(wǎng)絡(luò)框架來挖掘不同圖像組之間的語(yǔ)義相關(guān)性。擬采用的網(wǎng)絡(luò)由兩部分組成:語(yǔ)義感知協(xié)同模塊(SPCM)和輔助分類融合模塊(ACFM)。首先,使用擴(kuò)張卷積從主干中提取并增強(qiáng)特征;隨后,將語(yǔ)義感知協(xié)同模塊用于公共顯著對(duì)象識(shí)別;最后,將輔助分類融合模塊應(yīng)用于融合共識(shí)特征和多尺度特征。該模型主干網(wǎng)絡(luò)以自上而下的方式提取突出區(qū)域,以全面探索圖像組的一致性。

1 模型及算法建立

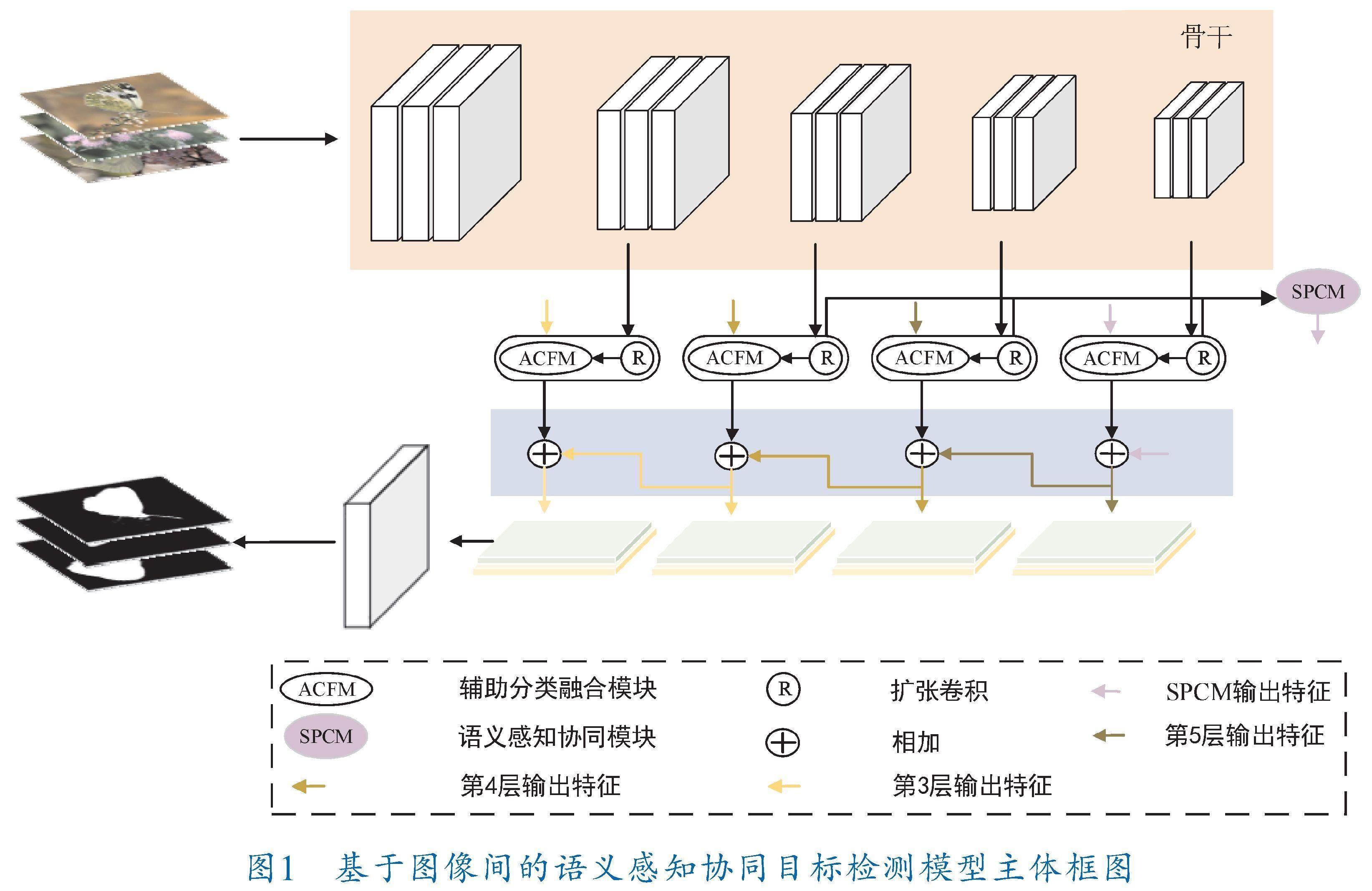

基于圖像間的語(yǔ)義感知協(xié)同目標(biāo)檢測(cè)模型如圖1所示。該模型通過自上而下的連接方式設(shè)計(jì)了語(yǔ)義感知協(xié)同網(wǎng)絡(luò),該網(wǎng)絡(luò)以VGG?16網(wǎng)絡(luò)為骨干。具體而言,圖像間的語(yǔ)義感知協(xié)同目標(biāo)檢測(cè)算法通過3個(gè)階段實(shí)現(xiàn)檢測(cè)協(xié)同顯著性目標(biāo)。當(dāng)接收到一組圖像輸入后,首先采用擴(kuò)張卷積來擴(kuò)大感受野,以捕獲特定層中更豐富的特征。通過卷積及上采樣操作,將捕獲的特征與相鄰特征通過相乘及級(jí)聯(lián)方式進(jìn)行信息融合,再通過卷積進(jìn)行降維處理,最后將整個(gè)模塊饋送到ReLU激活函數(shù)以獲得圖像信息。此外,為了使用輕量級(jí)計(jì)算來對(duì)局部圖像共性特征進(jìn)行提取,筆者提出了語(yǔ)義感知協(xié)同模塊。該模塊可在水平和垂直方向上收集上下文信息,以增強(qiáng)逐像素表示能力。使用該模塊生成與參考特征相似的特征從而突出協(xié)同顯著區(qū)域,使用輔助分類融合模塊挖掘并提高與參考特征類似的特征,作為促進(jìn)協(xié)同特征學(xué)習(xí)的有力指導(dǎo)。最后采用高層信息反饋指導(dǎo)低層的方式實(shí)現(xiàn)對(duì)協(xié)同顯著性目標(biāo)檢測(cè)的精準(zhǔn)判斷。

1.1 語(yǔ)義感知協(xié)同模塊

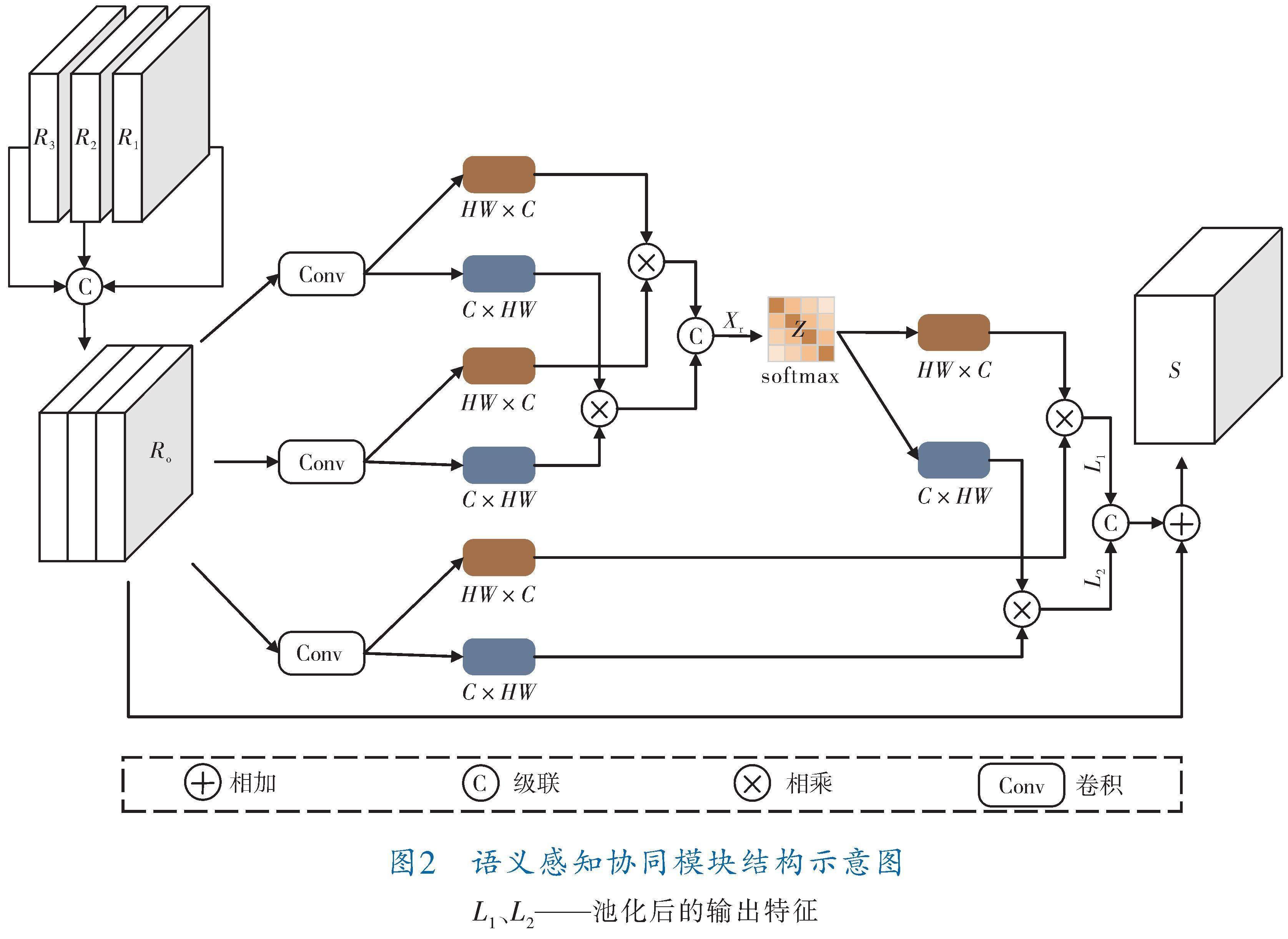

語(yǔ)義感知協(xié)同模塊結(jié)構(gòu)示意圖如圖2所示,對(duì)于協(xié)同語(yǔ)義信息的提取,考慮到層間信息的相關(guān)性,采用權(quán)重共享策略來加強(qiáng)層間信息的交互。

相鄰3層高級(jí)特征經(jīng)過擴(kuò)張卷積處理后表示為R、R、R,通過級(jí)聯(lián)融合為R,再將融合后的特征輸入到3個(gè)3×3卷積中進(jìn)行特征提取,隨后將特征轉(zhuǎn)置為HW×C和C×HW,同時(shí)引入通道分組連接策略并進(jìn)行通道混洗,其結(jié)果表示為X,將連接后的分組特征進(jìn)行交互以捕獲粗糙的組協(xié)同對(duì)象特征,并使用softmax激活函數(shù)對(duì)前者進(jìn)行補(bǔ)充和正則化,以避免它們過多地關(guān)注圖像特定的信息而忽略公共信息。經(jīng)過處理后的特征Z表示為:

Z=softmax(X)(1)

運(yùn)用親和矩陣來提取一組圖片的相似特征,通過一系列重組、取最大值、取平均值等操作得到特征圖,并將其與原始的特征圖相加,最后在組合空間上取均值得到語(yǔ)義感知協(xié)同模塊的輸出特征S為:

S=concatenate(L×L)+R(2)

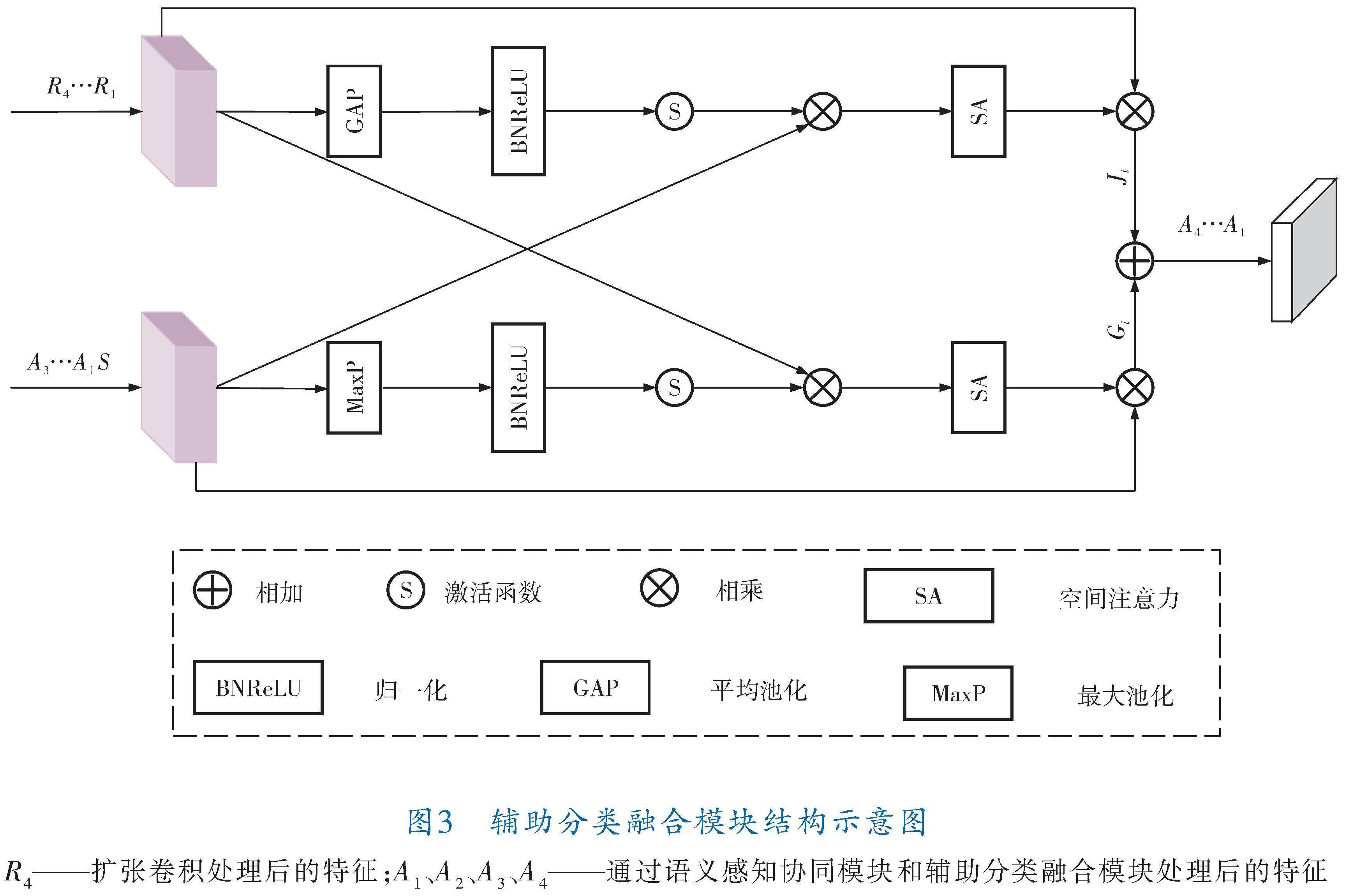

1.2 輔助分類融合模塊

輔助分類融合模塊結(jié)構(gòu)示意圖如圖3所示。

輔助分類融合模塊主要用于網(wǎng)絡(luò)的第2~5層。其中,第5層是將最高層通過擴(kuò)張卷積處理得到的特征R1與語(yǔ)義感知協(xié)同模塊的輸出特征S作為初始特征。首先將特征分別進(jìn)行平均池化和最大池化,充分提取并保留圖像的紋理及背景特征,從而有效降低背景噪聲的干擾。其次,特征信息經(jīng)過標(biāo)準(zhǔn)化操作加快訓(xùn)練速度后,可以減少變化帶來的不確定性。最后通過激活函數(shù)并與初始特征相乘后得到輸出J和G(i=1,2,3,4):

J=R×(SA(Sigmoid(BNReLU(GAP(R)))×S))×R(3)

G=S×(SA(Sigmoid(BNReLU(MaxP(S)))×R))×S(4)

利用空間注意力來增強(qiáng)協(xié)同特征和語(yǔ)義信息的表達(dá)能力,對(duì)關(guān)鍵線索進(jìn)行細(xì)化,提高協(xié)同特征的一致性及緊湊性。最后再用初始信息填補(bǔ)并相加聚合,在最大程度上將信息充分融合并輸出,即:

A=J+G(5)

第4層是以第5層的輸出A以及次高層通過擴(kuò)張卷積處理得到的特征R作為初始特征,重復(fù)運(yùn)用輔助分類融合模塊得到相應(yīng)的輸出。依此類推,利用早期的協(xié)同顯著性檢測(cè)結(jié)果來指導(dǎo)低層信息進(jìn)行聚合,從而生成最終的協(xié)同顯著性圖像。

2 實(shí)驗(yàn)及結(jié)果分析

2.1 模型訓(xùn)練

筆者選取3個(gè)協(xié)同顯著性檢測(cè)數(shù)據(jù)集并進(jìn)行評(píng)估從而驗(yàn)證所提方法的可行性。其中,iCoseg數(shù)據(jù)集[12]包括38個(gè)不同類別的643幅圖像。每組有4~41幅圖像,每幅圖像都有手動(dòng)標(biāo)記的逐像素級(jí)真實(shí)值用于評(píng)估。Cosal2015[13]是一個(gè)較新的數(shù)據(jù)集,它有50組共2 015張圖像,每組包含26~52張圖像,每組都面臨著不同的挑戰(zhàn)性問題,如復(fù)雜環(huán)境、遮擋問題、目標(biāo)外觀變化和背景雜波。CoSOD3k[14]是一個(gè)大型數(shù)據(jù)集,包含160組共3 316張圖像,涵蓋了廣泛的形狀、對(duì)象大小和背景類別,因此更適用于協(xié)同顯著性檢測(cè)方法的應(yīng)用和性能評(píng)估。

本實(shí)驗(yàn)中筆者采用4個(gè)廣泛使用的指標(biāo)來定量評(píng)估算法性能,即maximum E?measure(E)[15]、S?measure(S)[16]、maximum F?measure(F)[17]和mean absolute error(MAE)[18]。其中,E用于評(píng)估全局信息和局部細(xì)節(jié)的一致性;S是推理結(jié)果和真值圖像結(jié)構(gòu)相似性的評(píng)價(jià)指標(biāo);F表示諧波平均值是由自適應(yīng)閾值T(T=μ+σ,μ和σ表示協(xié)同顯著性圖的平均值和標(biāo)準(zhǔn)差)中的精密度和召回率組成的,是評(píng)價(jià)前景圖空間結(jié)構(gòu)相似性的可靠指標(biāo);MAE為預(yù)測(cè)協(xié)同顯著性圖和真實(shí)圖之間的平均絕對(duì)誤差。

實(shí)驗(yàn)硬件設(shè)備為Intel(R)Xeon(R)Bronze 3106 CPU@1.70 GHz處理器,16 GB操作內(nèi)存,具有兩個(gè)GeForce GTX 1080 TI 16 GB顯卡。本模型在PyTorch上實(shí)現(xiàn),使用VGG?16作為網(wǎng)絡(luò)骨干,并采用DUTS[19]數(shù)據(jù)集作為訓(xùn)練集。模型由Adam優(yōu)化器訓(xùn)練。所有圖像的像素均調(diào)整為256×256以便用于訓(xùn)練和測(cè)試,初始學(xué)習(xí)率為0.000 1,批量大小為10,迭代次數(shù)為10,當(dāng)訓(xùn)練損失達(dá)到平均水平時(shí),訓(xùn)練損失可減少10%。

2.2 實(shí)驗(yàn)結(jié)果

圖4為本文模型與6種代表性算法的圖像處理視覺對(duì)比結(jié)果,可以看出,本文模型可以更好地搜索和分割在具有挑戰(zhàn)性場(chǎng)景中同時(shí)出現(xiàn)的突出對(duì)象,同時(shí)能夠?qū)f(xié)同對(duì)象邊緣細(xì)化,而其他方法會(huì)受到不相關(guān)的突出對(duì)象或背景的干擾,導(dǎo)致圖像處理結(jié)果不盡人意。可見,本文模型可以更加準(zhǔn)確地檢測(cè)到重要的協(xié)同目標(biāo),并生成比其他方法更精確的共顯著性圖像。

表1為本文模型與9種代表性先進(jìn)方法的實(shí)驗(yàn)結(jié)果對(duì)比。

可以看出,在數(shù)據(jù)集iCoseg、Cosal2015和CoSOD3k上測(cè)試后,本文模型在所有指標(biāo)上都優(yōu)于其他方法。具體而言,盡管CoSOD3k數(shù)據(jù)集包含各種干擾信息,但本文模型仍然能夠很好地區(qū)分協(xié)同重要目標(biāo),并且算法性能出色。在Cosal2015和iCoseg數(shù)據(jù)集上,本文模型的4個(gè)指標(biāo)均優(yōu)于其他方法,證明了本文模型在處理協(xié)同顯著性檢測(cè)任務(wù)方面的有效性。

2.3 消融實(shí)驗(yàn)

在相同的實(shí)驗(yàn)環(huán)境與數(shù)據(jù)集下進(jìn)行消融實(shí)驗(yàn),結(jié)果見表2。可以看出,當(dāng)模型僅采用SPCM進(jìn)行優(yōu)化時(shí),所有指標(biāo)都得到了改善。在Cosal2015數(shù)據(jù)集中,MAE從0.104降至0.100,S從0.790升高至0.799,F(xiàn)從0.765升高至0.772,增加了0.9%,

E從0.831升高至0.836。可見,當(dāng)模型采用SPCM優(yōu)化后,其能夠很好地捕獲水平和垂直相關(guān)矩陣中的公共信息,從而使得性能得到了顯著提升。當(dāng)模型僅采用ACFM進(jìn)行優(yōu)化時(shí),模型的性能同樣得到了改善。以CoSOD3k數(shù)據(jù)集為例,采用ACFM優(yōu)化后,模型的MAE從0.119降低至0.115,

S從0.737升至0.749,F(xiàn)從0.680升至0.691,E從0.789升至0.797。可見,ACFM優(yōu)化后的模塊具有出色的處理協(xié)同任務(wù)的能力。最后,同時(shí)使用SPCM和ACFM進(jìn)行模型優(yōu)化,4個(gè)性能指標(biāo)均得到了進(jìn)一步提升,達(dá)到了更好的使用效果。

3 結(jié)束語(yǔ)

筆者提出了一個(gè)有效的協(xié)同顯著性檢測(cè)框架。它能夠自適應(yīng)地通過語(yǔ)義信息捕獲共識(shí)特征,包括語(yǔ)義感知協(xié)同模塊和輔助分類融合模塊。擴(kuò)張卷積使語(yǔ)義感知協(xié)同模塊能夠最大程度地提取所需信息。筆者應(yīng)用語(yǔ)義感知協(xié)同模塊來精確地提取圖像的共性特征。為了將共性特征與多尺度特征融合,引入了輔助分類融合模塊。在3個(gè)標(biāo)準(zhǔn)數(shù)據(jù)集上的實(shí)驗(yàn)結(jié)果表明,筆者所提算法在多個(gè)評(píng)估指標(biāo)上均優(yōu)于傳統(tǒng)方法,證明了本方法的有效性。

參 考 文 獻(xiàn)

[1]?? FU H Z,XU D,LIN S,et al.Object?based RGBD image co?segmentation with mutex constraint[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition(CVPR). IEEE, 2015.DOI:10.1109/CVPR. 2015.

7299072.

[2]?? WEI L N, ZHAO S S, BOURAHLA O E F, et al.Group?wise Deep Co?saliency Detection[C]//Proceedings of the 26th International Joint Conference on Artificial Intelligence.2017:3041-3047.

[3]?? FAN D P,LI T P,LIN Z,et al.Re?Thinking Co?Salient Object Detection[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2022,44(8):4339-4354.

[4]?? PASZKE A,GROSS S,MASSA F,et al.PyTorch:An imperative style,high?performance deep learning library[C]//33rd Conference on Neural Information Processing Systems.2019.DOI:10.48550/arXiv.1912.01703.

[5]?? JIANG B,JIANG X,ZHOU A,et al.A Unified Multiple Graph Learning and Convolutional Network Model for Co?saliency Estimation[C]//The 27th ACM International Conference.ACM,2019.DOI:10.1145/3343031.

3350860.

[6]?? CHANG K Y,LIU T L,LAI S H.From co?saliency to co?segmentation:An efficient and fully unsupervised energy minimization model[C]//CVPR 2011.IEEE,2011.DOI:10.1109/CVPR.2011.5995415.

[7]? GAO R J,GUO Q,XU F,et al.Can You Spot the Chameleon?Adversarially Camouflaging Images from Co?Salient Object Detection[C]//2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR). IEEE, 2022.DOI:10.1109/CVPR52688.

2022.00219.

[8]?? ZHENG P, FU H Z, FAN D P,et al. GCoNet+:A Stronger Group Collaborative Co?Salient Object Detector[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2023:1-17.

[9]?? HSU K J,LIN Y Y,CHUANG Y Y.DeepCO3:Deep Instance Co?Segmentation by Co?Peak Search and Co?Saliency Detection[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).IEEE,2019.DOI:10.1109/CVPR.2019.00905.

[10]?? JERRIPOTHULA K R,CAI J F,YUAN J S.Quality?Guided Fusion?Based Co?Saliency Estimation for Image Co?Segmentation and Colocalization[J].IEEE Transactions on Multimedia, 2018,20(9):2466-2477.

[11]?? JIN W D,XU J,CHENG M M,et al.Icnet:Intra?saliency correlation network for cosaliency detection[J].Advances in Neural Information Processing Systems,2020,33:18749-18759.

[12]?? ZHANG D W,HAN J W,HAN J G,et al.Cosaliency Detection Based on Intrasaliency Prior Transfer and Deep Intersaliency Mining[J].IEEE Transactions on Neural Networks and Learning Systems,2016,27(6):1163-1176.

[13]?? PASZKE A,GROSS S,MASSA F,et al.PyTorch:An Imperative Style,High?Performance Deep Learning Library[J].2019.DOI:10.48550/arXiv.1912.01703.

[14]?? WEI Y C,LIANG X D,CHEN Y P,et al.STC:A Simple to Complex Framework for Weakly?Supervised Semantic Segmentation[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(11):2314-2320.

[15]?? FAN D P,CHENG M M,LIU Y,et al.Structure?measure:A new way to evaluate foreground maps[C]//2017 IEEE International Conference on Computer Vision(ICCV).IEEE,2017:4558-4567.

[16]?? ACHANTA R, HEMAMI S, ESTRADA F, et al.Frequency?tuned salient region detection[C]//2009 IEEE Conference on Computer Vision and Pattern Recognition. IEEE, 2009.DOI:10.1109/CVPR.2009.5206596.

[17]?? CHENG M M, MITRA N J, HUANG X L, et al.SalientShape:Group saliency in image collections[J].Visual Computer,2014,30(4):443-453.

[18]?? WANG L J,LU H C,WANG Y F,et al.Learning to detect salient objects with image?level supervision[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).IEEE,2017.DOI:10.1109/CVPR.2017.404.

[19]?? BATRA D,KOWDLE A,PARIKH D,et al.iCoseg:Interactive co?segmentation with intelligent scribble guidance[C]//2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition.IEEE,2010:3169-3176.

[20]?? FU H Z,CAO X C,TU Z W.Cluster?based co?saliency detection[J].TIP,2013,22(10):3766-3778.

[21]?? LI Y J,F(xiàn)U K,LIU Z,et al.Efficient saliency?model?guided visual co?saliency detection[J].IEEE Signal Processing Letters,2015,22(5):588-592.

[22]?? YE L,LIU Z,LI J,et al.Co?saliency detection via co?salient object discovery and recovery[J].IEEE Signal Processing Letters,2015,22(11):2073-2077.

[23]?? ZHANG K,LI T,LIU B,et al.Co?saliency detection via mask?guided fully convolutional networks with multi?scale label smoothing[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition.2019:3095-3104.

[24]?? LI B,SUN Z X,TANG L,et al.Detecting robust co?saliency with recurrent co?attention neural network[C]//Proceedings of the 28th International Joint Conference on Artificial Intelligence.2019:818-825.DOI:

10.24963/ijcai.2019/115.

[25]?? JIANG B,JIANG X Y,ZHOU A J,et al.A unified multiple graph learning and convolutional network model for co?saliency estimation[C]//The 27th ACM International Conference.ACM,2019.DOI:10.1145/3343031.3350860.

[26]?? WU Z,SU L,HUANG Q M.Stacked cross refinement network for edge?aware salient object detection[C]//2019 IEEE/CVF International Conference on Computer Vision(ICCV).IEEE,2020.DOI:10.1109/ICCV.2019.00736.

[27]?? ZHANG K H,CHEN J,LIU B,et al.Deep object co?segmentation via spatial?semantic network modulation[C]//Proceedings of the AAAI Conference on Artificial Intelligence.AAAI,2020:12813-12820.