基于改進(jìn)YOLOv5 和BiFPN 的蘋(píng)果檢測(cè)方法*

溫彬彬

(河北工業(yè)職業(yè)技術(shù)大學(xué),河北 石家莊 054000)

蘋(píng)果是全球最受歡迎、最重要的經(jīng)濟(jì)作物之一,具有低投入、高產(chǎn)出、高收益等特點(diǎn),是促進(jìn)農(nóng)民脫貧致富和推動(dòng)鄉(xiāng)村振興的重要抓手[1]。數(shù)字化、智能化的農(nóng)業(yè)正在高速發(fā)展,蘋(píng)果目標(biāo)檢測(cè)對(duì)于智能果園的生產(chǎn)管理、病蟲(chóng)害預(yù)測(cè)、果實(shí)采摘以及果實(shí)質(zhì)量評(píng)估等方面具有重要作用,快速且準(zhǔn)確的蘋(píng)果檢測(cè)技術(shù)為果農(nóng)提供了更加高效、便捷的農(nóng)業(yè)管理手段,加速推動(dòng)了農(nóng)業(yè)領(lǐng)域的智能化發(fā)展。

1 目標(biāo)檢測(cè)發(fā)展現(xiàn)狀

目標(biāo)檢測(cè)是計(jì)算機(jī)視覺(jué)領(lǐng)域的一項(xiàng)重要任務(wù),它的目標(biāo)是在圖像或視頻中準(zhǔn)確地定位和識(shí)別出感興趣的目標(biāo)對(duì)象。早期的目標(biāo)檢測(cè)方法主要基于手工設(shè)計(jì)的特征,如Haar 特征、HOG 特征等[2],主要通過(guò)在圖像中尋找特定的局部特征模式,然后使用分類器進(jìn)行目標(biāo)檢測(cè)。但是由于手工特征的設(shè)計(jì)通常依賴于領(lǐng)域知識(shí)和經(jīng)驗(yàn),且難以適應(yīng)復(fù)雜的場(chǎng)景和目標(biāo)變化,因此在性能和泛化能力上存在一定的局限性。為了解決目標(biāo)尺寸和位置的變化,研究者提出了基于滑動(dòng)窗口的方法。這類方法通過(guò)在圖像上移動(dòng)不同尺寸和位置的窗口,并使用分類器對(duì)每個(gè)窗口進(jìn)行分類[3],以判斷是否包含目標(biāo)。然而,這種方法需要對(duì)大量的窗口進(jìn)行分類,計(jì)算量較大,且容易產(chǎn)生大量的誤檢測(cè)。隨著深度學(xué)習(xí)的興起,目標(biāo)檢測(cè)領(lǐng)域也迎來(lái)了革命性的突破。基于深度學(xué)習(xí)的目標(biāo)檢測(cè)方法通常采用卷積神經(jīng)網(wǎng)絡(luò)(CNN)來(lái)提取圖像特征[4],并通過(guò)分類器和回歸器來(lái)預(yù)測(cè)目標(biāo)的類別和位置。一系列經(jīng)典的方法如R-CNN、Fast R-CNN、Faster R-CNN、YOLO 和SSD 等被相繼提出,并在各自的任務(wù)中取得了較好的性能。這些方法通過(guò)端到端的訓(xùn)練方式,可以自動(dòng)學(xué)習(xí)圖像特征和目標(biāo)檢測(cè)模型,大大提升了檢測(cè)性能和效率。但CNN 是兩階段的檢測(cè)器,模型具有大量的參數(shù)和復(fù)雜的計(jì)算結(jié)構(gòu),計(jì)算和推理速度較慢,而且大量研究表明,CNN 對(duì)小目標(biāo)的檢測(cè)性能較弱。為了進(jìn)一步提升檢測(cè)速度和準(zhǔn)確率,研究者們提出了一系列單階段檢測(cè)器,如YOLOv2、YOLOv5、RetinaNet 和EfficientDet 等[5]。這些方法通過(guò)設(shè)計(jì)新的網(wǎng)絡(luò)結(jié)構(gòu)、特征融合機(jī)制和損失函數(shù)等,實(shí)現(xiàn)了在速度和準(zhǔn)確率上的平衡。

2 YOLO算法簡(jiǎn)介

YOLO 系列算法(You Only Look Once)由于實(shí)時(shí)性和高準(zhǔn)確性而備受關(guān)注。YOLOv1 是YOLO 系列的第一版[6],是Joseph Redmon 等在2016 年提出的一種端到端的物體識(shí)別與檢測(cè)方法,采用了多個(gè)網(wǎng)格劃分與多尺度預(yù)測(cè)的策略,相較于同期方法如Faster R-CNN、SSD 等有著更快的推理速度,但是YOLOv1 在檢測(cè)小目標(biāo)和困難目標(biāo)上效果不佳。為了解決這些問(wèn)題,Joseph Redmon 等在2017 年提出了YOLOv2,使用Anchor Boxes來(lái)預(yù)測(cè)目標(biāo)的位置和尺寸,使用Darknet-19 網(wǎng)絡(luò)結(jié)構(gòu)來(lái)提取圖像特征,使用批量歸一化技術(shù)來(lái)加速模型的訓(xùn)練等,在精度和檢測(cè)數(shù)目上有明顯的提升。YOLOv3 進(jìn)一步提高了檢測(cè)精度,引入了特征金字塔(Feature Pyramid Network,FPN)技術(shù)和多尺度特征圖預(yù)測(cè)的策略,更適合小目標(biāo)的檢測(cè),然而YOLOv3 在速度方面的表現(xiàn)并不理想。為了達(dá)到速度和檢測(cè)性能之間的平衡,2020年4 月Alexey 等推出了YOLOv4,提出了一系列的優(yōu)化措施來(lái)平衡速度與精度;同年6 月,YOLOv5在YOLOv4 的基礎(chǔ)上進(jìn)一步優(yōu)化并公開(kāi)代碼,提出在特征提取階段使用更強(qiáng)的CSPDarkNet 網(wǎng)絡(luò)模型,在目標(biāo)邊框損失計(jì)算上使用CIoU 損失(Complete Intersection over Union Loss)來(lái)更精確地描述兩個(gè)目標(biāo)框之間的位置偏差[7],大量實(shí)驗(yàn)表明,YOLOv5 相較于前代算法YOLOv4,在速度和精度方面都有著不小的提升。

YOLO 系列算法在農(nóng)業(yè)領(lǐng)域的應(yīng)用非常廣泛,特別是在農(nóng)作物的檢測(cè)、分類和病害診斷方面。楊佳昊等[8]利用LCNN 替換YOLOv5s 主干對(duì)模型主體進(jìn)行縮減,對(duì)番茄黃化曲葉病檢測(cè)模型開(kāi)展輕量化試驗(yàn);劉忠意等[9]提出一種改進(jìn)的YOLOv5 方法,在主干網(wǎng)絡(luò)部分使用RepVGG(re-param VGG)模塊替換原始C3 模塊,加強(qiáng)網(wǎng)絡(luò)對(duì)特征信息的提取能力。還有一些研究人員使用深度學(xué)習(xí)來(lái)進(jìn)行蘋(píng)果識(shí)別。張立杰等[10]提出了一種基于改進(jìn)SSD 卷積神經(jīng)網(wǎng)絡(luò)的蘋(píng)果定位與分級(jí)算法,所提方法具有良好的分割效果。曹志鵬等[11]采用輕量化的主干網(wǎng)絡(luò)Ghostnet 替代YOLOv4 中的CSPdarknet53 主干網(wǎng)絡(luò),再采用深度可分離卷積替換YOLOv4 中的頸部網(wǎng)絡(luò),該算法加快了檢測(cè)速度,減少了權(quán)重文件的大小。周桂紅等[5]提出了一種基于改進(jìn)YOLOv4 和基于閾值的邊界框匹配合并算法的全景圖像蘋(píng)果識(shí)別方法,該方法在精確率和召回率上有明顯的提升。張境鋒等[12]提出一種Des-YOLOv4 算法與蘋(píng)果檢測(cè)方法,該方法具有檢測(cè)速度快、檢測(cè)精度高的優(yōu)點(diǎn)。

雖然YOLOv5 在農(nóng)業(yè)領(lǐng)域應(yīng)用較為廣泛,但是自然環(huán)境下成熟的蘋(píng)果存在果實(shí)大小不一、果實(shí)之間遮擋嚴(yán)重等問(wèn)題。為了解決目標(biāo)檢測(cè)中的這些問(wèn)題,本文提出一種基于改進(jìn)YOLOv5 網(wǎng)絡(luò)的果實(shí)檢測(cè)方法,在中間層的特征增強(qiáng)模塊中改變?cè)卣鹘鹱炙?jiǎn)單雙向融合特征圖,采用BiFPN 特征融合網(wǎng)絡(luò)[13],將不同尺度的特征融合,可以在保持高分辨率特征的同時(shí),提升檢測(cè)模型對(duì)小目標(biāo)的感知能力。

3 改進(jìn)的YOLOv5模型

3.1 YOLOv5算法介紹

YOLOv5 是YOLO 系列的第五代算法,相較于初代算法,其在模型架構(gòu)、錨框匹配、損失函數(shù)等方面進(jìn)行了大量改進(jìn),并最終在速度和精度之間取得了更好的平衡。其結(jié)構(gòu)包括以下幾個(gè)組成部分:

1)Backbone 網(wǎng)絡(luò)。由多個(gè)卷積層和池化層組成,將原始圖像轉(zhuǎn)化為一系列特征圖,這些特征圖可以捕捉到不同尺度和語(yǔ)義層次的信息,有助于提高目標(biāo)檢測(cè)算法在不同尺度上的檢測(cè)能力。YOLOv5 使用CSPDarknet 作為其主干網(wǎng)絡(luò)(backbone network),它是一種輕量級(jí)的卷積神經(jīng)網(wǎng)絡(luò)。CSPDarknet 通過(guò)使用CSP(Cross Stage Partial Network)結(jié)構(gòu)來(lái)提高特征的表達(dá)能力和計(jì)算效率。

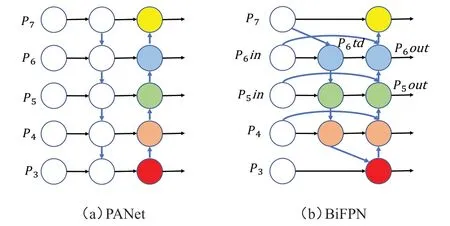

2)Neck網(wǎng)絡(luò)。將特征圖進(jìn)行融合,將低層次的細(xì)節(jié)特征和高層次的語(yǔ)義特征結(jié)合起來(lái),從而提高模型對(duì)目標(biāo)的檢測(cè)能力,為了實(shí)現(xiàn)更好的目標(biāo)檢測(cè)性能,YOLOv5 還引入了一種名為PANet(Path Aggregation Network)的Neck 網(wǎng)絡(luò)結(jié)構(gòu)。PANet 可通過(guò)多尺度特征融合的方式,將不同層次的特征進(jìn)行聚合。

3)Head 網(wǎng)絡(luò)。YOLOv5 的頭部網(wǎng)絡(luò)(head network)由一系列卷積層和全連接層組成。它負(fù)責(zé)對(duì)骨干網(wǎng)絡(luò)提取的特征進(jìn)行進(jìn)一步處理,以輸出目標(biāo)的檢測(cè)框、類別標(biāo)簽和置信度得分。

4)Anchor Boxes。YOLOv5 使用了Anchor Boxes來(lái)預(yù)測(cè)目標(biāo)的位置和尺寸。Anchor Boxes是一組預(yù)定義的矩形框,每個(gè)框都與一個(gè)特定的尺度和縱橫比相關(guān)聯(lián)。YOLOv5 通過(guò)預(yù)測(cè)Anchor Boxes 的偏移量和尺度縮放因子來(lái)生成最終的檢測(cè)框。

5)L o s s 函數(shù)。Y O L O v 5 使用了一種組合的損失函數(shù)來(lái)訓(xùn)練模型,包括目標(biāo)檢測(cè)損失(object detection loss)和分類損失(classification loss)。目標(biāo)檢測(cè)損失主要用于衡量檢測(cè)框的準(zhǔn)確性,分類損失主要用于衡量類別的預(yù)測(cè)準(zhǔn)確性。

綜上所述,YOLOv5算法通過(guò)Backbone網(wǎng)絡(luò)提取圖像特征,通過(guò)Neck網(wǎng)絡(luò)進(jìn)行多尺度特征融合,然后通過(guò)Head 網(wǎng)絡(luò)生成檢測(cè)結(jié)果,并使用Loss 函數(shù)進(jìn)行模型訓(xùn)練和優(yōu)化。這種結(jié)構(gòu)設(shè)計(jì)使得YOLOv5在目標(biāo)檢測(cè)任務(wù)中具有較高的準(zhǔn)確性和較快的檢測(cè)速度。

YOLOv5 模型的準(zhǔn)確率很大程度上是由中間層特征增強(qiáng)模塊決定的,中間層特征增強(qiáng)模塊的關(guān)鍵是特征金字塔,傳統(tǒng)的特征金字塔網(wǎng)絡(luò)PANet 使用簡(jiǎn)單雙向融合網(wǎng)絡(luò)在不同層級(jí)的特征圖之間進(jìn)行上下文信息的傳遞,如圖1(a)所示。簡(jiǎn)單雙向融合網(wǎng)絡(luò)可能會(huì)造成特征的分辨率降低和信息丟失,在進(jìn)行特征融合時(shí),會(huì)導(dǎo)致不同層級(jí)的特征在數(shù)量和質(zhì)量上存在不平衡的問(wèn)題,影響目標(biāo)檢測(cè)的準(zhǔn)確性。

圖1 PANet和BiFPN結(jié)構(gòu)

3.2 BiFPN網(wǎng)絡(luò)結(jié)構(gòu)

為了解決信息傳遞不夠充分而導(dǎo)致模型準(zhǔn)確率下降的問(wèn)題,在YOLOv5 模型中使用一種改進(jìn)的特征提取模塊BiFPN(Bi-directional Feature Pyramid Network),它是一種用于目標(biāo)檢測(cè)任務(wù)的特征金字塔網(wǎng)絡(luò)。

BiFPN 通過(guò)引入雙向的信息傳遞機(jī)制,更好地利用了不同層級(jí)特征的上下文信息,如圖1(b)所示。BiFPN 模塊包括兩個(gè)階段:自上而下和自下而上。在自上而下的階段,高層特征圖通過(guò)上采樣進(jìn)行細(xì)化,并與低層特征圖進(jìn)行融合。這樣可以使得高層特征圖獲得更豐富的上下文信息。在自下而上的階段,低層特征圖通過(guò)下采樣進(jìn)行粗化,并與高層特征圖進(jìn)行融合。這樣可以使得低層特征圖獲得更多的細(xì)節(jié)信息。BiFPN 結(jié)構(gòu)中的每個(gè)層都與上下兩個(gè)相鄰的層進(jìn)行連接,這種雙向連接的設(shè)計(jì)可以有效地將不同層級(jí)的特征信息進(jìn)行融合和交互,提高了特征的表達(dá)能力。BiFPN 結(jié)構(gòu)通過(guò)上下兩個(gè)分支分別進(jìn)行不同尺度的特征融合,可以在保持高分辨率特征的同時(shí),將更高層級(jí)的語(yǔ)義信息引入,提升檢測(cè)模型對(duì)小目標(biāo)的感知能力。BiFPN 結(jié)構(gòu)的特征融合過(guò)程中,采用了一種動(dòng)態(tài)權(quán)重分配的方式,根據(jù)特征的質(zhì)量和重要性,自適應(yīng)地調(diào)整各個(gè)特征通道的權(quán)重,以保證高質(zhì)量特征的有效利用。BiFPN 結(jié)構(gòu)可以根據(jù)需要進(jìn)行多次重復(fù)堆疊,每次重復(fù)都通過(guò)進(jìn)一步的特征融合和優(yōu)化,提高了網(wǎng)絡(luò)的深度可擴(kuò)展性,可以適應(yīng)不同復(fù)雜度和精度要求的目標(biāo)檢測(cè)任務(wù)。

BiFPN 網(wǎng)絡(luò)通過(guò)加權(quán)特征融合機(jī)制、卷積、下采樣的方式實(shí)現(xiàn)融合,以P6out為例,P6out是將第6 層輸入的P6td、P6in和第5 層的P5out加權(quán)融合得到的,P6td是自上而下第6 層的中間特征,P6td和P6out的表達(dá)式分別如式(1)、式(2)所示。

式中,ω1、ω2、ω′1、ω′2和ω′3是權(quán)重參數(shù);Resize是下采樣操作;ε是一個(gè)參數(shù),用來(lái)避免由于權(quán)重參數(shù)過(guò)小而導(dǎo)致的數(shù)值不穩(wěn)定。

BiFPN 模塊的引入使得YOLOv5 模型在蘋(píng)果識(shí)別任務(wù)中具有更好的性能和更高的準(zhǔn)確性。它能夠提取多尺度的特征,并且能夠更好地處理不同尺度的目標(biāo)。BiFPN 結(jié)構(gòu)基于雙向連接、多尺度特征融合、動(dòng)態(tài)權(quán)重分配和深度可擴(kuò)展性等特點(diǎn),有效地提升了目標(biāo)檢測(cè)模型的性能和表達(dá)能力。

4 實(shí)驗(yàn)與分析

4.1 實(shí)驗(yàn)環(huán)境

本實(shí)驗(yàn)配置環(huán)境為:臺(tái)式計(jì)算機(jī),C P U 采用Intel-core i9-9900k 處理器,顯卡采用NVIDIA GeForce GTX 2080ti,顯存為12 GB,內(nèi)存為32 GB,采用pytorch框架,編程語(yǔ)言使用python 3.6。

4.2 實(shí)驗(yàn)數(shù)據(jù)集處理

本實(shí)驗(yàn)采用自建數(shù)據(jù)集,數(shù)據(jù)集共包含圖片1 800張,包括不同遮擋情況、不同果實(shí)數(shù)量等的數(shù)據(jù)圖片,共計(jì)3 000個(gè)目標(biāo)。同時(shí),為了避免過(guò)擬合,保證網(wǎng)絡(luò)模型訓(xùn)練效果,在模型訓(xùn)練之前對(duì)數(shù)據(jù)集進(jìn)行圖像增強(qiáng),例如縮放、旋轉(zhuǎn)、調(diào)整對(duì)比度和飽和度等。

4.3 實(shí)驗(yàn)結(jié)果分析

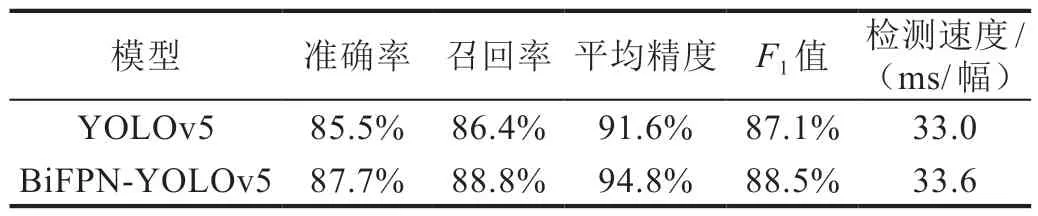

為了保持一致,使用YOLOv5 原網(wǎng)絡(luò)進(jìn)行相同的測(cè)試。選擇準(zhǔn)確率、召回率、平均精度、F1值和檢測(cè)速度作為模型性能評(píng)價(jià)指標(biāo),實(shí)驗(yàn)結(jié)果如表1所示。

表1 兩種算法的檢測(cè)效率對(duì)比

通過(guò)實(shí)驗(yàn)數(shù)據(jù)可以看出,改進(jìn)后的BiFPN-YOLOv5 模型同原始YOLOv5 模型對(duì)比,在準(zhǔn)確率上提高了2.2 個(gè)百分點(diǎn),召回率提高了2.4個(gè)百分點(diǎn),平均精度提高了3.2 個(gè)百分點(diǎn),但是訓(xùn)練時(shí)間增加了0.6 ms/幅,這是由BiFPN 的結(jié)構(gòu)引起的。實(shí)驗(yàn)結(jié)果表明:改進(jìn)后的模型提升了準(zhǔn)確率、召回率、平均精度和F1值,由此驗(yàn)證了改進(jìn)后的BiFPNYOLOv5模型具有一定的可行性。

5 結(jié)論

本文主要解決了果蔬采摘機(jī)器人在背景復(fù)雜且蘋(píng)果尺寸不一的情況下檢測(cè)準(zhǔn)確率低的問(wèn)題,使用BiFPN 特征網(wǎng)絡(luò)替換傳統(tǒng)YOLOv5 模型中的PANet特征網(wǎng)絡(luò),將淺層圖像特征層引入到金字塔圖像融合模塊中,改變?cè)W(wǎng)絡(luò)模型簡(jiǎn)單雙向特征的融合方式,提高了蘋(píng)果小目標(biāo)的檢測(cè)精度。在自建數(shù)據(jù)集上進(jìn)行實(shí)驗(yàn)驗(yàn)證,改進(jìn)后的模型提升了準(zhǔn)確率、召回率、平均精度和F1值,證明了改進(jìn)算法的有效性。