基于代理選舉的高效異構(gòu)聯(lián)邦學(xué)習(xí)方法

王光輝 白天水 丁爽 何欣

摘 要:物聯(lián)網(wǎng)多樣性終端設(shè)備在計(jì)算、存儲(chǔ)、通信方面的異構(gòu)性導(dǎo)致聯(lián)邦學(xué)習(xí)效率不足。針對上述聯(lián)邦訓(xùn)練過程中面臨的問題,基于代理選舉思路,提出了一種高效聯(lián)邦學(xué)習(xí)算法。設(shè)計(jì)了基于馬氏距離的代理節(jié)點(diǎn)選舉策略,將設(shè)備的計(jì)算能力與閑置時(shí)長作為選舉因素,選舉性價(jià)比高的設(shè)備作為代理節(jié)點(diǎn),充分發(fā)揮設(shè)備計(jì)算能力。進(jìn)一步設(shè)計(jì)了基于代理節(jié)點(diǎn)的新型云邊端聯(lián)邦學(xué)習(xí)架構(gòu),提升了異構(gòu)設(shè)備之間的聯(lián)邦學(xué)習(xí)效率。基于MNIST和CIFAR-10公開數(shù)據(jù)集與智能家居設(shè)備真實(shí)數(shù)據(jù)的實(shí)驗(yàn)表明,該聯(lián)邦學(xué)習(xí)方法的效率提高了22%。

關(guān)鍵詞:聯(lián)邦學(xué)習(xí);設(shè)備異構(gòu);代理選舉;云邊端;高效性

中圖分類號(hào):TP301?? 文獻(xiàn)標(biāo)志碼:A

文章編號(hào):1001-3695(2024)03-007-0688-06

doi:10.19734/j.issn.1001-3695.2023.06.0297

Efficient and heterogeneous federated learning based on agent election

Wang Guanghui1,2,Bai Tianshui1,Ding Shuang1,2,He Xin1,2

(1.School of Software,Henan University,Kaifeng Henan 475000,China;2.Henan International Joint Laboratory of Intelligent Network Theory & Key Technology,Kaifeng Henan 475000,China)

Abstract:The heterogeneity of diverse end devices in terms of computation,storage,and communication leads to insufficient accuracy and efficiency in federated learning.To address the issues faced in the aforementioned federated training process,this paper presented an efficient federated learning algorithm based on the idea of device agent election.To select agent nodes from diverse devices,it designed a device agent node election strategy based on Mahalanobis distance by considering the devices computational capabilities and idle time as election factors to fully leverage their computing power.Furthermore,it proposed a novel cloud-edge-end federated learning architecture using the agent node to improve the efficiency of federated learning between heterogeneous devices.Experimental results based on the MNIST and CIFAR-10 public datasets and the practical smart home datasets demonstrate that the proposed efficient federated learning algorithm achieves average improvement about 22% in learning efficiency.

Key words:federated learning;device heterogeneity;agent election;cloud-edge-end;efficiency

0 引言

人工智能作為物聯(lián)網(wǎng)技術(shù)的核心場景,正朝著為人們提供更加舒適、便捷服務(wù)的方向發(fā)展。物聯(lián)網(wǎng)終端設(shè)備分布在人們生活中的各個(gè)場景,同時(shí)伴隨著互聯(lián)網(wǎng)的發(fā)展逐漸升級為智能化[1]。為了向用戶提供更加智能化與更優(yōu)質(zhì)的服務(wù),設(shè)備廠商需要通過數(shù)字化設(shè)備產(chǎn)品收集人們的生活數(shù)據(jù)(如語音交互數(shù)據(jù)、電力使用數(shù)據(jù)、家庭情景模式等)以優(yōu)化服務(wù)模型。然而,這些生活數(shù)據(jù)對于用戶往往是私密的,所以智能用戶在享受優(yōu)化模型服務(wù)的同時(shí),也面臨著隱私數(shù)據(jù)泄露的風(fēng)險(xiǎn)[2]。

聯(lián)邦學(xué)習(xí)技術(shù)為解決設(shè)備場景中的數(shù)據(jù)隱私保護(hù)問題提供了新穎思路。聯(lián)邦學(xué)習(xí)利用原始數(shù)據(jù)集不出本地的模式保證數(shù)據(jù)隱私與安全。面向終端設(shè)備場景的聯(lián)邦學(xué)習(xí)算法讓模型的訓(xùn)練在設(shè)備端進(jìn)行,將得到的模型更新傳輸給服務(wù)器,從而進(jìn)行模型的下一步聚合。由于用戶的私密數(shù)據(jù)不出本地,既可以提供模型優(yōu)化服務(wù),又可以提升數(shù)據(jù)隱私與安全等級。

然而,設(shè)備場景中設(shè)備異構(gòu)性導(dǎo)致了聯(lián)邦學(xué)習(xí)效率方面的不足。設(shè)備產(chǎn)品數(shù)量與樣式不斷增加,導(dǎo)致設(shè)備節(jié)點(diǎn)計(jì)算能力與通信能力不一致,因此將聯(lián)邦學(xué)習(xí)思想應(yīng)用在終端設(shè)備之上,需要考慮如何提高訓(xùn)練模型的準(zhǔn)確率以及訓(xùn)練效率。在訓(xùn)練通信負(fù)載上,云端直接與設(shè)備產(chǎn)品通信,交換數(shù)據(jù)的方式會(huì)增加通信負(fù)載[3],降低訓(xùn)練效率。另一方面,智能設(shè)備種類與樣式層出不窮,智能設(shè)備的計(jì)算能力各不相同[4]。此外,無計(jì)算能力設(shè)備中的數(shù)據(jù)無法參與到整體模型訓(xùn)練,導(dǎo)致訓(xùn)練結(jié)果準(zhǔn)確率不足。

現(xiàn)有工作已經(jīng)關(guān)注到了異構(gòu)設(shè)備場景中的聯(lián)邦學(xué)習(xí)研究。例如:文獻(xiàn)[5]提出一種拓?fù)鋬?yōu)化方案,減少智能家居終端場景中低性能設(shè)備參與訓(xùn)練時(shí)拖慢整體訓(xùn)練效率問題;為了提高終端設(shè)備場景下的聯(lián)邦學(xué)習(xí)效率,Wu等人[6]提出在邊緣客戶端設(shè)備添加生成卷積自編碼器以降低通信成本;文獻(xiàn)[7]提出分層模型訓(xùn)練,并采用從多分支模型出發(fā)將全局統(tǒng)一模型拆分為適配不同客戶端資源的子模型序列,提高了客戶端參與度和資源利用效率。然而,針對真實(shí)設(shè)備的異構(gòu)性導(dǎo)致的聯(lián)邦學(xué)習(xí)效率不足問題,上述研究方案沒有充分考慮設(shè)備的不同計(jì)算能力,仍然需要進(jìn)一步完善。

由于設(shè)備間異構(gòu)性原因,終端設(shè)備種類和計(jì)算力參差不齊,比如設(shè)備間計(jì)算力不相同時(shí),在多個(gè)設(shè)備組成的集群中,訓(xùn)練效率往往由計(jì)算力最低的設(shè)備決定。所以為解決設(shè)備間異構(gòu)的情況,本文在終端設(shè)備組成的集群中選取一個(gè)代理設(shè)備,該代理設(shè)備擁有集群內(nèi)較高計(jì)算力,能夠通過自身計(jì)算力解決集群內(nèi)的任務(wù)下發(fā)、模型聚合等工作,減少設(shè)備異構(gòu)性導(dǎo)致訓(xùn)練低的問題,提高訓(xùn)練效率;同時(shí)在訓(xùn)練時(shí),代理設(shè)備能夠使當(dāng)前集群內(nèi)的終端設(shè)備先進(jìn)行集群內(nèi)訓(xùn)練,將已經(jīng)獲得較高準(zhǔn)確率的模型通過代理設(shè)備再與其他集群或者云端模型聚合,可以減少終端設(shè)備的訓(xùn)練壓力,并且通過代理設(shè)備,可以減少每個(gè)終端設(shè)備間交互過程,減少通信負(fù)載,最終提高整體訓(xùn)練效率。

本文從智能設(shè)備代理選舉的角度研究提升聯(lián)邦學(xué)習(xí)效率的新方法。首先,為了充分利用了異構(gòu)智能設(shè)備的不同計(jì)算能力,并且保障無算力節(jié)點(diǎn)參與聯(lián)邦學(xué)習(xí),將設(shè)備的計(jì)算能力與閑置時(shí)長作為選舉因素,并設(shè)定終端設(shè)備為集群場景進(jìn)行分組,從每個(gè)小組集群參與訓(xùn)練的設(shè)備中選舉代理節(jié)點(diǎn),在選舉算法上設(shè)計(jì)了基于馬氏距離的設(shè)備代理節(jié)點(diǎn)選舉策略,從多樣性智能設(shè)備中選舉代理節(jié)點(diǎn),選舉出的代理節(jié)點(diǎn)在計(jì)算能力等方面優(yōu)于其他普通設(shè)備,可以讓性能高的設(shè)備發(fā)揮作用,減少計(jì)算資源浪費(fèi),提高整體訓(xùn)練效率。其次,為了提升智能設(shè)備場景中聯(lián)邦學(xué)習(xí)效率,基于設(shè)備代理節(jié)點(diǎn),設(shè)計(jì)了一種新型的云邊端聯(lián)邦學(xué)習(xí)架構(gòu),借助區(qū)域基站和設(shè)備代理對學(xué)習(xí)訓(xùn)練進(jìn)行分級逐級聚合,減少了異構(gòu)性設(shè)備的通信與計(jì)算開銷。此外,設(shè)備代理節(jié)點(diǎn)可以收集無計(jì)算能力設(shè)備數(shù)據(jù),并將其數(shù)據(jù)進(jìn)行聚合,提升了模型訓(xùn)練的準(zhǔn)確性。本文的貢獻(xiàn)總結(jié)如下:

a)從設(shè)備代理節(jié)點(diǎn)選舉的角度,提出了一種基于代理選舉的高效聯(lián)邦學(xué)習(xí)算法(federated learning with agent election,F(xiàn)edAE),充分利用物聯(lián)網(wǎng)多樣性智能設(shè)備的計(jì)算能力,提升聯(lián)邦學(xué)習(xí)算法的效率。

b)設(shè)計(jì)了一種基于馬氏距離的設(shè)備代理節(jié)點(diǎn)選舉策略。設(shè)定以終端設(shè)備集群分組,從每個(gè)集群內(nèi)參與訓(xùn)練的終端設(shè)備中,根據(jù)設(shè)備的CPU、空閑時(shí)長數(shù)據(jù),利用馬氏距離計(jì)算設(shè)備的性能相似度表征設(shè)備的閑置計(jì)算能力,以進(jìn)行代理節(jié)點(diǎn)選舉。

c)基于MNIST公開數(shù)據(jù)集與智能家居設(shè)備的真實(shí)數(shù)據(jù),開展了對比實(shí)驗(yàn),驗(yàn)證了本文算法的有效性。

1 相關(guān)工作

數(shù)據(jù)隱私安全促使對聯(lián)邦學(xué)習(xí)的研究成為一個(gè)重要課題,并且也廣泛應(yīng)用于醫(yī)療、金融、交通、制造業(yè)和其他物聯(lián)網(wǎng)領(lǐng)域[8~17]。文獻(xiàn)[5]提出一種拓?fù)鋬?yōu)化方案以減少低性能設(shè)備參與訓(xùn)練時(shí)拖慢整體訓(xùn)練效率問題,但是在智能家居場景下未考慮沒有計(jì)算能力設(shè)備的情況;文獻(xiàn)[18~20]利用對樣本優(yōu)化算法和模型聚合過程選擇方法提出了谷歌聯(lián)邦學(xué)習(xí)。這些研究方法若應(yīng)用到智能設(shè)備場景下,由于終端設(shè)備數(shù)據(jù)較多,會(huì)增加設(shè)備參與訓(xùn)練的計(jì)算復(fù)雜度。

現(xiàn)有工作已經(jīng)對設(shè)備的異構(gòu)性進(jìn)行聯(lián)邦學(xué)習(xí)開展研究。Cui等人[21]提出利用聚類思想,探索出一種基于迭代自組織數(shù)據(jù)分析技術(shù)算法(ISODATA)的異構(gòu)感知客戶端調(diào)度策略,但是沒有考慮客戶端數(shù)據(jù)量的問題,若通過該算法統(tǒng)一調(diào)度客戶端,會(huì)使聯(lián)邦學(xué)習(xí)面臨效率問題。文獻(xiàn)[22]針對智能家居場景,分別提出解決復(fù)雜場景架構(gòu)、區(qū)塊鏈與聯(lián)邦學(xué)習(xí)結(jié)合保證數(shù)據(jù)隱私[23]、強(qiáng)化聯(lián)邦學(xué)習(xí)方法以及提高訓(xùn)練準(zhǔn)確性,但這些都沒有考慮在密集情況下的聯(lián)邦訓(xùn)練效率問題。為了提高智能設(shè)備場景下的聯(lián)邦學(xué)習(xí)效率,文獻(xiàn)[21,24~27]在設(shè)備參與聯(lián)邦學(xué)習(xí)時(shí)分別提出解決異構(gòu)設(shè)備影響訓(xùn)練效率或準(zhǔn)確率的方法,但是都沒考慮無計(jì)算能力設(shè)備如何處理的情況。Liu等人[28]為解決計(jì)算能力不一致的問題提出異構(gòu)模型融合機(jī)制(HFL)方法,根據(jù)計(jì)算能力不同設(shè)備訓(xùn)練不同模型的概念,但如果設(shè)備數(shù)量很大,需要的模型數(shù)量也很大,為最終模型聚合增加了壓力。所以對于密集智能設(shè)備環(huán)境和設(shè)備的多樣性等因素來講,仍然需要進(jìn)行相關(guān)研究。

除以上關(guān)于提高聯(lián)邦學(xué)習(xí)效率的相關(guān)研究外,也有基于云邊端在聯(lián)邦學(xué)習(xí)下提高學(xué)習(xí)效率的研究。文獻(xiàn)[29]提出基于云邊端的聯(lián)邦學(xué)習(xí),從實(shí)驗(yàn)結(jié)果可以明顯看出,該架構(gòu)下對于提升聯(lián)邦學(xué)習(xí)效率和準(zhǔn)確性有很大的幫助,但是未將模型分在每一層上進(jìn)行模型聚合和更新。而文獻(xiàn)[7]提出分層模型訓(xùn)練,并采用從多分支模型出發(fā)將全局統(tǒng)一模型拆分為適配不同客戶端資源的子模型序列,提高了客戶端參與度和資源利用效率。但是在多樣性智能設(shè)備場景下,復(fù)雜設(shè)備中將統(tǒng)一模型拆分會(huì)面臨很大的壓力。文獻(xiàn)[30]也采用云邊端分級模型訓(xùn)練和聚合,但是沒有考慮多樣性智能設(shè)備的場景。

綜上述所,本文提出了一種新型適應(yīng)多樣性智能設(shè)備場景下云邊端的架構(gòu)體系。一方面,利用設(shè)備地理位置優(yōu)勢,單個(gè)基站負(fù)責(zé)所屬設(shè)備區(qū)域單元,將模型進(jìn)行分壓訓(xùn)練聚合,減少通信負(fù)載壓力,提高整體聯(lián)邦學(xué)習(xí)效率;另一方面,在子端設(shè)定的設(shè)備代理可以充分利用閑置計(jì)算資源,提高學(xué)習(xí)效率,設(shè)備代理收集無計(jì)算能力設(shè)備的數(shù)據(jù),在解決計(jì)算力多樣化場景的同時(shí)提高最終訓(xùn)練的準(zhǔn)確性。

2 系統(tǒng)架構(gòu)和問題設(shè)置

2.1 聯(lián)邦學(xué)習(xí)架構(gòu)

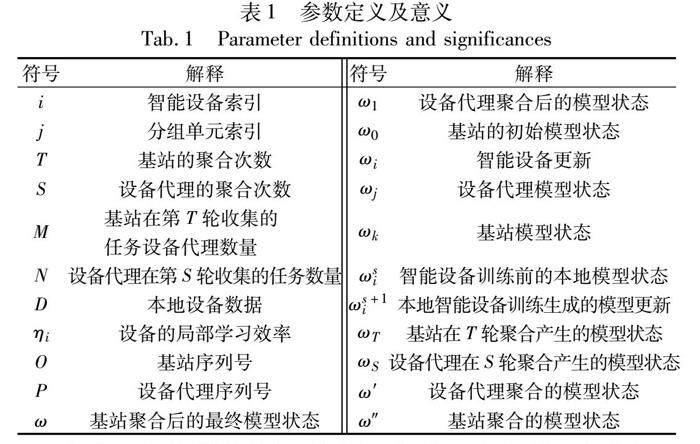

基于代理選舉的新型云邊端架構(gòu)闡述如下。該架構(gòu)屬于一種分布式邊緣計(jì)算解決架構(gòu),多個(gè)區(qū)域間利用多基站的位置分布,使集群中眾多數(shù)量的智能設(shè)備終端參與訓(xùn)練,并將最終模型進(jìn)行聚合與更新。在聚集的社區(qū)環(huán)境中,以終端設(shè)備集群為單位進(jìn)行分組,眾多設(shè)備所參與的訓(xùn)練任務(wù)由基站發(fā)布給設(shè)備代理。其次,任務(wù)通過設(shè)備代理傳遞給智能訓(xùn)練設(shè)備,并將本地更新平均聚合返回給基站。其中,每個(gè)設(shè)備代理是以設(shè)備小組為單位,通過自身設(shè)定值和小組其他組成訓(xùn)練設(shè)備空閑情況以決定此設(shè)備代理狀態(tài)是否參與任務(wù),并且根據(jù)參與者的自身計(jì)算能力通過選舉算法進(jìn)行選舉,成為設(shè)備代理。然后設(shè)備代理將初始模型和任務(wù)分發(fā)給小組內(nèi)其他設(shè)備,每個(gè)設(shè)備代理接收空閑智能設(shè)備本地更新內(nèi)容,最終聚合接收到的內(nèi)容模型平均值。最后設(shè)備代理將該模型更新返回給基站進(jìn)行二次聚合模型平均值,最終基站將聚合后的狀態(tài)傳遞給設(shè)備代理,由設(shè)備代理分發(fā)最終模型更新給智能設(shè)備。最終生成的模型狀態(tài)在基站之間共享。其中,定義ωi、ωj分別表示智能設(shè)備本地訓(xùn)練模型狀態(tài)和設(shè)備代理的模型更新狀態(tài),ωk(k=1,2,…,O)表示第k個(gè)基站的模型狀態(tài),O表示參與訓(xùn)練的基站的個(gè)數(shù)。本文中使用的主要符號(hào)及其解釋含義如表1所示。

該新型架構(gòu)的數(shù)據(jù)交互如圖1所示。其中,任務(wù)定義和決定由設(shè)備廠商或其他上層機(jī)構(gòu)確定。基站利用自身計(jì)算和通信等資源進(jìn)行臨時(shí)領(lǐng)導(dǎo)者選取,該領(lǐng)導(dǎo)者為參與的單元小組的設(shè)備代理建立索引,該索引表主要記錄參與訓(xùn)練的代理選舉的貢獻(xiàn)值,以便之后進(jìn)行相應(yīng)的獎(jiǎng)勵(lì)。單元小組局域網(wǎng)由智能設(shè)備客戶端組成,通過設(shè)備代理與其他客戶端進(jìn)行模型訓(xùn)練以更新聚合。架構(gòu)的整體流程描述如下:

a)任務(wù)分發(fā)。基站臨時(shí)領(lǐng)導(dǎo)者在確定任務(wù)之后,以廣播的方式發(fā)送給分組設(shè)備代理單元,并建立初始模型狀態(tài)ω0。設(shè)備代理在接收到基站發(fā)布的任務(wù)信息時(shí),設(shè)備代理單元根據(jù)自身的狀態(tài)值和獎(jiǎng)勵(lì)情況確定是否參與此次任務(wù)的訓(xùn)練。并且智能終端設(shè)備通過本身的閑置情況來決定是否參與設(shè)備代理的訓(xùn)練任務(wù),并將該決定返回給設(shè)備代理,與設(shè)備代理其他組成設(shè)備共同決定該集群內(nèi)設(shè)備代理的狀態(tài)值。參與的設(shè)備代理與相應(yīng)的基站建立通信連接,基站為其注冊到臨時(shí)索引表中。

b)本地訓(xùn)練。智能設(shè)備根據(jù)模型狀態(tài)和數(shù)據(jù)特征進(jìn)行本地?cái)?shù)據(jù)訓(xùn)練家居模型。擁有計(jì)算能力的設(shè)備自身進(jìn)行模型訓(xùn)練,無計(jì)算能力的傳感器數(shù)據(jù)將通過設(shè)備代理進(jìn)行收集,設(shè)備代理將這部分?jǐn)?shù)據(jù)與自身的本地?cái)?shù)據(jù)進(jìn)行訓(xùn)練。本地訓(xùn)練又分為單輪迭代和多輪迭代兩種方式,具體根據(jù)設(shè)備自身計(jì)算能力情況進(jìn)行選擇。多輪訓(xùn)練結(jié)果相比單論訓(xùn)練效果更好,但是時(shí)間花費(fèi)較大。最后每個(gè)設(shè)備將本地模型更新傳送給設(shè)備代理。

c)模型聚合。設(shè)備代理接收其他設(shè)備的本地更新之后,設(shè)備代理本身與其他設(shè)備進(jìn)行一次更新的平均匯總,將該聚合后的模型傳送給建立連接的基站,多個(gè)基站都接收到相應(yīng)的平均匯總,基站進(jìn)行二次模型聚合,并將該聚合狀態(tài)返回給參與的設(shè)備代理,設(shè)備代理再次分發(fā)給分組集群內(nèi)參與的其他終端設(shè)備。終端設(shè)備進(jìn)行新一輪的訓(xùn)練。多個(gè)基站之間共享模型狀態(tài)。

d)獎(jiǎng)勵(lì)機(jī)制。參與訓(xùn)練的設(shè)備代理免費(fèi)獲取模型狀態(tài),未參與的設(shè)備代理支付相應(yīng)的金額以獲取模型更新。這部分資金將用于獎(jiǎng)勵(lì)對模型更新付出巨大貢獻(xiàn)的集群設(shè)備代理參與者。

2.2 問題設(shè)置

本文旨在提出一種基于代理選舉的高效聯(lián)邦學(xué)習(xí)算法FedAE。基于上述新型聯(lián)邦學(xué)習(xí)架構(gòu),充分利用智能設(shè)備場景中多樣設(shè)備的計(jì)算能力,提升聯(lián)邦學(xué)習(xí)的精確性與效率。具體地,F(xiàn)edAE需要達(dá)到的目標(biāo)如下:

a)高效性。通過提出基于代理選舉的云邊端體系結(jié)構(gòu),充分利用空閑資源設(shè)備進(jìn)行分布式云邊端訓(xùn)練模型,提高聯(lián)邦學(xué)習(xí)效率。并提出基于架構(gòu)模型的設(shè)備代理FedAE算法,保證在設(shè)備密集和異構(gòu)場景下能夠進(jìn)行高效的聯(lián)邦訓(xùn)練。

b)隱私性。在終端設(shè)備集群為單元的網(wǎng)絡(luò)中,用戶數(shù)據(jù)始終不出集群內(nèi)部網(wǎng)絡(luò),只將集群內(nèi)設(shè)備訓(xùn)練后的模型更新傳送出去,極大地保護(hù)了智能設(shè)備中的數(shù)據(jù)。

c)準(zhǔn)確性。單個(gè)集群設(shè)備群的感知具有局限性,多個(gè)集群的模型進(jìn)行聚合得到的最后結(jié)果可以使單個(gè)設(shè)備具有更準(zhǔn)確的模型結(jié)果。并在集群內(nèi)指定設(shè)備代理,以適應(yīng)不具有計(jì)算力的設(shè)備參與訓(xùn)練的情況,提高模型結(jié)果的準(zhǔn)確性。

3 FedAE算法設(shè)計(jì)

3.1 算法基本思想

FedAE算法的設(shè)計(jì)主要針對密集居住社區(qū)環(huán)境中設(shè)備數(shù)量較多的場景,解決數(shù)據(jù)通信瓶頸,提高學(xué)習(xí)效率。在以終端設(shè)備集群為單位的設(shè)備組合中,以設(shè)備的計(jì)算能力以及每天的空閑時(shí)長兩個(gè)屬性為依據(jù),通過選舉算法計(jì)算每個(gè)設(shè)備的權(quán)重值,將權(quán)重值最大的設(shè)備設(shè)定為設(shè)備代理,之后通過閑置算力設(shè)備進(jìn)行本地訓(xùn)練和設(shè)備代理的模型聚合,最后在通信基站中進(jìn)行二次模型平均。在智能設(shè)備產(chǎn)品中,利用閑置算力訓(xùn)練本地?cái)?shù)據(jù),將模型更新上傳至設(shè)備代理。設(shè)備代理進(jìn)行單位內(nèi)的一次模型聚合平均,并與其他設(shè)備將該模型重復(fù)迭代。設(shè)備代理每次迭代過程中,將該輪的最新模型傳輸?shù)交局校具M(jìn)行二次模型的聚合平均。基站之間定期進(jìn)行模型共享,更新最新模型數(shù)據(jù),提高學(xué)習(xí)效率。與傳統(tǒng)FedSGD和FedAvg算法相比,F(xiàn)edAE能夠解決傳輸過程中數(shù)據(jù)量大的問題。

3.2 本地計(jì)算

設(shè)備通過當(dāng)前模型狀態(tài)和本地?cái)?shù)據(jù)進(jìn)行模型計(jì)算,當(dāng)f(ω)=1n∑ni=1fi(ω)時(shí),目標(biāo)函數(shù)f(ω)如式(1)所示,對于一般機(jī)器學(xué)習(xí)fi(ω)=l(xi,yi,ω)。其中:損失函數(shù)(xi,yi)由ω決定,表示預(yù)測局部數(shù)據(jù)的損失;D表示設(shè)備收集的本地?cái)?shù)據(jù)。

每個(gè)設(shè)備包括設(shè)備代理在內(nèi)的設(shè)備都以此進(jìn)行梯度下降訓(xùn)練,得到集群中最新模型數(shù)據(jù)。

3.3 設(shè)備代理選舉

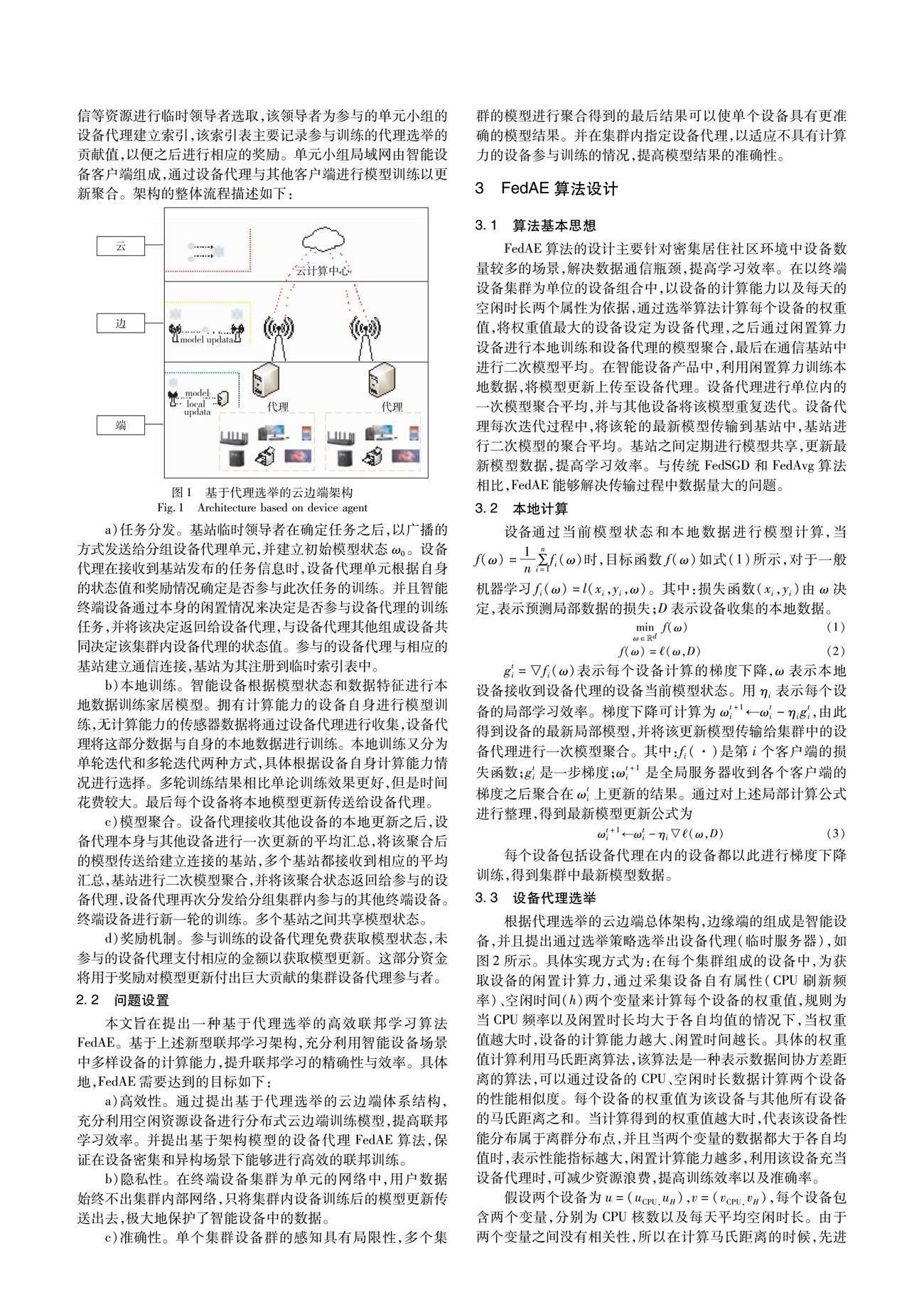

根據(jù)代理選舉的云邊端總體架構(gòu),邊緣端的組成是智能設(shè)備,并且提出通過選舉策略選舉出設(shè)備代理(臨時(shí)服務(wù)器),如圖2所示。具體實(shí)現(xiàn)方式為:在每個(gè)集群組成的設(shè)備中,為獲取設(shè)備的閑置計(jì)算力,通過采集設(shè)備自有屬性(CPU刷新頻率)、空閑時(shí)間(h)兩個(gè)變量來計(jì)算每個(gè)設(shè)備的權(quán)重值,規(guī)則為當(dāng)CPU頻率以及閑置時(shí)長均大于各自均值的情況下,當(dāng)權(quán)重值越大時(shí),設(shè)備的計(jì)算能力越大、閑置時(shí)間越長。

具體的權(quán)重值計(jì)算利用馬氏距離算法,該算法是一種表示數(shù)據(jù)間協(xié)方差距離的算法,可以通過設(shè)備的CPU、空閑時(shí)長數(shù)據(jù)計(jì)算兩個(gè)設(shè)備的性能相似度。每個(gè)設(shè)備的權(quán)重值為該設(shè)備與其他所有設(shè)備的馬氏距離之和。當(dāng)計(jì)算得到的權(quán)重值越大時(shí),代表該設(shè)備性能分布屬于離群分布點(diǎn),并且當(dāng)兩個(gè)變量的數(shù)據(jù)都大于各自均值時(shí),表示性能指標(biāo)越大,閑置計(jì)算能力越多,利用該設(shè)備充當(dāng)設(shè)備代理時(shí),可減少資源浪費(fèi),提高訓(xùn)練效率以及準(zhǔn)確率。

假設(shè)兩個(gè)設(shè)備為u=(uCPU,uH),v=(vCPU,vH),每個(gè)設(shè)備包含兩個(gè)變量,分別為CPU核數(shù)以及每天平均空閑時(shí)長。由于兩個(gè)變量之間沒有相關(guān)性,所以在計(jì)算馬氏距離的時(shí)候,先進(jìn)行坐標(biāo)旋轉(zhuǎn),也可稱作主成分分析,坐標(biāo)旋轉(zhuǎn)時(shí)將原始坐標(biāo)點(diǎn)通過一個(gè)正交矩陣旋轉(zhuǎn)到新的坐標(biāo)中,最后馬氏距離的計(jì)算可以等價(jià)于點(diǎn)u壓縮后的坐標(biāo)值到數(shù)據(jù)重心v壓縮后的坐標(biāo)值的歐氏距離計(jì)算。所以u與v的協(xié)方差計(jì)算公式為

3.4 模型聚合

本地更新第一次聚合,通過設(shè)備代理進(jìn)行集群內(nèi)的一次積累本地更新,并且設(shè)備代理平均該積累后的模型如式(7)所示。每個(gè)設(shè)備代理循環(huán)迭代出一個(gè)最新模型。

ωs= ∑Ni=1ωiN(7)

底層集群設(shè)備代理之間聚合模型。設(shè)備代理間經(jīng)過通信定期共享模型狀態(tài),設(shè)備代理再次聚合獲得訓(xùn)練狀態(tài)ω′。

ω′ = ∑Pj=1ωjP(8)

同樣地,通信基站中進(jìn)行二次更新聚合。基站積累設(shè)備代理傳入的最新結(jié)果模型并且第二次平均積累后的設(shè)備代理更新,同樣,基站迭代平均設(shè)備代理的模型結(jié)果如式(9)所示。

ωT= ∑Mj=1ωjM(9)

高層聚合模型狀態(tài)。與設(shè)備代理一樣,基站定期共享最新模型狀態(tài),聚合最終模型更新,如式(10)所示。

ω″=∑Ok=1ωkO(10)

算法1給出了FedAE相應(yīng)的偽代碼。在數(shù)據(jù)量巨大的情況下,該算法應(yīng)用代理選舉的云邊端架構(gòu),利用閑置設(shè)備計(jì)算時(shí)間,提高該模型的學(xué)習(xí)效率。數(shù)據(jù)在設(shè)備產(chǎn)品本地進(jìn)行計(jì)算,通過設(shè)備代理和基站兩次模型平均聚合以提高學(xué)習(xí)效率。

算法1 基于云邊端的設(shè)備代理選舉聯(lián)邦學(xué)習(xí)

輸入:MINST數(shù)據(jù)集;初始模型ω0;基站數(shù)量O;基站迭代次數(shù)M;終端設(shè)備數(shù)量P;終端設(shè)備迭代次數(shù)N;學(xué)習(xí)效率ηi;用于代理設(shè)備選舉的計(jì)算屬性u與空閑時(shí)長v。

輸出:最終全局模型。

云端服務(wù)器將訓(xùn)練任務(wù)下發(fā),并下發(fā)初始模型ω0

4 實(shí)驗(yàn)評估

4.1 實(shí)驗(yàn)設(shè)置

本文為驗(yàn)證FedAE算法的有效性,采用實(shí)驗(yàn)環(huán)境為:CPU為Intel Core i7-1165G7 @2.80 GHz、GPU為NVIDIA GeForce MX450、RAM為16 GB的配置機(jī)器上運(yùn)行實(shí)驗(yàn)流程,軟件環(huán)境信息為Python 3.9。

采用公開數(shù)據(jù)集MNIST進(jìn)行驗(yàn)證,該數(shù)據(jù)集含有6 000張訓(xùn)練圖像數(shù)據(jù)用于輸入聯(lián)邦訓(xùn)練實(shí)驗(yàn),并且設(shè)定該實(shí)驗(yàn)的參與設(shè)備不存在惡意節(jié)點(diǎn)。根據(jù)算法1設(shè)計(jì)2個(gè)云端,2個(gè)邊緣基站,通過總數(shù)為50、100、200個(gè)設(shè)備分別驗(yàn)證。在集群分組上,以家庭為集群進(jìn)行分組,其中設(shè)定每個(gè)家庭集群擁有5個(gè)終端設(shè)備,當(dāng)進(jìn)行本地訓(xùn)練時(shí),每次迭代時(shí)間為0.5 s,基本通信耗時(shí)常量0.02 s;選舉由設(shè)備在家庭集群節(jié)點(diǎn)內(nèi)完成本地訓(xùn)練以及在家庭集群設(shè)備代理上完成模型聚合的任務(wù)。

根據(jù)實(shí)驗(yàn)算法,在該實(shí)驗(yàn)中區(qū)分設(shè)備代理與其他設(shè)備,通過增加本地迭代次數(shù)表示家庭設(shè)備代理收集并訓(xùn)練傳感器設(shè)備數(shù)據(jù)來表示設(shè)備代理角色;然后將多個(gè)設(shè)備代理訓(xùn)練好的模型更新再次與基站通信,進(jìn)行模型平均,完成第二次的訓(xùn)練;最終由多個(gè)基站的模型更新在云端進(jìn)行模型的聚合,完成整個(gè)訓(xùn)練流程,得到最終訓(xùn)練結(jié)果。

實(shí)驗(yàn)對比方案包括經(jīng)典聯(lián)邦學(xué)習(xí)算法的FedSGD、FedAvg以及基于異構(gòu)分層聯(lián)邦訓(xùn)練算法[7]。在實(shí)驗(yàn)中,為了表現(xiàn)選舉算法的有效性,將隨機(jī)指定代理選舉的FedAE-Random算法參與對比。隨機(jī)指定設(shè)備代理算法在實(shí)驗(yàn)中只在家庭單元中進(jìn)行聚合過程,沒有收集傳感器設(shè)備數(shù)據(jù)參與到訓(xùn)練過程。最終實(shí)驗(yàn)通過在參與客戶端迭代輪次為200時(shí)的情況下,將每次訓(xùn)練后的準(zhǔn)確率進(jìn)行記錄。

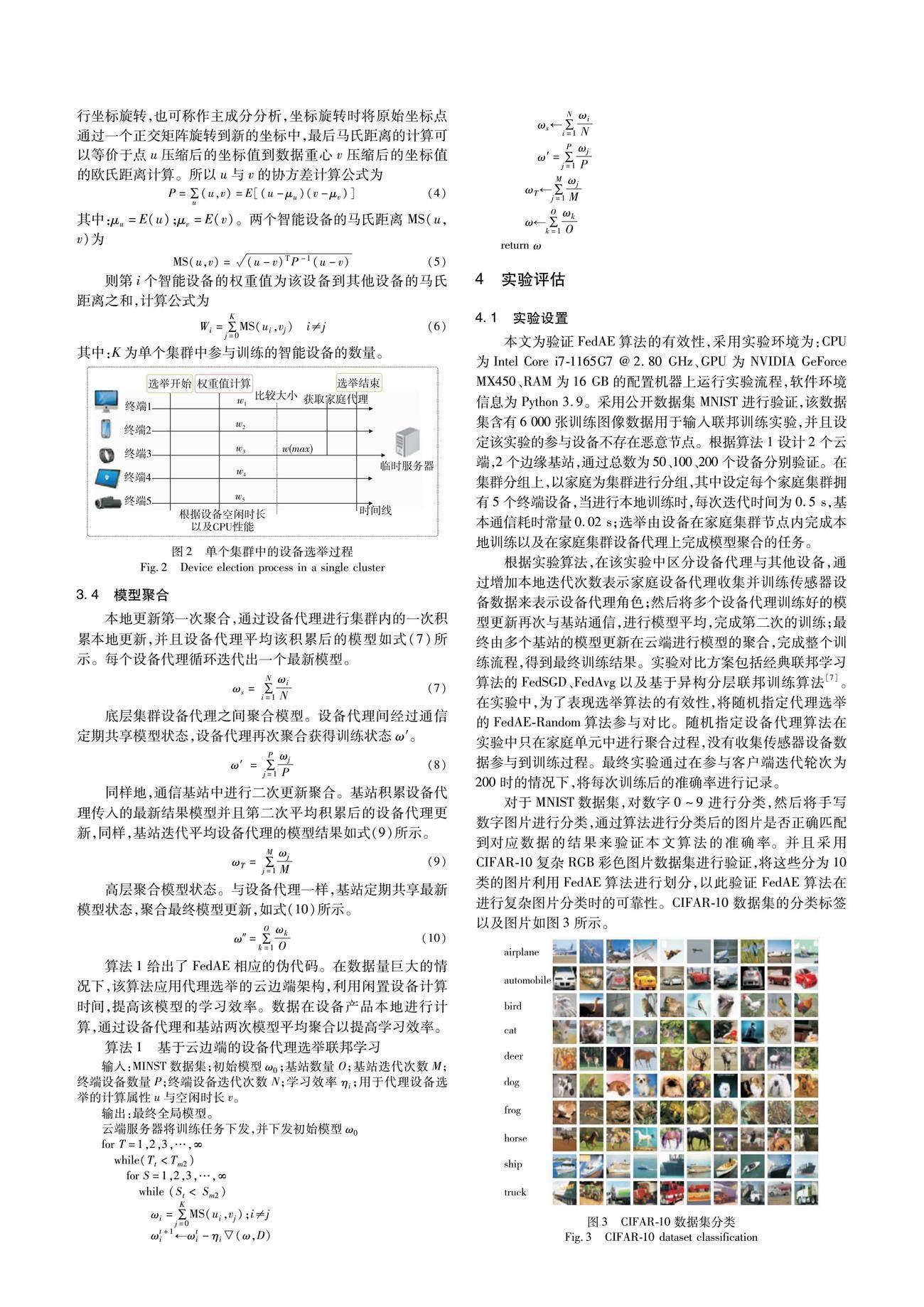

對于MNIST數(shù)據(jù)集,對數(shù)字0~9進(jìn)行分類,然后將手寫數(shù)字圖片進(jìn)行分類,通過算法進(jìn)行分類后的圖片是否正確匹配到對應(yīng)數(shù)據(jù)的結(jié)果來驗(yàn)證本文算法的準(zhǔn)確率。并且采用CIFAR-10復(fù)雜RGB彩色圖片數(shù)據(jù)集進(jìn)行驗(yàn)證,將這些分為10類的圖片利用FedAE算法進(jìn)行劃分,以此驗(yàn)證FedAE算法在進(jìn)行復(fù)雜圖片分類時(shí)的可靠性。CIFAR-10數(shù)據(jù)集的分類標(biāo)簽以及圖片如圖3所示。

4.2 設(shè)備代理設(shè)置

引入選舉策略,通過選舉后的設(shè)備代理用于訓(xùn)練過程并與其他算法對比。根據(jù)智能家居真實(shí)場景下常用的智能設(shè)備,假設(shè)定義五種設(shè)備,通過調(diào)查以及統(tǒng)計(jì)方法得到對應(yīng)的CPU刷新頻率和設(shè)備每天平均空閑時(shí)長,真實(shí)統(tǒng)計(jì)信息如表2所示。

通過權(quán)重式(6),計(jì)算出各個(gè)智能設(shè)備的權(quán)重值如表3所示。由此得出,在單元家庭中設(shè)定電腦PC為設(shè)備代理,在每個(gè)家庭分組中將采集到?jīng)]有計(jì)算能力的設(shè)備數(shù)據(jù)在電腦PC上進(jìn)行本地訓(xùn)練,并與其他設(shè)備進(jìn)行更新聚合,最終將訓(xùn)練后的結(jié)果與邊緣基站通信參與到云邊端的架構(gòu)中。

4.3 實(shí)驗(yàn)結(jié)果

在不同參與客戶設(shè)備規(guī)模下,利用訓(xùn)練數(shù)據(jù)集訓(xùn)練后的模型將測試數(shù)據(jù)集的圖片進(jìn)行分類。例如對于MNIST數(shù)據(jù)集,輸入一張手寫圖片,對比結(jié)果是否匹配到對應(yīng)的標(biāo)簽下;對于CIFAR-10數(shù)據(jù)集,輸入包含車輛的彩色圖片,對比結(jié)果是否匹配到車輛標(biāo)簽中,以此對比算法的有效性,并分別統(tǒng)計(jì)FedAE算法與對比算法的準(zhǔn)確率、效率以及隱私結(jié)果,分析FedAE在各個(gè)方面對比其他算法表現(xiàn)的差異。

在MNIST數(shù)據(jù)集上驗(yàn)證訓(xùn)練結(jié)果的準(zhǔn)確性,通過不同規(guī)模的客戶端參與量進(jìn)行對比,結(jié)果如圖4~6所示。由圖4~6可以看出,對應(yīng)的幾種算法所表現(xiàn)的趨勢是一致的,但訓(xùn)練的準(zhǔn)確率在參與迭代次數(shù)的縱向上來看并不相同。在不同參與規(guī)模下,準(zhǔn)確率均趨于收斂,但對比FedAvg與其他分層算法,F(xiàn)edAvg與FedAvg-Random算法的實(shí)驗(yàn)準(zhǔn)確率在訓(xùn)練200輪后依然分別平均提高了4‰和5‰,表現(xiàn)優(yōu)于對比算法。對比分層異構(gòu)聯(lián)邦訓(xùn)練結(jié)果,F(xiàn)edAE更能反映當(dāng)在云邊端的架構(gòu)中引入設(shè)備代理參與訓(xùn)練后的優(yōu)越性,表現(xiàn)出FedAE算法在解決異構(gòu)環(huán)境下充分利用對端的計(jì)算能力,提高模型訓(xùn)練的整體準(zhǔn)確率。并由此可以得到,在訓(xùn)練結(jié)果達(dá)到同一準(zhǔn)確率的同時(shí),F(xiàn)edAE算法所需的訓(xùn)練輪次少于其他算法,說明了FedAE算法的高效性。此外,對比FedAE與FedAE-Random,采用選舉后的算法訓(xùn)練后的準(zhǔn)確率高于之前隨機(jī)指定的設(shè)備代理,并且在通信輪次達(dá)到200時(shí),選舉后的算法依然高于選舉前2‰,結(jié)果表明通過設(shè)備的自有屬性計(jì)算出的權(quán)重值可以提高訓(xùn)練效率。

當(dāng)采用更復(fù)雜的數(shù)據(jù)集CIFAR-10驗(yàn)證訓(xùn)練結(jié)果的準(zhǔn)確性時(shí),在客戶端數(shù)量為100,通信為100輪,其他條件不變的情況下,驗(yàn)證FedAE算法在復(fù)雜數(shù)據(jù)集上的表現(xiàn),將每10輪準(zhǔn)確率取平均值繪出折線圖,可更直觀地看出每種算法的訓(xùn)練趨勢,結(jié)果如圖7所示。由圖7可以看出,在訓(xùn)練輪次相同的情況下,F(xiàn)edAE算法優(yōu)于其他算法。在每輪評估準(zhǔn)確率的時(shí)候都會(huì)有很大的波動(dòng),這是由于為設(shè)置設(shè)定的學(xué)習(xí)率引起的,過小的學(xué)習(xí)率會(huì)導(dǎo)致收斂速度很慢,所以為適應(yīng)FedAE算法,將學(xué)習(xí)率設(shè)定為0.01;FedAvg和分層算法在模型更新的時(shí)候由于收斂速度過大,導(dǎo)致錯(cuò)過最好的點(diǎn),會(huì)出現(xiàn)了圖上的交叉點(diǎn)。從圖7可以看出,相較于其他算法,F(xiàn)edAE算法在整體上準(zhǔn)確率都處于領(lǐng)先地位。由此,通過在兩個(gè)數(shù)據(jù)集上的實(shí)驗(yàn)驗(yàn)證了FedAE算法的有效性。由實(shí)驗(yàn)結(jié)果圖4~7并通過分析可知,每輪訓(xùn)練結(jié)果的準(zhǔn)確率提升平均在7‰,這是由于聯(lián)邦訓(xùn)練算法的訓(xùn)練結(jié)果的準(zhǔn)確率都趨于平穩(wěn)且趨于收斂。通過分析前200輪的結(jié)果,對比其他算法,本文提出的FedHA算法在達(dá)到相同準(zhǔn)確率的情況下,所需的訓(xùn)練輪次更少,由此驗(yàn)證了FedHA的高效性。

此外,本文還通過計(jì)算訓(xùn)練消耗時(shí)長驗(yàn)證了評估算法的高效性,實(shí)驗(yàn)結(jié)果如圖8所示。通過模擬設(shè)備訓(xùn)練場景,在參與客戶端進(jìn)行訓(xùn)練時(shí),將FedAE與FedAvg和異構(gòu)分層聯(lián)邦算法在達(dá)到一定準(zhǔn)確率時(shí)的時(shí)長消耗作對比。在訓(xùn)練結(jié)果準(zhǔn)確率達(dá)到90%時(shí),F(xiàn)edAE與FedAvg以及對比實(shí)驗(yàn)在效率上分別提高了25.7%和18.3%,而異構(gòu)分層聯(lián)邦算法并不能很好地適應(yīng)密集環(huán)境下的多樣性設(shè)備場景。可見相較于其他算法,本文算法在訓(xùn)練過程中時(shí)間消耗更短,訓(xùn)練效率更高。由此表明通過引入家庭設(shè)備代理,進(jìn)而充分利用家庭設(shè)備計(jì)算力,可提高整體訓(xùn)練效率。

在聯(lián)邦訓(xùn)練過程中,對于數(shù)據(jù)隱私保護(hù)效果如圖9所示。由于運(yùn)用數(shù)據(jù)不出設(shè)備本地的聯(lián)邦訓(xùn)練思想,所以FedAE算法在FedAvg算法的基礎(chǔ)上進(jìn)行了修改,進(jìn)而使隱私保護(hù)結(jié)果與FedSGD與FedAvg算法表現(xiàn)一致。隨著參與訓(xùn)練設(shè)備的增加,隱私保護(hù)效果也在不斷增加。在參與訓(xùn)練的智能設(shè)備較少時(shí),根據(jù)文獻(xiàn)[32]可知,數(shù)據(jù)隱私會(huì)存在對應(yīng)的泄露風(fēng)險(xiǎn)。當(dāng)參與訓(xùn)練的設(shè)備不斷增加之后,數(shù)據(jù)安全性也得到提高,最終會(huì)隨著參與設(shè)備數(shù)量的增加接近沒有數(shù)據(jù)從本地傳輸出去的情況,如圖中綠色線條所示(見電子版)。

通過對算法實(shí)驗(yàn)結(jié)果在各個(gè)方面的對比,對于準(zhǔn)確率的實(shí)驗(yàn),現(xiàn)有算法在訓(xùn)練達(dá)到一定輪次時(shí),準(zhǔn)確率會(huì)趨于穩(wěn)定。本文通過分析前200輪訓(xùn)練的結(jié)果可知,在保證數(shù)據(jù)隱私安全的情況下,在訓(xùn)練初始階段,本文算法在達(dá)到與其他算法相同準(zhǔn)確率時(shí),所需訓(xùn)練輪次更少,并且耗時(shí)最短,所以本文算法在訓(xùn)練效率上有所提高。

5 結(jié)束語

聯(lián)邦學(xué)習(xí)是智能設(shè)備領(lǐng)域中重要的數(shù)據(jù)隱私保護(hù)計(jì)算技術(shù)。智能設(shè)備異構(gòu)場景中存在多種多樣的終端設(shè)備,導(dǎo)致了聯(lián)邦學(xué)習(xí)客戶端的異構(gòu)性,影響了聯(lián)邦學(xué)習(xí)的精確性與效率。本文提出從設(shè)備中選舉代理節(jié)點(diǎn)的思路,研究提升聯(lián)邦學(xué)習(xí)效率與精確性的新方法,設(shè)計(jì)了一種基于代理選舉的高效聯(lián)邦學(xué)習(xí)算法FedAE。首先,設(shè)計(jì)了一種基于馬氏距離的設(shè)備代理節(jié)點(diǎn)選舉策略,從多樣性的智能設(shè)備中選出設(shè)備代理節(jié)點(diǎn),充分利用設(shè)備的計(jì)算能力;其次,本文設(shè)計(jì)了一種基于設(shè)備代理選舉的新型云邊端學(xué)習(xí)架構(gòu),將設(shè)備本地?cái)?shù)據(jù)進(jìn)行分級迭代聚合,減少了通信壓力,提高了聯(lián)邦學(xué)習(xí)效率。通過設(shè)備代理節(jié)點(diǎn)可以收集無計(jì)算能力設(shè)備的數(shù)據(jù)進(jìn)行模型聚合,提高了聯(lián)邦學(xué)習(xí)的精確性。基于MNIST和CIFAR-10公開數(shù)據(jù)集以及智能設(shè)備的真實(shí)數(shù)據(jù)進(jìn)行仿真實(shí)驗(yàn),相比于現(xiàn)有方案,本文提出的高效聯(lián)邦學(xué)習(xí)算法在準(zhǔn)確率和學(xué)習(xí)效率方面具有優(yōu)勢。

參考文獻(xiàn):

[1]Razmjoo A,Gandomi A,Mahlooji M,et al.An investigation of the policies and crucial sectors of smart cities based on IoT application[J].Applied Sciences,2022,12(5):2672.

[2]張文平.大數(shù)據(jù)背景下的物聯(lián)網(wǎng)智能家居研究[J].電子元器件與信息技術(shù),2022,6(1):85-86.(Zhang Wenping.Research on IoT smart homes in the context of big data[J].Electronic Components and Information Technology,2022,6(1):85-86.)

[3]Lee S,Choi D H.Federated reinforcement learning for energy management of multiple smart homes with distributed energy resources[J].IEEE Trans on Industrial Informatics,2020,18(1):488-497.

[4]Aivodji U M,Gambs S,Martin A.IOTFLA:a secured and privacy-preserving smart home architecture implementing federated learning[C]//Proc of IEEE Security and Privacy Workshops.Piscataway,NJ:IEEE Press,2019:175-180.

[5]Huang Shanfeng,Zhang Zezhong,Wang Shuai,et al.Accelerating federated edge learning via topology optimization[J].IEEE Internet of Things Journal,2023,10(3):2056-2070.

[6]Wu Qiong,Chen Xu,Zhou Zhi,et al.FedHome:cloud-edge based personalized federated learning for in-home health monitoring[J].IEEE Trans on Mobile Computing,2022,21(8):2818-2832.

[7]鐘正儀,包衛(wèi)東,王吉,等.一種面向云邊端系統(tǒng)的分層異構(gòu)聯(lián)邦學(xué)習(xí)方法[J].計(jì)算機(jī)研究與發(fā)展,2022,59(11):2408-2422.(Zhong Zhengyi,Bao Weidong,Wang Ji,et al.A hierarchical heterogeneous federated learning method for cloud edge systems[J].Computer Research and Development,2022,59(11):2408-2422.)

[8]Hegiste V,Legler T,Ruskowski M.Application of federated machine learning in manufacturing [C]//Proc of International Conference on Industry 4.0 Technology.Piscataway,NJ:IEEE Press,2022:1-8.

[9]Wu Guangjun,Wang Shupeng,Ning Zhaolong.Blockchain-enabled privacy-preserving access control for data publishing and sharing in the Internet of Medical Things[J].IEEE Internet of Things Journal,2021,9(11):8091-8104.

[10]Zhang Chi,Liu Yu,Wang Le,et al.Joint intelligence ranking by fede-rated multiplicative update[J].IEEE Intelligent Systems,2020,35(4):15-24.

[11]Pokhrel S R,Choi J.Federated learning with blockchain for autonomous vehicles:analysis and design[J].IEEE Trans on Communications,2020,68(8):4734-4746.

[12]Elbir A M,Soner B,Coleri S,et al.Federated learning in vehicular networks[C]//Proc of IEEE International Mediterranean Conference on Communications and Networking.Piscataway,NJ:IEEE Press,2022:72-77.

[13]Sabuj S R,Elaharief M,Jo H S.A partial federated learning model in cognitive UAV-enabled edge computing networks[C]//Proc of the 13th International Conference on Information and Communication Technology Convergence.Piscataway,NJ:IEEE Press,2022:1437-1440.

[14]Ying Chenchao,Jin Haiming,Wang Xudong,et al.Double insurance:incentivized federated learning with differential privacy in mobile crowdsensing[C]//Proc of International Symposium on Reliable Distributed Systems.Piscataway,NJ:IEEE Press,2020:81-90.

[15]Putjorn P.Designing augmented learning platform with IoT and Chatbot-based learning technology for primary school students in northern Thailand[C]//Proc of the 6th International Conference on Information Technology.Piscataway,NJ:IEEE Press,2022:275-279.

[16]Saranya M,Amutha B,Niranjana T.AI buildings:design of artificially intelligent buildings in the energy sector with an autonomous federated learning approach[C]//Proc of the 6th International Conference on ISMAC.Piscataway,NJ:IEEE Press,2022:686-694.

[17]Su Zhou,Wang Yuntao,Luan T H,et al.Secure and efficient federated learning for smart grid with edge-cloud collaboration[J].IEEE Trans on Industrial Informatics,2021,18(2):1333-134.

[18]Ye Dongdong,Yu Rong,Pan Miao,et al.Federated learning in vehicular edge computing:a selective model aggregation approach[J].IEEE Access,2020,8:23920-23935.

[19]Cai Lingshuang,Lin Di,Zhang Jiale,et al.Dynamic sample selection for federated learning with heterogeneous data in fog computing[C]//Proc of IEEE International Conference on Communications.Pisca-taway,NJ:IEEE Press,2020:1-6.

[20]Cao Jiayu,Zhang Ke,Wu Fan,et al.Learning cooperation schemes for mobile edge computing empowered Internet of Vehicles[C]//Proc of IEEE Wireless Communications and Networking Conference.Pisca-taway,NJ:IEEE Press,2020:1-6.

[21]Cui Yangguang,Cao Kun,Cao Guitao,et al.Client scheduling and resource management for efficient training in heterogeneous IoT-edge federated learning[J].IEEE Trans on Computer-Aided Design of Integrated Circuits and Systems,2021,41(8):2407-2420.

[22]Yu Tianlong,Li Tian,Sun Yuqiong,et al.Learning context-aware policies from multiple smart homes via federated multi-task learning[C]//Proc of the 5th International Conference on Internet-of-Things Design and Implementation.Piscataway,NJ:IEEE Press,2020:104-115.

[23]Zhao Yang,Zhao Jun,Jiang Linshan,et al.Privacy-preserving blockchain-based federated learning for IoT devices[J].IEEE Internet of Things Journal,2020,8(3):1817-1829.

[24]Wang K I K,Ye Xiaozhou,Sakurai K,et al.Federated learning with clustering-based participant selection for IoT applications[C]//Proc of IEEE International Conference on Big Data.Piscataway,NJ:IEEE Press,2022:6830-6831.

[25]Zhang Tao,Song Anxiao,Dong Xuewen,et al.Privacy-preserving asynchronous grouped federated learning for IoT[J].IEEE Internet of Things Journal,2021,9(7):5511-5523.

[26]Salh A,Ngah R,Audah L,et al.Energy-efficient federated learning with resource allocation for green IoT edge intelligence in B5G[J].IEEE Access,2023,11:16353-16367.

[27]Lu Xiaofeng,Liao Yuying,Liu Chao,et al.Heterogeneous model fusion federated learning mechanism based on model mapping[J].IEEE Internet of Things Journal,2021,9(8):6058-6068.

[28]Liu Lumin,Zhang Jun,Song S H,et al.Client-edge-cloud hierarchical federated learning[C]//Proc of IEEE International Conference on Communications.Piscataway,NJ:IEEE Press,2020:1-6.

[29]路松峰,屠向陽,周軍龍,等.云邊端協(xié)同的增量聯(lián)邦學(xué)習(xí)算法[J].華中科技大學(xué)學(xué)報(bào):自然科學(xué)版,2023,51(10):12-18.(Lu Songfeng,Tu Xiangyang,Zhou Junlong,et al.Incremental federated learning algorithm for cloud-edge-device collaboration[J].Journal of Huazhong University of Science and Technology:Natural Science Edition,2023,51(10):12-18.)

[30]Zhu Ligeng,Liu Zhijian,Han Song.Deep leakage from gradients[C]//Proc of the 33rd International Conference on Neural Information Processing Systems.Red Hook,NY:Curran Associates Inc.,2019:14774-14784.