基于動(dòng)態(tài)頻域分解的樂隊(duì)指揮動(dòng)作生成

賀鑫 劉凡 陳德龍 周睿志

摘 要:

近年來,音樂與人體動(dòng)作之間的內(nèi)在關(guān)聯(lián)一直以來都在被廣泛研究。然而,很少有人關(guān)注音樂驅(qū)動(dòng)的樂隊(duì)指揮動(dòng)作生成這一任務(wù),即以音樂為輸入信號,生成與音樂節(jié)奏和語義相協(xié)調(diào)的樂隊(duì)指揮動(dòng)作。聚焦于這一任務(wù),針對指揮動(dòng)作多種語義成分時(shí)空重合的特性,提出基于動(dòng)作動(dòng)態(tài)頻域分解(dynamic frequency-domain motion decomposition,DFMD)的指揮動(dòng)作生成方法。具體地,首先利用節(jié)拍信息構(gòu)建濾波器,將指揮動(dòng)作分解成高頻和低頻分量;接著,通過深度卷積神經(jīng)網(wǎng)絡(luò)動(dòng)態(tài)地學(xué)習(xí)這些分量;最后合成最終的指揮動(dòng)作。在大規(guī)模指揮動(dòng)作數(shù)據(jù)集ConductorMotion100上進(jìn)行的實(shí)驗(yàn)中,基于DFMD的指揮動(dòng)作生成方法得到的低頻動(dòng)作分量和高頻動(dòng)作分量的標(biāo)準(zhǔn)差分別達(dá)到了4.457 9和9.646 6,與真實(shí)動(dòng)作十分接近。該方法突破了現(xiàn)有基于時(shí)域或空間域動(dòng)作分解中連貫性與協(xié)調(diào)性不可兼得的局限,并有效避免了大幅值低頻動(dòng)作對小幅值高頻動(dòng)作的影響。可視化結(jié)果證明生成的動(dòng)作自然、美觀、多樣,且與音樂信號緊密同步。為音樂與動(dòng)作之間的關(guān)聯(lián)提供了新的解釋,并為音樂表演領(lǐng)域帶來了創(chuàng)新的應(yīng)用前景。

關(guān)鍵詞:跨模態(tài)生成;人體動(dòng)作生成;頻域分解;動(dòng)作分解;音樂驅(qū)動(dòng)生成

中圖分類號:TP391.4?? 文獻(xiàn)標(biāo)志碼:A??? 文章編號:1001-3695(2024)03-042-0923-05doi: 10.19734/j.issn.1001-3695.2023.07.0321

Conducting motion generation based on dynamic frequency domain decomposition

He Xin, Liu Fan, Chen Delong, Zhou Ruizhi

(School of Computer & Information, Hohai University, Nanjing 210098, China)

Abstract:

In recent years, the intrinsic relationship between music and motions have been widely studied. However, very few efforts have been made to develop music-driven conducting motion generation models, which takes music as input signal to generate conducting motion in harmony with music rhythm and semantics. This paper proposed a music-driven conducting motion generation approach based on DFMD. Specifically, firstly it constructed a filter using the beat information to decompose the command action into high and low frequency components. Then, a deep convolutional neural network dynamically learnt these components, and it synthesized the final command action. Experimental results on the large-scale ConductorMotion100 dataset show that the standard deviation of the generated low-frequency and high-frequency motion components is 4.457 9 and 9.646 6, which are very close to the real motions. The proposed method breaks through the limitations of coherence and coordination in time-domain or spatial-domain motion decomposition, and effectively avoids the influence of large-value low-frequency motion on small-value high-frequency motion. The visualized results show that the generated movements are natural, beautiful, diverse, and closely synchronize with the music signal. It provides a new understanding of the connection between music and movement, and brings innovative application prospects to the field of musical performance. Key words:cross-model generation; human motion generation; frequency domain decomposition; motion decomposition; music-driven generation

0 引言

指揮是交響樂團(tuán)的靈魂。自中世紀(jì)歐洲教堂唱詩班到二十一世紀(jì)的現(xiàn)代音樂,指揮技術(shù)與藝術(shù)不斷發(fā)展,已經(jīng)成為一門內(nèi)容豐富的學(xué)科[1]。指揮的肢體語言復(fù)雜多變[2],需要在樂團(tuán)演奏時(shí)實(shí)時(shí)地傳達(dá)節(jié)拍、力度、情感、演奏法等多種信息[3],同時(shí)保持一定的風(fēng)格與美感。近年來,隨著深度學(xué)習(xí)算法理論的發(fā)展與計(jì)算性能的飛速提升,人工智能領(lǐng)域的學(xué)者已經(jīng)成功地對多種人類藝術(shù)進(jìn)行建模與學(xué)習(xí)。深度學(xué)習(xí)已經(jīng)能生成包括詩歌藝術(shù)、繪畫藝術(shù)、音樂藝術(shù)、舞蹈藝術(shù)在內(nèi)的多種人類藝術(shù)形式。

然而,學(xué)界對于指揮藝術(shù)的建模研究還比較初步,且主要面向判別類的任務(wù),如節(jié)拍跟蹤、拍式識別、演奏法識別、情感識別等。生成式任務(wù),即音樂驅(qū)動(dòng)的指揮動(dòng)作生成任務(wù),指的是以音樂為條件控制信號,生成與之節(jié)奏同步且語義相關(guān)的指揮動(dòng)作,而這部分的相關(guān)研究工作開展比較少。Wang等人[4]在2003年提出了首個(gè)指揮動(dòng)作生成方法。隨后,幾種基于規(guī)則的生成方法[5~7]陸續(xù)被提出,但這些方法無法靈活地學(xué)習(xí)真實(shí)指揮動(dòng)作的內(nèi)在規(guī)律,導(dǎo)致生成動(dòng)作重復(fù)性強(qiáng)、多樣性差。目前,在各種生成任務(wù)中廣泛成功的深度學(xué)習(xí)方法尚未被應(yīng)用至音樂驅(qū)動(dòng)的指揮動(dòng)作生成任務(wù)上。

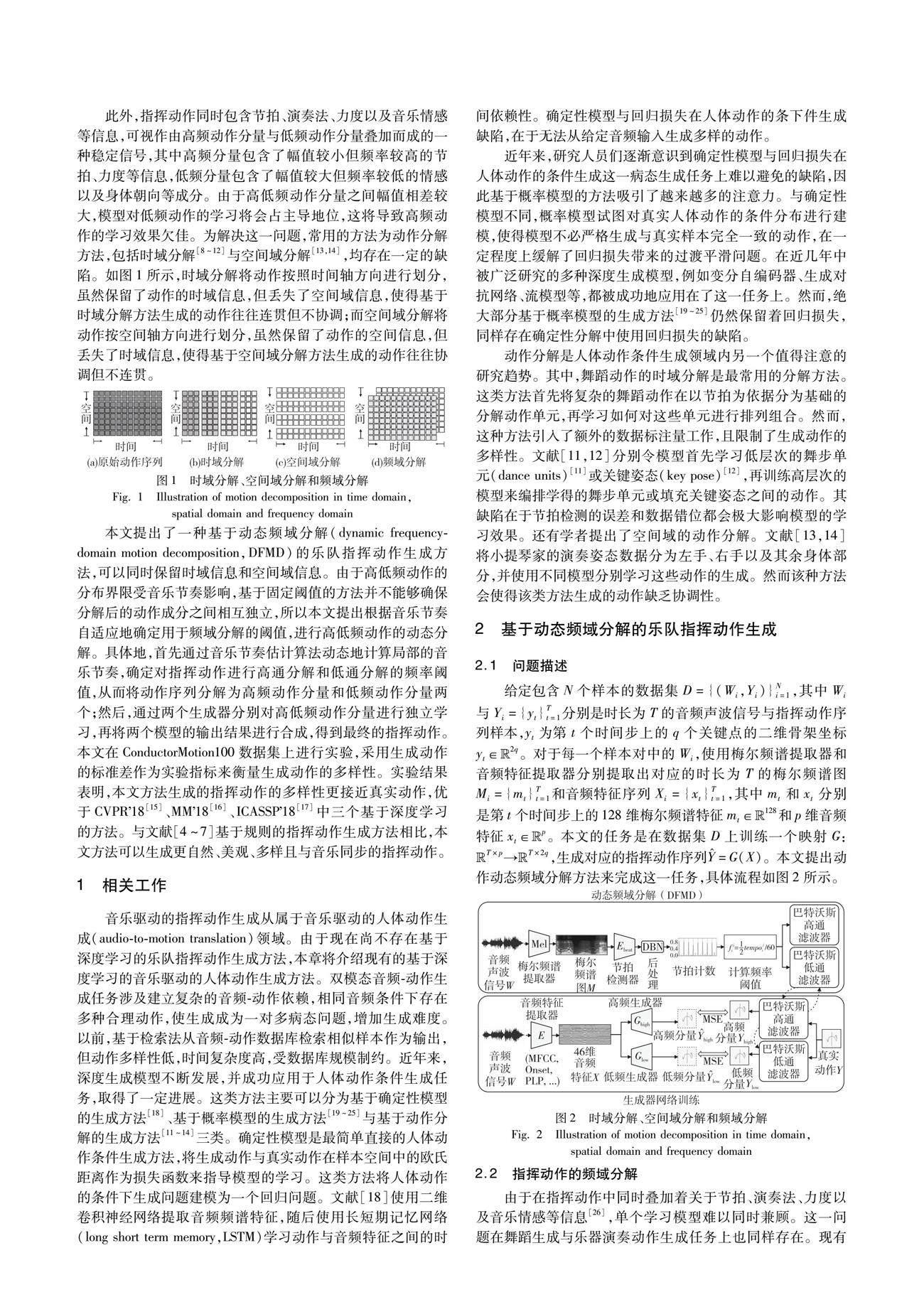

此外,指揮動(dòng)作同時(shí)包含節(jié)拍、演奏法、力度以及音樂情感等信息,可視作由高頻動(dòng)作分量與低頻動(dòng)作分量疊加而成的一種穩(wěn)定信號,其中高頻分量包含了幅值較小但頻率較高的節(jié)拍、力度等信息,低頻分量包含了幅值較大但頻率較低的情感以及身體朝向等成分。由于高低頻動(dòng)作分量之間幅值相差較大,模型對低頻動(dòng)作的學(xué)習(xí)將會占主導(dǎo)地位,這將導(dǎo)致高頻動(dòng)作的學(xué)習(xí)效果欠佳。為解決這一問題,常用的方法為動(dòng)作分解方法,包括時(shí)域分解[8~12]與空間域分解[13,14],均存在一定的缺陷。如圖1所示,時(shí)域分解將動(dòng)作按照時(shí)間軸方向進(jìn)行劃分,雖然保留了動(dòng)作的時(shí)域信息,但丟失了空間域信息,使得基于時(shí)域分解方法生成的動(dòng)作往往連貫但不協(xié)調(diào);而空間域分解將動(dòng)作按空間軸方向進(jìn)行劃分,雖然保留了動(dòng)作的空間信息,但丟失了時(shí)域信息,使得基于空間域分解方法生成的動(dòng)作往往協(xié)調(diào)但不連貫。

本文提出了一種基于動(dòng)態(tài)頻域分解(dynamic frequency-domain motion decomposition,DFMD)的樂隊(duì)指揮動(dòng)作生成方法,可以同時(shí)保留時(shí)域信息和空間域信息。由于高低頻動(dòng)作的分布界限受音樂節(jié)奏影響,基于固定閾值的方法并不能夠確保分解后的動(dòng)作成分之間相互獨(dú)立,所以本文提出根據(jù)音樂節(jié)奏自適應(yīng)地確定用于頻域分解的閾值,進(jìn)行高低頻動(dòng)作的動(dòng)態(tài)分解。具體地,首先通過音樂節(jié)奏估計(jì)算法動(dòng)態(tài)地計(jì)算局部的音樂節(jié)奏,確定對指揮動(dòng)作進(jìn)行高通分解和低通分解的頻率閾值,從而將動(dòng)作序列分解為高頻動(dòng)作分量和低頻動(dòng)作分量兩個(gè);然后,通過兩個(gè)生成器分別對高低頻動(dòng)作分量進(jìn)行獨(dú)立學(xué)習(xí),再將兩個(gè)模型的輸出結(jié)果進(jìn)行合成,得到最終的指揮動(dòng)作。本文在ConductorMotion100數(shù)據(jù)集上進(jìn)行實(shí)驗(yàn),采用生成動(dòng)作的標(biāo)準(zhǔn)差作為實(shí)驗(yàn)指標(biāo)來衡量生成動(dòng)作的多樣性。實(shí)驗(yàn)結(jié)果表明,本文方法生成的指揮動(dòng)作的多樣性更接近真實(shí)動(dòng)作,優(yōu)于CVPR18[15]、MM18[16]、ICASSP18[17]中三個(gè)基于深度學(xué)習(xí)的方法。與文獻(xiàn)[4~7]基于規(guī)則的指揮動(dòng)作生成方法相比,本文方法可以生成更自然、美觀、多樣且與音樂同步的指揮動(dòng)作。

1 相關(guān)工作

音樂驅(qū)動(dòng)的指揮動(dòng)作生成從屬于音樂驅(qū)動(dòng)的人體動(dòng)作生成(audio-to-motion translation)領(lǐng)域。由于現(xiàn)在尚不存在基于深度學(xué)習(xí)的樂隊(duì)指揮動(dòng)作生成方法,本章將介紹現(xiàn)有的基于深度學(xué)習(xí)的音樂驅(qū)動(dòng)的人體動(dòng)作生成方法。雙模態(tài)音頻-動(dòng)作生成任務(wù)涉及建立復(fù)雜的音頻-動(dòng)作依賴,相同音頻條件下存在多種合理動(dòng)作,使生成成為一對多病態(tài)問題,增加生成難度。以前,基于檢索法從音頻-動(dòng)作數(shù)據(jù)庫檢索相似樣本作為輸出,但動(dòng)作多樣性低,時(shí)間復(fù)雜度高,受數(shù)據(jù)庫規(guī)模制約。近年來,深度生成模型不斷發(fā)展,并成功應(yīng)用于人體動(dòng)作條件生成任務(wù),取得了一定進(jìn)展。這類方法主要可以分為基于確定性模型的生成方法[18]、基于概率模型的生成方法[19~25]與基于動(dòng)作分解的生成方法[11~14]三類。

確定性模型是最簡單直接的人體動(dòng)作條件生成方法,將生成動(dòng)作與真實(shí)動(dòng)作在樣本空間中的歐氏距離作為損失函數(shù)來指導(dǎo)模型的學(xué)習(xí)。這類方法將人體動(dòng)作的條件下生成問題建模為一個(gè)回歸問題。文獻(xiàn)[18]使用二維卷積神經(jīng)網(wǎng)絡(luò)提取音頻頻譜特征,隨后使用長短期記憶網(wǎng)絡(luò)(long short term memory,LSTM)學(xué)習(xí)動(dòng)作與音頻特征之間的時(shí)間依賴性。確定性模型與回歸損失在人體動(dòng)作的條下件生成缺陷,在于無法從給定音頻輸入生成多樣的動(dòng)作。

近年來,研究人員們逐漸意識到確定性模型與回歸損失在人體動(dòng)作的條件生成這一病態(tài)生成任務(wù)上難以避免的缺陷,因此基于概率模型的方法吸引了越來越多的注意力。與確定性模型不同,概率模型試圖對真實(shí)人體動(dòng)作的條件分布進(jìn)行建模,使得模型不必嚴(yán)格生成與真實(shí)樣本完全一致的動(dòng)作,在一定程度上緩解了回歸損失帶來的過渡平滑問題。在近幾年中被廣泛研究的多種深度生成模型,例如變分自編碼器、生成對抗網(wǎng)絡(luò)、流模型等,都被成功地應(yīng)用在了這一任務(wù)上。然而,絕大部分基于概率模型的生成方法[19~25]仍然保留著回歸損失,同樣存在確定性分解中使用回歸損失的缺陷。

動(dòng)作分解是人體動(dòng)作條件生成領(lǐng)域內(nèi)另一個(gè)值得注意的研究趨勢。其中,舞蹈動(dòng)作的時(shí)域分解是最常用的分解方法。這類方法首先將復(fù)雜的舞蹈動(dòng)作在以節(jié)拍為依據(jù)分為基礎(chǔ)的分解動(dòng)作單元,再學(xué)習(xí)如何對這些單元進(jìn)行排列組合。然而,這種方法引入了額外的數(shù)據(jù)標(biāo)注量工作,且限制了生成動(dòng)作的多樣性。文獻(xiàn)[11,12]分別令模型首先學(xué)習(xí)低層次的舞步單元(dance units)[11]或關(guān)鍵姿態(tài)(key pose)[12],再訓(xùn)練高層次的模型來編排學(xué)得的舞步單元或填充關(guān)鍵姿態(tài)之間的動(dòng)作。其缺陷在于節(jié)拍檢測的誤差和數(shù)據(jù)錯(cuò)位都會極大影響模型的學(xué)習(xí)效果。還有學(xué)者提出了空間域的動(dòng)作分解。文獻(xiàn)[13,14]將小提琴家的演奏姿態(tài)數(shù)據(jù)分為左手、右手以及其余身體部分,并使用不同模型分別學(xué)習(xí)這些動(dòng)作的生成。然而該種方法會使得該類方法生成的動(dòng)作缺乏協(xié)調(diào)性。

2.5 網(wǎng)絡(luò)結(jié)構(gòu)

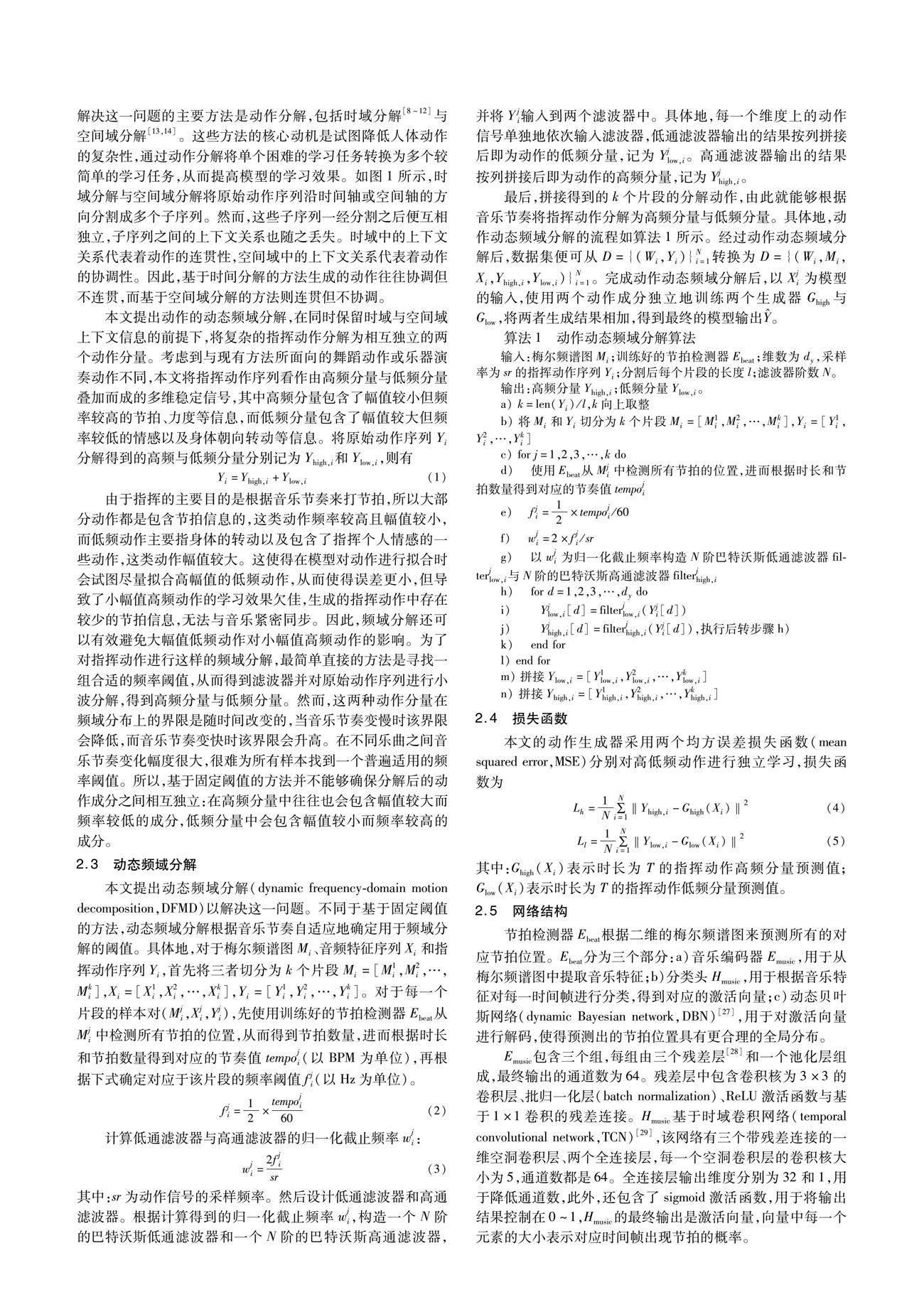

節(jié)拍檢測器Ebeat根據(jù)二維的梅爾頻譜圖來預(yù)測所有的對應(yīng)節(jié)拍位置。Ebeat分為三個(gè)部分:a)音樂編碼器Emusic,用于從梅爾頻譜圖中提取音樂特征;b)分類頭Hmusic,用于根據(jù)音樂特征對每一時(shí)間幀進(jìn)行分類,得到對應(yīng)的激活向量;c)動(dòng)態(tài)貝葉斯網(wǎng)絡(luò)(dynamic Bayesian network,DBN)[27],用于對激活向量進(jìn)行解碼,使得預(yù)測出的節(jié)拍位置具有更合理的全局分布。

Emusic包含三個(gè)組,每組由三個(gè)殘差層[28]和一個(gè)池化層組成,最終輸出的通道數(shù)為64。殘差層中包含卷積核為3×3的卷積層、批歸一化層(batch normalization)、ReLU激活函數(shù)與基于1×1卷積的殘差連接。

Hmusic基于時(shí)域卷積網(wǎng)絡(luò)(temporal convolutional network,TCN)[29],該網(wǎng)絡(luò)有三個(gè)帶殘差連接的一維空洞卷積層、兩個(gè)全連接層,每一個(gè)空洞卷積層的卷積核大小為5,通道數(shù)都是64。全連接層輸出維度分別為32和1,用于降低通道數(shù),此外,還包含了sigmoid激活函數(shù),用于將輸出結(jié)果控制在0~1,Hmusic的最終輸出是激活向量,向量中每一個(gè)元素的大小表示對應(yīng)時(shí)間幀出現(xiàn)節(jié)拍的概率。

動(dòng)作生成器G也基于時(shí)域卷積網(wǎng)絡(luò),該網(wǎng)絡(luò)有5個(gè)一維空洞卷積層和殘差塊。每一層的卷積核大小為5,由于每一個(gè)時(shí)間步長的輸入是一個(gè)46維的音樂特征向量,第一層有46個(gè)通道,其他層通道數(shù)都是64。

由于最初的TCN是為預(yù)測類任務(wù)而設(shè)計(jì)的,所以它采用的是因果卷積。為了學(xué)習(xí)雙向依賴,本文將其改為了非因果卷積。由于動(dòng)作數(shù)據(jù)已歸一化,本文使用tanh作為最后一層的激活函數(shù),其他層的激活函數(shù)為ReLU。

3 實(shí)驗(yàn)

3.1 數(shù)據(jù)準(zhǔn)備

本文采用ConductorMotion100[30]數(shù)據(jù)集進(jìn)行實(shí)驗(yàn)。ConductorMotion100數(shù)據(jù)集中的每一個(gè)樣本對為60 s的音頻聲波信號—指揮動(dòng)作序列樣本對,總時(shí)長為100 h,采樣率為30 fps。其中,指揮動(dòng)作序列Yi在每一個(gè)時(shí)間步為一個(gè)20維特征向量,對應(yīng)于姿態(tài)序列中頭頂、鼻子、頸部、雙肩、雙肘、雙手、臀部這10個(gè)指揮動(dòng)作關(guān)鍵點(diǎn)的二維坐標(biāo)。

首先使用梅爾頻譜提取器和音頻特征提取器分別提取每一個(gè)樣本對中Wi對應(yīng)的梅爾頻譜圖Mi和音頻特征序列Xi。其中,Mi在每一個(gè)時(shí)間步上的特征是一個(gè)128維的梅爾頻譜特征向量(Mel bank features),為128個(gè)頻帶的輸入表示,由于只包含梅爾頻譜特征,梅爾頻譜圖的歸一化處理是對整體進(jìn)行的;Xi在每一時(shí)間步上的音頻特征是一個(gè)46維特征向量,包括1維的頻譜質(zhì)心(spectral centroid)、1維的觸發(fā)音力度(onset strength)、1維的主要局部脈沖(predominant local pulse,PLP)、20維梅爾頻率倒譜系數(shù)(Mel frequency cepstral coefficients,MFCC),以及以上23維特征的一階差分,與梅爾頻譜圖不同,音頻特征的每一維獨(dú)立地進(jìn)行歸一化處理。

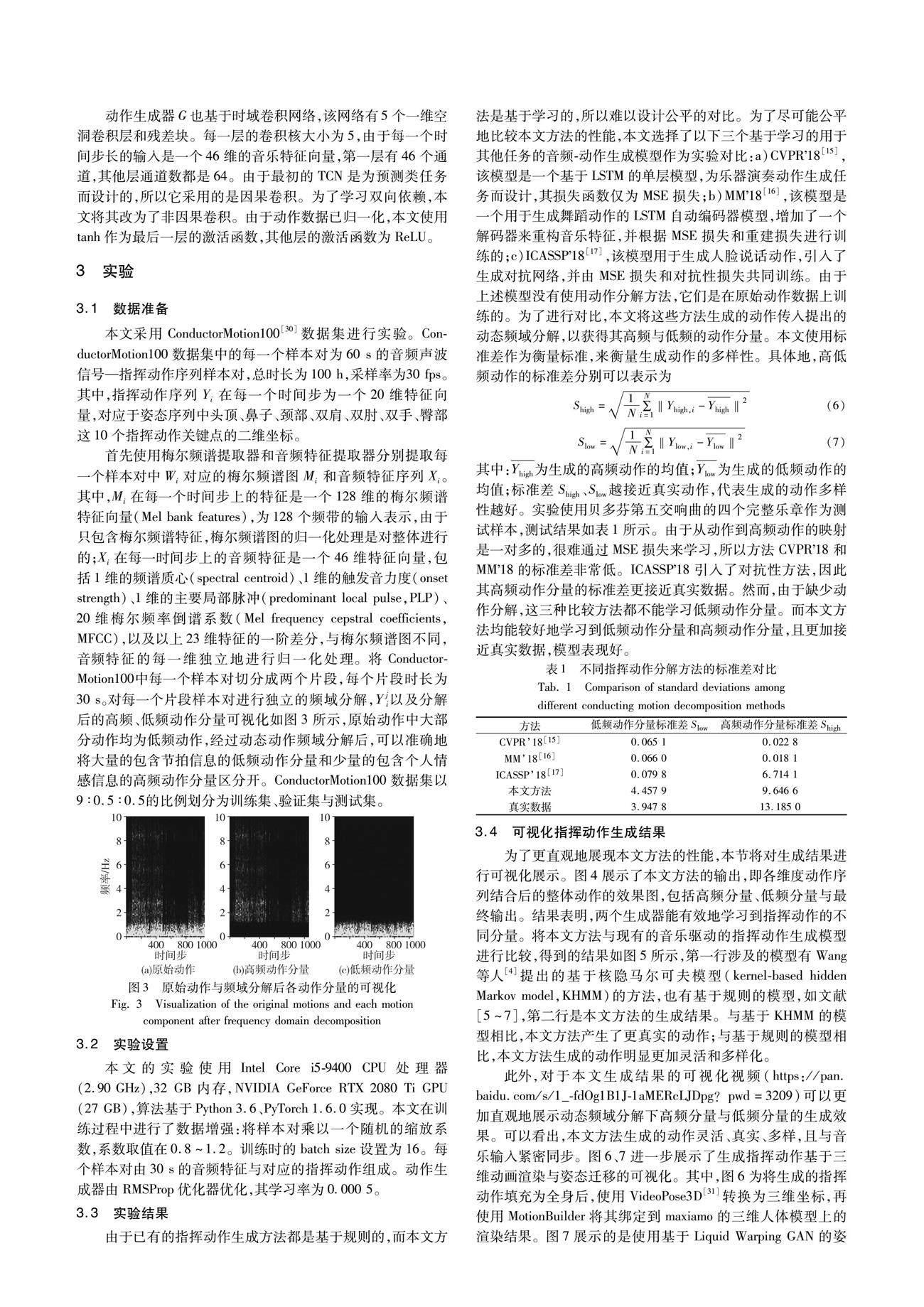

將Conductor-Motion100中每一個(gè)樣本對切分成兩個(gè)片段,每個(gè)片段時(shí)長為30 s。對每一個(gè)片段樣本對進(jìn)行獨(dú)立的頻域分解,Yji以及分解后的高頻、低頻動(dòng)作分量可視化如圖3所示,原始動(dòng)作中大部分動(dòng)作均為低頻動(dòng)作,經(jīng)過動(dòng)態(tài)動(dòng)作頻域分解后,可以準(zhǔn)確地將大量的包含節(jié)拍信息的低頻動(dòng)作分量和少量的包含個(gè)人情感信息的高頻動(dòng)作分量區(qū)分開。

ConductorMotion100數(shù)據(jù)集以9∶0.5∶0.5的比例劃分為訓(xùn)練集、驗(yàn)證集與測試集。

3.2 實(shí)驗(yàn)設(shè)置

本文的實(shí)驗(yàn)使用Intel Core i5-9400 CPU處理器(2.90 GHz),32 GB內(nèi)存,NVIDIA GeForce RTX 2080 Ti GPU (27 GB),算法基于Python 3.6、PyTorch 1.6.0實(shí)現(xiàn)。

本文在訓(xùn)練過程中進(jìn)行了數(shù)據(jù)增強(qiáng):將樣本對乘以一個(gè)隨機(jī)的縮放系數(shù),系數(shù)取值在0.8~1.2。訓(xùn)練時(shí)的batch size設(shè)置為16。每個(gè)樣本對由30 s的音頻特征與對應(yīng)的指揮動(dòng)作組成。動(dòng)作生成器由RMSProp優(yōu)化器優(yōu)化,其學(xué)習(xí)率為0.000 5。

3.3 實(shí)驗(yàn)結(jié)果

由于已有的指揮動(dòng)作生成方法都是基于規(guī)則的,而本文方法是基于學(xué)習(xí)的,所以難以設(shè)計(jì)公平的對比。為了盡可能公平地比較本文方法的性能,本文選擇了以下三個(gè)基于學(xué)習(xí)的用于其他任務(wù)的音頻-動(dòng)作生成模型作為實(shí)驗(yàn)對比:

a)CVPR18[15],該模型是一個(gè)基于LSTM的單層模型,為樂器演奏動(dòng)作生成任務(wù)而設(shè)計(jì),其損失函數(shù)僅為MSE損失;

b)MM18[16],該模型是一個(gè)用于生成舞蹈動(dòng)作的LSTM自動(dòng)編碼器模型,增加了一個(gè)解碼器來重構(gòu)音樂特征,并根據(jù)MSE損失和重建損失進(jìn)行訓(xùn)練的;

c)ICASSP18[17],該模型用于生成人臉說話動(dòng)作,引入了生成對抗網(wǎng)絡(luò),并由MSE損失和對抗性損失共同訓(xùn)練。

由于上述模型沒有使用動(dòng)作分解方法,它們是在原始動(dòng)作數(shù)據(jù)上訓(xùn)練的。為了進(jìn)行對比,本文將這些方法生成的動(dòng)作傳入提出的動(dòng)態(tài)頻域分解,以獲得其高頻與低頻的動(dòng)作分量。本文使用標(biāo)準(zhǔn)差作為衡量標(biāo)準(zhǔn),來衡量生成動(dòng)作的多樣性。具體地,高低頻動(dòng)作的標(biāo)準(zhǔn)差分別可以表示為

其中:Yhigh為生成的高頻動(dòng)作的均值;Ylow為生成的低頻動(dòng)作的均值;標(biāo)準(zhǔn)差Shigh、Slow越接近真實(shí)動(dòng)作,代表生成的動(dòng)作多樣性越好。

實(shí)驗(yàn)使用貝多芬第五交響曲的四個(gè)完整樂章作為測試樣本,測試結(jié)果如表1所示。由于從動(dòng)作到高頻動(dòng)作的映射是一對多的,很難通過MSE損失來學(xué)習(xí),所以方法CVPR18和MM18的標(biāo)準(zhǔn)差非常低。ICASSP18引入了對抗性方法,因此其高頻動(dòng)作分量的標(biāo)準(zhǔn)差更接近真實(shí)數(shù)據(jù)。然而,由于缺少動(dòng)作分解,這三種比較方法都不能學(xué)習(xí)低頻動(dòng)作分量。而本文方法均能較好地學(xué)習(xí)到低頻動(dòng)作分量和高頻動(dòng)作分量,且更加接近真實(shí)數(shù)據(jù),模型表現(xiàn)好。

3.4 可視化指揮動(dòng)作生成結(jié)果

為了更直觀地展現(xiàn)本文方法的性能,本節(jié)將對生成結(jié)果進(jìn)行可視化展示。圖4展示了本文方法的輸出,即各維度動(dòng)作序列結(jié)合后的整體動(dòng)作的效果圖,包括高頻分量、低頻分量與最終輸出。結(jié)果表明,兩個(gè)生成器能有效地學(xué)習(xí)到指揮動(dòng)作的不同分量。

將本文方法與現(xiàn)有的音樂驅(qū)動(dòng)的指揮動(dòng)作生成模型進(jìn)行比較,得到的結(jié)果如圖5所示,第一行涉及的模型有Wang等人[4]提出的基于核隱馬爾可夫模型(kernel-based hidden Markov model,KHMM)的方法,也有基于規(guī)則的模型,如文獻(xiàn)[5~7],第二行是本文方法的生成結(jié)果。與基于KHMM的模型相比,本文方法產(chǎn)生了更真實(shí)的動(dòng)作;與基于規(guī)則的模型相比,本文方法生成的動(dòng)作明顯更加靈活和多樣化。

此外,對于本文生成結(jié)果的可視化視頻(https://pan.baidu.com/s/1_-fdOg1B1J-1aMERcLJDpg?pwd=3209)可以更加直觀地展示動(dòng)態(tài)頻域分解下高頻分量與低頻分量的生成效果。可以看出,本文方法生成的動(dòng)作靈活、真實(shí)、多樣,且與音樂輸入緊密同步。

圖6、7進(jìn)一步展示了生成指揮動(dòng)作基于三維動(dòng)畫渲染與姿態(tài)遷移的可視化。其中,圖6為將生成的指揮動(dòng)作填充為全身后,使用VideoPose3D[31]轉(zhuǎn)換為三維坐標(biāo),再使用MotionBuilder將其綁定到maxiamo的三維人體模型上的渲染結(jié)果。圖7展示的是使用基于Liquid Warping GAN的姿態(tài)遷移方法[32],將生成的指揮動(dòng)作遷移至給定圖像上的效果。

4 結(jié)束語

本文提出了基于動(dòng)態(tài)頻域分解的指揮動(dòng)作生成方法,相較于現(xiàn)有傳統(tǒng)方法,本文方法可以生成更加自然、美觀、多樣,且與音樂同步的指揮動(dòng)作,突破了現(xiàn)有動(dòng)作分解方法中連貫性與協(xié)調(diào)性不可兼得的局限。本文提出的動(dòng)作動(dòng)態(tài)頻域分解以音樂節(jié)奏為依據(jù),將動(dòng)作分解為高頻分量與低頻分量,顯著降低了學(xué)習(xí)難度。未來的研究工作將考慮進(jìn)一步拓寬本文提出的基于動(dòng)態(tài)頻域分解的樂隊(duì)指揮動(dòng)作生成方法的應(yīng)用,在舞蹈生成、說話姿勢生成等任務(wù)上驗(yàn)證本文方法的可行性。

參考文獻(xiàn):

[1]李嚴(yán)君. 樂隊(duì)指揮及中西方指揮形式研究[J]. 北方音樂,2020,9(18): 251-252. (Li Yanjun. A study of orchestra conducting and Chinese and western forms of conducting[J]. Northern Music,2020,9(18): 251-252.)

[2]張金鑫. 多樣化樂隊(duì)指揮形式的探究[J]. 當(dāng)代音樂,2018(6): 108-109. (Zhang Jinxin. Exploration of diverse band conducting forms[J]. Contemporary Music,2018(6): 108-109.)

[3]程酢培. 試論指揮“圖式”的重要性[J]. 當(dāng)代音樂,2016(14): 74-77. (Cheng Zuopei. The importance of “schema” in conducting[J]. Contemporary Music,2016(14): 74-77.)

[4]Wang Tianshu,Zheng Nanning,Li Yan,et al. Learning kernel-based HMMs for dynamic sequence synthesis[C]// Proc of the 10th Pacific Conference on Computer Graphics and Applications. Piscataway,NJ: IEEE Press,2002: 87-95.

[5]Ruttkay Z,Huang Zhisheng,Eliens A. Gestures for embodied agents with logic programming[C]// Proc of International Workshop on Constraint Solving and Constraint Logic Programming. Berlin: Springer-Verlag,2003: 266-284.

[6]Reidsma D,Nijholt A,Bos P. Temporal interaction between an artificial orchestra conductor and human musicians[J]. Computers in Entertainment,2008,6(4): 1-22.

[7]Ryosuke T,Yusaku M,Tomoo I,et al. Multiple virtual conductors allow amateur orchestra players to perform better and more easily[C]// Proc of the 20th International Conference on Computer Supported Coo-perative Work in Design. Piscataway,NJ: IEEE Press,2016:486-491.

[8]Ye Zijie,Wu Haozhe,Jia Jia,et al. ChoreoNet: towards music to dance synthesis with choreographic action unit[C]// Proc of the 28th ACM International Conference on Multimedia. New York: ACM Press,2020: 744-752.

[9]Guo Xin,Zhao Yifan,Li Jia. DanceIt: music-inspired dancing video synthesis[J]. IEEE Trans on Image Processing,2021,30: 5559-5572.

[10]Duan Yinglin,Shi Tianyang,Zou Zhengxia,et al. Semi-supervised learning for in-game expert-level music-to-dance translation[EB/OL]. (2020-09-27). https://arxiv.org/abs/2009.12763.

[11]Lee H Y,Yang Xiaodong,Liu Mingyu,et al. Dancing to music[C] // Proc of Annual Conference on Neural Information Processing Systems. 2019: 3581-3591.

[12]Li Buyu,Zhao Yongchi,Sheng Lu. DanceNet3D: music based dance generation with parametric motion Transformer[EB/OL]. (2021-05-18). https://arxiv.org/abs/2103.10206.

[13]Liu Junwei,Lin Hungyi,Huang Yufen,et al. Body movement generation for expressive violin performance applying neural networks[C]// Proc of IEEE International Conference on Acoustics,Speech and Signal Processing. Piscataway,NJ: IEEE Press,2020: 3787-3791.

[14]Kao H K,Su Li. Temporally guided music-to-body-movement generation[C]// Proc of the 28th ACM International Conference on Multimedia. New York: ACM Press,2020: 147-155.

[15]Shlizerman E,Dery L,Schoen H,et al. Audio to body dynamics[C]// Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ: IEEE Press,2018: 7574-7583.

[16]Tang Taoran,Jia Jia,Mao Hanyang. Dance with melody: an LSTM-autoencoder approach to music-oriented dance synthesis[C]// Proc of the 26th ACM International Conference on Multimedia. New York: ACM Press,2018: 1598-1606.

[17]Sadoughi N,Busso C. Novel realizations of speech-driven head movements with generative adversarial networks[C]// Proc of IEEE International Conference on Acoustics,Speech and Signal Processing. Piscataway,NJ: IEEE Press,2018: 6169-6173.

[18]Yalta N,Ogata T,Nakadai K. Sequential deep learning for dancing motion generation,SIG-Challenge-046-08[R]. [S.l.]: Japanese Society for Artificial Intelligence,2016.

[19]Sun Guofei,Wong Yongkang,Cheng Zhiyong,et al. DeepDance: music-to-dance motion choreography with adversarial learning[J]. IEEE Trans on Multimedia,2020,23: 497-509.

[20]Ren Xuanchi,Li Haoran,Huang Zijian,et al. Self-supervised dance video synthesis conditioned on music[C]// Proc of the 28th ACM International Conference on Multimedia.New York:ACM Press,2020:46-54.

[21]Ginosar S,Bar A,Kohavi G,et al. Learning individual styles of conversational gesture[C]// Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ: IEEE Press,2019: 3497-3506.

[22]Chen Lele,Li Zhiheng,Maddox R K,et al. Lip movements generation at a glance[C]// Proc of European Conference on Computer Vision. Berlin: Springer-Verlag,2018: 520-535.

[23]Zhou Hang,Liu Yu,Liu Ziwei,et al. Talking face generation by adversarially disentangled audio-visual representation[C]// Proc of AAAI Conference on Artificial Intelligence. Palo Alto,CA: AAAI Press,2019: 9299-9306.

[24]Eskimez S E,Maddox R K,Xu Chenliang,et al. End-to-end generation of talking faces from noisy speech[C]// Proc of IEEE International Conference on Acoustics,Speech and Signal Processing. Pisca-taway,NJ: IEEE Press,2020: 1948-1952.

[25]Song Yang,Zhu Jingwen,Li Dawei,et al. Talking face generation by conditional recurrent adversarial network[EB/OL]. (2019-07-25). https://arxiv.org/abs/1804.04786.

[26]Huang Yufen,Chen Tsungping,Moran N,et al. Identifying expressive semantics in orchestral conducting kinematics[C]// Proc of the 20th International Society for Music Information Retrieval Conference. 2019: 115-122.

[27]Krebs F,Bck S,Widmer G. An efficient state-space model for joint tempo and meter tracking[C]// Proc of the 16th International Society for Music Information Retrieval Conference. 2015: 72-78.

[28]He Kaiming,Zhang Xiangyu,Ren Shaoqing,et al. Deep residual learning for image recognition[C]// Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ: IEEE Press,2016: 770-778.

[29]Bai Shaojie,Kolter J Z,Koltun V. Convolutional sequence modeling revisited[C]// Proc of the 6th International Conference on Learning Representations. [S.l.]: OpenReview.net,2018.

[30]Liu Fan,Chen Delong,Zhou Ruizhi,et al. Self-supervised music motion synchronization learning for music-driven conducting motion generation[J]. Journal of Computer Science and Technology,2022,37(3): 539-558.

[31]Pavllo D,F(xiàn)eichtenhofer C,Grangier D,et al. 3D human pose estimation in video with temporal convolutions and semi-supervised training[C]// Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ: IEEE Press,2019: 7753-7762.

[32]Liu Wen,Piao Zhixin,Min Jie,et al. Liquid warping GAN: a unified framework for human motion imitation,appearance transfer and novel view synthesis[C]// Proc of IEEE International Conference on Computer Vision. Piscataway,NJ: IEEE Press,2019: 5904-5913.