基于稀疏實例與位置感知卷積的植物葉片實時分割方法

任守綱 朱勇杰 顧興健 武鵬飛 徐煥良

摘要: ?植物葉片分割在高通量植物表型數據獲取任務中起著關鍵作用。目前,多數植物葉片分割方法專注于提高模型分割精度,卻忽視模型復雜度和推理速度。針對該問題,本研究提出一種基于稀疏實例激活與有效位置感知卷積的實例分割模型(ePaCC-SparseInst),實現植物葉片實時、精確分割。在ePaCC-SparseInst 中引入1組稀疏實例激活圖作為葉片對象表示方式,并使用二部圖匹配算法實現預測對象與實例激活圖的一一映射,從而避免了繁瑣的非極大值抑制(Non-maximum suppression,NMS)運算,提高了模型的推理速度。此外,在實例分支中引入有效位置感知卷積(ePaCC)模塊,在增大模型全局感受野的同時提高了模型的推理速度。在Komatsuna數據集上,ePaCC-SparseInst平均分割精度(AP)達到85.33%,每秒傳輸幀數達到43.52。在相同訓練條件下,ePaCC-SparseInst的性能優于SparseInst、Mask R-CNN、CondInst等實例分割算法。此外在CVPPP A5數據集上,ePaCC-SparseInst較上述算法同樣取得了更好的分割精度和推理速度。本研究提出的方法采用純卷積的架構實現了葉片的實時分割,可以為在移動端或邊緣設備上獲取植物表型數據提供技術支持。

關鍵詞: ?實例分割; 計算機視覺; 植物表型; 葉片分割

中圖分類號: ?TP391.41 ???文獻標識碼: A ???文章編號: ?1000-4440(2024)03-0478-12

Real-time segmentation of plant leaves based on sparse instances and position aware convolution

REN Shou-gang1,2, ZHU Yong-jie1, GU Xing-jian1, WU Peng-fei3, XU Huan-liang1

(1.College of Artificial Intelligence, Nanjing Agricultural University, Nanjing 210095, China; 2.National Engineering and Technology Center for Information Agriculture, Nanjing 210095, China; ?3.Xinjiang Xingnong Network Information Center/Xinjiang Uygur Autonomous Region Agricultural Meteorological Observatory, Urumqi 830002, China)

Abstract: ?The segmentation of plant leaves plays a crucial role in high-throughput plant phenotyping data acquisition tasks. Currently, most methods for plant leaf segmentation focus on improving the accuracy of the segmentation model but overlook the models complexity and inference speed. In response to this issue, this study proposed an instance segmentation model (ePaCC-SparseInst) based on sparse instance activation and efficient position-aware convolution to achieve real-time and accurate segmentation of plant leaves. In ePaCC-SparseInst, a set of sparse instance activation maps was introduced as the representation of leaf objects. A bipartite graph matching algorithm was employed to establish a one-to-one mapping between predicted objects and instance activation maps, thereby avoiding the cumbersome non-maximum suppression (NMS) operation and improving the models inference speed. Additionally, an effective position-aware circulate convolution (ePaCC) module was introduced into the instance branch, which increased the models global receptive field and enhanced its inference speed. On the Komatsuna dataset, ePaCC-SparseInst achieved an average segmentation precision (AP) of 85.33% and an inference speed of 43.52 frames per second (FPS). Under the same training conditions, its performance surpassed instance segmentation algorithms such as SparseInst, Mask R-CNN, and CondInst. Furthermore, on the CVPPP A5 dataset, ePaCC-SparseInst achieved better segmentation accuracy and inference speed than the aforementioned algorithms. The proposed method used a pure convolutional architecture to achieve real-time leaf segmentation, which could provide technical support for obtaining plant phenotypic data on mobile or edge devices.

Key words: ?instance segmentation; computer vision; plant phenotypes; leaf segmentation

植物葉片在揭示植物生長發育狀況的過程中起到關鍵作用。例如葉面積和葉片的形狀(葉長、葉寬、葉傾角等)與植物的光合作用、呼吸作用、蒸騰作用以及碳和養分同化等多種生理活動密切相關[1]。因此借助非破壞性方法獲取葉片特征數據,與植物基因數據相結合,能為改善植株的遺傳性狀提供參考,從而提高作物產量[2]。在高通量植物表型任務中,分割出植物葉片是獲得生物量特征的重要前提之一[3]。因此葉片分割是植物表型任務中的關鍵步驟,精準且快速地從復雜的背景中分割出葉片區域,有助于植物葉片表型參數的快速提取,同時也對植物生長狀況的同步觀察以及病蟲害的實時監督等方面有著重要的意義[4]。葉片分割任務主要分為單目標葉片分割和多目標葉片分割2類[5-7]。

在單目標葉片分割方面,通常優先采用傳統的圖像分割方法或者基于深度學習的語義分割方法。蔣煥煜等[8]將基于形態學的分水嶺算法用于葉片邊緣分割,借此提取穴孔中的番茄幼苗的葉片面積和葉片周長。孫國祥等[9]提出了基于邊緣鏈碼信息的番茄苗重疊葉面分割算法,對72孔和128孔的分割準確度達到了100%和96%,分割單張圖片的平均耗時分別達到0.835 s和0.990 s。王紀章等[10]借助Kinect相機對彩色葉片圖像進行預處理、閾值分割、形態學運算以及連通分量統計等操作,實現了幼苗的無損檢測,該算法估算出的葉面積與實際葉面積的平均誤差僅為2.15%。針對綠色葉片圖像分割困難的問題,伍艷蓮等[11]提出一種改進的均值漂移算法,實現了對綠色作物的精確分割,性能上優于常規的均值漂移算法且圖像的錯分率小于6.5%。面對不同的背景、陰影等成像環境,單一模型往往難以很好地解決植物葉片分割問題,胡靜等[12]提出一種基于魯棒隨機游走的交互式植物葉片分割方法,通過人機交互獲取前景的像素信息,獲得了光滑、魯棒的植物葉片分割結果圖。Kan等[13]提出的基于U-net的葉片分割模型,采用了ResNet-50作為主干網絡用于編碼圖片,并在解碼器中引入特征融合模塊,更好地融合了來自底層的位置信息以及來自高層的語義信息。從上述的方法可以看出,傳統的圖像分割算法和基于深度學習的語義分割算法,雖然大多有著不錯的分割效果,但是無法分割出植物中的每一張葉片。而實例分割算法則能將圖片中的每一個實例對象都分割出來,即使這些實例對象屬于同一個類別。

在多目標葉片分割方面,目前已有較多基于實例分割的研究。Yin等[14]提出一種基于倒角匹配的多葉片對齊算法,該算法能找到輸入圖像中多個葉片的最佳對齊方式,且能應用于葉片的實例分割當中。Ren等[15]率先將循環神經網絡(Recurrent neural network, RNN)應用在葉片實例分割任務中,該算法能一次一個地查詢葉片實例并對其進行實例分割,即使在遮擋場景下性能也不會出現衰退。隨著He等[16]提出Mask R-CNN,基于卷積神經網絡(Convolutional neural network,CNN)的實例分割網絡占據了絕大部分的實例分割任務,與上述2種算法相比,以Mask R-CNN為代表的實例分割算法有著更高的分割精度。喬虹等[17]采用Mask R-CNN對大田環境下的葡萄葉片進行了檢測與分割,結果顯示不同的葡萄葉片分割精度都大于等于0.88。該葡萄葉片檢測與分割算法展示了Mask R-CNN對不同天氣狀況以及各種復雜背景下的葉片分割任務都有著較好的魯棒性和較高的分割精度。但是該算法在葉片邊緣的分割精度依舊不夠理想,這是由Mask R-CNN經過感興趣區域(ROI)裁剪導致特征圖分辨率降低等原因導致的。針對以上問題,袁山等[18]采用結合了注意力機制的Cascade mask R-CNN,解決葉片遮擋以及葉片邊緣特征不明顯等問題。以Mask R-CNN為代表的兩階段實例分割算法,雖然在精度上有著很大的優勢,但是其在推理速度方面仍存在著較大的缺陷。例如在袁山等的工作中可以看到,Mask R-CNN推理1張圖片需要耗時0.383 s,Cascade mask R-CNN需要耗時0.387 s,以及其改進模型需要耗時0.562 s。而Guo等[4]提出了一種端到端無錨的單階段實例分割算法,以提高葉片的分割精度。該算法省去了大多數實例分割算法所依賴的錨框,節約了大量實例篩選的時間,但其在解碼器中加入的多尺度注意力模塊以及掩碼細化模塊又降低了推理的速度。由上述方法可以看出,模型分割精度與推理速度之間存在一定的對立性和矛盾性。若將上述模型應用在移動端或邊緣設備上時,會對模型的部署和使用造成較大的困難[19]。SparseInst模型[20]作為現有實時實例分割的基準模型,有著較快的推理速度和較高的分割精度,同時很好地控制模型的大小,但在實例識別時,由于其感受野的局限性,會導致面積較小的葉片分割錯誤。

Hu等[21]在Faster R-CNN[22]目標檢測算法的檢測分支中引入一個帶有自注意力機制的對象關系模塊,該模塊通過目標對象的外觀特征和形狀之間的潛在聯系同時處理這一組對象,對這一組對象之間的關系進行建模,提高了算法的檢測精度。在實例分割的研究中,Guo等[23]在SOLOv2[24]的核分支(Kernel branch)中引入了Vision Transformer(ViT),試圖捕獲長距離的上下文依賴,獲得全局特征信息,以更好地區分具有相同語義類別的重疊實例。受這2個工作的啟發,本研究擬在SparseInst實例分支中引入一個帶有全局感受野的有效位置感知卷積(ePaCC)模塊替換原有的普通卷積層,通過該模塊獲取長距離的上下文語義信息,輸出全局性、語義信息性更強的實例激活圖,在保持精度不降低的情況下,提高葉片實例分割的速度。此外,在ePaCC模塊中引入eSE注意力模塊,緩解模型通道信息丟失問題的同時進一步提升模型的推理速度。最后使用基于匈牙利算法的二部圖匹配算法實現預測對象與真實標簽(GT)的一一映射,避免繁瑣的參數設計和后處理操作,以期實現植物葉片實時實例分割。

1 材料與方法

1.1 試驗數據集

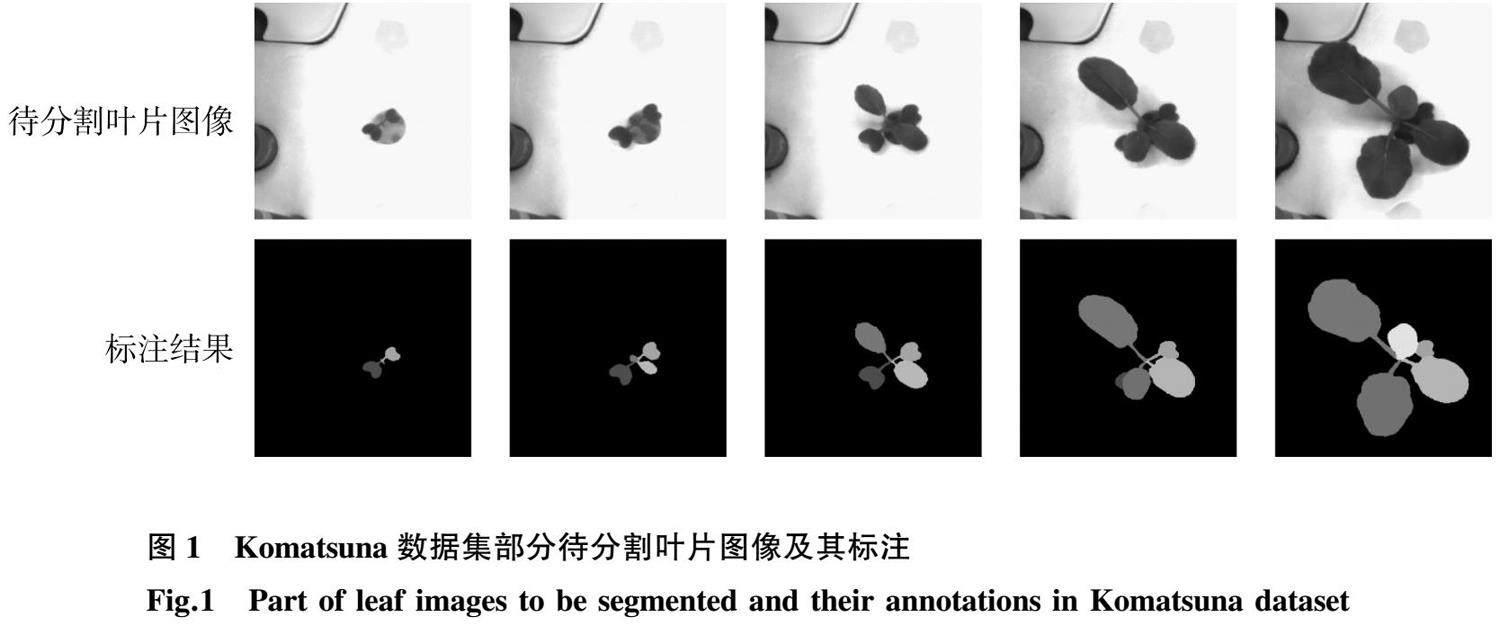

Komatsuna植物葉片數據集[7]總共有900張小松菜各個生長階段的圖片。本研究隨機選取720張圖片作為訓練集,剩余的180張圖片作為測試集。其中每一張圖片的分辨率為480×480。圖1展示了部分Komatsuna數據集的原始圖像以及對應的標注信息。

CVPPP[6]中的A5數據集由不同尺寸的煙草花和擬南芥圖像組成,共計810張圖像。其中,擬南芥原始圖像分辨率為:500×530、530×565和441×441,煙草花原始圖像的分辨率為:2 448×2 048。本研究將810張圖像劃分為訓練集(648張)和測試集(162張)。

1.2 數據增強

數據增強是解決深度學習樣本較少問題的常用方法之一[25]。本研究使用Detectron2自帶的隨機縮放圖像的最小邊長進行數據增強。輸入圖像的最小邊長會隨機調整為352、384、416、448、480,使得輸入模型訓練的葉片圖像為720張,而實際訓練的圖片數量為3 600張,這基本滿足了實例分割訓練模型對圖片數量的要求。

1.3 ePaCC-SparseInst模型概述

ePaCC-SparseInst模型主要由3個部分組成(圖2),分別為用于特征提取的主干網絡、實例上下文編碼器以及基于實例激活圖的分割解碼器。主干網絡用于從輸入圖像中提取多尺度特征。實例上下文編碼器將主干網絡中生成的多尺度特征融合,以生成上下文信息更加豐富的單尺度特征圖。最后將生成的特征圖送入基于實例激活圖的分割解碼器中,生成葉片實例的激活圖,以突出葉片實例,用于后續網絡的識別和分割。

1.4 實例上下文編碼器和基于實例激活圖的分割解碼器

ePaCC-SparseInst的實例上下文編碼器不同于以往的實例分割算法所使用的特征金字塔網絡(Feature pyramid network,FPN)[26],而是對其進行重構。實例上下文編碼器在主干網絡輸出的特征層C5之后采用金字塔池化模塊(Pyramid pooling module,PPM)[27]放大模型的感受野,旨在輸出語義信息更為豐富的特征圖。最后輸出的單級特征圖融合了P3、P4和P5 3層特征圖,其分辨率為原始圖像的八分之一。

基于實例激活圖的分割解碼器由實例分支和掩碼分支構成。如圖2所示,實例分支生成實例激活圖和3個N×D(N:實例激活圖的個數;D:向量的長度)的向量用于后續實例識別和分割。實例激活圖位于實例分支中,旨在全局范圍內突出每個實例對象的信息區域。突出區域的實例特征語義信息豐富,在實例識別中,有很強的實例感知能力。而掩碼分支則用于解碼特征圖并生成葉片對象的分割結果。

1.5 實例分支

與現有的實例分割模型不同,ePaCC-SparseInst既不依賴邊界框[22]也不依賴稠密的錨框[28]定位實例對象,而是通過一組稀疏的實例激活圖(Instance activate maps,IAM)來定位潛在的實例對象。實例激活圖作為一種新的實例對象表示方式,可以動態地顯示每個實例對象的區域信息。實例激活圖是由ePaCC模塊和Sigmoid激活函數在實例分支中激活后生成。給定ePaCC生成的特征圖X∈RD×(H×W)(D:向量的長度;H:向量的高度;W:向量的寬度),經過實例激活函數后輸出的實例激活圖為A=fiam(X)∈RN×(H×W)。A為N個實例激活圖的稀疏集,fiam(·)為非線性的Sigmoid激活函數。實例激活圖根據區域位置信息聚合特征,以獲得每個實例的語義信息,用于識別和分割實例對象。然后通過1個全連接層生成3個N×D的向量,這3個向量分別是:掩碼分支生成實例掩碼的動態卷積核、實例特征的類別及其類別置信分。

1.6 ePaCC模塊

本研究在實例分支中引入一個帶有全局感受野的ePaCC模塊替代普通卷積層,試圖捕獲長距離的上下文依賴,獲得全局特征信息以更好地區分具有相同語義類別的重疊葉片。ePaCC改進自一種全新的輕量級卷積模塊位置感知卷積(PaCC)[29],其憑借全卷積的結構完美融合了Vision Transformer的優點。該模塊具有全局感受野的同時,也具備普通卷積的位置敏感性。ePaCC與普通的輕量級卷積神經網絡和ViT相比,擁有更好的性能、更少的參數和更快的推理速度。其結構如圖3所示。

ePaCC模塊提取特征的主要結構為PaCC算子,該算子主要有2種類型,分別是垂直方向的PaCC算子(PaCC-V)以及水平方向的PaCC算子(PaCC-H)。如圖4所示,PaCC-H的感受野能覆蓋一整行,而PaCC-V的感受野則能覆蓋一整列。結合PaCC-H和PaCC-V則能實現提取全局特征的功能。以PaCC-V為例,PaCC算子的實現見公式(1)~公式(5):

peV=F(p ~ eV)=[peV0,peV1,…,peVh-1]T (1)

peVe=EV(peV,w) (2)

kV=F(k ~ )=[kV0,kV1,…,kVh-1] (3)

xp=x+peVe (4)

yi,j=∑ ?t∈(0,h-1) kVtxp[(i+t)modh,j] (5)

其中peV是指垂直方向實例位置編碼,通過F(雙線性插值函數)由一個垂直方向基本位置編碼p ~ eV生成。p ~ eV由垂直方向的實例位置編碼延展得到;peVe是垂直方向位置編碼的展開形式;kV是每一個PaCC的實例卷積核,由基本的實例卷積核k ~ 通過雙線性插值函數得到。x是輸入特征圖;xp是包含了位置信息的輸入特征圖;yi,j表示PaCC模塊在位置(i,j)處輸出的特征。EV:垂直方向延展;w:實例位置編碼雙線性插值后張量的寬度;mod:模運算;h:高度。

Metaformer結構是Vision Transformer取得成功的關鍵之一[30],它通常由2個重要的組件構成:令牌混合器和通道混合器。前者用于在不同空間位置的令牌之間交換信息,后者用于在不同通道之間交換信息。ePaCC模塊則使用一組串并聯的PaCC算子替換Metaformer中的自注意力模塊,構成一個新的空間模塊。為了使純卷積架構的PaCC模塊也具有數據驅動性,引入eSE注意力模塊作為ePaCC模塊的通道混合器,使網絡模型可以關注輸入特征圖中更加重要的特征信息,同時抑制不必要的干擾信息,從而輸出語義信息更豐富的特征圖。

1.7 eSE注意力模塊

SE注意力模塊是卷積神經網絡中最常用的注意力模塊[31]。如圖5所示,SE注意力模塊中2個壓縮通道維數的全連接層會導致通道信息丟失的問題。因此本研究采用eSE通道注意力模塊[32]替代PaCC模塊中的SE通道注意力模塊。該模塊只使用一個通道數為C的全連接層,保證了通道信息不會因為通道壓縮而丟失,進一步增強了實例激活圖的質量,并提升了模型的推理速度。假設給定特征圖Xi∈RC×H×W,經過eSE注意力模塊后輸出的特征圖可以用公式表示為:

AeSE(Xi)=σ{WC[Fgap(Xi)]} (6)

X0=XiAeSE(Xi) (7)

其中Fgap(·)為全局平均池化;WC是全連接層;σ是一個Sigmoid激活函數。

1.8 掩碼分支

本研究的掩碼分支沿用了SparseInst的掩碼分支,首先通過卷積層生成掩碼特征圖M∈RD×H×W,結合來自實例分支的動態卷積核{wi}N生成每一個實例對象的分割掩碼mi=wi×M。最后通過雙線性插值恢復到原始比例的特征圖。

實例激活圖會隨輸入特征的改變而改變,因此很難手工制定規則來分配標簽進行模型訓練。針對該問題,本研究將標簽分配問題轉化為二部圖匹配問題,并使用匈牙利算法[33]實現預測對象與實例激活圖的一一映射。二部圖匹配有助于實例激活圖突出顯示單個實例對象并抑制冗余預測,因此避免了計算繁瑣的非極大值抑制(NMS),節約了大量模型推理時間。

2 結果與分析

2.1 模型訓練

試驗環境為Nvidia GTX 1080Ti GPU、顯存11 G和Linux Ubuntu 18.04操作系統。本研究中的所有網絡模型都基于開源框架detectron2和Pytorch進行部署,同時配備了Python3.7、Cuda10.2并行計算架構以及Cudnn7.6 GPU加速庫。

參數設置:每次迭代訓練的圖片為4張,ePaCC-SparseInst、SparseInst、SOLOV2、CondInst均迭代25 000次,而Mask R-CNN僅迭代10 000次,這是因為ePaCC-SparseInst的二部圖匹配算法需要更多訓練輪次來收斂網絡模型,而Mask R-CNN則會因為迭代輪次過多而產生過擬合的現象,導致分割精度劇烈降低。ePaCC-SparseInst的初始學習率為0.000 050 0,因為二部圖匹配算法對學習率十分敏感,初始學習率太大會導致模型在訓練開始時就梯度爆炸。當網絡迭代到16 000次和20 000次時,學習率會分別衰減為0.000 005 0和0.000 000 5;SOLOv2和CondInst的初始學習率為0.000 200 0,學習率衰減規則同ePaCC-SparseInst一致;Mask R-CNN的初始學習率為0.005 000 0,當網絡迭代到8 000次和9 000次時,學習率會衰減為0.000 500 0和0.000 050 0。此外SparseInst和ePaCC-SparseInst中的超參數N設為100,超參數D設為256。為了保證試驗結果的可信性,本研究中所有展示的評價指標都是3次訓練結果的平均值。

2.2 評價指標

本研究使用實例分割算法中最常用的評價指標平均分割精度(AP)來衡量網絡模型的分割精度,包括AP50、AP75、APs、APm以及AP1。其中AP50和AP75表示真實標簽和預測結果的交并比為50%以及75%時的平均分割精度;APs表示像素小于322實例對象的平均分割精度,在本研究中用來衡量網絡對小葉片的檢測效果;AP1表示像素大于962實例對象的平均分割精度,在本研究中用來評估網絡對大葉片的檢測效果;而APm表示像素則介于322和962之間實例對象的平均分割精度。AP的計算公式如下所示:

P= TP TP+FP ×100% (8)

R= FP TP+FN ×100% (9)

AP=∫ 10P(R) (10)

式中,TP表示正樣本被預測正確的像素總和;FP表示正樣本被預測錯誤的像素總和;FN表示負樣本被預測錯誤的像素總和;P表示準確率;R表示召回率;AP表示平均分割精度。

為了衡量模型的推理速度,本研究使用模型在1080Ti服務器上每秒傳輸幀數(Frames per second,FPS)作為模型推理速度的評價指標。

2.3 模型主干網絡的選擇與分析

主干網絡(Backbone)是模型提取特征的關鍵部件之一,能提取輸入圖片的信息,生成不同尺度的特征圖,供后續網絡的檢測與分割。選擇正確的主干網絡以及合適的網絡深度可以讓模型的性能得到進一步提升。本研究選用ResNet系列中4種不同深度的模型作為ePaCC-SparseInst的主干網絡并進行了一系列的試驗分析,試驗結果如表1所示。結果表明,ResNet-50作為ePaCC-SparseInst的主干網絡時,分割效果明顯優于其他幾種模型,同時模型FPS達到43.52,滿足實時性的需求。ResNet-18和ResNet-34雖有較快的推理速度,但是分割精度都低于ResNet-50。而ResNet-101則因為網絡模型的進一步加深,出現了一定程度的性能衰退。因此,綜合考慮模型的精度和推理速度,本研究選用ResNet-50作為ePaCC-SparseInst的主干網絡。

2.4 模型消融試驗

消融試驗可以探究網絡中的各個子結構對模型性能產生的影響。表2展示了實例上下文編碼器中各個組件對網絡模型性能的影響。為了增大感受野和獲取更多的實例上下文信息,增加金字塔池化模塊使模型的AP較基準模型SparseInst提高了0.75個百分點。融合特征金字塔P3到P5的多尺度特征,增強了輸出單尺度特征的表達能力并將ePaCC-SparseInst的平均分割精度進一步提高至85.33%。此外為了驗證ePaCC-SparseInst中新增模塊的效果,本研究設置了消融試驗,將ePaCC-SparseInst中改進或者添加的模塊逐個刪除后進行訓練。試驗結果如表3 所示。

從表3可以看出,使用PaCC模塊替換普通卷積層解碼特征之后,模型的AP提高了0.29個百分點,FPS提高了1.19,APs從60.33%提升至61.63%,這是因為引入的PaCC模塊有著普通卷積層所不具備的全局感受野,能在全局的范圍內,找到普通卷積網絡不能感知的小葉片。將PaCC中的SE注意力模塊替換成eSE注意力模塊之后,模型的性能又獲得了進一步的提升,雖然平均分割精度僅提高了0.17個百分點,但模型的推理速度提升了1.33。這是因為eSE注意力模塊中的單層全連接層緩解了PaCC模塊通道丟失問題,同時進一步提高了模型的推理速度。通過上述消融試驗可以發現,本研究對SparseInst的改進都取得了積極的作用,特別是引入了eSE注意力模塊的ePaCC模塊對模型的精度和速度都有較大提升。

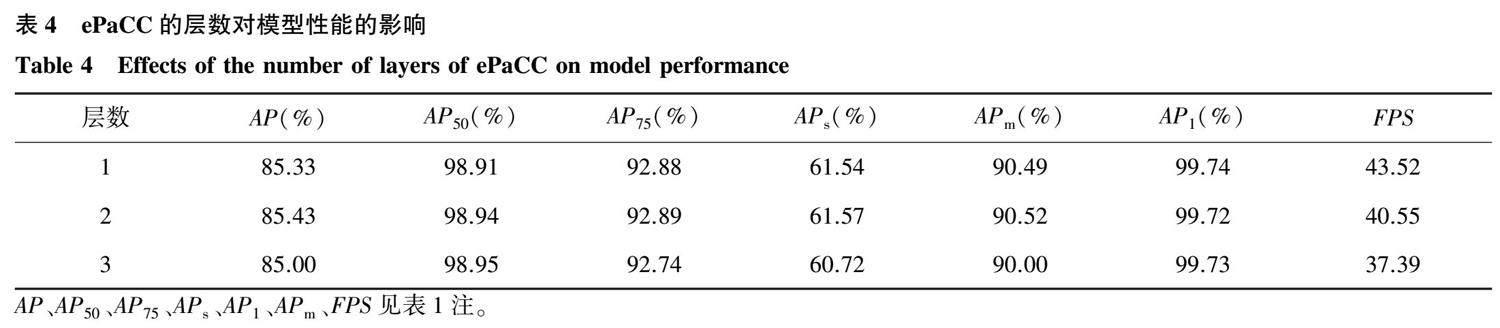

2.5 ePaCC的層數對模型性能的影響及分析

為了設計出更好的實例分支解碼器,本研究進行了如表4所示的對比試驗。該試驗評估了不同層數的ePaCC模塊對模型性能的影響。

由表4可以看出,當ePaCC的層數從1層增加到2層時,模型的分割精度得到略微的提升,但是模型的FPS降低了2.97 。而ePaCC的層數增加到3層時,模型的分割精度反而出現一定程度的降低,其中最為明顯的是APs,較1層ePaCC降低0.82個百分點,這表明模型對小葉片的分割精度出現了大幅降低。因此為了平衡分割精度和模型的推理速度,本研究選用層數為1的ePaCC作為實例分支中的解碼器。同時也證明了ePaCC有著較好的擬合能力,僅需1層就能很好地擬合數據。

2.6 ePaCC-SparseInst與不同模型的對比試驗

使用Komatsuna數據集對比Mask R-CNN以及目前較為先進的實時實例分割方法。最后在相同的測試集下進行推理測試,最終的試驗結果如表5所示。

由表5可知,ePaCC-SparseInst實例分割算法在Komatsuna數據集上的FPS達到43.52,也就是單幀圖片的分割時間僅需22.97 ms,同時平均分割精度達到了85.33%。而經典的實例分割算法Mask R-CNN單幀圖片的分割時間需要40.93 ms,平均分割精度僅為75.15%。如果直接將Mask R-CNN應用于農業場景中,將無法滿足實時分割植物葉片的需求。對比當前較為流行的實時實例分割算法CondInst和SOLOv2,ePaCC-SparseInst在推理模型推理速度以及葉片分割精度上都有一定程度的優勢。因此可以得出結論,ePaCC-SparseInst在推理速度和分割精度上都有著不錯的效果,為模型在移動端或算力較低的邊緣設備上部署提供了一種可行的方案。

此外,本研究還對上述幾種實例分割方法進行了可視化分析,如圖6所示。其中Mask R-CNN的分割結果是最差的,這主要由Mask R-CNN的2個缺陷導致的:首先,Mask R-CNN是兩階段的實例分割算法,這導致掩碼的分割結果極度依賴檢測結果的準確性。而檢測框出現偏差時,就會對分割結果產生影響。從圖6也可以看出這一現象,檢測框的不準確導致部分葉片的葉尖部分沒有被分割出來。為了提高檢測的精度,有些方法在Faster R-CNN的基礎上進行了一定的改進,如Cascade R-CNN[34]等。但這些方法大多會增加額外的開銷,導致模型的復雜度以及推理時間大大增加。其次,Mask R-CNN在ROI Align之后,特征圖的分辨率僅為28×28,導致部分語義信息丟失。而以CondInst為代表的實例分割算法都拋棄了ROI Align,在原始特征層上動態地生成分割掩碼,盡可能地保留更多的語義信息。但CondInst實例分割算法從本質上來說還是兩階段實例分割算法,只是將檢測算法從Faster R-CNN替換成了檢測精度更高的FCOS[28],因此也會因為檢測結果不佳影響最終掩碼的分割精度。SOLOv2將分割問題很好地轉化為位置分類問題,做到了不需要目標檢測來引導實例分割。但是其在小面積葉片的分割與檢測上,很容易出現漏檢的情況。由表5中SOLOv2 APs指標以及圖6也可以看出這個缺陷。而ePaCC-SparseInst在模型分割精度上較SparseInst有著略微的提高。從SparseInst的第二張可視化圖中可以看出,葉子細小的葉柄沒有被完整的分割出來,而改進的SparseInst則將細小的葉柄分割出來了。同時也可以看出ePaCC-SparseInst分割出的葉片較SparseInst一般有著更高的置信分。這說明ePaCC模塊使ePaCC-SparseInst的實例分支輸出的實例激活圖更具全局性,使得模型的分割精度得到了進一步的提升。

另外,在CVPPP A5數據集上,ePaCC-SparseInst的FPS也達到了41.63 ,比SparseInst快4.5。引入帶有全局感受野的ePaCC模塊后,全局感受野對葉面積較大的葉片感知能力得到了提升,ePaCC-SparseInst的AP1比SparseInst平均分割精度高2.74個百分點。補充的CVPPP A5數據集也說明了本研究提出的ePaCC-SparseInst在實時分割葉片上效果較其他算法有較大的優勢。

2.7 模型復雜度分析

為了對比本研究的模型與現有的實例分割模型的復雜度以及模型參數量的大小,選用ResNet-50為主干網絡,輸入模型的圖像尺寸為480×480像素的小松菜植物圖像,對比各個模型的每秒浮點計算數(Floating point operations per second,FLOPs)和模型參數量。

由表6可知,與Mask R-CNN、SOLOv2等實例分割算法相比,ePaCC-SparseInst的模型每秒浮點計算數以及參數量都得到了大幅的降低;同時, ePaCC-SparseInst較SparseInst增加的模型參數量可以忽略不計,但模型每秒浮點計算數減少了16.06 G。因此,全卷積結構的ePaCC-SparseInst大幅削減了模型每秒浮點計算數和參數量,同時提高了模型的分割精度,為在算力較低的設備上實現實時實例分割提供了一種可行的參考方案。

3 討 論

本研究以Komatsuna數據集中的小松菜各個生長階段的圖片為主要研究對象,以SparseInst實例分割網絡為基礎,兼顧模型精度和推理速度,對SparseInst實例分割網絡進行了改進,構建了ePaCC-SparseInst實時實例分割網絡,并進行了一定的試驗分析和評估。最終得到了如下結論:

1) 引入了稀疏的實例激活圖作為對象的表示方式,并使用匈牙利算法實現標簽和預測結果一一映射,大大地提高了模型的推理速度。同時在解碼器中使用帶有全局感受野的ePaCC模塊。該模塊把PaCC模塊中的SE注意力模塊替換成能更好得保留通道信息的eSE注意力模塊,進一步降低了模型在單張圖片上的推理時間。

2) 基于Komatsuna數據集中原先和數據增強后的共3 600張圖片,對ePaCC-SparseInst實例分割網絡進行試驗。結果表明:ePaCC-SparseInst實例分割網絡的平均精度為85.33%,推理速度每秒傳輸幀數為43.52。

3)通過消融試驗證明了ePaCC-SparseInst各個改進模塊的有效性。并將其與Mask R-CNN、CondInst和SOLOv2等實例分割算法進行對比試驗,結果表明改進后的SparseInst實例分割算法無論在分割精度上還是模型推理速度上,都優于其他實例分割算法。

本研究為基于圖像實例分割的植物表型研究提供了一種兼顧精度和速度的改進思路,對植物葉片的表型研究和實際應用領域都具有重要的應用價值和前景。

參考文獻:

[1] ?ZHOU Y, SRINIVASAN S, MIRNEZAMI S V, et al. Semiautomated feature extraction from RGB images for sorghum panicle architecture GWAS[J]. Plant Physiology,2019,179(1):24-37.

[2] PIERUSCHKA R, SCHURR U. Plant phenotyping:past,present,and future[J]. Plant Phenomics,2019,2019(3):1-6.

[3] SCHARR H, MINERVINI M, FRENCH A P, et al. Leaf segmentation in plant phenotyping:a collation study[J]. Machine Vision and Applications,2016,27(4):585-606.

[4] GUO R, QU L, NIU D, et al. LeafMask:towards greater accuracy on leaf segmentation[C]. Montreal,BC,Canada:IEEE,2021.

[5] ?GRAND-BROCHIER M, VACAVANT A, CERUTTI G, et al. Tree leaves extraction in natural images:comparative study of preprocessing tools and segmentation methods[J]. IEEE Transactions on Image Processing,2015,24(5):1549-1560.

[6] SCHARR H, PRIDMORE T, TSAFTARIS S A. Computer vision problems in plant phenotyping[C]. Venice,Italy:IEEE,2017.

[7] UCHIYAMA H, SAKURAI S, MISHIMA M, et al. An easy-to-setup 3D phenotyping platform for KOMATSUNA dataset[C]. Venice,Italy:IEEE,2017.

[8] 蔣煥煜,施經揮,任 燁,等. 機器視覺在幼苗自動移缽作業中的應用[J]. 農業工程學報,2009,25(5):127-131.

[9] 孫國祥,汪小旵,何國敏. 基于邊緣鏈碼信息的番茄苗重疊葉面分割算法[J]. 農業工程學報,2010,26(12):206-211.

[10] 王紀章,顧容榕,孫 力,等. 基于Kinect相機的穴盤苗生長過程無損監測方法[J]. 農業工程學報,2021,52(2):227-235.

[11] 伍艷蓮,趙 力,姜海燕. 基于改進均值漂移算法的綠色作物圖像分割方法[J]. 農業工程學報,2014,30(24):161-167.

[12] 胡 靜,陳志泊,張榮國, 等. 基于魯棒隨機游走的交互式植物葉片分割[J]. 模式識別與人工智能,2018,31(10):933-940.

[13] ?KAN J, GU Z, MA C, et al. Leaf segmentation algorithm based on improved U-shaped network under complex background[C]. Chongqing,China:IEEE,2021.

[14] YIN X, LIU X, CHEN J, et al. Multi-leaf alignment from fluorescence plant images[C]. Steamboat Springs,CO,USA:IEEE,2014.

[15] REN M, ZEMEL R S. End-to-end instance segmentation with recurrent attention[C]. Honolulu,HI,USA:IEEE,2017.

[16] HE K, GKIOXARI G, DOLLR P, et al. Mask R-CNN[C]. Venice,Italy:IEEE,2017.

[17] 喬 虹,馮 全,趙 兵,等. 基于Mask R-CNN的葡萄葉片實例分割[J]. 林業機械與木工設備,2019,47(10):15-22.

[18] 袁 山,湯 浩,郭 亞. 基于改進Mask R-CNN模型的植物葉片分割方法[J]. 農業工程學報,2022,38(1):212-220.

[19] 邢潔潔,謝定進,楊然兵,等.基于YOLOv5s的農田垃圾輕量化檢測方法[J]. 農業工程學報,2022,38(19):153-161.

[20] CHENG T, WANG X, CHEN S, et al. Sparse instance activation for real-time instance segmentation[C]. New Orleans,LA,USA:IEEE,2022.

[21] HU H, GU J, ZHANG Z, et al. Relation networks for object detection[C]. Salt Lake City,UT,USA:IEEE,2018.

[22] REN S, HE K, GIRSHICK R, et al. Faster R-CNN:towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(6):1137-1149.

[23] GUO R, NIU D, QU L, et al. SOTR:segmenting objects with transformers[C]. Montreal,QC,Canada:IEEE,2021.

[24] WANG X, ZHANG R, KONG T, et al. SOLOv2: dynamic and fast instance segmentation[C]. Red Hook,NY,USA:Curran Associates Inc.,2020.

[25] BUSLAEV A, IGLOVIKOV V I, KHVEDCHENYA E, et al. Albumentations:fast and flexible image augmentations:2[J]. Information,2020,11(2):125.

[26] LIN T-Y, DOLLR P, GIRSHICK R, et al. Feature pyramid networks for object detection[C]. Honolulu,HI,USA:IEEE,2017.

[27] ZHAO H, SHI J, QI X, et al. Pyramid scene parsing network[C]. Honolulu,HI,USA:IEEE,2017.

[28] TIAN Z, SHEN C, CHEN H, et al. FCOS:fully convolutional one-stage object detection[C]. Seoul,South Korea:IEEE,2019.

[29] ZHANG H, HU W, WANG X. ParC-Net:position aware circular convolution with merits from ConvNets and transformer[C]. Tel Aviv,Israel:Springer Nature Switzerland,2022.

[30] YU W, LUO M, ZHOU P, et al. Metaformer is actually what you need for vision[C]. New Orleans,LA,USA:IEEE,2022.

[31] HU J, SHEN L, ALBANIE S, et al. Squeeze-and-excitation networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2020,42(8):2011-2023.

[32] LEE Y, PARK J. CenterMask:real-time anchor-free instance segmentation[C]. Seattle,WA,USA:IEEE,2020.

[33] STEWART R, ANDRILUKA M, NG A Y. End-to-end people detection in crowded scenes[C]. Las Vegas,NV,USA:IEEE,2016.

[34] CAI Z, VASCONCELOS N. Cascade R-CNN: delving into high quality object detection[C]. Salt Lake City,UT,USA:IEEE,2018.

(責任編輯:陳海霞)