基于改進YOLO v5的蘋果葉部病害檢測

趙興 岳喜申 鄔歡歡

摘要:針對YOLO v5檢測模型存在的漏檢率和誤檢率問題,改進目標檢測技術,提升蘋果葉部病害早期發現及定位的準確性和速度,從而減少經濟損失。先采用加權雙向特征金字塔網絡(BiFPN)特征融合方法,有效改善PANet對多尺度特征融合的不良影響,并引入Transformer機制,有效改進原始網絡結構,使其專注于有用的信息,并增強特征融合效果。再使用ATCSP模塊和自上而下的特征融合方法,增強模型對多尺度疾病的檢測效果,并將強大的語義信息傳達至模型底層,進一步提高檢測精度。使用數據集由實驗室采集的蘋果樹葉樣本構成,包含3 331張標記圖像的矩形位置來標記病害。由于圖像亮度分布不均勻,采用直方圖均衡化和改進的直方圖均衡化處理,使圖像對比度得到增強,大幅降低后續圖像特征提取的計算量。在訓練和測試過程中,還對原始病害圖像進行旋轉、隨機亮度增強、隨機色度增強、隨機對比度增強和銳化等數據增強操作。結果表明,改進的YOLO v5檢測算法可以顯著提高蘋果葉部病害檢測的精度,對比原始算法,平均精度mAP@0.5提高20.8%。改進YOLO v5蘋果葉部病害檢測算法能夠及時發現和定位蘋果葉部病害,進而為深度學習技術在農業病害監測中的廣泛應用提供技術支撐。

關鍵詞:改進的YOLO v5;蘋果;葉部病害;BiFPN;Transformer機制;精度

中圖分類號:TP391.41;S126? 文獻標志碼:A

文章編號:1002-1302(2024)08-0183-09

收稿日期:2023-05-15

基金項目:塔里木大學校長基金(編號:TDZKZD202104、TDZKSS202240);新疆生產建設兵團財政科技計劃項目南疆重點產業創新發展支撐計劃(編號:2022DB005)。

作者簡介:趙 興(1999—),男,新疆哈密人,碩士研究生,主要從事農業信息化、數字圖像處理研究。E-mail:1924360002@qq.com。

通信作者:鄔歡歡,碩士,教授,主要從事智慧農業、計算機圖像處理、人工智能研究。E-mail:wuhuanhuan@taru.edu.cn。

傳統的蘋果病害檢測主要依靠個人經驗和專家診斷,主觀性和延遲性強,難以達到快速準確的檢測要求。早期的機器學習方法使用圖像預處理[1]、圖像分割[2]和特征提取技術來選擇和設計人工特征[3],然后使用特定的機器學習算法對疾病特征進行分類[4-5]。雖然基于機器學習的方法能夠實現特定植物病害識別的高檢測精度,但繁雜的特征選擇和設計工作給其推廣和應用帶來了諸多困難。我國是世界上最大的蘋果生產國和消費國,占世界蘋果種植總面積的40%以上,在世界蘋果產業中占有重要地位。由于氣候的影響,蘋果葉片不可避免地受到不同疾病的感染,這會顯著影響蘋果的質量和產量,造成巨大的經濟損失。因此,快速有效地發現和防控蘋果葉片病害是當務之急[6-7]。檢測作物病害的傳統方法很大程度上依賴于專家的經驗。這需要大量的勞動力和時間,準確性也無法保證。近年來,隨著農業信息化進程的加快,基于機器學習的算法被應用于農業領域[8-10]。然而,支持向量機[11]、隨機森林[12]、決策樹[13]等機器學習算法需要專業經驗和手動特征選擇,限制其在實際場景中的應用。此外,基于機器學習的模型容易受到所選特征的影響,無法達到令人滿意的精度。隨著深度學習的發展,深度卷積神經網絡被用于作物病害的監測。基于深度卷積神經網絡的作物病害檢測可自動提取不同病害特征,實現高精度檢測,提高穩定性,為蘋果葉片早期病害檢測提供高效的端到端方法[14-15]。但是,大多數基于卷積神經網絡(CNN)的模型包含很多參數,計算非常復雜,訓練過程對高性能服務器依賴性強[16-18]。在農業領域,植物病害是對植物生長和產量的主要威脅因素。研究人員為了尋找更好的方法來控制這些疾病,作出了巨大的貢獻。傳統的機器學習算法最初被轉移到農田,用以檢測植物病害。Redmon 等利用灰度共生矩陣提取特征以及利用SVM分類器進行疾病分類的水稻葉片病害新方法,檢測性能精度為97.91%[19-21]。Ren等使用簡單線性迭代聚類(SLIC)算法得到超像素塊,使用SVM分類器對超像素塊進行分類,結果顯示,261張患病影像的準確度、精確度、召回率、F1分數分別為98.5%、96.8%、98.6%、97.7%[22]。但機器學習算法需要復雜的圖像預處理和疾病特征提取專業知識來獲得高質量的圖像[23],并不能保證檢測的準確性。卷積神經網絡近年來發展迅速,在農業領域取得了良好的效果。采用Kiwi-Inception結構和密集連接策略構建Kiwi-ConvNet,可以增強多尺度特征的提取能力,保證多維度特征融合。Sethy等使用MEAN塊和Apple-Inception提出MEAN-SSD這一新的檢測模型,改進后的MEAN-SSD檢測速度達到12.53幀/s、平均精度均值(mAP)達到83.12%[24-26]。Sun等通過引入Inception和Inception-resnet模塊,提出具有更高特征提取能力且更快的DR-IACNN模型。mAP可以達到81.1%,但速度只有15.01幀/s[27]。綜上,基于CNN的模型已廣泛應用于作物病害的識別和檢測,并取得了良好的效果。但上述檢測模型尚不準確,無法檢測令人困惑的早期蘋果葉部病害。蘋果葉部病害檢測可以被視為目標檢測問題[28]。深度學習模型具有較強的特征表現能力,但深度學習方法在目標檢測問題上比具有人工設置特征的檢測器更具有顯著優勢[29]。在執行目標檢測時,這些深度學習方法要完成檢測幀的定位和分類2項任務。基于深度學習的目標檢測方法主要分為兩級目標檢測算法和一級目標檢測算法[30-31]。兩級目標檢測算法分2個階段實現目標檢測:先從輸入網絡的圖像中提取建議區域,再對每個建議區域進行分類和位置回歸,最后實現目標檢測。單階段目標檢測算法直接生成對象的類概率和位置坐標值,而不需要區域建議階段。算法的典型代表是YOLO、SSD、YOLO v2、YOLO v3、RetinaNet、YOLO v4和YOLO v5。現有的蘋果葉部病害檢測算法存在病害識別效率和識別精度“雙低”等問題。因此,本研究提出一種改進的YOLO v5檢測算法。本研究針對形狀不規則和小目標的蘋果葉部病害問題,提出一種基于改進YOLO v5模型的病害目標檢測算法。并采用ATCSP模塊來改進PANet的結構,引入BiFPN的思想,通過學習得到權重參數來融合不同層的特征映射。它可以過濾其他級別的特征,并將有用的信息保持在該級別,以提高對微小病害的檢測精度。基于Transformer機制設計自注意力模塊,其可以增加有用特征的權重,抑制無效特征的權重,從而提高目標檢測的精度。

1 相關工作

YOLO v5是基于原始的YOLO目標檢測架構設計,并使用近年來卷積神經網絡領域的最佳優化策略,由Glenn Jocher在2020年提出。YOLO v5骨干網絡結合Focus結構和CSP結構,提取輸入樣本中的主要信息。Yolov5使用PANet[32]結構來融合特征層,并在特征層的3個不同尺度上實現預測。YOLO v5體系結構包含4種體系結構,它們之間的主要區別為在網絡特定位置上的特征提取模塊和卷積核的數量有所不同。因此,本研究全面考慮識別模型的準確性、效率和規模,并基于YOLO v5體系結構進行蘋果葉部對象識別網絡的改進設計。原始YOLO v5的網絡結構見圖1。

YOLO v5使用PANet結構來融合和輸出多尺度的特征圖。PANet是一種基于特征金字塔(FPN)的自下而上的增強結構,這是一種雙向融合,而不是原來的單一融合。由圖2可知,PANet由自頂向下的融合路徑和自底向上的融合路徑組成自上而下的融合。它通過2倍上采樣對最近的特征圖X進行調整,并在調整通道后通過1×1卷積將其添加到預層的特征圖Y中。自下而上的融合是自上而下融合的相反過程,即上采樣被下采樣所取代。

2 改進的網絡結構

2.1 BiFPN頭部特征融合網絡

根據Sharma 等的研究結果[33],在頭部網絡的特征融合結構中,與FPN和PAN等其他特征融合結構相比,雙向特征金字塔網絡結構(BiFPN)可以實現更高效的雙向跨尺度連接和加權特征融合。YOLO v3采用的FPN特征融合結構本質上受到單向信息流的限制。該結構從上到下傳輸特征信息,并通過上采樣和低級別特征融合高級別特征,以獲得用于預測的特征圖(圖3-a)。基于FPN特征融合結構,YOLO v4和YOLO v5采用的PAN特征融合結構增加了1個額外的自下而上的路徑聚合網絡(圖3-b),它將淺層定位信息傳輸到深層,并在多個尺度上增強定位能力。Sharma 等提出的BiFPN特征融合結構將雙向(自下而上和自上而下)路徑視為特征網絡層,并多次重復同一層以實現更高級別的特征融合[33](圖3-d)。

Tan 等在此結構的基礎上提出名為EfficientDet的目標檢測算法[34],和同時期的其他目標檢測算法如YOLO v3、MaskRCNN、NAS-FPN等相比,在準確率、檢測速度和運算量上EfficientDet均具有明顯優勢,詳細的試驗數據對比圖見圖4。

EfficientDet與其他算法的性能對比圖顯示,雖然隨著YOLO算法的發展,EfficientDet算法的性能已經比不上YOLO v4和YOLO v5,但是它提出的BiFPN特征融合結構卻值得參考和借鑒,所以本研究將BiFPN特征融合結構引入YOLO v5算法,改進后的YOLO v5模型網絡結構見圖5。

由頭部網絡改進為BiFPN結構的YOLO v5網絡結構可知,本研究對骨干層的網絡進行保留,以輸入640像素×640像素的圖片為例,經過骨干網絡后輸出為1 024個尺寸為4×4的特征圖。在10層采用1×1的卷積核進行步長為1的卷積操作,得到512個尺寸為4×4的特征圖。在11層通過上采樣操作得到尺寸為8×8的特征圖,將在12層與6層得到的512個尺寸特征圖進行拼接,得到1 024個尺寸為8×8的特征圖。在6層通過ATCSP層,采

用3倍層疊,通過多次卷積等操作輸出512個尺寸為 8×8 的特征圖,CSP層的內部結構如圖6所示。

在14~17層采用與10~13層一樣的網絡結構,由14層輸入的1 024個尺寸為8×8的特征圖得到17層輸出的256個尺寸為16×16的特征圖。在18層采用3×3的卷積核進行步長為2的卷積操作,得到256個尺寸為8×8的特征圖。在19層結合BiFPN特征融合模式的思想,采用雙向跨尺度連接,對特征圖尺寸同為8×8的19、14、6層進行多尺度特征融合,得到1 024個尺寸為8×8的特征圖。在20層通過CSP層,采用3倍層疊, 通過多次卷積

等操作輸出512個尺寸為8×8的特征圖。同理,在21~23層采用與18~20層一樣的網絡結構,其中在22層采用雙向跨尺度連接,對特征圖尺寸同為 4×4的22、10、9層進行多尺度特征融合,得到 2 048 個尺寸為4×4的特征圖。最終在23層輸出 1 024 個尺寸為4×4的特征圖,檢測層也保持與原有YOLO v5一致的結構。改進后的模型用于蘋果葉部初次檢測,由于該模型保留了原始YOLO v5模型的骨干網絡,便于對成熟的蘋果葉部檢測的YOLO v5模型進行遷移學習。通過將BiFPN特征融合結構引入YOLO v5算法,在訓練蘋果葉部檢測數據時提升召回率,同時可以有效地提升平均精度。

2.2 自注意力機制

Transformer機制最初是由Vaswani 等提出的[35],用于機器翻譯,并在許多NLP任務中建立最先進的技術。為了使Transformer也適用于計算機視覺任務,已經進行了一些修改。只在每個查詢像素的局部鄰域中應用自注意,而不是全局應用。本研究提出稀疏Transformer,它采用可擴展的近似來實現全局自注意。最近,視覺變壓器(ViT)通過直接將具有全局自關注的Transformer直接應用于全尺寸圖像,實現了最先進的圖像網分類技術。本研究采用Transformer的核心思想,利用注意機制設計Transformer層模塊,其結構如圖7所示。Transformer層包含多頭注意結構,多頭注意力模塊結構如圖8所示。

多頭自注意力模塊是設計特征融合網絡的基本組成部分。計算公式為

Attention(Q,K,V)=softmaxQKTdkV。(1)

式中:Q表示查詢向量;K表示鍵向量;V表示值向量。

將注意機制擴展到多個頭部,使該機制能夠考慮不同的注意分布,并使模型關注信息的不同方面。多頭注意機制見公式(2)。

MuitiHead(Q,K,V)=Concat(H1,…,Hi)W;(2)

Hi=Attention(QWQi,KWKi,VWIVi)。(3)

式中:Hi表示第i個頭的輸出;W是輸出變換矩陣;WQi、WKi、WVi均表示第i個頭的查詢、鍵、值變換矩陣。

不同蘋果葉片病害感染的區域大小不一,同一病害的病斑大小仍然不固定。對于銹病和鏈格孢菌斑病而言,具有小斑點簇疾病的銹病病斑通常是油性橙色并從葉表面突出。相比之下,病斑鏈格孢菌斑點是棕褐色的,在病斑處枯萎;疾病斑點是灰色的,且在疾病斑點內部具有網格形狀。就蚜蟲而言,蚜蟲連續成簇分布并集中在嫩葉上。對于蜘蛛螨而言,疾病斑點也是方格的,但呈淺黃色,感染區域較大。對于感染整張葉片的病害,花葉感染的葉片上覆蓋著亮黃色的斑點,褐斑病感染的葉片是黃色的,白粉病感染的葉片上覆蓋著1層白色粉末,葉子變得卷曲,這給特征提取帶來了困難。

雖然BiFPN可以提取早期蘋果葉病的主要特征,但由于卷積核大小相同,該模型無法提取多尺度斑點的特征。此外,詳細特征沒有與抽象特征融合,因此網絡無法充分結合淺層位置信息和深層語義信息并加以利用。因此,有必要融合攜帶不同信息的特征圖。

在特征金字塔部分使用ATCSP模塊,通過并行化多個不同核大小的最大池化層,增強模型對多尺度疾病的檢測效果。BiFPN結構使用自上而下的特征融合方法,從上到下傳達強大的語義信息。相比之下,PANet使用自下而上的特征融合方法,從下到上傳達強大的定位信息。因此,BiFPN中的上采樣特征圖與骨干網絡中的淺層特征圖融合,PANet中的下采樣特征圖與FPN中的特征圖輸出融合。

3 結果與分析

3.1 蘋果葉部病害數據集

本試驗于2022年9月至2023年5月在塔里木大學園藝試驗站進行,所使用的數據集由筆者所在實驗室采集的蘋果樹葉片樣本構成,包含3 331張標記圖像的矩形位置來標記病害。其中,數據集中調整為512 像素×512像素用于訓練目的。通過LabelImg圖像處理工具,將蘋果病害圖像中病變的位置信息和類別信息寫入相應的xml文件中。之后,數據按訓練集 ∶測試集=7 ∶3的比例隨機劃分,形成VOC格式的數據集,其包括“斑點落葉病(alternaria boltch)”“褐斑病(brown spot)”“灰斑病(grey spot)”“花葉病(mosaic)”“銹病(rust)”5種病害。

3.2 數據增強

由于數據集受到室外光照的影響,在拍攝過程中會使圖像整體亮度分布不均勻,在圖像部分位置亮度過亮或過暗,因此需要調整圖像的對比度,實現對圖像的增強。

3.2.1 直方圖均衡化

圖像直方圖是表示圖像中亮度分布的直方圖,描述了圖像中每個亮度值的像素數,直方圖均衡化是通過改變圖像直方圖來改變圖像中各像素的灰度值,把原始圖像的直方圖變換為均衡的形式,對像素數量較多的灰度值進行擴展,對像素數量較少的灰度值進行并歸,從而增大對比度,達到對圖像增強的效果。

直方圖均衡化的數學表達式為

Sk=T(rk)=∑kj=0njn,k=0,1,…,L-1。(4)

式中:nj表示rk的像素數;n表示像素總數;k表示灰度級數;L表示可能出現的灰度級總數。

直方圖均衡化后的圖像整體亮度提升,但對于圖像中地面上過亮的區域更亮,所在過暗的區域沒有起到明顯的增強效果。

3.2.2 改進直方圖均衡化

針對上述直方圖均衡化對圖像過亮或過暗的區域沒有明顯增強的問題,利用自適應閾值的方法對圖像直方圖均衡化,通過對圖像局部對比度的調整使整幅圖像的對比度得到增強。

首先將圖像分成多個小塊,分別計算每個小塊圖像的直方圖,然后根據每個小塊圖像直方圖的峰值,計算每個小塊圖像的閾值,同時為了防止每個小塊圖像的對比度過高或過低,圖像子塊之間的對比度差距過大,從而引入新的噪聲,因此需要對每個子塊的閾值進行限制,主要根據相鄰塊的閾值進行插值獲得,使得整幅圖像的閾值低于某個限制值。通過動態調整找到圖像直方圖的某個閾值X,使過高幅值的小塊圖像直方圖降至閾值X,同時對于幅值過低的區域進行填補,通過調整整幅圖像的局部閾值,從而解決圖像過亮或過暗的區域對比度沒有明顯增強的問題。

直方圖均衡化后的蘋果葉部圖像整體亮度大幅度提升,圖像中亮度較大的區域圖像對比度增強效果較明顯,而自適應直方圖均衡化可以有效解決圖像過亮或過暗的區域對比度沒有明顯增強的問題,使整幅圖像對比度得到增強,減小后續圖像特征提取的計算量。對訓練集原始疾病圖像進行旋轉、隨機亮度增強、隨機色度增強、隨機對比度增強和銳化,經過數據增強后的數據集如圖9所示。

3.3 訓練環境和評價指標

為了衡量改進的算法相比原始算法的性能改善情況,本研究采用mAP@0.5、mAP@0.5 ∶0.95和召回率(R)作為評價指標。

精度(P)為所有預測出的目標中預測正確的目標所占的比例,計算公式為

P=TPTP+FP。(5)

召回率(R)為所有標注為正確的目標中預測正確的目標所占的比值,計算公式為

R=TPTP+FN。(6)

其中:上述2個公式中的參數TP表示預測正確的正面示例數;FP表示預測錯誤的反面示例數;FN表示預測錯誤的正面示例數;TN表示預測正確的反面示例數。

平均精度(AP)是衡量訓練出的網絡模型在單個類別上優劣的重要指標,其計算公式為

AP=∫10P(R)dR。(7)

所有類別的平均精度(mAP)是衡量訓練出的網絡模型在每個類別上的平均優劣的重要指標,是指取所有類別上AP的平均值,它通常分為mAP@0.5和mAP@0.5 ∶0.95。其中,mAP@0.5是指將IoU設為0.5時,所有類別的所有圖片AP的平均值;mAP@0.5 ∶0.95是指IoU閾值從0.5到0.95,步長0.05上的平均mAP。IoU是指預測框和真實框的交集部分的面積與預測框和真實框的并集部分的面積比值。IoU和mAP的計算公式分別為:

IoU=SoverlapSunion;(8)

mAP=∑Ni=1APiN。(9)

3.4 試驗結果分析

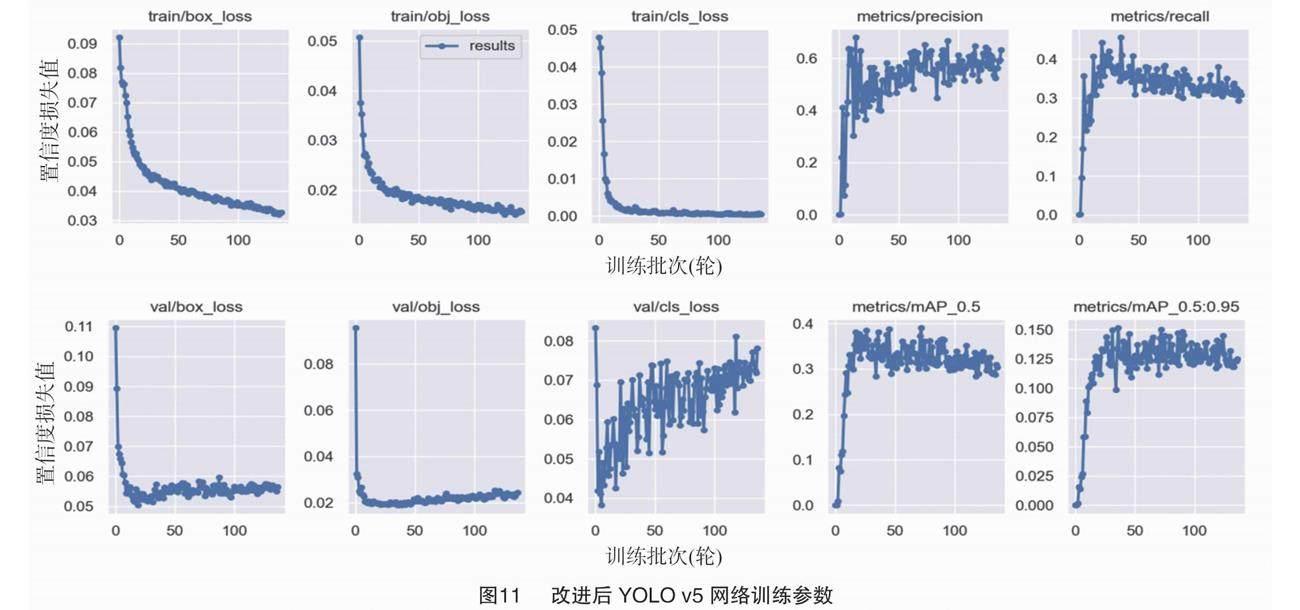

葉部病害檢測應同時考慮精確度和召回率,原始網絡訓練參數見圖10,改進后的網絡訓練結果見圖11。本研究利用mAP、召回率等參數來驗證模型的性能,并對檢測結果進行評價。為了確認改進后YOLO v5網絡的各組件對最終性能的影響,通過ATCSP模塊的整合,mAP@0.5從0.323 1提高到0.390 4,提高幅度為20.8%,召回率從0.305 96提升到0.455 85,提高幅度為49.0%。表明改進后的YOLO v5可以過濾其他級別的特征,并將有用的信息保持在該級別,以提高對小病害的檢測精度。在此基礎上,再采用Transformer機制設計Transformer層模塊,它可以增加有用特征的權重,抑制無效特征的權重,利用多頭注意結構,提高目標檢測精度。

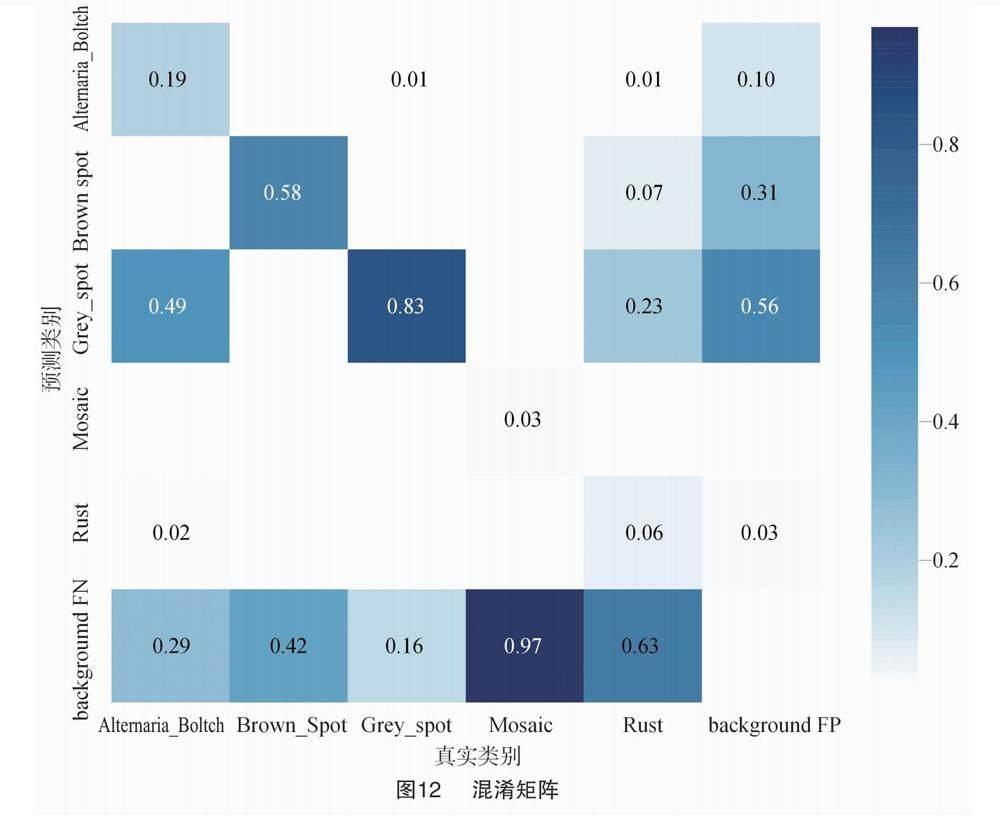

此外,改進后YOLO v5網絡全面評估了BiFPN對多尺度學習的能力。在評價指標IoU=0.95的情況下,mAP的差距也很明顯,表明BiFPN對多尺度對象特別是小對象檢測的有效性。另外,當召回率為0.15時,改進后YOLO v5網絡比原始YOLO v5網絡高出很多。檢測模型在面對容易混淆的疾病斑點時可能會混淆,而相同的疾病卻不同,使分類更加困難。采用歸一化后的混淆矩陣直觀評價改進后的YOLO v5對5種早期蘋果葉片病害的分類性能,結果見圖12,該模型在棕色斑點上的分類性能最好,大部分樣本的預測都正確。

相比之下,改進后的YOLO v5模型對銹病和花

葉病2種輕微斑點病的檢測性能較差,特別是花葉病,只有超過3%的樣本被正確預測。造成該結果的主要原因是早期的花葉病斑點較小,斑點特征不明顯且容易聚集。因此,該模型很難正確提取和區分早期花葉病的特征。

本研究還給出每種疾病的F1分數曲線,以便進行更全面的模型評估。F1分數是精度和召回率總和的平均值,在評估模型時將兩者考慮在內。由圖13可知,當置信水平在0.2~0.7之間時,模型對所有疾病的F1平均得分都很高,而在置信水平為0.134時,F1平均得分最高,為0.390。結果表明,改進后的YOLO v5能夠較好地對5種早期蘋果葉片病害進行分類,能夠滿足實際應用場景的檢測需求。

4 結論

本研究提出的改進YOLO v5蘋果葉部病害檢

測方法,可以在農業生產中發揮較大的作用。采用ATCSP結構來滿足蘋果葉部病害實時檢測的要求,引入自注意力機制的模塊可以精確地檢測出特定的蘋果葉部病害。經過遷移學習后,淺層特征提取網絡可以快速收斂并保持超過原始網絡的檢測精度,同時檢測普遍存在的病害和特定的病害,更好地利用不同任務之間的互補性。為了更好地提高病害檢測性能,引入跨階段局部網絡,在試驗部分對改進算法進行評估,與其他主流算法進行比較,發現改進后的算法適用于蘋果葉部病害的自動檢測任務,可以較好地提高病害檢測的準確性和效率,進而提高農業生產的信息化水平。

參考文獻:

[1]Srinivasan K,Dastoor P H,Radhakrishnaiah P,et al. FDAS:a knowledge-based framework for analysis of defects in woven textile structures[J]. Journal of the Textile Institute,1992,83(3):431-448.

[2]彭明霞,夏俊芳,彭 輝. 融合FPN的Faster R-CNN復雜背景下棉田雜草高效識別方法[J]. 農業工程學報,2019,35(20):202-209.

[3]謝金衡,張炎生. 基于深度殘差和特征金字塔網絡的實時多人臉關鍵點定位算法[J]. 計算機應用,2019,39(12):3659-3664.

[4]劉 洋,馮 全,王書志. 基于輕量級CNN的植物病害識別方法及移動端應用[J]. 農業工程學報,2019,35(17):194-204.

[5]王 聃,柴秀娟. 機器學習在植物病害識別研究中的應用[J]. 中國農機化學報,2019,40(9):171-180.

[6]Usha Devi G,Gokulnath B V. A survey on plant disease prediction using machine learning and deep learning techniques[J]. Inteligencia Artificial,2020,23(65):136-154.

[7]Govardhan M,Veena M B. Diagnosis of tomato plant diseases using random forest[C]//2019 Global Conference for Advancement in Technology.Bangalore,2019:1-5.

[8]Han K,Wang Y H,Tian Q,et al. GhostNet:more features from cheap operations[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Seattle,2020:1577-1586.

[9]He K M,Zhang X Y,Ren S Q,et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2015,37(9):1904-1916.

[10]He K M,Zhang X Y,Ren S Q,et al. Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition.Las Vegas,2016:770-778.

[11]Howard A G,Zhu M L,Chen B,et al. MobileNets:efficient convolutional neural networks for mobile vision applications[EB/OL]. 2017:arXiv:1704.04861.http://arxiv.org/abs/1704.04861.

[12]Krizhevsky A,Sutskever I,Hinton G E. ImageNet classification with deep convolutional neural networks[J]. Communications of the ACM,2017,60(6):84-90.

[13]Lin T Y,Dollár P,Girshick R,et al. Feature pyramid networks for object detection[C]//Conference on Computer Vision and Pattern Recognition.Honolulu,2017:936-944.

[14]Liu B,Ding Z F,Zhang Y,et al. Kiwifruit leaf disease identification using improved deep convolutional neural networks[C]//44th Annual Computers,Software,and Applications Conference.Madrid,2020:1267-1272.

[15]Liu S,Qi L,Qin H F,et al. Path aggregation network for instance segmentation[C]//Conference on Computer Vision and Pattern Recognition.Salt Lake,2018:8759-8768.

[16]Liu W,Anguelov D,Erhan D,et al. SSD:single shot MultiBox detector[M]//Leibe B,Matas J,Sebe N,et al. Computer vision-ECCV 2016.Cham:Springer International Publishing,2016:21-37.

[17]Loey M,ElSawy A,Afify M. Deep learning in plant diseases detection for agricultural crops[J]. International Journal of Service Science,Management,Engineering,and Technology,2020,11(2):41-58.

[18]Prashar K,Talwar R,Kant C. Robust automatic cotton crop disease recognition (ACDR) method using the hybrid feature descriptor with SVM[C]. International Conference on Computing on Sustainable Global Development,2017.

[19]Redmon J,Divvala S,Girshick R,et al. You only look once:unified,real-time object detection[C]//Conference on Computer Vision and Pattern Recognition.Las Vegas,2016:779-788.

[20]Redmon J,Farhadi A. YOLO9000:better,faster,stronger[C]. Conference on Computer Vision and Pattern Recognition,2017.

[21]Redmon J,Farhadi A. YOLO v3:an incremental improvement[EB/OL]. arXiv:1804.(2018-04-08)[2023-05-10]. http://arxiv.org/abs/1804.02767.

[22]Ren S Q,He K M,Girshick R,et al. Faster R-CNN:towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(6):1137-1149.

[23]Sethy P K,Barpanda N K,Rath A K. Detection and identification of rice leaf diseases using multiclass SVM and particle swarm optimization technique[J]. J Innovative Tech and Exploring Eng,2019,8(6S2):108-120.

[24]Sethy P K,Barpanda N K,Rath A K,et al. Image processing techniques for diagnosing rice plant disease:a survey[J]. Procedia Computer Science,2020,167:516-530.

[25]SimonyanK,ZissermanA.Verydeepconvolutionalnetworksfor

large-scale image recognition[EB/OL]. 2014:arXiv:1409.1556.http://arxiv.org/abs/1409.1556.

[26]Sun H N,Xu H W,Liu B,et al. MEAN-SSD:a novel real-time detector for apple leaf diseases using improved light-weight convolutional neural networks[J]. Computers and Electronics in Agriculture,2021,189:106379.

[27]Sun Y Y,Jiang Z H,Zhang L P,et al. SLIC_SVM based leaf diseases saliency map extraction of tea plant[J]. Computers and Electronics in Agriculture,2019,157:102-109.

[28]Szegedy C,Liu W,Jia Y Q,et al. Going deeper with convolutions[C]//Conference on Computer Vision and Pattern Recognition.Boston,2015:1-9.

[29]Turkoglu M,Yanikogˇlu B,Hanbay D. PlantDiseaseNet:convolutional neural network ensemble for plant disease and pest detection[J]. Signal,Image and Video Processing,2022,16(2):301-309.

[30]Wang C Y,Mark Liao H Y,Wu Y H,et al. CSPNet:a new backbone that can enhance learning capability of CNN[C]//Conference on Computer Vision and Pattern Recognition Workshops.Seattle,2020:1571-1580.

[31]Woo S,Park J,Lee J Y,et al. CBAM:convolutional block attention module[C]//European Conference on Computer Vision.Cham:Springer,2018:3-19.

[32]Xie X Y,Ma Y,Liu B,et al. A deep-learning-based real-time detector for grape leaf diseases using improved convolutional neural networks[J]. Frontiers in Plant Science,2020,11:751.

[33]Sharma N,Gupta S,Reshan M S A. EfficientNetB0 cum FPN based semantic segmentation of gastrointestinal tract organs in MRI scans[J]. Diagnostics,2023,13(14):2399.

[34]Tan M,Pang R,Le Q V. Efficientdet:scalable and efficient object detection[C]. Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2020:10781-10790.

[35]Vaswani A,Shazeer N,Parmar N,et al. Attention is all you need[C]//Conference on Natural Information Processing Systems. Long Beach,2017.