基于改進型MBLLEN網絡的內窺鏡圖像增強算法研究

關鍵詞:內窺鏡圖像;圖像增強;MBLLEN;U-Net;Hessian矩陣

中圖分類號:TP391 文獻標志碼:A

0 引言(Introduction)

目前,已有許多增強算法應用于內窺鏡圖像的亮度與細節增強,例如傳統算法有伽馬變換、Retinex技術[1]、圖像空間轉換[2-3]、Txi算法[4]、導向濾波[5]。在深度學習方面,有許多無監督學習低光圖像增強算法,例如XU 等[6]提出的SNR(Signal-to-Noise-Ratio)網絡、MA 等[7] 提出的SCI(Self-Calibrated Illumination)網絡及WU 等[8]提出的URetinex(Unfolding Retinex)網絡。

內窺鏡圖像的亮度不均勻,傳統算法僅能簡單地改變全局像素信息,并且無監督低微光增強網絡沒有明確的學習目標,缺乏解釋性,這些算法的應用結果均會產生色調改變及圖像噪聲。MBLLEN網絡是LV等[9]提出的一種有監督的低光增強網絡,具有多分支結構,解釋性較好,但其增強結果仍存在色調改變問題。因此,本研究改進了低光照增強MBLLEN網絡結構。為了解決內窺鏡圖像場景語義信息較少和深層CNN(Convolutional Neural Network)會出現梯度消失導致內窺鏡圖像亮度增強帶來的色調改變問題,本研究還引入了Hessian矩陣的特征值,對全局線性結構做細節后處理增強。本研究提出的增強算法能在確保內窺鏡圖像質量的同時,實現出色的亮度和細節表現。

1 研究方法(Method)

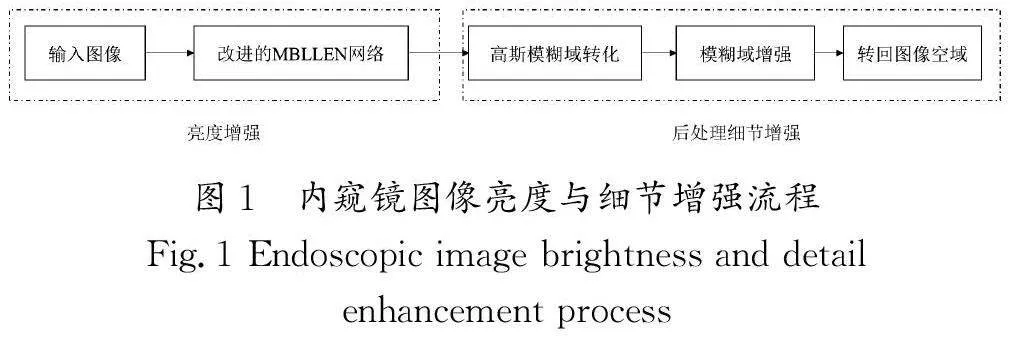

本研究構建了內窺鏡圖像亮度增強數據集,并采用改進的MBLLEN網絡有監督地對內窺鏡圖像進行增強。在亮度增強的內窺鏡圖像基礎上,將其轉化至高斯模糊域,引入Hessian矩陣的特征值,對內窺鏡的全局線性細節進行增強,然后轉回圖像空域。內窺鏡圖像亮度與細節增強流程如圖1所示。

2 改進型MBLLEN 網絡(Improved MBLLENnetwork)

2.1 數據集預處理

內窺鏡圖像數據集中的亮度特征大致可以分為低光、光照正常、高光3類。由于高光的內窺鏡圖像較少,因此本文基于The Kvasir Dataset[10]內窺鏡數據集中的低光圖像和光照正常圖像合成內窺鏡光照增強數據集。

針對兩種亮度特征的圖像,對V通道做不同的亮度處理。針對低光圖像,對其V通道做γ值大于1且小于1.5的伽馬變換隨機進行亮度恢復,目的是得到視覺效果較好的內窺鏡圖像;針對光照良好的圖像,對其V 通道做γ值小于1且大于0.5的伽馬變換隨機進行亮度衰減,目的是模擬亮度衰減情況下的內窺鏡圖像。最終得到亮度視覺較差和亮度視覺良好的內窺鏡圖像對作為數據集。伽馬變換如公式(1)所示:

2.2 改進型MBLLEN

MBLLEN是有監督多分支結構的深度神經網絡,它能夠學習低微光圖像的亮度特征并進行增強。在內窺鏡圖像亮度增強任務中,MBLLEN的特征提取層深度較深,而醫學圖像語義信息有限,存在冗余的特征提取卷積層和遺忘特征信息等問題。同時,原有的特征增強模塊無法增強深層次的信息,因此本研究對MBLLEN網絡進行改進,對亮度受損的內窺鏡圖像進行增強。

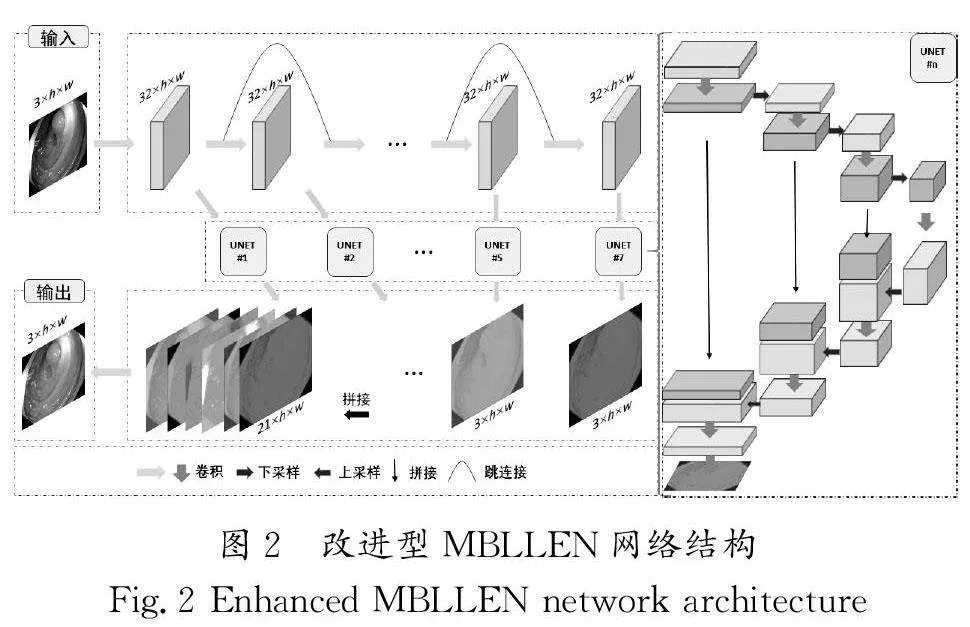

改進型MBLLEN 網絡結構如圖2所示。本文調整了MBLLEN的卷積特征提取層的深度,將其修改為7層以解決深層網絡丟失信息的問題。同時,為了防止梯度趨近零和加速收斂,用跳連接對特征提取層前后進行連接,使用U-Net結構替換了原有的特征增強層,用于增強內窺鏡圖像中深層次的亮度信息。

改進后的MBLLEN網絡包含3種模塊,即特征提取模塊、特征增強模塊及融合模塊。

(1)特征提取模塊是一個單流網絡,具有7層卷積網絡,每一層都采用卷積核大小為3×3的卷積,步長為1,填充大小為1,使用ReLU非線性激活函數。第一層的輸入是低光照內窺鏡圖像,接下來6層的輸入都是前一層的輸出特征,也是特征增強模塊的輸入。特征提取模塊每一層的輸出結果尺寸均為32×h×w。

(2)特征增強模塊為U-Net結構,其數量等于特征提取層模塊的層數。每個增強模塊的輸入都是特征提取層的結果,輸出是與輸入圖像大小相同的三通道圖像。U-Net的壓縮路徑包含3次下采樣,擴展路徑包含3次上采樣。壓縮路徑的下采樣采用卷積核大小為3×3的卷積,步長為1,填充大小為1,每層的特征融合是卷積核大小為3×3的卷積,步長為1,沒有填充;擴展路徑的上采樣采用卷積核大小為3×3的反卷積,步長為2,填充大小為1,額外填充大小為1。每層的特征融合采用的卷積核大小與壓縮路徑保持一致,保證輸入尺寸與輸出尺寸一致。所有的特征增強模塊同時訓練,但是沒有共享任何學到的參數。

(2)融合模塊接收所有特征增強模塊的輸出結果,生成最后的增強輸出結果。所有的增強輸出結果會被連接到一起,使用卷積核大小為1×1的卷積將圖像按權相加在一起。

3 圖像后處理(Image post-processing)

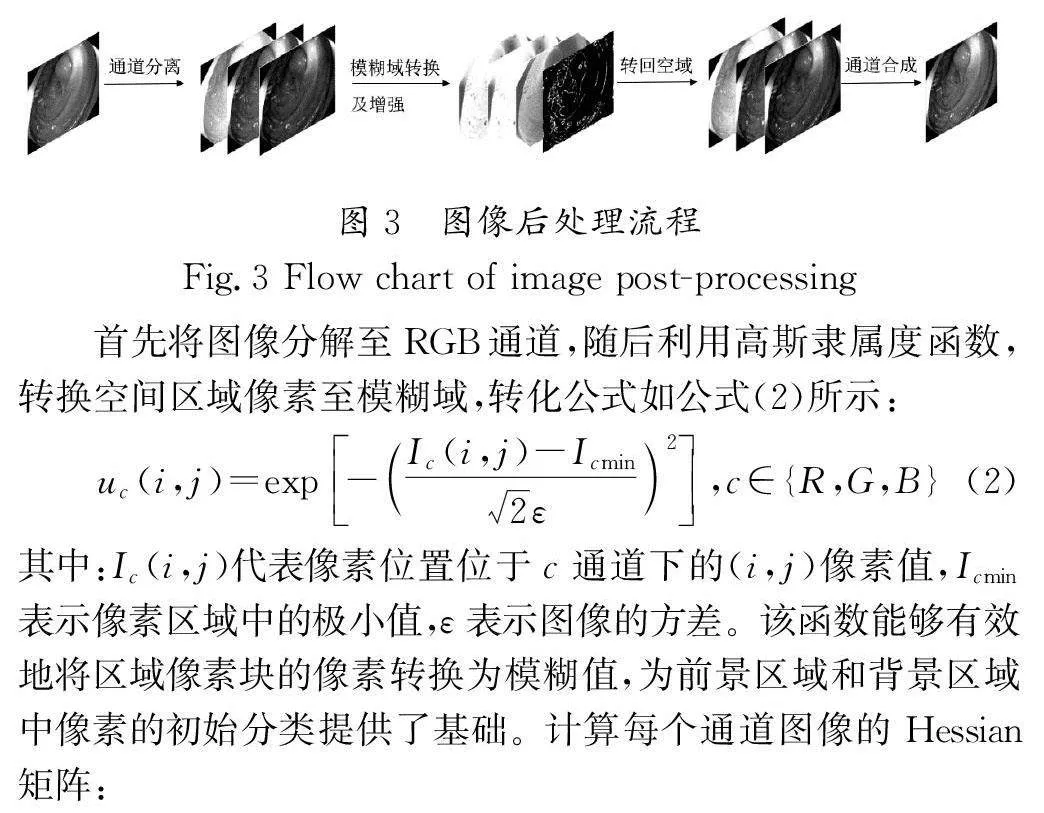

除了提升內窺鏡圖像亮度,本文還提出了一種基于圖像Hessian矩陣特征值的隸屬度增強算法,用于改善內窺鏡圖像中線性細節的表現,圖像后處理流程如圖3所示。

4 實驗及結果分析(Experiment and resultanalysis)

4.1 實驗數據集

本研究采用The Kvasir Dataset[10]胃腸道公開數據集,它包含8個不同類別的內窺鏡圖像,其中解剖標志有3類,病理結果有3類,內鏡檢查程序有2類。在The Kvasir Dataset中選取2 000張內窺鏡圖像,包含Z線、食管、胃腸等組織區域。選取其中的200張圖像作為驗證集,其余1 800張圖像作為訓練集。對訓練集數據進行擴增處理,包含翻轉、旋轉、高斯噪聲、高斯模糊4種操作,將圖像擴增到9 000張。

4.2 實驗環境與配置

改進型MBLLEN的優化器選取SGD(Stochastic GradientDescent),初始學習率設置為0.002,權重衰減系數設置為0.000 1,β1=0.9,β2=0.999。實驗平臺采用Ubuntu 16.04操作系統,搭載24 GB顯存的GeForce RTX 3090GPU進行實驗評估,利用開源深度學習框架Pytorch-1.13實現。

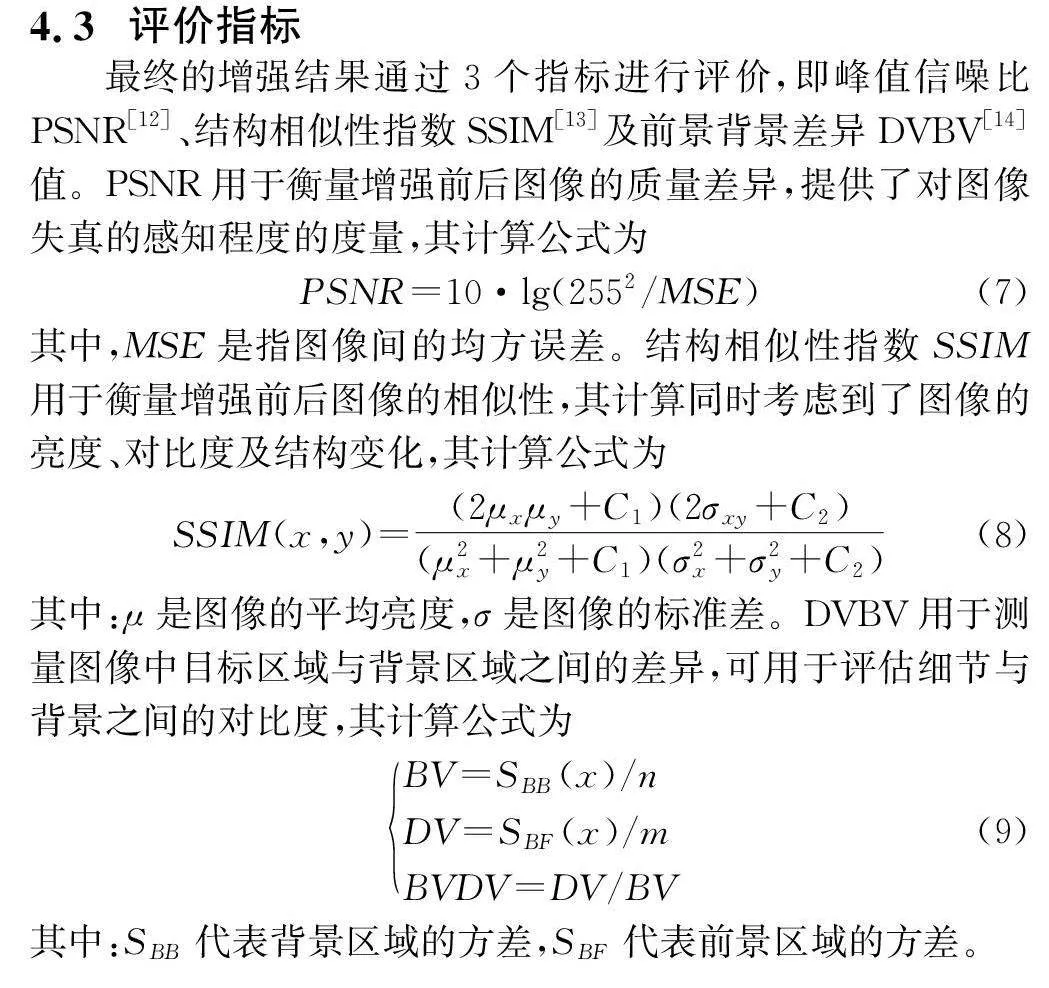

4.3 評價指標

4.4 實驗結果與分析

為了驗證改進型MBLLEN結構的優越性,本研究設計了消融實驗比較改進前后的結構在數據集中的損失收斂差異,損失函數在不同結構下的表現如圖4所示。圖4中,A代表原MBLLEN網絡結構,損失函數在20個epoch左右時收斂;B代表改為7層特征提取的MBLLEN網絡結構,損失函數在15個epoch左右時收斂;C代表改成7層特征提取和增加了跳連接的MBLLEN網絡結構,損失函數在17個epoch左右時收斂;D代表改成7層特征提取和U-Net的MBLLEN網絡結構,損失函數在15 個epoch 左右時收斂;E 代表全部改進下的MBLLEN網絡結構,損失函數在8個epoch左右時收斂。通過對比A與B發現,改成7層的特征提取MBLLEN網絡由于網絡變淺,損失函數收斂速度加快,但與原結構的收斂結果幾乎沒有差距,所以本研究不討論原結構與7層特征提取結構的具體差異。通過對比B與C發現,跳連接結構緩解了網絡中的梯度消失問題,提高了梯度的有效傳播,加速了網絡的收斂,并且更容易記住圖像中的重要特征,使損失的收斂結果趨近0。通過對比B與D發現,U-Net結構在多層次上學習圖像的局部和全局特征,加速了網絡的收斂,并且收斂速度比C結構更快,但收斂結果與C結構相近。通過對比C、D、E發現,本文改進結構中的每一部分都對模型加速收斂起到了一定的作用,并且能將損失收斂至最低,與內窺鏡圖像的適應性更好。A和B的模型輸出結果接近,如圖5中的MBLLEN所示;C、D、E的模型輸出結果接近,如圖5中的本文算法;模型的圖像輸出結果也顯示出改進后的模型與內窺鏡圖像具有更好的適配性。

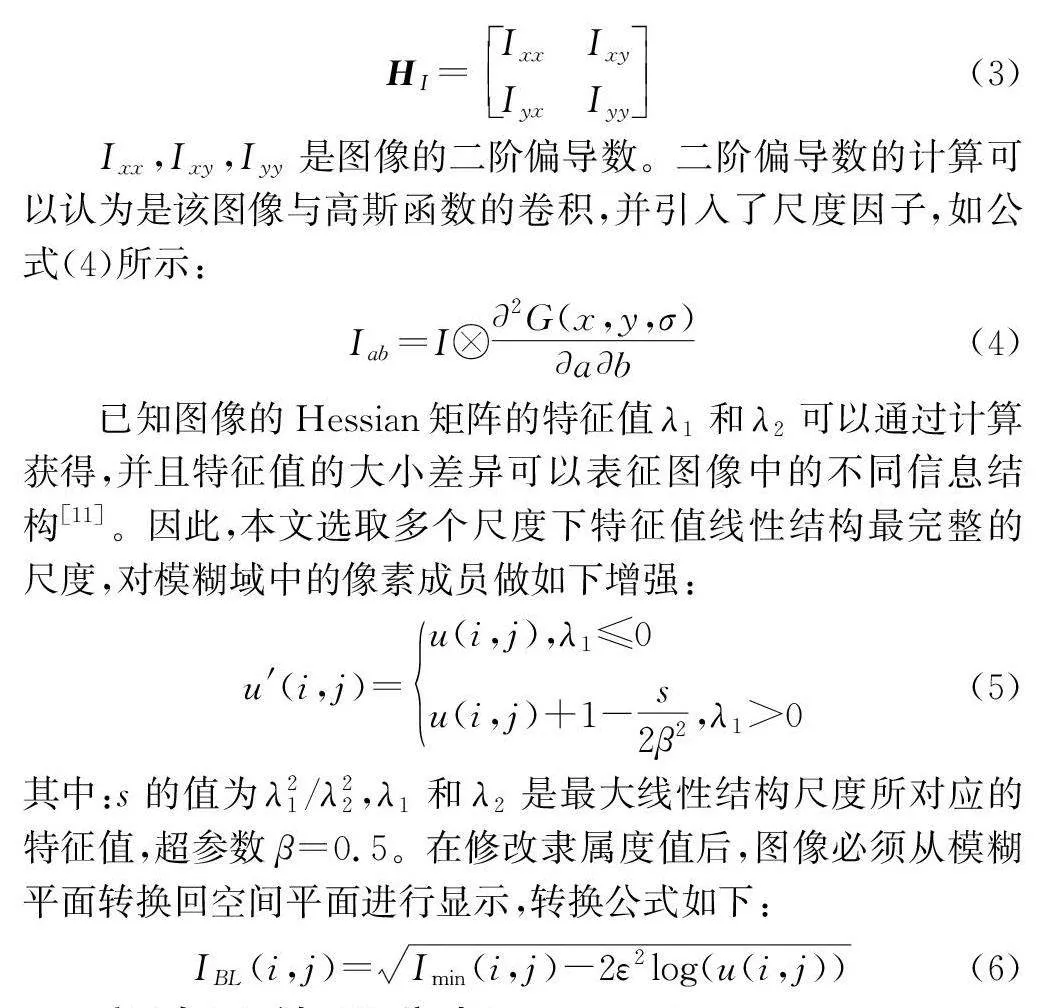

為了驗證本文算法的主觀有效性,將算法的結果與其他主流方法得到的結果進行對比,選取典型的兩張實驗結果(圖5和圖6),從視覺上可以觀察到Retinex、原結構MBLLEN、URetinex以及SCI算法在提高內窺鏡亮度的同時,改變了圖像的色調,增強算法調高了像素的亮度表現,同時降低了圖像的質量,破壞了原圖像結構;SATO[4]和ZHANG等[5]提出的內窺鏡增強算法為圖像展示了更多的血管或邊緣細節,但提高的亮度有限且引入了不必要的細節噪聲;本文算法的結果在亮度及線性細節前景增強前后的圖像質量幾乎沒有降低,可以從圖像中觀察到更多的血管細節和組織邊緣強度。

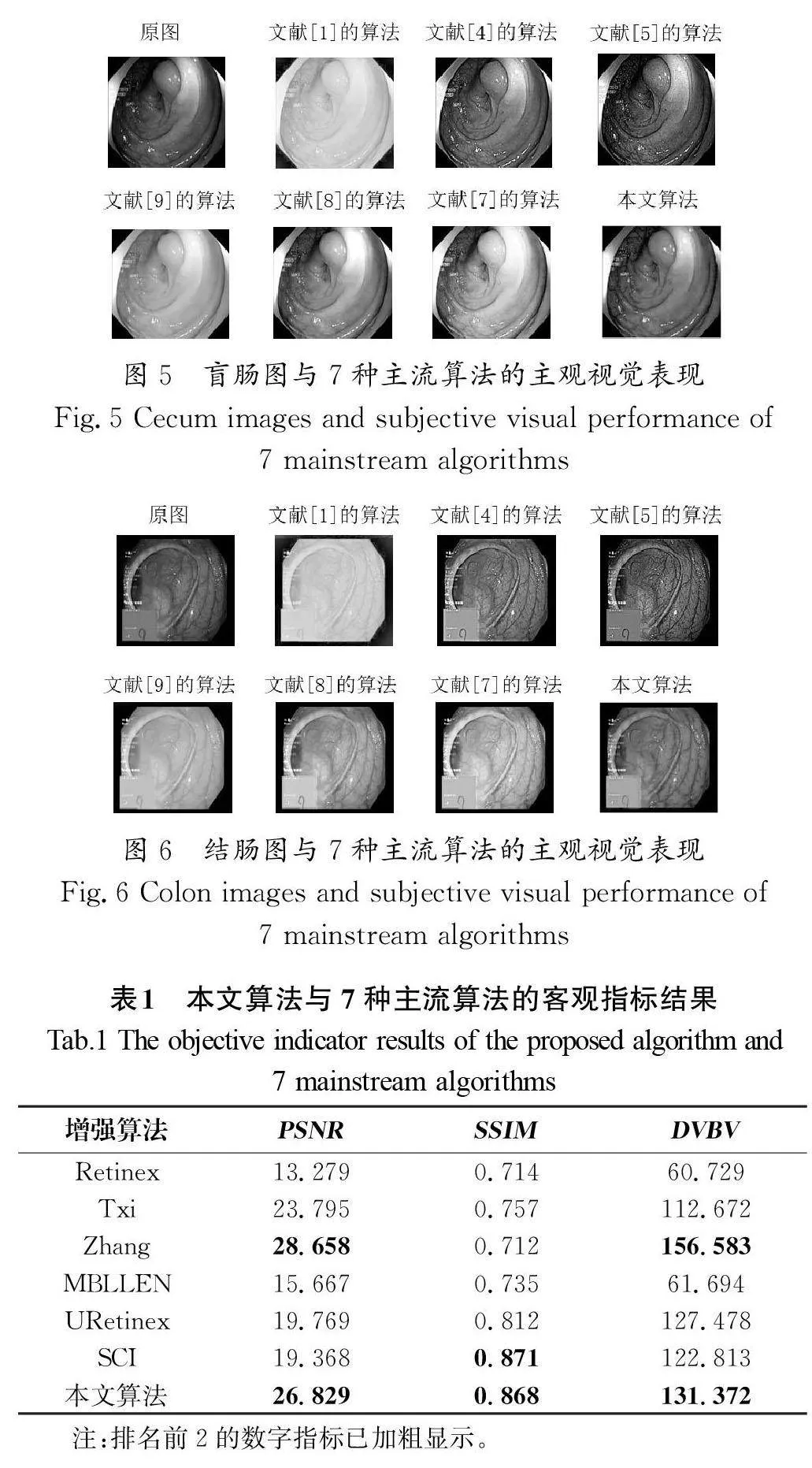

為驗證本文算法的客觀有效性,我們在200張驗證集上應用了主流算法,并計算了平均指標,結果如表1所示。表1中的結果表明,本文提出的內窺鏡圖像亮度與細節增強算法相較于改進前的MBLLEN在PSNR、SSIM、DVBV三項指標上均有較大的提升;同時,與其他6種主流圖像增強算法的對比結果顯示,在PSNR和DVBV指標方面,僅落后于文獻[5]中的改進引導濾波算法,在SSIM 指標方面,僅落后于引入自校準模塊的SCI算法,總體排名前列。客觀指標說明,本文算法能夠在保證圖像的質量與結構的前提下,提高圖像的亮度及線性細節前景對比度。

5 結論(Conclusion)

本研究提出了一種改進型MBLLEN網絡的內窺鏡圖像亮度與細節增強算法。首先,建立了內窺鏡圖像亮度增強數據集。其次,利用改進結構下的MBLLEN算法對內窺鏡圖像進行亮度增強,在原有的MBLLEN結構中縮短了特征卷積層,使用跳連接方式,將增強模塊替換成U-Net結構,能夠提高內窺鏡圖像特征的學習效率,并得到更擬合的亮度增強結果。最后,對內窺鏡圖像做高斯隸屬度轉化,引入Hessian矩陣特征值對圖像像素的模糊域進行線性增強。消融實驗證明了改進型MBLLEN網絡結構的有效性,并且在主流的6種圖像增強算法中,本研究增強的結果在主觀視覺上表現良好,200張驗證集的增強結果平均PSNR值為26.829,SSIM 值為0.868和DVBV值為131.372,在主流算法的增強結果中客觀指標排名靠前,滿足內窺鏡圖像在確保圖像質量未改變的同時,提高亮度與細節表現的要求。

作者簡介:

王利鋼(1999-),男,碩士生。研究領域:圖像與視頻處理技術。

童基均(1977-),男,博士,教授。研究領域:人工智能,醫學圖像處理。

陳佳龍(2000-),男,碩士生。研究領域:圖像與視頻處理技術。

劉軼丞(2000-),男,碩士生。研究領域:圖像與視頻處理技術。