基于高級語義及注意力的肺結(jié)節(jié)分割模型

摘" 要: 為了能夠早些發(fā)現(xiàn)肺結(jié)節(jié)患者,進(jìn)行有效的預(yù)防和治療,便能夠大大提升肺癌患者的生存率,針對醫(yī)學(xué)CT圖像肺結(jié)節(jié)分割時存在異質(zhì)性,會導(dǎo)致分割精度降低,提出一種基于高級語義及注意力的肺結(jié)節(jié)分割模型。該模型使用VGG16作為主干網(wǎng)絡(luò)搭建U?net模型;采用金字塔池化模塊(PPM),在盡可能保留原信息的情況下,將深層信息進(jìn)行加強提取,得到更加豐富的高級語義信息;同時利用CA注意力機制強化重要的特征,實現(xiàn)空間和通道方向上的信息整合;使用Focal Loss和Dice Loss函數(shù)解決肺結(jié)節(jié)分割中前背景不均衡和難區(qū)分的問題。實驗結(jié)果顯示,所提出的方法在IoU、[F1]分?jǐn)?shù)指標(biāo)上較U?net分割算法分別提高了1.33%、0.95%,有效地提升了分割精度,解決了與其他組織對比度低的問題。

關(guān)鍵詞: 深度學(xué)習(xí); 醫(yī)學(xué)CT圖像; 肺結(jié)節(jié)分割; U?net; 注意力機制; 金字塔池化; 損失函數(shù); 分割精度

中圖分類號: TN911.73?34; TP391.41" " " " " " " " " 文獻(xiàn)標(biāo)識碼: A" " " " " " " " 文章編號: 1004?373X(2024)05?0060?05

Pulmonary nodule segmentation model based on advanced semantics and attention

FENG Xiaoyu, WANG Mingquan, LI Leilei, ZHU Huanyu, LI Wenbo, XIE Shaopeng

(School of Information and Communication Engineering, North University of China, Taiyuan 030051, China)

Abstract: Detecting lung nodule patients early and carrying out effective prevention and treatment can greatly improve the survival rate of lung cancer patients. However, there is heterogeneity in the segmentation of lung nodules in medical CT (computed tomography) images, which will reduce the segmentation accuracy. In view of this, a lung nodule segmentation model based on advanced semantics and attention is proposed. VGG16 is used as the backbone network to build the model U?net. The pyramid pooling module (PPM) is adopted to strengthen the extraction of deep information while retaining the original information as much as possible, so as to obtain more abundant high?level semantic information. The CA (coordinate attention) mechanism is used to strengthen important features and realize spatial and channel direction information integration. Focal loss and dice loss functions are used to solve the problem of unbalanced background and difficult distinction in pulmonary nodule segmentation. The experimental results show that the proposed method improves 1.33% and 0.95% in IoU (intersection over union) and [F1]?score metrics in comparison with the U?net segmentation algorithm, so it can effectively improve the segmentation accuracy and solves the problem of low contrast with other tissues.

Keywords: deep learning; medical CT image; pulmonary nodule segmentation; U?net; attention mechanism; pyramid pooling; loss function; segmentation accuracy

0" 引" 言

隨著肺癌死亡率的不斷增加[1?3],研究者們對于肺部疾病的深入研究也成為必然。肺結(jié)節(jié)的大小、形狀會影響到肺部惡化,如果能夠早些發(fā)現(xiàn)肺結(jié)節(jié),并進(jìn)行有效的預(yù)防和治療,便能夠大大提升肺癌患者的生存率。如今計算機斷層掃描(Computed Tomography, CT)技術(shù)[4?6]不斷發(fā)展,為肺部掃描進(jìn)行肺結(jié)節(jié)檢測帶來了更多便捷。

對于肺結(jié)節(jié)的分割大致可以分為傳統(tǒng)分割和基于深度學(xué)習(xí)分割。文獻(xiàn)[7]通過結(jié)合肺結(jié)節(jié)的小波能量和漢森形狀指數(shù)進(jìn)行分割,提出基于局部形態(tài)特征的模糊速度函數(shù),加強血管黏連情況下肺結(jié)節(jié)的分割。文獻(xiàn)[8]提出結(jié)合窗口傅里葉濾波和模糊C均值的混合算法,可以清晰檢測到結(jié)節(jié)的形狀和位置。文獻(xiàn)[9]使用重新定義域中空間像素點的灰度以及參考標(biāo)準(zhǔn)選擇不同的模糊因子分割肺結(jié)節(jié)。但使用傳統(tǒng)分割方法需要很多的人力資源,且多次迭代后容易產(chǎn)生過分割和欠分割,計算復(fù)雜度也不斷增加,難以滿足臨床需求。所以使用深度學(xué)習(xí)的方法完成肺結(jié)節(jié)的分割成為一種趨勢,自AlexNet出現(xiàn)后,深度學(xué)習(xí)在圖像處理方面有著很好的成績,同時在肺結(jié)節(jié)分割問題上也出現(xiàn)了不少研究。從使用卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Network, CNN)[10]到代替CNN全連接層的全卷積神經(jīng)網(wǎng)絡(luò)(Fully Convolutional Network, FCN),最后發(fā)展到U?net網(wǎng)絡(luò),在肺結(jié)節(jié)分割上取得了一定的成果。U?net網(wǎng)絡(luò)具備在較小數(shù)據(jù)集的情況下分割效果更好的優(yōu)點,所以能廣泛應(yīng)用于醫(yī)學(xué)圖像分割。研究者們大都在其上進(jìn)行改進(jìn),包括后來出現(xiàn)采用密集跳躍連接的U?Net++模型[11]、結(jié)合殘差網(wǎng)絡(luò)提出ResUnet網(wǎng)絡(luò)[12]、使用深度可分離卷積為基本單元的mobile?Unet模型以及新型mobile?Unet模型[13]等都是在其基礎(chǔ)上進(jìn)行改進(jìn),以此來提高分割的效果。之后在分割領(lǐng)域還出現(xiàn)了Segnet[14]、pspnet[15]、R2Unet[16]網(wǎng)絡(luò),本文將在最后進(jìn)行實驗分析對比。

在CT掃描中,肺結(jié)節(jié)在整個圖像中所占比例很小、形態(tài)不規(guī)則、與背景分布不均衡、存在異質(zhì)性,給分割任務(wù)帶來了難度。為了更好地解決這些問題,本文提出基于高級語義及注意力的肺結(jié)節(jié)分割模型。

1" 網(wǎng)絡(luò)模型

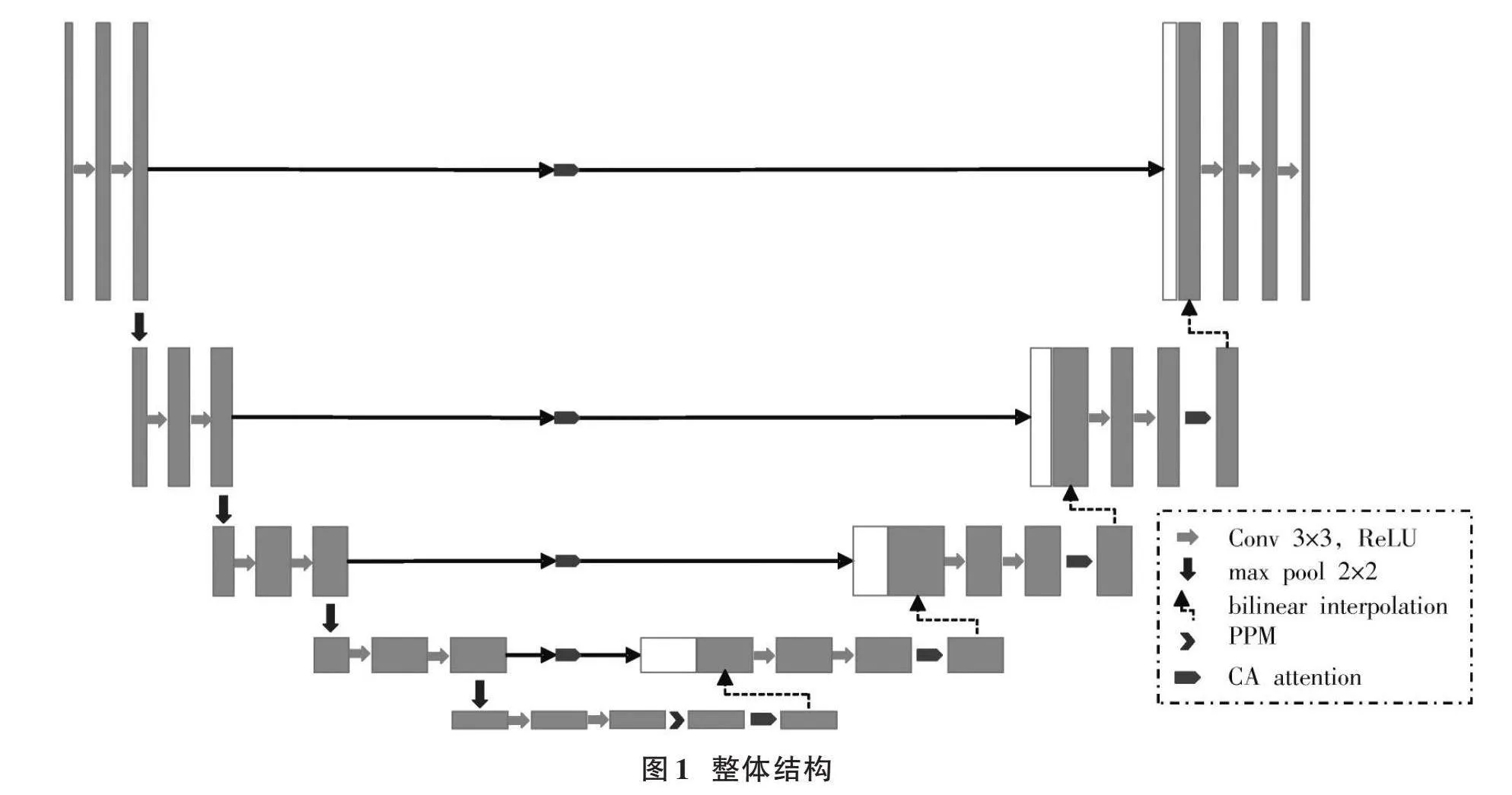

本文提出的基于高級語義及注意力的肺結(jié)節(jié)分割模型如圖1所示。U?net網(wǎng)絡(luò)包含兩個部分,編碼器和解碼器,且二者呈對稱狀,由VGG16進(jìn)行搭建特征提取部分,使用最大池化進(jìn)行下采樣生成4個不同深度的特征圖,解碼過程中通過雙線性插值法進(jìn)行上采樣,后將上采樣后的特征圖與同層編碼產(chǎn)生的特征圖進(jìn)行通道拼接、卷積,完成通道和空間的交互,使得特征表現(xiàn)力大大增強。最后加入金字塔池化模塊(Pyramid Pooling Module, PPM),將U?net特征提取出的深層信息進(jìn)行加強提取,通過CA注意力機制(Coordinate Attention)為更重要的信息注入更多的資源。

1.1" 金字塔池化模塊(PPM)

為了使主干網(wǎng)絡(luò)輸出的最高級語義特征內(nèi)部共享感受野,察覺到更多信息,本文使用PPM模塊,這樣可以在不降低分辨率的同時增加感受野,如圖2所示。PPM模塊最早出現(xiàn)在PSPNet網(wǎng)絡(luò)里,它可以很好地聚合不同區(qū)域的上下文信息,提升全局信息的利用率。

由于特征提取后圖像大小為32×32×512,所以將目標(biāo)特征圖分別池化到2×2、4×4、8×8、16×16大小,然后將通道壓縮至128×128;使用雙線性插值的方法,充分利用四周真實存在的像素值得到需要增加的像素值,提高上采樣的效果。

1.2" 注意力機制

為了解決任務(wù)目標(biāo)在整個圖像中所占比例小,且前景與背景中其他組織對比度低的問題,本文加入了CA注意力機制,加強模型的表征能力,削弱無效目標(biāo)的干擾,提升分割效果。

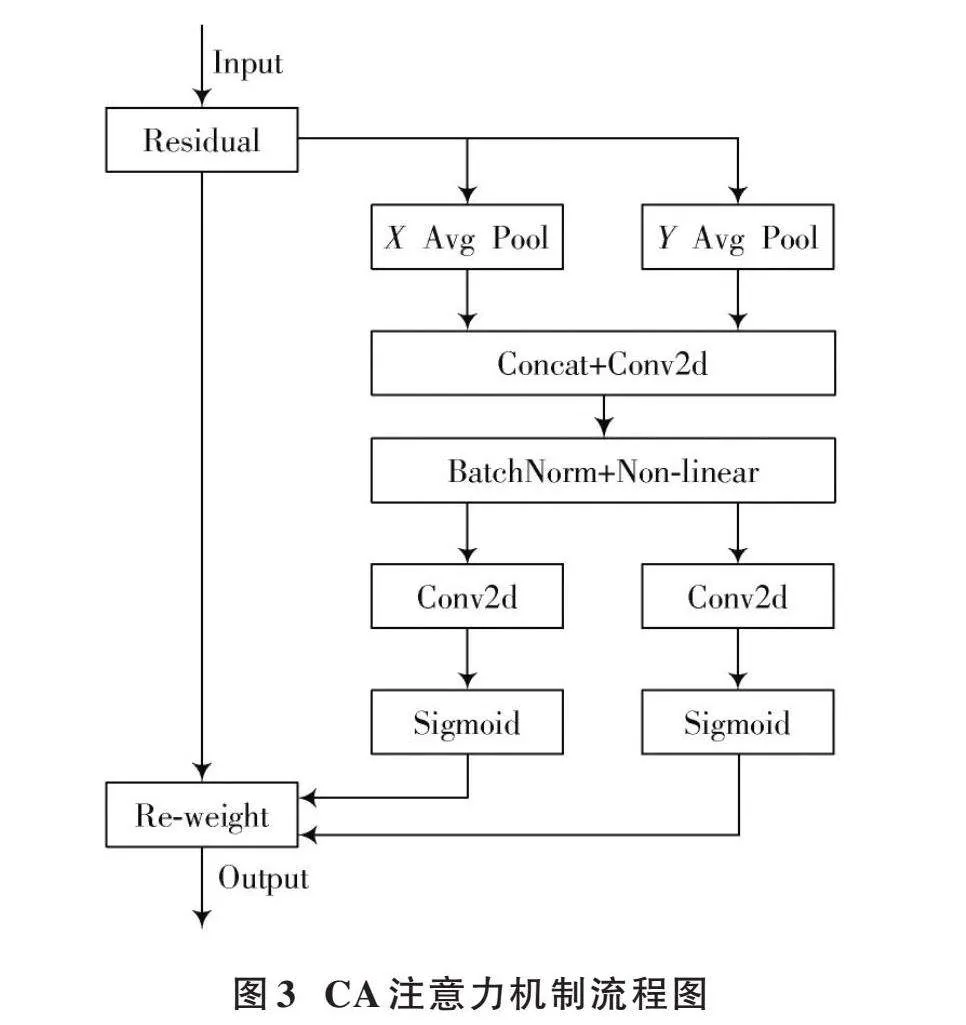

CA注意力機制通過對高、寬方向分別進(jìn)行平均池化,再將兩部分進(jìn)行拼接、卷積完成通道間信息的交互,成功地將空間位置信息嵌入到通道注意力內(nèi),這樣不僅可以抑制用處不大的通道特征,還可以捕獲到方向和位置感知的信息,更加精準(zhǔn)地定位和識別,實現(xiàn)特征圖空間和通道方向上的信息整合。

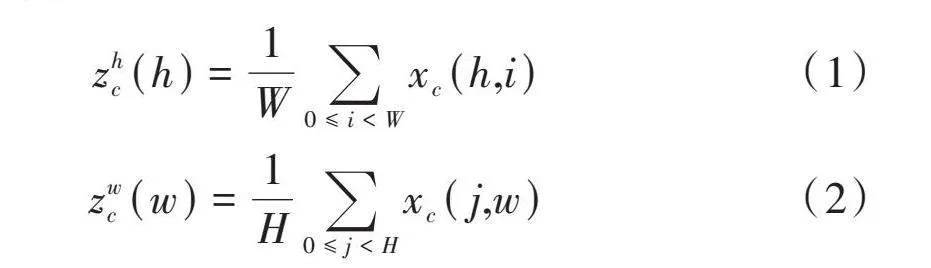

輸入特征層就會在高、寬方向分別進(jìn)行最大池化,得到第[C]維特征輸出如下:

[zhc(h)=1W0≤ilt;Wxc(h,i)] (1)

[zwc(w)=1H0≤jlt;Hxc(j,w)]" (2)

CA注意力機制的流程圖如圖3所示。

獲得1×[W]×[C]和[H]×1×[C]大小的特征層,并將[H]×1×[C]轉(zhuǎn)置成1×[H]×[C],進(jìn)行通道拼接、卷積和標(biāo)準(zhǔn)化得到特征;再將特征層高、寬分開,卷積、Sigmoid獲得高、寬分別的注意力情況;最后在原圖上進(jìn)行加權(quán),實現(xiàn)CA注意力機制。

1.3" 損失函數(shù)

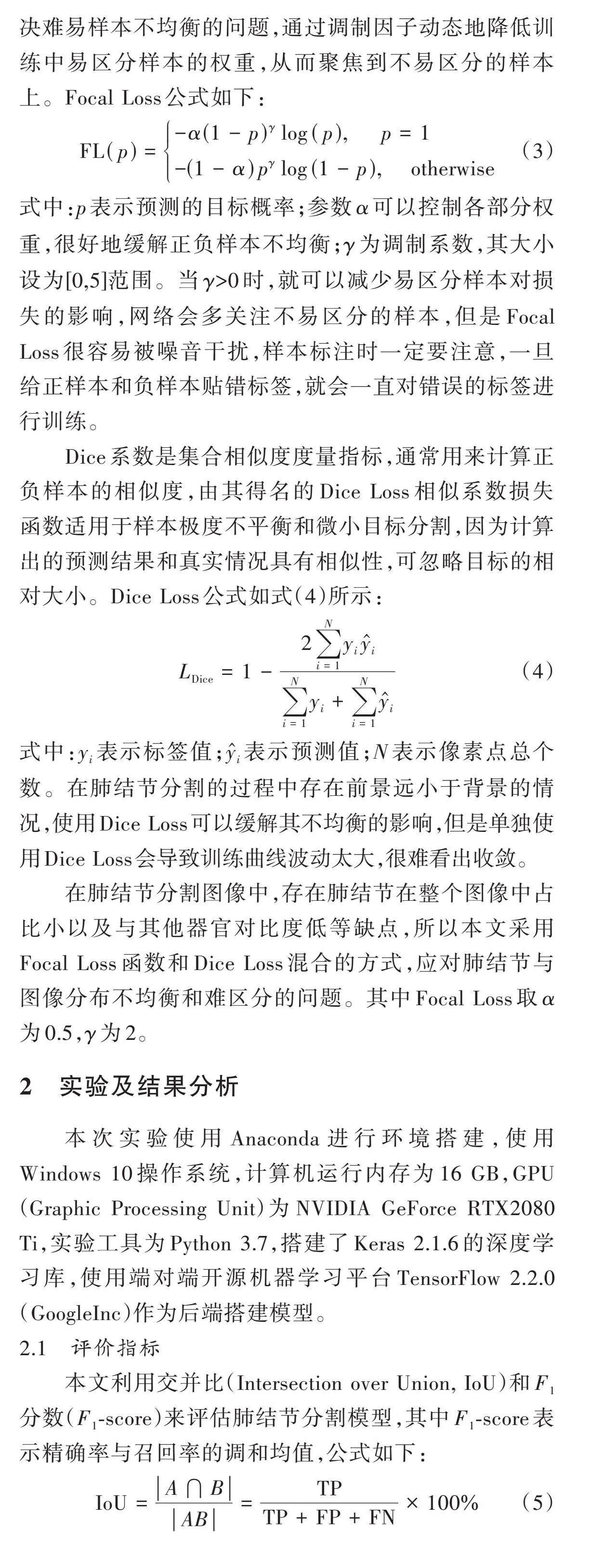

Focal Loss是動態(tài)縮放的交叉熵?fù)p失函數(shù),用于解決難易樣本不均衡的問題,通過調(diào)制因子動態(tài)地降低訓(xùn)練中易區(qū)分樣本的權(quán)重,從而聚焦到不易區(qū)分的樣本上。Focal Loss公式如下:

[FL(p)=-α(1-p)γlog(p)," " " "p=1-(1-α)pγlog(1-p)," " " otherwise] (3)

式中:[p]表示預(yù)測的目標(biāo)概率;參數(shù)[α]可以控制各部分權(quán)重,很好地緩解正負(fù)樣本不均衡;[γ]為調(diào)制系數(shù),其大小設(shè)為[0,5]范圍。當(dāng)[γ]gt;0時,就可以減少易區(qū)分樣本對損失的影響,網(wǎng)絡(luò)會多關(guān)注不易區(qū)分的樣本,但是Focal Loss很容易被噪音干擾,樣本標(biāo)注時一定要注意,一旦給正樣本和負(fù)樣本貼錯標(biāo)簽,就會一直對錯誤的標(biāo)簽進(jìn)行訓(xùn)練。

Dice系數(shù)是集合相似度度量指標(biāo),通常用來計算正負(fù)樣本的相似度,由其得名的Dice Loss相似系數(shù)損失函數(shù)適用于樣本極度不平衡和微小目標(biāo)分割,因為計算出的預(yù)測結(jié)果和真實情況具有相似性,可忽略目標(biāo)的相對大小。Dice Loss公式如式(4)所示:

[LDice=1-2i=1Nyiyii=1Nyi+i=1Nyi] (4)

式中:[yi]表示標(biāo)簽值;[yi]表示預(yù)測值;[N]表示像素點總個數(shù)。在肺結(jié)節(jié)分割的過程中存在前景遠(yuǎn)小于背景的情況,使用Dice Loss可以緩解其不均衡的影響,但是單獨使用Dice Loss會導(dǎo)致訓(xùn)練曲線波動太大,很難看出收斂。

在肺結(jié)節(jié)分割圖像中,存在肺結(jié)節(jié)在整個圖像中占比小以及與其他器官對比度低等缺點,所以本文采用Focal Loss函數(shù)和Dice Loss混合的方式,應(yīng)對肺結(jié)節(jié)與圖像分布不均衡和難區(qū)分的問題。其中Focal Loss取[α]為0.5,[γ]為2。

2" 實驗及結(jié)果分析

本次實驗使用Anaconda進(jìn)行環(huán)境搭建,使用Windows 10操作系統(tǒng),計算機運行內(nèi)存為16 GB,GPU(Graphic Processing Unit)為NVIDIA GeForce RTX2080Ti,實驗工具為Python 3.7,搭建了Keras 2.1.6的深度學(xué)習(xí)庫,使用端對端開源機器學(xué)習(xí)平臺TensorFlow 2.2.0(GoogleInc)作為后端搭建模型。

2.1" 評價指標(biāo)

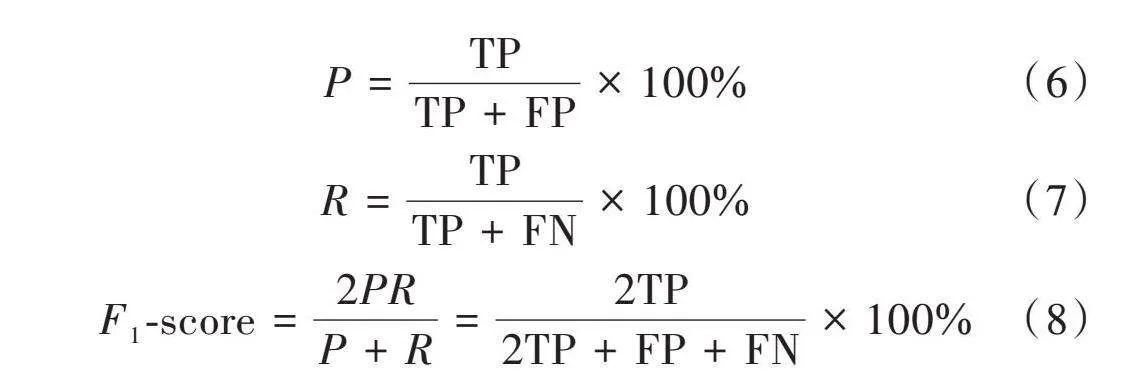

本文利用交并比(Intersection over Union, IoU)和[F1]分?jǐn)?shù)([F1]?score)來評估肺結(jié)節(jié)分割模型,其中[F1]?score表示精確率與召回率的調(diào)和均值,公式如下:

[IoU=A?BAB=TPTP+FP+FN×100%] (5)

[P=TPTP+FP×100%]" (6)

[R=TPTP+FN×100%] (7)

[F1?score=2PRP+R=2TP2TP+FP+FN×100%] (8)

式中:[A]表示真實分割結(jié)果;[B]表示預(yù)測分割結(jié)果;TP表示預(yù)測結(jié)果是要分割的目標(biāo);FP表示被預(yù)測部分是分割目標(biāo),預(yù)測結(jié)果是背景;FN表示被預(yù)測部分是背景,預(yù)測結(jié)果是分割目標(biāo)。

2.2" 模型驗證

實驗數(shù)據(jù)提取于LUNA16 CT影像數(shù)據(jù)集,是公用肺結(jié)節(jié)數(shù)據(jù)集LIDC?IDRI的子集,包含888例低劑量肺部CT影像,提取軸向切片,通過預(yù)處理得到數(shù)據(jù)圖像和標(biāo)注圖像,分別有1 186張分辨率為512×512的圖片,最終將80%的數(shù)據(jù)集作為訓(xùn)練集。

2.3" 實驗結(jié)果及對比

2.3.1" 消融實驗

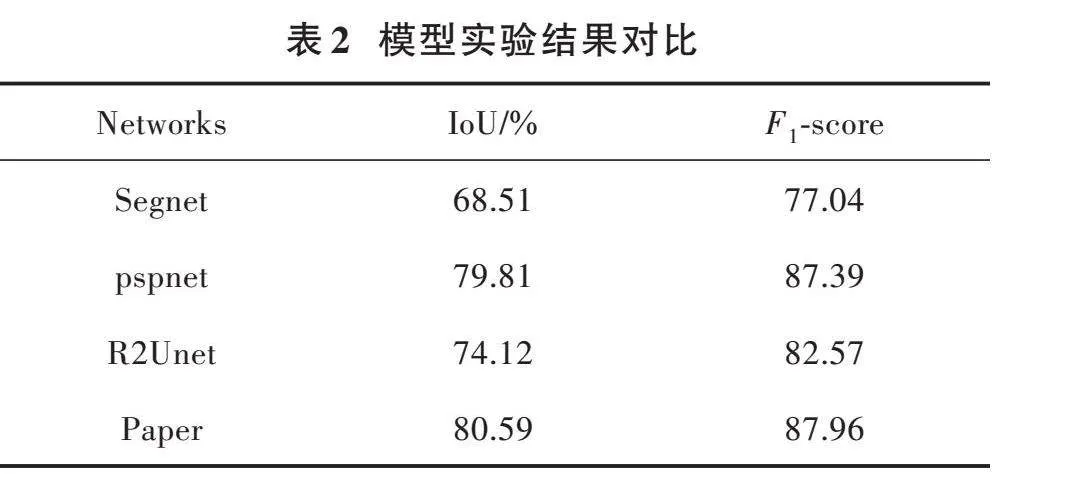

對本文模型進(jìn)行消融實驗,為了更好地體現(xiàn)本文模型的網(wǎng)絡(luò)性能,各個網(wǎng)絡(luò)計算得出評價指標(biāo)IoU和[F1]?score,完成消融實驗的性能對比,如表1所示,其中本文算法較其他三個網(wǎng)絡(luò)的IoU、[F1]?score都有所提高。

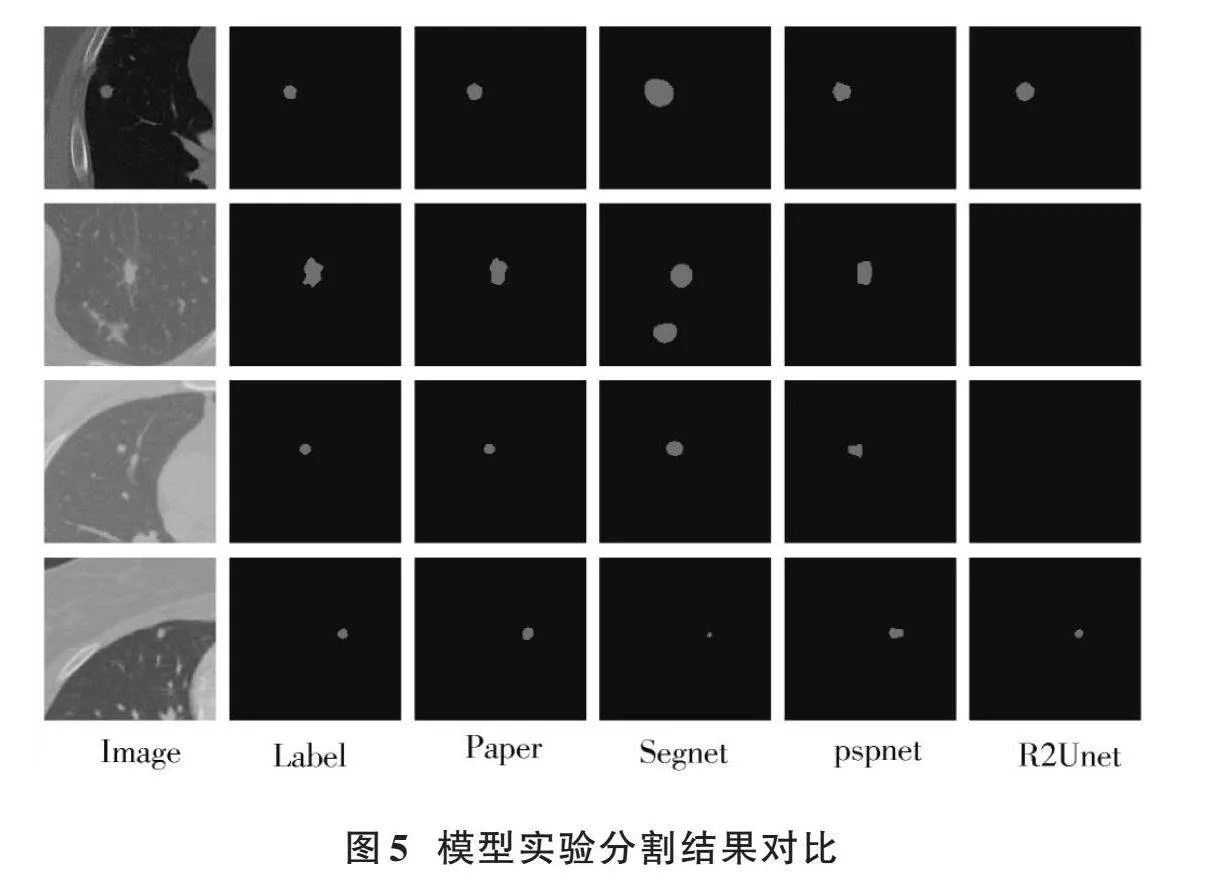

為了可視化效果更好,將分割結(jié)果裁剪并放大,從圖4的第1行和第4行可見,U?net加金字塔池化模塊和本文算法分割結(jié)果都更加接近標(biāo)準(zhǔn);第2行顯示對于前背景對比度高的小結(jié)節(jié)來說,分割結(jié)果都差不多;而在第3行可以看出來,對于前背景對比度低,其他組織干擾較大的結(jié)節(jié),本文模型同時加入兩個模塊分割效果更好,分割結(jié)果更加接近人工標(biāo)注結(jié)果。

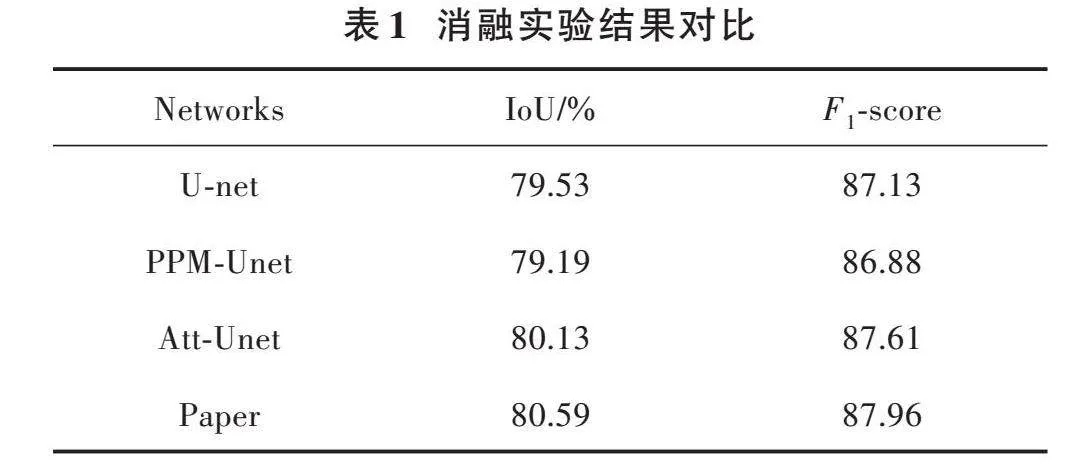

2.3.2" 模型性能對比實驗

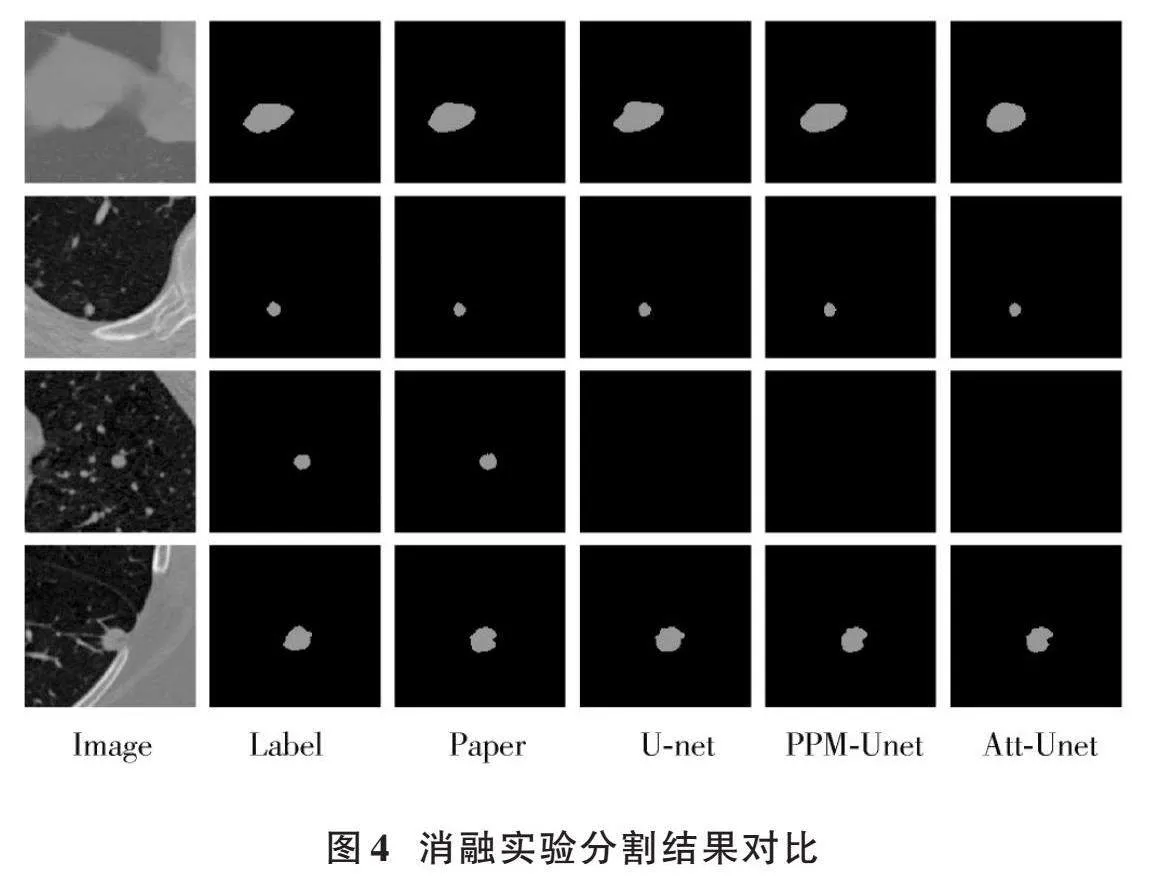

實驗將多個網(wǎng)絡(luò)進(jìn)行訓(xùn)練驗證,并對比本文的實驗結(jié)果,計算出評價指標(biāo)IoU和[F1]?score值,如表2所示。本文算法的交并比(IoU)值達(dá)到了80.59%,[F1]?score值為87.96。Segnet、pspnet、R2Unet網(wǎng)絡(luò)從評價指標(biāo)和分割結(jié)果都比本文數(shù)據(jù)集分割效果差。

各網(wǎng)絡(luò)的分割效果對比如圖5所示,均為測試結(jié)果裁剪所得。其中第二列為標(biāo)簽,Segnet網(wǎng)絡(luò)和R2Unet網(wǎng)絡(luò)總體上分別有些過分割和欠分割;而pspnet網(wǎng)絡(luò)分割結(jié)果接近標(biāo)簽,但對于邊緣處理還不夠精準(zhǔn);本文算法分割結(jié)果為第三列,分割精度相對更高,相對其他網(wǎng)絡(luò)更加接近標(biāo)簽。

3" 結(jié)" 語

本文充分研究了U?net網(wǎng)絡(luò)無法繼續(xù)更深層次地提取特征和擴大感受野,缺乏對資源合理分配等問題,提出了基于高級語義及注意力的肺結(jié)節(jié)分割模型,加入CA注意力機制提高對重要特征的資源分配,充分使用圖像特征;加入PPM金字塔池化模塊,完成對圖像深層特征提取,獲取更多的上下文信息;混合使用Focal Loss函數(shù)和Dice Loss函數(shù),有效解決前景背景分布不均衡和難區(qū)分的問題,從而提高分割性能。實驗結(jié)果表明,本文算法對于從LUNA16數(shù)據(jù)集提取出的數(shù)據(jù)分割效果良好,其各項指標(biāo)都有所提高,可以更加精確完整地分割肺結(jié)節(jié)。

注:本文通訊作者為王明泉。

參考文獻(xiàn)

[1] JENKINS R, WALKER J, ROY U B. Plain language summary of 2022 cancer statistics: Focus on lung cancer [J]. Future oncology, 2023(2): 1?11.

[2] 王澤洲,張揚,莫淼,等.大型單中心醫(yī)院登記的7753例肺癌手術(shù)患者生存報告:基于第8版國際肺癌TNM分期標(biāo)準(zhǔn)[J].中國癌癥雜志,2020,30(5):321?327.

[3] 伍思瑩.發(fā)病率死亡率雙高,肺癌早篩不可忽視[J].醫(yī)師在線,2022,12(2):20?21.

[4] 王婧璇,林嵐,趙思遠(yuǎn),等.基于深度學(xué)習(xí)的肺結(jié)節(jié)計算機斷層掃描影像檢測與分類的研究進(jìn)展[J].生物醫(yī)學(xué)工程學(xué)雜志,2019,36(4):670?676.

[5] KUMAR R, GUPTA N, VERMA R, et al. Utility of different positron emission tomography/computed tomography tracers in the evaluation of incidentally detected dual malignancies: An experience from a tertiary care center [J]. World journal of nuclear medicine, 2021, 20(4): 382?385.

[6] PENG X Q, YANG S Y, ZHOU L X, et al. Repeatability and reproducibility of computed tomography radiomics for pulmonary nodules: A multicenter phantom study [J]. Investigative radiology, 2022, 57(4): 242?253.

[7] 馮寶,張紹榮,陳業(yè)航,等.結(jié)合小波能量和漢森形狀指數(shù)的肺結(jié)節(jié)分割[J].儀器儀表學(xué)報,2018,39(11):240?247.

[8] MAO Q, ZHAO S G, GONG T, et al. An effective hybrid windowed Fourier filtering and fuzzy C?mean for pulmonary nodule segmentation [J]. Journal of medical imaging and health informatics, 2018, 8(1): 72?77.

[9] YANG T J, CHENG J F, ZHU C H. A segmentation of pulmonary nodules based on improved fuzzy C?means clustering algorithm [C]// 2018 2nd International Conference on Electronic Information Technology and Computer Engineering. [S.l.: s.n.], 2018: 1?6.

[10] 鄧忠豪,陳曉東.基于深度卷積神經(jīng)網(wǎng)絡(luò)的肺結(jié)節(jié)檢測算法[J].計算機應(yīng)用,2019,39(7):2109?2115.

[11] ZHOU Z W, SIDDIQUEE M M R, TAJBAKHSH N, et al. UNet++: A nested U?Net architecture for medical image segmentation [C]// Deep Learning in Medical Image Analysis and Multimodal Learning for Clinical Decision Support: 4th International Workshop. Heidelberg, Germany: Springer, 2018: 3?11.

[12] 柳小波,張育維.基于U?Net和ResUNet模型的傳送帶礦石圖像分割方法[J].東北大學(xué)學(xué)報(自然科學(xué)版),2019,40(11):1623?1629.

[13] 陳銘,梅雪,朱文俊,等.一種新型Mobile?Unet網(wǎng)絡(luò)的肺結(jié)節(jié)圖像分割方法[J].南京工業(yè)大學(xué)學(xué)報(自然科學(xué)版),2022,44(1):76?81.

[14] BADRINARAYANAN V, KENDALL A, CIPOLLA R. SegNet: A deep convolutional encoder?decoder architecture for image segmentation [J]. IEEE transactions on pattern analysis and machine intelligence, 2017, 39(12): 2481?2495.

[15] YAN L, LIU D, XIANG Q, et al. PSP net?based automatic segmentation network model for prostate magnetic resonance ima?ging [J]. Computer methods and programs in biomedicine, 2021, 207: 106211.

[16] ALOM M Z, HASAN M, YAKOPCIC C, et al. Recurrent residual convolutional neural network based on U?Net (R2U?Net) for medical image segmentation [EB/OL]. [2018?05?29]. https://arxiv.org/abs/1802.06955v4.