基于深度學習的遙感影像小型船舶檢測方法

摘要:隨著海洋貿易日益繁榮,船舶數量和交通量也快速增加。不同種類和尺寸的船舶分布在廣闊的海上,快速準確地發現和識別它們具有重要的實用價值。本文利用高分二號衛星影像制作高分辨率船舶檢測數據集(GF2-PMS) ,提出一種船舶智能檢測網絡結構進行模型訓練,并分別基于大尺度的高分二號衛星和谷歌地球影像測試其對小型船舶檢測的有效性和通用性。具體而言,作者對訓練數據集中的小型船舶樣本進行過采樣,生成更多樣本以便更好地匹配預測錨點。在網絡結構上,使用注意機制重新校準深度特征圖的輸入貢獻,并采用增加一個預測頭的方式提升對不同尺度船舶的匹配程度。實驗結果表明,采用過采樣策略使得船舶正確檢測率大幅提升,召回率從83.96%增至88.21%(提高4.25%) 。與YOLOv5的三個檢測頭相比,增加一個檢測頭在GF2-PMS數據集上獲得更高的檢測精度。另外,合理使用注意力機制能持續提升檢測精度,在測試集上實現較高的檢測精度(準確率=91.30%,召回率=94.93%,AP=97.10%) 。在兩張大尺度高分二號衛星影像測試下,本文的平均準確率從59.19%提升至76.73%,證明了該方法對小型船舶檢測的有效性。此外,在大尺度的谷歌高分辨率圖像上檢測,無論是小型船舶、復雜背景還是部分密集排列的船舶,該方法仍能提供令人滿意的檢測性能。綜上所述,本文提出了一種基于深度學習的有效小型船舶檢測方法,在大尺度遙感影像上展現了良好的通用性。該方法對船舶的大規模、高精度、智能監測具有重要意義,將大大提高船舶管理的決策效率。

關鍵詞:深度學習;小型船舶檢測;CBAM;過采樣;遙感圖像

中圖分類號:TP18 文獻標識碼:A

文章編號:1009-3044(2024)22-0025-04

開放科學(資源服務)標識碼(OSID)

0 引言

隨著全球經濟一體化,海洋貿易日益繁榮,船舶交通量也快速增加,快速準確地發現和識別它們具有重要的實用價值[1-2]。在軍事領域,能夠靈活監視敵方動態和部署,為決策制定提供信息保障;在民用領域,能監控特定海域與港口的海上交通,輔助監管部門實施海上救援和偵查等行動。因此,急需一種快速、準確、全面的方法來檢測船舶的位置和狀態。

遙感數據作為船舶檢測樣本集的關鍵來源[3],具有快速、大規模、連續動態的優點。根據傳感器的不同可分為合成孔徑雷達(Synthetic Aperture Radar, SAR) 與可見光遙感影像。目前已經出現了大量基于遙感數據的船舶人工檢測方法,然而,這些方法總是需要手工設計船舶特性,增加人力成本。隨著人工智能(AI) 的興起,自動船舶檢測技術的發展迅速,并從實驗階段逐漸轉向實踐階段。

本研究提出了一種結合過采樣策略和單級檢測網絡—YOLOv5的船舶智能檢測方法,實現對高分辨率遙感圖像下船舶目標,尤其是小型船舶,更快速、更準確地自動識別。具體來說,首先使用過采樣策略生成足夠信息豐富的小型船舶圖像,作為訓練數據集的訓練樣本。然后,將YOLOv5增加一個預測頭來細致處理船舶的大尺度方差。另外,在檢測器中還加入了一個CBAM模塊,進一步提高特征識別能力。最后,將改進的YOLOv5網絡應用于增強訓練樣本,完成船舶檢測任務,并以悉尼部分港口為例,分析了該方法在大尺度谷歌高分辨率影像下的船舶檢測效果。

1 數據集

在本研究中,使用高分辨率船舶檢測數據集(GF2-PMS) 作為模型評估的基準數據集。該數據集的原始數據來源于高分二號衛星影像,其分辨率為0.8m。制作樣本標簽過程中,使用QGIS開源軟件按以下要求完成:1) 標注每一張影像內所有大、中、小型船舶;2) 標注遺漏率為0;3) 鄰近船舶分開標注;4) 標簽文件符合PASCAL VOC standard標準。標注完成后以每艘船的中心為圖像切片的中心進行裁切,獲取部分圖像切片為800×800像素大小的船舶樣本。同時需要保證每艘船完全包含在至少一個圖像切片中,相應的位置信息構成了訓練標簽集。經過篩選后,GF2-PMS數據集中共包含1 423張光學圖像以及與其一一對應的標簽文件。

2 研究方法

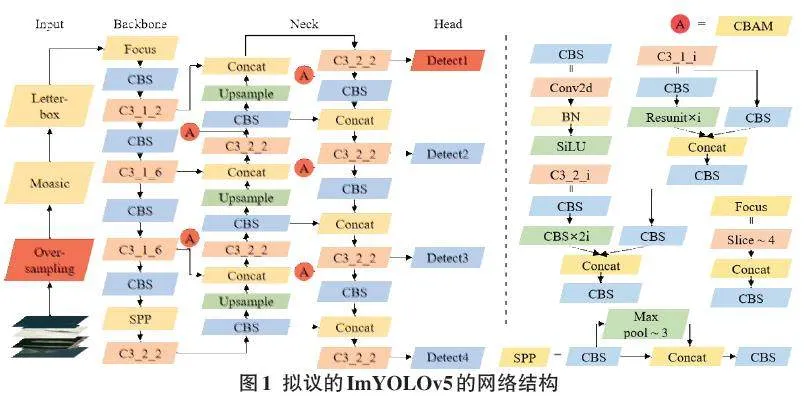

在研究方法方面,YOLOv5是一種高速率的單級檢測算法[4]。一般而言,原始的YOLOv5的網絡框架由輸入端(Input) 、主干網絡(Backbone) 、頸部(Neck) 以及預測層(Head) 四部分組成。輸入端使用Mosaic數據增強、自適應錨框計算與自適應圖片縮放方法提升模型的訓練速度和網絡的精度,經過一系列處理后輸入主干網絡;主干網絡使用Focus、CBS、C3和SPP在不同圖像細粒度上聚合并形成圖像特征;頸部則是混合和組合圖像特征的網絡層,加深主干網絡層同時生成三個不同尺度圖像特征并傳遞到預測層。預測層對輸入的特征圖進行回歸和分類操作,合并輸出不同尺度對象信息,確定目標類別和目標邊界框的精確位置。如圖1所示,本次研究提出一個改進的ImYOLOv5模型,主要包括以下3部分調整。

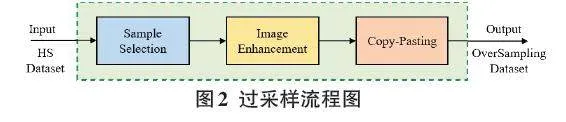

2.1 過采樣策略

深度卷積神經網絡在學習過程中,經常的卷積操作可能會導致圖像特征的損失問題,尤其是較小尺寸的實例。針對這一問題,YOLOv5在輸入端進行了一系列圖像增強處理來提升目標的檢測精度。在此基礎上,采用了過采樣的策略來解決包含小物體的圖像特征相對較少的挑戰。過采樣的核心思想是通過重復正比例數據,以增大正比例噪聲對模型的影響,這是提高小目標檢測性能的一種簡單直接的方法[5]。然而,直接對整個樣本進行過采樣會顯著增加計算量,降低模型訓練效率。這些操作對于中型和大型船舶的檢測則顯得不必要,因為它們通常能夠被正確檢測出來。

因此,本文設計了一個過采樣策略流程,包括以下步驟:首先,對訓練樣本進行預處理,篩選出含有小型船舶的原始影像;其次,對這些篩選結果進行過采樣。值得注意的是,為避免樣本重復,本文采用五種圖像變換方式進行處理,包括調整原始圖像的對比度、亮度、飽和度,添加高斯噪聲和特征模糊;接著,基于GF2-PMS數據集和提供的標簽文件,復制小船舶目標的原始位置;最后,將副本粘貼到不同位置。在粘貼過程中,通過設定過采樣率來控制對象個數,同時通過改變移動距離來保證目標不重疊,且完整保留在樣本圖像上。

2.2 CBAM模塊

在神經網絡中引入CBAM能夠提高網絡模型的特征表達能力。CBAM包括通道注意力(Channel Attention Module,CAM) 和空間注意力(Spatial Attention Module,SAM) 兩個順序的子模塊,是一種能對特征圖像局部信息聚焦的輕量級模塊。

CAM將輸入的特征圖F經過全局最大池化和全局平均池化后,將得到的兩個特征圖送入一個兩層的共享神經網絡中,再通過element-wise加和操作融合特征,經過Sigmoid非線性運算得到通道注意力特征FC。SAM將原始輸入F與通道注意力模塊生成的特征FC進行element-wise乘法操作,得到SAM的輸入F1。將F1經過基于通道的全局最大池化和全局平均池化后,得到兩個特征圖,進行通道拼接和Sigmoid非線性運算得到空間注意力特征FS,再將SAM的輸入F1與空間注意力模塊生成的特征FS進行element-wise乘法操作得到最終的輸出特征FR。

在大尺度高分辨率遙感影像上,覆蓋區域經常包含著特征模糊的地理元素。CBAM通過沿著通道和空間兩個獨立維度學習權重分配,使網絡更注重關鍵區域的信息,強化感興趣的信息并抵制模糊特征信息。這種方式能夠提高網絡在復雜場景中的特征表達能力和檢測性能。

2.3 針對小目標的預測頭

針對許多非常小的實例,研究還添加了一個用于小對象檢測的預測頭(圖1 Head) 。這樣做的主要目的是通過增加一個預測頭來減輕劇烈的物體尺度方差造成的負面影響。具體而言,在將輸入圖像尺寸為800×800像素時,原始YOLOv5最后輸出的特征圖大小分別為25×25像素、50×50像素、100×100像素,更細粒度的格網單元可以檢測出更細小的物體;通過增加一次上采樣操作,相應地增加了一個特征圖的大小為200×200像素的輸出。需要注意的是,在增加的預測頭上也疊加了CBAM的使用。通過添加額外的檢測頭,雖然增加了計算和內存成本,但對微小物體檢測性能的提升也是顯著的。

2.4 精度評價

本研究采用的模型評價指標為準確率、召回率以及平均精度(AP) 。準確率(Precision,P) 是指檢測器確定的真實船舶數占總船舶數的比例,表征船舶識別結果的完整程度。召回率(Recall,R) 是指檢測器確定的真實船舶數量與所有真實船舶數量的比值,反映出實際船舶對象數與船舶目標數的一致程度。AP則是通過船舶的準確率和召回率計算得出的曲線下的面積,用于全面評估目標檢測網絡的性能。

其對應的計算公式如下:

[P = TPTP + FP] (1)

[R = TPTP + FN] (2)

[AP = 01P(R)dR] (3)

式中:TP、FP和FN分別代表真陽性、假陽性和假陰性的數量。這些數值可以通過每個批處理的基于像素的混淆矩陣來計算得出。

2.5 訓練與優化環境

該網絡在使用64位Ubuntu 18.04操作系統和兩塊NVIDIA GTX Titan顯卡進行并行訓練時,每塊顯卡內存為12GB。模型對訓練集進行了500個批次的訓練。采用了隨機梯度下降作為優化器,其中初始學習率設置為0.02,動量設置為0.9,權重衰減設置為0.000 1,批大小設置為8。所有實驗均在這一環境和參數設定下完成。

3 結果與討論

3.1 過采樣結果

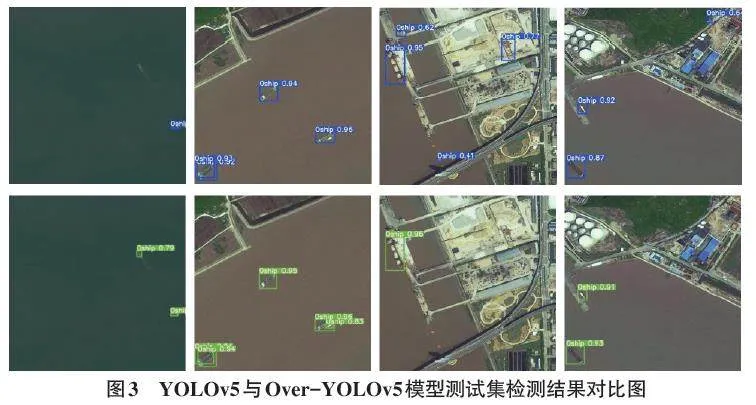

為了驗證過采樣策略的有效性,本文基于YOLOv5進行實驗。針對GF2-PMS數據集中的圖像,本文保持原始大小為800×800像素,按照7∶2∶1的比例劃分為訓練集和測試集進行精度驗證。根據表1所示,本文在測試數據集上統計了212艘船舶的檢測精度。第一行展示了原始YOLOv5的檢測精度,準確率和召回率分別為90.36%和83.96%。經過過采樣策略處理后,第二行顯示了檢測精度,召回率達到了88.21%,比YOLOv5的83.96%高出了4.25%。準確率從90.36%提升到90.78%,雖然僅有0.24%的變化,但也產生了積極影響。實驗結果表明,通過本文提出的過采樣策略擴充原有GF2-PMS數據集,能有效提高目標檢測精度。

3.2 消融實驗分析

為了評估對YOLOv5網絡另外兩處修改的有效性,本文在過采樣策略的基礎上進行了以下模塊消融分析。

1) 額外的預測頭的影響。為微小物體添加一個檢測頭會使原始YOLOv5的層數從283增加到341,參數量從7068936增加到7409952。雖然這增加了計算量,但準確率和召回率的提升也非常顯著。如表2所示,準確率從90.78%提升到93.37%,召回率從88.21%增至90.34%。額外的預測頭使船舶的平均精度(AP) 值從89.70%增加到93.46%,產生了3.76%的增量。對比結果表明,Over-YOLOv5+Tiny在檢測船舶時表現出色,因此計算量的增加是值得的。

2) CBAM。為驗證注意力機制的重要性,本文在增加額外預測頭的基礎上,將網絡模型與缺乏CBAM的模型進行了比較實驗。結果如表2所示。采用過采樣策略后的Over-YOLOv5+Tiny作為基線,并在實驗中保持其他超參數一致。加入CBAM帶來了2.64%的AP增量(93.46% vs. 96.10%) 。這表明CBAM能夠提取識別和魯棒特征,有效提高船舶的檢測性能。此外,將CBAM與類似模塊CA進行比較,使用CBAM的精度更高(96.10% vs. 95.21%) 。

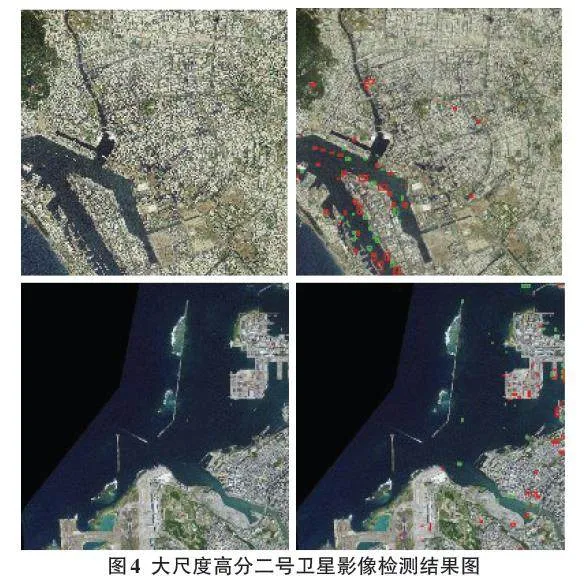

3) 驗證ImYOLOv5方法的有效性。為驗證Over-YOLOv5+Tiny+CBAM(即ImYOLOv5方法)對小型船舶檢測的有效性,本文選擇了兩張大尺度的高分二號衛星影像進行檢測,并對比原始YOLOv5進行分析,結果如圖4所示。綠色框表示ImYOLOv5的檢測結果,紅色框表示原始YOLOv5的檢測結果。從第一張大尺度影像中可以看出,ImYOLOv5相比原始的YOLOv5網絡檢測出的船舶數從35艘增至49艘,正確檢測數從29艘增至47艘,準確率從82.85%提升至95.91%;第二張大尺度影像中,檢測出的船舶數從76艘降至37艘,正確檢測數從27艘減至21艘,準確率從35.53%增至56.75%。結果顯示,在沒有海陸分割的前提下,ImYOLOv5方法具有更低的陸地誤檢率,且近海、遠海和港口的小型船舶檢測準確率更高。

3.3 普適性分析

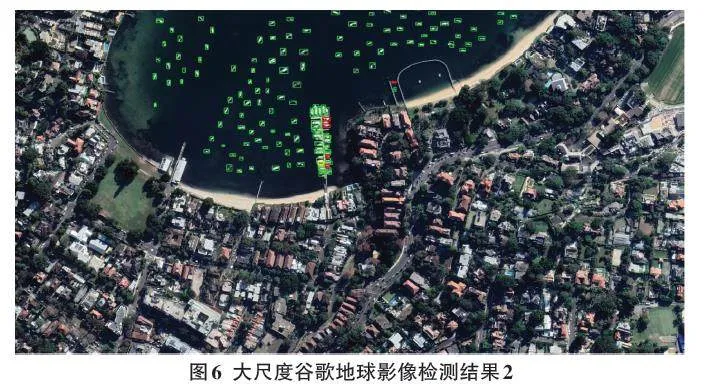

為了驗證該方法的泛化能力,本文在悉尼和澳門鄰近海域使用了兩張大尺度的谷歌影像進行測試,涵蓋了近海、深海和港口停泊等不同背景狀態。這些谷歌地球高分辨率圖像選擇了數據級別18,空間分辨率為0.5 m,包括紅、綠、藍三波段的8位數據。在這兩張大尺度谷歌影像下,90%以上的船舶為小型船舶。首先,本文將大尺度圖像劃分為多個尺寸為800×800像素的小尺度圖像,值得注意的是,小尺度圖像的重疊率設置為20%。然后,本文使用ImYOLOv5對每個小尺度圖像進行處理,最終輸出每艘船的位置。

圖5展示了一個尺寸為2 882×1 653像素的大尺度遙感圖像,其中綠色框表示本文方法的檢測結果,紅色框表示漏檢的船舶,黃色框表示誤檢的結果。從可視化結果可以看出,ImYOLOv5在對大尺度高分辨率遙感圖像進行檢測時表現出優秀的性能,但在面對一些輪廓模糊的船舶時仍會有明顯的漏檢和誤檢。

圖6展示了另一個分辨率為2 960×1 616像素的大尺度圖像,其中包含許多密集排列的船舶。在這種情況下,該方法仍然展現出良好的檢測性能。

綜合而言,本文的方法在各種復雜場景中都表現出很強的魯棒性,這歸功于所提出的過采樣策略以及結合注意力模塊和更精細化檢測頭網絡提供更好的特征表示,適用于小型船舶的檢測。

4 結論

本研究對YOLOv5模型進行了改進,提出了一種基于高分辨率遙感圖像的船舶智能檢測模型,通過高分二號高分辨率衛星影像制作船舶圖像樣本數據集,并在谷歌高分辨率影像上進行了廣泛的測試。在該模型中,采用過采樣策略對訓練樣本中的小型目標船舶進行過采樣,以生成足夠多的對象來匹配預測的錨框。網絡結構方面,利用注意機制重新校準深度特征圖的輸入貢獻,并通過增加一個額外的預測頭提升對不同尺度船舶的匹配程度。隨后采用遷移學習方法對模型進行訓練。實驗結果顯示,采用過采樣策略后,船舶檢測的AP和召回率明顯提高,AP從87.52%上升至89.70%(提升2.18%) ,召回率從83.96%上升至88.21%(提升4.25%) 。

綜合測試結果分析顯示,船舶召回率的提升主要體現在小型船舶的檢測上。再增加一個針對目標大尺度方差變化的檢測頭相比于YOLOv5的三個檢測頭在GF2-PMS數據集上取得了更高的檢測精度。合理使用注意力機制有助于進一步提升檢測精度。最終的方法在測試集上表現出高的精度(精度=91.30%,召回率=94.93%,AP=97.10%) 。在兩張大尺度高分二號衛星影像下的測試中,準確率分別從82.85%提升至95.91%和從35.53%提升至56.75%,證實了該方法對小型船舶檢測的有效性。在兩張大尺度的谷歌高分辨率圖像上進行的測試結果顯示,無論是小型船舶、復雜背景還是密集排列的船舶,該方法都提供令人滿意的檢測性能,進一步展現了其較高的遷移性。

隨著遙感技術的發展,光學遙感圖像數據具有更高的空間分辨率和光譜波段。本研究為利用光學高分辨率遙感圖像構建和應用深度學習模型提供了有益的參考。未來的研究將繼續提高深度學習算法對遙感圖像中過分密集小目標的檢測精度,并進一步縮減訓練時間。

參考文獻:

[1] 程靜,王榮杰,曾光淼,等.基于更快區域卷積神經網絡的多視角船舶識別[J].哈爾濱工程大學學報,2023,44(10):1832-1840.

[2] GUO H W,BAI H Y,YUAN Y M,et al.Fully deformable convolutional network for ship detection in remote sensing imagery[J].Remote Sensing,2022,14(8):1850.

[3] 姚紅革,王誠,喻鈞,等.復雜衛星圖像中的小目標船舶識別[J].遙感學報,2020,24(2):116-125.

[4] 李松林,江劍.基于改進YOLOv5的無人機小目標檢測算法[J].測試技術學報,2024,44(4): 354-362.

[5] KISANTAL M,WOJNA Z,MURAWSKI J,et al.Augmentation for small object detection[C]//9th International Conference on Advances in Computing and Information Technology (ACITY 2019).Aircc Publishing Corporation,2019:1-15.

【通聯編輯:唐一東】