基于隱式神經表示的圖像超分辨率

摘要:基于連續表示的圖像超分辨可以實現任意倍數的圖像分辨率縮放,目前已成為當前該領域研究的主流趨勢。隱式神經表示方法將坐標信息與深度特征信息作為輸入,給定坐標下的RGB值(紅綠藍值)作為輸出,提供了構建局部連續表示的基本框架,是典型的連續表示方法。然而,隱式神經表示方法未能充分考慮圖像的局部結構信息。為此,提出了基于權重學習和注意力機制的隱式神經表示方法。首先,引入權重學習模塊,該模塊借助梯度信息和多層感知機學習臨近特征點的權重。其次,引入通道注意力機制,以此增強特征通道中的關鍵信息,提升圖像局部連續表示的準確性。數值實驗結果表明,通過這兩種機制的共同作用,該算法的性能相較于現有算法有了顯著提升,表現出強大的競爭力。

關鍵詞:超分辨率重建;隱式神經表示;卷積神經網絡;注意力機制

中圖分類號:TP391.41文獻標志碼:A

0引言(Introduction)

圖像超分辨率重建(ImageSuper\|Resolution,SR)是將低分辨率(LowResolution,LR)圖像轉換為高分辨率(HighResolution,HR)圖像的過程,它作為計算機視覺領域的重要問題之一,近年備受矚目。現有SR方法主要側重處理整數倍的縮放因子,任意倍縮放因子的SR問題卻一直被忽略。為了應對目前SR領域中難以實現任意尺度放大的問題,本文采用了隱式神經表示的方法用于連續圖像表示,其中網絡以圖像坐標和像素點的深度特征信息作為輸入,預測給定坐標處的RGB值。在使用歐氏距離衡量周圍特征點對采樣點影響的基礎上,引入權重學習模塊,該模塊充分考慮圖像梯度信息,通過網絡學得的權重系數對RGB值進行高效而精準的調整;通過引入通道注意力機制[1]提高網絡的感知能力,更有效地捕捉關鍵特征,進而顯著提升了圖像質量。在這兩項改進措施的共同作用下,本文提出的SR算法在多個數據集上均實現了性能的提升。

1相關工作(Relatedwork)

在隱式神經表示中,使用隱式神經函數即數學模型多層感知機(MultiLayerPerceptron,MLP)[2]將坐標映射為圖像信息。該思路在模擬三維物體[3]的形狀、場景的外表和結構的外觀上得到了廣泛應用。MILDENHALL等[4]提出通過學習多個圖片視角,創建了一個對特定場景的隱式表示。與傳統的方法不同,這種連續的隱式表示可以用很少的參數描述物體的微小細節,而且它還可以被訓練來生成新的圖像視角。這種方法在計算機圖形和視覺領域有著廣泛的應用,可以更好地理解和呈現三維物體和場景。該方法通常使用一個函數進行表示,該函數接收輸入的坐標信息和其他參數,并映射到一個輸出,通常是圖像或其他數據的特征或屬性,即

本文網絡框架如圖1所示,通過卷積神經網絡[5]的主干網絡(CNNBackbone)對輸入的LR圖像進行深度特征提取。隨后,經過基于注意力機制的特征擴充模塊的作用,生成所需的像素特征。在坐標空間提取LR圖像與HR圖像像素點坐標之間的函數關系。將坐標信息、深度特征信息與考慮像素點大小的像素尺度感知模塊進行拼接,共同傳入隱式神經函數進行訓練。同時,引入權重學習模塊,通過像素點梯度信息調整網絡結果,以提升網絡的魯棒性。

在基于局部隱式神經表示的SR處理方法中,首先對輸入的圖像進行深度特征提取,這一步驟通過特征提取網絡,將每個連續的圖像轉化為一個二維特征圖F(i)∈RH×W×D。其中,H×W個特征點均勻地分布在二維域中,每個特征點在F(i)中代表連續圖像的局部部分,負責預測與自身最近的一組坐標的信號。引入隱式神經函數,將接收輸入的坐標信息及其他相關參數一并用于預測圖像中某個特定像素點的RGB值,即

Iq=(v,x)[JZ)][JY](2)

其中:v為二維特征圖F(i)的特征點,x為像素點對應的坐標信息,Iq為經過隱式神經函數預測出像素點的RGB值信息。

通過隱式神經函數,成功建立了離散的像素信息和連續的坐標信息之間的關聯,使得圖像的每個像素點都具有空間位置的參考。對于一張連續的圖片I(i),采樣點p處的RGB值被定義為

I(i)(p)=(v,δ(p,x))[JZ)][JY](3)

其中:v為采樣點p在F中最鄰近(歐氏距離最小)的特征點;x為最鄰近特征點的坐標信息;δ(·)表示采樣點p與最臨近x之間的坐標關系函數,對于關系函數δ(·)的建模方式有很多種,例如Transformer[6]中常用的點積和阿達瑪積。本文中采用減法運算,使計算量更小,同時取得了令人滿意的模型性能,即

δ(p,x)=γ(p)-η(x)[JZ)][JY](4)

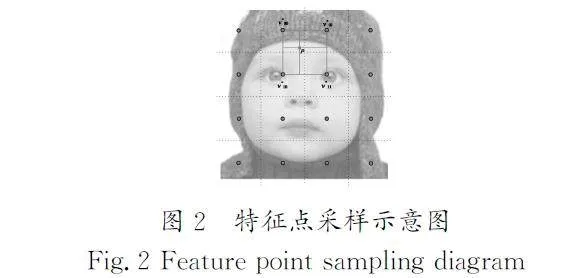

其中:γ、η分別表示采樣點與其鄰近特征點的坐標信息映射函數,本文選擇恒等映射實現映射函數。如圖2所示,在采樣點p處的RGB值由最近鄰特征點v00、p點坐標與v00點坐標x之間的函數關系共同決定。這一步驟的目的是確保在HR圖像中的每個像素點都能夠對應到LR圖像上的合適位置,從而保持了圖像的幾何一致性和空間關系。這種坐標空間的映射策略有助于保持圖像的空間連續性,以便更準確地還原HR圖像的像素信息,確保生成的HR圖像具有更好的視覺質量和細節。

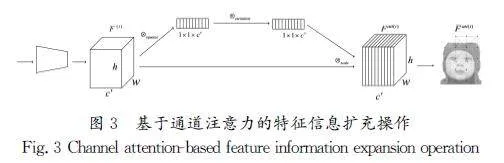

2.1基于注意力的特征信息擴充

在經過CNNBackbone進行特征提取處理后,LR圖像中原本包含RGB三個通道的信息被轉化成具有多個通道的特征圖F(i)。為了有效學習每個通道對模型任務的貢獻度,本文引入了通道注意力機制。該機制利用輸出的F(i),綜合分析每個通道的特征,生成一個實數表示每個通道的全局分布信息,增加了通道之間的相關性。通過全局池化結果,為每個特征通道分配權重,衡量其在當前任務中的重要性。最后,通過對原始特征進行加權運算,在通道維度上加強具有重要性的特征通道,并抑制不相關或不重要的特征通道,從而得到更優化的特征表示Fatt(i)。

為了增加Fatt(i)中每個特征點信息的信息量,本文采用了特征信息擴充的方法得到了[AKF-]att(i)。在[AKF-]att(i)中,每個特征點信息都是由其本身和周圍3×3個像素特征區域內的其他8個特征點的通道特征信息進行拼接得到的,對于位于圖像邊界以外的特征點,使用零向量進行填充。基于注意力機制的特征信息擴充的操作如下:

[AKF-]att(i)lm=concat({Fatt(i)l+j,m+k}j,k∈{-1,0,1})[JZ)][JY](5)

其中,concat表示向量拼接操作,在進行特征信息擴充后,[AKF-]att(i)代替Fatt(i)進行后續計算。基于通道注意力的特征信息擴充操作如圖3所示,本文的網絡在通道注意力機制的引導下進行了特征信息擴充,通過引入通道注意力機制,更加有效地調控不同通道之間的相關性,使網絡更專注于學習關鍵特征信息,同時進行特征信息擴充,以便更全面地捕捉圖像局部結構和紋理信息,從而提高了模型的表達能力和性能。

2.2像素尺度感知

受到ViT[7](VisionTransformer)中使用[class]模塊作為額外全局信息用于分類的啟發,本文提出了像素尺度感知的[Scale]模塊,用于擴充輸入的坐標信息。[Scale]模塊表示像素點的大小信息,通過添加該模塊,隱式神經函數能夠將查詢像素的形狀作為額外信息用于重構目標RGB值。將像素坐標信息與[Scale]進行拼接,隨后將其饋送到隱式神經函數中,公式(2)被重新定義為

其中:s=(sh,sw)是一個二維特征,代表當前像素點的尺寸大小信息;concat(x,s)表示對當前像素點的坐標信息與尺寸信息進行拼接操作。

2.3權重學習

在公式(3)中,通過使用單一特征點預測采樣點的RGB值可能導致預測結果的不連續性,尤其是當采樣點在空間域上移動時,特征點的選擇可能會發生突變。為了應對這一挑戰,LIIF[8](LocalImplicitImageFunction)借鑒了雙線性插值[9]的思想,使用每個采樣點周圍的4個特征點構成一個網格狀的正方形區域,與采樣點的坐標相對應,使用歐氏距離衡量每個特征點對采樣點的影響,并通過區域面積量化這種影響。這樣做的目的是使由局部特征點表示的局部片段能夠與其周圍的局部片段重合,從而確保每個采樣點都有4個獨立的特征點對其進行獨立的預測。在實際應用中,單純依靠距離信息評估特征點與采樣點的相互影響并不夠,梯度變化的角色同樣關鍵。例如,一個像素點雖然距離某特征點較遠,但是若該特征點的特征變化劇烈,那么它的特征信息可能受到梯度變化較大且距離較遠的像素點的影響更大。

因此,本文通過運用Canny算子[10]獲取圖像中的像素點梯度信息,并將其與特征點與采樣點的相對距離信息結合,通過網絡訓練,共同確定權重。相較于LIIF通過面積預測的人為權重,采用梯度信息通過網絡進行預測的方法充分考慮了像素點的變化率,使得模型更加關注顏色或紋理變化明顯的區域,從而能夠更準確地指導信號估計。這種方式更貼近圖像特性,有效地提升了對局部結構信息的捕捉和重建能力。對于采樣點p處的RGB值的預測,對周圍4個特征點的特征信息進行統籌考慮,每個特征點的權重大小由其梯度信息和與采樣點的相對距離共同決定,即

其中:vt(t∈{00,01,10,11})是指二維空間中左上、右上、左下、右下子空間中距離采樣點最近的特征點;wt(βt)表示其經隱式神經函數作用后,各自對應的權重系數,這里的權重系數是通過梯度調整網絡訓練得到的,即

t表示像素點的梯度信息,τt表示特征點與采樣點的相對距離。綜合考慮梯度和距離信息,可以更全面地捕捉特征點對預測結果的貢獻,使得模型能夠更好地適應圖像中的各種變化。

3實驗與結果分析(Experimentandresultsanalysis)

3.1數據集

本研究采用DIV2K[11]數據集,該數據集包含了高質量、現實世界背景下的2k分辨率圖像(2048×1080像素)。這些圖像的多樣性體現在它們覆蓋了各種場景、結構和紋理,為SR算法的訓練和評估提供了一個全面且真實的樣本庫。在實驗設計中,遵循了標準的數據分割方法,從DIV2K數據集中精選了800張圖像用于訓練。在測試階段,采用DIV2K的驗證集進行實驗驗證,該驗證集共包含100張圖像,除此之外,還在4個標準的基準數據集(Set5[12]、Set14[13]、B100[14]和Urban100[15])上對算法的性能進行了全面的評估。

3.2實驗設置

在本研究中,所有實驗均在精心配置的計算環境下進行,以確保實驗結果的準確性和可重現性。實驗環境基于Ubuntu18.04LTS操作系統,并利用了Python3.7作為主要的編程語言,深度學習實驗主要依賴于PyTorch1.7.1框架。所有深度學習相關的模型訓練和測試均在搭載NVIDIAA100GPU(具有40GB顯存)的高性能計算機上執行。

實驗中以隨機裁剪48×48個像素區域的圖像塊作為特征提取網絡的輸入,并采用Adam優化器,初始學習率設置為1×10-4,模型經過1000個訓練周期,批處理大小為16,每經過200個訓練周期,學習率會衰減為原來的0.5倍。本文的模型具有高度的靈活性,可以與不同的特征提取網絡相結合,隱式神經函數(·)和梯度調整網絡φ(·)分別由具有ReLU激活函數的5層MLP和2層MLP組成,隱藏層維度均為256。在整個訓練過程中,采用L1損失函數。

3.3消融實驗

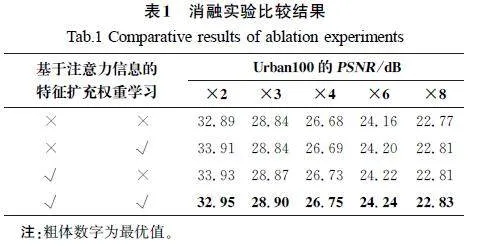

為驗證基于注意力的特征信息擴充模塊和權重學習模塊對超分辨率性能的實際貢獻,本文設計了消融實驗。在Urban100數據集上,分別移除了基于注意力的特征信息擴充模塊和權重學習模塊,以評估它們對2倍、3倍、4倍、6倍和8倍放大倍數下超分辨率性能的影響,×和√分別表示移除和保留該模塊。消融實驗比較結果如表1所示。從表1中的數據可以觀察到,在各個放大倍數下,移除基于注意力的特征信息擴充模塊和權重學習模塊導致測試得到的峰值信噪比(PeakSignal\|to\|NoiseRatio,PSNR)最低。隨后,逐步添加基于注意力的特征信息擴充模塊和權重學習模塊后發現,在5種放大倍數下,PSNR均有增長,特別是在同時添加兩個模塊時,相較于沒有這兩個模塊的情況,PSNR在2倍、3倍、4倍、6倍和8倍放大倍數下分別提升了0.06dB、0.06dB、0.07dB、0.08dB、0.06dB,進一步證明了兩個網絡模塊的共同作用對提高模型精度具有積極效果。

3.4對比實驗

實驗中采用了EDSR[16](EnhancedDeepResidualNetworks)和RDN[17](ResidualDenseNetwork)兩種深度特征提取網絡,兩種深度特征提取網絡都是通過深度堆疊和殘差學習的方式,以不同的方式有效地提取和傳遞圖像特征。將這兩種網絡提取的特征與本文的SR方法進行融合,再將本文的SR方法分別與雙三次插值[18](Bicubic)、采用EDSR和RDN網絡進行特征提取的MetaSR[19]網絡(EDSR\|MetaSR、RDN\|MetaSR)以及采用EDSR和RDN網絡進行特征提取的LIIF網絡(EDSR\|LIIF、RDN\|LIIF)進行評估,選擇PSNR作為評價指標。在DIV2K驗證集上進行方法性能的對比,對比結果如表2所示。由表2可得,本文算法在DIV2K驗證集上的性能表現最出色,相較于其他算法,在8種放大倍數下都展現出更好的性能。在4個標準基準數據集Set5、Set14、B100和Urban100上的對比結果如表3所示。由表3中的數據可知,本文算法在4個數據集上的總體性能表現最優。特別是在Urban100數據集上,本文算法展現出卓越的性能,這主要歸因于Urban100數據集中蘊含了豐富的細節、復雜的紋理及多樣的特殊結構。在面對這些具有挑戰性的圖像內容時,本文算法能夠更為出色地捕捉和重建圖像中的關鍵信息。

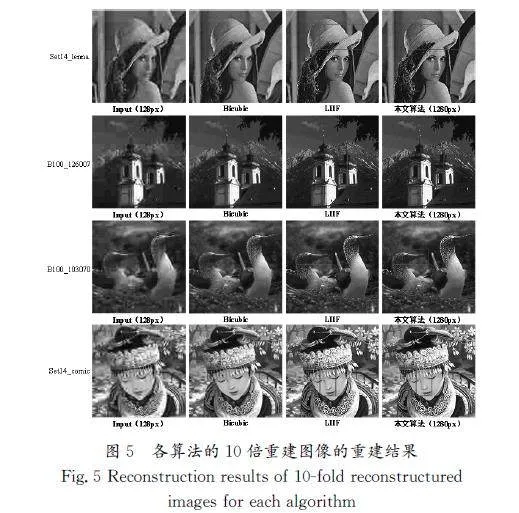

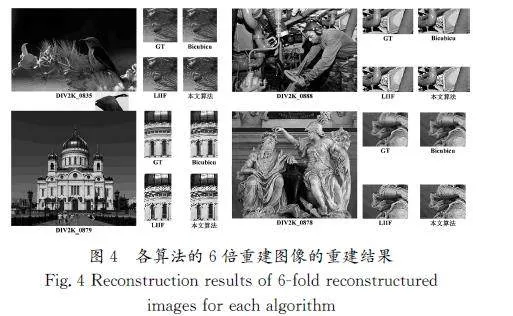

除了進行定量評估,為了更直觀地對比本文算法與其他算法在視覺上的有效性,在測試集中選擇了照片,如圖4和圖5所示,展示了各種對比模型在6倍和10倍超分辨率重建下的部分圖像效果。從圖4中可以看出,采用本文提出的網絡進行圖像重建后,較好地呈現了完整的細節。在DIV2K_0835中,更清晰地呈現了花蕊的信息;在DIV2K_0879中,有效地保留了遠處樓梯的細節;在DIV2K_0878和DIV2K_0888中,成功地消除了多余的偽影信息。這些結果表明本文算法在不同圖像上能夠有效地還原并增強圖像的細節信息。

進行10倍重建的圖像中(圖5),本文算法在多個場景中均展現出顯著的性能優勢。在Set14_lenna中,方框標注區域顯示本文算法明顯消除了帽檐處的多余偽影信息;在B100_126007中,方框標注區域凸顯了本文算法恢復出更為清晰的樓梯信息;在B100_103070中,方框標注區域表明本文算法使鳥兒的眼睛信息更加圓潤清晰;在Set14_comic中,方框標注區域表明本文算法成功地消除了鼻尖處的偽影信息。這些觀察結果進一步證實了本文算法在高倍數重建任務中的卓越性能,特別是在偽影去除和細節恢復方面相較于LWACEkK/R8aV19GRlbTpOYQ==IIF更為出色。在每個場景中,方框標注區域都凸顯了本文算法相對于LIIF的優越之處。該方法提高了重建圖像的整體質量。

4結論(Conclusion)

本文致力于解決連續圖像超分辨率重建中存在的局部結構信息不足的問題,通過引入權重學習模塊和通道注意力機制,提升了圖像表示的連續性和質量。權重學習模塊通過深度學習網絡捕捉梯度信息與RGB值之間的內在關聯,充分考慮圖像局部結構的精細特征,從而實現對圖像任意分辨率的高效、精準表示;通道注意力機制優化了關鍵信息在特征通道中的學習過程,進一步提升了圖像表示的準確性。實驗證明,本文的方法在不同放大倍數下均展現出卓越的視覺效果,顯著提升了圖像超分辨率重建的質量。這一創新性的解決方案不僅驗證了其技術優越性,還為連續圖像超分辨率重建領域開辟了一條新的、高效的研究路徑。

[HJ]

參考文獻(References)

[1]高艷鹍,劉一非,李海生,等.基于簡單通道注意力機制的單圖像超分辨率重建算法[J].計算機工程與設計,2023,44(7):2140\|2147.

[2]曾印,謝劭峰,張繼洪,等.顧及季節和高程影響的青藏高原濕延遲神經網絡預測模型[J].中國科技論文,2023,18(5):512\|517.

[3]CHENZQ,ZHANGH.Learningimplicitfieldsforgenerativeshapemodeling[C]∥IEEE.ProceedingsoftheIEEE/CVFConferenceonComputerVisionandPatternRecognition.Vancouver:IEEE,2019:5939\|5948.

[4]MILDENHALLB,SRINIVASANPP,TANCIKM,etal.Nerf:[JP3]representingscenesasneuralradiancefieldsforviewsynthesis[J].CommunicationsoftheACM,2021,65(1):99\|106.

[5]李薇,杜東升,鄧劍波,等.基于并聯式卷積神經網絡的遙感影像超分辨率重建[J].科學技術與工程,2023,23(27):11513\|11521.

[6]HASSANMM,HASSANMR,HUDAS,etal.Apredictiveintelligenceapproachtoclassifybrain\|computerinterfacebasedeyestateforsmartliving[J].Appliedsoftcomputing,2021,108:107453.

[7]YUANL,CHENYP,WANGT,etal.Tokens\|to\|tokenvit:Trainingvisiontransformersfromscratchonimagenet[C]∥IEEE.ProceedingsoftheIEEE/CVFinternationalconferenceoncomputervision.Montreal:IEEE,2021:558\|567.

[8]CHENYB,LIUSF,WANGXL.Learningcontinuousimagerepresentationwithlocalimplicitimagefunction[C]∥IEEE.ProceedingsoftheIEEE/CVFconferenceoncomputervisionandpatternrecognition.NewYork:IEEE,2021:8628\|8638.[HJ1.8mm]

[9]MASTYOM.Bilinearinterpolationtheoremsandapplications[J].Journaloffunctionalanalysis,2013,265(2):185\|207.

[10]于新善,孟祥印,金騰飛,等.基于改進Canny算法的物體邊緣檢測算法[J].激光與光電子學進展,2023,60(22):221\|230.

[11]AGUSTSSONE,TIMOFTER.Ntire2017challengeonsingleimagesuper\|resolution:Datasetandstudy[C]∥IEEE.ProceedingsoftheIEEEconferenceoncomputervisionandpatternrecognitionworkshops.Honolulu:IEEE,2017:126\|135.

[12]BEVILACQUAM,ROUMYA,GUILLEMOTC,etal.Low\|complexitysingle\|imagesuper\|resolutionbasedonnonnegativeneighborembedding[C]∥BMVAPress.BritishMachineVisionConference.London:BMVAPress,2012:1\|10.

[13]ZEYDER,ELADM,PROTTERM.Onsingleimagescale\|upusingsparse\|representations[M]∥Lecturenotesincomputerscience.Berlin,Heidelberg:SpringerBerlinHeidelberg,2012:711\|730.

[14]MARTIND,FOWLKESC,TALD,etal.Adatabaseofhumansegmentednaturalimagesanditsapplicationtoevaluatingsegmentationalgorithmsandmeasuringecologicalstatistics[C]∥IEEE.ProceedingsEighthIEEEInternationalConferenceonComputerVision.Vancouver:IEEE,2001:416\|423.

[15]HUANGJB,SINGHA,AHUJAN.Singleimagesuper\|resolution fromtransformedself\|exemplars[C]∥IEEE.ProceedingsoftheIEEEconferenceoncomputervisionandpatternrecognition.Boston:IEEE,2015:5197\|5206.

[16]LIMB,SONS,KIMH,etal.Enhanceddeepresidualnetworksforsingleimagesuper\|resolution[C]∥IEEE.ProceedingsoftheIEEEconferenceoncomputervisionandpatternrecognitionworkshops.NewYork:IEEE,2017:136\|144.

[17]ZHANGYL,TIANYP,KONGY,etal.Residualdensenetworkforimagesuper\|resolution[C]∥IEEE.ProceedingsoftheIEEEconferenceoncomputervisionandpatternrecognition.NewYork:IEEE,2018:2472\|2481.

[18]XIAP,TAHARAT,KAKUET,etal.Performancecomparisonofbilinearinterpolation,bicubicinterpolation,andB\|splineinterpolationinparallelphase\|shiftingdigitalholography[J].Opticalreview,2013,20(2):193\|197.

[19]HUXC,MUHY,ZHANGXY,etal.Meta\|SR:Amagnification\|arbitrarynetworkforsuper\|resolution[C]∥IEEE.ProceedingsoftheIEEE/CVFconferenceoncomputervisionandpatternrecognition.LongBeach:IEEE,2019:1575\|1584.