集成成像3D拍攝與顯示方法

王瓊?cè)A,鄧 歡

(四川大學(xué) 電子信息學(xué)院,四川 成都610065)

1 引 言

三維(3D)顯示是指采用光學(xué)和計算機等多種技術(shù)手段來模擬實現(xiàn)人眼的立體視覺特性,將空間物體以3D 信息再現(xiàn)出來,呈現(xiàn)出具有縱深感的立體圖像的一種顯示方式[1]。與傳統(tǒng)的二維(2D)顯示相比,3D 顯示能夠帶給觀看者更強的視覺沖擊和現(xiàn)場感受,能夠把人的感官甚至于思想完全帶入到所觀看的場景中去,不僅能讓觀看者獲得前所未有的視覺盛宴,還可以體驗一種不一樣的生活方式。在眾多的3D 顯示技術(shù)中,集成成像因其對光源沒有特殊要求(不需要相干光源),信息量相對較少,超薄屏幕(可壁掛),片源獲取相對容易,成本低廉等優(yōu)點,已成為3D 顯示領(lǐng)域的研究熱點之一[1-3]。

集成成像包括記錄和再現(xiàn)兩個過程。記錄過程利用微透鏡陣列記錄3D 場景在不同角度的3D 信息,由于構(gòu)成微透鏡陣列的每個透鏡元從不同方向記錄3D 場景的小部分信息,每個透鏡元都具有獨特的成像功能,在每個透鏡元的后焦平面上對應(yīng)生成了一幅不同方位視角的微小圖像,稱為圖像元,所有的圖像元組成了微圖像陣列。在這一過程中,3D 場景中的任意一點都被許多透鏡元記錄下來,該點的3D 信息就被擴散記錄于微圖像陣列中。再現(xiàn)過程中,利用普通2D 顯示器顯示微圖像陣列,再使用與記錄時參數(shù)相同的微透鏡陣列與之精密耦合,根據(jù)光路可逆原理,微透鏡陣列又把所有圖像元像素發(fā)出的光線聚集還原,在微透鏡陣列的前后方重建出與記錄時的3D場景完全相同的3D 圖像。由于CCD 等記錄器件和LCD 等顯示器件的發(fā)展成熟,集成成像記錄端的膠片可由CCD 代替,再現(xiàn)端的膠片可由LCD 等顯示器代替,由此構(gòu)成集拍攝和顯示3D圖像及3D 視頻于一體的集成成像系統(tǒng),其對應(yīng)的兩個過程又分別稱為集成成像3D 拍攝和集成成像3D 顯示。本文將介紹集成成像的幾種拍攝和顯示方法。

2 集成成像3D 拍攝方法

在長達(dá)100多年有關(guān)集成成像技術(shù)的研究過程中,人們累積了多種3D 拍攝方法,如全光學(xué)3D 拍攝法、直接3D 拍攝法、掃描式3D 拍攝法、攝像機陣列3D 拍攝法和計算機生成法等,下面一并進(jìn)行介紹。

2.1 全光學(xué)3D 拍攝法

G.Lippmann在1908年首次提出的集成攝影術(shù)就是采用的全光學(xué)3D 拍攝法[1],它使用真實的光學(xué)元件來完成。在微透鏡陣列的后焦平面上涂上一層感光乳劑,然后用漫射光照射3D 場景,被3D 場景反射的光線到達(dá)微透鏡陣列上,再被微透鏡陣列折射到感光乳劑上,這樣感光乳劑就記錄下了一幅微圖像陣列。全光學(xué)3D 拍攝法是最原始最粗糙的集成成像3D 拍攝法,存在深度反轉(zhuǎn)問題。而后1931年H.E.Ives提出的兩步記錄法能解決深度反轉(zhuǎn)問題,但是多次使用微透鏡陣列和感光乳劑,使得記錄的微圖像陣列模糊不清[4]。

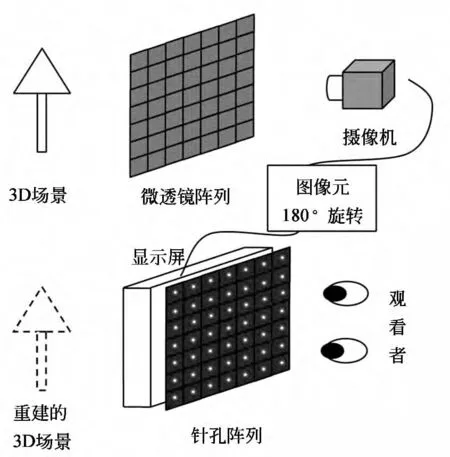

2.2 直接3D 拍攝法

1997年,日本的F.Okano等人采用直接拍攝法實現(xiàn)實時的集成成像3D 拍攝,如圖1所示為該實時3D拍攝系統(tǒng)的原理示意圖[5]。3D 場景發(fā)出的光線通過微透鏡陣列的每個透鏡元折射,然后被攝像機直接拍攝下來,形成了微圖像陣列。每個圖像元各自中心旋轉(zhuǎn)180°之后,被傳送到集成成像3D顯示器上顯示,該3D顯示器由普通的二維顯示器和一個針孔陣列組成,針孔陣列可以用來代替微透鏡陣列,由于圖像元經(jīng)過了180°旋轉(zhuǎn),解決了深度反轉(zhuǎn)問題。但該方法重建的3D 圖像只能是虛像,即凹進(jìn)顯示屏幕里面,沒有凸出顯示屏幕之外的實像,其3D顯示效果不佳。

圖1 直接拍攝法的原理示意圖Fig.1 Direct 3Dpickup method

后來M.Martinez-Corral等人提出,在微透鏡陣列與攝像機中間加入一個成像物鏡,便可進(jìn)行深度可調(diào)的集成成像3D 拍攝。由于附加的成像物鏡將會帶來一次深度反轉(zhuǎn),加之集成成像本身的深度反轉(zhuǎn),兩次深度反轉(zhuǎn)之后將是深度正確的3D 圖像,則不需進(jìn)行180°旋轉(zhuǎn)或兩步記錄來解決深度反轉(zhuǎn)問題,且通過適當(dāng)調(diào)節(jié)成像物鏡的位置,可以同時實現(xiàn)實像和虛像的3D 顯示[6]。J.Arai等人改進(jìn)了傳統(tǒng)的直接拍攝法,將漸變折射率微透鏡陣列直接與圖像傳感器相貼合,避免了相機鏡頭的使用所帶來的圖像畸變等問題[7]。但上述方法需要附加相應(yīng)的光學(xué)器件,如成像物鏡、漸變折射率微透鏡陣列等,將引入圖像畸變等問題,也增加了系統(tǒng)的復(fù)雜度。J.H.Kim 等人將直接拍攝法獲得的微圖像陣列進(jìn)行實時的計算機處理,通過控制中心深度平面的位置提高了圖像質(zhì)量[8]。

2.3 掃描式3D 拍攝法

一種較簡單的集成成像3D 拍攝方法是采用平臺式 的掃描3D 拍 攝 法[9-10],其3D 拍 攝 原 理 示意圖和實驗裝置如圖2所示,掃描攝像機被安置在一個掃描平臺上,通過平臺的平行移動來拍攝不同角度的3D 信息。該方法由于需要一段時間的掃描,因此要求3D 場景在掃描過程中是絕對靜止的,靜止時間依賴于掃描頻率,一般來說大概幾分鐘時間。對于大節(jié)距的透鏡元,圖像元分辨率為20×20個像素以上時,才能較為清楚地重建出3D 圖像,而掃描式3D 拍攝法使用的攝像機較難獲得高分辨率的微圖像陣列。

圖2 掃描式3D 拍攝法示意圖Fig.2 Scanning pickup method

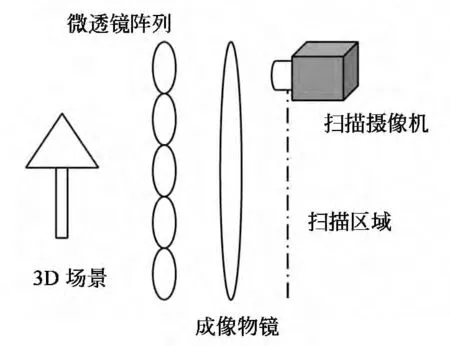

2.4 攝像機陣列3D 拍攝法

組成微透鏡陣列的每個透鏡元都可以用攝像機來代替,因此可以用等間距排列的攝像機陣列來代替微透鏡陣列,如圖3所示為攝像機陣列3D拍攝法示意圖[11]。由于透鏡元成像和攝像機成像存在上、下、左、右翻轉(zhuǎn)的關(guān)系,那么采用攝像機陣列拍攝獲取的微圖像陣列就相當(dāng)于微透鏡陣列拍攝的微圖像陣列中每個圖像元進(jìn)行180°旋轉(zhuǎn)后的效果,因此攝像機陣列3D 拍攝法獲取的微圖像陣列沒有深度反轉(zhuǎn)問題。而每個攝像機只需要獲取一個圖像元,因此圖像元的分辨率很高,可以組合成高質(zhì)量的微圖像陣列。但是該方法所需的攝像機個數(shù)較多,等于所需的圖像元個數(shù),各攝像機間需要進(jìn)行匹配、矯正等復(fù)雜操作,不適合大場景的集成成像3D 拍攝。

圖3 攝像機陣列3D 拍攝法示意圖Fig.3 3Dpickup method using camera array

圖4 稀疏攝像機陣列3D 拍攝法示意圖Fig.4 3Dpickup method using sparse camera array

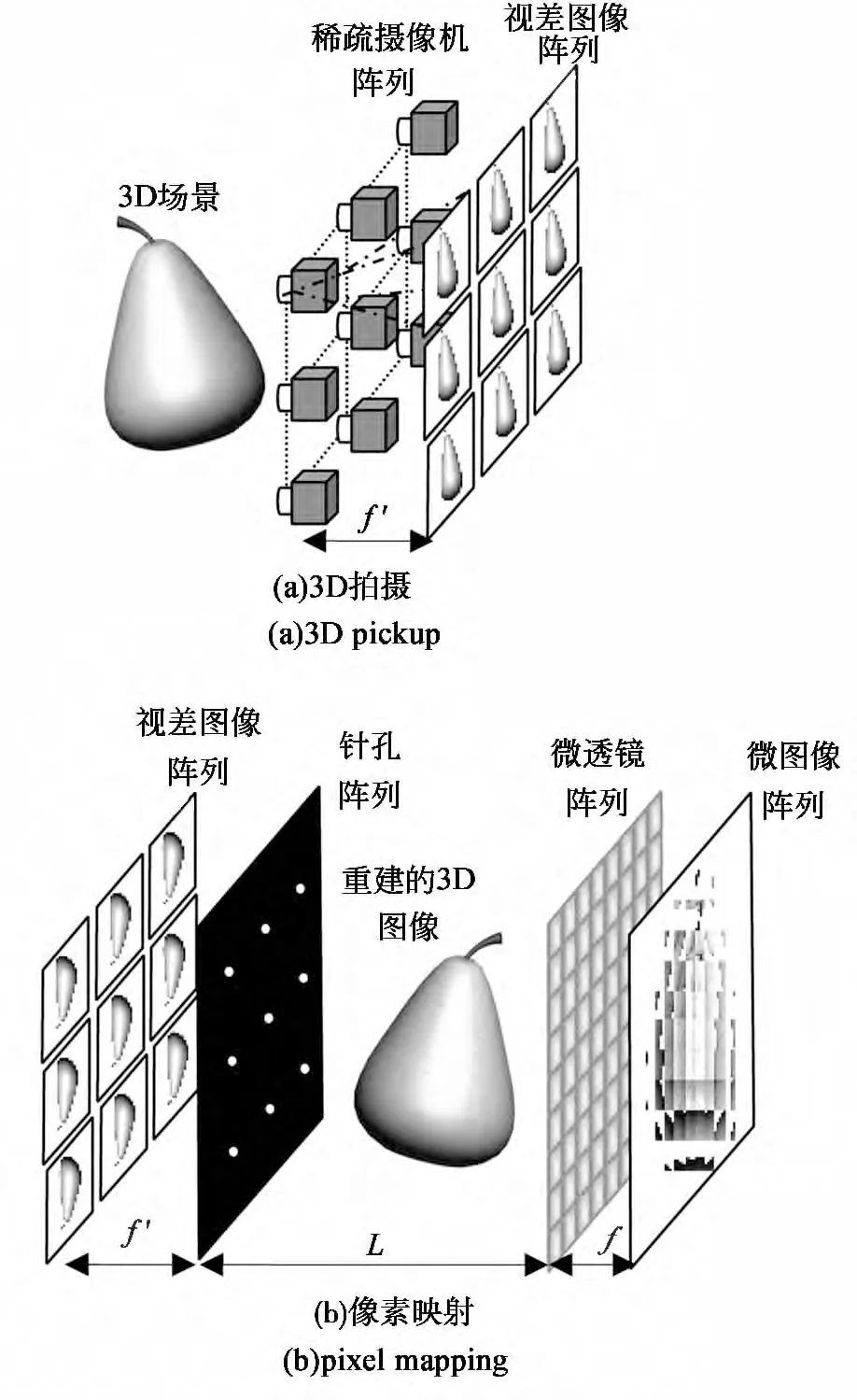

稀疏攝像機陣列法可以大幅度地減小拍攝時的攝像機個數(shù),使得大場景的集成成像3D 視頻拍攝成為可能。如圖4所示稀疏攝像機陣列拍攝3D 場景不同角度的立體信息,獲得視差圖像陣列,然后在計算機中通過建立的像素映射模型將視差圖像陣列轉(zhuǎn)換為微圖像陣列,就可獲得集成成像3D 顯示所需的微圖像陣列[12-13]。

2.5 計算機生成法

隨著計算機技術(shù)的發(fā)展,人們開始用計算機程序代替實際微透鏡陣列或攝像機來進(jìn)行3D拍攝。M.Halle等人在1998年提出多視點渲染算法,該算法在計算機中設(shè)置虛擬的相機陣列來代替微透鏡陣列的各個透鏡元對3D 模型進(jìn)行渲染,獲得的微圖像陣列可用于實際的集成成像3D 顯示[14]。但由于虛擬相機陣列包含的相機數(shù)量往往較多,計算機中需依次完成各個虛擬相機的渲染流程,導(dǎo)致計算過程十分耗時,無法實現(xiàn)微圖像陣列的實時渲染。S.W.Min等人基于方向性投影原理分別提出了點回溯算法[15]與視矢量渲染算法[16],兩種算法的虛擬相機渲染次數(shù)均等于圖像元的像素個數(shù),由于減少了虛擬相機的渲染次數(shù),故生成微圖像陣列的計算效率有所提高。點回溯算法僅適用于集成成像的聚焦顯示模式,而視矢量渲染算法雖然適用于集成成像的所有顯示模式,但該算法的計算效率受圖像元像素個數(shù)的限制,且不適用于大數(shù)據(jù)量3D模型的實時渲染。

為了進(jìn)一步提高計算機集成成像技術(shù)生成微圖像陣列的效率,科研工作者們開始嘗試采用GPU 并行處理數(shù)據(jù)技術(shù)來加速微圖像陣列的生成過程。K.C.Kwon等人在2012年提出基于圖像空間的并行計算算法[17],其優(yōu)勢在于該算法大大降低了3D 模型數(shù)據(jù)量對生成微圖像陣列過程的影響。由于微圖像陣列的渲染效率幾乎僅與其像素個數(shù)有關(guān),而該算法采用GPU 并行計算來完成微圖像陣列中各個像素的計算,故其計算效率可滿足大數(shù)據(jù)量3D模型的實時渲染。S.H.Jiao等人在2013年提出多光線集成渲染算法[18],該算法通過GPU 的幾何著色器將組成3D 模型的所有3D頂點數(shù)據(jù)進(jìn)行復(fù)制,使得所有的3D頂點均可通過一個透視投影幾何關(guān)系映射至單張紋理中,大大降低了GPU 與CPU 間數(shù)據(jù)傳輸?shù)臅r間,從而有效地提高了微圖像陣列的生成效率。

集成成像的計算機生成法雖然只能用于計算機模型和動畫的3D 拍攝,但其成本較低、拍攝速度快,已基本能實現(xiàn)較大場景的實時3D 拍攝,是目前常用的集成成像3D 拍攝方法。

3 集成成像3D 顯示方法

集成成像的3D 顯示過程包括基于視點的3D 顯示和基于深度平面的3D 顯示兩種,下面簡略分析這兩種集成成像3D 顯示方法。

3.1 基于視點的3D 顯示

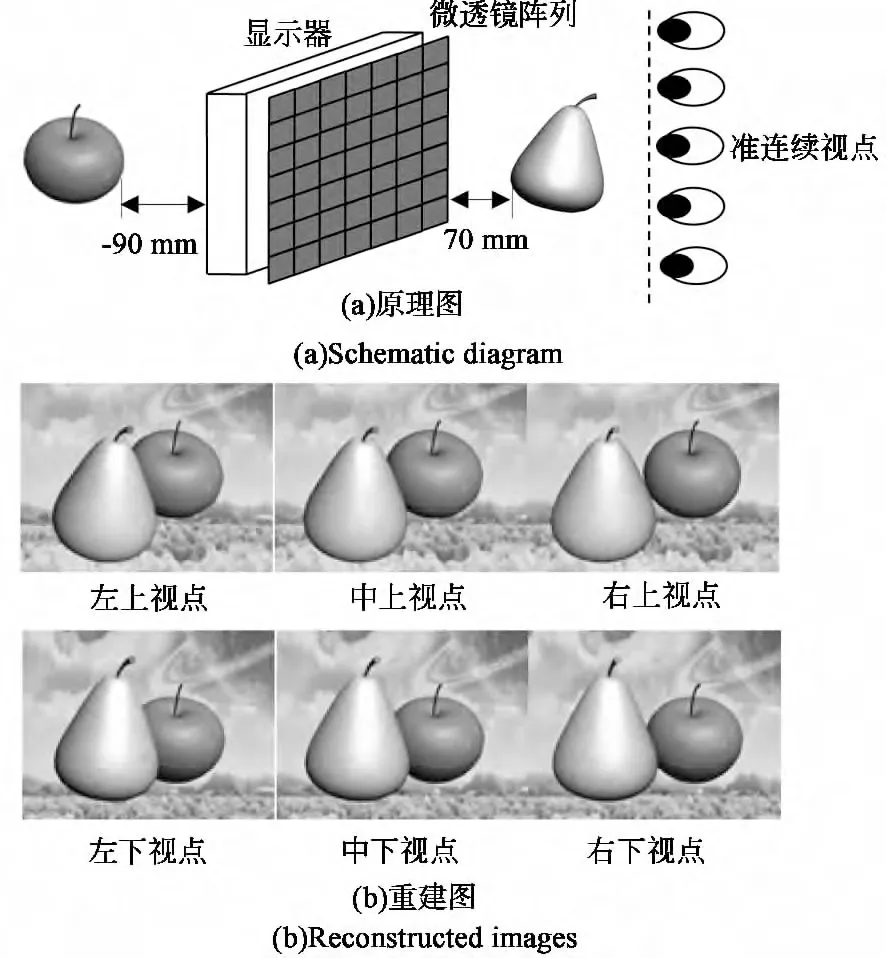

雖然集成成像3D 顯示在一定的觀看視區(qū)內(nèi)具有連續(xù)的視點,但由于采用了離散化像素結(jié)構(gòu)的感光器件進(jìn)行集成成像3D 拍攝和3D 顯示,因此,集成成像3D 顯示在觀看視區(qū)內(nèi)具有準(zhǔn)連續(xù)的視點。如圖5(a)所示為基于視點的集成成像3D 顯示原理圖,觀看者在準(zhǔn)連續(xù)視點內(nèi)的不同位置上都可以清晰地觀看到3D 圖像,從而獲得明顯的立體感[19]。由于人眼通過每個透鏡元只能在對應(yīng)圖像元上看到一個像素信息,因此人眼每只眼睛看到的像素個數(shù),即3D 分辨率,等于微透鏡陣列中的透鏡元個數(shù)。如圖5(b)所示為基于視點的集成成像3D 顯示獲得的6個不同視點上的圖像。除了傳統(tǒng)的集成成像3D 顯示外,還有360°視 角 的3D 顯 示 系 統(tǒng)[20]以 及 平 鋪 式3D 顯示[21]等。該基于視點的集成成像3D 顯示方法能為觀看者提供直觀的3D 感受,可用于娛樂、廣播傳媒、虛擬現(xiàn)實[22-23]、醫(yī)學(xué)[24-25]等方面。

圖5 基于視點的集成成像3D 顯示Fig.5 Integral imaging 3Ddisplay based on viewing point

3.2 基于深度平面的3D 顯示

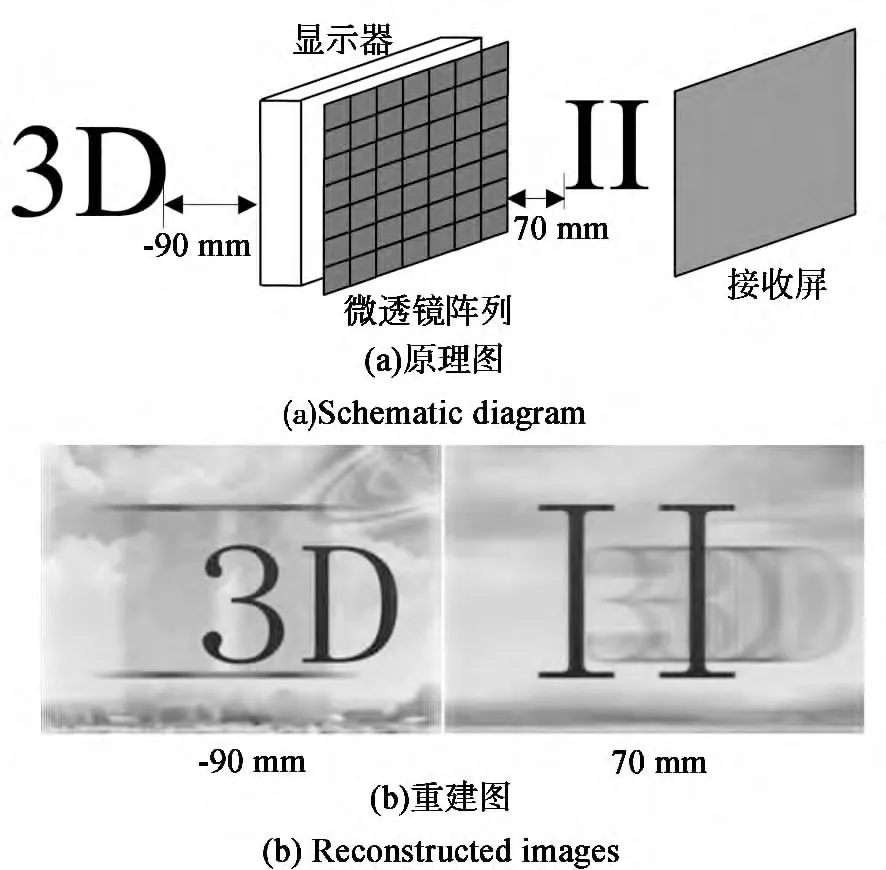

圖6 基于深度平面的集成成像3D 顯示Fig.6 Integral imaging 3Ddisplay based on the depth plan

基于深度平面的集成成像3D顯示的原理如圖6(a)所示,顯示器上像素發(fā)出的光線經(jīng)過微透鏡陣列折射后,在空間中會聚成像,重建出3D圖像,但所有的光線并不會終止,而是繼續(xù)向前傳播,并到達(dá)接收屏上,因此該接收屏可在不同深度平面上接收到重建的3D圖像。當(dāng)接收屏位于重建3D圖像的深度平面上時,將接收到清晰的圖像,否則接收到的則是模糊的圖像。在計算機中還可以設(shè)置虛擬的負(fù)深度,從而接收到3D 虛像。如圖6(b)所示為負(fù)深度和正深度平面上分別接收到的重建的3D 虛像和3D 實像,當(dāng)接收屏位于-90mm 處時,字符“3D”成清晰像,而字符“II”則成模糊像,反之亦然。該方法可用于遮擋物體的3D 重現(xiàn)[26-27]、微生物識別[28]和深度重建[29]等方面。

4 結(jié) 論

各國的科研工作者在集成成像技術(shù)方面進(jìn)行了深入的研究并提出很多有效的解決方法,本文對集成成像3D 拍攝和顯示的部分技術(shù)進(jìn)行了介紹。稀疏相機陣列法減小了相機個數(shù)、能適用于真實大場景的3D 拍攝,而計算機生成法拍攝速度快、成本低、可進(jìn)行計算機模型的實時視頻拍攝,將是集成成像3D 拍攝的主流技術(shù)。隨著計算機技術(shù)、微透鏡陣列制備工藝、記錄和顯示設(shè)備等的快速發(fā)展,集成成像將是未來3D 顯示技術(shù)的主要發(fā)展方向之一,并在3D 電視、3D 印刷、深度測量、建筑、娛樂、軍事、醫(yī)學(xué)診斷等領(lǐng)域具有很廣泛的應(yīng)用前景。期待集成成像3D 顯示走進(jìn)千家萬戶,改變?nèi)藗兊纳睢?/p>

[1] 王瓊?cè)A.3D 顯示器件與技術(shù)[M].北京:科學(xué)出版社,2011.Wang Q H.3 D Display Technology and Device[M].Beijing:Science Press,2011.(in Chinese)

[2] Lippmann G.La photographie integral[J].Comptes Rendus de l'Académie des Sciences,1908,146:446-451.

[3] Xiao X,Javidi B,Martinez-Corral M,et al.Advances in three-dimensional integral imaging:sensing,display,and applications[J].Applied Optics,2013,52(4):546-560.

[4] Ives H E.Optical properties of a lippmann lenticulated sheet[J].Journal of the Optical Society of America A,1931,21:171-176.

[5] Okano F,Hoshino H,Aral J,et al.Real-time pickup method for a three-dimensional image based on integral photography[J].Applied Optics,1997,36(7):1598-1603.

[6] Martínez-Corral M,Martínez-Cuenca R,Saavedra G,Orthoscopic,long-focal-depth 3Dintegral imaging[C]∥Proceedings of the SPIE,Stockholm,Sweden,2006:63940H(1-9).

[7] Aral J,Yamashita T,Miura M,et al.Integral three-dimensional image capture equipment with closely positioned lens array and image sensor[J].Optics Letters,2013,38(12):2044-2046.

[8] Kim J,Jung J H,Jang C,et al.Real-time capturing and 3Dvisualization method based on integral imaging[J].Optics Express,2013,21(16):18742-18753.

[9] Wang X,Hong H.Theoretical analysis for integral imaging performance based on micro-scanning of a microlens array[J].Optics Letters,2008,33(5):449-451.

[10] Papageorgas P G,Athineos S S,Sgouros N P,et al.3Dcapturing devices based on the principles of integral photography[C]∥1st International Scientific Conference,Tripoli,Libya,2006.

[11] Deng H,Wang Q H,Li D H,et al.Realization of undistorted and orthoscopic integral imaging without black zone in real and virtual fields[J].Journal of Display Technology,2011,7(5):255-258.

[12] Deng H,Wang Q H,Li D H,et al.1Dintegral imaging based on parallax images’virtual reconstruction[J].Chinese Optics Letters,2013,11(4):041101(1-4).

[13] Deng H,Wang Q H,Li D H.Method of generating orthoscopic elemental image array from sparse camera array[J].Chinese Optics Letters,2012,10(6):061102(1-3).

[14] Halle M.Multiple viewpoint rendering[C]∥SIGGRAPH ’98,Proceedings of the 25th Annual Conference on Computer Graphics and Interactive Techniques,1998:243-254.

[15] Min S W,Kim J,Lee B.New characteristics equation of three-dimensional integral imaging system and its applications[J].Japanese Journal of Applied Physics,2005,44(2):L71-L74.

[16] Park K S,Min S W,Cho Y.Viewpoint vector rendering for efficient elemental image generation[J].The Institute of Electronics,Information and Communication Engineers,2007,90(4):231-241.

[17] Kwon K C,Park C,Yoo K H,et al.High speed image space parallel processing for computer-generated integral imaging system[J].Optics Express,2012,20(2):732-740.

[18] Jiao S H,Wang X G,Kim J Y,et al.Multiple ray cluster rendering for interactive integral imaging system [J].Optics Express,2013,21(8):10070-10086.

[19] Deng H,Wang Q H,Li D H,et al.Realization of undistorted and orthoscopic integral imaging without black zone in real and virtual fields[J].Journal of Display Technology,2011,7(5):255-258.

[20] Jung J H,Park G,Kim Y,et al.360-degree viewable cylindrical integral imaging system using electroluminescent films[C]∥9th International Meeting on Information Display (IMID),Ilsan,Korea,2009:1254-1257.

[21] Hirayama Y,Saishu T,F(xiàn)ukushima R,et al.Flatbed-type auto stereoscopic display systems using integral imaging method[C]∥Consumer Electronics,Digest of Technical Papers,Las Vegas,USA,2006:125-126.

[22] Yanaka K,Yoda M,Lizuka T.Floating Integral Photography Using Fresnel Mirror[C]∥IEEE Virtual Reality,CA,USA,2012:135-136.

[23] Son J Y,Son W H,Kim S K,et al.Three-dimensional imaging for creating real-world-like environments[J].Proceedings of the IEEE,2013,101(1):190-205.

[24] Liao H,Sakuma I,Dohi T.Development and evaluation of a medical autostereoscopic image integral videography for surgical navigation[C]∥International Conference on Complex Medical Engineering,Beingjing,China,2007:213-218.

[25] Liao H,Hata N,Nakajima S,et al.Surgical navigation by autostereoscopic image overlay of integral videography[J].IEEE Transactions on Information Technology in Biomedicine,2004,8(2):114-121.

[26] Xiao X,Daneshpanah M,Javidi B.Occlusion-removed scheme using depth-reversed method in computational integral imaging[J].Journal of Display Technology,2012,8(8):483-490.

[27] Zhang M,Piao Y,Kim E S.Occlusion removal using depth mapping in three-dimensional integral imaging[J].Applied Optics,2010,49(14):2571-2580.

[28] Javidi B,Moon I,Yeom S.Three-dimensional identification of biological microorganism using integral imaging[J].Optics Express,2006,14(25):12096-12106.

[29] Deng H,Li D H,Wang Q H,et al.Integral imaging without image distortion using micro-lens arrays with different specifications[J].Optical Engineering,2013,52(10):103113(1-5).