結合運動特征的目標跟蹤方法

周明珠,周治平

(江南大學物聯網工程學院,江蘇無錫214122)

結合運動特征的目標跟蹤方法

周明珠,周治平

(江南大學物聯網工程學院,江蘇無錫214122)

針對視頻跟蹤過程中出現的背景干擾、目標遮擋等問題,提出基于多特征融合的均值漂移算法和最小二乘法軌跡預測跟蹤方法。為解決背景干擾問題,使用改進的混合高斯模型對背景實施建模,提取運動前景目標,采用提取出的運動信息結合顏色、紋理特征對目標進行描述,在跟蹤過程中利用運動信息去除背景噪聲的干擾,從而適應背景和目標的變化,得到目標位置,當遮擋發生時,根據目標遮擋前的先驗信息預測最小二乘法的目標軌跡,有利于重新捕獲目標。實驗結果表明,與已有的跟蹤方法相比,該方法在復雜背景和遮擋過程中對目標的定位更精確,魯棒性更好。

背景建模;均值漂移算法;多特征融合;運動信息;最小二乘法

1 概述

視覺跟蹤問題是計算機視覺領域中的一個重要問題。將3D視覺投射到2D圖像中,圖像的噪聲、雜亂的背景、復雜目標的運動、部分或者全部遮擋、光照變化等引起信息的丟失,使得視覺跟蹤具有挑戰性。從目標的全局信息中提取的區域特征,如顏色、紋理、灰度已經廣泛用于目標跟蹤領域[1]。很多基于顏色、紋理、梯度方向直方圖的跟蹤算法能夠很好地跟蹤變化的目標。文獻[2]用改進的局部二值模式(Local Binary Pattern,LBP)直方圖對目標進行跟蹤,降低了跟蹤的錯誤率。然而空間信息的不足導致直方圖描述受限制,很難識別具有相同顏色屬性的目標。而且單一的特征無法處理現實跟蹤環境中多變的情況,跟蹤目標和所處環境的變化使得跟蹤不精確、魯棒性差,為了改善這些問題,其中一種方法就是建立基于多特征的目標模型。文獻[3]提出一種多特征有效融合和更新的目標跟蹤方法,對復雜的跟蹤場景具有更強的魯棒性。文獻[4]提出結合LBP和Ohta顏色特征的協方差跟蹤算法。為

了加強基于概率假設密度(Probability Hypothesis Density,PHD)跟蹤性能,文獻[5]使用尺度不變特征和顏色特征對目標進行描述,在目標外形與背景區域相似的情況下,提高狀態估計和數量估計的穩定性和魯棒性。多特征融合不僅可以在估算狀態時提供更可靠的觀測值,而且不同的線索之間可以是互補的,當一個失敗另一個可能會成功。對于這種算法的關鍵及挑戰是如何優化融合多特征。LBP和顏色是目標的全局信息,具有較高的可信度,但是這些全局特征用在目標發生部分遮擋時跟蹤效果往往不好,所以,結合目標的局部信息。文獻[6]將角點特征與顏色特征融合,使得跟蹤穩定性與抗遮擋能力優于基于單一角點或顏色特征的均值漂移算法。運用均值漂移算法對目標進行跟蹤的研究方法在目前的跟蹤領域運用比較廣泛[7-8]。文獻[9]提出基于均值漂移算法跟蹤框架,結合顏色紋理直方圖對目標進行跟蹤,該方法提高了跟蹤的精確性和有效性。所以,跟蹤方法好壞的關鍵在于提取目標有效的外觀模型。文獻[10]利用偏最小二乘法對目標的正副樣本提取低維特征子空間,獲得具有判決性的外觀模型。

以上跟蹤方法都會受到復雜背景的影響,為了消除背景噪聲,本文提出一種結合運動信息的跟蹤方法。利用改進的混合高斯模型(Improved Gaussian Mixture Model,IGMM)對背景進行建模,對圖像進行二值化,從背景中提取運動目標,將運動目標的信息融入到基于顏色和紋理的均值漂移算法框架中,消除背景影響,并在目標發生遮擋時,利用最小二乘法對目標的軌跡進行預測。

2 特征提取與描述

2.1 均值漂移算法

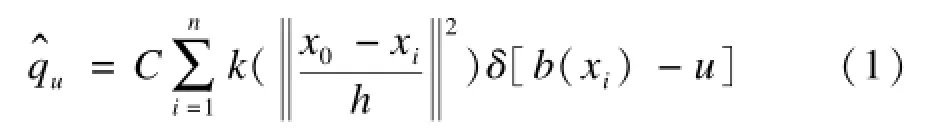

均值漂移算法是基于顏色特征和紋理特征對目標的形狀進行描述,對視頻序列中的目標區域的像素點,計算該特征空間中所有特征值的概率,就可以得到目標特征模型如下:

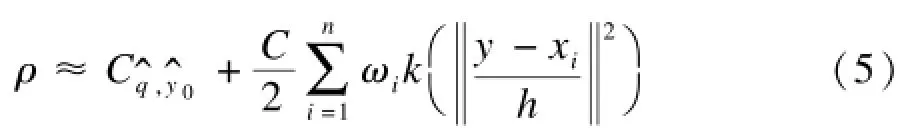

其中,C為歸一化常數;k為核函數;xi表示目標區域中第n個元素;x0表示目標的中心;b(xi)為像素點到像素特征的映射。以y為中心的候選目標區域的特征模型如下:

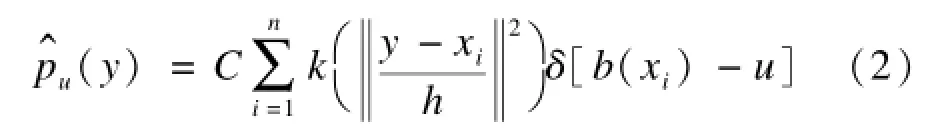

對目標區域和候選區域建立特征模型之后,利用Bhattacharyya系數度量候選區域與目標區域的相似性,如下:

一階泰勒展開式如下:

其中,C為特征的歸一化系數,并且有:

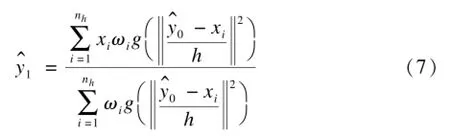

通過對相似度系數函數求最大值,可以得到目標的位置,如下:

2.2 改進混合高斯模型提取運動特征的方法

背景減除法在運動目標檢測算法中運用最廣泛。它是利用背景圖像與當前圖像的差分來檢測運動區域并將運動的目標從背景圖像中提取出來。背景減除法的關鍵是建立背景模型。

本文在混合高斯模型的基礎上結合幀差法提出了改進的混合高斯模型進行背景建模。混合高斯模型使用K個高斯分布來表示圖像中各個像素點的特征,用得到的新一幀圖像更新混合高斯模型,用當前圖像中的每個像素點與混合高斯模型匹配,如果匹配成功則判定為背景點,否則為前景點。

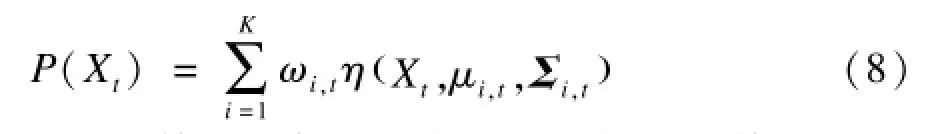

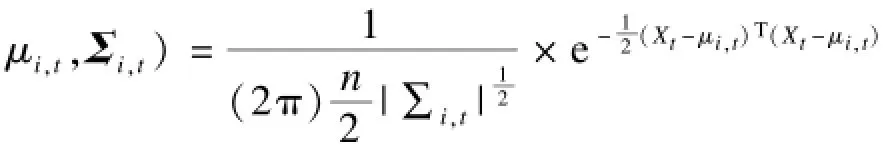

設在任意時刻t,像素點的灰度值為X,其概率密度函數為:

其中,α,β是學習率,且0≤α≤1,α的大小決定背景

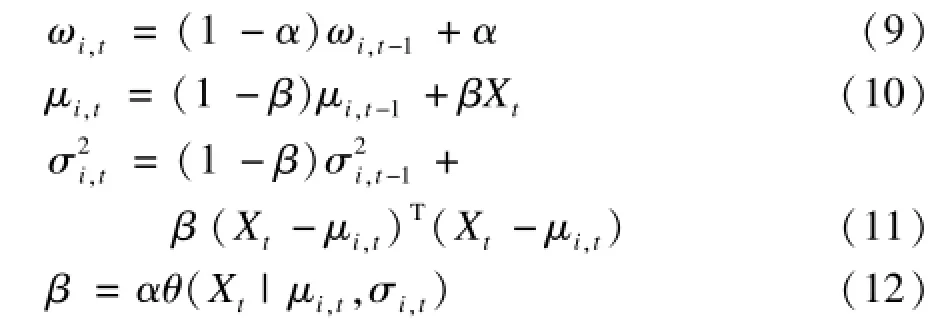

更新的速度,α越大,更新速度越快,α越小,更新速度越慢。更新完成后重新對混合高斯分布按優先級ρi,t由大到小進行排序。用前B個分布建立背景模型:

其中,T′是權重閾值。

在圖像處理過程中,幀間差分算法在檢測移動目標重疊部分時魯棒性較弱,很容易出現空洞現象。此外,由于幀間差分后的圖像包含2幀中相對變化的信息,檢測出的目標輪廓大小大于實際尺寸,而且目標快速移動時會出現重疊現象。本文提出基于動態閾值的3幀差分方法處理這個問題。算法的基本思想如下:

分別定義3個連續幀圖像fn(x,y),fn+1(x,y),fn+2(x,y),通過動態閾值分割得到二值圖,最后進行與操作得到移動目標的信息:

當Dk為1是前景,否則作為背景。Z為固定二值化閾值。經過以上操作后圖像仍然有比較大的噪聲點,所以,使用連通性分析算法[11]在4個或者8個相連區域檢測像素的連通性,以便找到屬于同一個連通區域的像素點,然后將低于閾值的連通區域作為干擾區域去除,保留目標區域。

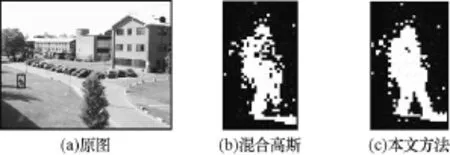

當使用混合高斯模型和3幀差分法分別得到視頻中移動目標后,將兩者得到的二值圖像進行或操作。最終獲得完整的移動目標。如圖1所示,用IGMM處理圖像幀,產生二值圖。它使當前幀分為兩部分,一部分是比背景亮的區域,目標落在此區域的概率比較高;另一部分是暗的區域,目標不落在此區域的概率比較高。第n幀的二值圖表示為:

圖1 2種方法提取的目標二值圖對比

2.3 結合運動信息的多特征描述

融合顏色直方圖的均值漂移算法是一種常用的目標跟蹤方法,單一的顏色特征使得算法具有計算量小的優點。然而單一的顏色特征可能無法識別目標,因為提取目標顏色特征中包含了背景顏色特征,這樣在用均值漂移算法根據顏色特征進行跟蹤時,由于背景的干擾容易出現偏差,而且顏色特征對光照變化敏感,對顏色變化依賴程度高,不適合背景混淆和光照變化場合下跟蹤。而紋理特征正好彌補了這些缺點[12]。LBP算法是以窗口中心點灰度值為閾值對窗口內其他像素作二值化處理,然后根據像素不同位置進行加權求和得到該窗口的LBP值,是目標的一種比較穩定的特征信息。

在跟蹤過程中,從連續幀之間的差異獲得的運動信息保存了所有移動的目標,同時,也包含了不感興趣的區域。因此,與運動信息相結合的顏色和紋理特征去除了這些不感興趣區域。

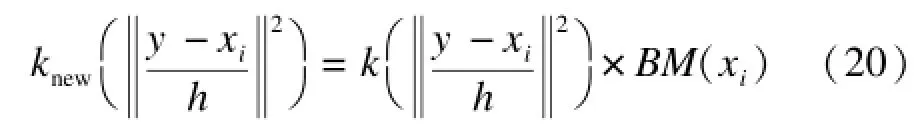

在本文所述的顏色和紋理特征融合到均值漂移算法框架的一般步驟中,2種特征在一定程度上有互補作用,當其中一種特征收到干擾,另外一個特征可實現補充功能。為了消除背景的干擾,在均值漂移算法框架中結合運動信息BM(xi),新的內核函數為:

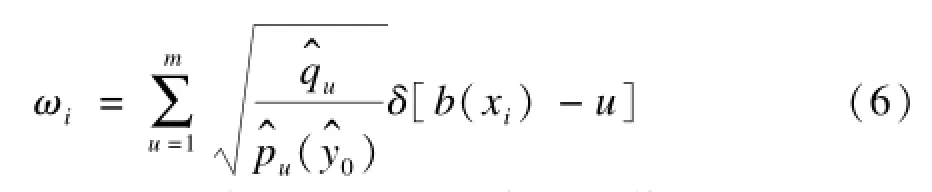

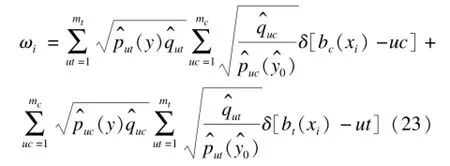

在計算目標新位置時,重新定義的權值:

2.4 多特征融合

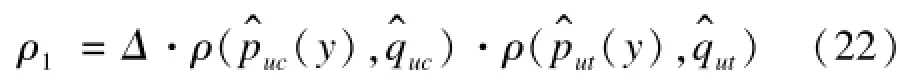

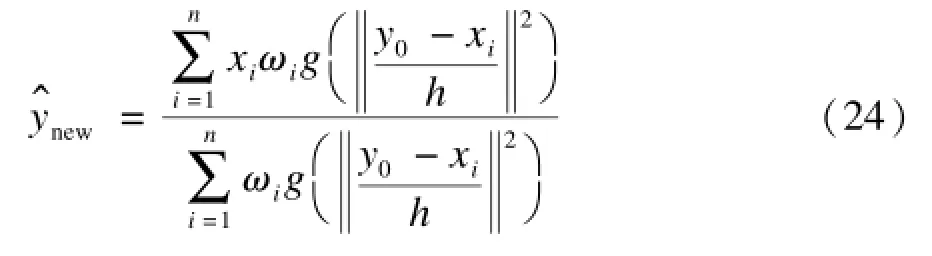

結合運動信息對目標區域和候選區域進行相應的特征描述之后,利用文獻[13]提出的融合相似性函數來度量候選與目標區域的相似性,利用對當前幀的搜索結果,確定相似性函數的最大值,得到目標位置:

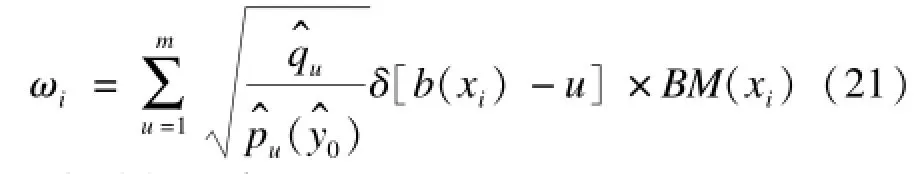

其中,ρ1為融合相似度系數,它由顏色和紋理的巴氏系數相乘得到的;Δ為敏感系數,取值區間為(0,1)。融合的相似系數與巴氏系數成正比,該值越大,ρ1越大,跟蹤效果好。由均值漂移算法可得,融合后的權值系數ωi為:

最終得到的目標位置為:

2.5 跟蹤算法

均值漂移算法容易受到遮擋的影響,因為當前幀中均值漂移算法迭代是根據前面幀迭代的結果計算的[14],所以當目標發生嚴重長時間遮時,跟蹤窗口將會漂移,算法就無法繼續跟蹤目標。運用最小二乘法擬合,可以根據先前得到的目標位置預測目標在遮擋時的軌跡,以便于在目標出遮擋物時能夠重新捕捉到目標。具體方法如下:

(1)首先運用改進的GMM模型對圖像幀進行背景建模,得到二值圖,計算目標的運動信息分布BM(xi)。

(2)分別計算目標和候選目標的顏色直方圖和紋理直方圖。

(3)將運動信息融入到均值漂移算法跟蹤框架中。

(4)將計算的到的顏色和紋理的巴氏系數相乘,得到融合相似度系數ρ1,新的取值ωi和目標的位置new。

(5)若目標發生遮擋,啟用最小二乘法進行目標軌跡估計。

遮擋過程由遮擋判定、遮擋處理兩部分組成。如果目標發生遮擋,跟蹤框中的非零像素會減少,當小到一個預先設定好的閾值時,判定目標發生遮擋,此時,啟用最小二乘法根據前m幀中目標的位置來對目標在下一時刻的位置進行預測。當目標出遮擋物時,重新啟用均值漂移算法繼續跟蹤目標。

3 實驗結果與分析

本文所有實驗基于Matlab2012a環境,在主頻2.10 GHz內存2.00 GB的PC計算機上完成。實驗的Man和Car視頻分別來自CAVIAR項目組和文獻[15]的MIT Traffic Data Set里的視頻序列。Man視頻一共80幀,其特點為跟蹤目標處于復雜的背景環境中。Car視頻一共97幀,目標為十字路口的汽車,在行駛過程中有遮擋情況。

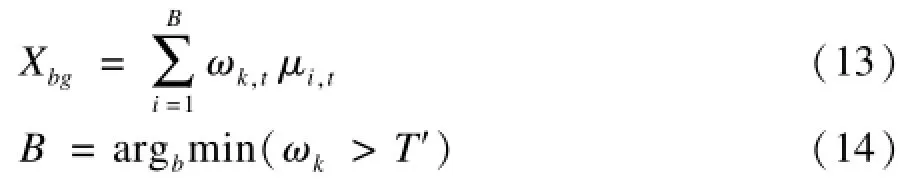

首先對視頻Man進行測試,目標為經過商店門口的行人。實驗結果如圖2所示,其分別為跟蹤結果的第5幀、第55幀和第68幀。

圖2 本文方法與其他跟蹤方法的比較

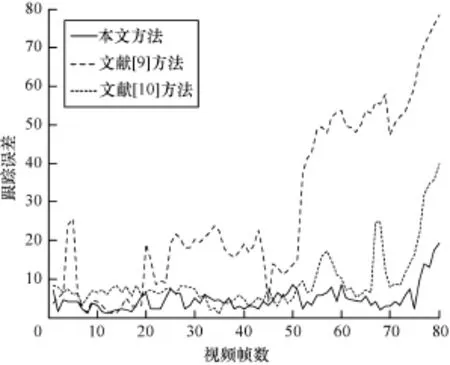

結合圖2(a)和圖3的跟蹤誤差曲線可以看出,由于該跟蹤序列中的行人處于背景比較復雜的場景中,因此文獻[9]基于顏色紋理的均值漂移算法對運動目標進行跟蹤時,在第5幀的時候,跟蹤的誤差出現比較大的波動,到第55幀時跟蹤目標基本丟失,這是因為當目標受到復雜背景環境影響時,簡單結合的顏色和紋理特征能自適應環境變化,造成了跟蹤結果的不準確,質心發生了較大的偏差,使得目標跟蹤失敗。從圖2(b)可以看出,文獻[10]雖然能跟蹤到目標,但是隨著時間的推移,跟蹤誤差越來越大。而本文方法能夠準確跟蹤目標,這主要是因為提取目標運動的信息能夠消除背景的干擾,即使背景特征與目標相似,也不會影響目標特征的提取。

圖3 跟蹤誤差曲線

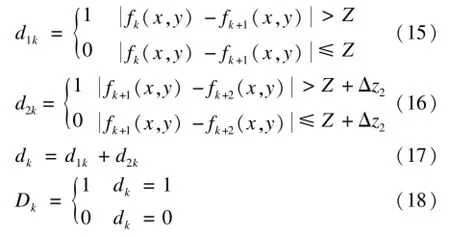

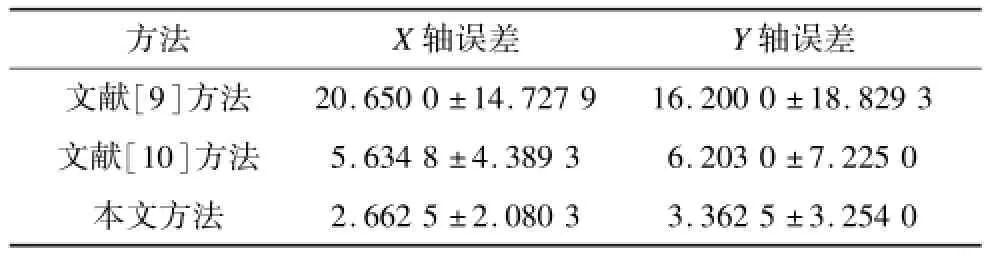

圖3的跟蹤誤差曲線和表1中的跟蹤誤差數據更清楚地反映出,本文方法和其他2種方法的差異。開始時除了文獻[9]在第5幀有明顯的波動,三者算法的差異性不是很大,隨著時間的推移,由于受到復雜背景的干擾,在第20幀后文獻[9]方法開始出現

較大偏差,逐漸丟失目標。第51幀后文獻[10]出現較大波動,雖然跟蹤沒有失敗,但是跟蹤的結果沒有本文方法跟蹤精確,因為文獻[10]沒有把目標從復雜背景中分離出來,容易受到背景的干擾,得不到精確的跟蹤結果。

表1 跟蹤誤差(均值±標準差)

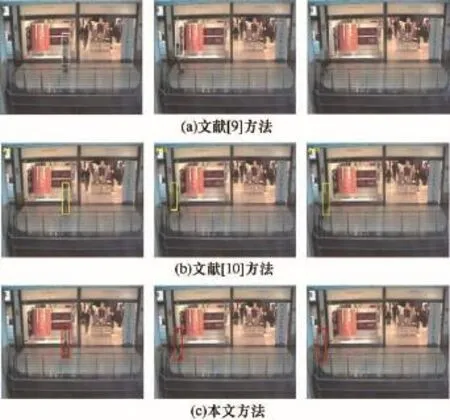

為了驗證本文方法在目標發生遮擋能夠繼續跟蹤目標,采用Car視頻進行實驗。圖4中跟蹤目標是交通十字路口的汽車,如圖4所示,圖4(a)為第69幀目標進入遮擋區域,圖4(b)為第92幀目標出遮擋區域,從左至右依次為文獻[9-10]方法和本文方法的跟蹤結果。

圖4 3種方法進/出遮擋物的跟蹤效果從圖4可以看出,文獻[9-10]方法在目標進遮擋區域時,受到遮擋物的影響,跟蹤出現偏差,在目標嚴重遮擋時跟蹤框一直停留在遮擋物上,無法在目標出遮擋物時捕捉到目標繼續跟蹤。本文方法在目標遮擋時結合最小二乘法對目標的位置進行預測,繼續跟蹤目標,在目標移出遮擋物時,能夠重新捕獲到目標并繼續進行跟蹤。

4 結束語

均值漂移算法在視頻跟蹤中無法精確跟蹤處于復雜背景和顏色相似遮擋物的目標。為此,本文提出一種改進的均值漂移算法對目標進行跟蹤。結合運動信息去除背景噪聲的干擾,結合最小二乘法對目標在遮擋情況下的位置進行預測,以便在目標出遮擋物時能夠被捕獲。實驗結果表明,該方法能使跟蹤結果更精確。然而,當目標處于動態背景或者鏡頭移動的場景中時,該跟蹤方法效果欠佳,如何處理動態場景下目標的跟蹤問題將是今后研究的重點。

[1]Kemp C,Drummond T.Multi-modal Tracking Using Texture Changes[J].Image and Vision Computing, 2008,26(3):442-450.

[2]Yuan Jirui,Egiazarian K.Multiple-level Patch-based Object Tracking Using MLBP-based Integral Histogram[C]// ProceedingsofIS&T/SPIEElectronicImaging.Burlingame,USA:International Society for Optics and Photonics,2013.

[3]李遠征,盧朝陽,李 靜.一種基于多特征融合的視頻目標跟蹤方法[J].西安電子科技大學學報:自然科學版,2012,39(4):2-8.

[4]Dash P P,Patra D,Mishra S K.Local Binary Pattern as aTextureFeatureDescriptorinObjectTracking Algorithm[C]//Proceedings of International Conference on Advanced Computing,Networking,and Informatics.Berlin,Germany:Springer,2014:541-548.

[5]Wu Jingjing,HuShiqiang,WangYang.Adaptive Multifeature Visual Tracking in a Probability Hypothesis Density Filtering Framework[J].Signal Processing, 2013,93(11):2915-2926.

[6]宋 丹,趙保軍,唐林波.融合角點特征與顏色特征的Mean Shift目標跟蹤算法[J].系統工程與電子技術, 2012,34(1):199-203.

[7]Mazinan A H,Amir-Latif A.Improvement of Mean Shift Tracking Performance Using an Efficient Convex Kernel Function and Extracting Motion Information[J].Computer and Electrical Engineering,2012,38(6): 1595-1615.

[8]Mazinan A H,Amir-Latif A.A New Algorithm to Rigid and Non-rigid Objects Tracking in Complex Environments[J].International Journal of Advanced Manufacturing Technology,2012,64(9/12):1643-1651.

[9]Ning Jifeng,Zhang Lie,David Z,et al.Robust Object Tracking Using Joint Color-texture Histogram[J].World Scientific,2009,23(9):1245-1263.

[10]Wang Qing,Chen Feng,Xu Wenli,et al.Object Tracking via Partial Least Squares Analysis[J].IEEE Transactions on Image Processing,2012,21(10):4454-4465.

[11]Zhang Shunmiao,LvDongkai.AMotionDetection Algorithm Based on Surendra Background Updating and BackgroundSubtraction[J].JouranalofNangjing Institute of Technology,2011,9(2):22-27.

[12]李遠征,盧朝陽,高全學,等.基于多特征融合的均值遷移粒子濾波跟蹤算法[J].電子與信息學報,2010, 32(2):411-415.

[13]楊 欣,費樹岷,李 剛,等.基于復雜特征融合的改進Mean Shift目標跟蹤[J].控制與決策,2014, 29(7):1297-1300.

[14]Wen Jing,Gao Xinbo,Yuan Yuan,et al.Incremental Tensor Biased Discriminant Analysis:A New Color-based Visual Tracking Method[J].Journal of Neurocomputing,2010, 73(4/6):827-839.

[15]Wang Xiaogang,Ma Xiaoxu,Grimson E.Unsupervised Activity Perception in Crowded and Complicated Scenes UsingHierarchicalBayesianModels[J].IEEE TransactionsonPatternAnalysisandMachine Intelligence,2009,31(3):539-555.

編輯 劉 冰

Target Tracking Method Combined with Motion Feature

ZHOU Mingzhu,ZHOU Zhiping

(School of Internet of Things Engineering,Jiangnan University,Wuxi 214122,China)

A novel target tracking method for target’s localization with mean shift based on multiple features and least squares method prediction is proposed to solve background interference,problems of partial occlusion and other issues.Aiming at the problems of background interference,the Improved Gaussian Mixture Model(IGMM)is proposed to build background model and to extracted foreground moving object.The motion information,color information and texture information are fused to represent the target,according to the change of the target and backgrounds,combined with the motion feature to remove noise interference of background and to locate the object.In the occlusion process,when the mean shift integrating multi-feature fails to track the target,it can use least squares method to predict the location of the target.Experimental results demonstrate that the method can track the target accurately and has better robustness in complex backgrounds or occlusion situations.

background modeling;mean shift algorithm;multi-feature fusion;motion information;least square method

周明珠,周治平.結合運動特征的目標跟蹤方法[J].計算機工程,2015,41(3):242-246.

英文引用格式:Zhou Mingzhu,Zhou Zhiping.Target Tracking Method Combined with Motion Feature[J].Computer Engineering,2015,41(3):242-246.

1000-3428(2015)03-0242-05

:A

:TP391

10.3969/j.issn.1000-3428.2015.03.045

國家自然科學基金資助項目(61373126)。

周明珠(1988-),女,碩士,主研方向:圖像處理,目標跟蹤;周治平,教授、博士。

2014-04-08

:2014-05-29E-mail:6121905018@vip.jiangnan.edu.cn