特征融合和模型自適應更新相結合的相關濾波目標跟蹤

王 暐,王春平,李 軍,張 偉

(1. 軍械工程學院2系,河北 石家莊 050003;2. 中國人民解放軍 63813 部隊,海南 文昌 571339;3. 中國人民解放軍 66285 部隊,河北 懷來 571339)

?

特征融合和模型自適應更新相結合的相關濾波目標跟蹤

王暐1*,王春平1,李軍2,張偉3

(1. 軍械工程學院2系,河北 石家莊 050003;2. 中國人民解放軍 63813 部隊,海南 文昌 571339;3. 中國人民解放軍 66285 部隊,河北 懷來 571339)

提出了一種基于自適應特征融合和自適應模型更新的相關濾波跟蹤算法(CFT)。該算法在跟蹤的訓練階段利用損失函數計算特征的自適應權重,在檢測階段對不同特征的響應圖進行加權求和,從而實現了響應圖層面的自適應特征融合。設計了自適應的模型更新策略,采用響應圖的峰值旁瓣比判斷是否發生遮擋或錯誤跟蹤,據此決定是否在當前幀更新目標模型。在11個視頻序列上對所提算法進行了實驗,驗證了所采用的自適應特征融合策略和自適應模型更新策略的有效性。與多個傳統的采用單特征的相關濾波跟蹤算法進行了比較,結果顯示,所提算法的跟蹤精度和成功率典型值分別提升了18.2%和11.5%。實驗結果驗證了特征融合和自適應模型更新對跟蹤算法的改進具有指導意義。

視覺跟蹤;相關濾波跟蹤;特征融合;模型自適應更新

*Correspondingauthor,E-mail:wang_wei.buaa@163.com

1 引 言

目標跟蹤是計算機視覺領域的基礎性研究,在精密控制、自動駕駛、安全監控等場景有著廣泛的應用[1-2]。自上世紀80年代,跟蹤算法的研究主要經歷了光流法[3]、基于mean shift的跟蹤[4]和基于粒子濾波的跟蹤[5]等。近十年來,許多學者采用機器學習方法設計魯棒的跟蹤算法,使視覺跟蹤的研究有了長足進步[1],特別是最近比較熱的一類是基于相關濾波的跟蹤算法(Correlation Filter based Tracking, CFT),它具有精度高、速度快、魯棒性好的特點[6],已成為了新的研究熱點。

相關研究表明,特征表達對CFT的跟蹤性能有非常重要的影響[7]。原始CFT僅利用灰度特征進行跟蹤,Henriques等[7]對CFT特征進行了多通道擴展,利用角度梯度直方圖(Histogram of Oriented Gradient, HOG)[8]進行跟蹤,使算法的跟蹤精度有了大幅提升。MARTIN等[9]采用顏色名[9]特征(Color Name, CN),并通過奇異值分解來提升跟蹤速度,對彩色視頻序列的跟蹤取得了較大的提升。MA等[10]結合分層深度特征對CFT進行了改進。但是,每種特征是從不同方面對目標進行表達的,對各不同視頻序列的跟蹤性能差異較大。Yang等[11]將CN和HOG進行組合后用于CFT框架,提出了MF跟蹤算法,實驗結果表明特征融合能夠有效提高跟蹤性能。但文獻[11]采用串接方式將CN和HOG進行組合,無法針對每個視頻序列進行最優的特征融合。此外,CFT在跟蹤時只采用線性累加的方式更新濾波器模型[6,7],易將不正確的目標表觀更新到濾波器模型中,從而引起漂移。

為此,本文提出一種基于特征融合和模型自適應更新的相關濾波跟蹤算法(Feature Fusing and model Adaptive Updating based Tracking method, FAUT)。首先,利用相關濾波響應圖評估各特征的跟蹤性能,在跟蹤過程中自適應地對特征響應圖進行加權,以提升跟蹤性能。其次,設計了一種自適應的濾波器模型更新策略,根據響應圖的峰值旁瓣比決定是否更新跟蹤模型,提高了更新的可靠性。在若干視頻序列上的對比實驗驗證了所提算法的有效性。

2 FAUT

本節將對所提算法進行詳細描述:首先簡要介紹CFT的基本原理,然后對特征在響應圖層面的自適應融合進行具體描述,在2.3節給出自適應更新策略,最后對所提算法進行總結。

2.1CFT的基本原理

視覺跟蹤的任務為:在視頻序列的第一幀由人工或檢測算法給定目標狀態(一般為目標的最小外接矩形,需要指定矩形中心坐標和邊長)的情況下,由跟蹤算法估計目標在后續每一幀中的狀態。

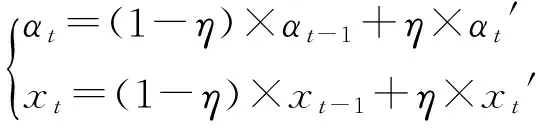

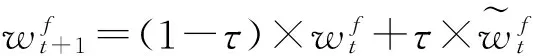

與大多數跟蹤算法相同,CFT在每一幀的跟蹤中包括兩個階段:目標檢測和濾波器模型訓練(更新)。第一幀時,由于目標狀態已知,可直接根據目標狀態訓練濾波器模型,濾波器模型由濾波器系數α和目標模板x構成,目標模板x即目標區域的特征表達,濾波器系數α采用嶺回歸方法訓練[6]。對于第t(t>1)幀圖像,CFT首先根據第t-1幀訓練的濾波器模型(αt-1,xt-1)進行相關濾波,得到濾波響應圖,響應圖的最大值處即對應檢測到的目標狀態;然后根據檢測結果訓練濾波器(αt′,xt′),接著采用線性插值更新濾波器,

(1)

其中,η為插值系數,實驗中取固定值0.015。圖1(彩圖見期刊電子版)所示為CFT跟蹤流程,具體細節請參考文獻[6, 7]。

圖1 CFT的一般跟蹤流程圖Fig.1 Flowchart of traditional CFT

圖2 CN和HOG特征的特點示意圖Fig.2 Characteristics sketch of CN, HOG features

2.2自適應特征融合

圖2(彩圖見期刊電子版)為當存在復雜背景+劇烈光照變化或目標存在連續姿態變化時,單獨使用CN和HOG特征的結果。雖然CN和HOG特征都能有效提升CFT的跟蹤性能[7,9]。但是,如圖2上所示,當背景光照發生劇烈變化時,單獨采用CN的CFT均不能有效地從背景中判別出目標;而如圖2下所示,當目標發生較大形變時,單獨采用HOG的CFT跟蹤失敗,表明HOG特征無法較好地處理目標變形、旋轉等問題[11]。

事實上,CN和HOG的特征是互補的。如果在原始圖像上進行差分操作(求梯度),將差分操作的次數稱為階次,則CN和HOG分別為圖像的0階和1階特征,它們可從不同方面對圖像進行表達。顏色和梯度對應視覺系統中不同層面的神經元,它們從不同的層面對圖像進行抽象和特征提取,顏色對目標形狀、尺度等具有較好的不變性,而梯度對光照等具有較好的不變性[12]。單個特征的表達能力有限,制約了CFT跟蹤性能的提升,考慮到顏色和梯度特征的互補性,本文提出從濾波響應圖層面進行特征融合,并從不同的方面對目標進行表達,以提升跟蹤性能。同時,為了增加融合的適應性,在對不同視頻序列進行跟蹤時對特征進行自適應加權,以突出視頻幀中更具判別力的特征。

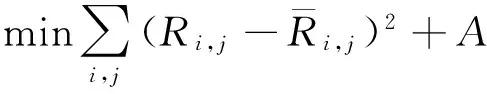

在跟蹤訓練階段計算和更新特征權重。CFT采用嶺回歸方法訓練濾波器,訓練中采用如下的損失函數:

(2)

第t幀訓練中,損失差的計算簡寫如下,

(3)

其中:sum(·)表示對矩陣內每一項求和,F={CN,HOG}表示特征的集合。特征f對應的歸一化的權重為:

(4)

其中:{F-f}表示F中不同于f的另一特征。

(5)

(6)

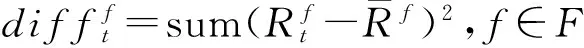

2.3自適應更新策略

由于跟蹤過程中目標及背景是動態變化的,因此跟蹤算法要對目標表觀模型進行實時更新。傳統的CFT采用式(1)的線性插值方法進行更新,能夠保留目標在之前幀的濾波器模型,同時也可以及時將最新的表觀加入到模型中。但是當跟蹤出現偏差,或者目標被遮擋時,式(1)會將錯誤的目標表觀信息引入到模型中,從而使跟蹤誤差不斷累積,導致后續幀中引入的誤差增大,最終導致跟蹤失敗,即產生所謂的漂移。為了避免上述問題,需要設計自適應的模型更新策略。

為了正確更新目標的表觀模型,大多數跟蹤算法[13]都通過對跟蹤質量的評價實現,即檢測跟蹤中是否發生遮擋或較大誤差。而跟蹤質量評價方法應與具體的跟蹤算法相結合。對于相關濾波跟蹤,其濾波響應圖的形狀能夠有效反映跟蹤質量。當目標被遮擋或跟蹤出現偏差時,濾波的響應峰值較小,當背景復雜或存在干擾物體時,濾波響應圖的峰值附近會產生偽峰值,這兩種情況均會使目標相對于背景的響應值不夠突出。針對響應圖的這種性質,參考文獻[14],本文引入響應圖的峰值旁瓣比(Peak to Sidelobe Ratio,PSR)對跟蹤結果進行評價,PSR的計算方法如下,

(7)

其中:p為響應圖Rt的最大值(峰值),峰值周圍的區域定義為旁瓣,μ和σ分別為旁瓣區域的均值和標準差。實驗中,將峰值周圍c×γ的區域定義為旁瓣區域,以避免背景區域對PSRt值計算的干擾。PSRt越大,表明跟蹤結果越可靠。本文預定義更新閾值U,只有當PSRt>U時,更新濾波器模型和權重,否則不更新。

2.4所提算法

綜上所述,FAUT算法的流程如下。

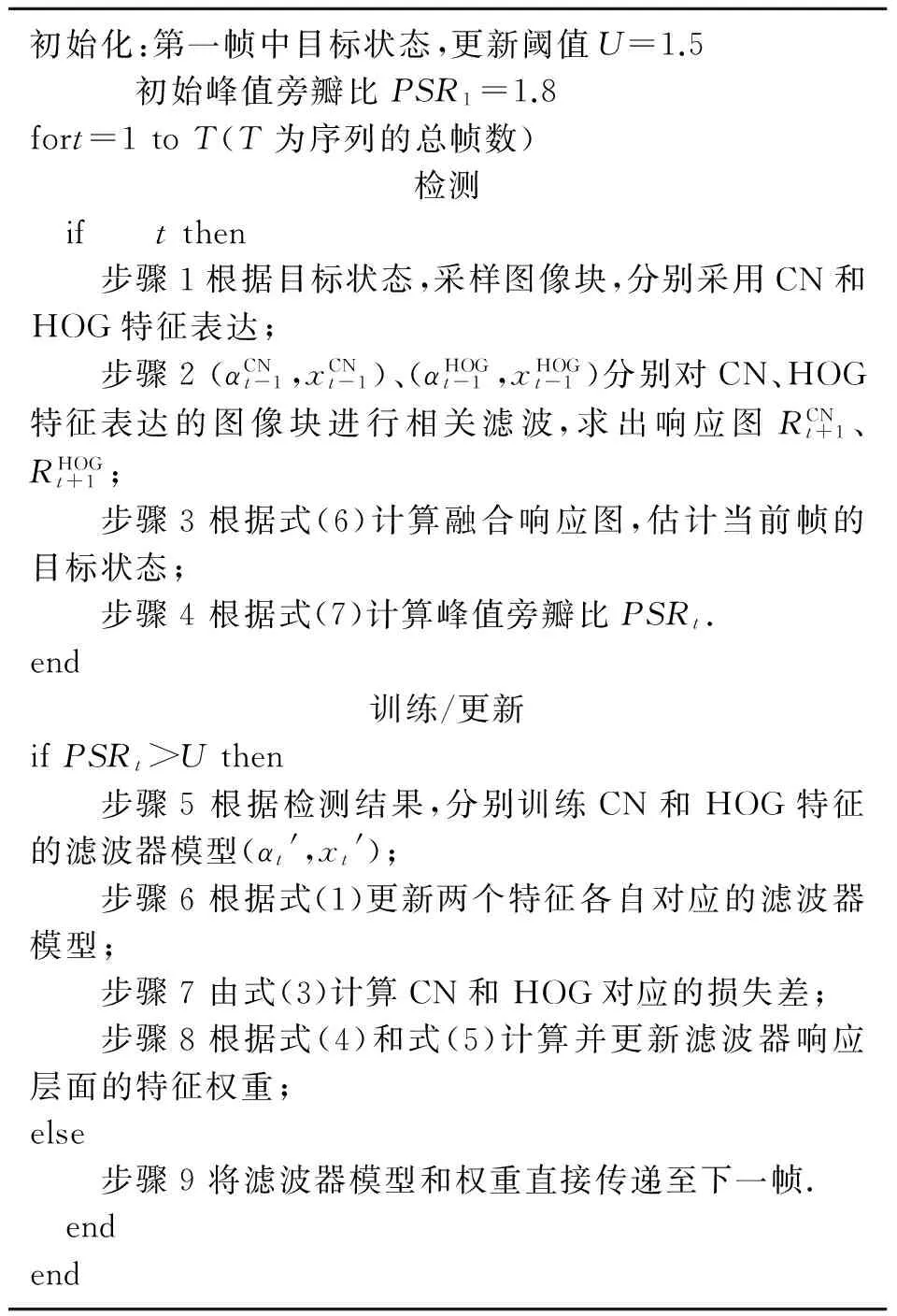

初始化:第一幀中目標狀態,更新閾值U=1.5 初始峰值旁瓣比PSR1=1.8fort=1toT(T為序列的總幀數)檢測 if tthen步驟1根據目標狀態,采樣圖像塊,分別采用CN和HOG特征表達;步驟2(αCNt-1,xCNt-1)、(αHOGt-1,xHOGt-1)分別對CN、HOG特征表達的圖像塊進行相關濾波,求出響應圖RCNt+1、RHOGt+1;步驟3根據式(6)計算融合響應圖,估計當前幀的目標狀態;步驟4根據式(7)計算峰值旁瓣比PSRt.end訓練/更新ifPSRt>Uthen步驟5根據檢測結果,分別訓練CN和HOG特征的濾波器模型(αt',xt');步驟6根據式(1)更新兩個特征各自對應的濾波器模型;步驟7由式(3)計算CN和HOG對應的損失差;步驟8根據式(4)和式(5)計算并更新濾波器響應層面的特征權重;else步驟9將濾波器模型和權重直接傳遞至下一幀. endend

3 實 驗

為評估所提算法的性能,本文進行了兩組實驗分析:一、對所提算法進行了詳細的分析實驗,以驗證特征融合和更新策略的有效性;二、與其它7種算法在11個序列上進行了對比實驗。

實驗中,旁瓣區域的邊長c和r為目標邊長的0.1倍,預定義更新閾值U取為1.5,HOG特征提取參數的設置與文獻[7]相同。

3.1FAUT算法分析

本文在視頻序列Soccer上對提出的自適應特征融合策略和更新策略進行了實驗分析。

3.1.1自適應特征融合

圖3為CN和HOG特征在每幀的自適應權重值,可見在整個跟蹤過程中特征權重不斷變化。第31幀,目標存在快速運動,運動模糊導致目標結構信息丟失,表現為該幀的HOG特征響應圖在非目標中心出現較大響應,而CN特征的響應較為集中,融合后的響應圖能夠確定目標中心。第210幀時,目標存在尺度變化,使得CN特征在距離目標中心較遠處出現了高響應,而HOG特征的峰值響應則明顯降低。但由于特征權重的自適應變化,融合后的響應圖抑制了CN特征響應圖中背景的高響應,使其具有了更明顯的峰值。

3.1.2自適應更新策略

圖4為跟蹤中每幀的峰值旁瓣比PSR。在Soccer序列第44、156幀,目標處于候選區域中心,且較為清晰,故PSR值遠大于自適應閾值U。第54、106、112幀,目標出現運動模糊或被嚴重遮擋,如果在這幾幀更新濾波器模型,則會導致漂移。而本文由于采用自適應更新策略,上述幀的PSR值均小于閾值U,故不對濾波器模型進行更新。該序列的目標尺度在200幀以后逐漸變小,而所提FAUT采用的PSR能夠在這種情況下保持較大的值,如第287幀,通過不斷更新濾波器模型,實現了穩定跟蹤。這也驗證了所提自適應更新策略的有效性。

圖4 峰值旁瓣比PSR結果(Soccer序列上)Fig.4 Results of PSR

實時性分析算法運行平臺為配置2.6 GHz i5處理器、4 GB內存的普通電腦,仿真環境為Matlab 2014b。對于視頻序列Soccer,本文算法、KCF和CNT每秒跟蹤的幀數分別17.5、55.2和24.1,所提算法基本能滿足實時性要求。

3.2算法對比分析

對所提FAUT算法進行了定量的對比分析。對比算法包括4種CFT框架下的算法:原始CSK[6](采用灰度特征)、CNT[9](采用CN特征)、KCF[7](采用HOG特征)、MF[11](采用CN和HOG直接組合的特征),以及其它3種近幾年提出的跟蹤算法:Struck[14]、CXT[15]、MIL[16]。采用的11個序列均來自于文獻[1],包括:Bolt、Couple、Deer、Fish、Football、Football1、Freeman1、Matrix、MountainBike、Soccer、Tiger2。這些序列包含了光照變化、遮擋、變形、快速運動、旋轉、背景干擾等跟蹤中常見的挑戰性場景,保證了公平對比。

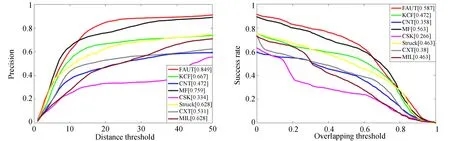

在分析中采用精度曲線和成功率曲線進行定量對比。某一幀圖像中,跟蹤算法的跟蹤框與標注的真實目標框的中心距離稱為距離精度,兩個框的重疊面積與總面積之比為重疊率。精度曲線的橫軸為給定的距離精度閾值,縱軸為跟蹤的距離精度大于給定閾值的圖像幀占所有圖像幀的比例。通常取閾值為20個像素時的精度曲線值(P20)為典型值。成功率曲線的橫軸為給定的重疊率閾值,當跟蹤的重疊率大于給定閾值時認為該幀跟蹤成功。成功率曲線的縱軸為跟蹤成功的幀占所有圖像幀的比例,將曲線下方的面積(AUC)作為該曲線的典型值。

圖5(彩圖見期刊電子版)為本文算法和其它7種算法在11個序列上的精度曲線和成功率曲線。由圖5可見,FAUT算法的跟蹤精度和成功率明顯高于Struck、CXT和MIL。在5種CFT框架下的跟蹤算法中,3種采用單獨特征的算法(即KCF、CNT和CSK)性能差異較大,這驗證了特征對CFT跟蹤算法的重要性。實驗結果還顯示,采用特征融合算法(即所提FAUT和MF)的性能明顯優于KCF、CNT和CSK。相比于單特征中性能最優的KCF算法,所提FAUT的P20和AUC分別提高了18.2%(0.849 vs 0.667)和11.5%(0.587 vs 0.472),這是因為多特征融合能夠從不同方面對目標進行表達,從而提高了跟蹤算法的判別力,驗證了本文特征融合策略的有效性。相比于通過串接HOG和CN特征直接進行融合的MF算法,FAUT避免了錯誤的濾波器模型更新,P20和AUC最大分別提高了9%和2.4%,驗證了更新策略的有效性。

圖5 所提FAUT算法與其它7種算法的性能對比結果Fig.5 Tracking results of proposed FAUT method and other 7 tracking methods

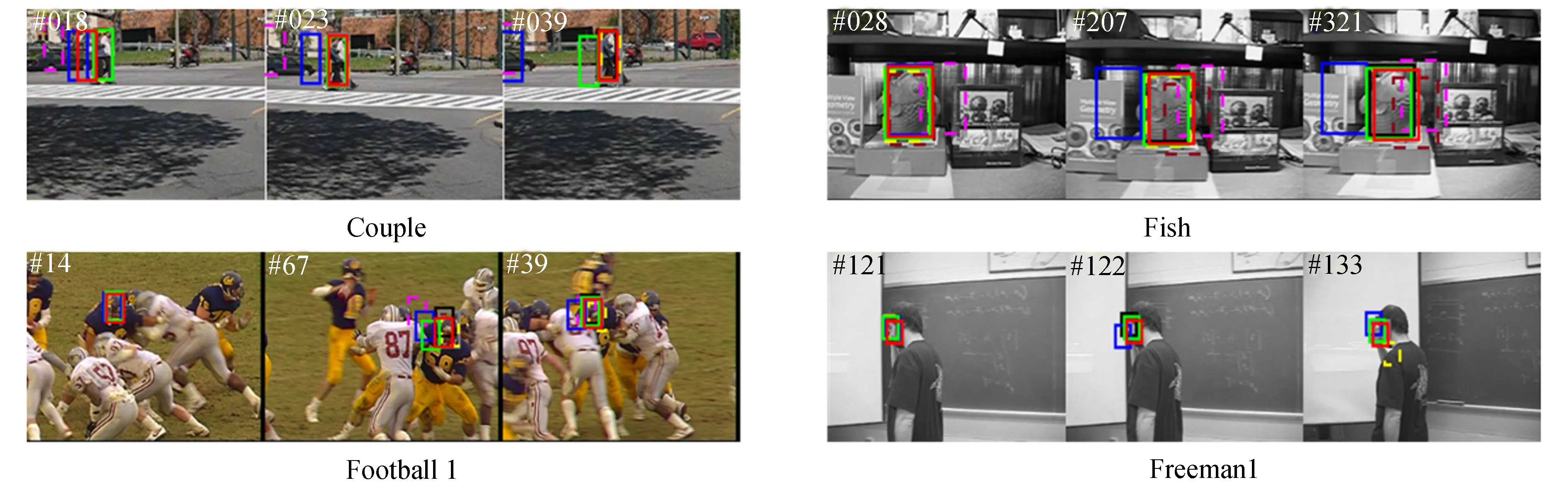

圖6(彩圖見期刊電子版)為FAUT與其他7種算法的定性分析結果,本文主要對FAUT、CNT、KCF、MF等4種算法進行對比分析。

Couple序列:第18幀中,背景車輛與目標顏色相似,導致本文FAUT和CNT出現跟蹤偏差,但由于PSR小于預定義的閾值,FAUT未更新目標模型,且由于FAUT采用了目標的紋理信息(即HOG特征)進行跟蹤,使目標更易于從背景中區分出來,所以在第23幀中FAUT又重新捕獲了目標。第39幀中,目標與背景的顏色差異較大而具有類似的紋理信息,導致KCF跟蹤失敗,而FAUT和MF能夠繼續跟蹤目標。

Fish序列:該序列為灰度序列,所以僅采用顏色信息的CNT跟蹤失敗。目標具有明顯的紋理,所以FAUT、KCF和MF均能成功跟蹤目標。

Football1序列:該序列中目標快速運動且背景變化較大,導致多數算法在第67幀中跟蹤失敗,只有所提FAUT能夠準確跟蹤運動員頭部,這進一步驗證了特征融合和自適應更新的有效性。

Freeman1和Football序列:在這兩個灰度序列上CNT依然最早丟失目標,而其他3種算法則能夠實現準確跟蹤,且FAUT的跟蹤結果最準確。

Deer序列:第25幀,由于目標的快速運動出現了模糊,導致HOG特征的判別力下降,KCF丟失目標。第29幀,MF由于錯誤的模型更新發生漂移,而所提算法依然能準確跟蹤目標。

MountainBike序列:該序列中目標與背景在顏色和紋理上差別均較為明顯,且不存在遮擋現象,所以CFT框架下的幾種算法均能準確跟蹤目標。

Tiger2序列:第227幀中,目標被強光照射,顏色特征失效,MF和CNT跟蹤發生偏差,KCF和所提FAUT則能夠準確跟蹤。第343幀中,由于旋轉目標紋理發生較大變化,KCF跟蹤失敗,而其它3種采用了顏色特征的CFT算法則可穩定跟蹤目標。

上述定性分析進一步表明本文所采用的自適應特征融合和更新策略有效提升了跟蹤效果。

圖6 所提FAUT與其它7種算法的跟蹤結果展示。圖2、圖3和圖4已經對序列Bolt、Matrix、Soccer進行了分析,故此處不再列出。Fig.6 Screenshots of tracking results for FAUT and other 7 methods

4 結 論

本文從自適應特征融合和自適應模型更新兩個方面對CFT進行了研究。首先,將CN和HOG兩種互補的特征在濾波響應圖層面進行融合,并利用訓練過程中的損失函數自適應地計算特征權重。其次,針對原始CFT在每一幀中無差別地更新濾波器模型,會導致錯誤跟蹤或發生遮擋時濾波器模型性能惡化,利用濾波響應圖的峰值旁瓣比對遮擋和錯誤跟蹤進行評估,實現了自適應更新。通過對所提FAUT算法的詳細分析和與其他算法的對比實驗,得出FAUT較其它CFT框架下的跟蹤算法性能更優,驗證了特征融合和自適應模型更新對跟蹤算法的重要性,對后續跟蹤算法的研究有一定的指導意義。

[1]WU Y, LIM J, and YANG M H. Online object tracking: A benchmark[C].2013IEEEConferenceonComputerVisionandPatternRecognition(CVPR),Portland,USA, 2013: 1354-1362.

[2]YILMAZ A, JAVED O, SHAH M. Object tracking: a survey[J].ACMComputingSurveys, 2006, 38(4):1-45.

[3]DECARLO D, METAXAS D. Optical flow constraints on deformable models with applications to face tracking [J].InternationalJournalofComputerVision, 2000, 38(2): 99-127.

[4]COMANICIU D, RAMESH V, MEER P. Kernel-based object tracking[J].IEEETransactiononPatternAnalysisandMachineIntelligence, 2003, 25(5):564 -577.

[5]MEI X,LING H B. Robust visual tracking and vehicle classification via sparse representation[J].IEEETransactionsonPatternAnalysisandMachineIntelligence, 2011, 33(11): 2259 -2272.

[6]HENRIQUES J F,CASEIRO R, MARTINS P,etal.. Exploiting the circulant structure of tracking-by-detection with kernels[C].EuropeanConferenceonComputerVision,Florence,Italy, 2012: 702-715.

[7]HENRIQUES J F,CASEIRO R,MARTINS P,etal..High-speed tracking with kernelized correlation filters[J].IEEETransactionsonPatternAnalysisandMachineIntelligence, 2015, 32(9): 1627-1645.

[8]FELZENSZWALB P F,GIRSHICK R B,MCALLESTER D,etal..Object detection with discriminatively trained part-based models[J].IEEETransactionsonPatternAnalysisandMachineIntelligence, 2010, 32(9): 1627-1645.

[9]MARTIN D, FAHAD S K, MICHAEL F,etal.. Adaptive color attributes for real-time visual tracking[C].IEEEConferenceonComputerVisionandPatternRecognition,Columbus,USA, 2014: 1090-1097.

[10]MA C, HUANG J B, YANG X K,etal.. Hierarchical convolutional features for visual tracking [C].InternationalConferenceonComputerVision,Santiago,Chile, 2015: 3038-3046.

[11]YANG L, ZHU J K. A scale adaptive Kernel correlation filter tracker with feature integration[C].EuropeanConferenceonComputerVision,Zurich,Switzerland, 2014: 254-265.

[12]JIANG Y S, MA J W. Combination features and models for human detection[C].IEEEConferenceonComputerVisionandPatternRecognition,Boston,USA, 2015: 240-248.

[13]WANG N Y, SHI J, YEUNG D,etal.. Understanding and diagnosing visual tracking systems[C].InternationalConferenceonComputerVision,Santiago,Chile, 2015: 3101-3109.

[14]BOMLE D S, BEVERIDGE J R, DRAPER B A,etal.. Visual object tracking using adaptive correlation filters[C].IEEEConferenceonComputerVisionandPatternRecognition,SanFrancisco,USA, 2010: 2544-2550.

[15]SAM H, AMIR S,PHILIP H. Struck: Structured output tracking with kernels[C].InternationalConferenceonComputerVision,Barcelona,Spain, 2011: 263-270.

[16]THANG B, NAM V, GERARD G M. Context tracker: Exploring supporters and distracters in unconstrained environments[C].IEEEConferenceonComputerVisionandPatternRecognition,ColoradoSprings,USA, 2011: 1177-1184.

[17]BORIS B, YANG M H, SERGE J B. Visual tracking with online multiple instance learning[C].IEEEConferenceonComputerVisionandPatternRecognition,Miami,USA, 2009: 983-990.

王暐(1989-),男,甘肅靖遠人,博士研究生,主要從事計算機視覺、嵌入式系統設計方面的研究。E-mail:wang_wei.buaa@163.com

王春平(1965-),男,陜西漢中人,教授,博士生導師,主要從事圖像處理、火力控制理論與應用方面的研究。E-mail:wchp17@139.com

(版權所有未經許可不得轉載)

Correlation filter tracking based on feature fusing and model adaptive updating

WANG Wei1*,WANG Chun-ping1, LI Jun2, ZHANG Wei3

(1.The2ndDepartment,OrdnanceEngineeringCollege,Shijiazhuang050003,China; 2.The63813UnitoftheChinesePeople′sLiberationArmy,Wenchang571339,China; 3.The66285UnitoftheChinesePeople′sLiberationArmy,Huailai571339,China)

A Correlation Filter based Tracking(CFT) method based on adaptive feature fusing and model adaptive updating is proposed. The proposed method computes the adaptive feature weights by using the loss function of a filter model in training stage, and performs the weighted summing for response maps with multiple features in detection stage. Then it realizes the adaptive feature fusing of response maps. Furthermore, an adaptive model updating strategy is designed to estimate the occlusions and wrong tracking results by utilizing the Peak to Sidelobe Ratio (PSR) of the response maps. The model is updated only when the PSR is small enough. The proposed method is tested on 11 video sequences to verify the validity of the proposed adaptive feature fusing and model adaptive updating strategies. Comparing with other CFT methods by using single feature, the proposed tracker has significantly improvements, by 18.2% in representative precision score and 11.5% in representative success score. Experimental results demonstrate that the adaptive feature fusing strategy and model updating strategy are all effective for improving tracking performance.

vision tracking; correlation filter tracking; feature fusion; model adaptive updating

2016-06-06;

2016-06-24.

國家自然科學基金資助項目(No.61141009)

1004-924X(2016)08-2059-08

TP391

A

10.3788/OPE.20162408.2059