體感操控多臂棚室機器人作業決策規劃算法研究

權龍哲 李成林 馮正陽 劉佳偉

(東北農業大學工程學院, 哈爾濱 150030)

體感操控多臂棚室機器人作業決策規劃算法研究

權龍哲 李成林 馮正陽 劉佳偉

(東北農業大學工程學院, 哈爾濱 150030)

針對目前棚室內機器人作業分析算法智能性不足、準確作業率較低,且一次巡航過程只能進行單一作業,存在使用效率不高的問題,提出了一種搭載在三臂棚室機器人上,基于體感操控作業的決策規劃算法,用Kinect采集含操作人員位姿信息的深度圖像,結合隨機森林統計學習理論和基于高斯核函數的Mean shift算法,確定了代表人體位姿的20個關鍵骨骼點坐標,在此基礎上提出了一種基于模式切換的三臂映射關系,將骨骼點信息映射到機器人工作空間,使人的兩只手臂能自如的控制三臂機器人,在一次巡航中完成多種棚室作業;此外,還提出了一種結合骨骼追蹤技術和YCbCr顏色空間的手勢特征分割方法,實現了用手勢控制機器人末端執行器作業。最后,搭建了用于測試體感決策算法的三臂機器人樣機,進行了針對該決策算法的精確性試驗,根據試驗誤差數據對肩部關節夾角采用離散化取值識別,解決了肩部關節識別誤差,結果表明:測試者被捕捉到的關節處夾角和機器人對應關節夾角的最大映射誤差為1.90°,上位機發送夾角值與機器人實際轉動的夾角值最大誤差為0.80°,在誤差允許范圍內,同時在該精度下完成一套采摘加噴施作業指令,平均耗時13.34 s,且操作者還可通過體感操控訓練進一步提高機器人作業性能,表明該算法具有準確性和實用性。

多臂溫室機器人; 決策規劃; 體感技術; Kinect傳感器

引言

現代智能棚室及植物工廠多為閉鎖式農產品生產系統,為避免作物大面積染病,進入廠區的工作人員需更換無塵服并接受全面除菌消毒,另外人員長期處于密閉環境中開展采摘、噴施等棚室作業不利于身體健康[1-2],利用農業機器人代替人工作業是有效的解決途徑[3-4]。國內外學者在基于自主視覺的基礎上,對葡萄噴藥、收獲[5-6],番茄采摘、分揀[7-9],草莓[10]、黃瓜采摘[11-12],獼猴桃收獲[13]等農業機器人進行了研究,取得了較大進展,但為適應復雜的田間環境及多變的作業需求,目前相關研究人員正致力于進一步提升機器人的智能性。

目前在工業領域,國內外學者[14-21]設計并研制基于Kinect體感操作的機械臂或機器人,可由人直接遠程操控,實時模仿人體動作,代替人完成某些繁重、危險的作業,具有較高的實用價值;但經查閱資料發現,該應用思路在農業領域未見報道。針對上述傳統智能棚室或植物工廠人工作業模式存在較多弊端,而智能農業機器人系統的普適性尚需完善的現狀,本文設計一種基于 Kinect 的遠程體感操控農業機器人,將遠程體感操控技術應用于無人棚室及植物工廠中,避免人員的頻繁進出及辛勞作業;由人代替智能算法進行識別,運用體感技術使機器人模仿操作人員的動作進行采摘、噴施等棚室作業,達到整個運動規劃過程由人完成,且該過程對于人來說是極其容易的;考慮到當前棚室機器人在一次巡航過程中基本為單一作業,存在效率較低的現狀,為機器人設計三臂結構以提高效率,并針對此結構提出一種基于模式切換的三臂映射關系和結合骨骼點信息與YCbCr顏色模型的手勢特征提取算法,使操作人員可輕松操控三臂機器人在一次棚室巡航中完成如采摘、施肥等多種作業。

1 基于體感操控的三臂機器人

1.1 機械構型

圖1所示是用于搭載體感決策算法的三臂棚室機器人樣機。該機器人由三臂作業機構、自鎖升降機構、履帶底盤、機器人控制系統、視覺系統5部分組成。三臂結構中的右臂末端執行器可對目前棚室或植物工廠種植的大部分果蔬進行采摘,并將采摘后的果蔬放入左臂末端的果蔬收納盒中,從而使機器人在一次棚室巡航作業中能采摘更多的果蔬,提高機器人的工作效率;后臂末端的三通道噴灑機構能分別噴灑水、營養液、農藥,以滿足智能棚室或植物工廠作物在不同生長時期的需求。自鎖升降機構使機器人能適應不同高度的棚室作物。旋轉圓盤承載整個機器人上半身,使機器人上半部分能夠旋轉,是實現三臂模式切換和全方位作業的基礎。履帶底盤由2個直流無刷電動機驅動,能夠實現原地轉向和無級變速。

圖1 三臂多功能棚室農業機器人機構簡圖Fig.1 Structure diagram of three-arm multi-function greenhouse agriculture robot1.旋轉底座 2.剪切器 3.右臂 4.可更換式抓持器 5.儲液罐(共3個) 6.自鎖升降機構 7.履帶底盤 8.旋轉圓盤 9.果蔬收納盒 10.三通道噴灑機構 11.左臂 12.后臂 13.無線攝像頭

1.2 工作原理

機器人控制系統通過無線設備接受上位機的命令,控制各關節伺服電動機轉動。機器人視覺系統由無線攝像頭、Kinect體感攝像頭和上位機組成,Kinect采集人體動作信息,通過無線設備將信息發送給機器人,使機器人模仿人體動作進行作業,實現人員對機器人的遠程體感操控;機器人頭部裝有無線攝像頭,攝像頭底座為旋轉底盤,可擴大視角,負責對棚室或植物工廠內工作環境進行實時監控,并用無線設備將攝制的視頻回傳到上位機,整個機器人工作流程如圖2所示。其中,欲實現機器人在體感操控下的棚室作業,首先需使用Kinect采集人體動作信息并映射到機器人工作空間,因而人體信息的準確采集和映射關系的對應建立是實現三臂機器人棚室作業的基礎。

圖2 三臂多功能棚室農業機器人工作流程圖Fig.2 Work flow of three-arm multi-function greenhouse agriculture robot

2 面向三臂機器人操控的人體動作信息采集

2.1 骨骼點數據預處理

由深度圖像得到面向三臂操控的骨骼點數據,本文采用Kinect獲得操作人員的深度圖像。Kinect由紅外線發射器、RGB攝像頭、紅外線接收器和麥克風陣列組成,采用光編碼技術進行景深成像,生成操作人員所在場景的深度信息[22]。得到深度圖像后,計算出每個像素點歸一化的深度差信息作為該點的特征量,即

(1)

其中

θ=(μ,v)

式中dI(x)——包含操作人員的圖像I中像素x的深度

μ、v——偏移量

使用隨機決策樹和森林分類器對該深度圖像像素點的特征向量與決策樹的閾值τ進行比較,根據結果往左或右劃分,算出x像素在t棵樹中的條件概率分布,最后得到所有樹的分布平均值P(L|I,X)為

(2)

式中T——決策樹的個數Pt(L|I,X)——圖像I中x像素在第t棵樹中的條件概率分布

將其值作為最終的分類依據,把像素點劃分到對應骨骼點的歸屬集合,在此為能夠表示操作人員位姿且考慮到三臂操控的需要,將集合數設定為20個(即最后得到的骨骼點數為20)。此后,還需從這些集合中找到概率分布峰值對應點,將其作為被捕捉的操作人員骨骼點坐標[23]。在此,本文采用引入高斯核的Mean shift算法,其主體公式為

(3)

其中

wic=P(c|I,xi)dI(xi)2

2.2 骨骼點數據規劃

經上述算法得到骨骼數據后,將其導入到上位機中,將得到的骨骼點數據轉化為一個20×3的矩陣,該矩陣中每行的數據分別對應一個骨骼點的x、y、z坐標,坐標單位為m,骨骼點坐標的建立方式如圖3所示,其中z軸坐標表示人到Kinect的距離,y軸坐標表示各個骨骼點與xOz平面的距離,x軸坐標則表示骨骼點與yOz平面的距離。

圖3 Kinect骨骼點世界坐標系建立示意圖Fig.3 Schematic of Kinect of skeletal points in WCS

然后把具有三維坐標的20個骨骼點經坐標變換,對應映射到RGB攝像頭所攝圖片的二維像素坐標系中,最后繪出操作人員操控三臂機器人所需的20個骨骼點坐標在RGB圖片中的分布位置,如圖4所示,且對各個骨骼點進行命名,以便表達。

圖4 面向三臂機器人操控的骨骼架構示意圖Fig.4 Schematic of skeletal point for three arms robot1.頭部 2.肩部 3.右肩 4.右肘 5.脊椎 6.右腕 7.右手8.右髖 9.右膝 10.右踝 11.右腳 12.左腳 13.左踝 14.左膝 15.左手 16.左腕 17.左髖 18.臀部 19.左肘 20.左肩

3 骨骼點信息與三臂機器人映射關系的建立

將Kinect骨骼點數據導入上位機初步處理后,接下來便將含人體動作特征的骨骼點信息對應映射到機器人工作空間,該步驟正是實現體感操控機器人的關鍵。但考慮到機器人具有三臂結構,且3個機械臂對應不同的棚室作業類型。如何使人兩臂能自如控制棚室三臂機器人作業是保證其功能與效率的前提。在此,提出一種基于模式切換的三臂映射關系,以實現人體兩臂控制機器人三臂作業。

3.1 骨骼點數據處理

根據三臂機器人結構特點,把機器人作業的模式分為作業模式和巡航模式。其中作業模式又分為采摘模式和噴施模式,采摘模式指機器人在無人棚室或植物工廠中對已成熟的作物進行采摘作業;而對于其中未成熟、營養不足或出現病蟲害的作物,體感操控機器人切換到噴施模式,對作物進行澆水或施肥或除蟲作業。機器人的巡航模式則對應在棚室或植物工廠中移動、轉向。對于機器人前進、后退、轉向、作業狀態之間的切換,本文根據人相對于Kinect空間位置的不同,作為進入不同模式的依據,該位置量化為向量

(4)

其中α為體感算法捕獲到人體骨骼點舍去y值后的坐標,用以表示操作人員在xOz平面中與Kinect的位置關系,這樣可使切換模式不會受人身高和Kinect豎直擺放位置的影響,使整套控制決策算法具有普適性。而對于具體使用哪個骨骼點(x,z)作為人體空間位置的表示,考慮到脊椎點處于Kinect骨架的中間部分,且該點對操作人員身高、姿態、外界干擾等各種因素具有較小的敏感性,能很好的表示人體在xOz平面的位置信息,因此本文采用脊椎的x、z坐標來表示人體相對于Kinect的位置。同時對于模式切換時的閾值規劃,本文將Kinect視野范圍劃分為如圖5所示的若干個區間,機器人根據人體脊椎點所屬區域不同而進入不同的工作模式。將各個區間的長寬值整合為一個閾值矩陣

(5)

其中,l1=100 cm,l2=50 cm,l3=100 cm,l4=50 cm,l5=50 cm,l6=60 cm,l7=50 cm,l8=250 cm。

在此,為方便說明,將閾值矩陣T中的各個長度元素看成1個長度區間的集合。

圖5 體感操作區域平面示意圖Fig.5 Schematic of Kinect operation area

由此可得,當滿足

(α(3)∩T(1,2))∩(α(1)∩T(2,2))≠?

(6)

時,參照圖5可知,人體被上位機識別為進入前進區域;此時機器人開始向前直線運動,即進入巡航模式。其他模式的切換同理。

3.2 基于模式切換的三臂映射關系

考慮到劃分過多、區域過小時可能出現識別跳變,導致模式切換穩定性較差,本文將采摘模式和噴施模式都集成為作業模式,根據上述閾值判斷法,若滿足

(α(3)∩T(1,3))∩(α(1)∩T(2,2))≠?

(7)

時,則被識別為進入作業區域,此時機器人只能在采摘模式和噴施模式之間切換,進行采摘或噴灑作業。因此需設定一個特征量作為模式切換決策閾值,該特征量需具有以下特點:①特征量對周圍環境干擾具有較強的魯棒性。②不與三臂體感操作相干擾。以保證模式切換的準確性和處在某一模式作業時的穩定性。

3.2.1 基于統計方法尋找模式切換最優特征量

考慮到該機器人上部為三臂結構,下部為履帶式移動平臺的特點,人體上部的骨骼信息映射數量較多,而下部則僅由脊椎骨骼點空間坐標便可控制機器人底盤運動,造成下部分的骨骼點都未得到利用。因此,可將人體下部分的骨骼點構成一個可作為模式切換的特征量。本文從骨骼點架中左腿選取2個骨骼點,再從右腿中選取與之對稱的2個骨骼點,共4個骨骼點分別組成代表左右腿的兩向量,將其稱為1個向量組,用其夾角表示人兩腿之間的夾角,并以此作為模式切換特征量,但如何選取出夾角值不受其他動作干擾的向量組合是保證模式切換效率與穩定的關鍵。在此,本文隨機征集了身高范圍在165~190 cm,體重范圍在45~90 kg的10位測試者,收集了他們在較長時間(5 min)進行采摘或噴灑作業時腿部骨骼點坐標數據。取時間步長為1 s,利用分別位于兩腿對稱位置的骨骼點組合出6組能表示雙腿夾角的向量組合,計算出5 min內每1 s每個向量組合夾角,每人1個向量組合,300組夾角數據,再對每人6個向量組合的300組夾角分別求方差,最后把10位測試者對應每個組合的向量夾角方差求平均值,得到表1所示數據。

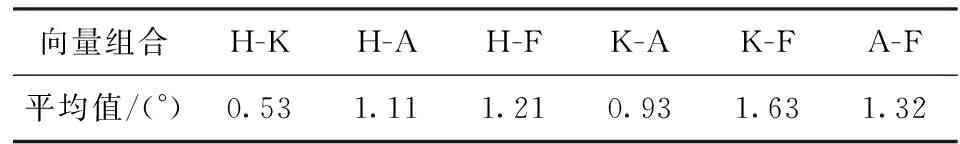

表1 測試者Kinect骨骼點向量夾角方差統計Tab.1 Statistics of variance in testers’ Kinect skeletal joints

注: H-K表示骨骼點右髖與骨骼點右膝形成向量與右腿對應骨骼點左髖和骨骼點左膝形成向量的夾角,其余向量組合均用此方法解釋。

表1中,H-K向量組合的夾角方差平均值最小,表明這4個骨骼點表示的夾角幾乎不會受其他作業動作影響,能夠滿足棚室作業時對模式切換穩定性的要求。于是用這4個點像素坐標構成向量組合的夾角,作為模式切換的特征量,從圖4可看出,該特征量對應的人體特征為操作人員左右髖部骨骼點到兩膝骨骼點之間形成的向量組在空間上的夾角,空間上的夾角穩定也就意味著其在xOy與yOz平面上夾角的穩定。設Kinect骨骼點中右髖、 左髖、 右膝、 左膝在平行于xOy平面上的骨骼點坐標分別為(x1,y1)、(x2,y2)、(x3,y3)、(x4,y4)。

設模式切換特征量為

(8)

其中

(9)

(10)

本文設定一個閾值Tτ=12°,當T1>Tτ時,機器人處于采摘作業模式,其左右兩臂根據人體映射到機器人工作空間的骨骼點信息進行采摘作業,反之則進入噴施模式。同樣,再將H-K向量組合在yOz平面上的夾角定義為一個特征量

(11)

其中

(12)

(13)

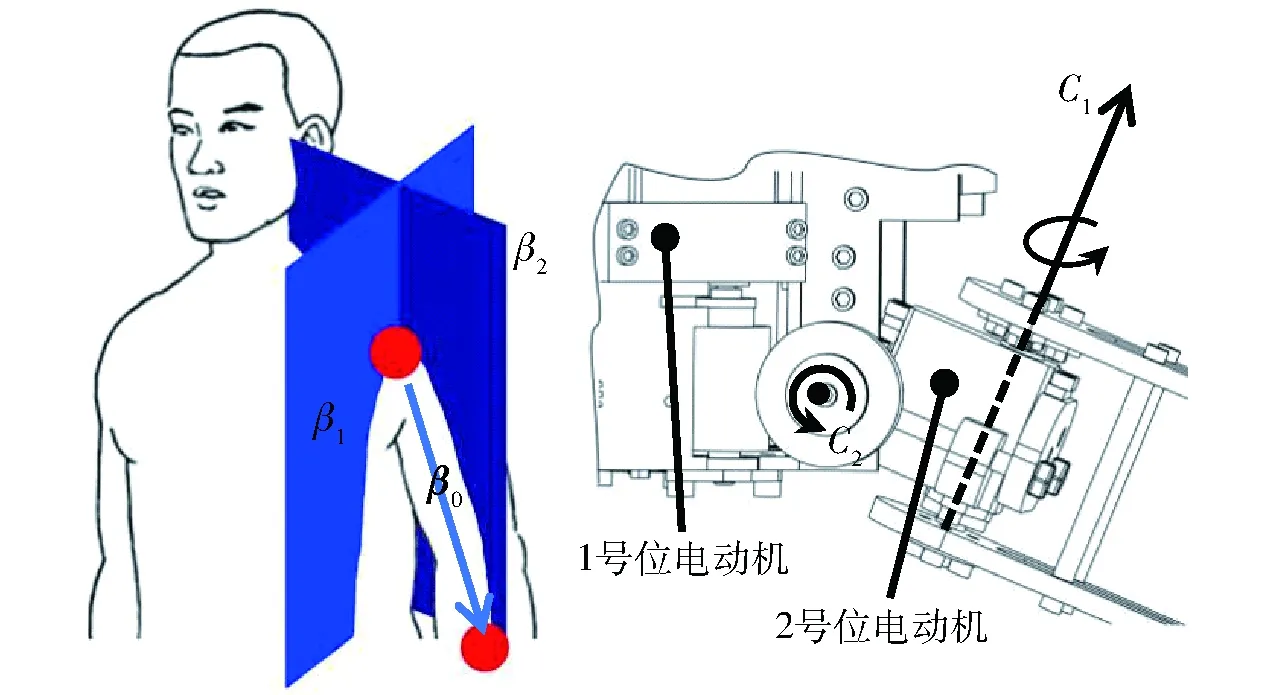

設定一個閾值Tξ=14°,當T2>Tξ,且保持該狀態超過4 s時,頭部攝像頭下面的伺服電動機便開始轉動,以增大視角范圍,T2 3.2.2 肩部關節映射關系的建立 機器人的手臂構造與人臂不同。如圖6所示,機器人的肩關節只有2個空間自由度;而對于人臂,在只考慮肩關節和肘關節時,人臂有5個自由度。在此,先設β0為右肩關節與右肘關節骨骼點構成的向量,β01、β02分別表示β0在xOy平面和yOz平面投影得到的向量,于是把人的右肩部運動位姿分解為向量β01與平面β1以及β02與平面β2的夾角,設右肩關節與右肘關節點的坐標分別為(xs,ys,zs)、(xe,ye,ze),則 (14) (15) (16) 把β01與β1面夾角映射到機器人工作空間作為軸C2的轉角。且由于β1面平行于骨骼點坐標空間的yOz平面,因此,向量β01與平面β1夾角即為β01與yOz平面的夾角,可求得 (17) 其中 同理,β2面平行于骨骼點坐標空間的xOy平面,可求得β02與β2平面夾角,即對應C1轉角 (18) 右肩關節與右肘關節組成的向量與平面夾角為0°時,對應機器人相應關節處伺服電動機的零位。 圖6 人體肩關節運動信息到機械臂關節的映射Fig.6 Mapping of Shoulder in motion information to joint of robot arm 3.2.3 肘部關節映射關系的建立 人的肘關節為球銷副,具有2個空間自由度,但繞手臂自身軸線旋轉的動作無法被Kinect識別。因此,Kinect只能捕獲到1個自由度的肘關節信息,但恰與肘部為轉動副連接的機器人運動特點相對應。但是由于肘關節和腕關節相對于世界坐標系的位置由肩關節的位姿決定,造成了表示肘部關節位姿時無法像上述肩關節夾角一樣與某固定平面形成夾角即可描述對應關節點的運動姿態。因此本文建立如圖7所示采用空間向量的右肘關節映射關系,直接根據3個骨骼點在世界坐標系中的坐標組成2個向量,用其構成的夾角描述該運動位姿。 圖7 肘關節映射Fig.7 Mapping of Elbow 右肘關節分別與右肩關節點和腕關節點組成向量β3、β4,即 (19) (20) 其中,腕關節點的坐標為(xw,yw,zw)。根據空間向量夾角計算公式 (21) 即可算出肩、肘、腕三關節之間形成的夾角,并將其映射為機器人右肘部關節運動角度。至此,整個機器人的右臂便與Kinect捕捉的人體骨骼點之間建立了相應的映射關系;由于機器人3只手臂結構只有各自的末端執行器不同,其余構造均相同,因此機器人后臂、左臂與上述映射關系一致,此處便不再贅述人體動作和其運動關系之間的映射情況。后臂是在切換到噴施模式時才能由人體右臂驅動,采摘模式時,只有左右兩臂才能運動,而且換到噴施模式時,左右兩臂又被鎖死。 3.2.4 三臂機器人末端執行器的映射控制 三臂機器人具有針對不同作業類型的末端執行器,能夠完成多種棚室作業。其中,機器人右臂末端是1個軟軸式仿手形抓持器(圖8a),能夠有效地對類橢球形果蔬進行抓取;此外,還可將其更換為面向長條形果蔬的末端抓持器(圖8b)。右臂手上還裝有1個由伺服電動機驅動的剪切器,與抓持器集成在右臂上(圖1中部件2、4),協同工作,減少操作人員的操作負擔,提高采摘效率。 圖8 右臂可更換式末端執行器Fig.8 Replaceable end effector in right arm 由于本文使用的是Kinect第一代設備,其深度圖像得到的骨骼點信息對于手勢識別誤差較大。為提高本系統的可操作性與穩定性,本文采用基于骨骼點信息和YCbCr顏色空間結合的手勢分割法提取操作人員的手勢特征,再用其控制3個末端執行器。該手勢特征提取方法為:得到手部骨骼點后,分割出一個以該點為中心的圖像。而且經測得,在總圖像尺寸為640像素×480像素時,尺寸為50像素×50像素的分割圖像基本能囊括整個手部。得到分割圖像后,接下來便是提取手部特征,本文采用基于YCbCr空間的手部提取方法,即先把分割出的基于RGB空間的手部圖像轉化到YCbCr顏色空間,其中Y為顏色的亮度成分,Cb和Cr則為藍色和紅色的濃度偏移量成分,而且經統計表明不同人種膚色主要受亮度信息影響,而受膚色信息的影響很小,所以直接考慮YCbCr空間的Cb、Cr分量,映射為CbCr空間,在該空間下,受亮度變化的影響小,而且發現膚色在CbCr空間的分布呈現良好的聚類特性,統計分布滿足[26] 77≤Cb≤127 (22) 133≤Cr≤173 (23) 基于此分布得到聚類分割出的手部二值圖像后,將二值圖像面積與分割出的圖像面積相比,當比值大于0.8便識別為手掌張開狀態,反之則為握拳狀態,如圖9所示。 圖9 結合Kinect骨骼點信息與YCbCr顏色模型的手勢 特征分割方法流程圖Fig.9 Flow chart of combinating skeleton point information and YCbCr color gesture feature segmentation method 本文規定,在采摘模式時,人的右掌張開對應抓持器張開狀態,握拳則對應抓持器閉合抓取。左手手掌握拳時剪切器執行摘剪果蔬動作,把果蔬從作物上剪斷,左手張開時剪切器復位后停止運動。當處于噴施模式時,右手掌張握動作對應噴施的開關,左手手勢動作則對應噴施液種類之間的切換。 建立操作人員位姿信息與機器人工作空間的映射對應關系之后,對該決策算法的精準度和棚室作業效果進行了試驗。 4.1 試驗平臺的搭建 本試驗用Matlab開發上位機程序,在東北農業大學農業機器人研究室內搭建三臂棚室農業機器人樣機和棚室作業環境。試驗場地分為兩處,即遠程操控場地和棚室作業場地,棚室作業場地情況由機器人頭上的無線攝像頭進行實時拍攝并回傳到遠程操控場地的顯示終端上。操作人員只需通過顯示終端界面便能觀察機器人的實時動作,從而遠程操控機器人作業,以驗證體感決策算法的可行性和精準性,試驗平臺如圖10所示。 圖10 遠程操控場地Fig.10 Remote control1.上位機 2.Kinect 3.顯示終端 4.操作人員 圖11 誤差數據采集流程Fig.11 Processing of error data acquisition 4.2 精準性試驗 完成試驗平臺的搭建后,對該體感決策算法映射誤差進行試驗,分析可知該系統的誤差主要有2個來源:一個是Kinect捕獲操作人員動作時產生的誤差,另一個為骨骼點數據映射到機器人工作空間時產生的誤差。根據建立映射關系時對關節點夾角的定義,需要對肩關節部位分別與本文定義的2個平面之間夾角及肘關節夾角的3個值進行測量,以確定誤差大小,這3個值分別為操作人員實際位姿值、體感算法捕捉值、機器人實際動作夾角。首先讓之前的10位測試人員穿戴上采用光洋單圈絕對值編碼器的關節夾角測試儀(圖11a),其測試精度為0.05°,用其測得人體肩、肘關節的實際運動夾角,并與體感捕獲關節夾角做比較,以檢驗體感技術捕獲角度值的精準性;參照關節夾角測試儀的示數,測試人員用肩關節分別做出與圖6所示β1、β2面夾角依次為10°、20°、30°、…、90°的位姿,且本文編寫了用于顯示人體被捕捉到的骨骼點關節角度的界面顯示程序(圖11b),記下人手臂關節做出某個角度時對應體感算法捕捉并顯示在界面的角度。記錄該角度的同時,用遙控裝置關閉機器人控制系統與上位機通信的串口,確保機器人此刻的位姿是與顯示界面上記錄的關節點數據同時刻映射,用萬能角度尺對機器人手臂對應位置夾角進行測量(圖11c),得到機器人對應轉角角度。得到以上3組數據后便能求出上述分析的誤差。10個測試者都測試后,對體感算法捕捉到的10個測試者的肩關節角度及量得的機器人實際動作角度分別求平均值,同理,與肩關節角度誤差測試步驟類似,再對肘關節的夾角進行相同步驟的試驗,但由于結構上的區別,人體肘部夾角變化范圍取為90°~180°,并繪出所有差值折線圖。 圖12 人體關節夾角與機器人關節夾角映射誤差統計折線圖Fig.12 Curves of mapping error between human and robot joint angle 圖12a中肩部關節與β2夾角折線圖表明,當人體關節點夾角越大時,體感算法捕捉到的誤差絕對值越大,到90°時出現了誤差的最大值5.80°,這是因為當人肩部關節與β2之間的夾角為較大值時,手臂指向Kinect攝像頭方向,造成肩部及肘部關節被遮擋而導致深度信息被干擾,從而引起骨骼點識別偏差,導致相對較大的誤差;而圖12c中,人肘部關節夾角越小時,誤差絕對值越大,最大誤差絕對值為1.90°,同理肘部夾角較小時,若手腕指向Kinect方向,也會出現肘關節視覺遮擋,從而導致誤差的出現;同時捕獲夾角映射到機器人實際工作空間的電動機轉角誤差最大差值為0.80°,主要是由手臂裝配間隙及為提高單片機運行效率采取角度取整導致的,對基于體感操作的控制方式,該誤差滿足體感操作要求;但對于人體肩關節大角度時產生的人體實際關節夾角和體感捕獲夾角最大誤差5.80°,則可能出現誤差跳變影響遠程棚室作業效果;考慮到在體感操作過程中,三臂機器人大臂主要確定工作區域、小臂負責后續定位采摘的特性,將大臂轉動角度規劃為以15°為步長、0°~90°的離散轉動區間,當體感算法捕捉到操作人員手臂關節角度為0°~7.50°時,機器人對應電動機轉角為0°,當人體關節角度為7.50°~22.50°時,機器人對應電動機轉角為15°,以此類推當體感算法捕捉到人體關節角度為82.50°~90°時,機器人電動機轉角為90°。再次進行誤差測試,體感算法映射的最大絕對誤差出現在肘關節處,其值為1.90°,肩關節由于采用上述規劃后理論上已不存在識別誤差,故誤差較未規劃之前得到了較好的消除。 4.3 試驗平臺的搭建 在上述規劃基礎上,讓10位測試者模擬在無人棚室或植物工廠下作業,用于測試決策算法性能。每人在遠程操控試驗場地通過觀察顯示終端實時傳回視頻,了解目標對象和機器人的動作情況,進而通過體感技術遠程操控三臂機器人,進行采摘單個黃瓜作業和噴施作業,其噴施作業面積為1 m2。由于本文采用的是基于體感技術的機器人,在進行體感操控作業時,操作人員觀察顯示界面實時回傳視頻完成機器人的目標定位和采摘運動規劃,若操作人員定位果蔬出現位置誤差時,通過顯示界面的實時視頻反饋的情況,在采摘運動過程中人員可主動糾正,以適應復雜多變的作業環境,記錄完成單次作業指令的時長,作為衡量體感決策算法作業性能的標準,并再做1組10個測試者用人工完成相同采摘噴施作業的試驗,記錄下所用時間;將所有試驗數據列于表2中。 表2 測試者遠程棚室作業耗時統計Tab.2 Statistics of working hours in greenhouse s 由表2可得,測試者操控機器人完成每套棚室作業指令的平均耗時為13.34 s,其中采摘耗時6.36 s,噴施耗時6.98 s;人工作業耗時為11.57 s,其中采摘耗時為4.87 s,噴施耗時為6.70 s。表明該體感決策算法具有較好的效率,而且操作者可通過體感操控訓練進一步提高機器人作業性能;而對于6號測試者出現采摘耗時8.64 s及噴施耗時8.27 s,明顯高于試驗平均值的情況,通過骨骼點捕捉軟件記錄下的數據分析可知,其主要時間耗費在手勢識別上,進一步觀察可知該測試者在進行試驗時右手掌為指向Kinect的攝像頭姿態,導致Kinect無法正確捕獲其手勢。因此在操作時應注意讓手掌面向攝像頭,以增加手勢識別的效率和準確率。 相對于人工作業,操作人員可在一個舒適環境中完成遠程體感操控,對智能棚室及植物工廠實施“無人化管理”,降低對作物及健康的損害;此外經精準性測試后采用大臂離散區間轉動方法,允許人體肩部關節有一定的姿態改變而不影響機器人動作位姿,緩解了長時間體感操控可能出現的關節酸痛的情況,而且整個作業過程只需運動肢體和改變相對于攝像頭的位置,省去了在棚室行走和采摘時的體力損耗。 圖13 遠程操控采摘作業Fig.13 Picking works with remote operation (1)將基于Kinect體感技術的決策算法應用在操控多臂棚室農業機器人上,操作人員能夠通過無線設備遠程操作機器人進行多種棚室作業,并在實驗室搭建的棚室環境下取得了較好的作業效果。 (2)通過Kinect采集包含操作人員動作信息的深度圖像,提取每個像素點與鄰域的全局均一化深度差值作為該點特征量,利用隨機樹和森林對其進行分類,最后采用引入高斯核的Mean shift算法迭代得到了20個能代表人體位姿的關鍵點;在此基礎上,建立了一種基于骨骼點追蹤技術的人體兩臂與機器人三臂的映射關系,還結合骨骼點信息與YCbCr顏色空間模型,準確的定位了手掌位置,分割出包絡手部的圖像部分,經形態學處理后得到效果較好的手勢特征。在實驗室搭建的棚室環境內,實現了測試人員遠程操控三臂機器人進行多種棚室作業。 (3)搭建了用于試驗Kinect三臂決策算法的三臂機器人樣機,對決策算法映射動作的精準性和作業性能進行了試驗。試驗結果表明,體感捕捉人體關節角度最大誤差為5.80°,出現在肩關節處,本文通過對機器人肩關節轉動轉角的離散化規劃后,肩關節夾角識別誤差相當于消除,識別誤差主要產生在肘部,最大誤差絕對值為1.90°;而捕捉到的關節夾角值到機器人實際轉動夾角值的最大絕對誤差為0.80°,在此精度下,人員遠程操控機器人能自如的進行工作模式切換,完成一套棚室作業指令平均耗時13.34 s,能滿足無人棚室或植物工廠復雜環境作業需要。 (4)針對上述傳統智能棚室或植物工廠人工作業模式存在較多弊端,而智能農業機器人系統的普適性尚需完善的現狀,該決策算法的提出可為農業機器人的操控方式提供一種新思路,能加快智能棚室及植物工廠“無人化管理”及棚室機器人實用化、高效化的步伐。 1 王凱, 么鴻雁, 劉劍君. 蔬菜大棚微環境對人體健康的影響[J]. 疾病監測, 2015, 30(6):507-512. WANG Kai, YAO Hongyan, LIU Jianjun. Progress in research of impact of greenhouse microenvironment on human health[J]. Disease Surveillance,2015,30(6):507-512. (in Chinese) 2 CECCHINI M, COLANTONI A, MASSANTINI R, et al. Estimation of the risks of thermal stress due to the microclimate for manual fruit and vegetable harvesters in central Italy[J]. Journal of Agricultural Safety & Health, 2010, 16(3):141-159. 3 朱鳳武, 于豐華, 鄒麗娜,等. 農業機器人研究現狀及發展趨勢[J]. 農業工程, 2013, 3(6):10-13. ZHU Fengwu, YU Fenghua, ZOU Li’na,et al.Research status quo and future perspective of agricultural robots[J].Agricultural Engineering,2013,3(6):10-13. (in Chinese) 4 DONG F, HEINEMANN W, KASPER R. Development of a row guidance system for an autonomous robot for white asparagus harvesting[J]. Computers & Electronics in Agriculture, 2011, 79(2):216-225. 5 OBERTI R, MARCHI M, TIRELLI P, et al. Selective spraying of grapevines for disease control using a modular agricultural robot[J]. Biosystems Engineering, 2016,146:203-215. 6 羅陸鋒, 鄒湘軍, 楊洲,等. 基于改進人工蜂群模糊聚類的葡萄圖像快速分割方法[J/OL]. 農業機械學報, 2015, 46(3):23-28. http:∥www.j-csam.org/jcsam/ch/reader/view_abstract.aspx?file_no=20150304&flag=1. DOI:10.6041 /j.issn.1000-1298.2015.03.004. LUO Lufeng,ZOU Xiangjun YANG Zhou,et al.Grape image fast segmentation based on improved artifical bee colony and fuzzy clustering[J]. Transactions of the Chinese Society for Agricultural Machinery,2015,46(3):23-28. (in Chinese) 7 尹建軍, 武傳宇, YANG S X,等. 番茄采摘機器人機械臂避障路徑規劃[J/OL]. 農業機械學報, 2012, 43(12):171-173,157. http:∥www.j-csam.org/jcsam/ch/reader/view_abstract.aspx?file_no=20121231&flag=1. DOI:10.6041/j.issn.1000-1298.2012.12.031. YIN Jianjun, WU Chuanyu, YANG S X, et al. Obstacle-avoidance path planning of robot arm for tomato-picking robot[J/OL].Transactions of the Chinese Society for Agricultural Machinery,2012,43(12):171-175,157. (in Chinese) 8 趙金英, 張鐵中, 楊麗. 西紅柿采摘機器人視覺系統的目標提取[J]. 農業機械學報, 2006, 37(10):200-203. 9 劉繼展, 李萍萍, 倪齊,等. 番茄采摘機器人真空吸盤裝置設計與試驗[J]. 農業機械學報, 2010, 41(10):170-173. LIU Jizhan, LI Pingping, NI Qi,et al.Design and test of the vacuum suction device for tomato harvesting robot[J]. Transactions of the Chinese Society for Agricultural Machinery,2010,41(10):170-173. (in Chinese) 10 張凱良, 楊麗, 張鐵中. 草莓收獲機器人采摘執行機構設計與試驗[J]. 農業機械學報, 2011, 42(9):155-161. ZHANG Kailiang, YANG Li, ZHANG Tiezhong. Design and experiment of picking mechanism for strawberry harvesting robot[J].Transactions of the Chinese Society for Agricultural Machinery,2011,42(9):155-161. (in Chinese) 11 馮青春, 袁挺, 紀超,等. 黃瓜采摘機器人遠近景組合閉環定位方法[J]. 農業機械學報, 2011, 42(2):154-157. FENG Qingchun, YUAN Ting, JI Chao, et al.Feedback lacating control based on close scene for cucumber harvesting robot[J]. Transactions of the Chinese Society for Agricultural Machinery,2011,42(2):154-157. (in Chinese) 12 HENTEN E J V, SCHENK E J, WILLIGENBURG L G V, et al. Collision-free inverse kinematics of the redundant seven-link manipulator used in a cucumber picking robot[J]. Biosystems Engineering, 2010, 106(2):112-124. 13 傅隆生, 張發年, 槐島芳德,等. 獼猴桃采摘機器人末端執行器設計與試驗[J/OL]. 農業機械學報, 2015, 46(3):1-8. http:∥www.j-csam.org/jcsam/ch/reader/view_abstract.aspx?file_no=20150301&flag=1.DOI:10.6041/j.issn.1000-1298.2015.03.001. FU Longsheng, ZHANG Fanian, GEJIMA Yoshinori, et al. Development and experiment of end-effector for kiwifruit harvesting robot[J/OL]. Transactions of the Chinese Society for Agricultural Machinery,2015,46(3):1-8. (in Chinese) 14 AFTHONI R,RIZAL A,SUSANTO E. Proportional derivative control based robot arm system using Microsoft Kinect[C]∥2013 IEEE International Conference on Robotics, Biomimetics, and Intelligent Computational Systems (ROBIONETICS), 2013: 24-29. 15 AMATYA S, PETCHARTEE S. Real time kinect based robotic arm manipulation with five degree of freedom[C]∥2015 Asian Conference on Defence Technology (ACDT), 2015:982-990. 16 JIMENEZ MORENO R. Tracking of human operator arms oriented to the control of two robotic arms[C]∥2014 XIX Symposium on Image, Signal Processing and Artificial Vision, 2014: 1-4. 17 DU G, ZHANG P. Markerless human-robot interface for dual robot manipulators using Kinect sensor[J]. Robotics and Computer-Integrated Manufacturing, 2014, 30(2):150-159. 18 LIN H B, MEI W L, ZHANG Y. Implement of robot arm body feeling interaction system based on the Kinect skeletal information[J]. Applied Mechanics & Materials, 2012, 220:1203-1206. 19 LALLEE S, LEMAIGNAN S, LENZ A, et al. Towards a platform-independent cooperative human-robot interaction system: I. perception[C]∥IEEE/RSJ 2010 International Conference on Intelligent Robots and Systems, 2010:4444-4451. 20 LALLEE S, PATTACINI U, BOUCHER J D, et al. Towards a platform-independent cooperative human-robot interaction system: II. perception, execution and imitation of goal directed actions[C]∥IEEE/RSJ International Conference on Intelligent Robots & Systems, 2011:2895-2902. 21 LALLEE S, PATTACINI U, LEMAIGNAN S, et al. Towards a platform-independent cooperative human robot interaction system: III an architecture for learning and executing actions and shared plans[J]. IEEE Transactions on Autonomous Mental Development, 2012, 4(3):239-253. 22 GARCIA J, VALENCIA E S, ZALEVSKY Z, et al. Range mapping using speckle decorrelation: US,7433024B2[P]. 2008-10-07. 23 LEPETIT V, LAGGER P, FUA P. Randomized trees for real-time keypoint recognition [C]∥2005 IEEE Computer Soeiety Conference on Computer Vision & Pattern Recognition, 2005, 2:775-781. 24 COMANICIU D, MEER P. Mean shift: a robust approach toward feature space analysis [J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2002, 24(5):603-619. 25 SHOTTON J, FITZGIBBON A, COOK M, et al. Real-time human pose recognition in parts from single depth images[C]∥2011 IEEE Conference on Computer Vision and Pattern Recognition, 2011:1297-1304. 26 AIBINU A M, SHAFIE A A, SALAMI M J E. Performance analysis of ANN based YCbCr skin detection algorithm[J]. Procedia Engineering, 2012, 41:1183-1189. Algorithm of Works’ Decision for Three Arms Robot in Greenhouse Based on Control with Motion Sensing Technology QUAN Longzhe LI Chenglin FENG Zhengyang LIU Jiawei (CollegeofEngineering,NortheastAgriculturalUniversity,Harbin150030,China) There are many problems in the current greenhouse and plant factory. It’s an effective solution to work by robots. However, because of the limit of the intelligent algorithm at present, the robot’s works are imprecise.And they can just complete single job in once cruise which cause the inefficient using. Aiming at the problem, an algorithm which based on the motion sensing of Kinect and used in three arms robot was proposed, by using the Kinect to collect the depth image, including the operating personnel and combining the Random forests of statistical learning theory with the mean shift algorithm based on the Gauss kernel function which acquired 20 skeletal joints that can standard the human motion. On this basis, a mapping relation was put forward in innovation of three arms based on the mode switching to achieve that the two arms of the man can freely control three arms of the robot and perform several works in greenhouse. In addition, a way of gesture features segmentation was proposed which based on skeletal tracking technology in Kinect and YCbCr color space, realizing the aim that using the action of the palm to control the robot’s end effectors. Finally, a prototype of three arms robot was built to test the decision algorithm of motion sensing and its accuracy. A discrete value was taken for the angle in shoulder joint to recognize the error data in experiment, so eliminated errors in the shoulder joints. The results showed that the maximum mapping error of joint angle was 1.90° between human and robot. The maximum error of the host computer sending angle and the real angle by robot was 0.80°, which was within the margin of error. Meanwhile, the average time of completing an order of picking and spraying was 13.34 s, the picking time was 6.36 s and the spraying time was 6.98 s. And the performance of the robot can be boosted by training the manipulator. It was indicated that this algorithm had a great practicability and can work accurately. multi-arms robot in greenhouse; decision programming; motion sensing technology; Kinect sensor 10.6041/j.issn.1000-1298.2017.03.002 2016-07-15 2016-08-15 黑龍江省普通高等學校青年創新人才培養計劃項目(LR-356214)、國家自然科學基金項目(51405078)、黑龍江省博士后基金項目(LBH-Z13022)和東北農業大學“青年才俊”項目(518020) 權龍哲(1980—),男,副教授,主要從事農業智能裝備研究,E-mail: quanlongzhe@163.com S24 A 1000-1298(2017)03-0014-10

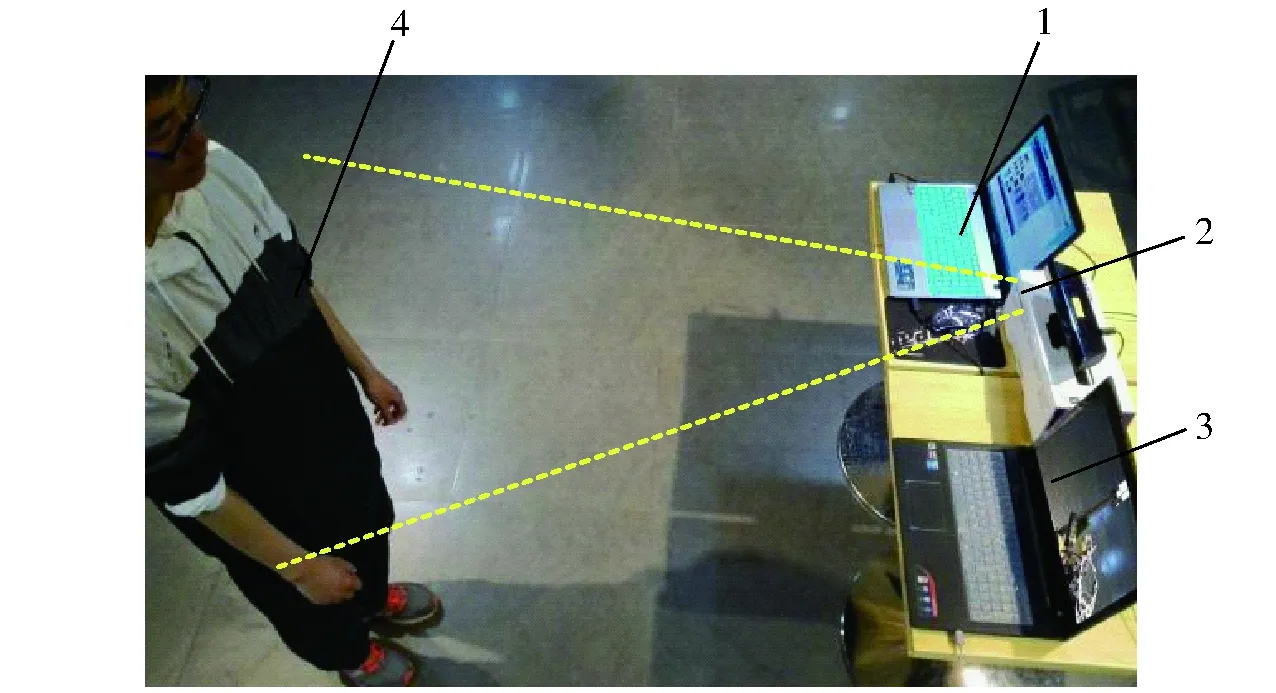

4 三臂棚室機器人作業試驗

5 結論