基于深度學習神經網絡的SAR星上目標識別系統研究

袁秋壯,魏松杰,羅 娜

(南京理工大學 計算機科學與工程學院,江蘇 南京 210094)

基于深度學習神經網絡的SAR星上目標識別系統研究

袁秋壯,魏松杰,羅 娜

(南京理工大學 計算機科學與工程學院,江蘇 南京 210094)

實現對地面目標的智能識別,對一種基于深度學習的卷積神經網絡(CNN)的星載合成孔徑雷達(SAR)星上目標識別系統進行了研究。系統由星上和地面兩部分組成。其中:地面部分進行網絡結構設計、SAR圖像數據預處理、CNN模型訓練、模型壓縮及上傳;星上部分接收上傳模型并解壓縮、目標識別、識別后粗篩圖像下傳地面;地面進行人工篩查,篩查后的正確圖像作為訓練數據對CNN模型進行再訓練,逐步獲得精度更高的模型。提出的CNN架構為卷積層2個、下采樣層2個、Dropout層3個、Flatten層1個、全連接層2個,最終輸出標簽11類。為使訓練后的CNN模型能部署到衛星上使用,采用數據精度壓縮和剪枝兩種數據深度壓縮方法以減小數據存儲量和減低網絡復雜度。在Keras深度學習開源庫環境中實現設計的CNN模型,對運動和靜止目標獲取與識別(MSTAR)數據庫中的11類軍事目標識別的實驗結果表明:識別和分類的效果良好,整體識別成功率達96.29%;模型能壓縮至原來的1/13,精度損失小于2%。

SAR圖像; 智能目標識別; 深度學習; 卷積神經網絡; 深度壓縮; 數據精度壓縮; 剪枝; 模型效率

0 引言

星載合成孔徑雷達(SAR)是一種工作在微波波段的成像雷達,具高分辨率和大面積的數據獲取能力,可全天候全天時工作,也有一定的植被和遮蓋物的穿透能力[1]。因此,星載SAR在民用和軍事領域獲得了廣泛應用。與光學成像后可直接獲取目標不同,SAR圖像需經復雜的數據處理才能識別圖像中感興趣的目標,其中特征提取、圖像分析專家審查等多個環節需要人工參與,這直接影響了SAR圖像應用的時效性,特別是在軍事SAR遙感應用領域。盡管SAR圖像處理的時效性在穩步提升,但與軍事應用需求相比還有較大差距。2006年,HINTON提出了基于深度學習神經網絡的人工智能算法,為自動提取圖像特征和識別圖像中目標提供了有效的技術途徑[2]。

深度學習是近年來機器學習領域中的一個新研究熱點,為語音識別、視覺對象識別、對象檢測等領域帶來了顯著突破。其本質是一種特征學習方法,將原始數據通過一些簡單的非線性模型轉變成更高層次、更抽象的表達[3]。2006年,HINTON等提出了深度置信網絡,與傳統神經網絡不同,該網絡應用無監督學習方法初始化權值,從而引出了深度學習的概念[4]。此外,還出現了其他深度學習模型,如深度卷積神經網絡(CNN)、深度并發神經網絡(RNN)等[5-6]。由于使用原始圖像作為網絡的輸入,CNN在圖像分類或模式識別等領域取得了大量成果。深度學習神經網絡被認為是目前計算機圖像處理領域中最先進的技術之一,雖然其功能強大,但網絡中大規模的權值參數消耗了大量的計算和內存資源,如AlexNet模型超過200 MB,VGG-16模型超過了500 MB,這使將訓練好的模型部署到嵌入式系統中變得十分困難。解決這一問題的有效途徑是壓縮網絡模型,為此提出了深度壓縮的概念。目前,常用的深度壓縮方法有網絡剪枝、權值量化和哈希網絡(HashedNets)等[7-9]。2016年,文獻[10]綜合了上述三種方法對一些經典神經網絡模型進行壓縮和測試,并獲得了較好的效果。

本文主要研究將CNN應用于SAR圖像目標識別領域,設計了一個基于CNN的SAR圖像目標識別系統,以實現對地面目標的智能識別。該系統可在星上運行,并將識別的特定目標圖像傳輸到地面,從而減少衛星至地面的傳輸量。為使模型能在星上運行,采用深度壓縮方法對模型進行壓縮。最后用實驗對設計的CNN網絡模型的識別和分類效果進行驗證。

1 系統設計

卷積神經網絡的計算量相對較少,可自動提取圖像的多層次信息,便于對圖像進行分類,因此本文將之用于星載圖像處理,處理流程如圖1所示。本系統由星上和星下(地面)兩部分組成。星下進行網絡結構設計、對SAR圖像數據的預處理、訓練CNN模型、壓縮模型并將其上傳到星上;星上接收地面上傳的模型并對其解壓縮,進行目標識別,將識別后的粗篩圖像傳至地面,地面進行人工篩查并將篩查后的正確圖像作為訓練數據對CNN模型進行再訓練,逐步得到精確度更高的模型。

2 基于深度卷積神經網絡的SAR模型

2.1卷積神經網絡

CNN是一種特征的前饋神經網絡,通過局部感受域、權值共享與池化三種核心技術實現高效的特征提取與學習,現廣泛用于手寫字符識別、人臉識別等圖像分類或模式識別領域[11-12]。CNN的基本網絡結構由輸入層、卷積層、全連接層和輸出層四部分疊加組成,如圖2所示。

a)輸入層:若處理的是圖像,則輸入數據為圖像的像素值。

b)卷積層(圖2中C塊):一般有多層,用于特征提取。每層可采用多個不同的卷積核,每個卷積核提取一個特征平面,多個不同的卷積核則可提取多個不同的特征平面。

c)下采樣層(圖2中S塊),也稱池化層,緊接著卷積層,主要是利用圖像局部相關性,對卷積層提取的特征平面進行信息降維,減少數據處理量,提升網絡學習的速度[13]。下采樣不僅能使特征平面降維,而且一定程度上可防止網絡出現過擬合學習,提高網絡的泛性。一般包括最大值、平均與隨機三種池化操作過程。

d)全連接層:相當于多層感知機的隱含層部分,即采用全連接方式前向傳播,加權組合得到輸出。

e)輸出層:若CNN網絡的目的是分類任務,則輸出層通常是一個分類器,如支持向量機(SVM)、Softmax多分類器。

2.2基于深度卷積神經網絡的SAR模型設計

本文設計的深度CNN架構如圖3所示。其中:輸入為灰度圖像,網絡結構包含卷積層2個、下采樣層2個、Dropout層3個、Flatten層1個、全連接層2個,最終輸出標簽11類,實現SAR圖像中目標分類與識別。

a)數據輸入層(Input)

輸入層直接輸入圖像的像素值,圖像尺寸為1×128×128。

b)Conv1卷積層

采用32個不同的卷積核,每個卷積核大小為3×3,即Conv1卷積層從輸入數據中進行特征的選擇與學習,最終輸出32個特征平面。因每個卷積核需要訓練3×3=9個參數和1個偏置參數,故32個卷積核則一共需要學習的參數為(3×3+1)×32=320個。實驗輸入圖像大小為128×128,卷積核卷積操作滑動步長為2像素,卷積后特征平面的映射大小為((128-3+2)/2)×((128-3+2)/2)=63×63。

c)S1下采樣層

對Conv1提取的32個63×63的特征平面進行無重疊的最大值下采樣處理,采樣區域為2×2,因此S1層的輸出為32個降維后的((63/2)+1)×((63/2)+1)=32×32個特征平面,將數據量減少為原來的約四分之一。

d)Dropout層

深度網絡常會由于網絡結構過于復雜,而訓練樣本數量不足,出現過度學習擬合現象。對此,研究者提出了一種新思路:Dropout。Dropout是指在網絡模型在每次訓練時隨機以概率p輸出為0(該層中的p=0.2),使網絡某些隱含層節點的權重不參與訓練,權重保留之前訓練的結果,暫不更新,其物理意義相當于某些節點的網絡連接線斷開。反向傳播學習時也同樣忽略這些斷開的節點。

e)Conv2卷積層、S2下采樣層與Dropout層

原理同b)、c)、d),進一步抽象與泛化提取圖像數據的特征。

f)Flatten全連接層

Flatten層用于將輸入“壓平”,即將多維的輸入一維化,常用于從卷積層到全連接層的過渡。

g)Dense 全連接層

該全連接層共有神經節點512個,每個神經節點都與上一層的所有神經節點連接。每個神經元的輸出可表示為

(1)

式中:xi為全連接層輸入的神經元的值;wi,j為權值;bj為偏置。激活函數仍采用ReLU函數。全連接層的神經元個數直接影響網絡的擬合效果和訓練速度。

h) Dropout層

為進一步防止過擬合,添加一層Dropout,p=0.5。

i)Dense輸出層

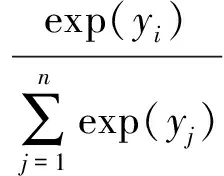

采用Softmax多分類器,輸出為0~1間的數值,代表樣本屬于某類標簽的概率。本文研究中共有地物目標11類,因此輸出層設神經元11個。Softmax的表達式為

(2)

式中:yi為第i個神經元輸出的結果;n為神經元個數。

3 模型壓縮

用上述卷積神經網絡訓練獲得的模型大小可達數百上千兆字節,若將其傳輸至星上將耗費相當的時間,且模型在星上運行還會占用相當大的計算和內存資源,因此需對原始模型進行壓縮,以便于傳輸和部署到星上。本文用于深度壓縮的方法有數據精度壓縮和剪枝兩種。

3.1數據精度壓縮

本文訓練好的神經網絡模型保存的權重數據類型是32位浮點型,每個數據占用4 B。如能減小單個數據的存儲量,整個模型的大小就會因此減小。為此,本文對權重數據的精度進行壓縮,壓縮的基本原理如圖4所示。

假設網絡中的權重數據精度為1×10-8,即保留到小數點后8位,若將精度壓縮為1×10-4,只存儲到小數點后4位的數據,則數據占用的字節數會減少到原來的一半。但如直接壓縮數據而不考慮被壓縮的部分,會影響數據精度,從而影響模型的準確度。因此,本文采用對數據進行選擇性壓縮的方法,具體如下。

對一個浮點數0.d1d2…dn來說,可將其表示為d1d2…dn×10-n,即精度為1×10-n。若將精度壓縮為1×10-m,只存儲到小數點后m位,即表示為d1d2…dm×10-m,則其精度損失為

(d1d2…dm.dm+1…dn×10-m-d1d2…dm×10-m)/10-m=0.dm+1…dn

轉換成百分比為

L=0.dm+1…dn×100%

(3)

式中:L為精度損失的百分比。本文選擇壓縮L值在某些閾值范圍內的數據,當L≤30%時,認為被壓縮的部分精度損失較小,可忽略;當L≥70%時,認為精度損失較大,需在d1d2…dm的基礎上加1;當L為30%~70%時的數據被認為對壓縮的影響較大,不作壓縮處理。因此,理論上可有60%的數據被壓縮。

3.2剪枝

神經網絡通常是過參數化的,訓練得到的網絡模型保存了所有連接的參數,這導致模型有巨大的冗余。為降低網絡的復雜度和過擬合,本文對網絡進行剪枝,所用方法是對小權值的連接進行剪枝,即移除權值低于既定閾值的所有連接。

剪枝的基本原理如圖5所示。考慮一個全連接層神經網絡,對第N-1層和第N層來說,第N-1層的每個神經元都與第N層的所有神經元連接,每個連接可視作是一個帶權值的“枝”。這些“枝”的權值大小代表連接的重要性,權值越大連接越重要,反之,權值越小連接越不重要。剪枝的作用就是將不重要(權值較小)的連接從網絡中移除,可將較密集的網絡變成稀疏網絡,顯著降低網絡的復雜度。

剪枝后的參數矩陣變成了一個稀疏矩陣,本文用壓縮稀疏行(CSR)格式存儲相應權值。CSR是常用的存儲矩陣的格式,該格式壓縮存儲行信息,僅顯式保留每行第一個非零元素的位置。

考慮一個稀疏矩陣A,其非零元素個數為nnz,行數為n。定義3個數組:1個浮點型數組val;2個整型數組col_ind,row_ptr。其中:val存儲A中非零元素,大小為nnz;col_ind存儲val數組中元素的列索引,大小為nnz;row_ptr保存A每行第一個非零元素在val中的的索引,一般定義row_ptr(n+1)=nnz+1。這種方法只需存儲數據2nnz+n+1個,可大幅節省存儲空間。

3.3模型效率評估

本文用壓縮后模型的效率評估壓縮效果。有

(4)

式中:E為壓縮后模型的效率;rCP為壓縮前后識別率的比值;rCR為壓縮前后模型大小的比值。可知:E越大,壓縮模型的效率越高。

4 仿真實驗與分析

4.1試驗環境SAR數據集選擇

為驗證本文提出的基于深度卷積神經網絡模型針對星載SAR遙感圖像中目標自動識別的可行性和準確性,在深度學習開源庫Keras環境中實現深度卷積神經網絡模型。實驗的工作站采用64位的Ubuntu15操作系統,處理器為Intel? Xeon(R)CPU,型號為E5-2609 v3@1.90 GHz×12,內存為31.3 GB,獨立顯卡型號為Quadro K2200/PCIe/SSE2。

4.2SAR數據集

4.2.1 數據集介紹

實驗數據集采用美國國防研究規劃局(DARPA)和空軍研究實驗室(AFRL)聯合資助的運動和靜止目標獲取與識別(MSTAR)遙感SAR數據庫。MSTAR數據庫里包括BRDM2,BMP2,BTR60,BTR70,D7,ZIL131,ZSU234,T62,T72,2S1,SLICY共11類地物目標,如圖6所示。同一大類中不同型號的實際差異為目標的軍事配置不同,如同類坦克有無機關槍、油箱,以及天線是否展開等,稱為變形目標。數據庫在設計時考慮SAR 圖像對方位因素十分敏感,故而對每類目標采集大量不同方位的圖像,方位范圍為0°~360°。

4.2.2 圖像數據預處理

由于MSTAR數據集的SAR圖像訓練樣本圖像分辨率與大小各異且數量不足,無法直接用于深度卷積神經網絡學習,易導致過擬合,因此本文用以下方法進行數據預處理和訓練樣本庫擴充。

a)規范化數據集

為保證所有圖像大小與分辨率的一致,從原生的Sun floating point format格式提取分辨率為95%的JPEG格式圖像,并統一規范圖像尺寸為128×128。

b)實時數據提升

在網絡模型訓練學習時,進行實時數據提升,包括圖片隨機轉動的角度、圖片水平偏移的幅度、圖片豎直偏移的幅度、逆時針方向的剪切變換角度、隨機縮放的幅度等變化。

c)加噪聲

添加人工噪聲,防止網絡的過度擬合,增加模型的魯棒性。

4.3實驗設置

實驗采用的MSTAR訓練集和測試集見表1。在11類目標的識別實驗中,目標包括BRDM2,BMP2,BTR60,BTR70,D7,ZIL131,ZSU234,T62,T72,2S1,SLICY共11類目標。訓練樣本為17°俯仰角下不包括變體(即不包括BMP2_SNC21,BMP2_SN9566,T72_SN812,T72_SNS7等型號)的SAR圖像數據,測試樣本為15°俯仰角下包含上述變體的各目標SAR圖像數據。

表1 MSTAR標準數據集中訓練集與測試集樣本分布

4.4深度CNN識別SAR圖像目標實驗結果

本文的深度卷積網絡模型的測試分類結果見表2。由表2可知:SAR圖像目標分類結果較好,平均識別率達到96.29%,其中T72(132),2S1,BTR60,D7,SLICY,ZSU的識別率均大于99%。此外,對相同類型不同變體的SAR目標(BMP2,T72)識別效果也較好。文獻[14]基于卷積神經網絡建模,采用同樣的MSTAR訓練集和測試集進行實驗測試,平均識別率為93.76%。由此可見,本文的深度卷積神經網絡一定程度優于文獻[14]的方法,SAR目標識別率更高。

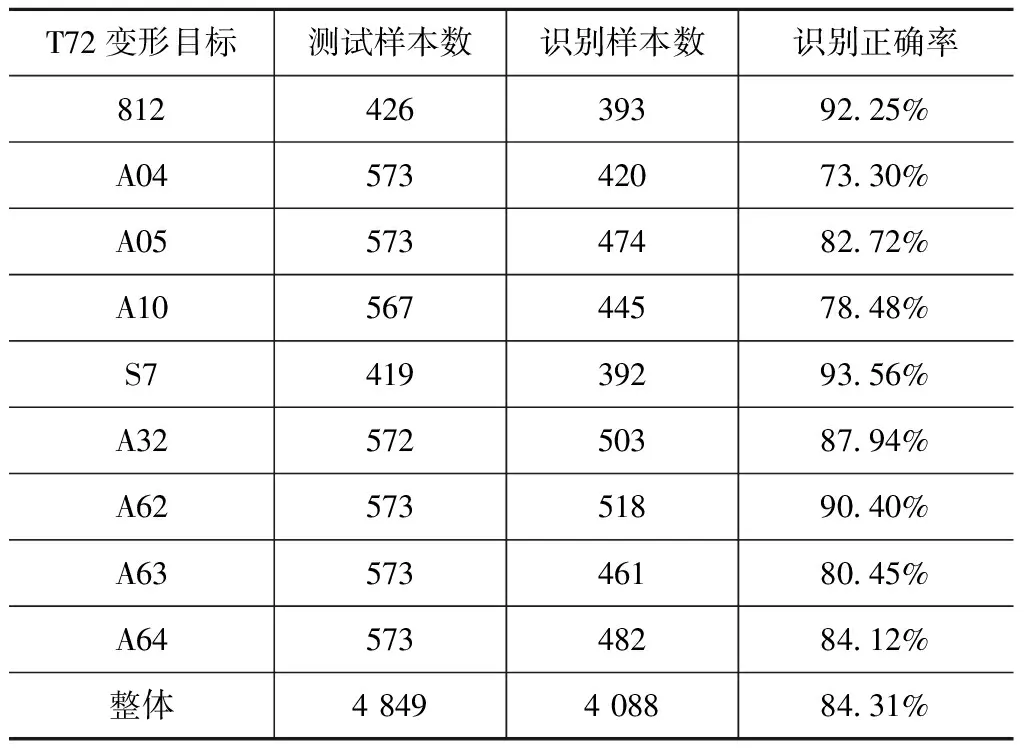

4.5深度CNN識別SAR圖像目標系統泛化能力

驗證本文模型的泛化能力,即指經訓練后的神經網絡對未在訓練集中出現的(但來自同一分布的)樣本做出正確反應的能力。針對MSTAR中T72坦克大類目錄下9類不同目標配置或型號的其他坦克進行測試,識別結果見表3。由表3可知:整體上T72變形目標的識別正確率可達84.31%,其中個別類的變形目標識別能力較差,如A04,A10;對812,S7,A62三類坦克的識別率均大于90%,分類結果較好。

表2 MSTAR11SAR目標識別結果

表3 對T72坦克中不同目標配置與型號的識別結果

4.6壓縮后CNN模型的壓縮率和識別能力分析

本文對實驗用的CNN模型進行了壓縮,并測試了壓縮后模型的識別能力。模型壓縮前后的識別正確率、壓縮率及效率見表4。本文測試了用不同壓縮算法壓縮后的模型,并得到了效率最高一個,由表4可知:本文提出的數據精度壓縮+剪枝的方法將模型從40.6 MB壓縮到3.1 MB(原來的1/13),而精度僅損失1.16%,證實了壓縮方法的有效性。

表4 模型壓縮前后的統計數據

5 結束語

針對衛星SAR圖像目標識別的時效性難以滿足快速軍事應用的問題,本文提出利用深度卷積神經網絡進行快速智能識別SAR圖像中的軍事目標。仿真實驗表明提出的新方法無需人工干預,能快速實現智能識別星載SAR圖像目標。此外,本文還使用了深度壓縮算法對訓練好的CNN模型進行了壓縮,便于將其移植于計算資源有限的星上環境使用,最終實現星上成像數據的實時識別與應用的目的,為軍事和民用提供有效技術支撐。壓縮實驗結果表明:壓縮后的模型對目標的識別率并未出現明顯的降低,設計的CNN網絡模型具良好的識別和分類效果,壓縮模型的識別準確度損失較小。

[1] TOMIYASU K. Tutorial review of synthetic-aperture radar (SAR) with applications to imaging of the ocean surface[J]. Proc IEEE, 1978, 66(5): 563-583.

[2] HINTON G E. To recognize shapes, first learn to generate images[R]. University of Toronto: UTML TR 2006-003, 2006.

[3] LECUN Y, BENGIO Y, HINTON G. Deep learning[J]. Nature, 2015, 521(7553): 436-444.

[4] HINTON G E, OSINDERO S, TEH Y W. A fast learning algorithm for deep belief nets[J]. Neural Computation, 2006, 18(7): 1527-1554.

[5] LECUN Y. Generalization and network design strategies[D].Toronto: University of Toronto, 1989.

[6] BODEN M. A guide to recurrent neural networks and backpropagation[J]. Dallas Project Sics Technical Report T Sics, 2001, 1-9.

[7] HAN S, POOL J, TRAN J, et al. Learning both weights and connections for efficient neural networks[J]. Computer Science, 2015, 1136-1143.

[8] GONG Y C, LIU L, YANG M, et al. Compressing deep convolutional networks using vector quantization[J]. Computer Science, 2014, 1-9.

[9] CHEN W, WILSON J T, TYREE S, et al. Compressing neural networks with the hashing trick[J]. Computer Science, 2015, 2285-2294.

[10] HAN S, MAO H, DALLY W J. Deep compression: compressing deep neural networks with pruning, trained quantization and Huffman coding: ICLR[C]∥ San Juan: 2016 International Conference on Learning Representation, 2016.

[11] CIRESAN D C, MEIER U, GAMBARDELLA L M, et al. Convolutional Neural network committees for handwritten character classification[C]∥ International Conference on Document Analysis and Recognition. [S. l.]: IEEE Computer Society, 2011: 1135-1139.

[12] ROYCHOWDHURY A, LIN T Y, MAJI S, et al. One-to-many face recognition with bilinear CNNs[J]. Computer Science, 2016: 1-9.

[13] 尹寶才, 王文通, 王立春. 深度學習研究綜述[J]. 北京工業大學學報, 2015, 41(1): 48-59.

[14] 田壯壯, 占榮輝, 胡杰民, 等. 基于卷積神經網絡的SAR圖像目標識別研究[J]. 雷達學報, 2016, 5(3): 320-325.

ResearchonSARSatelliteTargetRecognitionSystemBasedonDeepLearningNeuralNetwork

YUAN Qiu-zhuang, WEI Song-jie, LUO Na

(School of Computer Science and Technology, Nanjing University of Science and Technology, Nanjing 210094, Jiangsu, China)

To realize the intelligent recognition of ground target, a synthetic aperture radar (SAR) satellite target recognition system based on deep learning (DL) convolutional neural network (CNN) was studied in this paper. The system composed of two parts of onborne segment and ground segment. The network structure design, SAR image pretreatment, CNN model training, and the model compression and uploading were carried on in the ground segment. The compressed model receiving and decompressing, target recognition, recognized coarse screening image downloading were carried on in the onborne segment. Then the images downloaded were screened by manual labour in the ground segment. The screened images were served as the training data for CNN model again. It would obtain higher precision images step by step. There were 2 convolutional layers, 2 lower sampling layers, 3 Dropout layers, 1 Flatten layer, 2 connection layers and 11 output label in the CNN structure. To use the trained CNN model onborne, two deep compression method were adopted to decrease the data memory and network complex, which were data precision compression and pruning. The CNN model proposed was realized in Keras deep learning open source library. The experimental results in recognizing 11 classes of military targets in the database of Moving and Stationary Target Acquisition and Recognition (MSTAR) showed that the effect of recognition and classification was well. The overall recognition success rate was 96.29%. The model could be compressed to 1/13 of the original one while the accuracy loss rate was less than 2%.

spaceborne synthetic aperture radar (SAR) image; intelligent target recognition (ITR); deep learning (DL); convolutional neural network (CNN); deep compression; data precision compression; pruning; model efficiency

1006-1630(2017)05-0046-08

2016-12-08;

2017-02-23

國家自然科學基金資助(61472189);上海航天科技創新基金資助(F2016020013)

袁秋壯(1994—),男,碩士生,主要研究方向為圖像處理。

TN957.52

A

10.19328/j.cnki.1006-1630.2017.05.007