人工智能的倫理風險及其治理

◎孫保學

目前,人工智能技術已經在各行各業和人們的日常生活中被廣泛應用。在語音技術、圖像技術、視頻技術、人機交互、知識圖譜和增強現實等領域,人工智能的應用使得效率大大提升。人們在智能手機或電腦上獲取的新聞、廣告、音樂和視頻等,很多都是智能搜索算法根據用戶的瀏覽習慣進行的個性化推薦;招聘網站能夠根據客戶的需求自動匹配適合某個崗位的求職者;很多體育新聞和財經報道其實是由人工智能系統寫出;……對于人工智能對人們生活的重塑,社會輿論和學術界都給予了很多關注,但主要是集中在產業發展和就業影響方面,缺少從哲學尤其是倫理學視角來思考人工智能技術風險及其治理的研究。

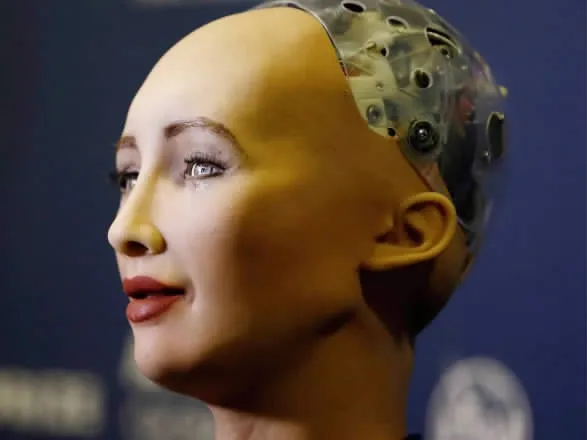

索菲亞,世界上首個被授予公民資格的機器人。

一、智能算法影響下的未來社會

我們正加速進入人工智能時代。計算機技術和互聯網技術曾先后主導了兩次信息技術革命。當前,我們正身處以人工智能技術為核心的第三次信息技術浪潮之中。它的突破性變革表現在:一方面,從技術 (軟件和硬件)的演進和發展的角度看,不僅計算機的運算能力較幾十年前取得了飛速提升,而且以深度學習為代表的人工智能算法使人工智能的自主學習能力大大增強。學習算法具備了更強的自主能力,能夠自行學習和編程,處理越來越復雜的任務;另一方面,從外部影響因素來看,大數據時代的到來使機器學習的復雜算法得以流暢運行和應用。同時,商業創新和投資應用的推波助瀾使各項技術得以快速迭代,像機器翻譯、語音識別、醫療診斷、無人機和自動駕駛等技術越來越多地嵌入到人們的日常生活中。

不過,人工智能技術給人類帶來便利的同時,也給人們帶來很多擔憂。人工智能在越來越多的領域開始超越人類智能,人們對于它的未來發展感到憂慮和恐懼。很多人擔心人工智將來會搶走自己的工作,最終引發全球性的失業潮,給社會帶來不安和動蕩。假如人類的工作真的都被智能機器所接管,那么人類的價值將會如何?人類將何去何從?不過,在技術專家看來,情況并沒有如此糟糕。按照他們的預測,在人工智能領域潛藏巨大的市場,絕大多數工作確實會消失,但同時也會創造出更多的新型工作。事實上,上述擔憂并不會妨礙產業界追求更高商業利潤的腳步;同樣,人類對未知領域的好奇心也會驅使著科學家們不斷地探究人工智能的極限和邊界,上述擔憂也不會阻止科學界追尋終極算法的可能。

人工智能對人類生活的影響與日俱增,并且覆蓋領域正加速擴展并不斷深化。長遠來看,人工智能的廣泛應用將帶來巨大的社會效益。隨著智能設備被越來越多地應用于社會,人類也將從機械的重復性勞動中解放出來,完成那些復雜、精密或危險的任務,成為人類的得力助手。不過,隨著人工智能技術的不斷迭代和大規模應用,人類與人工智能在交互過程中的沖突也將會日益增多,越來越多的倫理挑戰將逐漸凸顯出來。

二、人工智能引起的主要倫理風險

從根本上說,人工智能的倫理問題主要由算法的自主學習能力所衍生出來。下文將從數據隱私、安全威脅、算法歧視和人工主體權利四個方面簡述人工智能所帶來的倫理挑戰。

第一,隱私泄露。在某種程度上,新一輪人工智能浪潮的到來是由數據驅動的,數據是未來社會發展的 “新石油”。但是,在對數據資源進行價值開發過程中,隱私問題可能成為最突出的倫理挑戰。在信息時代,各種網站和APP都可以作為平臺收集數據,利用腳本跟蹤并記錄用戶的一舉一動。數據挖掘技術能夠在各種看似不相關的數據中找到有價值的信息。人們的各種身份信息、網絡行為和生活軌跡都有可能被用來進行商業價值開發。人們在網絡空間免費獲取各種便利的同時,是以讓渡自己的一些個人數據信息為代價的。為迎合用戶需求,智能設備會提供所謂的 “個性化定制”服務,根據使用者的習慣和偏好分析和確定出使用者的行為特征,自動調整算法參數,從而能夠進行選擇推薦和事務管理。但是,這些信息在被數據平臺收集并存儲到云端后,一旦出現防護漏洞就有可能造成大面積的隱私泄露。云計算和數據共享技術的廣泛應用更是加劇了這種隱私泄露的風險。信息技術的創新使社會變得更加開放和透明,但同時也使個人隱私漸漸成為一種稀缺資源。

第二,安全風險。從近期看,人工智能所帶來的倫理上的安全風險主要表現為三個方面:一是技術濫用。人工智能的自我學習能力對于數據的需求是無限的,為了不斷提高性能表現,算法對于數據的挖掘將變得越來越精細和深入,這可能會侵入到受保護的信息。而且,黑客會利用人工智能技術非法竊取云端或平臺的數據;二是技術缺陷。不成熟的技術更可能導致智能系統的異常運行,加之算法決策的 “黑箱”特征導致的不透明性和解釋性困難,使得算法決策的歸責變得困難,這同樣埋下了安全隱患;三是管理缺失。如果智能系統的安全防護措施不到位,很可能被非法侵入和操控,從而威脅公共安全。從長遠來看,隨著人工智能的發展和演化,人工智能有可能發展出自我意識和自由意志,那么人工智能威脅到人類生存不是沒有可能。在學術界,像庫茲韋爾和霍金都曾表達過這種擔憂;在產業界,像蓋茨和馬斯克等人也都認為,不加約束地發展人工智能技術會存在極大的安全隱患。

第三,算法歧視。表面看來,算法作為一種數學結構,具有客觀的和確定性的特征。因此,算法決策應該不大可能會受到人們的情感和價值觀的影響。但是,實際情況卻恰恰相反。人工智能系統基于算法模型和數據學習人類的行為數據,進而做出分析和預測。不過,訓練數據可能并不真實地反映客觀的實際情況,它們有可能受到一些對抗樣本的干擾或污染,使其做出一些錯誤決策。而且,在這些數據中也可能潛藏著不易被人們察覺地價值偏好或風俗習慣。在特定群體中存在的種族歧視或性別歧視,最終都有可能被反映到數據中,從而被機器學習所繼承。這種歧視往往很難通過技術手段消除,從源頭上甄別哪些數據帶有歧視性是極其困難的。為了解決某個問題或任務,不同的算法工程師會設計出不同的算法,它們在細節上滲透著設計者的主觀特質。如果在算法設計中暗藏某種歧視,那么它可能要比潛藏于數據中的歧視更不利于社會公正。

第四,人工主體權利。人工智能在代替人類進行決策或行動時,需要遵循人類社會的規則,符合法律和倫理的要求。否則,它的應用和推廣有可能會面臨社會的民意挑戰和輿論壓力。在未來社會,我們將如何看待人工智能主體或機器人呢?是將它們視為人類的伙伴,還是視其為低人一等的機器?與被人類馴化的寵物和家畜相比,它們的地位會有所不同嗎?它們是否會獲得法律上和道德上的主體地位呢?這些問題看似遙遠,但在我們身邊的確已經發生。2017年10月25日,機器人Sophia(索菲亞)在沙特獲得國籍,成為世界上第一個獲得公民身份的機器人,由此引發熱議。將來,越來越多的安保機器人、護理機器人和家用型機器人將會出現在人們的日常生活中,它們在與人交互的過程中難免會碰到各種法律、倫理問題。人工智能主體的違法和不道德行為究竟該如何處理?假如人工智能沒有財產權,那么它們是否有資格或有能力像人類一樣承擔責任呢?如果人工智能獲得主體地位,它的責任和義務與人類是一樣的嗎?如果人工智能的決策算法由人類設定,或者人們對智能機器的決策形成強烈依賴,那么作為人工智能的使用者或擁有者是否應當承擔某種監護責任呢?上述問題都是政府相關部門、公眾、學術界和產業界應該深入思考和討論的。

實際上,如果人工智能不能贏得公眾的信任、消除人們對其潛在風險的擔憂和恐懼,其應用和推廣勢必會遭遇阻力。因此,有關人工智能的倫理風險的研究應盡快提上議事日程,立法和行政機構要盡快制定相關的法律法規和政策,以此指導和規制人工智能技術良好發展,產業界要設計出符合政策和法律的人工智能產品,防止其被誤用和濫用。

三、人工智能倫理風險的治理機制

在未來社會,人類與智能機器共存將是一種新常態。那么,如何盡量地減少人工智能在設計、研發、生產和使用環節的倫理風險呢?事實上,實現倫理治理主要依靠良好的制度設計和政策引導,而非單純地依靠道德倡議就能夠湊效。總體而言,我們需要從立法、監管、產業、技術和國際合作做出努力,采取必要的應對措施,減少或避免倫理沖突發生的可能性。

第一,要建立和完善智能社會的政策和法律體系,加強人工智能開發和應用的頂層設計。應對倫理風險之所以要結合立法工作,是因為倫理治理和法律治理往往是相互關聯的。康德曾指出,“法律是道德標準的底線”。法律作為最低要求的道德,能夠為合乎倫理的人工智能的良序發展提供方向上的引導。政策、法律和法規應當促進人工智能產業的發展,不妨礙人工智能產品的安全性的提升。在一些特殊領域,法律法規要明確人工智能主體的權利和義務,避免威脅到人類權利。

第二,要盡快制定人工智能產業的安全標準,推行安全認證制度。人工智能產品要符合社會需求,贏得公眾的信任,但這要建立在它們具有非常高的可靠性和安全性的基礎上。要盡最大可能避免安全事故的發生,不斷提高人工智能產品的安全系數,只有經過嚴格測試達標的產品才能投放市場。與此同時,要對人工智能的技術開發人員進行倫理培訓。這是從價值嵌入的角度考慮問題。要加強相關從業人員的道德教育,使人工智能在研發和設計階段就接受倫理準則的約束,使得制造商不因商業利益的驅動而做鋌而走險之事。

第三,要建立和健全人工智能的監管體系。這種監管體系需要從兩個方面展開:一方面,政府相關的職能部門要制定針對不同行業的監管體系和標準,對人工智能產品從設計、研發、數據采集、市場推廣和應用等環節進行全方位監管。要定期審查社會上應用的人工智能系統是否符合道德標準。人工智能應用軟件要進行特定的技術檢測,對于違規軟件實行整改或下架處理,使其退出市場。這種以懲戒為主的外部約束有利于人工智能產業和市場主體加強自律。另一方面,著眼于人工智能的運行和應用層面,要研發類似電子警察的人工智能系統,即用人工智能監管人工智能,防止人工智能技術被非法利用或偏離正常運行。

第四,要強化代碼規制和算法設計的管控,研發和應用受控型人工智能。在一些人工智能的應用領域,算法決策往往涉及道德責任的歸屬和認定,而算法決策過程的不透明性可能意味著責任追溯的困難。因此,只有那些具備更高可追溯性的人工智能系統才是有發展前景的,只有那些符合社會的道德標準和更具人性化的智能設計才具有廣泛的市場可接受度。就目前來講,人工智能的第一屬性是技術或工具,而非社會主體。人工智能的算法設計務必要合乎倫理規范和法律要求,不能侵害人類權利。

第五,要加強國際合作,共同推動人工智能的全球治理。隨著科學技術在全球范圍的廣泛應用,人工智能研究的科學共同體、跨過公司和國際行會組織等往往是超越國界的,其影響是廣泛和深刻的。雖然各國之間有競爭和差異,但是所面對的問題相似性和共性居多。人工智能的治理已經很難僅僅局限于本國本地取得良好的治理效果。人工智能風險治理的框架要在一些基本問題上達成國際共識,才能更好地服務于全人類的福祉。