基于卷積神經網絡的稀疏目標場景下智能視頻人數統計方法

焦會英

摘要

行人檢測是智能交通視頻分析的基礎技術之一,也是計算機視覺中的關鍵技術本文基于卷積神經網絡的Faster R-CNN框架,采用多層網絡構建深度卷積神經網絡,實現復雜環境下的行人檢測。基于深度學習的目標檢測算法從海量數據中自動學習特征,此外,還采用了基于openev的高斯前景檢測方法,將其與深度神經網絡檢測方法融合,從而整合了運動信息與靜態檢測的結果,降低了漏檢率,提高了檢測準確度,相比傳統的目標檢測算法有更好的檢測效果。最后,本文給出了稀疏人群場景下的行人人數評估方法,以減少當前幀視頻人數檢測的誤檢率,提高檢測精度。

【關鍵詞】神經網絡 深度學習 機器學習 行人檢測 行人計數

1 引言

近幾年來,卷積神經網絡(CNN)和目標檢測框架的成功應用大大提高了目標檢測的性能。目標檢測最先進的檢測框架例如R-CNN以及其后繼改進框架Fast R-CNN,FasterR-CNN都是從區域檢測窗口中提取深度卷積特征,再將檢測區域分為不同的類別。這些基于深度學習的卷積神經網絡檢測方法,通過大量的數據訓練,在目標分類和目標檢測領域表現出了非常優秀的檢測準確率和魯棒性。但其檢測算法更適用于靜態圖片行人檢測,在視頻檢測領域仍然存在一定的缺陷。由于視頻信息的時序性要求目標的出現概率和位置在時間上是連續的,即隨著時間的推移所檢測出的目標位置和在固定位置上檢測出的目標的概率不會有突然變化。如果將卷積神經網絡靜態圖片的檢測框架直接應用于視頻檢測問題,由于每幀的檢測結果相互獨立,無法關聯行人的運動信息,將導致相鄰幀之間的行人計數結果容易出現較大偏差。

本文主要研究針對稀疏人群監控場景下的行人計數算法。主要貢獻有以下幾點:

(1)提出了融合深度神經網絡和運動信息的行人檢測方法,提升了稀疏目標場景下的行人檢測準確率。在技術細節上,我們采用非極大值抑制方法融合靜態圖像檢測結果和運動前景標定的行人檢測框結果,并通過實驗設置檢測框的大小邊界,減除冗余標定檢測框,提高了稀疏目標場景下行人檢測的準確率。

(2)提出稀疏目標運動場景下的行人計數評估方法,提高檢測系統的準確率和魯棒性。

2 相關工作

傳統的目標檢測方法,一般采用人工提取的圖像特征,包括SIFT、HOG、LBP等特征。在此基礎上,考慮到單一模型無法解決遮擋和復雜背景等問題,Felzenszwalb等人提出DPM(Deformable part-based models)模型,它運用整體和部分的多模型系統解決遮擋等問題,在深度卷積神經網絡問世之前,該算法在目標檢測領域一直處于核心地位。

深度學習模型采用多層神經網絡,從大規模數據深度挖掘圖像的特征,并將這些特征表示出來應用在各種計算模型之中。W.Ouyang等人提出聯合深度學習(UDN)的概念,將行人檢測的幾個重要的部分進行了聯合學習,在處理海量視頻圖像方面取得了很好的效果。

2.1 Faster R-CNN框架檢測

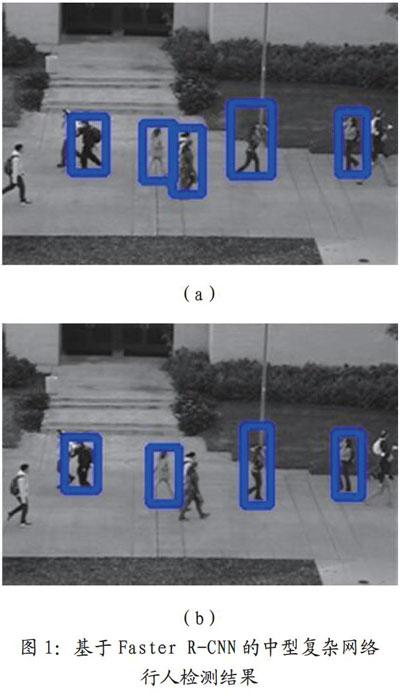

針對現有行人目標檢測的方法,我們采用Faster R-CNN框架,將一直以來分離的regionproposal和CNN分類融合到了一起,使用端到端的網絡進行目標檢測,并且對框架進行模型選擇和微調,簡單網絡目標檢測速度達到17fps,復雜網絡達到5fps。通過實驗比較,我們采用中型網絡進行目標檢測,其檢測速度接近于簡單網絡的檢測速度,檢測準確率卻能基本達到復雜網絡的效果。圖1展示了采用中型復雜網絡對靜態行人圖片的檢測結果。

然而,采用基于Faster-RCNN的中型復雜網絡無法關聯視頻圖像的時序和運動信息,前一幀中標定的行人目標檢測框,在下一幀中同一目標的檢測結果有可能會丟失。從而,整體視頻的檢測結果存在一定的突變性和不穩定性。

2.2 混合高斯背景建模檢測

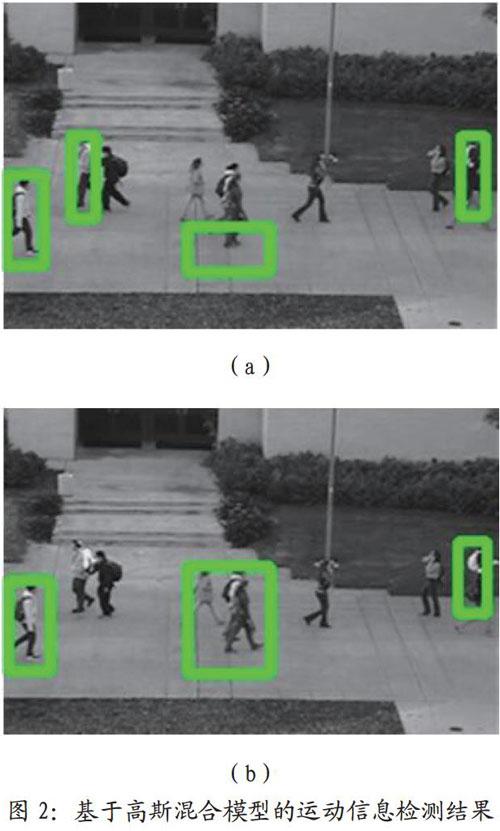

通過混合高斯模型,得到視頻圖像中目標的運動信息,對運動目標進行前景圖像提取,采用形態學處理,定位前景連通區域的邊界像素,得到標記目標前景連通區域的矩形框,如圖2所示。

高斯混合背景檢測方法的優點是可以利用相鄰視頻幀的時序和運動信息檢測出視頻中的運動目標:缺點是對于靜止的目標檢測存在很大的局限性,并且對于運動聯通區域無法進行行人識別,對相鄰運動目標的計數存在誤差。且無法識別圖像中的陰影區域,造成統計誤差。因此,本文融合基于Faster R-CNN的檢測方法和基于高斯混合模型的運動信息檢測方法,得出更高效的視頻目標檢測算法。

3 主要成果論述

3.1 融合神經網絡和運動信息的檢測方法

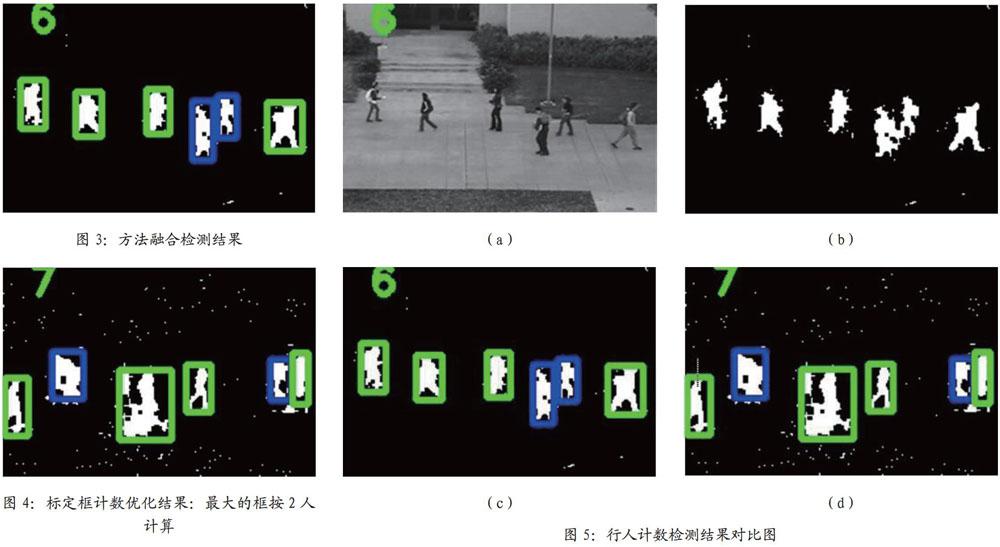

本文提出的融合運動信息與神經網絡靜態檢測的行人視頻計數算法,主要運用混合高斯背景建模和Faster R-CNN深度網絡對視頻圖像進行處理。其主要思想是:以深度神經網絡從視頻圖像中檢測出的行人區域R為基準,將混合高斯背景建模提取的前景運動區域D與R融合,生成更為準確的最終檢測結果,如圖3所示。該算法的細節在3.2和3.3節進行介紹。

3.2 標定框計數優化

使用混合高斯前景檢測算法和深度神經網絡行人檢測算法兩種方法同時對相同視頻幀進行行人檢測,一定會出現標定框重疊現象。并且,當行人相距較近時,采用混合高斯前景檢測算法得到的前景運動區域極大可能包含多個運動行人,得到錯誤的包含多個檢測結果的標定框。

針對上而發生的情況,我們提出標定框計數優化算法:

(1)以深度神經網絡檢測到的行人標定框為基本,將與基本框重合面積超過50%的前景動態檢測框清除,保留Faster R-CNN和基于運動背景檢測算法得出的相對獨立的檢測結果。

(2)設置代表單人標定框的而積范圍。在該范圍內,通常每個標定框代表計數一個行人。對于檢測框標定出的連通區域包含兩個以上行人的情況,其標定框的像素而積一般遠大于正常情況下單人標定框的面積范圍。因此,我們在算法中設置當標定框的像素個數大于400時,我們對框內的人數統計為2.

(3)前景檢測中出現的陰影區域也會被作為前景運動目標提取出來,產生一些較小的標定框。在算法中我們設置當標定框像素小于120時,清除此標定框。

(4)根據上述方法,對不同大小的標定框統計相應的人數值,從而計算出視頻圖片中的實時人數。

經標定框計數優化后的效果如圖4所示。

3.3 計數評估優化算法

我們進一步提出了稀疏目標運動場景下的行人計數評估優化方法。在稀疏目標監控場景下,通常短時間內(一般為1~2秒)的人數可以認為是一個常數。在算法中,我們將這個時間段設置為2秒,每秒的視頻幀率認為是15ft,故在30幀內,我們認為視頻中的實際人數是保持不變的。然而由于漏檢和錯檢,相近幀視頻的計數結果往往存在一定差異。設當前時刻下最近30幀視頻的人數統計結果為X=(x1,x2,x3,…,x30),我們將向量內出現頻率最高的檢測數作為當前幀的行人計數結果(S'j)。

設xi為當前視頻圖像第i幀的真實行人數量,si為未采用計數優化算法時第i幀視頻圖像的檢測人數,si'為使用上述計數優化算法得到的第i幀的人數計數結果。對大量視頻幀數(N)的人數估計結果與真實情況進行對比,可計算出:

兩個統計量。其中,|1-p|為未采用計數優化的檢測錯誤率,|1-p|為采用計數優化的檢測錯誤率,N為視頻幀數,實驗結果顯示|1-p|<|1-p|。

4 關鍵實現技術

4.1 Faster-Rcnn檢測框架

R-CNN以及它的改進框架Fast R-CNN、Faster R-CNN都是從區域檢測窗口中提取深度卷積特征,然后再將檢測區域分為不同類別。通過大量的數據訓練,能夠提升這些基于深度學習的卷積神經網絡檢測方法對復雜環境下目標檢測、識別的準確性和魯棒性。

基于Faster-rcnn卷積神經網絡的目標分類算法如下所示:

(1)將整張圖片輸入CNN,進行特征提取。

(2)用區域建議網絡(Region ProposalNetwork,簡稱RPN)生成候選區域(RegionProposal),每張圖片生成300個候選區域。

(3)把候選區域映射到CNN的最后一層卷積特征圖(feature map)上。

(4)通過Rol pooling層使每個RoI生成固定尺寸的feature map。

利用Softmax Loss(探測分類概率)和Smooth Ll Loss(探測邊框回歸)對分類概率和邊框回歸(Bounding box regression)聯合訓練。技術細節可參考[5]。

4.2 Faster-Rcnn模型動]練與微調

在訓練RPN時,一個Mini-batch是由一幅圖像中任意選取的256個proposal組成的,其中正負樣本的比例為1:1。如果正樣本不足128,則多用一些負樣本以滿足有256個Proposal可以用于訓練,反之亦然。訓練RPN時,與VGG網絡共有的層參數可直接拷貝經ImageNet訓練得到的模型中的參數;其余層參數用標準差=0.01的高斯分布初始化。

5 實驗驗證

5.1 實驗環境

實驗采用VOC數據集【】進行訓練,在USCD行人檢測數據集的vidd子集上進行測試,程序的運行環境為:

Ubuntu 14.10

Opencv2.9

Caffe7.5

GPU gtx860

內存:8.00G

CPU:i7-4720HQ2.6GHz

5.2 實驗結果

圖5是基于卷積神經網絡和運動前景檢測算法在USCD vidd.數據集上某個視頻幀的檢測效果。(a)為原始的視頻輸入圖像,(b)為基于混合高斯背景建模算法經形態學處理后檢測出的前景運動目標,(c)圖融合了卷積神經網絡的靜態檢測結果和混合高斯模型的運動前景檢測結果。其中,綠色框是深度卷積神經網絡在每幀靜態圖像中檢測出的行人目標,藍色框是將運動前景圖像檢測與深度神經網絡靜態檢測結果融合后標記出的神經網絡漏檢的行人目標。(d)圖是經標定框計數優化和最終計數評估優化后得到的行人目標計數結果。

從圖5中可以看出,本文提出的算法彌補了卷積神經網絡在視頻圖像行人計數方面的主要缺陷,提高了視頻行人計數統計的魯棒性和準確率。

6 總結

本文提出了一種融合卷積神經網絡與前景運動信息的視頻行人計數方法。我們解決了Faster R-CNN等基于深度神經網絡的檢測模型不能有效利用動態信息的主要問題,提高了視頻幀行人檢測的準確性。并提出了標定框計數優化和計數評估優化兩個新方法,利用魯棒統計技術,有效降低了人數的誤檢率。實驗結果表明,本文提出的算法在相當程度上解決了在稀疏目標場景中存在一定形變、遮擋時目標行人計數不準確的問題,具有準確率高,魯棒性好,檢測速率快等優點,具有較強的實際應用價值。

參考文獻

[1]C.Szegedy,W.Liu,y.Jia,P.Serinanet,S.Reed,D.Anguelov,D.Ethan,V.Vanhoucke,and A.Rabinovich,“Going deeper withconvolutions,”CVPR,2015.

[2]K.Simonyan and A. Zisserman,“Very deep convolutionalnetworks for large-scale imagerecognition,”IntI Conf.LearningRepresentations,2014.

[3]R.Girshick,J.Donahue,T.Darrell,and J.Malik,“Richfeature hierarchies for accurateobject detection and semanticsegmentation,”CVPR,2014.

[4]R.Girshick,“Fast r-cnn,”ICCV,2015.

[5]S.Ren,K.He,R.Girshick,and J.Sun,“Faster r-cnn:Towards real-time object detection with regionproposal networks,”NIPS,2015.

[6]K.He,X.Mang,S.Ren,and J.Sun,“Deep residual learning for imagerecognition,”in Proceedings of theIEEE Conference on Computer Visionand Pattern Recognition,2016,pp.770-778.

[7]S.loffe and C.Szegedy,“Batchnormalization:Accelerating deepnetwork training by reducing internalcovariate shift,”arXiv preprintarXiv:1502.03167,2015.

[8]W.Ouyang,X.Wang,X.Zeng,S.Qiu,P.Luo,Y.Tian,H.Li,S.Yang,Z.Wang,C.-C.Loy et al.,“DeepID-net:Deformable deep convolutional neuralnetworks for object detection,”CVPR,2015.

[9]David G.Lowe,Distinctive ImageFeatures from Scale-InvariantKeypoints,International Journal ofComputer Vision,Vol.60,Page 91-110,Nov 2004.

[10]Dalal N, Triggs B.Histogramsof oriented gradients for humandetection[C]//Computer Vision andPattern Recognition,2005.CVPR 2005.IEEE Computer Society Conference on.IEEE,2005,1:886-893.

[11]Ahonen T,Hadid A,Pietikdinen M.Face description with local binarypatterns:application to facerecognition[J].IEEE Trans PatternAnal Mach Intell,2006,28(12):2037-2041.

[12]Felzenszwalb P,Mcallester D,Ramanan D.A discriminativelytrained,multiscale,deformable partmodel[J].Cvpr,2008,8::1-8.

[13]Ouyang W,Wang X.JointDeep Learning for PedestrianDetection[C]//IEEE InternationalConference on Computer Vision.IEEE,2014:2056-2063.