生成式對(duì)抗網(wǎng)絡(luò):從生成數(shù)據(jù)到創(chuàng)造智能

王坤峰 左旺孟 譚營(yíng) 秦濤 李力 王飛躍

技術(shù)創(chuàng)新是社會(huì)經(jīng)濟(jì)發(fā)展的核心驅(qū)動(dòng)力.繼以物聯(lián)網(wǎng)、云計(jì)算、大數(shù)據(jù)和移動(dòng)互聯(lián)網(wǎng)為代表的信息技術(shù)之后,以深度學(xué)習(xí)為代表的人工智能技術(shù)蓬勃發(fā)展,被公認(rèn)是社會(huì)經(jīng)濟(jì)發(fā)展的新動(dòng)能和新引擎,有望在農(nóng)業(yè)生產(chǎn)、工業(yè)制造、經(jīng)濟(jì)金融、社會(huì)管理等眾多領(lǐng)域產(chǎn)生顛覆性變革.生成式對(duì)抗網(wǎng)絡(luò)(Generative adversarial networks,GAN)作為一種新的生成式模型,已成為深度學(xué)習(xí)與人工智能技術(shù)的新熱點(diǎn),在圖像與視覺計(jì)算、語(yǔ)音語(yǔ)言處理、信息安全等領(lǐng)域中展現(xiàn)出巨大的應(yīng)用和發(fā)展前景.

1 GAN的原理與現(xiàn)狀

生成式對(duì)抗網(wǎng)絡(luò)GAN是由Goodfellow等[1]在2014年提出的一種生成式模型.其核心思想來源于博弈論中的二人零和博弈.基本的GAN模型在結(jié)構(gòu)上由一個(gè)生成器(Generator)和一個(gè)判別器(Discriminator)組成,如圖1所示.從某個(gè)概率分布pz(例如高斯分布)中采樣隨機(jī)變量z,作為生成器G的輸入,經(jīng)過G的非線性映射,輸出信號(hào)G(z).取決于G的結(jié)構(gòu)和計(jì)算復(fù)雜性,從z到G(z)一般經(jīng)過高度復(fù)雜的非線性變換,使得隨機(jī)變量G(z)具備擬合高度復(fù)雜分布的能力.不失一般性,將G(z)稱為生成數(shù)據(jù)(或偽數(shù)據(jù)),相應(yīng)地將來自物理世界的數(shù)據(jù)x稱為真實(shí)數(shù)據(jù).判別器D以G(z)或x為輸入,通過計(jì)算其屬于真實(shí)數(shù)據(jù)的概率,判斷輸入數(shù)據(jù)是來自于真實(shí)數(shù)據(jù)還是生成數(shù)據(jù).由于G和D一般采用高度非線性并且可微的深度神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu),因而均可以采用端對(duì)端學(xué)習(xí)策略進(jìn)行訓(xùn)練.具體而言,在訓(xùn)練G和D時(shí),采用對(duì)抗學(xué)習(xí)策略,使二者的訓(xùn)練目標(biāo)相反.D的目標(biāo)是最大化對(duì)數(shù)似然函數(shù)以判斷G(z)和x的來源,將G(z)判斷為生成數(shù)據(jù),將x判斷為真實(shí)數(shù)據(jù).與之相對(duì)的是,G的目標(biāo)是最小化對(duì)數(shù)似然函數(shù),使G(z)的分布pg逼近真實(shí)數(shù)據(jù)x的分布pdata.不斷迭代此對(duì)抗訓(xùn)練過程,交替更新判別器D和生成器G的參數(shù),使D和G的性能不斷提高;當(dāng)達(dá)到平衡狀態(tài)時(shí),則認(rèn)為G(z)學(xué)習(xí)到了真實(shí)數(shù)據(jù)x的分布空間,此時(shí)G(z)和x在分布上不具有差異性,判別器D無法對(duì)數(shù)據(jù)來源做出正確的判斷.

Goodfellow等[1]從理論上證明了當(dāng)GAN模型收斂時(shí),生成數(shù)據(jù)具有和真實(shí)數(shù)據(jù)相同的分布.但是在實(shí)踐中,GAN的收斂性和生成數(shù)據(jù)的多樣性通常難以保證[2].主要存在兩個(gè)問題:生成器梯度消失和模式坍塌(Mode collapse).梯度消失是指由于生成器G和判別器D的訓(xùn)練不平衡,判別器D的性能很好,對(duì)生成數(shù)據(jù)G(z)和真實(shí)數(shù)據(jù)x能夠做出完美的分類,那么D對(duì)應(yīng)的誤差損失將很小,進(jìn)而反向傳播到G的梯度值很小,使得生成器G不能得到有效的訓(xùn)練.模式坍塌是指對(duì)于任意隨機(jī)變量z,生成器G僅能擬合真實(shí)數(shù)據(jù)分布pdata的部分模式,雖然G(z)與真實(shí)數(shù)據(jù)x在判別器D難以區(qū)分,但是生成器G無法生成豐富多樣的數(shù)據(jù).

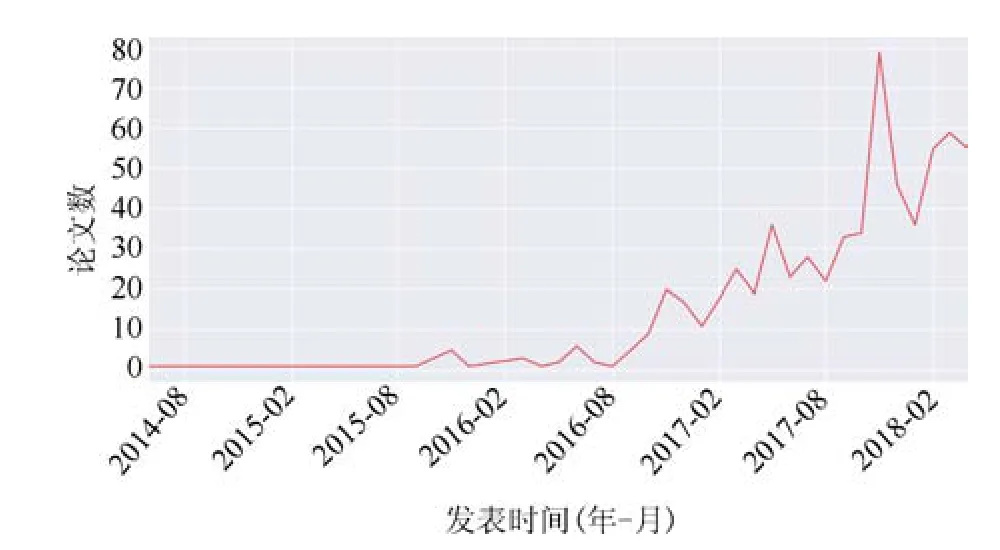

為了解決GAN模型存在的問題,國(guó)內(nèi)外學(xué)者提出了許多衍生模型[3].例如,Arjovsky等[4]提出了Wasserstein GAN,用Earth-mover距離代替Jensen-Shannon散度,來度量生成數(shù)據(jù)分布與真實(shí)數(shù)據(jù)分布之間的差異,在很大程度上緩解了梯度消失和模式坍塌問題.圖2顯示了arXiv上GAN 論文數(shù)量 (以 Generative adversarial networks、Generative adversarial nets和Adversarial learning為關(guān)鍵詞檢索得到)的變化趨勢(shì),反映了GAN的研究熱度變化.可以看出,Goodfellow等提出GAN后的兩年內(nèi),相關(guān)論文的數(shù)量并不多,但是從2016年下半年開始,論文數(shù)量快速增長(zhǎng).

圖1 GAN的基本結(jié)構(gòu)和計(jì)算流程Fig.1 Basic structure and computation procedure of GAN

圖2 arXiv上GAN論文數(shù)量的變化趨勢(shì)Fig.2 Trend of the number of GAN papers published on arXiv

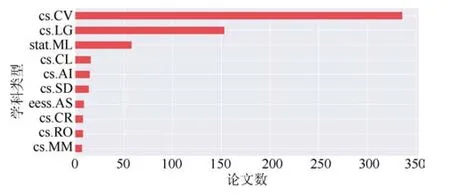

另外,有許多衍生模型是從應(yīng)用的角度提出的.例如,圖像到圖像轉(zhuǎn)換具有廣泛的應(yīng)用,Zhu等[5]提出了CycleGAN,它包括兩個(gè)生成器和兩個(gè)判別器,在對(duì)抗損失的基礎(chǔ)上增加了循環(huán)一致性損失,用于訓(xùn)練非配對(duì)的圖像到圖像轉(zhuǎn)換模型.目前,GAN已經(jīng)被廣泛應(yīng)用于計(jì)算機(jī)視覺、語(yǔ)音語(yǔ)言處理、信息安全等領(lǐng)域.圖3顯示了arXiv上GAN論文所屬的學(xué)科領(lǐng)域.可以看出,論文最多的學(xué)科領(lǐng)域是計(jì)算機(jī)視覺(cs.CV),說明GAN目前主要用于圖像處理與計(jì)算機(jī)視覺;其次是機(jī)器學(xué)習(xí)(cs.LG和stat.ML)、計(jì)算與語(yǔ)言(cs.CL)、人工智能(cs.AI)、語(yǔ)音(cs.SD)、語(yǔ)音處理(eess.AS)、機(jī)器人(cs.RO)、密碼與安全(cs.CR)、多媒體(cs.MM)等.

2 GAN:從生成數(shù)據(jù)到創(chuàng)造智能

GAN的初始目的是基于大量的無標(biāo)記數(shù)據(jù)無監(jiān)督地學(xué)習(xí)生成器G,具備生成各種形態(tài)(圖像、語(yǔ)音、語(yǔ)言等)數(shù)據(jù)的能力.隨著研究的深入與發(fā)展,以生成圖像為例,GAN能夠生成百萬(wàn)級(jí)分辨率的高清圖像[6].實(shí)際上,GAN生成數(shù)據(jù)并不是無標(biāo)記真實(shí)數(shù)據(jù)的單純復(fù)現(xiàn),而是具備一定的數(shù)據(jù)內(nèi)插和外插作用,可以作為一種數(shù)據(jù)增廣方式,結(jié)合其他數(shù)據(jù)更好地訓(xùn)練各種學(xué)習(xí)模型.進(jìn)而,通過在生成器的輸入同時(shí)包括隨機(jī)變量z和隱碼c并最大化生成圖像與隱碼c的互信息,InfoGAN能夠揭示復(fù)雜數(shù)據(jù)中隱含的分布規(guī)律,實(shí)現(xiàn)數(shù)據(jù)的解釋化表達(dá)[7].因而,GAN不僅可以用于探索復(fù)雜數(shù)據(jù)的潛在規(guī)律,還能夠生成高質(zhì)量的生成樣本以作為真實(shí)數(shù)據(jù)的有效補(bǔ)充,為學(xué)習(xí)智能模型提供了新的視角和數(shù)據(jù)基礎(chǔ).

圖3 arXiv上GAN論文所屬的TOP 10學(xué)科領(lǐng)域Fig.3 Top 10 subject categories of the GAN papers published on arXiv

對(duì)于條件GAN模型,生成網(wǎng)絡(luò)的輸入往往被定義為樣本的類別甚至其他形式(模態(tài))的數(shù)據(jù).到目前為止,已經(jīng)研究了根據(jù)文本描述生成圖像[8],進(jìn)行交互式圖像編輯[9],從低分辨率圖像生成高分辨率圖像[10],預(yù)測(cè)視頻的未來幀[11],將仿真圖像轉(zhuǎn)換為真實(shí)風(fēng)格的圖像[12],實(shí)現(xiàn)通用的圖像到圖像轉(zhuǎn)換[5],對(duì)真實(shí)圖像的光照和天氣條件進(jìn)行變換[13],從二維圖像生成物體的三維模型等[14].數(shù)據(jù)形式(模態(tài))的轉(zhuǎn)換可以進(jìn)一步帶來不同模態(tài)之間數(shù)據(jù)的可復(fù)用、模型和知識(shí)的遷移,創(chuàng)造更高水平的智能.例如,SimGAN能夠?qū)⒎抡鎴D像轉(zhuǎn)換為更具真實(shí)感的圖像,同時(shí)保持仿真圖像的標(biāo)注信息不變,利用轉(zhuǎn)換后的圖像數(shù)據(jù)來訓(xùn)練視線估計(jì)和手勢(shì)估計(jì)模型,使模型精度得到大幅提升[12].

更進(jìn)一步,由于GAN引入了對(duì)抗學(xué)習(xí)機(jī)制,在訓(xùn)練生成器產(chǎn)生更高質(zhì)量數(shù)據(jù)的過程中,本身就會(huì)創(chuàng)造新的智能.例如,將語(yǔ)義分割卷積神經(jīng)網(wǎng)絡(luò)作為GAN的生成器,用判別器來判斷分割圖是來自分割網(wǎng)絡(luò)還是來自真實(shí)標(biāo)注,可以引入更高階的一致性約束,提高語(yǔ)義分割的精度[15];在本專刊中,鄭文博等撰寫的“基于貝葉斯生成對(duì)抗網(wǎng)絡(luò)的背景消減算法”利用GAN的對(duì)抗學(xué)習(xí)機(jī)制來訓(xùn)練背景消減神經(jīng)網(wǎng)絡(luò),將一批輸入圖像直接轉(zhuǎn)換成一批前景/背景分割結(jié)果,在公共測(cè)試集上取得了良好的性能;Mal-GAN能夠主動(dòng)生成具有對(duì)抗性的病毒代碼樣本,攻擊黑盒病毒檢測(cè)模型,有利于提高反病毒軟件的性能[16].總之,GAN在對(duì)抗樣本、數(shù)據(jù)增廣、遷移學(xué)習(xí)和創(chuàng)造智能等方面都展現(xiàn)出巨大的潛力,已成為當(dāng)前的深度學(xué)習(xí)與人工智能研究中關(guān)注的熱點(diǎn).

3 GAN與平行智能

GAN作為一種有效的生成數(shù)據(jù)和創(chuàng)造智能的模型,與平行智能密切相關(guān)[17].平行智能強(qiáng)調(diào)虛實(shí)互動(dòng),其載體是基于ACP(Arti ficial systems,computational experiments,and parallel execution)的平行系統(tǒng)[18].利用人工系統(tǒng)來建模和表示實(shí)際系統(tǒng),通過計(jì)算實(shí)驗(yàn)來分析和評(píng)估各種計(jì)算模型,借助平行執(zhí)行來引導(dǎo)實(shí)際系統(tǒng)向著理想的目標(biāo)狀態(tài)逼近.平行智能包括平行視覺、平行學(xué)習(xí)等分支.

平行視覺[19?20]是ACP理論在視覺計(jì)算領(lǐng)域的推廣.平行視覺利用人工場(chǎng)景來模擬和表示復(fù)雜挑戰(zhàn)的實(shí)際場(chǎng)景,使采集和標(biāo)注大規(guī)模多樣性的圖像數(shù)據(jù)集成為可能,通過計(jì)算實(shí)驗(yàn)進(jìn)行視覺算法的設(shè)計(jì)與評(píng)估,最后借助平行執(zhí)行來在線優(yōu)化視覺系統(tǒng),實(shí)現(xiàn)對(duì)復(fù)雜環(huán)境的感知與理解.利用GAN的半監(jiān)督/無監(jiān)督學(xué)習(xí)能力,能夠生成大規(guī)模、多樣性的圖像數(shù)據(jù)[12?13],有利于對(duì)視覺模型進(jìn)行充分的訓(xùn)練與評(píng)估,提高視覺模型在復(fù)雜場(chǎng)景下的運(yùn)行可靠性.平行學(xué)習(xí)[21]是一個(gè)新型的機(jī)器學(xué)習(xí)理論框架.首先從原始數(shù)據(jù)中選取特定的“小數(shù)據(jù)”,輸入到軟件定義的人工系統(tǒng)中,并由人工系統(tǒng)產(chǎn)生大量新的數(shù)據(jù);然后這些人工數(shù)據(jù)和特定的原始小數(shù)據(jù)一起構(gòu)成解決復(fù)雜問題所需要學(xué)習(xí)的“大數(shù)據(jù)”集合,通過計(jì)算實(shí)驗(yàn)和平行執(zhí)行來設(shè)計(jì)優(yōu)化機(jī)器學(xué)習(xí)模型,得到應(yīng)用于某些具體場(chǎng)景或任務(wù)的“精準(zhǔn)知識(shí)”.GAN能夠生成大量新的數(shù)據(jù),作為訓(xùn)練數(shù)據(jù)的一部分,提高機(jī)器學(xué)習(xí)模型的性能.簡(jiǎn)言之,可以把GAN看作真與假的平行,把平行智能看作虛與實(shí)的平行.GAN必將促進(jìn)平行智能理論的發(fā)展!

4 專刊論文概覽

為促進(jìn)我國(guó)生成式對(duì)抗網(wǎng)絡(luò)(GAN)相關(guān)理論、方法、技術(shù)與應(yīng)用研究的開展,及時(shí)反映我國(guó)學(xué)者在相關(guān)領(lǐng)域的最新研究進(jìn)展,我們特組織本專刊,針對(duì)GAN的基礎(chǔ)理論與方法、結(jié)構(gòu)優(yōu)化和訓(xùn)練穩(wěn)定性、對(duì)抗機(jī)制以及在各領(lǐng)域的應(yīng)用等重要問題,面向國(guó)內(nèi)研究者征文.本專刊共收到38篇稿件.經(jīng)過同行評(píng)議,我們錄用了其中的13篇稿件,研究?jī)?nèi)容涉及GAN的新結(jié)構(gòu)、因果關(guān)系抽取、多視圖學(xué)習(xí)與重構(gòu)、低秩圖像生成等基礎(chǔ)研究;GAN在圖像識(shí)別、人臉表情識(shí)別、背景消減等計(jì)算機(jī)視覺領(lǐng)域的應(yīng)用基礎(chǔ)研究;以及在語(yǔ)言模型數(shù)據(jù)增強(qiáng)、自能源混合建模與參數(shù)辨識(shí)、原油總氫物性預(yù)測(cè)等其他領(lǐng)域的應(yīng)用基礎(chǔ)研究.

首先,林懿倫等撰寫的綜述文章“人工智能研究的新前線:生成式對(duì)抗網(wǎng)絡(luò)”概括了GAN的基本思想,對(duì)近年來相關(guān)的理論與應(yīng)用研究進(jìn)行了梳理,總結(jié)了常見的GAN網(wǎng)絡(luò)結(jié)構(gòu)與訓(xùn)練方法、博弈形式和集成方法,并對(duì)一些應(yīng)用場(chǎng)景進(jìn)行了介紹.在此基礎(chǔ)上,對(duì)GAN發(fā)展的內(nèi)在邏輯進(jìn)行了歸納總結(jié).

針對(duì)GAN的生成模型學(xué)習(xí)效率低、判別模型易出現(xiàn)梯度消失等問題,王功明等撰寫的“一種能量函數(shù)意義下的生成式對(duì)抗網(wǎng)絡(luò)”提出一種能量函數(shù)意義下基于重構(gòu)誤差的生成式對(duì)抗網(wǎng)絡(luò)(Energy reconstruction error GAN,E-REGAN).將自適應(yīng)深度信念網(wǎng)絡(luò)作為生成模型,來加快學(xué)習(xí)速度;將自適應(yīng)深度自編碼器作為判別模型,用重構(gòu)誤差作為能量函數(shù)來表征判別模型的性能,能量越小表示GAN學(xué)習(xí)過程越趨近于納什均衡的平衡點(diǎn).在MNIST和CIFAR-10數(shù)據(jù)集上的實(shí)驗(yàn)結(jié)果表明,與同類模型相比,E-REGAN在學(xué)習(xí)速度和數(shù)據(jù)生成能力兩方面都有較大提高.

GAN的學(xué)習(xí)目標(biāo)是完整擬合真實(shí)樣本的分布,然而在實(shí)踐中,真實(shí)樣本分布的復(fù)雜程度難以預(yù)計(jì),容易發(fā)生模式坍塌.為了提高無監(jiān)督條件下的GAN生成能力,減少模式坍塌,張龍等撰寫的“協(xié)作式生成對(duì)抗網(wǎng)絡(luò)”強(qiáng)調(diào)不同模式之間既有差異又有聯(lián)系,提出一種新的協(xié)作式生成網(wǎng)絡(luò)結(jié)構(gòu).通過構(gòu)建多個(gè)生成模型,在它們之間引入?yún)f(xié)作機(jī)制,使得生成模型在訓(xùn)練過程中能夠相互學(xué)習(xí),提高模型對(duì)真實(shí)數(shù)據(jù)的擬合能力.實(shí)驗(yàn)表明,該模型在二維圖像生成方面有顯著的效果,協(xié)作機(jī)制可以加快模型收斂速度,提高訓(xùn)練效率,還能消除損失函數(shù)噪聲,在三維模型生成方面也產(chǎn)生了一定的效果.通過調(diào)整模型參數(shù),能夠有效抑制模式坍塌.

因果關(guān)系是一種重要的關(guān)系類型,在事件預(yù)測(cè)、情景生成、問答、文本蘊(yùn)涵等許多任務(wù)中具有重要的應(yīng)用價(jià)值.現(xiàn)有的因果關(guān)系抽取方法大多需要繁瑣的特征選擇,并且嚴(yán)重依賴知識(shí)庫(kù).為此,馮沖等撰寫的“融合對(duì)抗學(xué)習(xí)的因果關(guān)系抽取”利用GAN的對(duì)抗學(xué)習(xí)特性,將帶注意力機(jī)制的雙向門控循環(huán)單元神經(jīng)網(wǎng)絡(luò)與對(duì)抗學(xué)習(xí)相融合,在因果關(guān)系增強(qiáng)模型中引入因果關(guān)系解釋語(yǔ)句.通過重新定義生成模型和判別模型,基本的因果關(guān)系抽取網(wǎng)絡(luò)能夠與判別網(wǎng)絡(luò)形成對(duì)抗,進(jìn)而從因果關(guān)系解釋信息中獲得高區(qū)分度的特征.實(shí)驗(yàn)結(jié)果驗(yàn)證了該方法的有效性和優(yōu)越性.

綜合多個(gè)甚至所有的角度往往有助于對(duì)事物的全面和深入理解,然而在實(shí)際應(yīng)用中,完整視圖數(shù)據(jù)會(huì)導(dǎo)致巨大的獲取成本.為了從已有視圖構(gòu)建事物的完整視圖,孫亮等撰寫的“基于生成對(duì)抗網(wǎng)絡(luò)的多視圖學(xué)習(xí)與重構(gòu)算法”提出一種基于GAN的多視圖學(xué)習(xí)與重構(gòu)算法,利用已知單一視圖,通過生成模型構(gòu)建其他視圖.提出新型表征學(xué)習(xí)算法,將同一實(shí)例的任意視圖都能映射到相同的表征向量,并保證其包含實(shí)例的完整重構(gòu)信息.為構(gòu)建給定事物的多種視圖,提出基于GAN的重構(gòu)算法,在生成模型中加入表征信息,保證了生成視圖數(shù)據(jù)與源視圖相匹配.實(shí)驗(yàn)表明該算法取得了很好的視圖重構(gòu)性能.

低秩紋理模型是圖像處理領(lǐng)域中的一個(gè)重要紋理模型,借助于紋理的低秩性可以對(duì)受到各種變換干擾的圖像進(jìn)行校正.針對(duì)低秩圖像校正問題,趙樹陽(yáng)等撰寫的“基于生成對(duì)抗網(wǎng)絡(luò)的低秩圖像生成方法”提出了一種由原始圖像直接生成低秩圖像的生成式對(duì)抗網(wǎng)絡(luò)(Low-rank generative adversarial network,LR-GAN).該方法將傳統(tǒng)的無監(jiān)督學(xué)習(xí)的低秩紋理映射算法(Transform invariant low-rank textures,TILT)作為引導(dǎo)加入到網(wǎng)絡(luò)中來輔助判別器,使網(wǎng)絡(luò)整體達(dá)到無監(jiān)督學(xué)習(xí)的效果,并且使低秩對(duì)抗對(duì)在生成器和判別器上都能夠?qū)W習(xí)到低秩表示.為了保證生成的圖像既有較高的質(zhì)量又有相對(duì)較低的秩,同時(shí)考慮到低秩約束條件下優(yōu)化問題的不易解決,在經(jīng)過一定階段的TILT引導(dǎo)后,設(shè)計(jì)并加入了低秩梯度濾波層來逼近網(wǎng)絡(luò)的低秩最優(yōu)解.實(shí)驗(yàn)表明,LR-GAN取得了很好的低秩圖像生成效果.

在漫畫繪制的過程中,按草稿繪制出線條干凈的線稿是一個(gè)很重要的環(huán)節(jié).現(xiàn)有的草圖簡(jiǎn)化方法具有一定的線條簡(jiǎn)化能力,但是由于草圖繪制方式的多樣性以及畫面復(fù)雜凌亂程度的不同,這些方法的適用范圍和效果有限.為此,盧倩雯等撰寫的“基于生成對(duì)抗網(wǎng)絡(luò)的漫畫草稿圖簡(jiǎn)化”提出一種基于GAN的草圖簡(jiǎn)化方法,將條件隨機(jī)場(chǎng)和最小二乘生成對(duì)抗網(wǎng)絡(luò)相結(jié)合,搭建草圖簡(jiǎn)化的深度卷積神經(jīng)網(wǎng)絡(luò)模型,通過生成器和判別器之間的零和博弈與條件約束,得到更加接近于真實(shí)線稿的簡(jiǎn)化圖.

深度卷積生成對(duì)抗網(wǎng)絡(luò)在傳統(tǒng)GAN的基礎(chǔ)上引入卷積神經(jīng)網(wǎng)絡(luò)作為模型骨架結(jié)構(gòu),條件生成對(duì)抗網(wǎng)絡(luò)在GAN的基礎(chǔ)上擴(kuò)展為條件模型.唐賢倫等撰寫的“基于條件深度卷積生成對(duì)抗網(wǎng)絡(luò)的圖像識(shí)別方法”結(jié)合深度卷積生成對(duì)抗網(wǎng)絡(luò)和條件生成對(duì)抗網(wǎng)絡(luò)的優(yōu)點(diǎn),建立了條件深度卷積生成對(duì)抗網(wǎng)絡(luò)模型.利用卷積神經(jīng)網(wǎng)絡(luò)強(qiáng)大的特征提取和表達(dá)能力,加以條件輔助生成樣本,將此結(jié)構(gòu)優(yōu)化改進(jìn)后,應(yīng)用于MNIST、CIFAR-10等圖像識(shí)別任務(wù)中,有效提高了識(shí)別準(zhǔn)確率.

讓機(jī)器能夠識(shí)別人的表情,是人機(jī)交互的關(guān)鍵.在自然交流中,人的情緒表達(dá)往往伴隨著豐富的頭部姿態(tài)和肢體動(dòng)作,使得提取有效的表情特征非常困難.現(xiàn)有的表情識(shí)別方法大多基于通用的人臉特征表示和識(shí)別算法,很少考慮表情識(shí)別和身份識(shí)別的差異,使得算法不夠魯棒.為此,姚乃明等撰寫的“基于生成式對(duì)抗網(wǎng)絡(luò)的魯棒人臉表情識(shí)別”提出一種對(duì)人臉局部遮擋圖像進(jìn)行用戶無關(guān)表情識(shí)別的方法.該方法包括一個(gè)基于Wasserstein GAN的人臉圖像生成網(wǎng)絡(luò),能夠?yàn)閳D像中的遮擋區(qū)域生成上下文一致的補(bǔ)全圖像;還包括一個(gè)表情識(shí)別網(wǎng)絡(luò),在表情識(shí)別和身份識(shí)別任務(wù)之間建立對(duì)抗關(guān)系,提取用戶無關(guān)的表情特征并推斷表情類型.該方法在公共數(shù)據(jù)集上取得了較高的表情識(shí)別準(zhǔn)確率.

背景消減是計(jì)算機(jī)視覺領(lǐng)域的一個(gè)重要研究方向.實(shí)際環(huán)境中存在的光照變化、陰影、背景運(yùn)動(dòng)等因素對(duì)背景消減提出了嚴(yán)重挑戰(zhàn).為此,鄭文博等撰寫的“基于貝葉斯生成對(duì)抗網(wǎng)絡(luò)的背景消減算法”提出一種基于GAN的背景消減算法.首先利用中值濾波算法進(jìn)行背景數(shù)據(jù)的獲取,然后基于貝葉斯GAN建立背景消減模型,采用深度卷積神經(jīng)網(wǎng)絡(luò)構(gòu)建貝葉斯GAN的生成器和判別器,利用GAN的對(duì)抗學(xué)習(xí)機(jī)制來進(jìn)行模型訓(xùn)練.訓(xùn)練后的生成器能夠?qū)⒚總€(gè)像素分類為前景或背景,有效解決了光照變化、非靜止背景、鬼影(Ghost)等問題.

基于最大似然估計(jì)(Maximum likelihood estimation,MLE)的語(yǔ)言模型數(shù)據(jù)增強(qiáng)方法存在暴露偏差問題,無法生成具有長(zhǎng)時(shí)語(yǔ)義信息的采樣數(shù)據(jù).為此,張一珂等撰寫的“基于對(duì)抗訓(xùn)練策略的語(yǔ)言模型數(shù)據(jù)增強(qiáng)技術(shù)”提出一種基于對(duì)抗訓(xùn)練策略的語(yǔ)言模型數(shù)據(jù)增強(qiáng)方法,通過一個(gè)卷積神經(jīng)網(wǎng)絡(luò)判別模型判斷生成數(shù)據(jù)的真?zhèn)?引導(dǎo)遞歸神經(jīng)網(wǎng)絡(luò)生成模型學(xué)習(xí)真實(shí)數(shù)據(jù)的分布.語(yǔ)言模型的數(shù)據(jù)增強(qiáng)問題實(shí)質(zhì)上是離散序列的生成問題.為了將判別模型的誤差通過反向傳播算法回傳到生成模型,該方法將離散序列生成問題表示為強(qiáng)化學(xué)習(xí)問題,利用判別模型的輸出作為獎(jiǎng)勵(lì)對(duì)生成模型進(jìn)行優(yōu)化,采用蒙特卡洛搜索算法對(duì)生成序列的中間狀態(tài)進(jìn)行評(píng)價(jià).實(shí)驗(yàn)表明,在有限文本數(shù)據(jù)條件下,隨著訓(xùn)練數(shù)據(jù)量的增加,該方法可以降低識(shí)別字錯(cuò)誤率,優(yōu)于基于MLE的數(shù)據(jù)增強(qiáng)方法.

自能源是能源互聯(lián)網(wǎng)的子單元,旨在實(shí)現(xiàn)能量間的雙向傳輸及靈活轉(zhuǎn)換.由于自能源在不同工況下的運(yùn)行特性存在很大差異,現(xiàn)有方法不能對(duì)其進(jìn)行精確的參數(shù)辨識(shí).為此,孫秋野等撰寫的“基于GAN技術(shù)的自能源混合建模與參數(shù)辨識(shí)方法”提出了一種基于GAN的數(shù)據(jù)和機(jī)理混合驅(qū)動(dòng)方法,對(duì)自能源模型進(jìn)行參數(shù)辨識(shí).將GAN模型中訓(xùn)練數(shù)據(jù)與專家經(jīng)驗(yàn)結(jié)合,進(jìn)行模糊分類,解決了自能源在不同工況下的模型切換問題.通過應(yīng)用含策略梯度反饋的GAN技術(shù)對(duì)模型進(jìn)行訓(xùn)練,解決了自能源中輸出序列離散的問題.仿真實(shí)驗(yàn)結(jié)果表明,提出的模型具有較高的辨識(shí)精度和更好的推廣性,能夠有效地?cái)M合系統(tǒng)在不同工況下的狀態(tài)變化.

針對(duì)原油物性的回歸預(yù)測(cè)問題,鄭念祖等撰寫的“基于Regression GAN的原油總氫物性預(yù)測(cè)方法”提出一種回歸生成對(duì)抗網(wǎng)絡(luò)(Regression GAN,RGAN)結(jié)構(gòu),該結(jié)構(gòu)在傳統(tǒng)GAN的生成模型和判別模型的基礎(chǔ)上增加了一個(gè)回歸模型.通過判別模型與生成模型之間的對(duì)抗學(xué)習(xí),使得判別模型提取了原油物性核磁共振氫譜譜圖的一系列潛在特征.回歸模型和判別模型共享首層潛在特征,即樣本空間的淺層表達(dá),有利于提高回歸模型的預(yù)測(cè)精度及穩(wěn)定性.通過在生成模型增加互信息約束,并采用回歸模型的均方誤差損失函數(shù)來估計(jì)互信息下界,使得生成模型產(chǎn)生更加接近于真實(shí)的樣本.實(shí)驗(yàn)結(jié)果表明,RGAN有效提高了原油總氫物性的預(yù)測(cè)精度及穩(wěn)定性.

本專刊的順利完成,離不開作者、審稿專家和《自動(dòng)化學(xué)報(bào)》編輯們的大力支持與協(xié)助.我們?cè)诖吮硎菊\(chéng)摯的感謝,并希望本專刊對(duì)我國(guó)生成式對(duì)抗網(wǎng)絡(luò)與人工智能領(lǐng)域的研究起到積極的促進(jìn)作用.

1 Goodfellow I J,Pouget-Abadie J,Mirza M,Xu B,Warde-Farley D,Ozair S,et al.Generative adversarial nets.In:Proceedings of the 27th International Conference on Neural Information Processing Systems.Montreal,Canada:Curran Associates,Inc.,2014.2672?2680

2 Creswell A,White T,Dumoulin V,Arulkumaran K,Sengupta B,Bharath A A.Generative adversarial networks:an overview.IEEE Signal Processing Magazine,2018,35(1):53?65

3 Wang Kun-Feng,Gou Chao,Duan Yan-Jie,Lin Yi-Lun,Zheng Xin-Hu,Wang Fei-Yue.Generative adversarial networks:the state of the art and beyond.Acta Automatica Sinica,2017,43(3):321?332(王坤峰,茍超,段艷杰,林懿倫,鄭心湖,王飛躍.生成式對(duì)抗網(wǎng)絡(luò)GAN的研究進(jìn)展與展望.自動(dòng)化學(xué)報(bào),2017,43(3):321?332)

4 Arjovsky M,Chintala S,Bottou L.Wasserstein GAN.arXiv preprint arXiv:1701.07875,2017.

5 Zhu J Y,Park T,Isola P,Efros A A.Unpaired imageto-image translation using cycle-consistent adversarial networks.In:Proceedings of the 2017 IEEE International Conference on Computer Vision(ICCV).Venice,Italy:IEEE,2017.2242?2251

6 Karras T,Aila T,Laine S,Lehtinen J.Progressive growing of GANs for improved quality,stability,and variation.arXiv preprint arXiv:1710.10196,2017.

7 Chen X,Duan Y,Houthooft R,Schulman J,Sutskever I,Abbeel P.InfoGAN:interpretable representation learning by information maximizing generative adversarial nets.In:Proceedings of the 30th Conference on Neural Information Processing Systems.Barcelona,Spain:Curran Associates,Inc.,2016.

8 Zhang H,Xu T,Li H S,Zhang S T,Huang X L,Wang X G,et al.StackGAN:text to photo-realistic image synthesis with stacked generative adversarial networks.arXiv preprint arXiv:1612.03242,2016.

9 Zhu J Y,Kr?henbühl P,Shechtman E,Efros A A.Generative visual manipulation on the natural image manifold.arXiv preprint arXiv:1609.03552,2016.

10 Ledig C,Theis L,Huszar F,Caballero J,Cunningham A,Acosta A,et al.Photo-realistic single image superresolution using a generative adversarial network.arXiv preprint arXiv:1609.04802,2016.

11 Santana E,Hotz G.Learning a driving simulator.arXiv preprint arXiv:1608.01230,2016.

12 Shrivastava A,P flster T,Tuzel O,Susskind J,Wang W D,Webb R.Learning from simulated and unsupervised images through adversarial training.In:Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Honolulu,HI,USA:IEEE,2017.2242?2251

13 Liu M Y,Breuel T,Kautz J.Unsupervised image-to-image translation networks.In:Advances in Neural Information Processing Systems 30.Barcelona,Spain:Curran Associates,Inc.,2017.

14 Wu J J,Zhang C K,Xue T F,Freeman B,Tenenbaum J.Learning a probabilistic latent space of object shapes via 3D generative-adversarial modeling.In:Advances in Neural Information Processing Systems 29.Barcelona,Spain:Curran Associates,Inc.,2016.

15 Luc P,Couprie C,Chintala S,Verbeek J.Semantic segmentation using adversarial networks.arXiv preprint arXiv:1611.08408,2016.

16 Hu W W,Tan Y.Generating adversarial malware examples for black-box attacks based on GAN.arXiv preprint arXiv:1702.05983,2017.

17 Wang F Y,Wang X,Li L X,Li L.Steps toward parallel intelligence.IEEE/CAA Journal of Automatica Sinica,2016,3(4):345?348

18 Wang Fei-Yue.Parallel system methods for management and control of complex systems.Control and Decision,2004,19(5):485?489,514(王飛躍.平行系統(tǒng)方法與復(fù)雜系統(tǒng)的管理和控制.控制與決策,2004,19(5):485?489,514)

19 Wang Kun-Feng,Gou Chao,Wang Fei-Yue.Parallel vision:an ACP-based approach to intelligent vision computing.Acta Automatica Sinica,2016,42(10):1490?1500(王坤峰,茍超,王飛躍.平行視覺:基于ACP的智能視覺計(jì)算方法.自動(dòng)化學(xué)報(bào),2016,42(10):1490?1500)

20 Wang K F,Gou C,Zheng N N,Rehg J M,Wang F Y.Parallel vision for perception and understanding of complex scenes:methods,framework,and perspectives.Arti ficial Intelligence Review,2017,48(3):299?329

21 Li Li,Lin Yi-Lun,Cao Dong-Pu,Zheng Nan-Ning,Wang Fei-Yue.Parallel learning—a new framework for machine learning.Acta Automatica Sinica,2017,43(1):1?8(李力,林懿倫,曹東璞,鄭南寧,王飛躍.平行學(xué)習(xí)—機(jī)器學(xué)習(xí)的一個(gè)新型理論框架.自動(dòng)化學(xué)報(bào),2017,43(1):1?8)