基于圖像內容視覺感知的圖像質量客觀評價方法?

姚軍財 劉貴忠

1)(西安交通大學電子與信息工程學院,西安 710049)

2)(陜西理工大學物理與電信工程學院,漢中 723000)

1 引 言

隨著光電、信息和通信技術的快速發展,圖像技術的應用日益廣泛.但是,在圖像的獲取、存儲、傳輸和處理過程中均會發生不同程度的改變,導致圖像有一定的失真,直接影響了觀察者的主觀感知效果和服務質量.因此,需要一種有效而又實用的度量失真圖像質量的評價方法.有效可靠的圖像質量客觀評價方法不僅能自動評價其優劣,而且還能對圖像進行質量監控,指導參數設置和優化模塊算法,指導和控制網絡傳輸等.目前,雖然圖像質量評價方面的研究工作取得了較多的成果,但還遠遠不能滿足實際應用的要求和需要,主要是因為其客觀質量評價與主觀感知結果存在一定的差距.因此,研究盡可能逼近人眼主觀感知、有效且方便的圖像質量客觀評價方法非常必要,具有重要的理論研究意義和實際應用價值[1?3].

近些年,國內外的許多專家學者對圖像質量客觀評價方法做了大量的研究工作,提出了較多的評價模型[3?12],其中代表性的有MSE(mean square error),PSNR(peak signal-to-noise ratio),SSIM(structural similarity index)[3],VSNR(visual signal-to-noise ratio)[4],FSIM(feature similarity index)[5],GMSD(gradient magnitude similarity deviation)[6]和VSI(visual saliency-induced index)[7].但分析其評價模型,仍存在些許的不足[5,12,13],其主要表現如下.

1)模型只是計算圖像間的數值差異,完全沒有考慮人類感知因素,致使圖像主客觀評價結果差異較大.如PSNR和MSE等基于像素域的評價方法,但該方法計算簡單,以致目前仍是最為普遍的評價方法之一.

2)考慮了部分人眼視覺特性,但主客觀評價結果仍存在一定程度的差異.國內外在此方面做了大量的研究,得出了較多的成果[3?10],其中普遍認同的是Wang等[3,4]提出的SSIM評價模型.該模型是利用人眼對圖像結構信息的感知特性,從亮度、對比度和結構三個方面構建的評價模型.綜合考慮模型計算復雜度、評價精度和實時性等因素,其評價效果優于SNR,PSNR,VSNR,FSIM,GMSD和VSI.但該模型主要是基于人眼對圖像中的結構信息可以自適應這一特征提出的,沒有考慮圖像中的視覺冗余[5],即人眼對圖像的失真存在一定的閾值,當失真量低于閾值時,人眼不能感知,則主觀評價分數基本不變;但對于SSIM來說,只要有失真,其評價分數便有變化,從而導致了主客觀評價的不一致性.

3)沒有考慮圖像本身內容的感知和復雜度的影響.目前的評價方法主要是針對壓縮和傳輸等外在因素影響而進行的評價,如塊效應、模糊和振鈴效應等,很少考慮圖像內容本身的感知,并且基本上沒有考慮圖像內容復雜度的影響,致使主客觀評價結果存在一定程度上的不一致[10,13?15].目前,這方面的研究已成為熱點.

4)評價模型比較復雜.此問題是目前結合人眼視覺特性進行圖像質量評價研究中的一個難點問題,結合人眼視覺特性及其數學模型在很大程度上會增加評價模型的計算復雜度,如VSNR,FSIM和VSI等.一般評價方法是通過提取和分析圖像中引起失真的特征因素、根據視覺特性和權重構建評價模型.此類方法評價效果雖然較為顯著,但其針對性較強;且為了提高評價準確度,需要提取更多的有效特征,使得計算更加復雜[4,5].

基于以上的不足,本文結合圖像內容的復雜性特征和人眼對亮度感知的非線性、掩蔽特性以及對比敏感度特性,提出了一種基于人眼對圖像內容感知的質量客觀評價方法,采用LIVE,TID2008和CSIQ三個數據庫中的共47幅參考圖像和1549幅測試圖像進行仿真實驗,并與PSNR,SSIM和VSNR等典型的圖像質量客觀評價模型進行了對比分析.結果表明:在圖像質量客觀評價中,考慮人眼對圖像內容和復雜度的感知有助于提高圖像質量主客觀評價的一致性,評價精度可得到進一步的提高.

2 視覺模型及其在圖像質量評價中的應用

2.1 對比敏感度視覺模型

用戶體驗是圖像質量客觀評價的四大關鍵因素之一.目前的評價方法最主要不足之處是沒有較好地結合人眼視覺特性,導致主客觀評價的不一致[3?7].人眼對比敏感特性是4個重要的空間視覺特性之一,國內外專家學者對其進行了大量的研究,提出了較多的數學模型,其模型一般稱之為人眼對比敏感度函數(contrast sensitivity function,CSF),該函數主要描述人眼對比敏感度值(一般采用人眼對比覺察閾值的倒數來定量描述)與角頻率(fθ)之間的函數關系[16?18].綜合考慮圖像質量評價算法的復雜性、CSF模型反映感知特性的效果等方面,分析前人的視覺模型.本文選用由Stephen等[16]提出的人眼亮度對比敏感度函數(CSFL),以及由Nadenau[17]提出的人眼紅綠(rg)和藍黃(by)對立色對比敏感度函數(CSFrg和CSFby),其表達如(1)—(3)式:

1)人眼亮度對比敏感度函數

式中,

其中CL表示人眼覺察亮度目標光柵的對比敏感度閾值;L表示光柵的平均亮度;fθ為人眼觀察光柵時的角頻率,單位為cpd(cycle per degree);w表示覺察時空間視角對應的刺激瞳孔的大小[16].

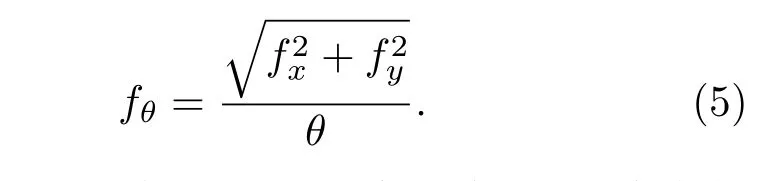

2)人眼紅綠和藍黃對立色對比敏感度函數

式中Crg和Cby分別是定量描述人眼對紅綠和藍黃對立色光柵的彩色對比敏感度閾值[17,18].

2.2 視覺模型在圖像評價中的應用

在結合人眼視覺特性的圖像質量評價中,最為關鍵的一點是構建視覺模型與圖像數據之間的關系[12,16],而兩者之間的聯系即為頻率.在圖像技術中,圖像經變換后得到頻譜圖,其頻率稱之為空間頻率.而在CSF模型中的頻率是角頻率,其定義為單位視角內刺激人眼的光柵條紋的周期數目,表達式為[18]

式中N為視角范圍內目標光柵條紋的周期數目,θ為觀察視角.則要將視覺模型CSF應用到圖像數據中,需要構建兩頻率之間的關系.具體的計算方法如下.

圖像經離散余弦變換(DCT)后得到的頻譜圖上任意一點的頻譜坐標(fx,fy)即為該點的空間頻率,且其任意一點經逆變換后得到空域圖.通過實驗發現:任意一點對應的空域圖均是豎直或水平或兩者共存的條紋光柵,且光柵與原頻譜圖大小相同,光柵的周期數目為.則可以把圖像看成是由若干個光柵合并而成;而人眼是最好的頻譜濾波器,則人眼觀察頻譜圖像上的點時,可以等效為觀看其點對應的光柵.基于此特點,當人眼觀察圖像時,人眼即是覺察周期數目為的光柵,觀察視角為圖像大小范圍所對應的視角;結合(4)式,則人眼觀察圖像時,圖像上任意一點的角頻率計算如(5)式,則其較好地將兩頻率聯系起來.

根據以上關系,當人眼觀察圖像時,圖像中任意一點的角頻率都可通過(5)式計算獲得;再代入到CSF視覺模型(1),(2)和(3)式中,則可以計算獲得人眼覺察圖像中任意一像素點的對比敏感度閾值,包括亮度和色度的閾值.從而將CSF用在圖像評價中.

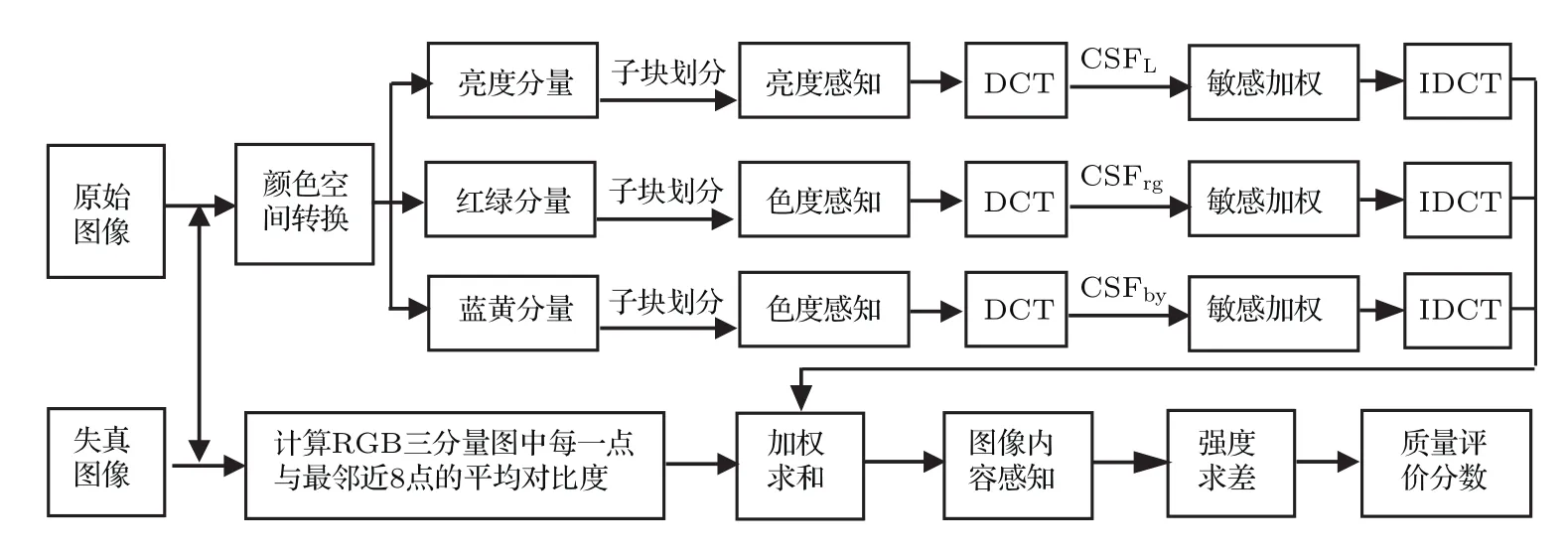

3 圖像質量客觀評價模型構建方法

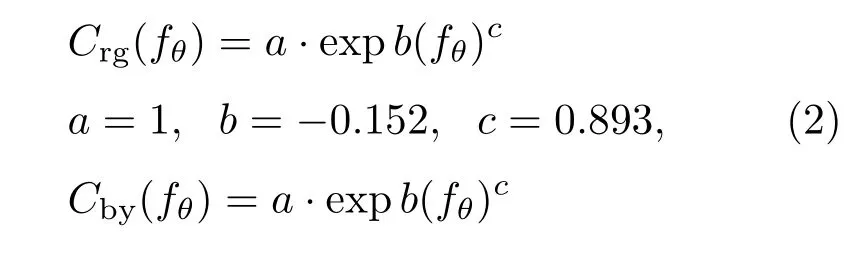

人眼接收到的圖像信息主要是對圖像的亮度和色度信息的感知,則可以把人眼感知到的圖像的亮度和色度作為人眼感知圖像的初步信息.而人眼感知圖像每一點的亮度和色度信息受到兩個方面的影響:一是該點小范圍內其他各點引起的亮度和色度對比對其的影響,即局部對比度的影響;二是人眼對目標本身的敏感程度的影響.考慮二者的影響,以人眼的敏感程度和局部平均對比度作為感知初步信息的權重來求和,其信息之和作為人眼感知圖像的信息內容(即感知圖像),以此思想構建圖像內容感知模型.并以此模型求源圖像和失真圖像之間的強度差,以該差作為圖像質量客觀評價的分數,從而構建圖像質量客觀評價模型,模型構建思路流程如圖1.

圖1 提出的圖像質量客觀評價方法流程圖Fig.1.The architecture for proposed objective evaluation method of image quality.

1)圖像信息強度感知

圖像是由亮度和色度混合而成,但無論是亮度,還是色度,對外的表現均是其能量強度的呈現,人眼對其的感知亦是對其強度的感知.在目前的圖像質量評價方法中,表現圖像差異的方法主要是用強度差來描述.但人眼對能量強度的感知是按對數形式變化,從而導致主客觀評價的不一致.基于此,采用人眼對光強度的感知模型((6)式),分別計算人眼對圖像的亮度、色度的強度感知值S,以此作為人眼感知圖像亮度和色度的信息.

式中I為彩色圖像的亮度(L)、紅綠(rg)和藍黃(by)三個分量圖中各點的能量強度值,K為常數.

具體操作為:將圖像從RGB色空間轉換到YCbCr色空間描述,進行亮度和色度分離,得到亮度、紅綠和藍黃三個分量圖;并分別對其進行8 pixels×8 pixels大小子塊劃分.利用(6)式,分別計算三個分量圖中所有子塊的每一點的亮度對應的主觀感知強度值S,分別記為SL,Srg和Sby.

2)人眼對圖像信息強度的敏感

同一目標在不同的空間位置或具有不同的強度,給人眼的感知敏感程度是不同的.研究表明,在觀察圖像時,最為引起人眼注意的范圍是58個像素點的區域[16,17].則在圖像技術中,為了方便處理,一般將關注的范圍定為8 pixels×8 pixels大小子塊.結合此特性和人眼對比敏感度特性,計算圖像每一子塊中每一像素點的敏感程度.具體操作如下.

①對所有子塊進行離散余弦變換,并將每個子塊頻譜圖的頻譜進行平移,使其零頻移至頻譜中心.計算每個子塊頻譜圖中每一點的空間頻率.根據前面的說明,則f為反離散余弦變換空域圖上呈現光柵的條紋的周期數目,即(4)式中的N.

②以8 pixels×8 pixels大小子塊為每次人眼關注的目標,計算其空間視角θ;根據?1中得出的N值,將N和θ代入(5)式,計算所有子塊中每一點的角頻率fθ.

③將角頻率fθ代入到人眼對比敏感度視覺模型(即(1),(2)和(3)式)中,分別計算出人眼對圖像中每一點的敏感程度值CL,Crg和Cby.

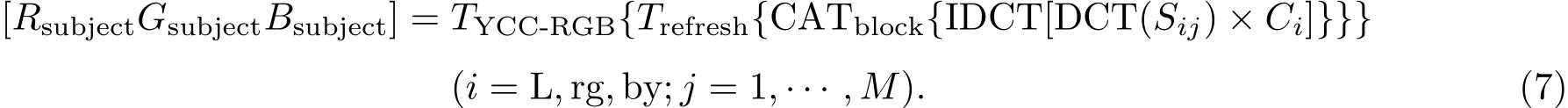

④4分別對SL,Srg和Sby進行DCT變換,以CL,Crg和Cby為權重因子,對其變換域值加權,再對其做反離散余弦變換(IDCT),并將所有子塊(數目為M)合成(CATblock),并排序恢復整幅圖像(Trefresh),其結果為人眼主觀感知圖像亮度和色度的值;并依據YCbCr和RGB之間的經典轉換(TYCC-RGB)關系式轉換到RGB色空間中,得到人眼主觀感知圖像的R,G,B分量圖,記為Rsubject,Gsubject,Bsubject,如(7)式:

3)局部環境對感知圖像信息強度的影響

當人眼觀看圖像時,人眼感知圖像中的每一點都受到該點周圍多個像素點的影響.則為了考慮此影響,對RGB圖像分別以R,G,B三分量圖中每一點自身為中心,計算該點與周圍最鄰近的8個點之間的對比度值,并求其平均值Cmean.以此值作為感知該點受到局部周圍環境的影響因子.

4)圖像內容感知模型

以Cmean為權重因子,分別與主觀感知的Rsubject,Gsubject,Bsubject三分量圖中對應的各點幅值求積.依據RGB色空間顏色混合法則,將求積后的R,G,B值按比例關系混合(CATRGB)得到RGB彩色圖像,其即為人眼主觀感知的圖像(表述為感知圖像),記為RGBsubject.計算如(8)式,其即為人眼感知圖像內容模型.

式中Cm_R,Cm_G和Cm_B為Cmean對應于R,G,B分量圖中的局部對比度平均值.

5)圖像質量客觀評價模型

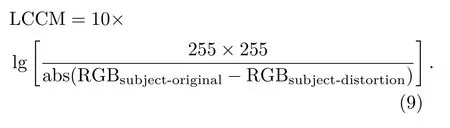

按照以上的圖像內容感知模型,分別處理,計算獲得原始圖像的感知圖像RGBsubject-original和失真圖像的感知圖像RGBsubject-distortion,并按對應像素點計算其平均強度差.基于峰值信噪比(PSNR)的定義式,用平均強度差代替PSNR中的均方誤差(MSE)值計算,計算結果則可作為圖像質量客觀評價分數.其分數值越大,表明圖像質量越好,反之則越差.計算如(9)式,其即為基于人眼對圖像內容感知的圖像質量客觀評價模型,記為LCCM(image quality evaluation model based on luminance,contrast influence and contrast perception).

4 實驗結果與討論

4.1 實驗結果

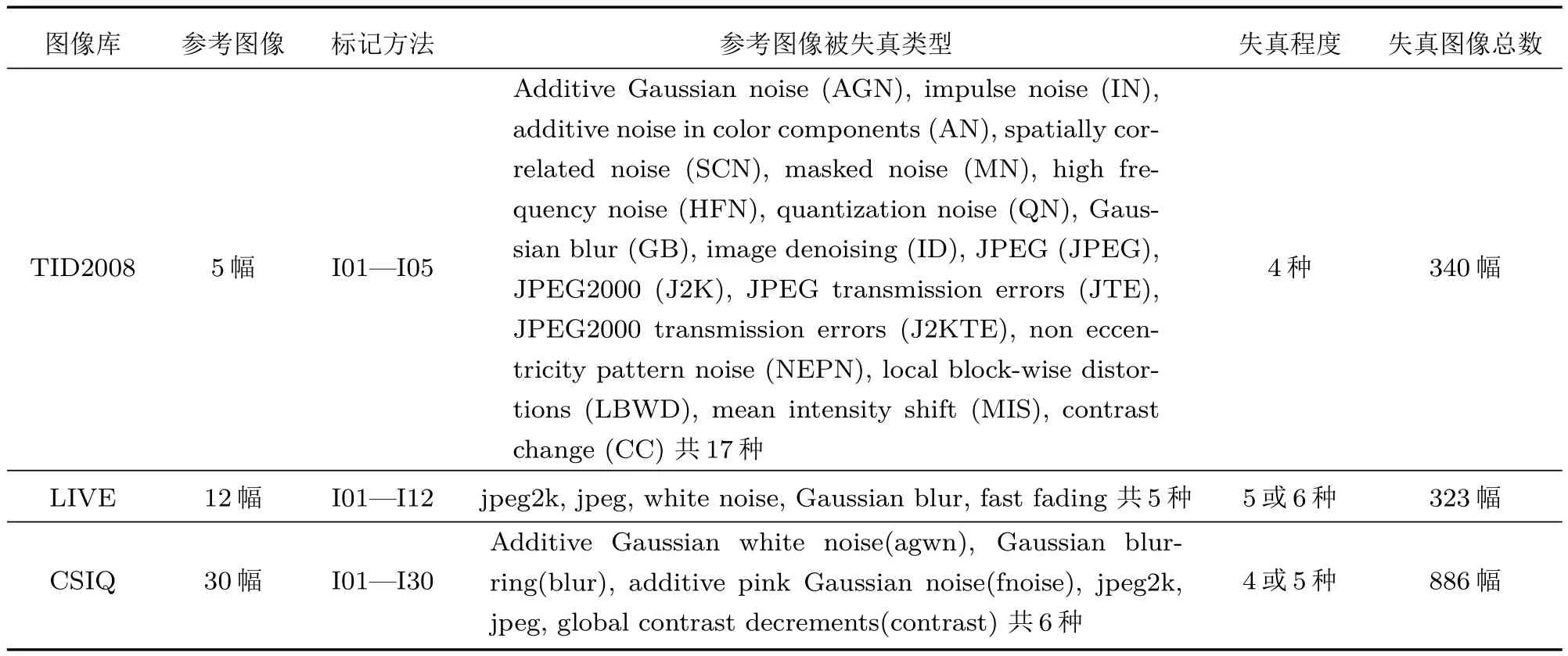

依據上述的圖像質量客觀評價方法,采用LIVE[19,20],TID2008[21,22]和CSIQ[23,24]三個數據庫中的共47幅參考圖像(如圖2,圖3和圖4)和1549幅測試(失真)圖像進行仿真實驗,對其進行評價,獲得圖像質量客觀評價分數LCCM值.其中,測試圖像來源于對參考圖像進行不同失真類型、失真程度的處理而獲得,3個圖像數據庫來源及參數說明如表1.

為了說明圖像質量客觀評價結果的準確性,一般將其與主觀評價分數MOS(mean opinion score)或DMOS(difference mean opinion score)值做相關性分析.相關性分析一般包括:1)做質量主客觀評價分數的散點圖,2)計算相關性參數.其中,散點圖主要是從直觀上反映主客觀評價結果的一致性程度;一般散點圖的縱坐標是質量主觀評價分數MOS或DMOS值,橫坐標是采用模型評價得出的客觀評價分數;為了更好地說明主客觀評價分數的一致性,采用最小二乘法對主客觀評價分數進行擬合,得出擬合曲線;則當散點圖中的散點越靠近擬合曲線(即離散程度越低),曲線的單調性越好,表明主客觀評價分數的相關性越好,一致性越高,則其評價模型就越好,反之則越差.相關性參數主要是從量化上反映主客觀評價結果的一致性程度;相關性參數主要有:Pearson線性相關系數(Pearson linear correlation coefficient,LCC),Spearman秩相關系數(Spearman rank order correlation coefficient,SROCC),均方根誤差(root mean square error,RMSE)和散點圖的離出率(outlier ratio,OR)[25,26].其中LCC和SROCC值越接近于1,表明相關性越好,評價模型越好,反之則越差;RMSE和OR越小,表明主客觀評價結果偏差越小,評價結果越好,反之則越差.此4個參數值能夠較好地從數值上衡量主客觀評價結果的一致性程度.

表1 3個圖像數據庫及參數說明Table 1.Three image databases and the parameters description.

圖2 LIVE數據庫中提供的12幅參考圖像Fig.2.Twelve reference images proposed by LIVE database.

圖3 TID2008數據庫中提供的5幅參考圖像Fig.3.Five reference images provided by TID2008 database.

圖4 CSIQ數據庫中提供的30參考圖像Fig.4.Thirty reference images proposed by CSIQ database.

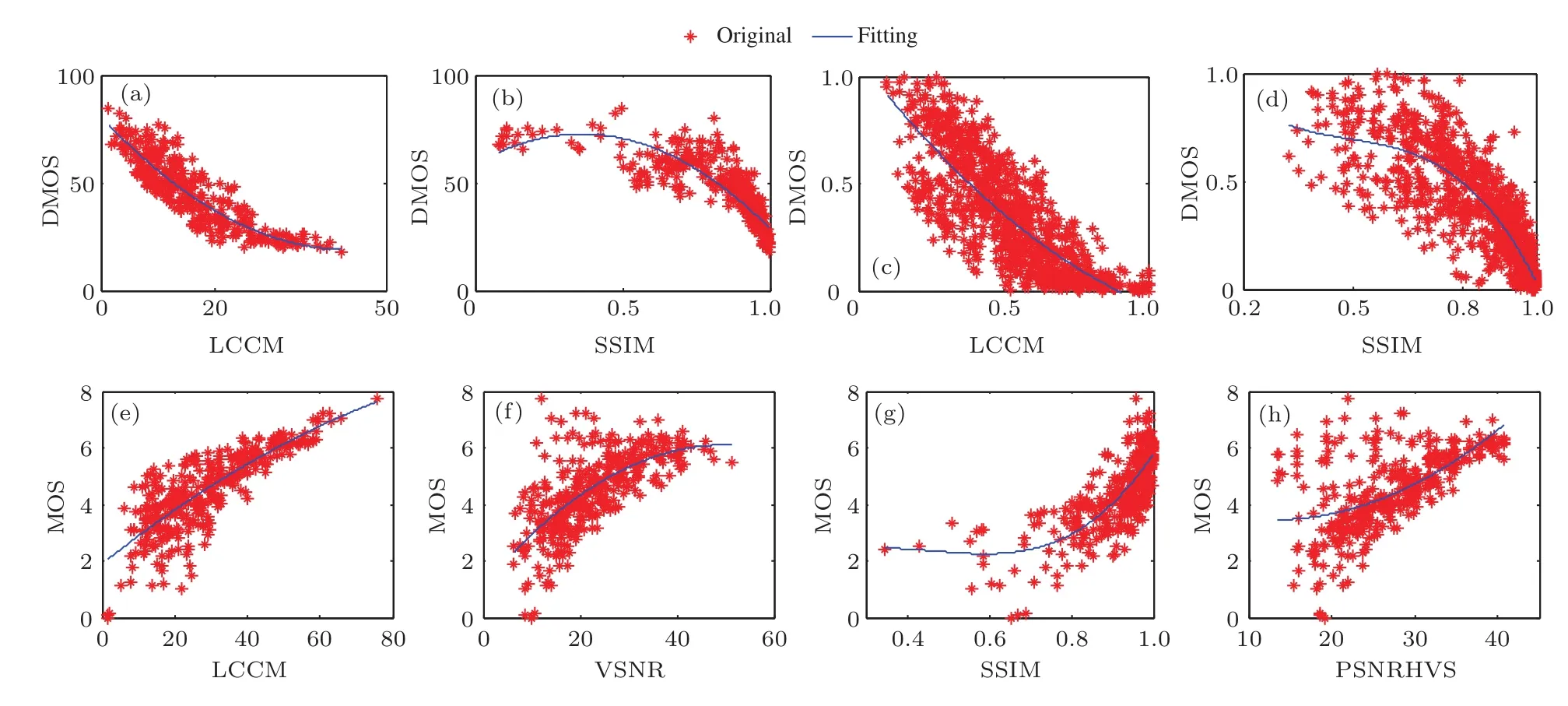

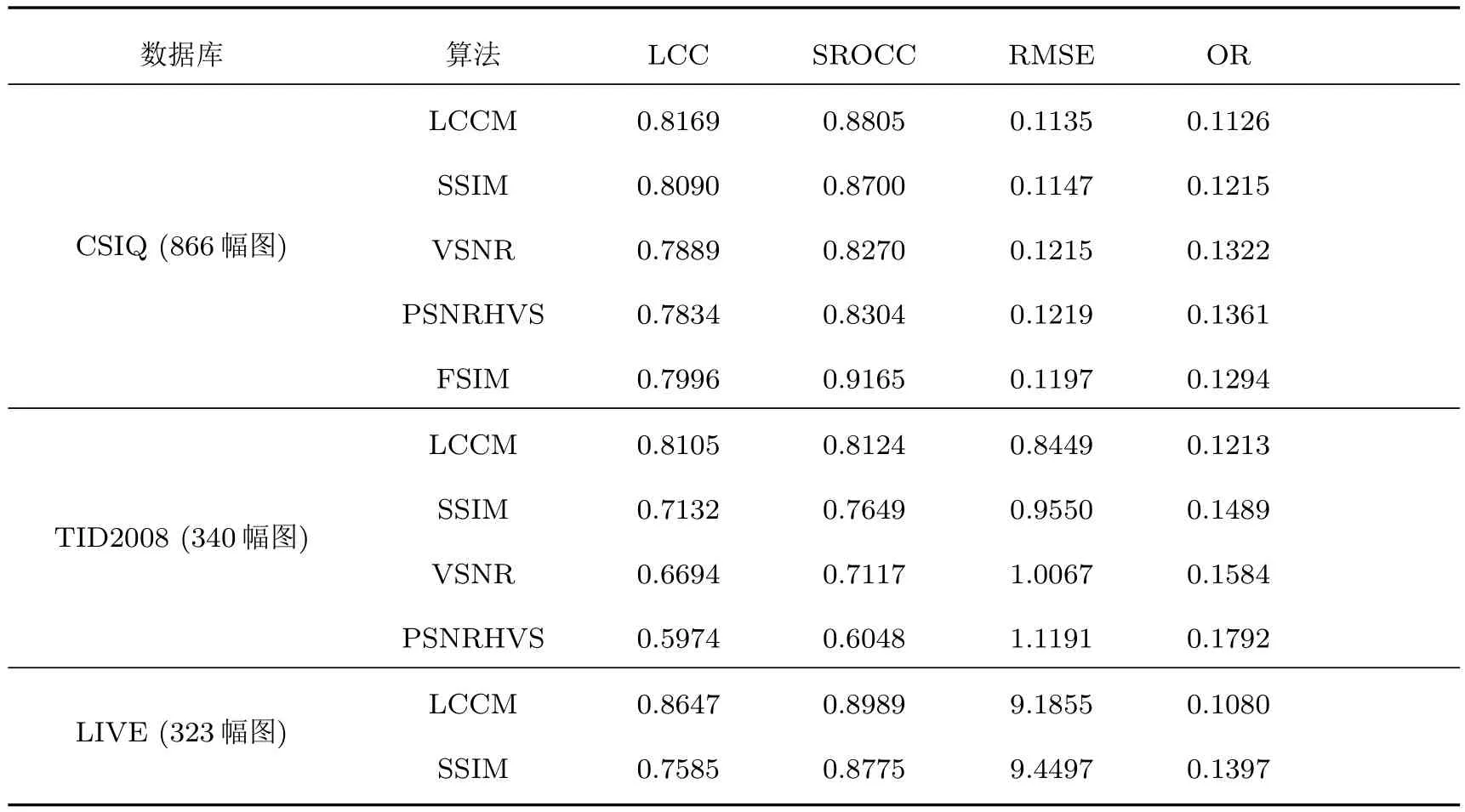

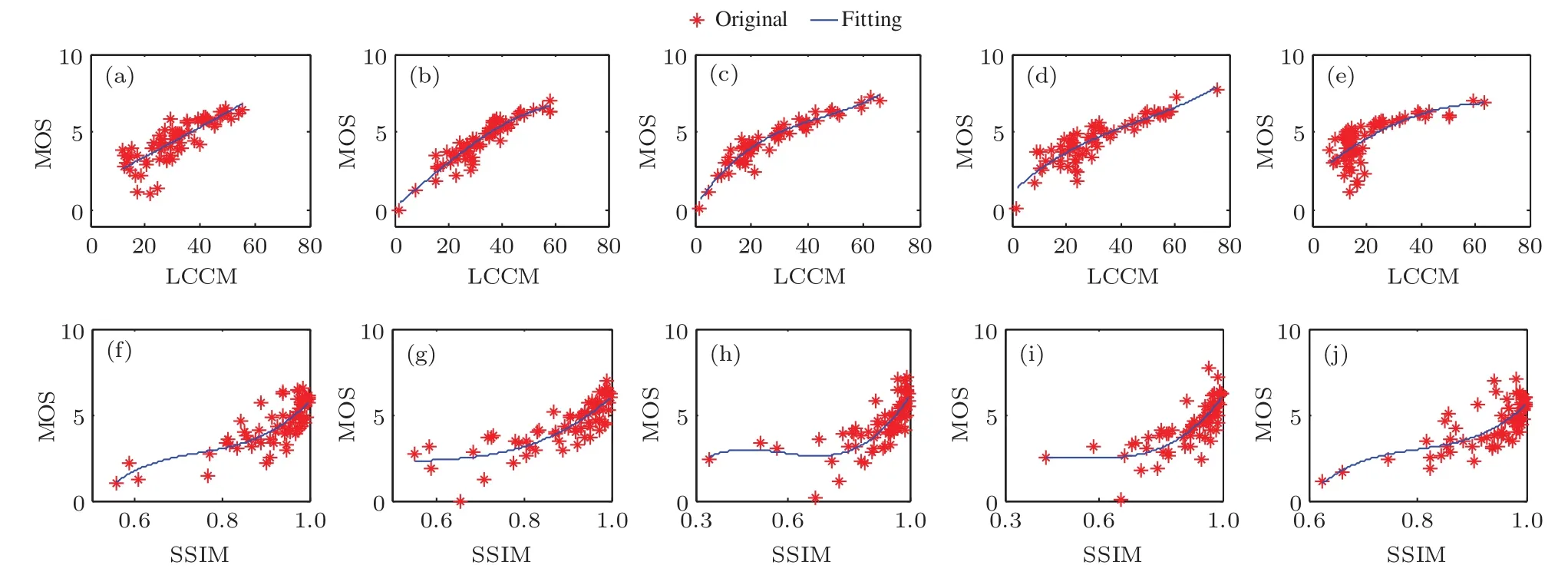

為了說明提出的LCCM圖像質量客觀評價模型的優劣,將其評價1549幅圖像的結果與LIVE,TID2008和CSIQ三個數據庫中提供的主觀評價分數MOS或DMOS值做相關性分析,且與SSIM,VSNR,PSNRHVS和FSIM模型的評價結果進行對比,結果如圖5,計算的4個參數值如表2.

圖5 LCCM,SSIM,VSNR和PSNRHVS模型評價的結果與3個數據庫中提供的主觀評價分數MOS或DMOS值之間的散點圖 (a)LIVE-LCCM;(b)LIVE-SSIM;(c)CSIQ-LCCM;(d)CSIQ-SSIM;(e)TID2008-LCCM;(f)TID2008-VSNR;(g)TID2008-SSIM;(h)TID2008-PSNRHVSFig.5.Scatter plots of LCCM,VSNR,SSIM and PSNRHVS versus MOS or DMOS provided by the LIVE,CSIQ and TID2008 databases:(a)LIVE-LCCM;(b)LIVE-SSIM;(c)CSIQ-LCCM;(d)CSIQ-SSIM;(e)TID2008-LCCM;(f)TID2008-VSNR;(g)TID2008-SSIM;(h)TID2008-PSNRHVS.

表2 衡量圖像主客觀評價一致性的4個參數值Table 2.Four parameters to measure the consistency between subjective and objective evaluations of images.

圖5中的橫坐標為采用LCCM,SSIM,VSNR和PSNRHVS模型評價的質量分數,縱坐標為主觀評價分數.從圖5中可以直觀地發現,相對于SSIM,VSNR和PSNRHVS的評價分數,LCCM評價結果的離散程度明顯偏小,曲線的單調性好于其他三種方法的結果.從相關性量化數值上,表2中的結果表明,LCCM模型的評價分數與DMOS或MOS的相關性系數LCC和SROCC值比SSIM的均得到了一定程度的提高,提高幅度分別平均為9.5402%和3.2852%;比VSNR和PSNRHVS提高幅度更大.

4.2 討 論

為了探討圖像內容復雜性和失真類型對圖像質量評價準確度的影響,以及結合人眼感知特性提高評價精度的途徑,從兩個方面將LCCM模型評價結果與3個數據庫中提供的主觀評價結果進行相關性分析.

4.2.1 圖像內容復雜性對質量評價的影響

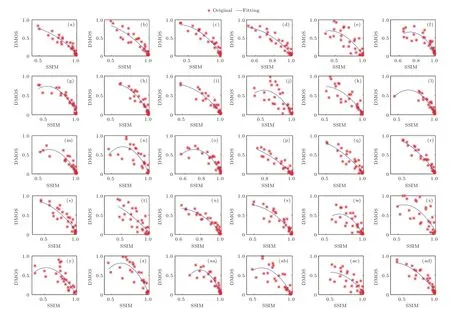

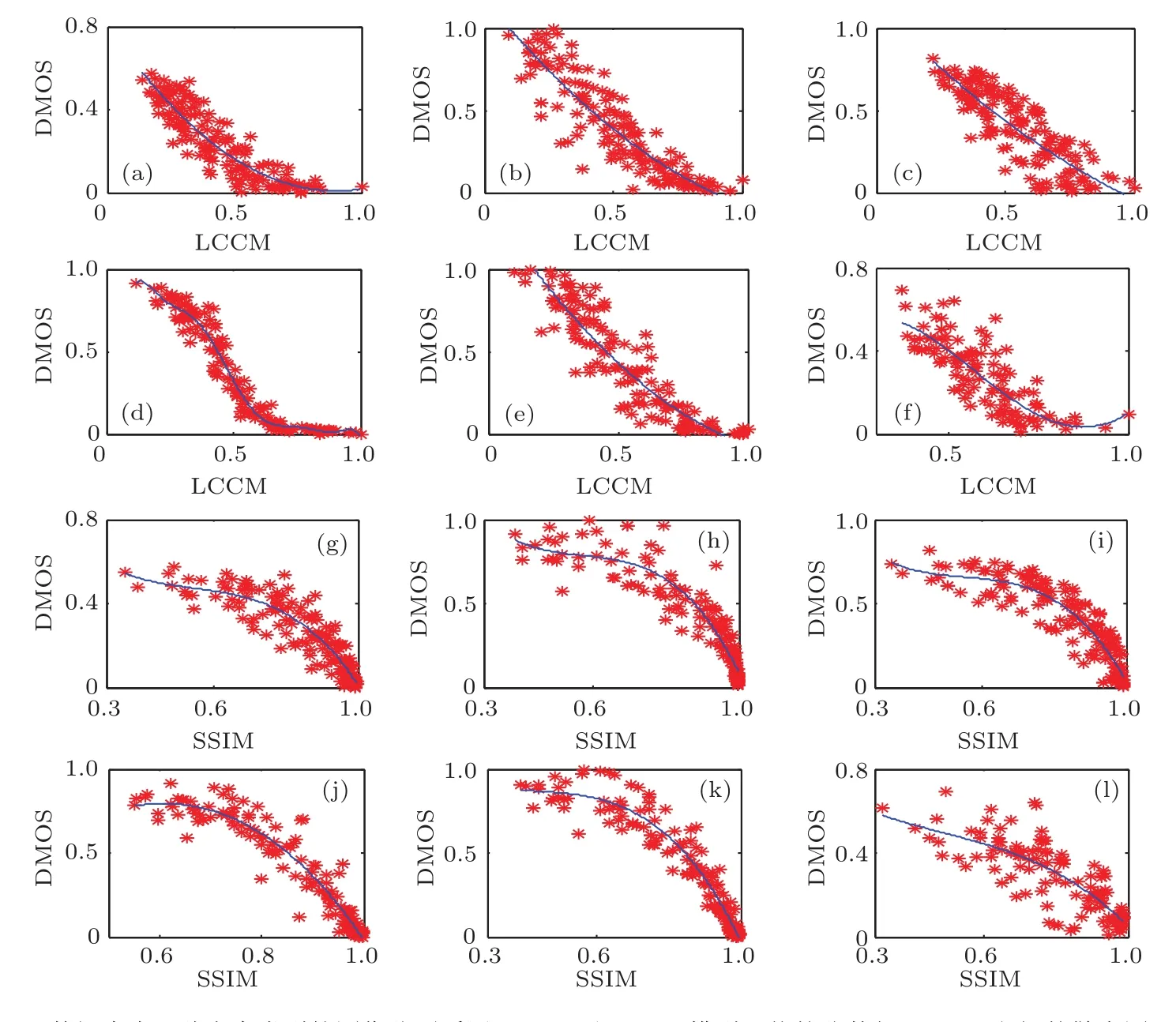

分析每一幅源圖像在不同的失真下的LCCM評價結果與主觀評價結果的相關性,并與SSIM評價結果進行對比分析,探討圖像內容的復雜性對質量客觀評價準確度的影響.結果如圖6—圖10.其中,圖6是TID2008數據庫中5幅源圖像(TID-01—TID-05)經過17種類型、不同程度失真后,采用LCCM和SSIM模型對其評價的結果與MOS值之間的散點圖;圖7是LIVE數據庫中12幅源圖像(buildings,fountain,dancers,church,womanhat,sailing1,bikes,carnivaldools,building2,cemetery,lighthouse,caps)經過5種類型、不同程度失真后,采用LCCM和SSIM模型對每幅源圖像失真后的系列圖像的評價結果與DMOS值之間的散點圖;圖8和圖9是CSIQ數據庫中30幅源圖像(Image01—Image30)經過6種類型、不同程度失真后,分別采用LCCM和SSIM模型對其評價的結果與DMOS值之間的散點圖;圖10是3個數據庫中每幅源圖像經過不同失真后,采用LCCM和SSIM模型對其評價的質量分數與主觀評價分數之間的相關性參數的對比.

圖6 TID2008數據庫中5幅源圖像每幅經過17種類型的失真后采用LCCM和SSIM模型對其評價的結果與MOS值之間的散點圖 (a)—(e)TID-I01-LCCM—TID-I05-LCCM;(f)—(j)TID-I01-SSIM—TID-I05-SSIMFig.6.Scatter plots between MOS and the objective evaluation scores obtained by using the LCCM and SSIM models to evaluate the tested images from any of five reference images in TID2008 database being distorted with 17 types:(a)–(e)TIDI01-LCCM–TID-I05-LCCM;(f)–(j)TID-I01-SSIM–TID-I05-SSIM.

圖6—圖9中的橫坐標為針對三個數據庫中的失真視頻、采用LCCM或SSIM模型評價的質量分數,縱坐標為其視頻主觀評價分數.通過對比各散點圖的離散程度和擬合曲線的單調性,可以直觀地分析主客觀評價分數的一致性(即相關性),從而判斷評價模型的優劣.結合3個數據庫中源圖像的內容特征,對比分析圖6—圖9上的散點分布和圖10中的相關性計算結果可以發現:1)當源圖像本身比較模糊時,如LIVE庫中的圖I03和CSIQ庫中的圖I05,I10,I24,LCCM評價結果與主觀評價結果的相關性明顯高于SSIM評價結果的相關性;2)當源圖像的紋理不復雜、圖像內容場景較少、大面積單色調或相近色或平坦區域時,如LIVE庫中的圖I05,I06,I08,I11,I12,CSIQ庫中的圖I06,I11,I14,I26,以及TID2008庫中的I01,I02,I03,LCCM評價精度在一定程度上高于SSIM的評價結果;而當紋理復雜、場景較多、顏色豐富的圖像,LCCM評價效果相近或差于SSIM.

圖7 LIVE數據庫中12幅源圖像每幅經過5種類型的失真后采用LCCM和SSIM模型對其評價的結果與DMOS值之間的散點圖(a)buildings-LCCM;(b)fountain-LCCM;(c)dancers-LCCM;(d)church-LCCM;(e)woman hat-LCCM;(f)sailing1-LCCM;(g)bikes-LCCM;(h)carnival dolls-LCCM;(i)buildings2-LCCM;(j)cemetry-LCCM;(k)lighthouse-LCCM;(l)caps-LCCM;(m)buildings-SSIM;(n)fountain-SSIM;(o)dancers-SSIM;(p)church-SSIM;(q)womanhat-SSIM;(r)sailing1-SSIM;(s)bikes-SSIM;(t)carnival dolls-SSIM;(u)buildings2-SSIM;(v)cemetry-SSIM;(w)lighthouse-SSIM;(x)caps-SSIMFig.7.Scatter plots between DMOSand the objective evaluationscoresobtainedbyusing the LCCMand SSIMmodelstoevaluatethe testedimagesfromany of12reference imagesinLIVE databasebeing distorted with5 types:(a)buildings-LCCM;(b)fountain-LCCM;(c)dancers-LCCM;(d)church-LCCM;(e)womanhat-LCCM;(f)sailing1-LCCM;(g)bikes-LCCM;(h)carnivaldolls-LCCM;(i)buildings2-LCCM;(j)cemetry-LCCM;(k)lighthouse-LCCM;(l)caps-LCCM;(m)buildings-SSIM;(n)fountain-SSIM;(o)dancers-SSIM;(p)church-SSIM;(q)woman hat-SSIM;(r)sailing1-SSIM;(s)bikes-SSIM;(t)carnival dolls-SSIM;(u)buildings2-SSIM;(v)cemetry-SSIM;(w)lighthouse-SSIM;(x)caps-SSIM.

圖8 CSIQ數據庫中30幅源圖像每幅經過6種類型的失真后采用LCCM模型對其評價的結果與DMOS值之間的散點圖(a)—(ad)Image01—Image30Fig.8.Scatter plots between DMOS and the objective evaluation scores obtained by using the LCCM model stoevaluate the tested images from any of30reference imagesinCSIQ database being distorted with6 types:(a)–(ad)Image01–Image30.

圖9 CSIQ數據庫中30幅源圖像每幅經過6種類型的失真后采用SSIM模型對其評價的結果與DMOS值之間的散點圖(a)—(ad)Image01—Image30Fig.9.Scatter plots between DMOS and the objective evaluation scores obtained by using the SSIM models to evaluate the tested images from any of 30 eference images in CSIQ database being distorted with 6 types:(a)—(ad)Image01—Image30.

圖10 3個數據庫中每幅源圖像經過不同失真后采用LCCM和SSIM模型評價的質量分數與主觀評價分數之間相關性的對比 (a)LIVE;(b)TID2008;(c)CSIQFig.10.Comparing correlation between the subjective scores and the objective results from evaluating all distorted images of each reference image in there databases with LCCM and SSIM respectively:(a)LIVE;(b)TID2008;(c)CSIQ.

分析其原因主要是對于本身模糊、紋理不復雜、場景較少、大面積平坦區域等特征的源圖像,存在更多的視覺冗余,人眼感知其失真的閾值更大;而在圖像質量評價時,只有當圖像失真量超過閾值時,人眼才能感知,但對于SSIM等模型的評價,只要有失真,其評價結果便會發生變化;更大的失真感知閾值增加了SSIM等客觀評價模型的主客觀評價的不一致,導致其模型的評價誤差更大.這需要采用結合更多視覺特性的評價模型來評價.而LCCM模型考慮了人眼感知亮度的非線性、掩蔽特性和對比度敏感特性,相對來說,其結合了更多的人眼視覺特性,所以對于此類圖像的評價效果要優于SSIM,PSNRHVS和MSE等模型.具體的原因分析如下.

1)掩蔽特性.當以上此類源圖像失真時,因為掩蔽特性使得人眼感知其失真的閾值變大,原本能夠感知的圖像失真,因為感知失真閾值的增加而現在不能被感知;人眼容忍圖像失真的程度增加,則使得更大范圍內的失真圖像的主觀評價分數基本不發生變化(圖像的失真不超過感知失真閾值);但對于SSIM等模型,只要有失真,其評價結果就要發生變化;而且由于感知失真閾值的增加,主觀分數基本不變的失真圖像的客觀評價分數變化更大,所以,人眼掩蔽特性是導致主客觀評價不一致的原因之一.而LCCM模型結合了人眼對比敏感度特性,當失真量沒有超過感知失真閾值時,人眼敏感值非常小或者為零,感知圖像上幾乎沒有差異,從而LCCM模型能夠很好地減少因人眼掩蔽特性和圖像視覺冗余帶來的質量評價結果的誤差,提高了其評價精度.

2)人眼感知亮度的非線性.人眼對亮度(或能量強度)的感知是非線性的,呈對數變化趨勢,即人眼感知到的失真量比實際的失真量要小.但對于SSIM等模型是按照實際的失真量來評價圖像間的差異,所以其也是導致主客觀評價不一致的原因之一.而LCCM模型在構建時,將圖像的亮度和色度的強度均按照人眼感知強度模型((6)式)進行了轉換,從而使其評價分數能夠有效地避免此視覺特性帶來的誤差.

3)人眼對比敏感度特性.人眼對目標的敏感程度主要受到周圍環境和空間頻率的影響,即相同的目標在不同的環境中、不同的空間位置,其人眼感知是不同的.則基于此特性,當圖像有相同的失真量時,不同的圖像,人眼感知的結果是不同的,但對于SSIM等模型,相同的失真量其評價結果即相同,從而導致了主客觀評價的不一致.所以,人眼敏感特性也是導致主客觀評價不一致的原因之一.而在LCCM模型的構建中,是以對比敏感度特性值作為感知亮度的權重因子,所以能夠較好地克服評價過程中其帶來的誤差,提高了評價結果的精度.

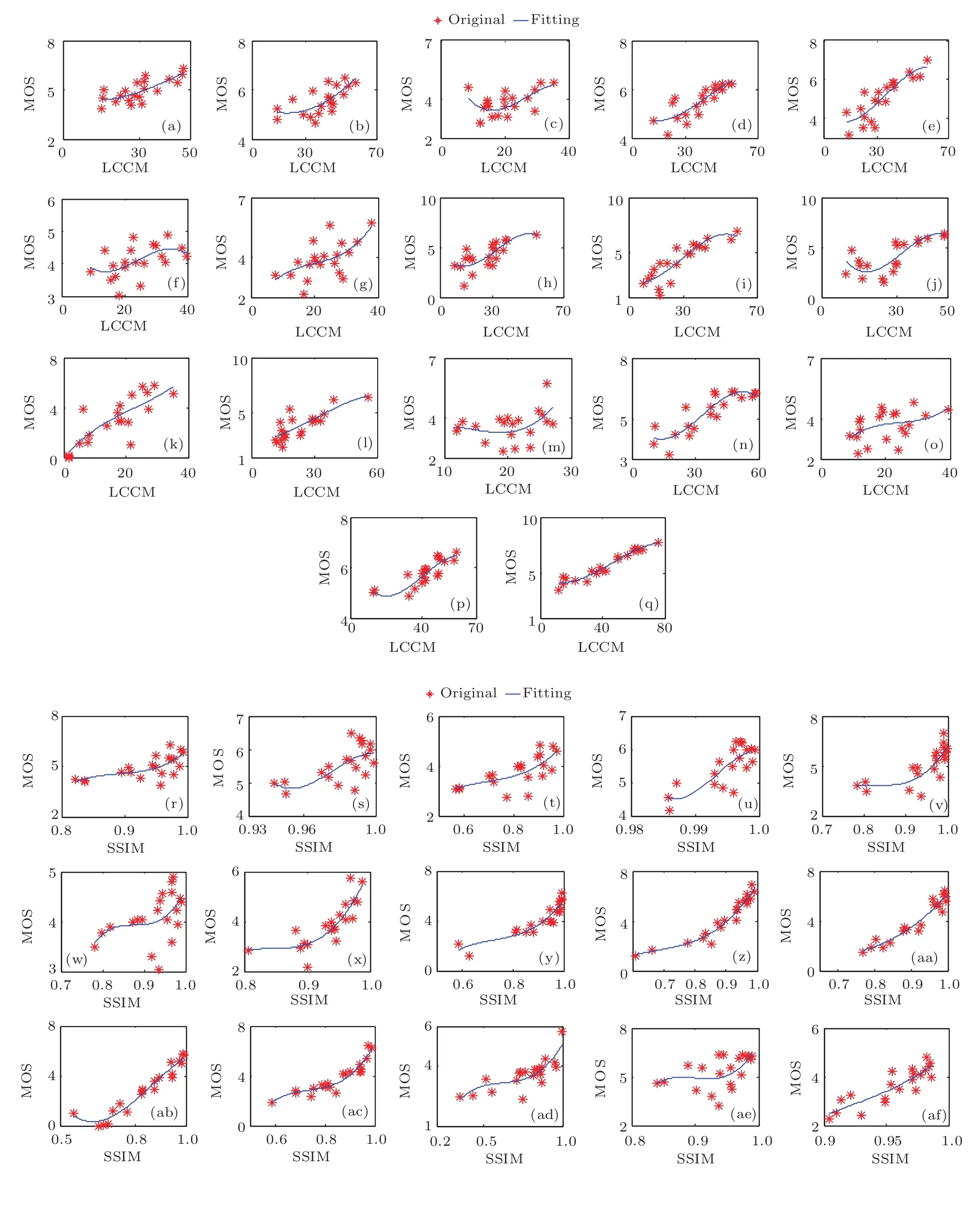

4.2.2 失真類型對質量評價的影響

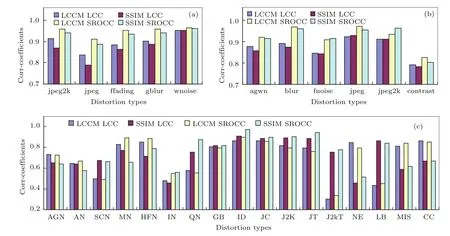

分析每一種類型、不同程度的失真下所有圖像的LCCM評價結果與主觀評價結果的相關性,并與SSIM進行對比分析,探討圖像的失真方式對質量客觀評價準確度的影響.結果如圖11—圖14.其中,圖11—圖13中的橫坐標為采用LCCM或SSIM模型評價三個數據庫中所有類型、不同失真程度的視頻的質量分數,縱坐標為其相應視頻質量主觀評價分數.圖中每一個子圖代表一種失真類型的評價結果,子圖中的曲線為采用最小二乘法擬合的結果.

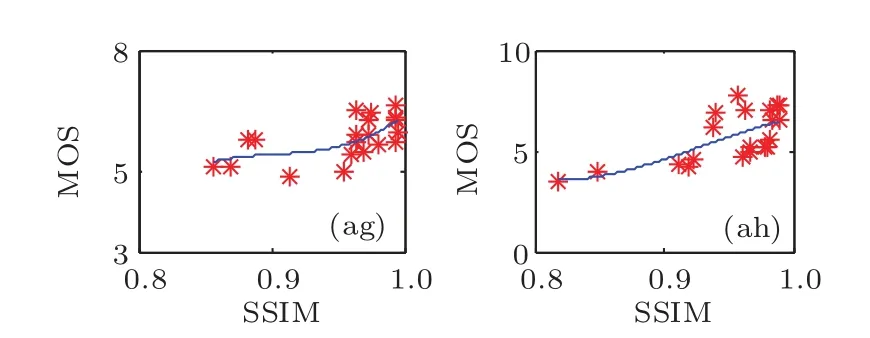

圖11 TID2008數據庫中17種失真類型的圖像分別采用LCCM 和SSIM模型評價的分數與MOS之間的散點圖 (a)AGNLCCM;(b)AN-LCCM;(c)SCN-LCCM;(d)MN-LCCM;(e)HFN-LCCM;(f)IN-LCCM;(g)QN-LCCM;(h)GB-LCCM;(i)ID-LCCM;(j)JC-LCCM;(k)J2K-LCCM;(l)JT-LCCM;(m)J2KT-SSIM;(n)NEPN-SSIM;(o)LBWI-SSIM;(p)MISSSIM;(q)CC-SSIM;(r)AGN-SSIM;(s)AN-SSIM;(t)SCN-SSIM;(u)MN-SSIM;(v)HFN-SSIM;(w)IN-SSIM;(x)QNSSIM;(y)GB-SSIM;(z)ID-SSIM;(aa)JC-SSIM;(ab)J2K-SSIM;(ac)JT-SSIM;(ad)J2 KT-SSIM;(ae)NEPN-SSIM;(af)LBWI-SSIM;(ag)MIS-SSIM;(ah)CC-SSIMFig.11.Scatter plots between the MOS and the objective evaluation scores obtained by evaluating the images with 17 distortions using the LCCM and SSIM models in TID2008 database:(a)AGN-LCCM;(b)AN-LCCM;(c)SCN-LCCM;(d)MN-LCCM;(e)HFN-LCCM;(f)IN-LCCM;(g)QN-LCCM;(h)GB-LCCM;(i)ID-LCCM;(j)JC-LCCM;(k)J2KLCCM;(l)JT-LCCM;(m)J2KT-SSIM;(n)NEPN-SSIM;(o)LBWI-SSIM;(p)MIS-SSIM;(q)CC-SSIM;(r)AGN-SSIM;(s)AN-SSIM;(t)SCN-SSIM;(u)MN-SSIM;(v)HFN-SSIM;(w)IN-SSIM;(x)QN-SSIM;(y)GB-SSIM;(z)ID-SSIM;(aa)JC-SSIM;(ab)J2K-SSIM;(ac)JT-SSIM;(ad)J2KT-SSIM;(ae)NEPN-SSIM;(af)LBWI-SSIM;(ag)MIS-SSIM;(ah)CC-SSIM.

圖12 LIVE數據庫中5種失真類型的圖像分別采用LCCM和SSIM模型評價的分數與DMOS之間的散點圖 (a)jpeg2k-LCCM;(b)fastfading-LCCM;(c)Gaussianblur-LCCM;(d)jpeg-LCCM;(e)whitenoise-LCCM;(f)jpeg2k-SSIM;(g)fastfading-SSIM;(h)Gaussianblur-SSIM;(i)jpeg-SSIM;(j)whitenoise-SSIMFig.12.Scatter plots between the DMOS and the objective evaluation scores obtained by evaluating images with 5 distortions using the LCCM and SSIM models in LIVE database:(a)jpeg2k-LCCM;(b)fastfading-LCCM;(c)Gaussianblur-LCCM;(d)jpeg-LCCM;(e)whitenoise-LCCM;(f)jpeg2k-SSIM;(g)fastfading-SSIM;(h)Gaussianblur-SSIM;(i)jpeg-SSIM;(j)whitenoise-SSIM.

基于散點圖的離散程度和擬合曲線的單調性,對比分析圖11—圖13中各種不同類型失真下的圖像質量評價結果的散點圖,并結合圖14中計算的相關性參數值,可以發現:LCCM對由AGN,MN,NEPN,HFN,MIS,CC類型失真的圖像的質量評價分數與主觀評價分數的相關性明顯高于SSIM的;而對由SCN,QN,JTE,J2 KTE,LBWD類型失真的圖像的評價結果與主觀評價結果的一致性低于或接近于SSIM評價結果的一致性.

結合不同失真類型的特征和人眼感知特性,分析其原因主要為:1)AGN等6種類型的失真均是對圖像每個小區域進行了相近程度的失真,圖像中不會出現局部對比度明顯變化,因此,圖像存在較多的視覺冗余,人眼能夠感知到的失真量上限仍比較大,從而給SSIM等模型的評價結果帶來了較大的誤差;而LCCM模型結合了人眼對比敏感度特性,較好地克服了由此給質量評價帶來的誤差,從而提高了評價精度;反之,SCN等5種失真對圖像局部破壞較大,致使圖像局部對比度改變明顯,人眼對其失真非常敏感,圖像的失真量均能被較好地感知,主客觀評價分數已經達到了各自的最佳精度,一致性很難再得到提升;2)人眼對色度的敏感程度低于對亮度的敏感程度,當顏色有較小的失真時,人眼不能感知或敏感度較低,從而也成為評價一致性較差的原因之一.

圖13 CSIQ數據庫中6種失真類型的圖像分別采用LCCM和SSIM模型評價的分數與DMOS之間的散點圖 (a)agwn-LCCM;(b)blur-LCCM;(c)fnoise-LCCM;(d)jpeg-LCCM;(e)jpeg2k-LCCM;(f)contrast-LCCM;(g)agwn-SSIM;(h)blur-SSIM;(i)fnoise-SSIM;(j)jpeg-SSIM;(k)jpeg2k-SSIM;(l)contrast-SSIMFig.13.Scatter plots between the DMOS and the objective evaluation scores obtained by evaluating images with 6 distortions using the LCCM and SSIM models in CSIQ database:(a)agwn-LCCM;(b)blur-LCCM;(c)fnoise-LCCM;(d)jpeg-LCCM;(e)jpeg2k-LCCM;(f)contrast-LCCM;(g)agwn-SSIM;(h)blur-SSIM;(i)fnoise-SSIM;(j)jpeg-SSIM;(k)jpeg2k-SSIM;(l)contrast-SSIM.

圖14 三個數據庫中的圖像經過每種類型的失真后分別采用LCCM和SSIM評價的結果與主觀評價結果之間相關性的對比 (a)LIVE;(b)CSIQ;(c)TID2008Fig.14.Comparing LCC and SROCC between the subjective evaluation scores and the objective evaluation scores obtained using the LCCM and SSIM models to evaluate the images processed with every type of distortion in LIVE,TID2008 and CSIQ database:(a)LIVE;(b)CSIQ;(c)TID2008.

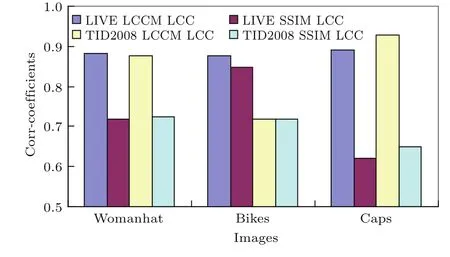

另外,提出的LCCM評價方法還能較好地避免因為拍攝焦點的不同而對質量評價結果帶來的影響.在拍攝圖像時,對于同一景物,焦點不同,圖像的表現效果不同,則其質量評價的結果不同.提出的質量評價算法由于采用8 pixels×8 pixels大小的子塊的評價結果的平均值,即每次評價主要聚焦的是圖像中一個非常小的部分,從而能夠較好地避免因為拍攝時焦點不同而帶來的影響.為了驗證所提評價方法的有效性,對LIVE和TID2008數據庫中同一景物但不同的拍攝焦點的3幅圖像(LIVE庫中的I05,I07,I12與TID2008庫中I03,I04,I05是同一景物,但拍攝的焦點不同)進行計算,得出LCCM值和SSIM值,并與其數據庫中提供的MOS值進行對比分析,計算得出線性相關性系數,結果如圖15.

圖15 采用LCCM和SSIM模型對3幅不同拍攝焦點的圖像的質量評價結果Fig.15.Quality evaluation of three images focused differently using the LCCM and SSIM models.

從圖15中可以看到:對于3幅圖像,采用LCCM方法評價得出的結果與主觀評價分數的相關性比SSIM方法評價的相關性明顯偏高.

5 結 論

結合人眼空間感知特性和圖像的復雜性特征,提出了一種基于人眼對圖像內容感知的圖像質量客觀評價方法.該方法首先結合人眼對亮度感知的非線性、掩蔽特性和對比度敏感特性,構建了一種圖像內容感知模型;再以此模型分別模擬人眼感知源圖像和失真圖像,并計算其強度差;最后基于強度差構建圖像質量客觀評價模型.采用LIVE,TID2008和CSIQ三個數據庫中的共47幅參考圖像和1549幅測試圖像進行仿真實驗,并與SSIM,PSNRHVS和VSNR等典型的圖像質量客觀評價模型進行對比分析.結果表明:所提方法的評價分數與主觀評價分數的Pearson線性相關性系數和Spearman秩相關系數值比SSIM的評價結果均有一定程度的提高,提高幅度分別平均為9.5402%和3.2852%,比PSNRHVS和VSNR提高幅度更大.表明在圖像質量客觀評價中,考慮人眼對圖像內容的感知和復雜度的分析有助于提高圖像質量主客觀評價的一致性,評價精度可得到進一步的提高.

[1]Wang Y Q 2014J.Nanjing Univ.(Nat.Sci.Ed.)50 361(in Chinese)[王元慶2014南京大學學報(自然科學版)50 361]

[2]Zhuang J Y,Chen Q,He W J,Mao T Y 2016Acta Phys.Sin.65 040501(in Chinese)[莊佳衍,陳錢,何偉基,冒添逸2016物理學報65 040501]

[3]Wang Z,Bovik A C,Sheikh H R,Simoncelli E P 2004IEEE Trans.Image Process.13 600

[4]Chandler D M,Hemami S S 2007IEEE Trans.Image Process.16 2284

[5]Zhang L,Zhang L,Mou X,Zhang D 2011IEEE Trans.Image Process.20 2378

[6]Xue W,Zhang L,Mou X,Bovik A C 2014IEEE Trans.Image Process.23 684

[7]Zhang L,Shen Y,Li H 2014IEEE Trans.Image Process.23 4270

[8]Paudyal P,Battisti F,Sj?str?m M,Olsson R,Carli M 2017IEEE Trans.Broadcast.63 507

[9]Bae S H,Kim M 2016IEEE Trans.Image Process.25 2392.

[10]Gu K,Wang S,Zhai G,Ma S,Yang X 2016Signal Image Video Process.10 803

[11]Wang X L,Wu D W,Li X,Zhu H N,Chen K,Fang G 2017Acta Phys.Sin.66 230302(in Chinese)[王湘林,吳德偉,李響,朱浩男,陳坤,方冠2017物理學報66 230302]

[12]Akamine W Y L,Farias M C Q 2014J.Electron.Imaging23 061107

[13]Li C F,Bovik A C 2010J.Electron.Imaging19 143

[14]Guo J,Hu G,Xu W,Huang L 2017J.Vis.Commun.Image Represent.43 50

[15]Hou W,Mei F H,Chen G J,Deng X W 2015Acta Phys.Sin.64 024202(in Chinese)[侯旺,梅風華,陳國軍,鄧喜文2015物理學報64 024202]

[16]Stephen W,Huw O,Vien C,Iain P S 2006Color Res.Appl.31 315

[17]Nadenau M 2000Ph.D.Dissertation(Lausanne:école Polytechnique Fédérale de Lausanne)

[18]Yao J C,Shen J,Wang J H 2008Acta Phys.Sin.57 4034(in Chinese)[姚軍財,申靜,王劍華 2008物理學報57 4034]

[19]Sheikh H R,Wang Z,Cormack L LIVE Image Quality Assessment Database Release 2 http://live.ece.utexas.edu/research/quality[2017-12-17]

[20]Sheikh H R,Sabir M F,Bovik A C 2006IEEE Trans.Image Process.15 3440

[21]Nikolay N P Tampere Image Database 2008 TID2008,version 1.0 http://www.ponomarenko.info/tid2008.htm[2017-12-17]

[22]Nikolay P,Vladimir L,Alexander Z,Karen E,Jaakko A,Marco C,Federica B 2009Adv.Modern Radioelectron.10 30

[23]Larson E C The CSIQ image database http://vision.okstate.edu/?loc=csiq[2017-12-17]

[24]Larson E C,Chandler D M 2010J.Electron.Imaging19 011006

[25]Zhang F,Bull D R 2013Proceedings of the 20th IEEE Interatinonal Conference on Image Processing(ICIP)Melbourne,Australia,September 15–18,2013 p39

[26]Gu K,Wang S,Zhai G,Lin W,Yang X,Zhang W 2016IEEE Trans.Image Process.62 446