輪廓定位下的人頭NSCT特征提取方法

孫萬春,張建勛,馬 慧,朱佳寶

(1.重慶理工大學(xué) 計(jì)算機(jī)科學(xué)與工程學(xué)院, 重慶 400054;2.安徽警官職業(yè)學(xué)院 計(jì)算機(jī)基礎(chǔ)教研室, 合肥 230031)

隨著商場及公共場所設(shè)施的逐步完善,在各類超市、電影院、室外休息場所都需要進(jìn)行人員流動(dòng)信息的采集。依靠采集到的信息[1]不僅能得到不同區(qū)域的消費(fèi)者消費(fèi)情況、客戶偏好、廣告需求定位等信息,更能有效地預(yù)防因?yàn)槿肆髅芏冗^大造成的安全事故的發(fā)生。鑒于此,提高和改善實(shí)際場景中人數(shù)統(tǒng)計(jì)工作一直是學(xué)者關(guān)注的熱點(diǎn)。隨著計(jì)算機(jī)視覺研究的不斷發(fā)展,很多學(xué)者針對人頭檢測提出了各類優(yōu)化方法,但是如何在不同的場所下提高人頭識別率仍然是其中核心問題。目前人頭檢測的數(shù)據(jù)源絕大多數(shù)來自于監(jiān)控設(shè)備,其提供的視頻信息經(jīng)常會出現(xiàn)分辨率較低、目標(biāo)重疊、有外界光線干擾等問題,這對檢測造成了極大的影響。

夏菁菁等[2]利用形態(tài)學(xué)的方法提出了一種基于人體骨架特征的人數(shù)統(tǒng)計(jì)方法,但是該方法對于目標(biāo)遮擋嚴(yán)重以及人流量較大的場景,不僅不能提取較完整的人體骨架特征,而且運(yùn)算效率較低,滿足不了實(shí)際場景需求。趙軍偉等[3]為了在實(shí)際應(yīng)用場景中能實(shí)時(shí)統(tǒng)計(jì)人數(shù),針對人頭顏色的專一性建立了相關(guān)的空間模型,利用人頭輪廓具有幾何特征的綜合特性來提高實(shí)時(shí)性要求,但是該方法對建立的空間顏色模型依賴性較大,不同區(qū)域的差異較大,準(zhǔn)確率有待提高。何揚(yáng)名等[4]在硬件上進(jìn)行了改進(jìn),采用雙目攝像頭,先通過左視圖進(jìn)行人頭區(qū)域的檢測,再利用右視圖進(jìn)行匹配,以此解決人頭識別率的問題。該方法硬件成本要求相對較高,并不適合任何場景,并且在發(fā)生人頭遮擋以及人頭分辨率較低等情況下并不是有效的解決方法。

目前,人數(shù)統(tǒng)計(jì)工作均基于監(jiān)控視頻[5],但在采集過程中經(jīng)常會受到各種外界環(huán)境的影響,并且為了能盡量保存較為完整的視頻數(shù)據(jù),會對視頻數(shù)據(jù)信息進(jìn)行了有損壓縮,致使圖像中的信息大量丟失,給人頭特征的提取帶來了較大的困難。

本文提出了輪廓定位下的人頭特征提取方法。首先利用人頭輪廓具有類橢圓共性,采用輪廓快速定位人頭區(qū)域,再對定位區(qū)域進(jìn)行擬合采樣,最后利用NSCT進(jìn)行人頭特征提取。該方法不僅可以在不變動(dòng)目前市場上攝像頭位置情況下達(dá)到檢測的要求,同時(shí)也能解決僅僅通過某種單一特征方法進(jìn)行人頭識別而造成效果不理想的問題。實(shí)驗(yàn)證明:本方法能有效提高人頭檢測準(zhǔn)確率,尤其在一些視頻源效果較差的場景中表現(xiàn)較好。

1 基于NSCT的人頭特征提取

1.1 Contourlet變換

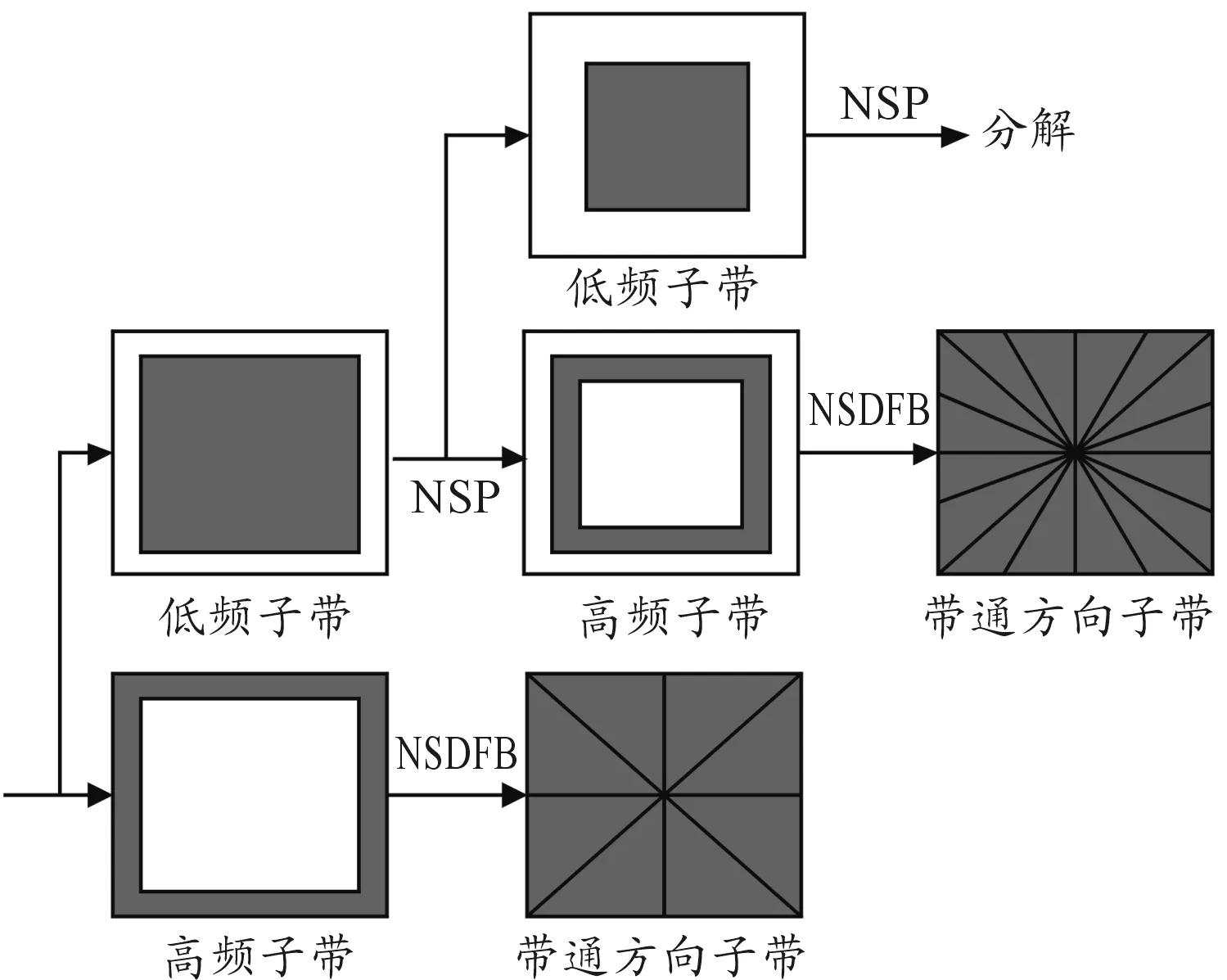

Do等在2002年提出了Contourlet變換,其在小波變換所具有的較好稀疏性能優(yōu)點(diǎn)的基礎(chǔ)上,利用離散域?yàn)V波器組達(dá)到了最優(yōu)化、最有效的圖像表達(dá)。這樣,在對圖像進(jìn)行頻譜分析的過程中,其不僅在不同尺度和方向上具有各向異性尺度關(guān)系[6],同時(shí)能更準(zhǔn)確地將圖像中邊緣等幾何結(jié)構(gòu)信息分解到各個(gè)尺度上的帶通方向子帶中去,圖1是其通過兩級實(shí)現(xiàn)各方向子帶信息變換的結(jié)構(gòu)。

圖1 CT變換結(jié)構(gòu)

圖1中,Contourlet變換[7]主要通過濾波器組來實(shí)現(xiàn)多尺度、多方向的變換。其中,又包含了拉普拉斯金字塔(laplacian pyramid,LP)和方向?yàn)V波器組(directional filter bank,DFB)兩部分。首先利用LP來完成多尺度方向的變換;其次通過LP分解的低頻采樣信息和上一級的信號的低通采樣進(jìn)行差值化得出一個(gè)帶通分量;最后Contourlet變換通過迭代的分解求差,將圖像中具有多尺度、多方向的信息進(jìn)行了靈活的結(jié)合。由此可見,該方法在圖像稀疏表達(dá)上效果較好。

1.2 非下采樣Contourlet變換

其中: ij表示通過NSCT分解的第j個(gè)尺度方向上的低頻子帶信息; dj,k表示其在第k個(gè)方向的子帶信息。

圖2 NSCT分解框架圖

NSCT分解變換能有效提取樣本數(shù)據(jù)信息中人頭的特征信息,因?yàn)槠湓诙喑叨确较蚓哂械奶匦阅芨玫靥崛∵吘墶⑤喞燃?xì)節(jié)特征。對于人頭樣本圖像首先進(jìn)行多層分解,本文采用3層分解方式進(jìn)行。通過式(1) 推理可知,總共會得到8個(gè)不同方向的分解結(jié)果。

圖3是對國際公開的FERET數(shù)據(jù)集中提取的一幅圖像進(jìn)行了3層分解后得到的各方向、尺度下的人頭分解子圖。

圖3 NSCT3層分解效果

1.3 幀間差分法下的人頭目標(biāo)分割

幀間差分法[10]對光線等外界因素變化不敏感,在人群大量集中的動(dòng)態(tài)環(huán)境下,能夠有助于快速檢測出運(yùn)動(dòng)目標(biāo)區(qū)域。具體實(shí)現(xiàn)方法如下:

式(2)中f( )表示圖像二值化函數(shù),t時(shí)刻坐標(biāo)點(diǎn)(x,y)的二值化表示為f(x,y,t),二值化閾值是T,其一般取經(jīng)驗(yàn)常數(shù),Dt,t-1(x,y,t)表示通過當(dāng)前幀f(x,y,t)與前一幀f(x,y,t-1)進(jìn)行差分計(jì)算后得到的二值化目標(biāo)區(qū)域。圖4為當(dāng)前幀(t時(shí)刻)與前一幀(t-1時(shí)刻)通過幀差法所得到的目標(biāo)區(qū)域。

圖4 目標(biāo)分割

1.4 目標(biāo)區(qū)域人頭輪廓定位

人頭區(qū)域具有一定的輪廓規(guī)律性,對目標(biāo)區(qū)域進(jìn)行輪廓特征判斷就是要快速、初步判斷目標(biāo)區(qū)域是否是人頭,這是關(guān)鍵的一步。因?yàn)槿祟^的外圍輪廓所包圍的面積在一定的約束范圍內(nèi),可根據(jù)經(jīng)驗(yàn)數(shù)據(jù)來篩選、判斷該區(qū)域范圍內(nèi)的人頭區(qū)域,以減少檢測花費(fèi)的時(shí)間。本文算法中用C來表示輪廓[11],即:

式(3)中:P代表人頭外圍輪廓區(qū)域周長;輪廓區(qū)域面積用A來表示。因?yàn)樵趯W(xué)術(shù)界并沒有像素點(diǎn)區(qū)域距離定義的規(guī)則標(biāo)準(zhǔn)時(shí),本文定義相鄰像素點(diǎn)之間的距離用單元1來表示,故目標(biāo)輪廓的周長P即為像素點(diǎn)數(shù)目。

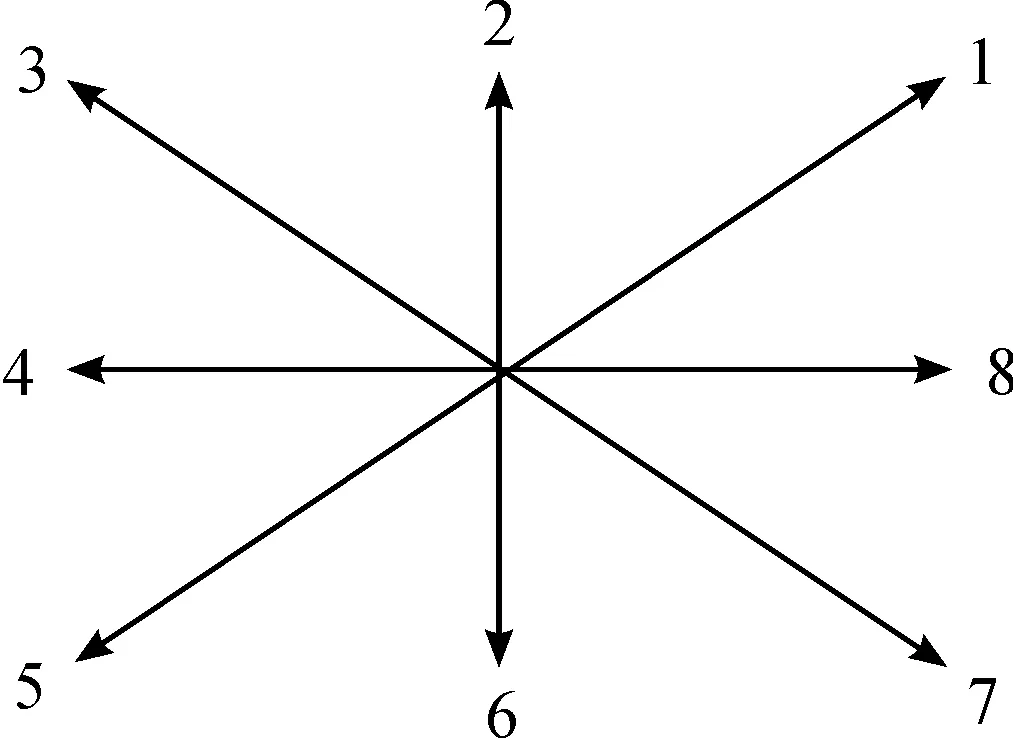

在對目標(biāo)輪廓面積A進(jìn)行計(jì)算時(shí),采用類似八方向碼來進(jìn)行邊界跟蹤,其改進(jìn)方式是對原八方向碼0用8來進(jìn)行代替,其余不變,1~8分別表示45°、90°、135°、180°、225°、270°、315°、0°,如圖5所示。

圖5 類八方向跟蹤示意圖

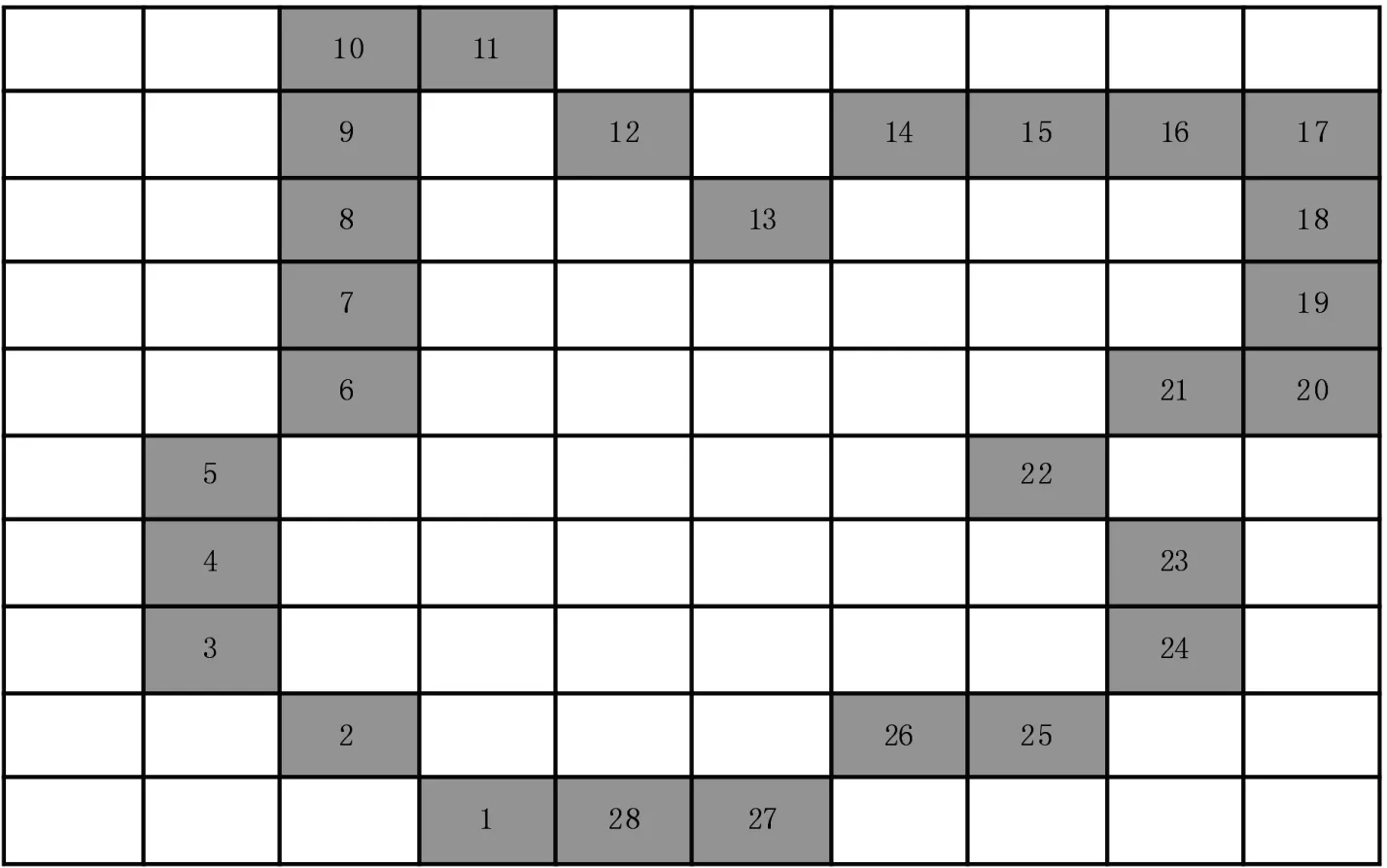

目標(biāo)對象邊緣范圍確定,并對其進(jìn)行提取,如圖6中灰色區(qū)域即為輪廓邊界范圍。

圖6 目標(biāo)定位輪廓邊界范圍

對于邊界的每一個(gè)像素點(diǎn)的坐標(biāo)值定義為Pix[i],其中i表示圖中輪廓邊界第i個(gè)像素點(diǎn),像素點(diǎn)的起始位置為最左下角的輪廓邊界。Pix[i]·x、Pix[i]·y分別表示像素點(diǎn)i在x、y方向的坐標(biāo)值。位置標(biāo)定如圖7所示。

圖7 邊界位置標(biāo)定

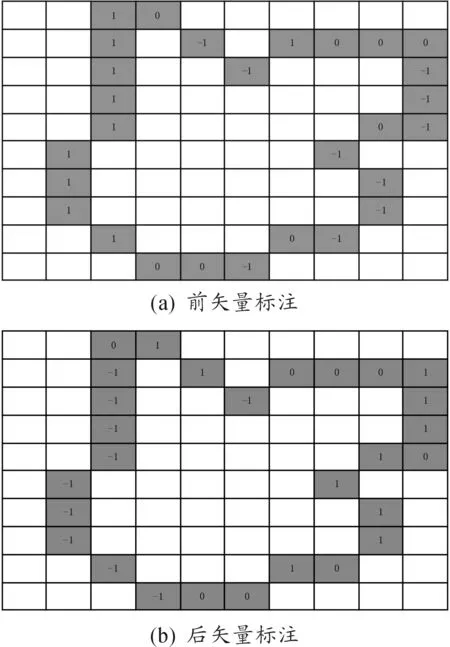

對于每一個(gè)像素點(diǎn)進(jìn)行兩次矢量標(biāo)定:前矢量標(biāo)定和后矢量標(biāo)定,定義如下:

式(4)中:ai表示像素點(diǎn)之間的方向,參考圖5。本文中對兩次標(biāo)定分別定義為SF和SL,其中:SF表示當(dāng)前像素點(diǎn)和前一個(gè)像素點(diǎn)之間的位置關(guān)系,SL則表示當(dāng)前像素點(diǎn)與后一個(gè)像素點(diǎn)之間的位置關(guān)系。SF標(biāo)注定義如下所示:

(5)

SL標(biāo)注定義為:

(6)

其中,當(dāng)i-1=0或者i+1>N時(shí),定義如下:

由式(5)-(7)可分別計(jì)算得到前一像素點(diǎn)和后一像素點(diǎn)矢量標(biāo)注值,計(jì)算結(jié)果如圖8所示。

圖8中兩個(gè)矢量值進(jìn)行求和,計(jì)算結(jié)果見圖9。

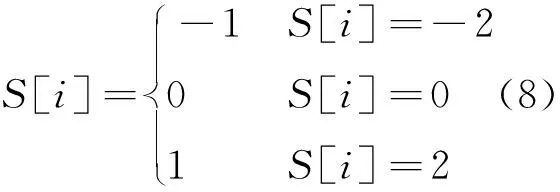

對于圖9,如果S[i]的值不為±1,則按照式(8)進(jìn)行判斷:

圖8 前、后矢量標(biāo)注

圖9 前、后矢量標(biāo)注相加

如果S[i]的值為±1,這里先定義Sx[i]:

假設(shè)S[i]的值為k,那么對于S[i]=±1,判斷如下:

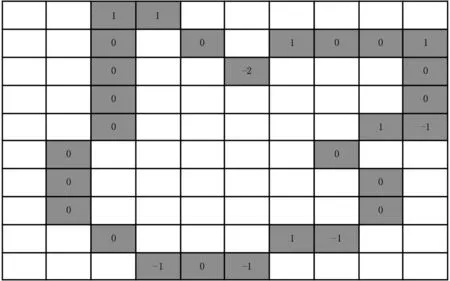

經(jīng)過上述流程計(jì)算的最終結(jié)果如圖10所示。

圖10 最終矢量標(biāo)注

依據(jù)圖10,輪廓區(qū)域面積計(jì)算方法定義如下:

其中:S[i]表示圖10中的結(jié)果;N表示S[i]為1的個(gè)數(shù)。根據(jù)式(3)推知任意一個(gè)圖形的人頭輪廓區(qū)域C的最小值為4π,最大值為:

其中w和h分別表示視頻圖像的像素寬度和高度。由于人頭的輪廓區(qū)域圖像一般不會大于整個(gè)監(jiān)控圖像的1/4,所以本文閾值T應(yīng)滿足:

利用閾值T判斷便可快速進(jìn)行人頭的目標(biāo)快速定位。

1.5 輪廓區(qū)域下的NSCT特征提取

輪廓區(qū)域定位能夠快速定位出可能符合人頭特征形狀的目標(biāo)區(qū)域,但是對于類圓的干擾仍然不能進(jìn)行有效的篩選,如圖11所示。對定位出的目標(biāo)區(qū)域進(jìn)行擬合、采樣至標(biāo)準(zhǔn)庫像素,本文選擇32像素×32像素標(biāo)準(zhǔn)。

圖11 人頭目標(biāo)區(qū)域擬合、采樣

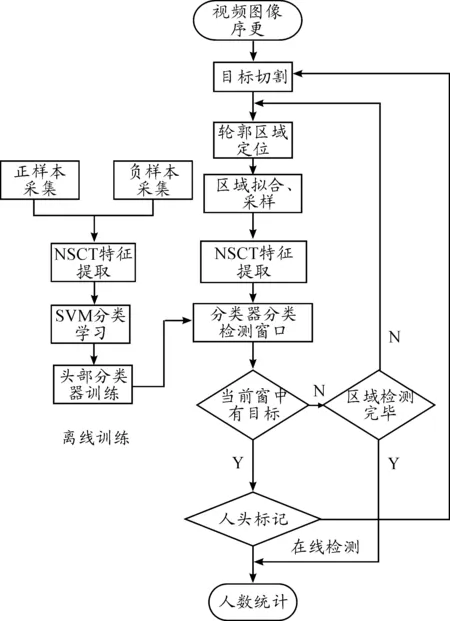

1.6 用支持向量機(jī)對人頭進(jìn)行識別

為了能對提取到的人頭特征進(jìn)行識別,本文采用了支持向量機(jī)下的基于統(tǒng)計(jì)學(xué)理論模型識別方法[12],由一定范圍的觀測樣本值和任意采樣區(qū)間對比得到最優(yōu)值空間,憑借此與其他類樣本之間的差別得到最大泛化,其基本原理:用于計(jì)算的特征參數(shù)經(jīng)過非線性算法轉(zhuǎn)換到一個(gè)多維空間,再通過內(nèi)積函數(shù)構(gòu)造出所需要的最優(yōu)化空間。SVM下人頭特征識別流程如圖12所示。

圖12 人頭識別流程

2 實(shí)驗(yàn)結(jié)果與分析

1) 實(shí)驗(yàn)環(huán)境

DELL Windows 10系統(tǒng),基于VS2012開發(fā)環(huán)境,采用Opencv2.4.13圖像處理庫。Intel i5-3470,3.20GHz,8GB 內(nèi)存空間。

2) 數(shù)據(jù)集

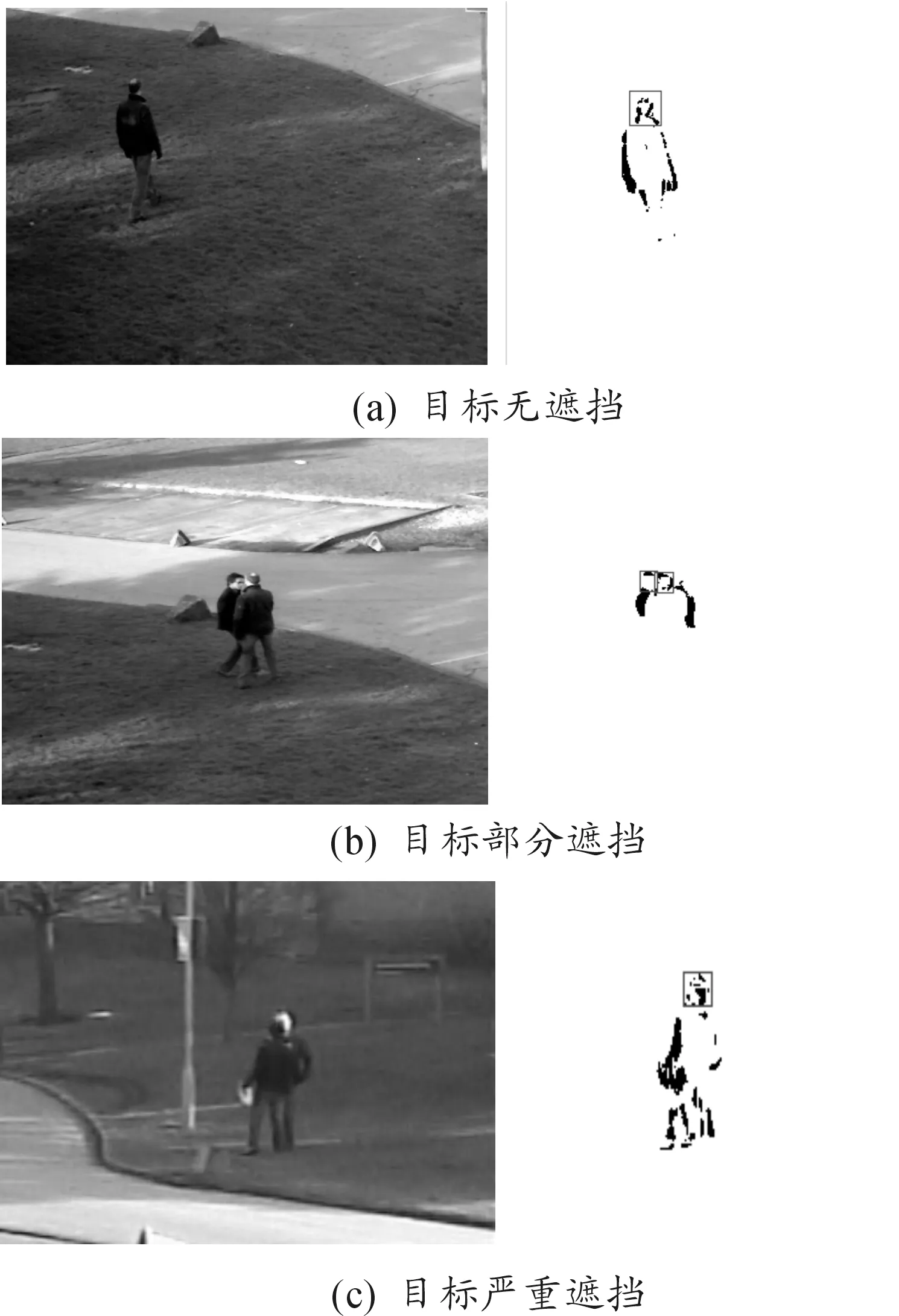

為了驗(yàn)證本文算法的有效性,測試視頻的幀來源于國際上公認(rèn)的數(shù)據(jù)庫PETS2009的Dataset S2:Person Count and Density Estimation。該數(shù)據(jù)庫包含了若干使用單相機(jī)、固定斜向下拍攝的視頻。視頻幀率為7幀/s。本文選用數(shù)據(jù)集S2中的兩段視頻來驗(yàn)證算法的有效性。其中:視頻段1是數(shù)據(jù)集S2里的S2.L3.Time_14-41.View_ 001,共包含240幀圖片,特點(diǎn)是人群正對攝像頭從遠(yuǎn)處不斷靠近攝像頭行走;視頻段2是數(shù)據(jù)集S2里的S2.L3.Time_14-41.View_004,共包含240幀圖片,特點(diǎn)是人群背對攝像頭向教學(xué)樓方向走去,慢慢遠(yuǎn)離攝像頭。實(shí)驗(yàn)結(jié)果如圖13所示。

圖13 人頭識別效果

從圖13可知:單個(gè)人雖然處于遠(yuǎn)視角,但是仍然能較好地進(jìn)行識別;當(dāng)出現(xiàn)兩個(gè)人互相遮擋時(shí),仍然能夠進(jìn)行正確的判斷;在嚴(yán)重遮擋情況下,人頭輪廓出現(xiàn)了重疊,存在一定的檢測誤差。

對PETS中的數(shù)據(jù)集進(jìn)行測試,圖14是現(xiàn)實(shí)中人數(shù)和采用本文算法檢測到的人頭數(shù)對比。

圖15給出了本文提取方法同文獻(xiàn)[2]和文獻(xiàn)[4]兩種特征人頭檢測召回率性能比較結(jié)果。

由圖15可知:在稀疏密度人群下,本文算法在識別率方面取得了較好的效果。另外,本文算法先通過輪廓定位人頭,再利用NSCT特征提取感興趣的區(qū)域,相比文獻(xiàn)[2]和[4],本文方法在視頻監(jiān)控圖像的分辨率較低的場景中人頭檢測的效果更佳。

圖14 實(shí)際人頭與估計(jì)人頭對比

圖15 幾種算法檢測率對比

3 結(jié)束語

本文針對監(jiān)控視頻下的人頭檢測領(lǐng)域,首次將NSCT特征同人頭輪廓進(jìn)行了相融合,發(fā)揮其各自的優(yōu)勢。首先,依據(jù)人頭類橢圓共性,利用輪廓快速進(jìn)行人頭定位,但該方法速度較快,存在較大誤差。為了解決該問題,對定位區(qū)域進(jìn)行擬合、采樣處理。其次,使用NSCT人頭特征提取,對傳統(tǒng)監(jiān)控視頻下的人頭分辨率較低時(shí)識別效果不理想的問題提供了有效的解決方法,即利用NSCT在目標(biāo)區(qū)域細(xì)節(jié)提取上的優(yōu)勢來進(jìn)行特征提取,從而避免了因分辨率較低帶來的信息缺失等問題。最后,用傳統(tǒng)的機(jī)器學(xué)習(xí)分類判斷人頭。實(shí)驗(yàn)證明:本文提出的算法取得比較好的結(jié)果,特別在分辨率低、圖像模糊的視頻中表現(xiàn)不錯(cuò)。但本文算法在人群密度較高場所下的人頭識別率較低,以后的工作中會考慮通過線性回歸模型的人數(shù)統(tǒng)計(jì)方法來解決該類問題。

重慶理工大學(xué)學(xué)報(bào)(自然科學(xué))2018年7期

重慶理工大學(xué)學(xué)報(bào)(自然科學(xué))2018年7期

- 重慶理工大學(xué)學(xué)報(bào)(自然科學(xué))的其它文章

- 農(nóng)業(yè)投資效率的評價(jià)及制約因素研究

——基于DEA方法和面板數(shù)據(jù)模型 - 基于節(jié)點(diǎn)影響力的標(biāo)簽傳播社區(qū)檢測算法

- GA-BP神經(jīng)網(wǎng)絡(luò)預(yù)測大學(xué)生體質(zhì)的模型構(gòu)建研究

- 間充質(zhì)干細(xì)胞干性維持及多向分化相關(guān)LncRNA的研究進(jìn)展

- 經(jīng)陰道剖宮產(chǎn)瘢痕妊娠病灶切除術(shù)的臨床研究

- 基于SP調(diào)查的地鐵與常規(guī)公交票價(jià)關(guān)系對客流的影響研究