蘭亭流觴故事何從覓

蘭亭流觴故事何從覓

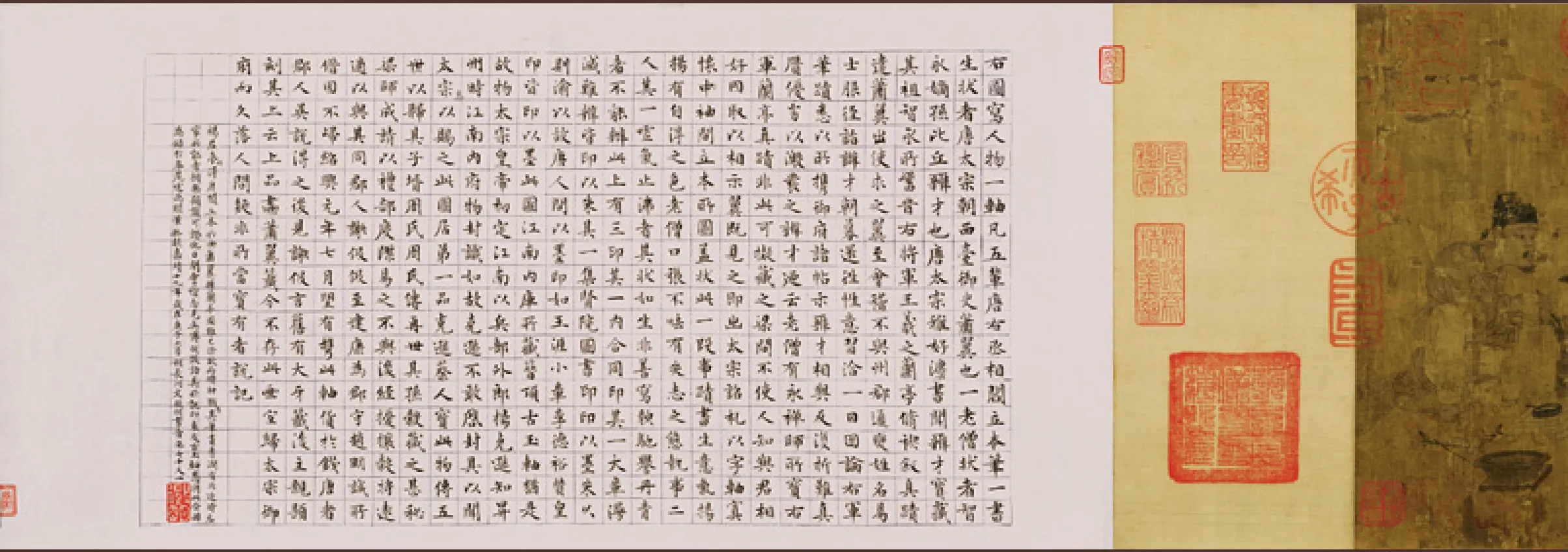

蘭亭修禊圖(局部)

金箋設色 24.2×60cm 文徵明 故宮博物院藏

明清時期,吳門畫派在以“蘭亭雅集”為題材的繪畫創作中首屈一指。文徵明這幅《蘭亭修禊圖》就是其中的杰出代表。整幅畫作林竹豐茂,山谷間有曲水流觴,亭榭內3人圍桌而坐,另有8雅士沿河兩岸席地而坐。山石林木先勾勒,再皴染著色,筆墨蒼秀含蓄,設色典雅清新。文徵明之友曾潛自號“蘭亭”,文徵明將這一題材入畫,并為之題詩,饋贈友朋,頗具深意。

公元353年的一個暮春時節,以王羲之為首的一群東晉名士,雅集于江南名勝之地會稽山陰的蘭亭。這一天正值農歷三月初三,名士們在延續古老的祓除儀式以蕩滌身心,曲水流觴則是儀式的核心所在。在王羲之的眼中,盛著瓊漿的羽觴隨清澈的流水蜿蜒而至,俯仰之間,天地已然不同:又有清流激湍,映帶左右,引以為流觴曲水,列坐其次。雖無絲竹管弦之盛,一觴一詠,亦足以暢敘幽情。是日也,天朗氣清,惠風和暢,仰觀宇宙之大,俯察品類之盛,所以游目騁懷,足以極視聽之娛,信可樂也。

然而,春天的流水和美酒帶給人們的并不僅僅是歡娛,還有比歡娛更值得深思的東西:人們彼此親密交往,俯仰之間便度過一生。人們遇到可喜的事情,就會忘記衰老即將到來。等到對已獲取的東西開始厭倦,世事已變,以往所得到的一切,很快又會成為過往的陳跡。人一生的長短取決于造化,而終究歸結于窮盡。后人怎樣看待今人,就像今人如何看待前人一樣,生命就在這樣的周而復始中茁壯或毀滅。

1661年前的上巳節,于蘭亭,這群東晉名士將中國人骨子里對宇宙、自然與生命的悲劇性認識推向了極致。這種魏晉風度或風骨有著驚人的吸引力和感召力。尤其是當我們展開王羲之那不可方物的《蘭亭序》書卷時,凝睇那絕世的鋒芒與婉轉,詩意、書境、曲水、流觴、天地、生死……時間似乎在那一瞬靜止了。

《蘭亭序》使得蘭亭修禊成為東晉名士風流最富文學意義的一次雅集,受到歷代文人的推崇和描繪。美文妙筆的《蘭亭序》不僅對后世書法藝術的發展產生了巨大影響,而且使后人在蘭亭文化熏陶和傳播之中得到美的享受,并產生無限的遐想。特別是《蘭亭序》在歲月更迭中顯露于世的故事,序文中令人向往的魏晉風度,嫻雅幽淡的理想境界及“書圣”王羲之的典故,都成為隋唐以來眾多畫家競相創作的繪畫題材。

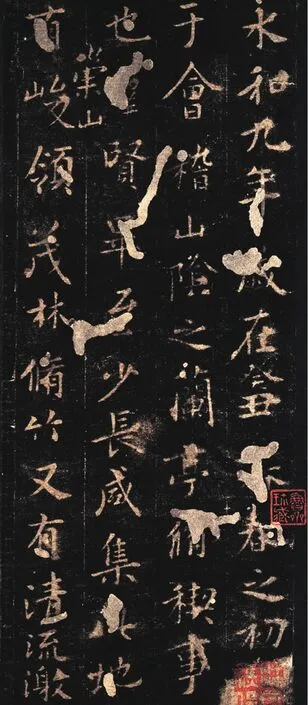

行書蘭亭詩蘭亭八柱第四(局部)

絹本 26.5×365.3cm

柳公權 故宮博物院藏

柳公權的書法初學王羲之,后遍觀唐代名家書法,認為顏真卿、歐陽詢的字最好,吸取二者之長,在晉人勁媚和顏書雍容雄渾之間,形成了自己的柳體,以骨力勁健見長,后世有“顏筋柳骨”的美譽。他的這幅蘭亭行書體現出其典型的書法特色,包括明代董其昌在內的很多名家都曾留下其摹本。

蘭亭繪畫,從最早傳為唐閻立本的《蕭翼賺蘭亭圖》至明清各種《蘭亭修禊圖》等,具有千余年的歷史。蘭亭是傳統文化的一個重要組成部分,也成為中國繪畫的重要題材。

以流觴故事為藍本的蘭亭繪畫,把如何表達或蘊涵傳統風度作為出發點。除了注重繪畫的題材和技法,更注重文明根基,尤其是作品所傳達出的內在意志和藝術家所賦予的古典骨氣。這使我們很容易想起初唐大詩人陳子昂,他說漢魏風骨到他那個時代已消失500年了,他實在是渴望那剛健質樸而又風流蘊藉的美學再次呈現:骨氣端翔,音情頓挫,光英朗練,有金石聲。

“后之視今,亦猶今之視昔……雖世殊事異,所以興懷,其致一也。”斗轉星移,時代變遷,形骸易朽,但有些東西循寰宇之道卻可以永世長存。正是如此,王羲之微醺之下的《蘭亭序》及逐其蹤跡的蘭亭繪畫,才得以流傳不衰。而琳瑯滿目的蘭亭雅集繪畫,讓后人有幸在千年之后,仍可追慕當年蘭亭修禊的文化盛事。

↑蕭翼賺蘭亭圖

絹本設色 28×65cm

宋摹本 遼寧省博物館藏

《蕭翼賺蘭亭圖》是初唐畫家閻立本根據何延之《蘭亭記》故事所作。描繪唐太宗御史蕭翼從王羲之第七代傳人的弟子袁辯才的手中將“天下第一行書”《蘭亭序》騙取到手獻給唐太宗的故事。畫的是蕭翼向袁辯才索畫,蕭翼洋洋得意,老和尚辯才張口結舌,失神落魄,旁有二仆在茶爐上備茶,各個人物的表情刻畫入微。該畫問世后曾多次被臨摹,其中宋摹本較為著名。

從左至右依次為:唐馮承素摹《蘭亭序》(局部),明文徵明臨《蘭亭序》(局部),明王鐸臨《蘭亭序》(局部)。人們臨習書法,從最初的臨寫《蘭亭序》,到自己創作,雖已面目全非,卻文化相襲。

蘭亭集賢圖

絹本長卷 27×375cm 錢選 美國大都會博物院藏

元錢選以白描的手法,在人物之間穿插了山石林木的布局,頗具匠心。畫中人物姿態各異,觀摩名畫者有之,促膝雅談者有之,甚至還表現了數人凝眉書寫作畫的形象。

蘭亭序圖(局部)

紙本設色 26.7×416cm 祝允明 遼寧省博物館藏

一幅《蘭亭序》引出一段蘭亭雅事,不同時代的畫家畫了幾乎相同的作品,借以抒發追懷古人、心傾自由的心境。幾乎相同的作品又收藏在了不同的幾大博物館,這不得不說是蘭亭文化留予文人與后世的一種奇妙緣分。

蘭亭修禊圖

絹本設色 43×43cm

李龍眠

作品以細筆小青綠畫法,表現樹木蔥郁、修竹傍水的春日美景以及文人雅士曲水流觴、修禊祈福的節日盛況。畫中層巒幽澗,茂林修竹,環境清雅,樹木、建筑、人物刻畫皆極精工,全圖于絢爛精微之中不失淡雅之致。

宋拓定武本蘭亭全卷

紙本 35×270cm

碑拓是印刷術發明之前的一種獨特的文獻保留形式。《蘭亭序》作為書法第一名帖,拓本眾多,豐富的碑帖版本讓《蘭亭序》不再只是那一紙一幅。蘭亭之所以成為蘭亭文化,恐怕碑帖的貢獻功不可沒。

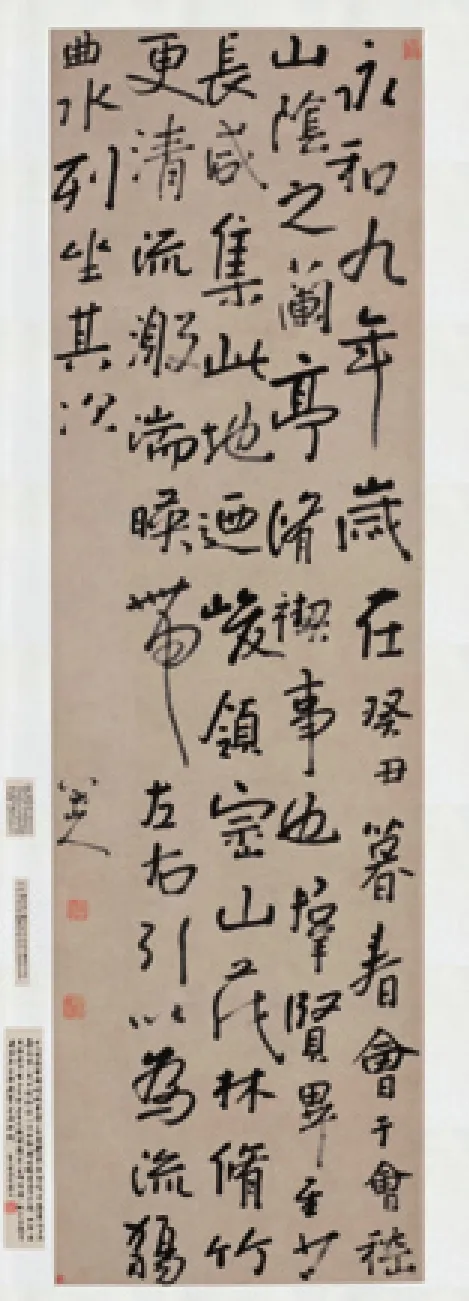

清八大山人臨《蘭亭序》

紙本 89×32cm

八大山人經歷明清之際天翻地覆的變化,自皇室貴胄淪為草野逸民,為避害而出家。其書法成就頗高,但被畫名所掩,注目者不多。他的書體以篆書的圓潤等線體施于行草,自然起截,了無藏頭護尾之態,以一種高超的手法,把書法的落、起、走、住、疊、圍、回蘊藏其中而不著痕跡。八大山人臨寫的這幅作品充分展現了他的書法特點,藏巧于拙,筆澀生樸,其書法中的真性情與恣肆之意也與蘭亭修禊的內在精神不謀而合。

溪堂詩思圖(局部)105.9×59.8cm 王翚 故宮博物院藏