基于改進的BCO算法的顯著性檢測

錢廣秀 徐亞超

摘要:本文在現有模型的基礎上,提出一種基于圖像顏色特征和圖像中物體特征的顯著性檢測算法CO(色差感受度和物體度分別用C,O來表示)。在原CO模型基礎上,我們增加了模糊感受度的概念,形成新的顯著性檢測模型BCO(參數模糊為B),關注區域的增加更完善了我們針對圖像前景和背景部分不同顯著度的標量,而且對于部分色差感受度誤以為是背景的像素具有糾正作用。通過實驗證明具有很好的可行性和有效性。

關鍵詞:顯著性檢測;色差感受度;物體度;CO;BCO。

0 引言

日益發展的機器視覺技術讓我們享受到信息時代的高速與便捷,而機器視覺研究的基礎在于對圖像的處理,如何高效的提取圖片中的有用信息是機器視覺的重點研究課題之一。本文在現有模型的基礎上,提出了基于人眼感受度和圖像物體度的顯著性檢測模型。人眼感受度在本文中指的是色差感受度和模糊感受度兩種因素。其中色差感受度的計算是在Lab顏色空間,使用SLIC算法將圖像分成許多超像素塊,建立馬爾科夫隨機游走圖模型,分別選定背景節點和前景節點為吸收態,計算相應狀態下的馬爾科夫吸收概率,用超像素塊之間的顏色特征相似度作為衡量其顯著性的依據。具體思路是先對圖像進行色差感受度和模糊感受度的運算;然后通過色差感受度的計算我們大體上估計出整幅圖像的前景和背景區域;最后通過模糊度的運算我們得到圖像上最容易受到視覺關注的區域。二者結合,就可以得到一個更加符合人的視覺關注特征的顯著圖像。

1 算法介紹

CO算法:

該模型的主要思想是首先計算整體圖像的顏色獨特度和物體度,色差的計算可以使圖像的顏色顯著部分更加突出,物體度會將關注度集中到畫面中的物體上,這種模型的思想完全符合人類的視覺注意機制,先是整體,而后是局部特征突出的部分,最終得出圖像的顯著性圖片。

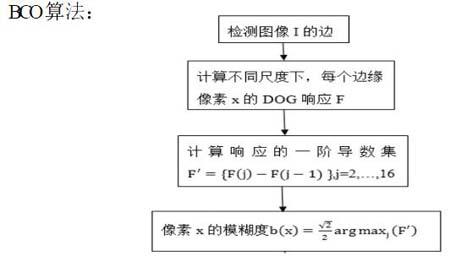

BCO算法:

至此,我們又獲得了新的圖像的參數模糊度B。模糊度的加入對原來的算法提供了更豐富的顯著性參數,實現了算法的改進。

2 實驗過程及結果對比

2.1 實驗結果的對比

在本小節中,我們選擇了幾種經典的顯著性檢測模型:IT模型,GB模型,RC模型,SR模型以及FT模型和本論文提出的顯著性檢測模型對相同的圖片進行檢測,得出顯著圖,并進行比較。MAP模型主要算法原理與本模型所述色差感受度的計算相似,故沒有詳述。UFO模型為獨特度,聚焦度和物體度特征的非線性結合,前面幾種算法比較常見故沒有詳述其原理和推導演算過程。

通過實驗結果對照圖我們得知,GB模型和IT模型得出的顯著圖最為模糊,只能大概顯示出部分顯著的高亮區域,而且難以分辨出圖片中物體的整體輪廓,FT和SR模型都屬于頻域運算模型,運算速度都很快,FT模型是運用了局部對比度,因此比較適合背景單一,SR模型在單一背景下可以獲得較好的顯著性區域的輪廓,復雜環境情況下的表現不太令人滿意。RC模型整體來看效果有了很大程度地改善,但在其他顏色亮度高的區域也被當成了顯著性區域,因此也是有待優化。MAP對于圖像的前景和背景區域得到比較優秀的區分結果,在細節紋理部分的檢測還有待優化。UFO模型整體看來檢測結果表現較好,但是需要較長的運算時間,效率較低。對比上述顯著性檢測領域的經典模型,本論文中提出的模型,集合了UFO模型與MAP模型的優點,兼顧整體圖像的顏色顯著度,圖像中物體的獨立存在,以及人類視覺聚焦關注特性的各種特點的算法,在顯著圖的提取上表現優秀,在復雜的場景中也能較好的標識出顯著性區域。

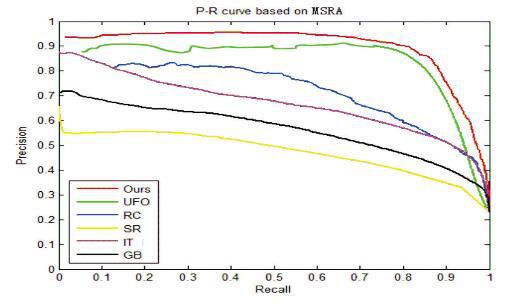

2.2 在數據集上進行顯著性檢測指標對比

將本文提出的模型與IT模型,GB模型,RC模型,SR模型和UFO模型在三個不同的圖像數據集中進行顯著性檢測,并針對每次檢測結果進行分析,分別繪制相應的PR特征曲線,進行運算結果的比較。為了獲得更有說服力的顯著性檢測評價效果,我們選擇了MSRA圖像數據集。在PR特征曲線,用不同的顏色分別代表每一種模型的運算結果,其中紅色代表本論文提出的模型,綠色代表UFO模型,藍色代表RC模型,黃色代表SR模型,紫色代表IT模型,黑色代表GB模型。

根據實驗我們所得到的具體結果如下幅圖所示:

從上圖我們可以明顯的看出,我們提出的新模型在每個數據集上的檢測與其他幾種模型相比,具有明顯優秀的表現,具有較高的查準率與查全率。

3 結語

本文主要思路為:首先對圖像進行色差感受度和模糊感受度的運算;然后通過色差感受度的計算我們大體上估計出整幅圖像的前景和背景區域;最后通過模糊度的運算我們得到圖像上最容易受到視覺關注的區域。二者結合,就可以得到一個更加符合人的視覺關注特征的顯著圖像。通過顯著性結果的對比和PR特征曲線的結果可以看出經過改進的BCO算法在顯著性檢測的應用中可行性和實用性表現的非常可觀,具有較好的實際應用價值。

參考文獻:

[1]Shi J,Yan Q,Xu L,et al. Hierarchical Image Saliency Detection on Extended CSSD [J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2016, 38(4):717.

[2]Wang Z,Teng S,Liu G,et al. Hierarchical sparse representation with deep dictionary for multi-modal classification[J]. Neurocomputing, 2017, 253(C):65-69.

作者簡介: 錢廣秀,出生年1992,漢,山東菏澤,研究生,山東科技大學,研究方向:機器視覺與模式識別

徐亞超,出生年1992,漢,山東泰安,研究生,山東科技大學,研究方向:機器視覺與模式識別