基于精細(xì)化殘差U-Net的新生兒局灶性腦白質(zhì)損傷分割模型

劉亞龍 李潔 王穎 仵賽飛 鄒佩

摘 要:針對(duì)新生兒局灶性腦白質(zhì)損傷的病灶區(qū)域小而樣本差異大導(dǎo)致的檢測(cè)與分割病灶較為困難的問(wèn)題,提出一種精細(xì)化深度殘差U-Net模型,以對(duì)病灶進(jìn)行精細(xì)的語(yǔ)義分割。首先,把核磁共振(MRI)圖像裁剪成較小的圖像塊;其次,利用殘差U-Net提取出每個(gè)圖像塊不同層次的深度特征;然后,將特征進(jìn)行融合并輸出每個(gè)圖像塊的病灶分布概率圖;最后,由全連接條件隨機(jī)場(chǎng)對(duì)拼接后的概率圖進(jìn)行優(yōu)化得到最終的分割結(jié)果。在某合作醫(yī)院提供的數(shù)據(jù)集上的評(píng)估結(jié)果顯示,在僅使用T1序列單模態(tài)數(shù)據(jù)的情況下,該模型在分割新生兒局灶性腦白質(zhì)損傷時(shí),病灶邊緣的分割精度得到提高,且模型抗干擾能力較好。該模型的Dice相似性系數(shù)達(dá)到了62.51%,敏感度達(dá)到69.76%,特異性達(dá)到99.96%,修正的Hausdorff距離降低到33.67。

關(guān)鍵詞:局灶性腦白質(zhì)損傷;新生兒;腦部腫瘤分割;深度學(xué)習(xí);語(yǔ)義分割;深度殘差U-Net模型

中圖分類號(hào): TP391.4文獻(xiàn)標(biāo)志碼:A

Segmentation model of neonatal punctate white matter lesion based on

refined deep residual U-Net

LIU Yalong*, LI Jie, WANG Ying, WU Saifei, ZOU Pei

(School of Electronic Engineering, Xidian University, Xian Shaanxi 710071, China)

Abstract: The tiny lesion area and the large difference between samples of neonatal punctate white matter lesion make it difficult to detect and segment the lesion. To solve the problem, a refined deep residual U-Net was proposed to realize the fine semantic segment of the lesion. Firstly, a Magnetic Resonance Imaging (MRI) image was cut into small patches. Secondly, the deep features of multiple layers of each image patch were extracted by the residual U-Net. Then, the features were fused and the probability map of the lesion distribution of each image patch was obtained. Finally, the probability map after splicing was optimized by the fully-connected condition random field to obtain the final segmentation results. The performance of the algorithm was evaluated on a dataset provided by a cooperative hospital. The results show that with only T1 order unimodal data used, the proposed model has the lesions edge segmented more precisely, and the anti-interference ability of the model is prominent. The model has the Dice similarity coefficient of 62.51%, the sensitivity of 69.76%, the specificity of 99.96%, and the modified Hausdorff distance reduced to 33.67.

Key words: Punctate White Matter Lesion (PWML); neonate; brain tumor segmentation; deep learning; semantic segmentation; deep residual U-Net

0 引言

新生兒局灶性腦白質(zhì)損傷(Punctate White Matter Lesion, PWML)是一種較為常見(jiàn)的腦部腫瘤。在早產(chǎn)的情況下,新生兒擁有不同程度PWML的概率將會(huì)達(dá)到20%[1-2],及時(shí)進(jìn)行人工干預(yù)可以減少新生兒腦部的發(fā)育障礙并改善預(yù)后情況。新生兒腦部結(jié)構(gòu)隨年齡變化較快,不同時(shí)期的新生兒腦部結(jié)構(gòu)有較為顯著的差異。因此,分割新生兒PWML的算法需要有較強(qiáng)的泛化能力和較好的魯棒性。目前認(rèn)為,PWML的特征在出生一周的新生兒腦部MRI中較為明顯,可以在T1加權(quán)以及T2加權(quán)的圖像中觀察到較為顯著的特征,分別表現(xiàn)為點(diǎn)狀、線狀或簇狀的T1加權(quán)高信號(hào)及T2加權(quán)低信號(hào)[3-4],一些PWML分割的相關(guān)工作均基于這些特征進(jìn)行展開(kāi)。

2013年,Cheng等 [5]提出了一種基于閾值分割PWML的方法,可以在一些病灶區(qū)域顯著、干擾較少的MRI中得到較好的結(jié)果。2015年,Cheng等[6]繼續(xù)提出了一種基于隨機(jī)過(guò)程來(lái)分割PWML的方法,該方法可以避免高斯分布的假設(shè),在低噪聲的MRI中也取得了較好的分割效果;但是,該方法處理步驟復(fù)雜,在分割噪聲較多以及對(duì)比度較低的MRI時(shí),性能仍然不夠魯棒[7]。最近,Mukherjee等[7]提出了一種綜合性的方法。該方法在單個(gè)層中通過(guò)最大極值穩(wěn)定區(qū)域[8]得到疑似的病灶區(qū)域,通過(guò)遺傳算法對(duì)該區(qū)域進(jìn)行選擇進(jìn)一步得到PWML的候選區(qū)域,然后根據(jù)PWML主要分布在腦室邊緣的假設(shè)對(duì)候選區(qū)域進(jìn)行篩選得到粗略分割的結(jié)果;之后的精細(xì)分割通過(guò)判斷病灶的相鄰層中在一定距離內(nèi)是否也有病變區(qū)域來(lái)保留或剔除該病灶區(qū)域,以此得到最終的分割結(jié)果。經(jīng)過(guò)實(shí)驗(yàn)驗(yàn)證,該方法在一定規(guī)模的數(shù)據(jù)集上取得了良好的效果;但是,該方法存在模型結(jié)構(gòu)復(fù)雜、處理流程繁多的問(wèn)題,且在數(shù)據(jù)集增大的情況下,模型的性能逐漸降低,魯棒性有待提高。

近年來(lái),機(jī)器學(xué)習(xí)與深度學(xué)習(xí)不斷發(fā)展,已經(jīng)在多個(gè)領(lǐng)域發(fā)揮出優(yōu)異的性能。在醫(yī)學(xué)信息分析領(lǐng)域,機(jī)器學(xué)習(xí)與深度學(xué)習(xí)算法在乳腺腫塊分類[9-10]、乳腺鉬靶腫瘤檢測(cè)[11-12]以及腦電數(shù)據(jù)分類[13]等領(lǐng)域中得到了廣泛的應(yīng)用。U型網(wǎng)絡(luò)(U-Net)[14]對(duì)細(xì)胞圖像的成功分割,再次證明了深度學(xué)習(xí)可以很好地被用于醫(yī)學(xué)圖像的語(yǔ)義分割。在腦部腫瘤分割以及腦白質(zhì)損傷分割方面,基于深度學(xué)習(xí)的方法也取得了優(yōu)異的性能[15-16]。另外,Zhang等[18]將特征提取能力強(qiáng)大的殘差網(wǎng)絡(luò)(ResNet)[17]與結(jié)構(gòu)先進(jìn)的U型網(wǎng)絡(luò)相結(jié)合,搭建了深度殘差U型網(wǎng)絡(luò)(Deep ResUnet),在遙感數(shù)據(jù)集上取得了較好的效果。焦點(diǎn)損失(focal loss)[19]可以在模型訓(xùn)練的時(shí)候,調(diào)整不均衡樣本以及難易樣本對(duì)模型損失的影響,提高模型的小目標(biāo)檢測(cè)能力。全連接條件隨機(jī)場(chǎng)(Fully-connnected Conditional Random Field, Fully-connnected CRF)[20]可以根據(jù)原始圖像中的紋理信息,對(duì)深度網(wǎng)絡(luò)分割結(jié)果進(jìn)行優(yōu)化,在圖像分割領(lǐng)域也獲得了廣泛的應(yīng)用。

因此,本文根據(jù)PWML的特點(diǎn),基于殘差U型網(wǎng)絡(luò),結(jié)合全連接CRF和焦點(diǎn)損失,提出了一種可以高效分割PWML病灶的深度學(xué)習(xí)分割模型。該模型相比于現(xiàn)有的一些算法,不需要預(yù)先去除頭皮區(qū)域,沒(méi)有復(fù)雜的預(yù)處理步驟,僅使用T1加權(quán)的MRI就可以精確地分割出PWML。

1 相關(guān)工作

1.1 深度殘差U型網(wǎng)絡(luò)

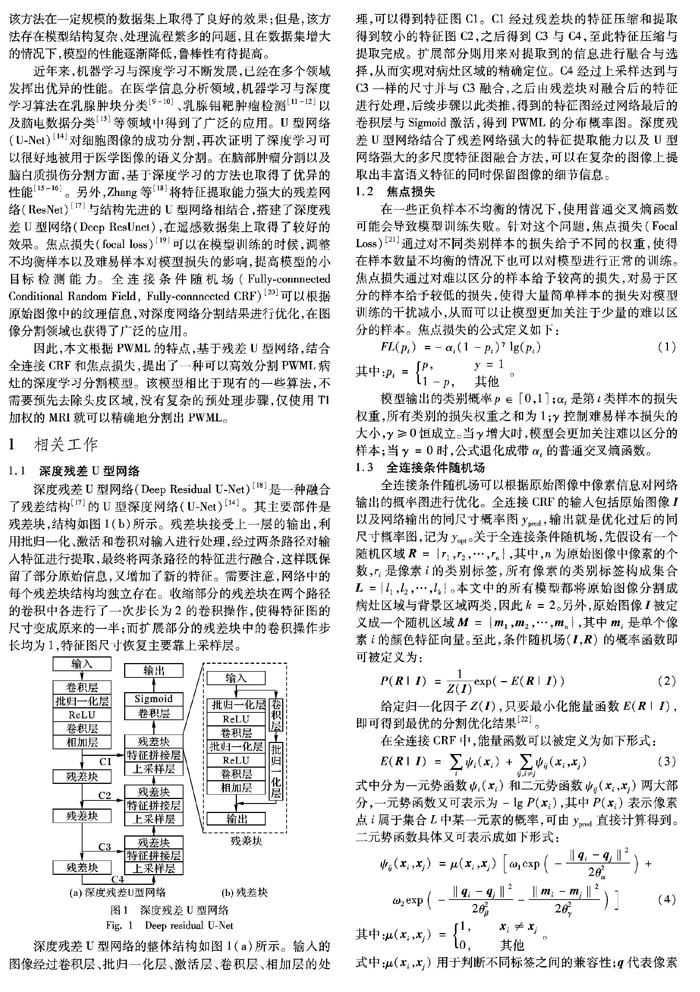

深度殘差U型網(wǎng)絡(luò)(Deep Residual U-Net)[18]是一種融合了殘差結(jié)構(gòu)[17]的U型深度網(wǎng)絡(luò)(U-Net)[14]。其主要部件是殘差塊,結(jié)構(gòu)如圖1(b)所示。殘差塊接受上一層的輸出,利用批歸一化、激活和卷積對(duì)輸入進(jìn)行處理,經(jīng)過(guò)兩條路徑對(duì)輸入特征進(jìn)行提取,最終將兩條路徑的特征進(jìn)行融合,這樣既保留了部分原始信息,又增加了新的特征。需要注意,網(wǎng)絡(luò)中的每個(gè)殘差塊結(jié)構(gòu)均獨(dú)立存在。收縮部分的殘差塊在兩個(gè)路徑的卷積中各進(jìn)行了一次步長(zhǎng)為2的卷積操作,使得特征圖的尺寸變成原來(lái)的一半;而擴(kuò)展部分的殘差塊中的卷積操作步長(zhǎng)均為1,特征圖尺寸恢復(fù)主要靠上采樣層。

深度殘差U型網(wǎng)絡(luò)的整體結(jié)構(gòu)如圖1(a)所示。輸入的圖像經(jīng)過(guò)卷積層、批歸一化層、激活層、卷積層、相加層的處理,可以得到特征圖C1。C1經(jīng)過(guò)殘差塊的特征壓縮和提取得到較小的特征圖C2,之后得到C3與C4,至此特征壓縮與提取完成。擴(kuò)展部分則用來(lái)對(duì)提取到的信息進(jìn)行融合與選擇,從而實(shí)現(xiàn)對(duì)病灶區(qū)域的精確定位。C4經(jīng)過(guò)上采樣達(dá)到與C3一樣的尺寸并與C3融合,之后由殘差塊對(duì)融合后的特征進(jìn)行處理,后續(xù)步驟以此類推,得到的特征圖經(jīng)過(guò)網(wǎng)絡(luò)最后的卷積層與Sigmoid激活,得到PWML的分布概率圖。深度殘差U型網(wǎng)絡(luò)結(jié)合了殘差網(wǎng)絡(luò)強(qiáng)大的特征提取能力以及U型網(wǎng)絡(luò)強(qiáng)大的多尺度特征圖融合方法,可以在復(fù)雜的圖像上提取出豐富語(yǔ)義特征的同時(shí)保留圖像的細(xì)節(jié)信息。

1.2 焦點(diǎn)損失

在一些正負(fù)樣本不均衡的情況下,使用普通交叉熵函數(shù)可能會(huì)導(dǎo)致模型訓(xùn)練失敗。針對(duì)這個(gè)問(wèn)題,焦點(diǎn)損失(Focal Loss)[21]通過(guò)對(duì)不同類別樣本的損失給予不同的權(quán)重,使得在樣本數(shù)量不均衡的情況下也可以對(duì)模型進(jìn)行正常的訓(xùn)練。焦點(diǎn)損失通過(guò)對(duì)難以區(qū)分的樣本給予較高的損失,對(duì)易于區(qū)分的樣本給予較低的損失,使得大量簡(jiǎn)單樣本的損失對(duì)模型訓(xùn)練的干擾減小,從而可以讓模型更加關(guān)注于少量的難以區(qū)分的樣本。焦點(diǎn)損失的公式定義如下:

FL(pt)=-αt(1-pt)γ lg(pt)(1)

其中:pt=p, y=1

1-p,其他 。

模型輸出的類別概率p∈[0,1];αt是第t類樣本的損失權(quán)重,所有類別的損失權(quán)重之和為1;γ控制難易樣本損失的大小,γ≥0恒成立。當(dāng)γ增大時(shí),模型會(huì)更加關(guān)注難以區(qū)分的樣本;當(dāng)γ=0時(shí),公式退化成帶αt的普通交叉熵函數(shù)。

1.3 全連接條件隨機(jī)場(chǎng)

全連接條件隨機(jī)場(chǎng)可以根據(jù)原始圖像中像素信息對(duì)網(wǎng)絡(luò)輸出的概率圖進(jìn)行優(yōu)化。全連接CRF的輸入包括原始圖像I以及網(wǎng)絡(luò)輸出的同尺寸概率圖ypred,輸出就是優(yōu)化過(guò)后的同尺寸概率圖,記為yopt。關(guān)于全連接條件隨機(jī)場(chǎng),先假設(shè)有一個(gè)隨機(jī)區(qū)域R={r1,r2,…,rn},其中,n為原始圖像中像素的個(gè)數(shù),ri是像素i的類別標(biāo)簽,所有像素的類別標(biāo)簽構(gòu)成集合L={l1,l2,…,lk}。本文中的所有模型都將原始圖像分割成病灶區(qū)域與背景區(qū)域兩類,因此k=2。另外,原始圖像I被定義成一個(gè)隨機(jī)區(qū)域M={m1,m2,…,mn},其中mi是單個(gè)像素i的顏色特征向量。至此,條件隨機(jī)場(chǎng)(I,R)的概率函數(shù)即可被定義為:

P(R|I)=1Z(I)exp(-E(R|I))(2)

給定歸一化因子Z(I),只要最小化能量函數(shù)E(R|I),即可得到最優(yōu)的分割優(yōu)化結(jié)果[22]。

在全連接CRF中,能量函數(shù)可以被定義為如下形式:

E(R|I)=∑iψi(xi)+∑ij,i≠jψij(xi,xj)(3)

式中分為一元?jiǎng)莺瘮?shù)ψi(xi)和二元?jiǎng)莺瘮?shù)ψij(xi,xj)兩大部分,一元?jiǎng)莺瘮?shù)又可表示為-lg P(xi),其中P(xi)表示像素點(diǎn)i屬于集合L中某一元素的概率,可由ypred直接計(jì)算得到。二元?jiǎng)莺瘮?shù)具體又可表示成如下形式:

ψij(xi,xj)=μ(xi,xj) [ω1exp(-‖qi-qj‖22θ2α)+

ω2exp(-‖qi-qj‖22θ2β-‖mi-mj‖22θ2γ)](4)

其中:μ(xi,xj)=1,xi≠xj

0,其他 。

式中:μ(xi,xj)用于判斷不同標(biāo)簽之間的兼容性;q代表像素位置信息,m代表像素的顏色信息,因此式(4)中方括號(hào)內(nèi)第一部分只與像素位置有關(guān),第二部分與像素位置與顏色有關(guān);超參數(shù)θα、θβ和θγ分別控制第一部分位置信息的尺度、第二部分位置信息的尺度以及第二部分顏色信息的尺度,表示各自高斯核的大小。

在數(shù)據(jù)增強(qiáng)方面,鑒于腦部MRI具有特定朝向的特點(diǎn),本文僅使用了左右翻轉(zhuǎn)以及小角度旋轉(zhuǎn)圖像的數(shù)據(jù)增強(qiáng)方法。即在模型訓(xùn)練的過(guò)程中,以0.5的概率橫向翻轉(zhuǎn)圖像,并以角度ω對(duì)原始圖像進(jìn)行旋轉(zhuǎn)(-10°<ω<10°)。通過(guò)聯(lián)合使用這兩種方法,大幅增加了數(shù)據(jù)的數(shù)量,最終增強(qiáng)了模型的泛化能力,減少了模型過(guò)擬合的情況。

4 實(shí)驗(yàn)結(jié)果評(píng)估與分析

本文將引入分割腦部腫瘤常用的評(píng)價(jià)指標(biāo),并利用這些指標(biāo)對(duì)模型分割PWML病灶的性能進(jìn)行評(píng)估。本文復(fù)現(xiàn)了文獻(xiàn)[7]中目前性能最優(yōu)的分割方法,并在同一數(shù)據(jù)集上對(duì)其性能進(jìn)行了測(cè)試。最后則逐步分析了本文提出的模型中每個(gè)模塊對(duì)模型整體性能的影響。

4.1 評(píng)估指標(biāo)

實(shí)驗(yàn)中使用Dice相似性系數(shù)(Dice Similarity Coefficient, DSC)、敏感度(Sensitivity)、特異性(Specificity)以及修正的Hausdorff距離(Modified Hausdorff Distanse, MHD)這四種常用的醫(yī)學(xué)影像分割指標(biāo)對(duì)本文模型以及文獻(xiàn)[7]方法進(jìn)行性能測(cè)試。分割正確的病灶區(qū)域面積記為STP,分割錯(cuò)誤的病灶區(qū)域面積記為SFN,分割正確的背景區(qū)域面積記為STN,分割錯(cuò)誤的背景區(qū)域面積記為SFP,則各個(gè)評(píng)價(jià)指標(biāo)的定義如下:

DSC=2STP/(SFN+SFP+2STP)

Sensitivity=STP/(STP+SFN)

Specificity=STN/(STN+SFP)

MHD(C,D)=max(d(C,D),d(D,C))

其中:DSC用以評(píng)估模型預(yù)測(cè)結(jié)果與專家給出的分割標(biāo)準(zhǔn)的相似性;敏感度用于評(píng)估模型正確分割出目標(biāo)的性能;特異性用以評(píng)估模型正確分割出背景的性能;修正的Hausdorff距離用以評(píng)估歐氏空間中的C和D兩個(gè)點(diǎn)集之間的距離,該式中d(C,D)=maxc∈C d(c,D),d(c,D)=mind∈D‖c-d‖表示集合C中某個(gè)元素距離集合D中所有元素的最小值,d(C,D)即表示集合C中所有元素d(c,D)的最大值。因此,MHD度量的是兩個(gè)集合之間的最大不匹配程度。

4.2 結(jié)果分析

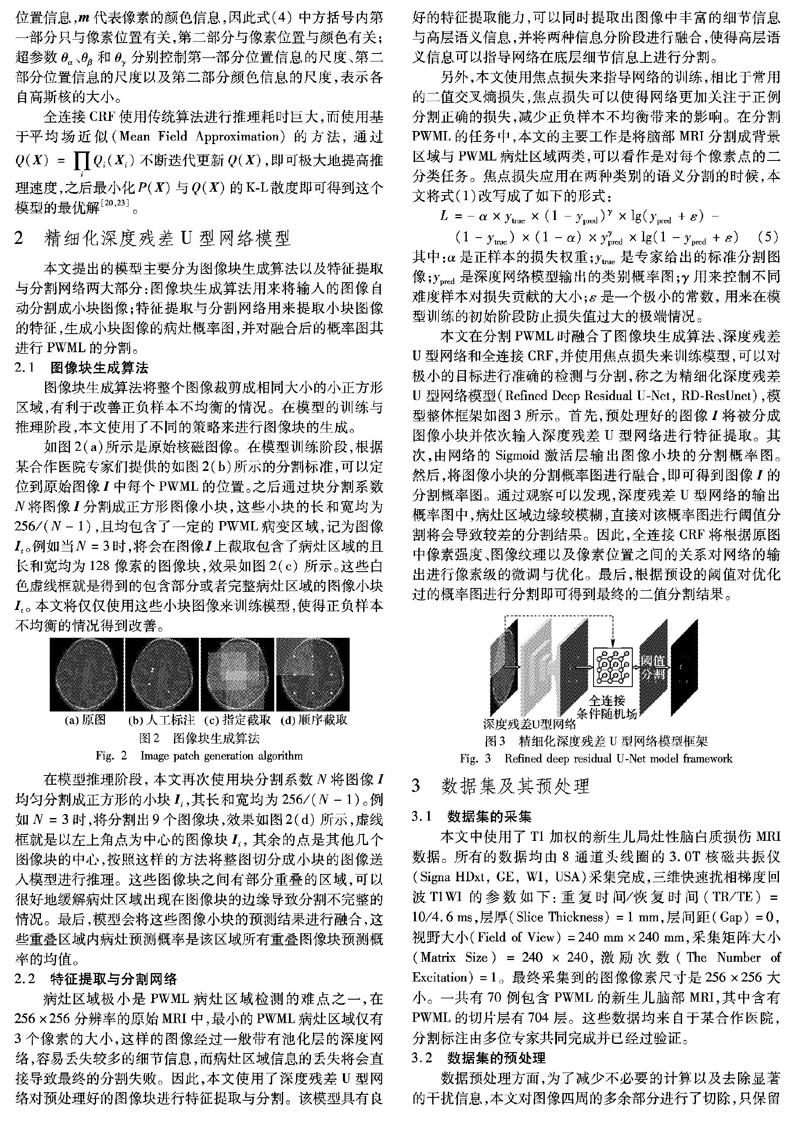

本文中所有的實(shí)驗(yàn)均基于第3章中描述的數(shù)據(jù)展開(kāi)。所有代碼均基于Tensorflow后端的Keras構(gòu)建。模型訓(xùn)練時(shí)使用了Adam優(yōu)化器[24],批大小為16,迭代100次,每次迭代100步,初始學(xué)習(xí)率為0.001;并設(shè)置了學(xué)習(xí)率的自動(dòng)衰減,即當(dāng)驗(yàn)證損失連續(xù)10個(gè)迭代周期沒(méi)有達(dá)到更小的值,學(xué)習(xí)率自動(dòng)下降為原來(lái)的一半。本文模型的訓(xùn)練過(guò)程如圖4所示,相較于二值交叉熵?fù)p失,焦點(diǎn)損失可以使得模型在驗(yàn)證集上的損失隨訓(xùn)練迭代次數(shù)快速下降,并趨于收斂,使得模型可以更好地分割PWML。

圖像根據(jù)N值進(jìn)行預(yù)處理。實(shí)際測(cè)試結(jié)果中發(fā)現(xiàn),提高N值可以提高模型小目標(biāo)檢測(cè)的能力,但是過(guò)大的N值將會(huì)導(dǎo)致塊圖像尺寸過(guò)小、數(shù)量過(guò)多,分割出的圖像小塊將僅僅包含病灶區(qū)域周?chē)恍〔糠值男畔ⅲ菀讓?dǎo)致模型訓(xùn)練過(guò)擬合,降低模型的泛化能力。N值偏小則會(huì)減弱模型的小目標(biāo)檢測(cè)能力,正負(fù)樣本不均衡的問(wèn)題改善不明顯,最終將導(dǎo)致模型分割失敗,因此在這里取N=3。

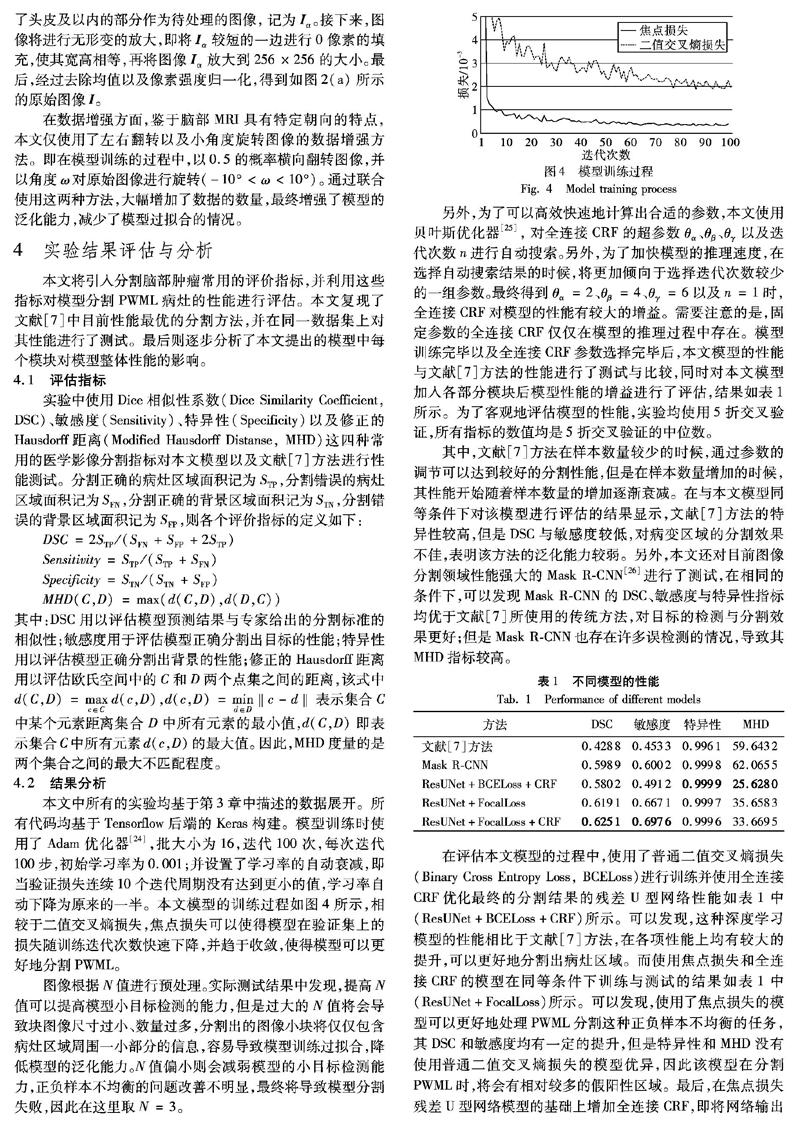

另外,為了可以高效快速地計(jì)算出合適的參數(shù),本文使用貝葉斯優(yōu)化器[25],對(duì)全連接CRF的超參數(shù)θα、θβ、θγ以及迭代次數(shù)n進(jìn)行自動(dòng)搜索。另外,為了加快模型的推理速度,在選擇自動(dòng)搜索結(jié)果的時(shí)候,將更加傾向于選擇迭代次數(shù)較少的一組參數(shù)。最終得到θα=2、θβ=4、θγ=6以及n=1時(shí),全連接CRF對(duì)模型的性能有較大的增益。需要注意的是,固定參數(shù)的全連接CRF僅僅在模型的推理過(guò)程中存在。模型訓(xùn)練完畢以及全連接CRF參數(shù)選擇完畢后,本文模型的性能與文獻(xiàn)[7]方法的性能進(jìn)行了測(cè)試與比較,同時(shí)對(duì)本文模型加入各部分模塊后模型性能的增益進(jìn)行了評(píng)估,結(jié)果如表1所示。為了客觀地評(píng)估模型的性能,實(shí)驗(yàn)均使用5折交叉驗(yàn)證,所有指標(biāo)的數(shù)值均是5折交叉驗(yàn)證的中位數(shù)。

其中,文獻(xiàn)[7]方法在樣本數(shù)量較少的時(shí)候,通過(guò)參數(shù)的調(diào)節(jié)可以達(dá)到較好的分割性能,但是在樣本數(shù)量增加的時(shí)候,其性能開(kāi)始隨著樣本數(shù)量的增加逐漸衰減。在與本文模型同等條件下對(duì)該模型進(jìn)行評(píng)估的結(jié)果顯示,文獻(xiàn)[7]方法的特異性較高,但是DSC與敏感度較低,對(duì)病變區(qū)域的分割效果不佳,表明該方法的泛化能力較弱。另外,本文還對(duì)目前圖像分割領(lǐng)域性能強(qiáng)大的Mask R-CNN[26]進(jìn)行了測(cè)試,在相同的條件下,可以發(fā)現(xiàn)Mask R-CNN的DSC、敏感度與特異性指標(biāo)均優(yōu)于文獻(xiàn)[7]所使用的傳統(tǒng)方法,對(duì)目標(biāo)的檢測(cè)與分割效果更好;但是Mask R-CNN也存在許多誤檢測(cè)的情況,導(dǎo)致其MHD指標(biāo)較高。

在評(píng)估本文模型的過(guò)程中,使用了普通二值交叉熵?fù)p失(Binary Cross Entropy Loss, BCELoss)進(jìn)行訓(xùn)練并使用全連接CRF優(yōu)化最終的分割結(jié)果的殘差U型網(wǎng)絡(luò)性能如表1中(ResUNet+BCELoss+CRF)所示。可以發(fā)現(xiàn),這種深度學(xué)習(xí)模型的性能相比于文獻(xiàn)[7]方法,在各項(xiàng)性能上均有較大的提升,可以更好地分割出病灶區(qū)域。而使用焦點(diǎn)損失和全連接CRF的模型在同等條件下訓(xùn)練與測(cè)試的結(jié)果如表1中(ResUNet+FocalLoss)所示。可以發(fā)現(xiàn),使用了焦點(diǎn)損失的模型可以更好地處理PWML分割這種正負(fù)樣本不均衡的任務(wù),其DSC和敏感度均有一定的提升,但是特異性和MHD沒(méi)有使用普通二值交叉熵?fù)p失的模型優(yōu)異,因此該模型在分割PWML時(shí),將會(huì)有相對(duì)較多的假陽(yáng)性區(qū)域。最后,在焦點(diǎn)損失殘差U型網(wǎng)絡(luò)模型的基礎(chǔ)上增加全連接CRF,即將網(wǎng)絡(luò)輸出的預(yù)測(cè)概率圖以及網(wǎng)絡(luò)輸入的原始圖像輸入全連接CRF,最終可以輸出優(yōu)化后的分割結(jié)果。該模型的性能如表1中(ResUNet+FocalLoss+CRF)所示,其DSC與敏感度相比上述其他模型又有較大的提升,因此該模型作為本文提出的最終模型,其分割結(jié)果可以更加貼合實(shí)際的病灶區(qū)域。

本文使用DSC與敏感度這兩種有代表性的指標(biāo)對(duì)各個(gè)模型在所有測(cè)試集樣本上的分割性能進(jìn)行統(tǒng)計(jì),結(jié)果如圖5所示。

由圖5可以發(fā)現(xiàn),文獻(xiàn)[7]方法的DSC與敏感度指標(biāo)的四分位間距均較大,表明該模型的性能在數(shù)據(jù)量較大的情況下不太穩(wěn)定,分割效果不理想。而使用了普通二值交叉熵?fù)p失和全連接CRF的殘差U型網(wǎng)絡(luò)(ResUNet+BCELoss+CRF)在分割PWML的性能上相比于前者有了較大的提升,且模型的性能在數(shù)據(jù)量較大的情況下也更為穩(wěn)定。將普通二值交叉熵?fù)p失換成焦點(diǎn)損失后(ResUNet+FocalLoss+CRF)可以發(fā)現(xiàn),模型分割PWML的DSC與敏感度指標(biāo)又有較大的提升,且DSC的四分位間距減小,說(shuō)明模型的魯棒性也有提高,總體性能提升明顯。最后,本文對(duì)沒(méi)有使用全連接CRF的焦點(diǎn)損失殘差U型網(wǎng)絡(luò)的性能進(jìn)行了測(cè)試,結(jié)果發(fā)現(xiàn),模型的DSC和敏感度相比于使用了全連接CRF的焦點(diǎn)損失殘差U型網(wǎng)絡(luò)均有一定程度的下降,證明了全連接CRF在提高算法性能方面起了重要的作用。另外,Mask R-CNN作為目前性能強(qiáng)大的分割算法,在分割PWML時(shí),模型性能較為穩(wěn)定,但是分割效果較為一般。

最后,各個(gè)方法分割PWML的效果如圖6所示,大腦中的白色點(diǎn)狀區(qū)域即為算法預(yù)測(cè)的病灶區(qū)域。圖中每一行是使用不同方法對(duì)同一個(gè)MRI切片的分割結(jié)果,最左側(cè)第一列圖像是輸入模型的原始MRI圖像,第二列是人工標(biāo)注的結(jié)果,而最后一列是本文最終模型的分割結(jié)果。其中,采用了殘差U型網(wǎng)絡(luò)的方法均可以很好分割出病灶,同時(shí)分割結(jié)果假陽(yáng)率較低,證明基于殘差U型網(wǎng)絡(luò)的方法在魯棒性上相比于文獻(xiàn)[7]方法具有一定的優(yōu)勢(shì),而本文最終模型誤檢測(cè)、漏檢測(cè)的情況也優(yōu)于Mask R-CNN。從圖6前三行中可以看出,采用了二值交叉熵?fù)p失的模型在檢測(cè)小目標(biāo)的時(shí)候性能較差,容易出現(xiàn)漏檢的情況。使用了焦點(diǎn)損失的模型則可以較好地應(yīng)對(duì)小目標(biāo)的情況。通過(guò)對(duì)比觀察第五列與第六列的圖像,發(fā)現(xiàn)全連接CRF可以在一定程度上減少模型預(yù)測(cè)的假陽(yáng)性部分,提高了模型預(yù)測(cè)與專家標(biāo)準(zhǔn)的匹配程度。最后三行是同一個(gè)病人的切片圖像,分別代表了腦部下、中、上這三個(gè)區(qū)域。其中第四行圖像包含了病人的眼部區(qū)域,最后一行則包含了大量與病灶相似的干擾區(qū)域,這些無(wú)用的區(qū)域容易對(duì)模型造成極大的干擾,但是本文提出的模型在對(duì)這些圖像進(jìn)行分割時(shí)均可以得到較好的結(jié)果,在分割同一個(gè)病人的時(shí)候具有良好的魯棒性。通過(guò)前三行的分割結(jié)果可以發(fā)現(xiàn),本文模型在分割PWML時(shí)對(duì)大腦的形態(tài)不敏感,在分割不同病人大腦中PWML的時(shí)候效果穩(wěn)定,算法魯棒性較好。

5 結(jié)語(yǔ)

本文提出了一種結(jié)合圖像塊生成、焦點(diǎn)損失、殘差U型網(wǎng)絡(luò)和全連接條件隨機(jī)場(chǎng)的新生兒局灶性腦白質(zhì)損傷分割模型,對(duì)新生兒腦部MRI進(jìn)行了準(zhǔn)確有效的像素級(jí)分割。圖像塊生成算法將圖像裁剪成一組較小的圖像塊,緩解了數(shù)據(jù)中正負(fù)樣本不均衡的問(wèn)題。殘差U型網(wǎng)絡(luò)對(duì)圖像塊進(jìn)行特征的提取,即可得到模型預(yù)測(cè)的分割概率圖。另外,模型的訓(xùn)練使用了焦點(diǎn)損失,使其在分割這種極小的目標(biāo)時(shí)可以更快更穩(wěn)定地收斂。模型推理時(shí)則使用了全連接條件隨機(jī)場(chǎng)對(duì)分割概率圖進(jìn)行像素級(jí)的優(yōu)化。最后,在某合作醫(yī)院采集的新生兒局灶性腦白質(zhì)損傷數(shù)據(jù)集上對(duì)模型的性能進(jìn)行測(cè)試的結(jié)果表明,本文提出的方法可以在存在干擾信息的情況下對(duì)病灶區(qū)域進(jìn)行準(zhǔn)確的分割,且在不同個(gè)體的腦部核磁圖像上具有較好的魯棒性,是一種準(zhǔn)確可靠的新生兒局灶性腦白質(zhì)損傷分割方法。但是,該模型依然存在一些局限性,例如在分割病灶時(shí),該模型僅考慮了單層切片中病灶的特征,沒(méi)有考慮相鄰切片之間像素的關(guān)系,會(huì)產(chǎn)生小概率誤檢與漏檢的情況。因此,如何使用相鄰切片層甚至全腦的圖像對(duì)新生兒腦白質(zhì)損傷進(jìn)行快速有效的分割,是需要進(jìn)一步探索的方向。

參考文獻(xiàn) (References)

[1]TORTORA D, PANARA V, MATTEI P A, et al. Comparing 3T T1-weighted sequences in identifying hyperintense punctate lesions in preterm neonates [J]. American Journal of Neuroradiology, 2015, 36(3): 581-586.

[2]KERSBERGEN K J, BENDERS M J N L, GROENENDAAL F, et al. Different patterns of punctate white matter lesions in serially scanned preterm infants [J]. PloS One, 2014, 9(10): e108904.

[3]DYET L E, KENNEA N, COUNSELL S J, et al. Natural history of brain lesions in extremely preterm infants studied with serial magnetic resonance imaging from birth and neurodevelopmental assessment [J]. Pediatrics, 2006, 118(2): 536-548.

[4]CORNETTE L G, TANNER S F, RAMENGHI L A, et al. Magnetic resonance imaging of the infant brain: anatomical characteristics and clinical significance of punctate lesions [J]. Archives of Disease in Childhood — Fetal and Neonatal Edition, 2002, 86(3): F171-F177.

[5]CHENG I, HAJARI N, FIROUZMANESH A, et al. White matter injury detection in neonatal MRI [C]// Proceedings of the Medical Imaging 2013: Computer-Aided Diagnosis, SPIE 8670. Bellingham, WA: SPIE, 2013: 86702L.

[6]CHENG I, MILLER S P, DUERDEN E G, et al. Stochastic process for white matter injury detection in preterm neonates [J]. NeuroImage: Clinical, 2015, 7: 622-630.

[7]MUKHERJEE S, CHENG I, MILLER S, et al. A fast segmentation-free fully automated approach to white matter injury detection in preterm infants [J]. Medical and Biological Engineering and Computing, 2019, 57(1): 71-87.

[8]MATAS J, CHUM O, URBAN M, et al. Robust wide-baseline stereo from maximally stable extremal regions [J]. Image and Vision Computing, 2004, 22(10): 761-767.

[9]JIAO Z, GAO X, WANG Y, et al. A deep feature based framework for breast masses classification [J]. Neurocomputing, 2016, 197: 221-231.

[10]HU Y, LI J, JIAO Z. Mammographic mass detection based on saliency with deep features [C]// Proceedings of the 2016 International Conference on Internet Multimedia Computing and Service. New York: ACM, 2016: 292-297.

[11]JIAO Z, GAO X, WANG Y, et al. A parasitic metric learning net for breast mass classification based on mammography [J]. Pattern Recognition, 2018, 75: 292-301.

[12]YANG D, WANG Y, JIAO Z. Asymmetry analysis with sparse autoencoder in mammography [C]// Proceedings of the 2016 International Conference on Internet Multimedia Computing and Service. New York: ACM, 2016: 287-291.

[13]JIAO Z, GAO X, WANG Y. Deep convolutional neural networks for mental load classification based on EEG data [J]. Pattern Recognition, 2018, 76: 582-595.

[14]RONNEBERGER O, FISCHER P, BROX T. U-Net: convolutional networks for biomedical image segmentation [C]// Proceedings of the 2015 International Conference on Medical Image Computing and Computer-Assisted Intervention, LNCS 9351. Cham: Springer, 2015: 234-241.

[15]HAVAEI M, DAVY A, WARDE-FARLEYC D. Brain tumor segmentation with deep neural networks [J]. Medical Image Analysis, 2017, 35: 18-31.

[16]GUERRERO R, QIN C, OKTAY O, et al. White matter hyperintensity and stroke lesion segmentation and differentiation using convolutional neural networks [J]. NeuroImage: Clinical, 2018, 17: 918-934.

[17]HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition [C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016: 770-778.

[18]ZHANG Z, LIU Q, WANG Y. Road extraction by deep residual U-Net [J]. IEEE Geoscience and Remote Sensing Letters, 2018, 15(5): 749-753.

[19]LIN T Y, GOYAL P, GIRSHICK R, et al. Focal loss for dense object detection [C]// Proceedings of the 2017 IEEE International Conference on Computer Vision. Piscataway: IEEE, 2017: 2999-3007.

[20]KRHENBHL P, KOLTUN V. Efficient inference in fully connected CRFs with Gaussian edge potentials [C]// Proceedings of the 25th Annual Conference on Neural Information Processing Systems. New York: Curran Associates, 2011: 109-117.

[21]LIN T Y, GOYAL P, GIRSHICK R, et al. Focal loss for dense object detection [C]// Proceedings of the 2017 IEEE International Conference on Computer Vision. Piscataway: IEEE, 2017: 2980-2988.

[22]LAFFERTY J, MCCALLUM A, PEREIRA F C N. Conditional random fields: probabilistic models for segmenting and labeling sequence data [C]// Proceedings of the 18th International Conference on Machine Learning. New York: International Machine Learning Society, 2001: 282-289.

[23]ZHENG S, JAYASUMANA S, ROMERA-PAREDES B, et al. Conditional random fields as recurrent neural networks [C]// Proceedings of the 2015 IEEE International Conference on Computer Vision. Piscataway: IEEE, 2015: 1529-1537.

[24]KINGMA D P, BA J L. Adam: a method for stochastic optimization [EB/OL]. [2019-02-20]. http://de.arxiv.org/pdf/1412.6980.

[25]SNOEK J, LAROCHELLE H, ADAMS R P. Practical Bayesian optimization of machine learning algorithms [C]// Proceedings of the 26th Annual Conference on Neural Information Processing Systems. New York: Curran Associates, 2012: 2951-2959.

[26]HE K, GKIOXARI G, DOLR P, et al. Mask R-CNN [C]// Proceedings of the 2017 IEEE International Conference on Computer Vision. Piscataway: IEEE, 2017: 2980-2988.

This work is partially supported by the National Natural Science Foundation of China (61671339).

LIU Yalong, born in 1994, M. S. candidate. His research interests include deep learning, medical image segmentation.

LI Jie, born in 1972, Ph. D., professor. Her research interests include image processing, intelligent transportation.

WANG Ying, born in 1981, Ph. D., associate professor. Her research interests include video processing and analysis, pattern recognition.

WU Saifei, born in 1995, M. S. candidate. His research interests include machine learning, computer vision.

ZOU Pei, born in 1993, M. S. candidate. Her research interests include video processing and analysis.

收稿日期:2019-04-29;修回日期:2019-06-26;錄用日期:2019-07-24。基金項(xiàng)目:國(guó)家自然科學(xué)基金資助項(xiàng)目(61671339)。

作者簡(jiǎn)介:劉亞龍(1994—),男,江蘇蘇州人,碩士研究生,CCF會(huì)員,主要研究方向:深度學(xué)習(xí)、醫(yī)學(xué)圖像分割; 李潔(1972—),女,陜西西安人,教授,博士,主要研究方向:圖像處理、智慧交通; 王穎(1981—),女,陜西西安人,副教授,博士,CCF會(huì)員,主要研究方向:影像處理與分析、模式識(shí)別; 仵賽飛(1995—),男,河南省周口人,碩士研究生,主要研究方向:機(jī)器學(xué)習(xí)、計(jì)算機(jī)視覺(jué); 鄒佩(1993—),女,湖北孝感人,碩士研究生,主要研究方向:影像處理與分析。

文章編號(hào):1001-9081(2019)12-3456-06DOI:10.11772/j.issn.1001-9081.2019049101