地鐵站出入通道多攝像機移動目標跟蹤研究

趙 凌

(鐵道警察學院 軌道交通安全保衛系, 鄭州 450053)

地鐵站視頻監控攝像機是地鐵交通安全維護的重要手段,公安機關利用視頻監控系統可以實現網上巡查、移動目標跟蹤抓拍、回放搜索、大客流預警與警力部署等工作。傳統的工作流程是先錄制視頻,再人工調取、分析視頻段。該方法對于單一攝像機視域尚可應用,但面對地鐵車站多攝像機視域時很可能耗時較多,從而影響后續工作部署。因此,在多攝像機視域下實現移動目標軌跡的自動跟蹤對于高效預警、控制可疑人員具有重要意義。

地鐵站出入通道是可疑人員進站乘車的必經之路,其間安裝的視頻監控攝像機具有以下視域特點:① 視域固定;② 出入通道光照亮度均勻;③ 移動目標會在相鄰攝像機視域內交替出現;④ 不同攝像機視域可能無重疊,也可能有重疊;⑤ 當多個移動目標同時出現在同一視域中時,可能相互遮擋,跟蹤難度加大。據此,多臺攝像機交替識別并跟蹤同一移動目標的關鍵是相鄰攝像機之間的目標傳遞。當前的相關研究主要集中在兩個方面:無重疊區域和有重疊區域的多視域移動目標跟蹤。

在無重疊區域跟蹤方面,文獻[1]通過提取兩個視域下有價值的特征點,設置匹配閾值,從而實現移動目標的傳遞和跟蹤。文獻[2-4]以移動目標所在的坐標和進出兩個視域邊界線的時間差閾值為約束條件,利用圖像的空間分塊和顏色直方圖匹配的方法實現移動目標的傳遞和跟蹤。文獻[5-7]利用分層結構的單詞樹直方圖和全局顏色直方圖獲取前景圖像的外觀特征,建立支持向量機增量學習在線訓練外觀特征的外觀識別模型,并對該模型進行在線自適應融合實現移動目標的傳遞和跟蹤。文獻[8-9]利用累加直方圖轉換函數對圖像的R、G、B分量進行亮度轉換,定義了顏色向量距離,在主顏色聚類的基礎上提取目標的主顏色直方圖,最后通過設置閾值對兩個目標的主顏色直方圖進行匹配,從而確定傳遞的目標。

有重疊跟蹤方面,文獻[10]利用尺度不變特征轉換(scale-invariant feature transform,SIFT)算法[11-12]自動提取移動目標特征點,生成視野分界線,通過顏色直方圖完成目標傳遞,利用Mean Shift算法[13-14]完成目標跟蹤。文獻[15]提出改進的投影不變量目標交換算法,將目標在兩個視域內的距離差與設置的閾值進行比較,若小于該閾值的目標只有1個,則完成目標傳遞;若類似目標有多個則啟動直方圖匹配算法進行匹配運算,匹配度最好的目標即傳遞的目標。考慮到地鐵站出入通道中移動目標的出現有其隨機性,接下來將重點研究無重疊區域相鄰兩臺攝像機的移動目標傳遞問題[16],這對于多攝像機無重疊區域的移動目標跟蹤研究更具普遍意義。

1 地鐵站出入通道相鄰攝像機監控模型的構建

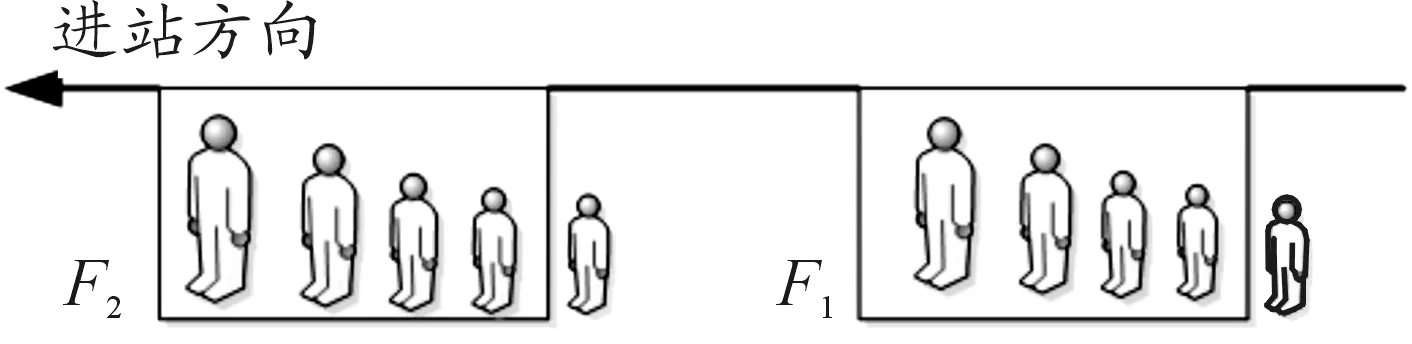

地鐵站出入通道是指地鐵站的步梯、直梯或自動扶梯與地鐵站廳層之間的人行通道。通常情況下,行人會由步梯、自動扶梯或直梯進入地鐵站出入通道,之后進入地鐵站廳層,憑票進入地鐵站臺層乘車出行。行人下車后由站臺層憑票途經站廳層,再經過地鐵站出入通道由步梯、自動扶梯或直梯出站。據此可知,行人乘坐地鐵勢必經過地鐵站出入通道,從而留下個人的移動軌跡,而地鐵站出入通道上通常會設置拐角,在拐角的顯著位置附近安裝有固定視域的視頻監控攝像機,這就使得相鄰攝像機對同一行人在不同視域內的軌跡跟蹤成為可能。本文主要研究行人經過“L形”地鐵站出入通道進站乘車的情況。如圖1所示,其中,F1、F2為相鄰攝像機C1、C2的無重疊區域的視域。

圖1 “L形”地鐵站出入通道相鄰攝像機監控模型示意圖

目標傳遞是多攝像機移動目標跟蹤的基礎。在圖1中,行人要進站乘車,必定按進站方向途經F1后,沿“L形”地鐵站出入通道繼續前行,之后必將出現在F2中。若C1、C2認定該行人為同一目標,則完成該行人圖像在兩臺相鄰攝像機之間的傳遞。

2 相鄰攝像機的目標傳遞

乘車進站時,行人正面出現在地鐵站出入通道攝像機中,成像大小為正比例逐漸放大,直到離開攝像機視域,如圖2所示。

圖2 行人經過視域時成像變化示意圖

F1、F2為相鄰兩臺攝像機的有效檢測視域,行人沿進站方向移動,成像逐漸變大。當行人進入攝像機視域時,可能會出現兩種情況:

情況1行人已經在此前地鐵站出入通道的攝像機視域中出現過,如圖1中的F2;

情況2行人第1次出現在地鐵站出入通道的攝像機視域中,如圖1中的F1。

一般情況下,行人在較短時間內途經F1、F2時的外觀、行為不會發生較大變化。本文選取行人的移動方向、身高寬度比、行走速度、著裝特征作為C1、C2目標傳遞時的特征匹配要素。

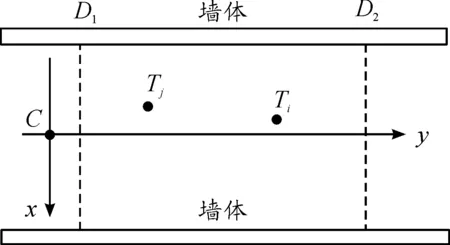

2.1 移動方向的匹配

由于攝像機安裝位置、視域范圍固定,因此可將攝像機在地面的投影點設為坐標原點C,以通過該點垂直于兩側墻體的直線為橫坐標x,以通過該點垂直于橫坐標的直線為縱坐標y,建立單有效視域二維平面坐標系,如圖3所示。

圖3 單有效視域二維坐標系

由圖3可知,在單視域環境下,攝像機的有效視域范圍為D1、D2與兩側墻體所構成的空間環境。一旦攝像機安裝位置確定,可認為在該空間環境對應的地面x、y坐標是確定的,即有效視域范圍內的行人腳下的坐標值(x,y)是確定的,且會隨著行人的移動不斷變化。假設行人在地鐵站出入通道行走時,行走路線近似直行,且通常有面向攝像機和反向攝像機兩種相對的行走方向。比較行人腳下坐標與坐標原點C(X,Y)之間歐氏距離的變化趨勢,歐氏距離減小則判斷為面向攝像機方向行走,歐氏距離增大則判斷為反向攝像機方向行走。本文只研究跟蹤面向攝像機移動的行人,從而排除反向攝像機方向行人的干擾。Ti和Tj分別是同一行人在途徑單有效視域下的任意兩點,其坐標分別為(xi,yi)和(xj,yj),若兩點和原點C(X,Y)之間的歐氏距離為DTij,則:

(1)

那么,當DTij>0時,行人面向攝像機移動;當DTij<0時,行人背向攝像機移動;當DTij=0時,行人沒有移動或沿垂直墻面方向移動。

2.2 身高寬度比的匹配

行人正面出現在攝像機視域中,其身高H和體寬W的輪廓數值是比較穩定的。但由于相鄰攝像機的參數不同,行人在不同視域中成像放大倍數也不同,H、W的數值會隨著行人的移動而不斷變化,因此只單獨考慮H、W的數值作為目標傳遞的參數是行不通的[17]。設身高寬度比為η,即行人作為移動整體成像時垂直高度與水平寬度之間的比值:

(2)

顯然,η不會因是否被放大而發生變化。當相鄰攝像機參數設置均相同時,η可以作為實時采樣比較的約束條件。考慮到檢測誤差和現場客觀因素的限制,取行人途徑F1、F2的身高寬度比分別為η1和η2,那么兩者差值為

Dfη=|η2-η1|

(3)

比較得出最小值,完成身高寬度比的匹配,即:

minDfη

(4)

實際情況下,并不是所有行人在經過F1或F2時都正對攝像機,在經過視域兩側時η值偏小,而正對著攝像機的η值接近真實值,因此同一行人在不同視域下η值可能相差較大。若單獨以η值作為目標傳遞的特征進行匹配可能無法完成目標傳遞,因此本文引入行走速度匹配。

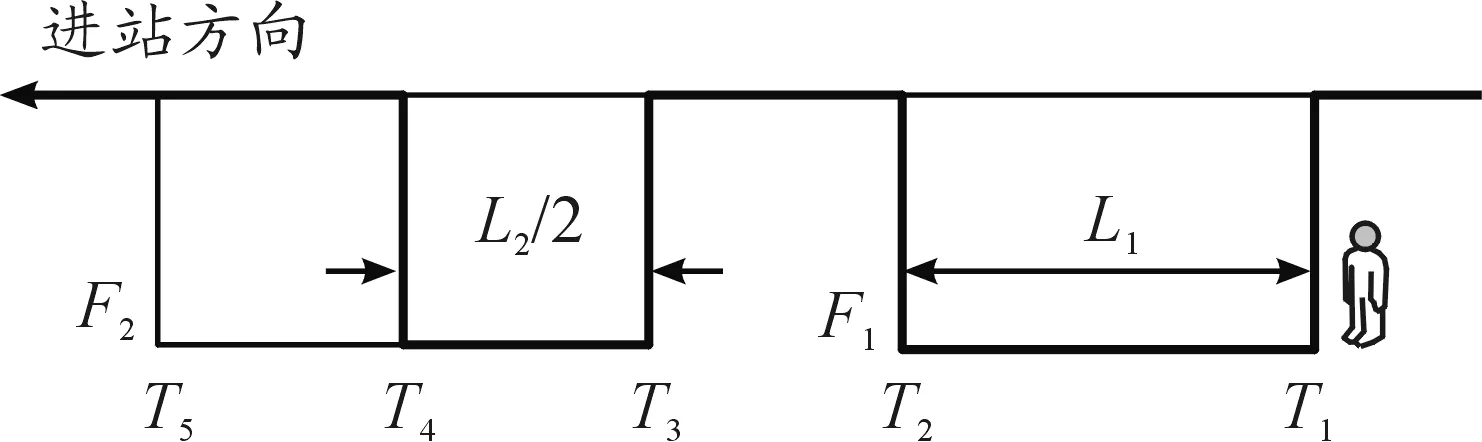

2.3 行走速度的匹配

通常情況下,受攝像機安裝位置和有效視域范圍的限制,行人在地鐵站出入通道單攝像機中出現的時間一般在10 s以內,行走速度相對穩定,這就為行走速度特征匹配創造了條件[18]。假設行人進入和離開F1的時間點分別為T1和T2,F1的有效長度為L1,如圖4所示。

圖4 行走速度檢測示意圖

行人經過F1的平均行走速度為

(5)

在途經F2時,利用同樣的方法可測算出行人經過L2/2時的平均行走速度為

(6)

行人在途經F2的T4與T5之間的后L2/2期間,通過計算相繼進入F1、F2的不同行人v2與v1的絕對差值:

Dfv=|v2-v1|

(7)

比較得出最小值,完成行人速度匹配,即:

minDfv

(8)

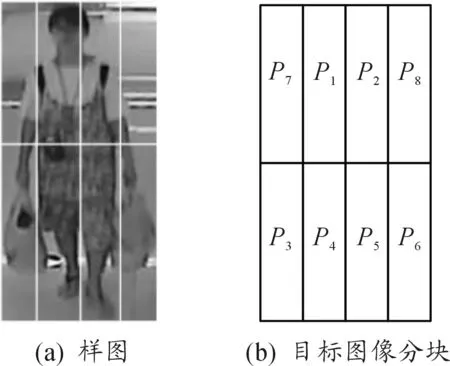

2.4 空間顏色直方圖的匹配

2.4.1空間位置選擇

顏色直方圖只包含圖像中顏色值出現的頻數,缺乏像素的空間位置信息,致使目標傳遞所需的特征匹配因素缺乏有針對性的比較對象[19]。為進一步提高目標匹配的準確性,以行人著裝特征為研究對象,同時兼顧行人提、拉箱包的情況,本文采用空間顏色二維直方圖匹配方法,先將行人圖像分割成2×4的方塊組合,然后統計每塊區域內的顏色直方圖,從而獲取該圖像的空間顏色二維直方圖,如圖5(a)所示。由圖5(b)可知:行人整體所在的主要塊區分布在P1、P2、P3、P4、P5、P6塊區,考慮到人體著裝顏色穩定性特點,根據經驗可以增加P1、P2塊區和P4、P5塊區的權重來提高圖像匹配的準確度。

圖5 空間位置選擇實例

2.4.2直方圖匹配

為盡可能避免非理想狀態下產生的噪聲影響,基于單攝像機目標跟蹤時,先對要跟蹤的行人隨機抽取n-1幀m級目標圖像直方圖作為比較樣本,記為:

sij=aij

(9)

其中i=1,…,n,j=1,…,m。那么最新一幀的直方圖與樣本直方圖的差的絕對值記為

Distn=|anj-aij|

(10)

當Disti小于某個閾值時,記為Threshold,對Disti進行累加操作,記為

(11)

當Sum值小于等于某一個經驗值(本文設Sum值為2)時,完成目標匹配。

3 仿真實驗與分析

3.1 算法設計

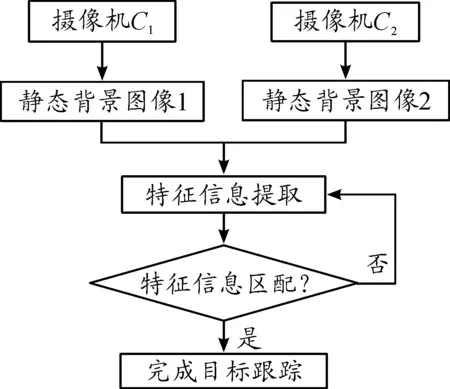

本文首先利用ViBe算法[20-21]建立移動目標背景檢測模型,當有行人出現時,即可建立移動目標模板,通過提取行人的移動方向、身高寬度、行走速度、空間顏色直方圖等特征信息構建行人的樣本集合。當滿足圖像匹配條件時,即可認為實現了移動目標在無重疊區域的相鄰兩臺攝像機視域下的軌跡跟蹤。算法具體流程如圖6所示。

圖6 算法流程

3.2 實驗結果及分析

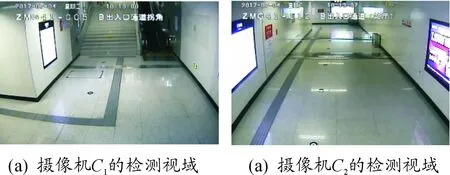

通常情況下,行人按照圖1的“進站方向”進站乘車。本文以國內某城市真實地鐵站出入通道視頻監控圖像為背景,構建由2臺相鄰攝像機組成的無重疊區域的實驗現場,對移動行人進行跟蹤,并建立特征跟蹤模板,如圖7所示。

圖8是2臺攝像機對行人目標交接的結果。圖8(a)在C1的第7 672幀圖像中檢測到目標1,用紅色方框跟蹤標識。圖8(e)在C2的第8 044幀圖像中檢測到目標1,該目標是C2中第2個目標。圖8(b)在C1的第7 754幀圖像中檢測到目標2,用藍色方框跟蹤標識;圖8(f)在C2的第8 084幀圖像中檢測到目標2,該目標是C2中第3個目標。由圖8(c)(d)(g)(h)可以看出:C1和C2實現了對目標1、2的跟蹤和傳遞。

圖7 地鐵站出入通道無重疊區域的相鄰2臺攝像機檢測視域

圖8 兩個行人在相鄰攝像機視域實現目標傳遞

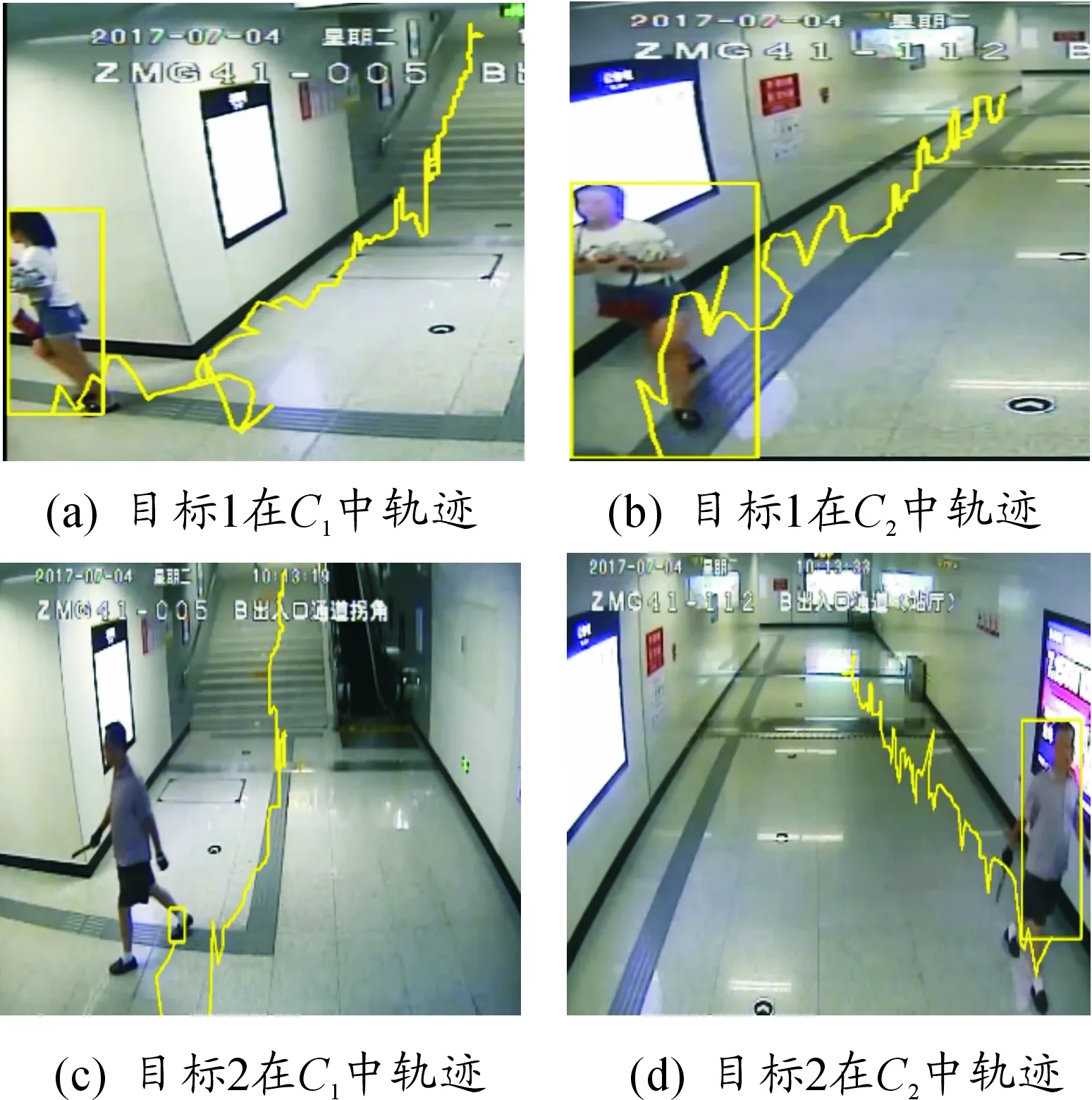

為進一步明確移動目標在地鐵站通道內的活動軌跡,圖9(a)(b)給出了目標1在攝像機C1和攝像機C2中的移動軌跡,圖9(c)(d)給出了目標2在攝像機C1和C2中的移動軌跡。由此可知,在本文提出算法背景下,均可獲取任何進出地鐵站行人的移動軌跡圖,從而實現對其移動規律、乘車習慣等方面的跟蹤監控。

圖9 移動目標在C1和C2之間實現軌跡跟蹤

由于SIFT算法對移動目標的尺度縮放、旋轉、亮度變化保持不變性,同時對視角變化、仿射變換、噪聲也保持一定程度的穩定性,為進一步檢驗本文算法對移動目標的跟蹤成效,以SIFT算法在單一攝像機視域內對移動目標的跟蹤成效為比較對象,給出了行人數量由10增至90時,本文算法與SIFT算法對移動目標跟蹤時的準確率變化情況,見圖10。由此可知,本文提出的算法對移動目標跟蹤的準確率明顯高于單一攝像機直接使用SIFT算法的目標跟蹤效果。同時不難發現,隨著移動目標數量的增多,移動目標之間相互遮擋現象明顯增多,跟蹤難度加大,2種算法的跟蹤準確率均呈下降趨勢。

圖10 本文算法與單攝像機直接使用SIFT算法時跟蹤移動目標的效果比較

4 結束語

本文分析了地鐵站出入通道視頻監控攝像機的視域特點,以行人經過相鄰2臺攝像機為例,將其移動方向、身高寬度比、行走速度、著裝特征作為匹配要素,有效實現了對同一移動目標的軌跡跟蹤,對地鐵站內多攝像機自動跟蹤可疑人員及其行為具有借鑒意義。但隨著地鐵站出入通道行人數量的增加,多攝像機協調跟蹤移動目標的難度進一步加大,解決該問題成為下一步研究的工作重點。