基于語義分割的檳榔內核輪廓檢測

朱澤敏 張東波 張瑩 汪忠

摘? ?要:針對檳榔去核工序中檳榔內核輪廓檢測問題,提出一種基于語義分割的檳榔內核輪廓檢測方法。分割模型以VGG16為基礎網絡,將全連接層替換為卷積層,增加了跳躍結構,將淺層特征經過采樣后在同一尺度下與深層特征進行融合,并將常規卷積替換成擴張卷積,減少了學習參數,提升了分割模型的實時性,得到最終的FCN-Dilated-VGG-8s分割模型。該模型對檳榔圖像分割的準確率達到98.79%,單張圖像分割只需0.071 s,模型大小只有FCN-VGG-8s模型的37.5%。算法表現出良好的魯棒性,實現了檳榔圖像準確、快速分割。通過對分割完后的圖像的邊界提取,即可得到完整平滑的檳榔內核輪廓線。

關鍵詞:語義分割;邊緣檢測;深度學習;全卷積網絡;擴張卷積

中圖分類號:TP391.4? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ?文獻標識碼:A

Betel Nut Stones Contour Detection Based on Semantic Segmentation

ZHU Ze-min1,ZHANG Dong-bo1,2?覮,ZHANG Ying1,2,WANG Zhong1

(1. College of Information Engineering ,Xiangtan University ,Xiangtan,Hunan 411105,China;

2. National Engineering Laboratory for Robot Visual Perception & Control Technology,Changsha,Hunan 410012,China)

Abstract:A method for the detection of betel nut stones contour based on semantic segmentation is proposed. The segmentation model is based on VGG16,among it the fully connected layer is replaced with convolution layer,moreover a jump structure is introduced,and the lower level features are merged with higher level deep features under the same scale,in addition we replace the conventional convolution with the dilated convolution,it results in reduced learning parameters,the real-time performance of the segmentation model is improved. By above process,the final FCN-Dilated-VGG-8s segmentation model is obtained. The accuracy of the model is 98.79% for betel nut image segmentation,and cost of single image segmentation is only 0.071s,and the model complexity is only 37.5% of the FCN-VGG-8s model. The algorithm shows good robustness and achieves accurate and quick segmentation of betel nut images. By extracting the boundary of the segmented image,a complete and smooth betel nut outline can be obtained.

Key words:semantic segmentation;edge detection;deep learning;full convolution network;dilated convolution

檳榔是一種快速消費食品,目前國內市場出售的檳榔通常屬于煙果檳榔,其加工工藝比較復雜,加工主要流程包括選籽→堿洗→水洗→泡制→烘烤→表皮加香→切籽→去核→點鹵→干燥→包裝→成品等十幾道工藝[1]。由于檳榔加工過程中經過擠壓后形狀變得極不規則(圖1),因此其中三道關鍵工藝:切籽、去核和點鹵工序目前通常由人工操作,由于每天加工量巨大,因此檳榔廠在上述三道工序上耗費的人工是很大的,由于人力成本逐年增加,而且生產環境有較強的刺激性氣味[2],因此對檳榔廠來說,招工的成本很高而且比較困難。為了降低人工成本,同時提高生產效率和產品品質,檳榔加工過程亟需提高自動化程度。

本文只研究檳榔加工過程的去核問題,檳榔切籽后被一分為二,切開后的檳榔有果壁和果核兩部分,如圖2所示,其中果核需要去除,為了去除果核,我們的解決方案是通過控制機械臂沿檳榔內核輪廓進行去核操作,為了實現這一操作,需要檢測出檳榔的完整內核區域輪廓曲線,從而給機械臂提供視覺引導。

傳統的輪廓檢測算法有基于邊緣檢測和基于區域分割的兩大類,基于邊緣檢測的算法主要利用局部邊緣的灰度突變,常用的有各種邊緣檢測算子,例如Sobel算子、Prewitt算子[3-5]、Canny算子等[6-7],優點是算法簡單,實時性好,但是由于過于關注局部信息,其對弱邊緣的檢測不夠理想,而且邊緣平滑性差、魯棒性弱,很多時候難以形成比較完整和閉合的輪廓,實驗表明,這種情況在檳榔圖像的輪廓檢測中出現的概率不低。基于區域分割的方法中,早期比較出名的有區域生長算法,分水嶺算法[8]、主動輪廓模型等[9],這一類算法的優點是利用了區域信息,綜合考慮了多種因素,能夠產生比較平滑且封閉的輪廓,但是需要人工干預,例如預設種子點或初始輪廓,另外算法比較復雜,通常達不到實時性要求,因此在工業圖像處理中很少采用。

由于檳榔個體形狀差異很大;不同批次檳榔的紋理,干濕度、內核顏色、果肉顏色差異很大;現場成像時易受到光照強度、污漬、破損等不可控因素影響,經前期實驗驗證出傳統邊緣檢測方法和區域分割方法都不能取得良好的輪廓檢測效果。

近年來,深度學習網絡模型在計算機視覺任務中得到廣泛應用,借助復雜模型的強大學習能力和大量數據的訓練,深度學習在目標檢測與識別、輪廓檢測、語義分割等傳統計算機視覺領域取得了很大的突破,在實際應用中達到了良好的性能。同時借助GPU和模型壓縮、優化加速處理,速度得到很大提升,在實際部署中能夠達到實時性處理要求。針對檳榔的內核輪廓檢測問題,采用基于深度網絡的輪廓檢測模型或語義分割模型都是可行的。經典的輪廓檢測模型有:Holistically-Nested Edge Detection(HED)[10]、Deep Category-Aware Semantic Edge Detection(CASENet)[11]等,由于直接采用輪廓檢測模型不能生成單像素寬度的輪廓曲線,同時其關注的仍是局部邊緣,因此檢測結果并不能直接區分內核輪廓和其它的邊緣。基于上述原因,我們選擇的方案是通過語義分割模型先將檳榔內核區域完整的分割出來,分割得到的內核區域的邊界曲線自然對應內核的輪廓曲線,這是很容易變換得到的。

研究了基于全卷積神經網絡的語義分割檳榔內核輪廓檢測方法。Shelhamer等將AlexNet[12]和VGG16等提出的分類網絡改造成全卷積網絡

FCN[13],并將分類網絡的學習參數遷移到語義分割任務中。本文基于語義分割全卷積網絡結構,將深度學習應用于檳榔內核輪廓檢測問題,我們將檳榔圖片分成背景、檳榔果壁、檳榔內核三部分,然后對分割得到內核區域部分進行邊界提取即可得到檳榔內核輪廓曲線上各點的坐標。通過遷移學習后,FCN-VGG16-Net模型能很好地將輸入的檳榔圖像分割成背景、檳榔果壁、檳榔內核三部分,從而幫助我們很好地解決了檳榔內核輪廓檢測任務。

1? ?改進的全卷積神經網絡

FCN由CNN發展而來,CNN自2012年在ILSVRC奪冠以來,在圖像分類、目標檢測與識別等方面取得了廣泛的應用。CNN在進行分類時主要由卷積層、池化層、全連接層和softmax層組成。圖像經過一系列卷積池化處理后,再經過全連接層輸出相同維度的特征向量,最后通過softmax層進行分類。網絡每經過一次池化操作后輸出特征尺寸變為輸入特征尺寸的1/2,這對于分類任務沒影響,但對語義分割問題而言由于丟失像素點位置信息,最終無法實現像素級分類的目標。因此FCN 以CNN 分類網絡為基礎,將網絡最后的全連接層替換為卷積層,輸出結果由一維的特征向量變成二維特征圖,再對縮小的特征圖進行若干次反卷積可恢復原始圖像大小,最后通過像素級分類,得到每個像素點的類別,從而得到語義分割結果。VGG16-Net是經典的特征提取網絡,本文以VGG16-Net作為特征提取的基礎網絡進行檳榔圖像分割實驗。最后在基于FCN-VGG16的基礎上增加跳躍結構并將第一個反卷積單元中傳統卷積fc6層替換成Dilated-convolutiondilated-fc6層,從而得到我們的檳榔圖像分割網絡,網絡架構如圖3所示,表1給出了詳細的網絡架構參數說明。

網絡的改進主要包括三個方面:

1)FCN全連接層被替換為卷積層。現有的FCN-VGG16-32s分割網絡在分類網絡VGG16-Net的基礎上將最后兩層全連接層改為卷積層,其中第一個替換的卷積層fc6對應卷積核尺寸為4096*512*7*7,第二個替換的卷積層fc7對應卷積核尺寸為4096*4096*1*1。由于FCN-VGG16的前五個卷積模塊分別包含一個池化層,每經過一層池化得到的特征圖大小變為輸入特征圖大小的1/2,五次池化后即得到一個尺寸為輸入1/32大小的特征圖,最后對所得特征圖進行反卷積,恢復到原圖尺寸大小,從而實現像素級別的預測分類。

2)增加了跳躍結構。CNN 通過淺層卷積提取圖像的細節特征,如邊緣、角點等,而深層卷積提取

注:表中scale_pool4層中的[512]*0.01和scale_pool3層中的[256]*0.001為特征融合時設置的可調節權重影響因子;dilated-fc6層為擴張卷積層。

語義特征。直接對最后一層卷積特征score-fr進行32倍上采樣得到FCN-VGG-32s模型,由于該模型只用了最后一層卷積特征,導致淺層輪廓、角點等細節信息丟失,使得分割結果粗糙、局部信息丟失嚴重。為融合淺層細節信息,FCN-VGG-8s在最初的FCN-VGG-32s基礎上添加了兩種跳躍結構:①FCN-VGG16-16s。在對scoer_fr層的輸出進行反卷積的基礎上,融合pool_4層特征,然后對融合后的特征upscore_pool4層進行stride為16,kernel_size為32的反卷積,從而將特征圖擴大16倍,恢復到原圖尺寸。②FCN-VGG16-8s。在FCN-VGG16-16s對upscore_pool4層進行反卷積的基礎上,再融合pool_3層的特征,并對融合后的特征進行stride為8,kernel_size為16的反卷積,將特征圖擴大8倍,再經過Crop層裁剪即可恢復到原圖尺寸。

3)將常規卷積替換成擴張卷積。dilated convolution最初是為了解決FCN在下采樣和上采樣特征圖縮小后再放大過程中造成信息損失這一問題提出來的,而在這里為了縮減模型大小,提升算法速度,本文從占據網絡數據超過90%的fc6層著手,將原有的4096*512*7*7的fc6卷積替換成4096*512*3*3的dilated-fc6,由于Dilated-Convolution卷積核大小為3*3,擴張率為3時感受野為7*7,這使得保持相同感受野的同時大大減少了學習參數,其中fc6層參數量為102764544個,dilated-fc6層參數量為18878464個,參數量對比如圖4所示。

當卷積核尺寸為7*7,擴張率為1時即為常規卷積,如圖5(a)所示,本文所用的擴張卷積其卷積核尺寸為3*3,擴張率為3,如圖5(b)所示,其感受野大小為7*7。

2? ?檳榔圖像分割實驗

2.1? ?數據采集與數據集制作

原始圖像由200萬像素的彩色CCD相機采集,光源采用白色穹形光源,圖像初始尺寸為1600*1200的彩圖,綜合考慮處理速度和分割效果,實驗中將圖像歸一化成500*375大小。標簽制作時我們將背景標注為黑色,檳榔內核標注為綠色,檳榔果壁標注為紅色,標簽示例如圖6(b)所示。原始數據一共818張,經左右翻轉,隨機旋轉一定角度,數據擴增到2454張,并隨機選取90%即2208張作為訓練樣本,剩下10%即246張作為測試樣本。

2.2? ?實驗環境

本文算法基于開源深度學習Caffe框架,實驗硬件配置為Intel i7-7700處理器,NVIDIA GeForce GTX 1080Ti顯卡,軟件環境為Ubuntu 16.04 LTS 操作系統,CUDA9.0配套Cudnn7.0的加速訓練環境。

2.3? ?評價指標

使用圖像分割中使用最多的Pixel Accuracy標準來衡量算法的精度。

Pixel Accuracy:即標記正確的像素占總像素的比例。

注:nij:即預測為類j類的i類像素數,ti:即ground truth segmentation中類別i的像素總數

2.4? ?模型訓練

深度神經網絡在模型訓練時要求數據集的量非常大,對硬件要求也比較高,而且模型訓練周期很長。而實際情況下我們數據集的量不夠,為了解決上述問題本文在模型訓練過程中應用遷移學習策略,將VGG16在Pascal VOC數據集上預訓練好的模型對網絡的下采樣部分進行初始化,這樣大大減少模型訓練時參數學習帶來的振蕩,既可以縮短訓練周期還能得到小數據集上訓練無法比擬的效果。訓練過程中交替調用前向(forward)算法和反向傳遞(backward)算法來更新參數,最小化損失(loss),訓練過程中關鍵參數如表2。

3? ?實驗結果與分析

3.1? ?對比實驗

為了驗證本文算法檳榔內核輪廓檢測的效果,以及實時性、魯棒性方面的優勢,本文設計了兩部分實驗:第一部分為基于傳統方法的檳榔內核輪廓檢測實驗,第二部分為基于深度學習的檳榔內核輪廓檢測實驗。

3.1.1? ?基于傳統方法的檳榔內核輪廓檢測實驗

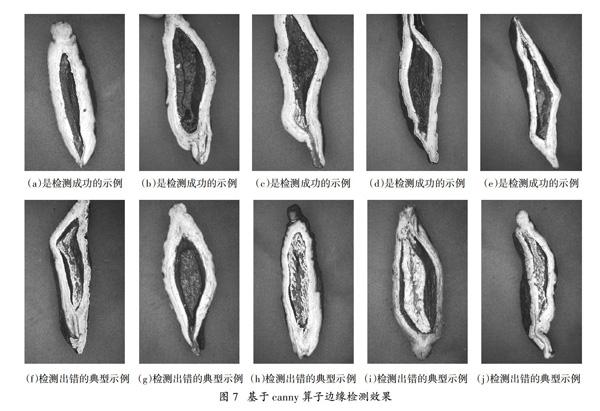

我們分別對比了基于canny算子的檳榔內核輪廓檢測方法,以及基于區域生長算法的檳榔內核輪廓檢測方法。基于canny算子的檳榔內核輪廓檢測方法需要先對圖像進行平滑,當取閾值上下限分別為threshold1為20,threshold2為50時邊緣檢測效果相對最佳,最后通過閾值去除過短的線,剩下即為檢測出的輪廓線,試驗結果示例如圖7所示。

圖7給出了部分示例實驗結果,其中圖7 (a) (b) (c) (d) (e)是檢測效果相對比較好的示例,但從中我們仍能觀察發現,輪廓線并不平滑,容易產生毛刺。圖7 (f) (g) (h) (i) (j) 給出了一些檢測失敗的典型示例:圖7(f)由于檳榔內核失水后,體積縮小,導致果壁與內核分離形成空隙,由于難以區分內核和果壁的邊緣,算法不能自動確定內核輪廓。圖7(g)由于檳榔下端果壁較薄,且檳榔端部顏色與內核相近造成內外輪廓線連在一起,不能形成準確的封閉的內核輪廓線。圖7(h)則因為檳榔內核部分紋理信息豐富,紋理產生的邊緣給內核部分的邊界邊緣檢測造成極大干擾。圖7(i)檳榔果壁內部紋理差異較大,同時果壁顏色與背景顏色相近,造成邊緣漏檢。圖7(j)則因為顏色相近的內核與果壁粘連,導致檳榔內核輪廓檢測失敗。

基于上述情況,我們得知基于邊緣檢測的方法存在的問題主要是:輪廓線易受紋理、噪聲干擾、檢測得到的輪廓線往往不夠光滑,很多時候不能形成封閉的內核輪廓線。局部邊緣細節對內核輪廓的判斷形成很大干擾。

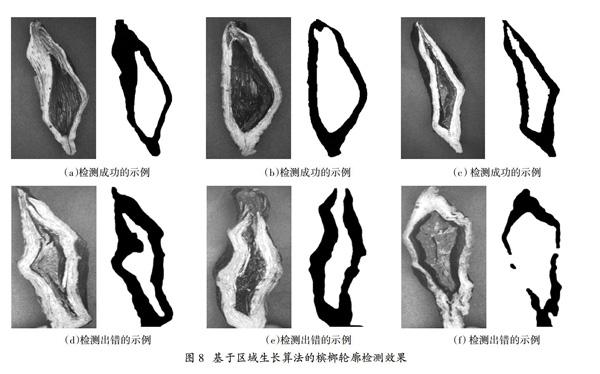

基于區域生長的方法受噪聲邊緣干擾影響相對較少且能夠形成的輪廓線相對光滑,于是我們采用區域生長方法也做了檳榔內核輪廓的檢測實驗。基于區域生長的檳榔輪廓檢測先用中值濾波對圖像進行平滑處理,然后對平滑處理后的圖像進行開閉運算,緊接著進行生長,最后再次進行開閉運算得到檳榔輪廓圖,實驗結果示例如圖8所示。

圖8給出了若干基于區域生長的檳榔內核輪廓檢測示例結果。圖8 (a) (b) (c)為檢測效果比較理想的示例。圖8(d)中由于果壁和內核部分灰度相近,在生長時誤將部分內核分割成果壁。圖8(e)中由于檳榔上端果壁較薄加上灰度相近,造成生長后的連通區域不閉合。圖8(f)在統一閾值分割下,由于檳榔局部干濕度不同,圖像灰度差異較大,導致區域生長效果很差。

總的來說,以上兩種傳統算法不需要繁瑣的模型訓練過程,且單張圖像處理時間很短,對硬件設備要求很低,但是它們存在的缺點也是致命的,算法很容易被噪聲邊緣干擾,當檳榔各批次差異較大,檳榔形狀及不規則時,檢測效果不理想,算法魯棒性很差。

4.1.2? ?基于深度語義分割的檳榔內核輪廓檢測

本部分包含三個實驗,其中實驗一用于驗證語義分割深度神經網絡中相對于輪廓檢測深度網絡方法的優越性,輪廓檢測網絡采用的是HED。實驗二用于驗證FCN-VGG在融合低層信息后提升分割效果的有效性,主要對比的網絡是FCN-VGG-8s,FCN-VGG-16s與FCN-VGG-32s。實驗三用于驗證Dilated Convolution取代常規Convolution縮減模型大小后,在提升處理速度方面的有效性,對比的網絡是FCN-VGG-8s與FCN-Dilated-VGG-8s。

實驗一、基于HED的深度神經網絡輪廓檢測實驗結果

圖9給出若干輪廓檢測示例,HED模型對大部分樣本檢測效果還不錯,但是存在以下問題:例如圖9(a)檳榔內核失水體積縮小后,在果壁與內核之間形成的縫隙對邊沿輪廓檢測造成嚴重干擾。圖9(b)由于內核與果壁灰度變化不明顯,導致無法檢測到邊緣。圖9(c)在獲取圖像時由于拍攝角度有一定傾斜,導致檳榔果壁側面對輪廓檢測造成干擾。由于HED模型檢測的輪廓還只是響應圖,不是單像素寬度的輪廓線,因此想獲得單像素寬度準確的輪廓線還需要作后續處理,而且定位精度難以保證。

實驗二、FCN-VGG-8s和FCN-VGG-16s分別是在FCN-VGG-32s網絡的基礎上融合pool_3和pool_4層特征后的模型,不同模型的分割結果示例如圖10所示。

為了體現算法優勢我們給出了分割難度相對較大的示例結果(圖10),從分割結果來看,融合低層信息后的語義網絡分割效果明顯優于沒有融合低層特征的網絡,且FCN-VGG-8s,FCN-VGG-16s與FCN-VGG-32s三個網絡中FCN-VGG-8s分割效果在細節部分明顯優于其他對比模型,這為后續輪廓邊緣提取提供了很好的初步結果。

實驗三、Dilated Convolution取代Convolution,實驗統計結果如表3所示:

在測試時我們選取了246張圖像作為驗證集,在測試五次后取平均值作為統計結果,從表3可知改進后的FCN-Dilated-VGG-8s比FCN-VGG-8s分割準確率高了0.47%,且訓練得到的模型減小到

原模型的37.5%。在顯存占用率測試時,我們將設置batch-size為1,分時輸入同一批圖像,測試五次后取平均值,最終得到相同環境下訓練期間顯存占用率減小到原模型的76.1%。在單張耗時測試時,我們取了100張圖像進行測試,也是分別測試五次取平均值作為統計結果,最終測得單張耗時縮減到原來模型的73%。綜上無論從分割效果,模型大小,顯存占用率,單張測試耗時,本文算法都有明顯優勢。

在得到語義分割的內核區域后,其邊界自然就是內核輪廓線,只要分割效果理想,輪廓線提取就很容易實現,圖11中對應示例圖所繪的綠色線部分即為該檳榔內核區域的輪廓線。

從上圖可知,Dilated-VGG-8s模型在細節部分的檢測效果明顯優于其它兩種模型,例如曲率變化較大的尖端(紅色箭頭表示處),其檢測得到的輪廓線和實際輪廓擬合的更好。同時Dilated-VGG-8s分割時單張檢測耗時只有VGG-8S的73%,顯存消耗減少了37.5%,所以無論從效率上還是硬件設備要求上,基于Dilated-VGG-8s語義分割的檳榔輪廓檢測具有明顯優勢。

4? ?結? ?論

傳統的基于傳統邊緣檢測和區域生長的輪廓檢測方法在面對復雜的、不規則的檳榔圖像時,算法魯棒性差,檢測成功率較低。為此,提出了基于語義分割的檳榔內核輪廓檢測方法。通過將FCN全連接層替換為卷積層,增加跳躍結構,將常規卷積替換成擴張卷積等改進措施,提升了全卷積FCN網絡的分割性能,在FCN-VGG-32s、FCN-VGG-16s、FCN-VGG-8s實驗對比中,本算法分割準確率最高,達到98.79%,單張圖片分割耗時減少到原來網絡的73%,在模型大小、顯存占用上有明顯優勢。

參考文獻

[1]? ? 孟繼勇. 食用檳榔自動切籽機控制系統設計[D]. 西安:西安電子科技大學,2014.

[2]? ? 高華北,張花玲,周湘暉,等. 檳榔加工業職業危害的調查[J]. 中國工業醫學雜志,2009(2):125—127.

[3]? ? JAIN N,KUMAR S,KUMAR A. Analysis of edge detection techniques using soft computing approaches[C]// Electrical,Electronics and Computer Science,IEEE,2016:1—4.

[4]? ? XIN G,KE C,HU X. An improved canny edge detection algorithm for color image[M]. IEEE,2012.

[5]? ? MANOORUBINI R,HARIPRIYA K,VIJAYARAGHAVAN R,et al. Comparison of edge detection techniques using traditional and soft computing approach[J]. International Journal of Applied Engineering Research,2014,9(2):161—166.

[6]? ? DONG Y,LI M,LI J. Image retrieval based on improved canny edge detection algorithm[C]// International Conference on Mechatronic Sciences,Electric Engineering and Computer, IEEE,2014:1453—1457.

[7]? ? RONG W,LI Z,ZHANG W,et al. An improved canny edge detection algorithm[C]// IEEE International Conference on Mechatronics and Automation,IEEE,2014:577—582.

[8]? ? GONZALEZ L C. Digital image processing solution manual (3rd edition)[J]. 北京:電子工業出版社,2017.

[9]? ? 秦倫明. 用于圖像分割的主動輪廓模型研究[D].北京:北京交通大學,2013.

[10]? XIE S,TU Z. Holistically-nested edge detection[C]// IEEE International Conference on Computer Vision,IEEE,2016:3—18.

[11]? YU Z,FENG C,LIU M Y,et al. CASENet:deep category-aware semantic edge detection[C]// Computer Vision and Pattern Recognition,IEEE,2017:1761—1770.

[12]? KRIZHEVSKY A,SUTSKEVER I,HINTON G E. ImageNet classification with deep convolutional neural networks[C]// International Conference on Neural Information Processing Systems. Curran Associates Inc,2012:1097—1105.

[13]? LONG J,SHELHAMER E,DARRELL T. Fully convolutional networks for semantic segmentation[C]// IEEE Conference on Computer Vision and Pattern Recognition. IEEE Computer Society,2015:3431—3440.