近視用戶眼動數據校正

栗戰恒 鄭秀娟 劉凱

摘 要:近視會導致用戶眼球發生形狀畸變,近視用戶眼球與視線估計中眼球參考模型的差異導致基于固定模型法得到的視線位置與用戶實際視線位置不一致,這影響了視線跟蹤的數據精度。針對以上問題,文中提出了一種基于眼球誤差模型的眼動數據校正方法。結合眼動儀使用中例行的視線標定,通過計算視線標定過程中參考點與對應的視線估計點之間關系求得近視用戶眼球與視線跟蹤中眼球參考模型之間的眼球誤差,然后根據眼球誤差計算跟蹤數據誤差,最后將誤差量補償于眼動數據,并進行了計算機仿真驗證。實驗結果表明:近視用戶眼球發生形狀畸變時其眼動數據偏差不僅與近視程度有關而且與用戶觀察點位置密切相關。數據校正前,視線估計點與真實值平均偏離誤差為48.66pixels;數據校正后,視線估計點均勻分布在真實值周圍,平均跟蹤誤差為28.02pixels,并且可以驗證,隨著觀察對象位置不同及近視程度變化,矯正后的數據偏差始終小于48pixels。說明以上提出的方法可以很好校正近視造成的眼動數據偏差。

關鍵詞:眼動儀;視線跟蹤; 校正;近視;眼動數據

中圖分類號:TP 391 文獻標識碼:A 文章編號:1672-7312(2019)04-0512-05

0 引 言

在過去的20年間,關于視線跟蹤的研究取得了很大的進步[1-2],但是由于人類眼部形狀各異,而且其大小、閉合、位置和光源等條件的差異,使得視線跟蹤技術仍舊面臨一些難題。視線估計技術有基于模型和基于回歸的2種類型。但是,大多數基于模型的視線估計方法常需要一些先驗參數,如依據Le Grand眼球模型建立的單攝像機單光源系統使用了角膜半徑經驗值C=7.7 mm,人機交互層面廣泛使用的Morimoto二次回歸模型[3]建立在Gullstrand眼球模型之上,而后者需要角膜半徑、折射率等先驗參數值,Shao等提出的2D模型的視線估計方法除了使用先驗的眼球半徑外更是假定眼球光軸視軸重合[4]。

雖然大樣本采樣建模得到的眼球固定內參數具有普適性,但對于一些個體來說并不適用,視線估計中恒定固有內參數的使用可能會導致視線估計得到的眼動數據與真實數據不一致。針對以上問題,文中提出了利用原有眼動數據進行校正的解決方案,并進行了計算機仿真實驗。

1 視線估計的影響因素

研究表明人的眼球在一定程度上與民族特征有關[5],并存在一定的個體差異。另外,近視造成的眼球畸變也會對基于模型的視線估計結果造成影響。近視被列為世界三大疾病之一,相關數據顯示全球人口近視發生率為22%。近視者眼球形狀的變化(尤其是高度近視者)使得依據先驗的眼球模型得到的眼動數據不再適用。

近年來國內外一些學者開始致力于眼動數據校正方面的研究[6-13]。其中,Biele和Kobylinski[11]、Schenk等[8]采用了誤差向量補償法;Vadillo等[13]采用了擬合矩陣法;Zhang和Hornof [14]采用了線性回歸向量法。上面提到的校正方法大多基于誤差數據本身進行數據擬合,文中由導致眼動數據偏差的眼球誤差模型出發,提出了利用原有眼動數據進行校正的解決方案,結合眼動儀使用中的視線標定,通過計算真實數據與誤差數據之間關系求得眼球誤差模型進而對眼動數據進行校正。

2 基于眼球模型的眼動數據校正

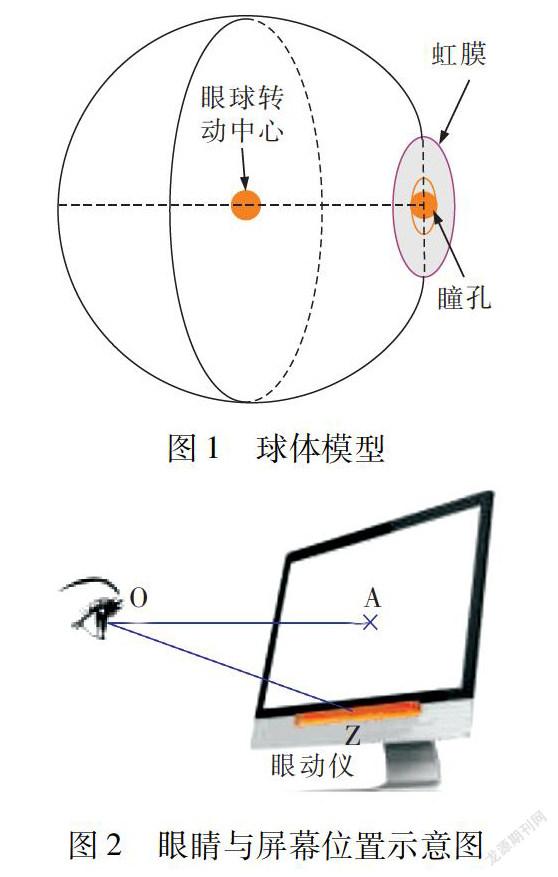

眼睛注視點的改變是靠眼球轉動來完成的。為了簡化計算,Shao等提出的模型擬合法將眼球視為圍繞一固定點旋轉的球體如圖1所示,眼球中心與瞳孔中心的連線即為用戶視線[15-16],文中根據此模型提出了眼動數據的校正方法。在眼動儀使用過程中,眼睛與屏幕位置關系如圖2所示,其中O為眼球中心,Z為眼動儀,A為眼睛正視前方時視線與屏幕的交點。對于眼動儀系統,B點位置不變,A點坐標、OZ及OA距離可通過眼動儀數據采集獲得,在以下討論中A點坐標和OA值可視為已知量。

眼動儀在使用之前要先進行一個視線標定以匹配眼動視角與屏幕坐標之間的關系,然后進行相關操作,文中提出的眼動數據校正算法借助眼動系統的視線標定過程。眼動數據校正流程可簡要概括為如下3個步驟:①由視線標定時屏幕參考點與對應的眼動視線估計點得到用戶眼球與眼球參考模型間的眼球誤差;②根據眼球誤差計算跟蹤數據誤差;③將誤差量補償于眼動數據。視線標定時,參考點坐標已知,對應的視線估計點坐標可由眼動儀得到。由于雙眼眼動數據的校正原理相同,文中以單個眼球為例進行校正原理分析。

2.1 近視用戶的數據校正

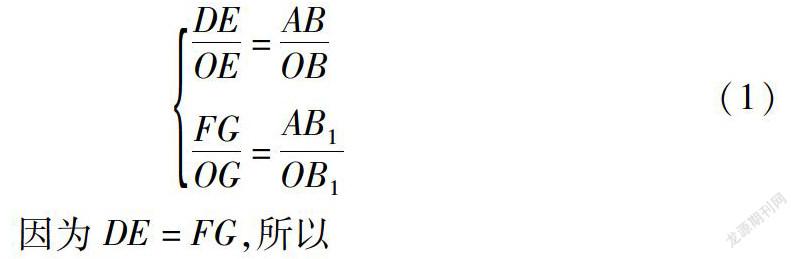

研究表明,近視患者的眼球較正視者眼球更為狹長,隨著近視屈光度數的增加,眼球前后徑、垂直徑和水平徑均有增長[17-18],近視用戶的眼球可以被假設為比正視者眼球大的球體模型。如圖3所示,虛線圓為視線估計時的眼球參考模型,實線圓為近視用戶眼球,兩圓的共同圓心為O.A為眼睛正視前方時視線與屏幕的交點,OA垂直于屏幕平面。B為視線標定時的一個參考點,B1為用戶注視B時基于模型的視線估計方法得到的視線估計點,A,B和B1在屏幕平面內共線。DE為用戶從A看向B時瞳孔在水平方向的移動距離,FG為DE在眼球參考模型上的映射,DE=FG.基于模型的視線估計方法中視線由A點移到B1點對應眼球參考模型中瞳孔在水平方向上移動距離FG.

記OE/OG為ρ,即用戶眼球與眼球參考模型半徑之比。視線標定時,A點、B點、B1點坐標及OA距離已知,易求得AB,OB,OB1及AB1距離,進而可求得ρ。對于同一受試者,其ρ值固定不變。

視線標定完成后,用戶視線點仍滿足圖3類似幾何關系。重畫圖3,這里為方便表示用戶實際視線點仍記作B,其他標注類似。進行視線估計時以上關系式仍然成立,可以推出

根據上式可以求得近視用戶的實際注視點B的坐標。

2.2 視線校正的仿真驗證

針對以上提出的校正方法采用計算機仿真進行驗證。通常眼動儀的有效跟蹤距離為50~80 cm,仿真時該距離設定為65 cm,并假設用戶正視點(用戶正視前方時,視線與屏幕的交點,對應上文中點A)位于屏幕中心,在寬高比為16∶9,屏幕分辨率為1 920×1 080 pixels的23.1英寸顯示器上進行。視線跟蹤過程中必然存在一定的眼球生理震顫和外界干擾從而造成數據誤差,我們用實驗擬合擾動誤差模型,之后將其施加于計算機仿真來模擬實際情形。顯示器屏幕被等分成9個部分,以每部分的中心作為測試參考點,并從上到下、從左到右依次編號為1,2,3,…,9.成年人眼球長度為23 mm左右,經典理論認為眼軸每延長1 mm,屈光力增加約3D[19].眼睛近視度數過高時易發生視網膜脫落,故仿真時選取近視度數范圍為0°到1 380°,對應ρ的取值范圍是1.0~1.2.

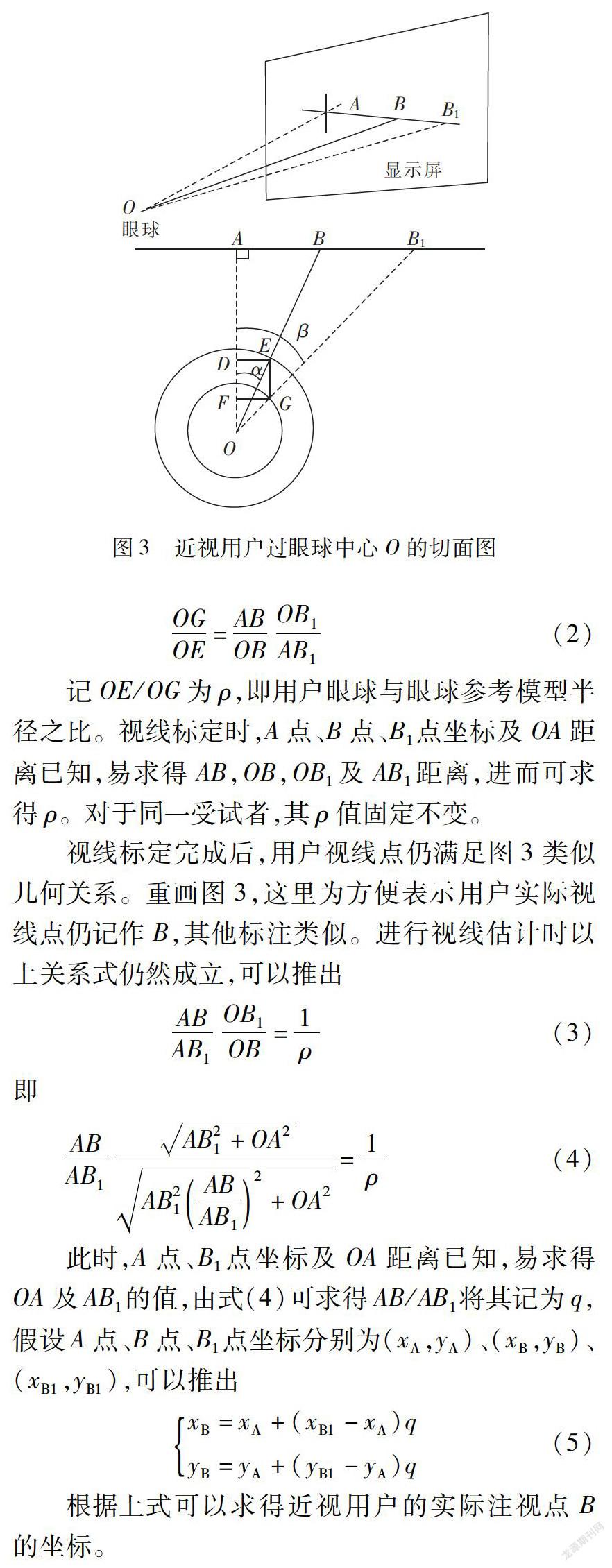

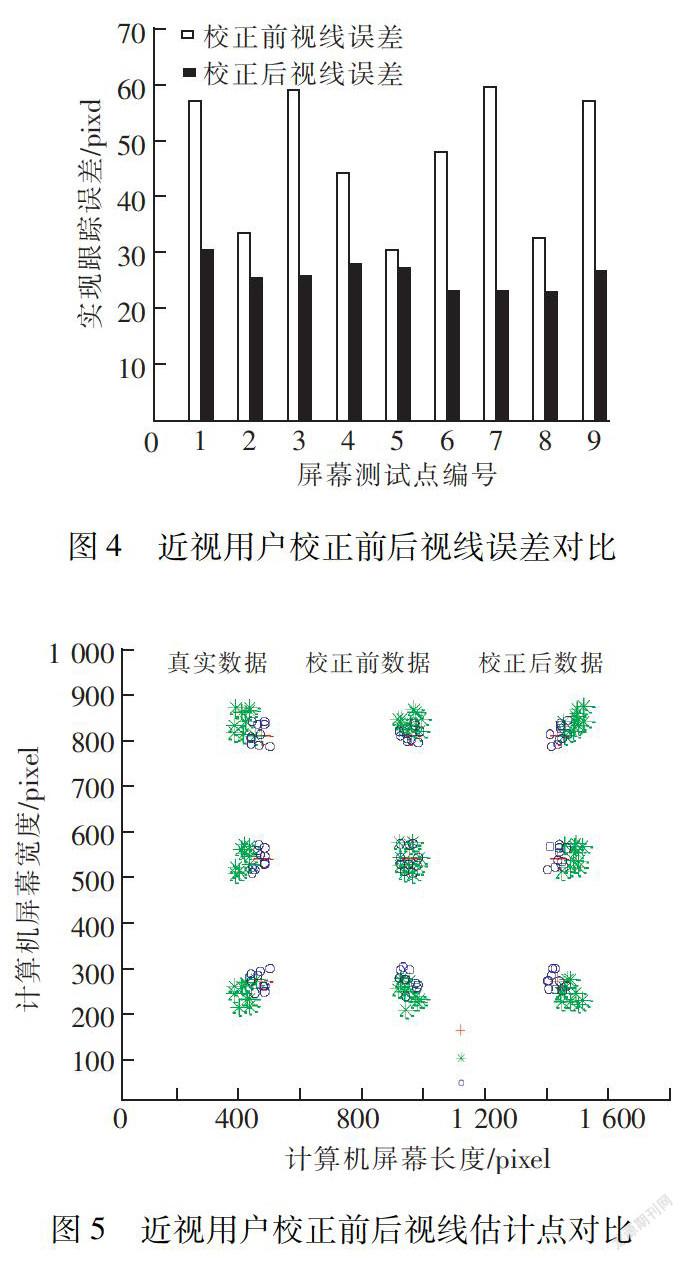

選取眼球半徑比ρ為1.1,進行了10次仿真模擬實驗。圖4為近視用戶校正前后視線誤差對比圖,圖5為校正前后視線估計點對比圖,測試點1~9表示屏幕上9個參考點。文中視線跟蹤誤差定義為參考點和所對應的視線估計點之間距離Δd的均值,單位為像素(pixel)。Δd越大,說明視線估計點位置和真實注視點位置之間的距離越遠,估計點誤差越大;反之,則估計點誤差越小。

由圖4及圖5可知,校正前各參考點的視線估計點與屏幕中心的距離均大于真實值與屏幕中心的距離,視線估計點呈現四周發散的趨勢。校正前,視線估計點與真實值偏離比較遠;校正后,視線估計點均勻分布在真實值周圍,平均跟蹤誤差為28.02 pixels(SD=3.34)。

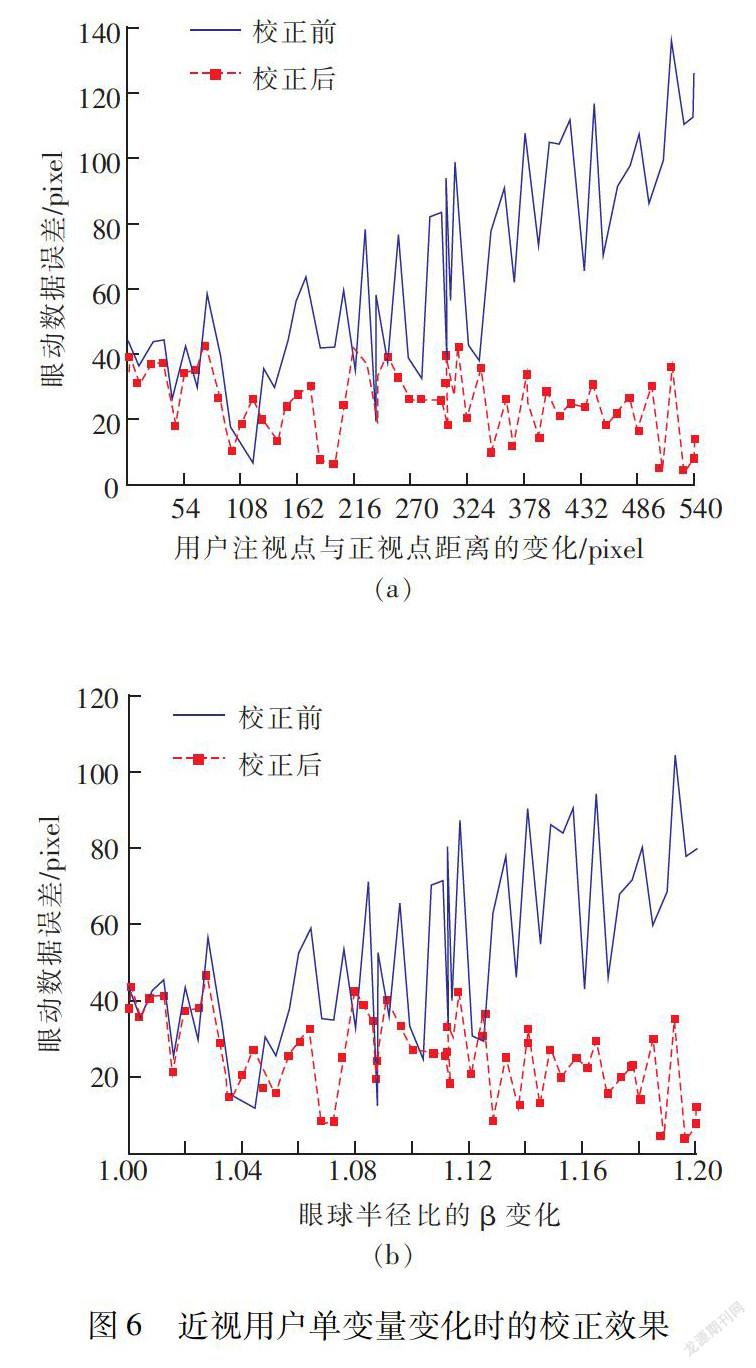

為了研究校正算法對單變量變化的校正效果,我們分別研究了用戶注視點與正視點距離、近視程度單變量變化時的校正效果。圖6(a)為選取ρ為1.1,當用戶注視點與A點的距離由0變為540 pixels時的仿真圖。顯然,校正后數據偏差穩定在±44.18 pixels范圍內,而校正前數據偏差隨著注視點與正視點距離變大逐漸變大。圖6(b)為用戶注視點與正視點距離為384 pixels,ρ從1變化為1.2時的仿真圖,隨著近視程度的加深(即ρ從1變為1.2)校正前數據偏差越來越大,校正后數據偏差穩定在±47.29 pixels的范圍內,并且可以驗證校正后數據偏差小于48 pixels。以上仿真結果說明,用戶近視時其眼動數據偏差不光與近視程度有關而且與用戶注視點位置密切相關。

3 結 語

文中對由用戶近視導致的特定情形下眼動數據不準問題提出了相應解決方案,仿真結果顯示以上校正方法十分有效。可以校正近視導致的依據固定眼球模型得到的眼動數據不準,雖然針對基于模型的視線估計方法,但對于瞳孔—角膜向量法及其他算法同樣具有參考作用(其他一些視線估計算法也在一定程度上借鑒了眼球生理模型)。文中校正算法對其他類型視線估計算法的適應性將在接下來進行研究。

文中僅列舉了近視用戶眼球誤差模型并進行了公式推導和校正說明,其他類型的眼球誤差模型校正原理相似。如,文中對近視者的校正中假設近視者眼球大于正視者的眼球,所以上述方法對用戶眼球半徑大于參考模型半徑的情形同樣適用。并且可以驗證,當用戶眼球半徑小于參考模型半徑時,上述校正算法同樣成立。雖然文中提出的校正算法對近視導致的特定類型跟蹤不準問題十分有效,但是存在一定的局限性,必須已知用戶眼病類型才可對其進行校正。對于其他類型眼動數據的校正將在接下來進行討論。

參考文獻:

[1] 李晨輝,龐志兵,張艷君,等.眼動測量在人機界面作業優化評估系統中的應用[J].技術與創新管理,2017,38(01):41-45.

[2]鄭秀娟,栗戰恒,張 昀.基于視覺特性的駕駛安全眼動研究進展[J].技術與創新管理,2018,39(01):50-59.

[3]Morimoto C H,Koons D,Amir A,et al.Pupil detection and tracking using multiple light sources[J].Image & Vision Computing,2000,18(04):331-335.

[4]Shao G,Che M,Zhang B,et al.A novel simple 2D model of eye gaze estimation[C]//International Conference on Intelligent Human-Machine Systems and Cybernetics,2010:300-304.

[5]李作勇.關于近視[J].中國眼鏡科技雜志,2000(06):30.

[6]Zhang Y,Hornof A J.Mode-of-disparities error correction of eye-tracking data[J].Behavior Research Methods,2011,43(03):834-842.

[7]Hornof A J,Halverson T.Cleaning up systematic error in eye-tracking data by using required fixation locations[J].Behavior Research Methods Instruments & Computers,2002,34(04):592.

[8]Schenk S,Dreiser M,Rigoll G,et al.GazeEverywhere:Enabling Gaze-only User Interaction on an Unmodified Desktop PC in Everyday Scenarios[C].CHI Conference,2017:3034-3044.

[9]Gibaldi A,Vanegas M,Bex P J,et al.Evaluation of the tobii eye X eye tracking controller and Matlab toolkit for research[J].Behavior Research Methods,2017,49(03):923-946.

[10]Zhang Y,Hornof A J.Easy post-hoc spatial recalibration of eye tracking data[C].Symposium on Eye Tracking Research and Applications,2014:95-98.

[11]Biele C,Kobylinski P.Surface recalibration as a new method improving gaze-based human-computer interaction[C].International Conference on Intelligent Human Systems Integration,2018:197-202.

[12]Binaee K,Diaz G,Pelz J,et al.Binocular eye tracking calibration during a virtual ball catching task using head mounted display[C].ACM Symposium on Applied Perception,2016:15-18.

[13]Vadillo M A,Street C N,Beesley T,et al.A simple algorithm for the offline recalibration of eye-tracking data through best-fitting linear transformation.[J].Behavior Research Methods,2015,47(04):1365-1376.

[14]Zhang Y,Hornof A J.Easy post-hoc spatial recalibration of eye tracking data[C].Symposium on Eye Tracking Research and Applications,2014:95-98.

[15]Kyung-Nam K,Ramakrishna R S.Vision-based eye-gaze tracking for human computer interface[C].IEEE International Conference on Systems.IEEE,1999(02):324-329.

[16]余 沁,劉龍繁,熊 艷,等.文字強調方式對多媒體學習的影響——基于眼動追蹤技術[J].生物醫學工程研究,2018,37(01):96-100.

[17]Atchison D A,Jones C E,Schmid K L,et al.Eye shape in emmetropia and myopia[J].Investigative Ophthalmology & Visual Science,2004,45(10):3380.

[18]Mutti D O,Sholtz R I,Friedman N E,et al.Peripheral refraction and ocular shape in children[J].Investigative Ophthalmology & Visual Science,2000,41(05):1022-1030.

[19]周躍華,李志輝.近視眼角膜屈光力及眼軸的測定分析[J].中華眼科雜志,1995(05):356-358.

(責任編輯:張 江)