自適應融合的長期目標跟蹤算法

劉巧玲, 劉一達(成都大學 信息科學與工程學院, 四川 成都 610106)

0 引 言

目標跟蹤是計算機視覺的重要組成部分之一,主要用于監控、人機交互和醫療圖像等方面[1].近年來, 基于相關濾波的實時目標跟蹤得到了廣泛關注,研究者們提出了大量相關目標跟蹤算法.Bolme等[2]首次提出了以均方誤差和最小為目標的相關濾波跟蹤方法,其最大優點是快速傅里葉變換求解相關操作,跟蹤速度快,但由于采樣數據有限,跟蹤算法容易受環境和目標表觀特征變化的影響.Henriques等[3]設計了一種基于循環結構的稠密采樣策略,可以盡可能多地采集樣本,又不影響目標跟蹤的執行速度,取得了很好的效果,但該算法只采用灰度特征來表征目標的表觀模型,當遇到灰度特征相近的目標時,容易造成跟蹤失敗.Danelljan等[4]使用顏色屬性(Color name,CN)擴展稠密采樣相關濾波跟蹤器,應用主成分分析對原本11維的顏色屬性進行降維,得到2維的顏色特征,改進了目標的表觀特征.Henriques等[5]采用方向梯度直方圖(Histogram of oriented gradient,HOG)特征和核函數技術來改進稠密采樣相關濾波跟蹤器,得到基于HOG特征的核相關濾波跟蹤算法,跟蹤魯棒性有了較大提高.Li等[6]將CN和HOG進行組合后用于相關濾波(Correlation filter,CF)框架,提出了SAMF跟蹤算法,實驗結果表明特征融合能夠有效提高跟蹤性能.此外,Ma等[7]提出了基于相關濾波的LCT算法,因引入再檢測模塊在長期跟蹤中性能良好.這些基于相關濾波器的跟蹤器性能優于經典算法,但并不總是如此有效地應對復雜的視頻環境.

當目標受尺度變化、嚴重遮擋、出視野或快速運動等因素影響時,基于相關濾波的跟蹤算法會出現跟蹤失敗的情況.針對這一問題,本研究在稀疏核相關濾波器(Sparse-kernel correlation filter,S-KCF)[8]的基礎上,引入顏色模型跟蹤,進行自適應融合,同時,應用了一種跟蹤失敗情況下的再檢測模塊,以響應圖最大值作為判斷跟蹤失敗和再檢測成功的標準,解決了KCF跟蹤器在跟蹤過程中目標因嚴重遮擋、出視野等因素而造成的跟蹤失敗問題,實現了長期的目標跟蹤.為驗證本研究方法的有效性,本研究利用OTB-2015評估基準[9]的100組完全標注的視頻序列進行測試,并與目前熱門的10種跟蹤算法進行對比.

1 基礎模型

1.1 S-KCF模型

核相關濾波器KCF[5]在實時跟蹤中取得了很大的成功,利用循環結構,將視覺跟蹤表述為相關濾波問題.首先,利用初始幀中目標區域的循環移位來訓練KCF模型,KCF模型用于預測下一幀的響應圖,具有最大響應值的位置即為新目標的位置.隨著跟蹤的進行,KCF模型逐步更新以適應背景變化.然而, 對于復雜場景, 傳統的KCF模型會由于許多相似的干擾物、嚴重的遮擋和光照變化而導致跟蹤失敗.

為了增強KCF模型對背景變化的魯棒性,文獻[8]提出了使用一個l0稀疏項來調整響應圖,從而抑制干擾物、遮擋和光照變化引起的高響應.典型的相關濾波器[10-11]是嶺回歸問題,

(1)

式中,f(xi)=WTφ(xi)是回歸函數,用特征空間投影器φ(·)訓練得到,{yi}是高斯形狀的響應圖,λ>0是控制過擬合的參數.

高斯型目標響應圖是稀疏的,由于干擾物在人群場景中具有相似的外觀,跟蹤器通常會生成多峰值響應圖.因此,在響應映射上添加稀疏正則化項,以便抑制不相關的響應并保留目標響應[8],

(2)

式中,Φ=[Φ(x1),…,Φ(xi)];y=[y1,…,yi]T;τ>0是控制響應圖稀疏性的參數.

在訓練過程中,稀疏約束使跟蹤器濾波器W考慮上下文變化,并將分類器的弱正響應推到0.因此,稀疏約束訓練的濾波器可以在測試集上生成稀疏響應映射.式(2)是一個NP困難問題,因為它有一個l0項.為了使式(2)易于處理,添加輔助二次約束,并重寫式(2)為,

(3)

式中,β是控制r和ΦTW相似度的參數,當β足夠大,r接近等于ΦTW.式(3)的解可以通過交替求解W和R找到,

(4)

(5)

對于核回歸(非線性),W=∑iαiφ(xi),因此,優化下的變量是α[5],可以用閉合形式求解,

(6)

式中,k是核矩陣K的第一行,矩陣K的元素為kij=φ(xi)Tφ(xi),∧表示向量的DFT,分數意味著元素級劃分,式(6)最優解r為,

(7)

式中,σ是軟閾值函數.

σ(ε,x)=sign(x)max(0,|x|-ε)

(8)

(9)

1.2 顏色模型

顏色模型[12]一般是基于廣泛使用的檢測跟蹤原理,它從邊界框集合中選擇得分最高的邊界框(給出目標位置)作為最終的測試結果,在幾幀內定位感興趣的對象.與其他基于分類器方法相比,顏色模型通過學習正樣本和負樣本來獲得參數.

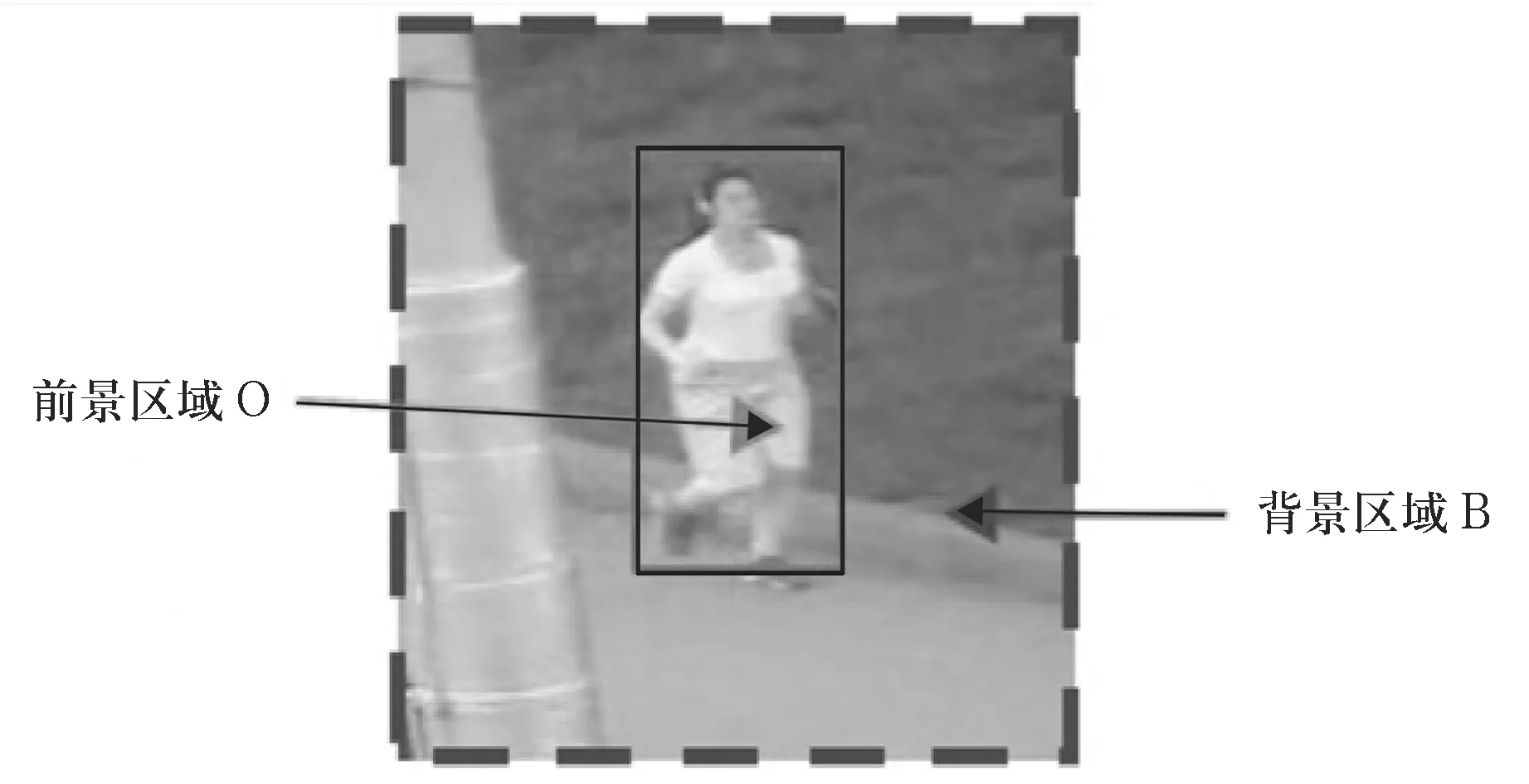

本研究采用基于RGB的顏色特征,在32×32×32的箱子空間中計算bins顏色直方圖.為了加快計算速度,在顏色模型中,Staple算法[12]將RGB空間表示的每個像素u映射到圖像32×32×32個分隔空間的索引特征j=φ(u)中.如圖1所示,在區域中的實線框內是前景區域O,實線邊框外虛線框內的區域是背景區域B.

圖1 訓練塊Td,t

假設矩陣框Td,t是從t幀估計的目標位置T周圍采樣得到的,Staple算法將Td,t分為前景區域O、背景區域B,分別計算前景區域O(與先前幀的估計目標共享大小)和背景區域B里每個特征比例.假設區域Ω∈{O,B},每個特征32×32×32個空格的比例可以用ρj(Ω)=Nj(Ω)/|Ω|來表示,其中Nj(Ω)=|{u∈Ω∶φ(u)=j}|表示區域Ω特征數量,|Ω|表示區域Ω里的總像素.因此,在線模型的ρj(O)和ρj(B)遵循以下公式,

(10)

(11)

(12)

圖2 顏色模型的響應

稱之為每一像素得分,如圖2(b)中的熱圖所示.

(13)

然后,利用固定尺寸st的滑動邊框的得分矩陣St+1,β,利用式(13)可以計算所有在Y集合中邊界框的顏色.由此,得到其他得分矩陣,

2 改進算法

2.1 自適應融合

本研究在S-KCF和顏色模型的基礎上,提出從濾波響應圖層面進行模型融合,以提升跟蹤性能,同時,為了增加融合的適應性,在對不同視頻序列進行跟蹤時對2個模型得到的響應圖進行自適應加權,以突出視頻幀中更具判別力的特征[10].

第t幀訓練中,損失差的計算簡寫如下,

(14)

式中,sum()表示對矩陣內每一項求和,F表示模型的集合.模型f對應的歸一化權重為,

(15)

式中,{F-f}表示F中不同于f的另一模型.

(16)

(17)

2.2 在線檢測

在跟蹤失敗的情況下,魯棒的長期跟蹤算法需要重新檢測模塊.當對每個幀進行再檢測時,計算復雜度很高,因此本研究提出了一種新的方法來檢測跟蹤失敗以確定何時需要激活再檢測模塊.

2.2.1 失敗檢測.

CCT跟蹤器[11]使用邊界框的重疊率來檢測跟蹤故障,但是平移估計的不準確性會導致結果不準確.本研究利用響應圖最大值來檢測,響應圖的最大響應值Rmax定義為,

Rmax=maxR

(18)

式中,R為響應圖.當前幀的準則Rmax大于其歷史平均值,并且具有一定比率時,當前幀中的跟蹤結果被認為是高置信度的.

2.2.2 對象重新檢測.

類似于CUR跟蹤器,本研究采用一個在線的CUR濾波器來重新檢測對象.但與CCT跟蹤器不同,本研究使用Rmax來確定是否更新過濾器,并且使用多通道特征來表示對象候選.CUR分解算法尋求矩陣A∈Rm×n的c列的子集以形成矩陣C∈Rm×c,r行的子集以形成矩陣R∈Rr×n,以及交矩陣U∈Rc×r,使得‖A-CUR‖ζ最小化,其中‖‖ζ是2范數或F范數.在跟蹤過程中,本研究將目標外觀表示為向量,數據矩陣A的一列.A也可以被視為歷史目標表示矩陣.根據文獻[11]中的理論,本研究用隨機抽樣的方法對數據矩陣A的c列進行抽樣,生成列矩陣C,然后對列矩陣C進行平均,從而實現目標檢測濾波器.矩陣C的列c可以從近似c=(2k/ε)(1+O(1))得到,其中,k是目標秩,ρ是A的秩,0<ε<1.

3 結果與分析

為驗證本研究算法的有效性,在配置為Matlab2016a、Intel(R)Core(TM)i5-7300 CPU、主頻2.6 GHz及8 GiB內存的平臺上,利用OTB-2015中[9]的100個完全標注的視頻數據集包含11種屬性進行評估,與目前熱門的跟蹤算法[4-15]進行了對比.OTB-2015視頻數據集[9]包含了以下11個屬性:光照變化(Illumination variation)、尺度變化(Scale variation)、遮擋(Occlusion)、形變(Deformation)、運動模糊(Motion blur)、快速運動(Fast motion)、平面內旋轉(In-plane rotation)、平面外旋轉(Out-of-plane rotation)、出視野(Out-of-view)、復雜背景(Background clutter)與低分辨率(Low resolution).

為了評估跟蹤算法的性能,本實驗采用了OTB-2015中的2種評估方法作為定量評價指標[9]:精確度圖(Precision plot)和成功率圖(Success plot).在跟蹤精度評估中,廣泛應用的是中心位置誤差(CLE).中心位置誤差定義為跟蹤目標的中心位置和手工標定的準確中心位置之間的平均歐式距離.精確度圖能夠顯示目標中心位置誤差小于閾值的幀數占視頻總幀數的百分比.實驗中閾值選定為20 pixels.成功率圖能夠顯示重疊率S大于給定閾值t0的幀數占視頻總幀數的百分比.其中,重疊率S定義為S=|Rt∩Ra|/|Rt∪Ra|,Rt為跟蹤的目標框,Ra為準確的目標框.成功率給出了閾值t0從0到1變化時,成功的幀數所占的比例,利用成功率圖曲線下的面積(AUC)作為跟蹤算法性能的評價準則.

3.1 整體性能分析

圖3為整體性能排名前10的跟蹤算法分別在SRE、TRE、OPE 3種方法下的.在OPE的精確度圖中,可以看到本研究的算法精確度為0.890,相比于KCF和LCT算法分別提高了21%和5.82%.在OPE的成功率圖中,本研究的算法成功率為0.861,相比于KCF和LCT算法分別提高了41.1%和7.48%.

圖3 排名前10跟蹤算法SRE、TRE、OPE的精確度圖和成功率圖

3.2 基于數據集屬性的性能分析

為充分評估本研究的算法跟蹤性能,利用OTB-2015視頻數據集的11個屬性進一步評估本研究算法的性能.圖4為排名前10的跟蹤算法在包含11個屬性數據集上的精確度圖.由圖4可知,本研究的算法除了在低分辨率這個屬性精度圖上排名第3位,其余10個屬性的精度圖上都排名第1位,對比其他算法中效果最好的LCT算法,在遮擋、出視野、變形和快速運動屬性精度圖上,本研究的算法分別提高了6.3%、4.5%、4.7%和15.1%.

圖4 排名前10跟蹤算法在11個屬性的精確度圖

通過整體性能、數據集屬性對比,可以看出本研究算法相對于其他算法具有更強的魯棒性.

4 結 論

本研究探討了一種有效的長期目標跟蹤算法,提出了稀疏核相關濾波和顏色模型的自適應融合.此外,本研究使用相關響應最大值來檢測完全遮擋和視野之外的跟蹤失敗,并使用在線CUR濾波器來重新檢測目標.實驗數據表明,在目標發生尺度變化、遮擋及快速運動等復雜場景下,與近年出現的幾種優秀跟蹤方法相比,本研究的算法具有更強的魯棒性.