基于生成對抗網(wǎng)絡(luò)的跨視角步態(tài)特征提取①

秦月紅,王 敏

(河海大學(xué) 計(jì)算機(jī)與信息學(xué)院,南京 211100)

步態(tài)是指走路時(shí)所表現(xiàn)的姿態(tài)和動(dòng)作,目前對于步態(tài)的研究一般是對人類步行運(yùn)動(dòng)的研究.與指紋、人臉、虹膜等不同的是,步態(tài)是唯一可在遠(yuǎn)距離非侵犯條件下獲取并利用的生物特征.心理學(xué)、醫(yī)學(xué)等領(lǐng)域的研究表明,步態(tài)具有唯一性,每個(gè)人的走路姿勢都不相同,因此步態(tài)可以用來鑒別身份.步態(tài)識別就是一種利用步態(tài)鑒別身份的技術(shù).隨著監(jiān)控視頻的覆蓋率逐漸擴(kuò)大,視頻清晰度的不斷提升,步態(tài)識別在公安刑偵、社會安全、身份認(rèn)證等領(lǐng)域逐漸發(fā)揮起重要作用[1].由此,步態(tài)識別在計(jì)算機(jī)視覺領(lǐng)域也掀起了一片研究熱潮.

然而,步態(tài)識別仍然面臨著很多挑戰(zhàn),拍攝視角、衣著、攜帶物、行走環(huán)境的變化等因素大大影響了步態(tài)識別的準(zhǔn)確率.而在眾多干擾因素中,最常見的就是拍攝視角的變化,因?yàn)樵趯?shí)際情境中人行走的方向和視頻拍攝之間的角度是最難控制且變化最多的.解決跨視角步態(tài)識別問題,是本文研究的重點(diǎn).

在深度學(xué)習(xí)領(lǐng)域,生成對抗網(wǎng)絡(luò)[2](Generative Adversarial Networks,GAN)自2014年提出以來就一直是學(xué)術(shù)界的研究熱點(diǎn),其原理為生成器和判別器的相互作用.在圖像處理方面,對于修復(fù)受損圖像、生成全新圖像等應(yīng)用場景,GAN的效果非常好.受此啟發(fā),本文通過對生成對抗網(wǎng)絡(luò)改進(jìn),將任意視角或行走狀態(tài)下的步態(tài)模板轉(zhuǎn)換成特定視角且正常狀態(tài)的步態(tài)模板,進(jìn)而去除干擾,提取有效的步態(tài)特征,從而提高步態(tài)識別的準(zhǔn)確率.

本文的結(jié)構(gòu)安排如下,第1部分介紹了近年來國內(nèi)外對于步態(tài)識別的研究成果,第2部分介紹所提出的基于生成對抗網(wǎng)絡(luò)的跨視角步態(tài)特征提取方法,第3部分展示了所提出方法與其他相關(guān)方法的的實(shí)驗(yàn)結(jié)果對比與分析,第4部分對全文進(jìn)行了總結(jié)與展望.

1 國內(nèi)外相關(guān)工作

近年來,隨著深度學(xué)習(xí)的發(fā)展,越來越多的研究人員將深度學(xué)習(xí)用于步態(tài)識別技術(shù)中.如Shiraga等人將步態(tài)能量圖作為模板,提出了基于卷積神經(jīng)網(wǎng)絡(luò)的步態(tài)識別模型GEINet[3].Wu等人在文獻(xiàn)[4]中提出的基于深度卷積神經(jīng)網(wǎng)絡(luò)的3種模型(deepCNNs)就取得了非常優(yōu)異的效果,該模型輸入為一對步態(tài)圖像,經(jīng)特征提取和計(jì)算,輸出的是兩個(gè)樣本的相似度,文中還對不同情況下三種模型的性能進(jìn)行的對比分析.

為了克服衣著和攜帶物對識別效果的影響,Liao等提出了一種從原始視頻中提取人體姿態(tài)關(guān)鍵點(diǎn)的方法[5],然后利用基于姿態(tài)的時(shí)空網(wǎng)絡(luò)學(xué)習(xí)步態(tài)特征.Feng等提出了基于長短時(shí)記憶模塊的人體姿態(tài)估計(jì)模型[6],針對人體關(guān)節(jié)熱圖進(jìn)行特征提取.

為了解決跨視角步態(tài)識別問題,一些研究人員試圖利用3D重建的方法,以通過在所需視角下投影3D模型來生成任意的二維視圖,但這種方法通常需要嚴(yán)格的環(huán)境條件和巨大的計(jì)算代價(jià).目前,解決跨視角問題最常見的方法是構(gòu)建能夠?qū)⒉綉B(tài)特征從一個(gè)視圖投影到另一個(gè)視圖的轉(zhuǎn)換模型.Makihara等[7]提出了一種視圖轉(zhuǎn)換模型,主要是利用奇異值分解的方法計(jì)算每個(gè)步態(tài)能量圖的投影矩陣并計(jì)算出視角特征值.受魯棒的主成分分析在特征提取上的良好表現(xiàn)的啟發(fā),Zheng等[8]提出了一種魯棒的視圖轉(zhuǎn)換模型用于步態(tài)識別.Bashir等[9]提出了一種基于高斯過程的框架來預(yù)估測試集中的步態(tài)視角的方法,然后運(yùn)用典型相關(guān)分析得出不同視角的步態(tài)序列的相關(guān)性.此外,Yu等人在文獻(xiàn)[10]中提出了一種用自動(dòng)編碼器(SPAE)去除來自于攜帶物、衣著等影響因素,之后將不同視角的步態(tài)模板特征轉(zhuǎn)換到統(tǒng)一側(cè)面視角的模型.但訓(xùn)練自動(dòng)編碼器過程較為復(fù)雜,要按照任務(wù)拆分從下至上依次訓(xùn)練,逐層累加,各層累加完畢后要對整個(gè)網(wǎng)絡(luò)重新調(diào)整.

受GAN在多領(lǐng)域圖像翻譯上的優(yōu)秀效果的啟發(fā),本文提出了一種基于生成對抗網(wǎng)絡(luò)跨視角的步態(tài)特征提取方法,主要思想是步態(tài)模板的多視角和多狀態(tài)轉(zhuǎn)換.生成對抗網(wǎng)絡(luò)是一種深度學(xué)習(xí)模型,是近年來復(fù)雜分布上的無監(jiān)督學(xué)習(xí)領(lǐng)域中最具前景的方法之一.例如,Choi等人在2017年提出的StarGAN[11]模型在人臉表情、發(fā)色轉(zhuǎn)換的效果非常驚人,堪稱GAN在多領(lǐng)域圖像翻譯中的典型成功案例.GAN的實(shí)現(xiàn)方法是讓生成器和判別器進(jìn)行博弈,訓(xùn)練過程中通過相互競爭讓這兩個(gè)模型同時(shí)得到增強(qiáng).Yu等在2017年提出的GaitGAN[12]就是將GAN用于視角轉(zhuǎn)換來進(jìn)行步態(tài)特征提取,與傳統(tǒng)GAN不同的是,GaitGAN使用了兩個(gè)判別器來確保生成圖片真實(shí)且保留有效的身份信息.但這種方法只是把任意視角的步態(tài)模板轉(zhuǎn)換成了側(cè)面視角的步態(tài)模板,并不能應(yīng)對實(shí)際情況中復(fù)雜的多視角變換問題.此外,He等人在2019年提出的MGANs[13]也是一種基于GAN的多任務(wù)視角轉(zhuǎn)換模型,該文首次將流形學(xué)習(xí)的概念引入步態(tài)視圖特征轉(zhuǎn)換,同時(shí)還提出了一種新的步態(tài)模板周期能量圖(PEI).

2 基于生成對抗網(wǎng)絡(luò)的步態(tài)特征提取

2.1 算法整體框架

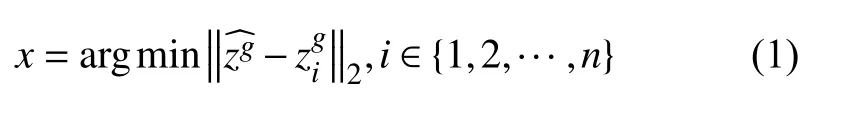

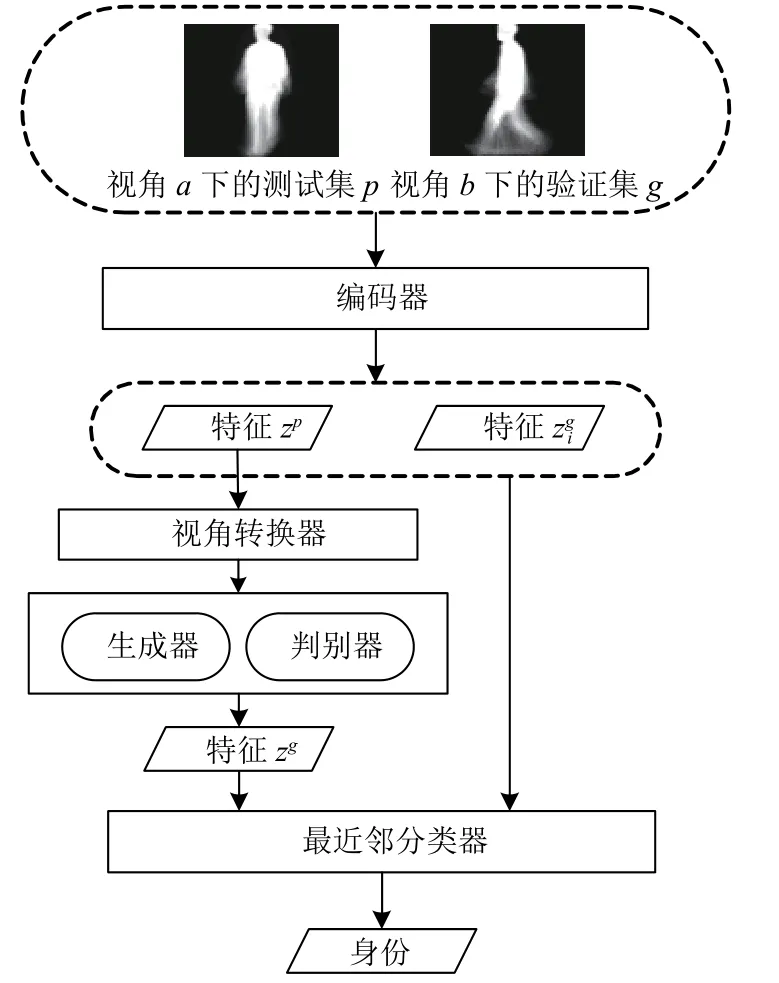

圖1給出了整個(gè)算法的流程圖.首先,所有測試集、訓(xùn)練集和驗(yàn)證集的步態(tài)視頻序列都被統(tǒng)一處理成同一種步態(tài)模板.對于測試集中的一個(gè)a視角下的測試樣本pa,驗(yàn)證集是含有n個(gè)樣本的b視角下的某種行走狀態(tài)的樣本集合假定pa一定與上述驗(yàn)證集中的某個(gè)樣本具有相同身份,我們的目標(biāo)就是確定pa的身份是{1,2,…,n}中的哪一個(gè).具體過程是,測試樣本的步態(tài)模板pa首先經(jīng)過一個(gè)編碼器E編碼得到隱特征zp=E(pa),然后經(jīng)過一個(gè)視角轉(zhuǎn)換器V把zp從視角a轉(zhuǎn)換到視角b,得到視角轉(zhuǎn)換后的特征隱表示zg=V(zp,a,b).將zg以及行走狀態(tài)的標(biāo)簽聯(lián)合輸入到生成對抗網(wǎng)絡(luò)中的生成器,得到視角b下的正常行走狀態(tài)的假特征模板的隱表示.在整個(gè)算法模型中,對生成器和判別器的訓(xùn)練是尤為重要的,通過對生成器與判別器進(jìn)行迭代交叉訓(xùn)練,使得所得到的在達(dá)到視圖轉(zhuǎn)換的同時(shí)最大化的保留身份信息.對于驗(yàn)證集中的所有步態(tài)模板gbi同樣經(jīng)過E的編碼得到隱特征其中i∈{1,2,…,n}.最終確定pa的身份是視角b驗(yàn)證集中的gbx,利用最近鄰分類器的計(jì)算公式如下:

其中,‖·‖2代表L2范數(shù).

圖1 算法流程圖

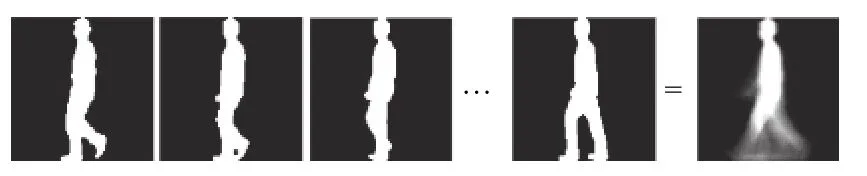

2.2 步態(tài)能量圖

本文提出的算法使用的步態(tài)模板為步態(tài)能量圖[14](GEI).在還沒有運(yùn)用深度學(xué)習(xí)的方法研究步態(tài)識別問題時(shí),Han等人在文獻(xiàn)[14]中提出的利用GEI和主成分分析進(jìn)行數(shù)據(jù)降維的方法(GEI+PCA)在正常行走狀態(tài)下就取得較好的效果,只是該方法較易受到衣著、攜帶物、視角變化等因素的影響.GEI是步態(tài)識別技術(shù)中最常用的步態(tài)模板,具有計(jì)算簡便且能保留原有的步態(tài)序列的周期性的特點(diǎn).簡單來說,步態(tài)能量圖就是一個(gè)完整周期內(nèi)的所有步態(tài)剪影圖的平均,如圖2所示.

圖2 步態(tài)能量圖的合成過程

GEI中的像素值可以解釋為一個(gè)步態(tài)周期內(nèi),人體占據(jù)GEI中像素位置的概率.由于GEI在步態(tài)識別中的成功應(yīng)用,本文也采用GEI作為輸入的步態(tài)模板.本文提取GEI的方法與Zheng等人在文獻(xiàn)[8]中提出的方法相同.

2.3 基于生成對抗網(wǎng)絡(luò)的跨視角步態(tài)特征提取

本文提出的基于生成對抗網(wǎng)絡(luò)的跨視角步態(tài)特征提取模型主要包含4個(gè)部分:(1)基于卷積神經(jīng)網(wǎng)絡(luò)的編碼器用于對GEI中的特征進(jìn)行編碼;(2)視角轉(zhuǎn)換器用來將一個(gè)視角的步態(tài)模板轉(zhuǎn)換到另一個(gè)視角;(3)生成器用于生成視角轉(zhuǎn)換之后的假GEI;(4)判別器用于判斷生成器生成的圖像的真實(shí)性并判斷其是否保留了原有輸入的身份信息.接下來對每部分進(jìn)行具體介紹.

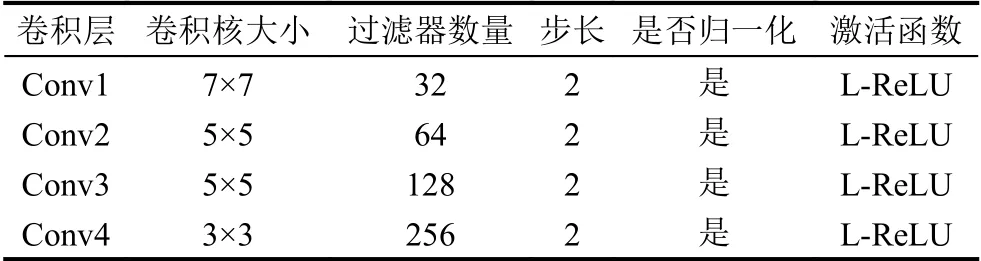

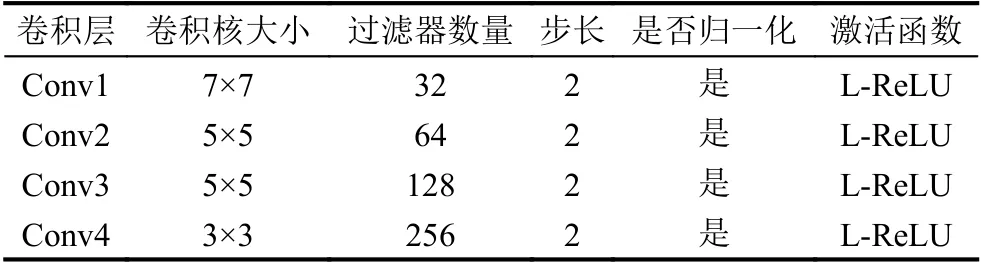

2.3.1 編碼器

為了獲得有用的特征進(jìn)行步態(tài)識別,本文提出的模型中引入了一個(gè)基于卷積神經(jīng)網(wǎng)絡(luò)的編碼器,具體結(jié)構(gòu)如表1所示,其主要由4個(gè)卷積層構(gòu)成.在特征提取的最初階段,輸入是a視角下的步態(tài)能量圖pa.為了減少計(jì)算量,提高訓(xùn)練速度,圖片尺寸縮放為64×64像素.之后使用均值池化并經(jīng)過全連接層得到步態(tài)特征隱表示zp.非線性激活層采用L-ReLU函數(shù).

表1 編碼器的組成

2.3.2 視角轉(zhuǎn)換器

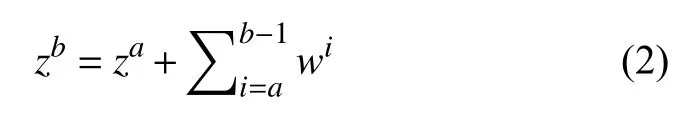

在跨視角的步態(tài)識別問題中,如何在保留步態(tài)模板的身份特征的情況下轉(zhuǎn)換其視角非常關(guān)鍵.根據(jù)流形學(xué)習(xí)的理論,我們所觀察到的數(shù)據(jù)實(shí)際上是由一個(gè)低維流形映射到高維空間的.可以假設(shè)輸入的步態(tài)模板位于一個(gè)低維的流形上,沿著該流形移動(dòng)的樣本可以實(shí)現(xiàn)視角的轉(zhuǎn)換[13].從視角a到視角b的轉(zhuǎn)換過程可以用如下公式表示:

其中,za和zb是經(jīng)過編碼器編碼后得到的步態(tài)特征隱表示,wi表示從視角i–1到視角i的轉(zhuǎn)換向量.與傳統(tǒng)的視角轉(zhuǎn)換方法不同的是,本文提出的模型是將視圖的特征轉(zhuǎn)換到一個(gè)隱空間.具體的轉(zhuǎn)換過程是通過沒有偏置的全連接層來完成的,從而減少重建視圖所積累的錯(cuò)誤.全連接層的權(quán)重可以表示為nb表示角度的標(biāo)簽,每個(gè)角度對應(yīng)一個(gè)權(quán)值.因此,編碼視角a到b的過程用向量可以表示為其中eiab∈{0,1},進(jìn)而視圖轉(zhuǎn)換過程可以表示為如下公式:

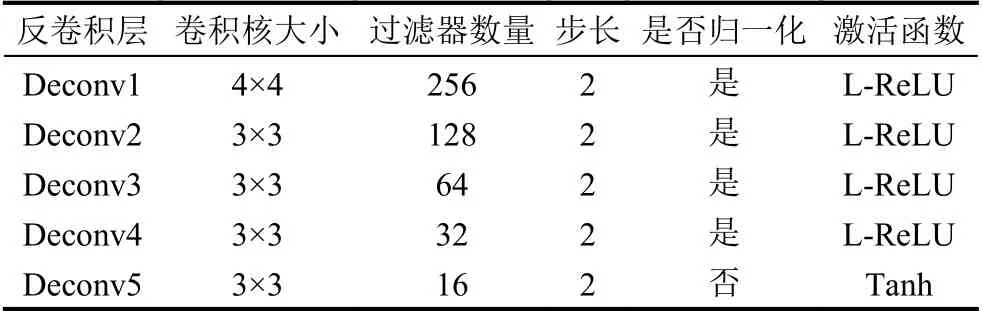

2.3.3 生成器

視角轉(zhuǎn)換器的輸出就是生成器的輸入,主要由5個(gè)反卷積層構(gòu)成,具體參數(shù)如表2所示.生成器的作用是生成與真實(shí)GEI難以區(qū)分的假圖片,但由于步態(tài)識別的結(jié)果受衣著、攜帶物等不同行走狀態(tài)的影響,所以本文方法中引入了行走狀態(tài)的獨(dú)熱編碼作為標(biāo)簽來控制輸出的GEI的行走狀態(tài)為正常狀態(tài),從而消除穿大衣、背包等干擾因素.定義生成器的輸入是[zb,c],其中zb是經(jīng)過視角轉(zhuǎn)換后的視角b下的步態(tài)特征隱表示,c為需要生成的行走狀態(tài)的獨(dú)熱編碼,通過生成器的反卷積過程得到重構(gòu)后的步態(tài)能量圖yb.

表2 生成器的組成

2.3.4 判別器

判別器的主要任務(wù)有兩個(gè):(1)判斷生成圖片的真實(shí)性;(2)判別該生成圖片的域是否為指定的角度域和狀態(tài)域.與編碼器類似,判別器主要由4個(gè)卷積層構(gòu)成,具體參數(shù)如表3所示.判別器的輸入為生成器生成的假圖片yb和真實(shí)圖要注意這里的應(yīng)是與生成的yb所指定的角度域、狀態(tài)域一致的真實(shí)GEI.通過對生成器和判別器的迭代訓(xùn)練,可以確保生成器生成足夠真實(shí)且保留原有身份信息的假GEI.

表3 判別器的組成

2.4 目標(biāo)函數(shù)

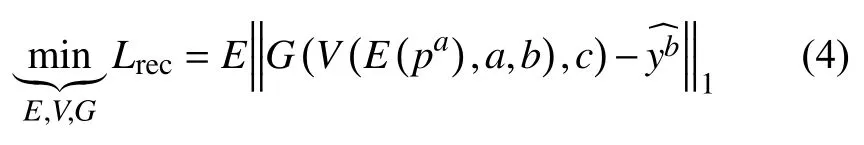

2.4.1 重構(gòu)損失

為了使生成圖像盡可能多的保留原始身份信息,最為重要的就是將真實(shí)圖與生成圖的逐像素?fù)p失最小化,因此提出了重建損失,公式如下:

其中,∥ ·∥1代表L1范數(shù),E、V、G分別表示編碼器,視角轉(zhuǎn)換器和生成器,pa是a視角下的原始輸入GEI,c表示行走狀態(tài)的獨(dú)熱編碼,是真實(shí)的GEI.

2.4.2 對抗損失

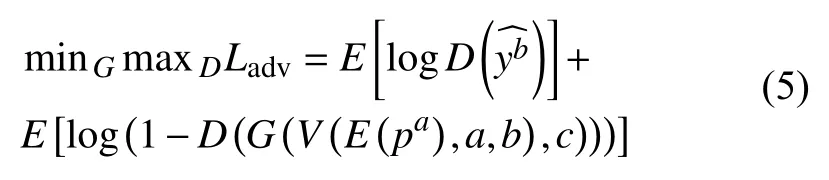

對于生成器和判別器的訓(xùn)練,我們采用的是常見的對抗損失,公式如下:

其中,E、V、G、D分別代表編碼器、視角轉(zhuǎn)換器、生成器和判別器,pa是a視角下的原始輸入GEI,c表示行走狀態(tài)的獨(dú)熱編碼,是真實(shí)的GEI.

2.4.3 目標(biāo)損失函數(shù)

最終的關(guān)于E、V、G、D的最終目標(biāo)損失函數(shù)定義如下:

其中,λ是用來調(diào)節(jié)重建損失和對抗損失的所占比重的超參數(shù),在本文提出的算法訓(xùn)練過程中,λ=0.0001.定義最終損失函數(shù)后,使用反向傳播算法對編碼器、視角轉(zhuǎn)換器、生成器和判別器進(jìn)行訓(xùn)練.

3 實(shí)驗(yàn)與分析

3.1 數(shù)據(jù)集

3.1.1 CASIA-B數(shù)據(jù)集

CASIA-B步態(tài)數(shù)據(jù)集[15]是中國科學(xué)院自動(dòng)化研究所提供的開源跨視角數(shù)據(jù)集,其中包括124人(31女,93男),拍攝視角有11個(gè)(從0°到180°,每18度為一個(gè)間隔),三種行走狀態(tài).每人有10個(gè)視頻序列,6個(gè)為正常行走狀態(tài)(nm01–nm06),2個(gè)為穿大衣行走狀態(tài)(cl0,cl02),2個(gè)為背包行走狀態(tài)(bg01,bg02).

3.1.2 OUMVLP數(shù)據(jù)集

OUMVLP數(shù)據(jù)集[16]是目前規(guī)模最大的多視角步態(tài)數(shù)據(jù)集,由日本大阪大學(xué)提出,其中包括10 307個(gè)人(5114男和5193女),年齡范圍從2到87歲,每人有14個(gè)視角(0°,15°,…,90°;180°,195°,…,270°)和兩個(gè)視頻序列(#00作為驗(yàn)證集,#01作為測試集).

3.2 實(shí)驗(yàn)設(shè)計(jì)

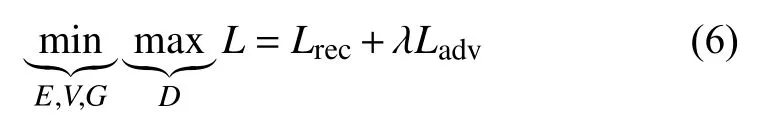

對于CASIA-B數(shù)據(jù)集,實(shí)驗(yàn)中我們規(guī)定前62人(ID:001-062)作為訓(xùn)練集,后62人(ID:063-124)作為驗(yàn)證集,并將測試集分為正常行走(nm)、背包(bg)、穿大衣(cl)及3種狀態(tài)混合(all)共4類,分別進(jìn)行4組實(shí)驗(yàn),具體見表4.訓(xùn)練過程的迭代次數(shù)為80 000次,學(xué)習(xí)率為1×10–5.

表4 CASIA-B實(shí)驗(yàn)設(shè)計(jì)

對于OUMVLP數(shù)據(jù)集,為了驗(yàn)證模型的魯棒性,便于與CASIA-B數(shù)據(jù)集做比較,實(shí)驗(yàn)中我們從所有人中隨機(jī)抽取62人作為訓(xùn)練集,再從剩下的人中隨機(jī)選擇幾組(62人為一組)作為驗(yàn)證集(#01)和測試集(#00).

3.3 實(shí)驗(yàn)結(jié)果與分析

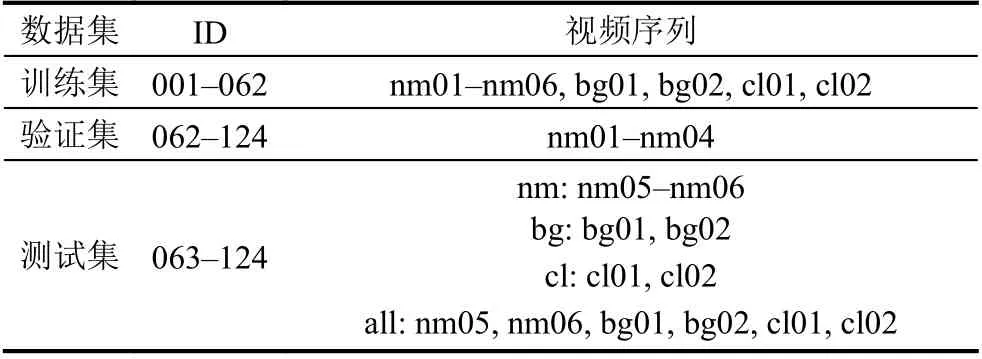

經(jīng)過在CASIA-B數(shù)據(jù)集上的實(shí)驗(yàn),3種行走狀態(tài)下與所有情況下的平均rank-1準(zhǔn)確率如表5所示.

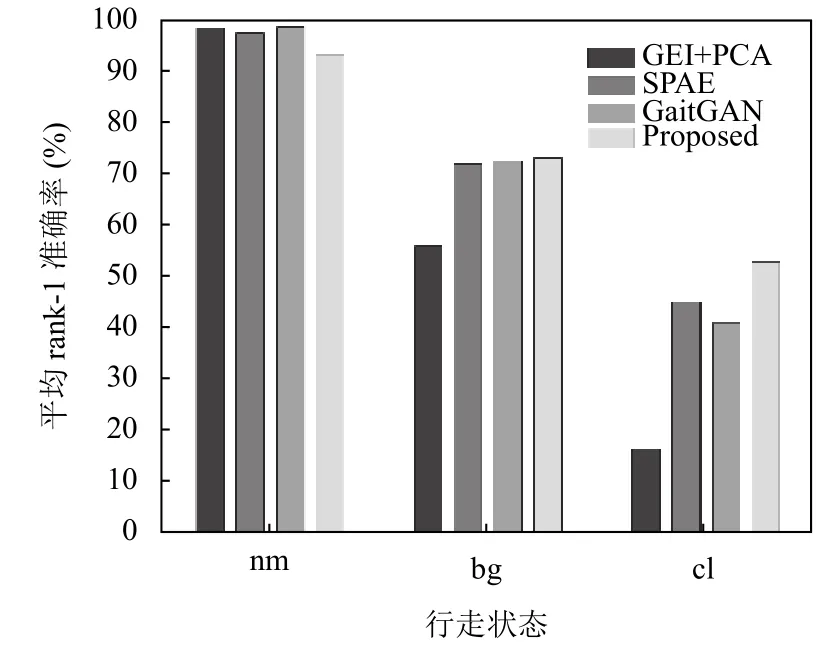

為了對實(shí)驗(yàn)結(jié)果更加直觀的進(jìn)行分析,我們選擇了3種在非跨視角情況下取得較好識別效果的方法(GEI-PCA[14],SPAE[10],GaitGAN[12])在同樣數(shù)據(jù)集上的平均rank-1準(zhǔn)確率進(jìn)行了對比.圖3為測試集與驗(yàn)證集視角相同條件下識別準(zhǔn)確率的柱狀圖,從圖中可以看出在nm和bg狀態(tài)下,本文提出的方法與其他3種方法沒有較大優(yōu)勢,但在cl狀態(tài)下,識別準(zhǔn)確率有所提升,驗(yàn)證了本文方法對于衣著這個(gè)干擾因素具有更好的適應(yīng)性.

表5 3種行走狀態(tài)下的平均rank-1準(zhǔn)確率(單位:%)

圖3 同視角下的平均rank-1準(zhǔn)確率比較

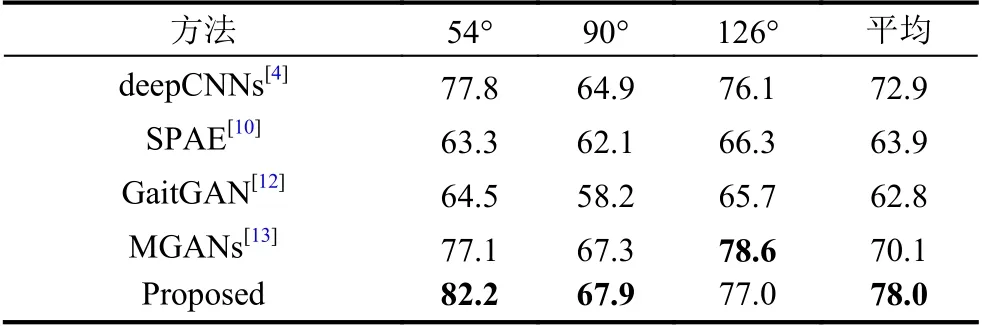

為了更好驗(yàn)證本文方法是否在跨視角步態(tài)識別上更具優(yōu)勢,在排除相同視角的情況下,我們選取了54°、90°和126°三種典型視角與 deepCNNs[4]、SPAE[10]、GaitGAN[12]及MGANs[13]4種方法進(jìn)行了比較,這4種方法代表了近年來利用深度學(xué)習(xí)進(jìn)行跨視角步態(tài)識別研究的最先進(jìn)成果.具體結(jié)果如表6所示.

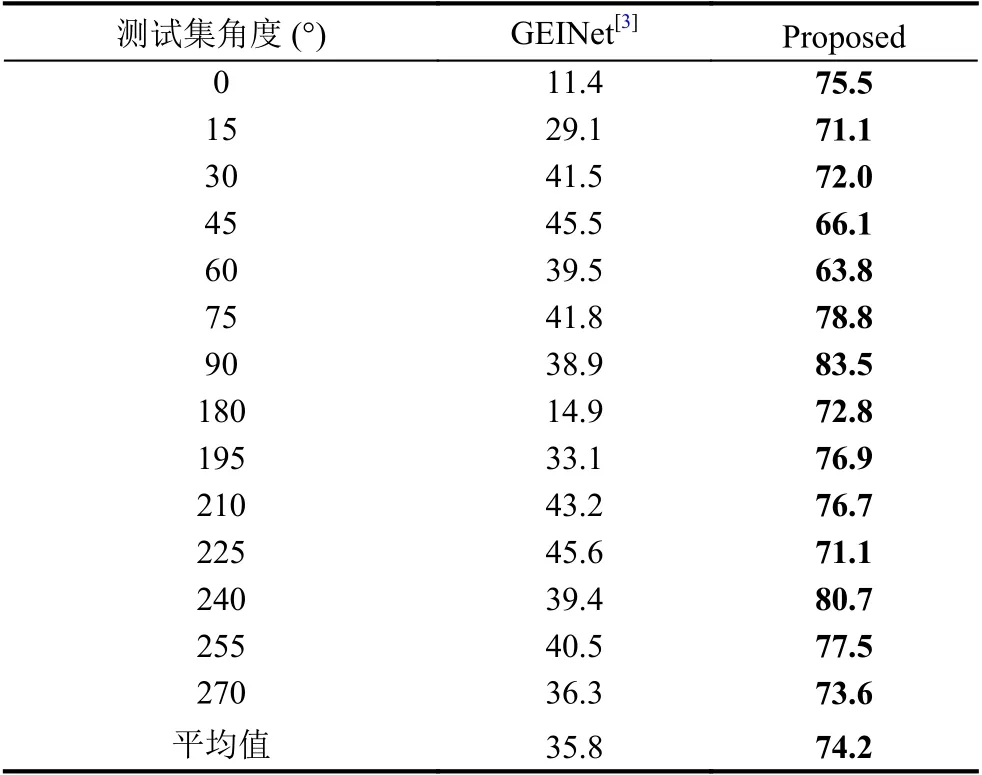

由于幾年來在OU-MVLP數(shù)據(jù)集上的實(shí)驗(yàn)數(shù)據(jù)不多,所以下面只選擇了GEINet[3]與本文提出的實(shí)驗(yàn)結(jié)果進(jìn)行比較,如表7所示.

綜合2個(gè)數(shù)據(jù)集上的實(shí)驗(yàn)結(jié)果可以得出結(jié)論,在測試集與驗(yàn)證集視角不一致的情況下,本文提出的方法的平均rank-1準(zhǔn)確率具有大幅度的提升,因此,該方法能較好地解決跨視角步態(tài)識別問題.

表6 CASIA-B排除相同視角下3種典型視角的識別準(zhǔn)確率 (單位:%)

表7 OU-MVLP排除相同視角下的rank-1準(zhǔn)確率 (單位:%)

3.4 模型評估

結(jié)合3.3部分的實(shí)驗(yàn)結(jié)果,不難發(fā)現(xiàn),在相同視角的步態(tài)識別問題上,本文提出的模型雖然不是最優(yōu)但并沒有顯著劣勢,且在穿著大衣的干擾因素下與其他方法相比具有更好的效果.在跨視角步態(tài)識別問題上,本文方法的平均rank-1準(zhǔn)確率有了大幅度的提升.這主要由于本文提出的模型在同視角識別的狀態(tài)下,與傳統(tǒng)深度學(xué)習(xí)方法相比沒有做出過多改進(jìn),而在跨視角識別問題和攜帶物、衣著變化上則具有一定優(yōu)勢.

此外,隨著行走狀態(tài)的改變,從表5可以看出,3種情況對于步態(tài)識別準(zhǔn)確率的影響程度是cl>bg>nm,這與以往研究結(jié)果一致.這是由于步態(tài)識別最重要的部分在于提取腿部特征,所以在穿著大衣的情況下能保留的腿部有效信息是最少的,所以該情況下識別準(zhǔn)確率會收到較大影響.對于跨視角步態(tài)識別問題,觀察表5不難發(fā)現(xiàn),視角在90°左右的識別效果較好,而在0°和180°附近時(shí)識別效果較差.這是由于在90°狀態(tài)下,可以提取到的腿部變化的信息是最多的,隨著跨度增大,提取的有效信息逐漸變少,從而導(dǎo)致不同視角下的識別準(zhǔn)確率差異較大.

綜上所述,本文提出的模型能較好的解決跨視角步態(tài)識別問題,且在行走狀態(tài)變化情況下具有一定的魯棒性,實(shí)驗(yàn)結(jié)果也驗(yàn)證了該方法是有效且可行的.

4 結(jié)論與展望

本文提出了一種基于生成對抗網(wǎng)絡(luò)的步態(tài)特征提取方法,能有效緩解拍攝視角、衣著和攜帶物變化等因素對步態(tài)識別結(jié)果的影響,在CASIA-B和OUMVLP數(shù)據(jù)集上的實(shí)驗(yàn)結(jié)果驗(yàn)證了本文提出的方法可以對步態(tài)模板進(jìn)行任意角度的轉(zhuǎn)化并提取出包含有效身份信息的步態(tài)特征.同時(shí),與現(xiàn)有的其他方法的比較也表明本文的方法是有效且可行的.

然而,目前所做的工作還不夠,實(shí)驗(yàn)所用的數(shù)據(jù)集的規(guī)模還比較小,識別準(zhǔn)確率也還不夠高.今后,在訓(xùn)練階段要使用更大規(guī)模的數(shù)據(jù)集,使用網(wǎng)絡(luò)結(jié)構(gòu)更復(fù)雜且更具魯棒性的模型.相信未來生成對抗網(wǎng)絡(luò)的發(fā)展會更好,使得包括步態(tài)識別在內(nèi)的其他問題取得新的研究突破.