智能汽車環境感知算法及測試評價方法分析

白林

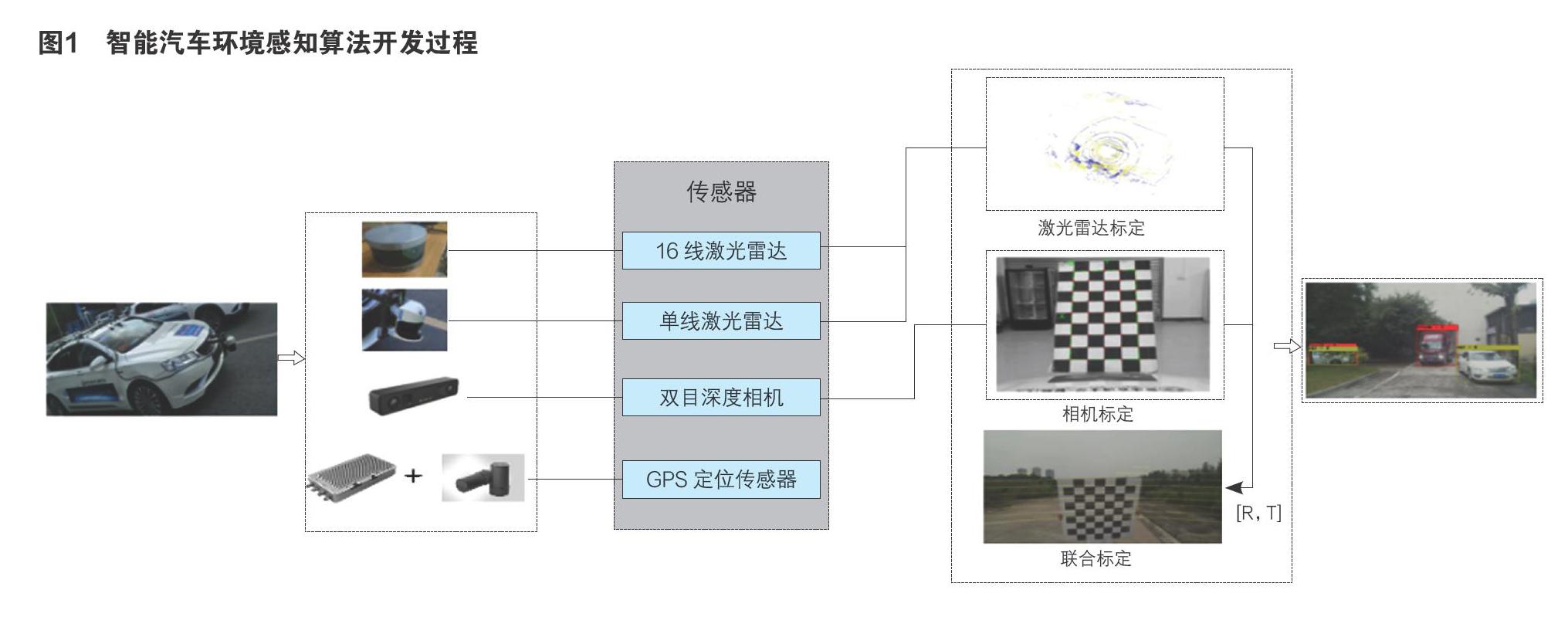

摘 要:針對智能汽車環境感知技術開發應用,從傳感器角度和算法角度分析智能汽車環境感知算法開發應用存在的問題。根據智能汽車環境感知算法開發的過程,對傳感器標定算法、單一傳感器環境感知算法、多傳感器信息融合環境感知算法及智能汽車環境感知算法測試評價方法進行分層分析,通過分層分析闡述智能汽車環境感知算法及測試評價方法的開發應用。展望智能汽車環境感知算法的未來發展趨勢。

關鍵詞:智能汽車;信息融合;環境感知;測試評價

1 前言

可靠的環境感知技術是智能汽車發展的基礎,然而環境感知技術到目前為止還存在著大量的技術瓶頸。從傳感器角度考慮,現有的傳感器都存在一些缺陷;如相機受光照變化、遮擋等因素影響嚴重,在沒有光源的夜晚會徹底失效;激光雷達在雨天受影響很大;基于GPS的定位系統穩定性較差。從算法角度考慮,大多數算法對環境變化的適應性不夠好。綜上,環境感知技術目前還存在大量急需解決的問題,基于多源信息融合的環境感知成為智能汽車環境感知技術向可靠、安全方向發展。

據智能汽車環境感知算法開發的過程,對傳感器標定算法、單一傳感器環境感知算法、多傳感器信息融合環境感知算法及智能汽車環境感知算法測試評價方法進行分層分析。

2 傳感器標定算法分析研究

傳感器標定是環境感知算法開發的基礎,相機通過標定可以解算相機內外參數,利用內外參數可以求解圖像坐標系對應用的世界坐標系,利于進行視覺環境感知算法的開發。雷達通過聯合相機標定可以確定雷達坐標系與相機坐標系之間進行旋轉和平移的變換關系,利于多傳感器信息融合,進行環境感知算法開發。相機雷達的外參標定是標定存在難點, Zhou L等[1]人針對棋盤圖像平面參數估計誤差之間的質量問題,提出了幾何約束,將旋轉與平移解耦,以減小這種相互作用的影響。引入表示棋盤平面單位法向量不確定度的權重,對每對圖像和激光雷達掃描質量進行綜合評價。Gong X等[2]人提出了一種解決三維激光雷達和攝像機組成的系統外參標定問題的方法,根據三面提物體相關的幾何約束表示,利用非線性最小二乘(NLS)問題對兩個傳感器之間的相對變換進行標定。利用多傳感器聯合標定得到的空間變換矩陣[R,T],可對多傳感器信息進行融合。

其中PL為雷達坐標系,Pc為相機坐標系,R,T分別為旋轉矩陣和平移向量。

3 智能汽車視覺感知算法分析研究

視覺感知本質是對圖像中的目標進行特征提取和分類,并進行判斷是否為檢測目標。目前基于深度神經網絡的目標檢測算法是視覺領域的主流之一,主要包括兩方面:基于候選區域的目標檢測算法和基于回歸方法的目標檢測算法。在基于候選區域的目標檢測算法方面,Ren, S等[3]人提出區域提議網絡(RPN)對輸入圖像進行預處理,預測目標位置和每個對應位置的置信度分數,并共享卷積特征給檢測網絡進行多目標檢測。基于區域提議網絡,Cai Z,Vasconcelos N等[4]人提出級聯RPN改進區域提議質量,目標識別上修改全局信息模型,提升目標檢測的準確性和檢測速度。雖然基于RPN的目標檢測檢測算法提升一定程度的準確性,但對不同尺度的目標檢測仍存在較大問題,應用多尺度特征表示結合卷積神經網絡的算法(MFR-CNN)[5]能有效解決不同尺度大小的目標檢測。為提高對交通標志等小目標的檢測,Habibi Aghdam H等[6]人提出輕量級ConvNet算法,從平均精度、每秒處理數據幀數及穩定提升對小目標檢測。在基于回歸方法的目標檢測算法,主要是通過遞歸思想,將目標檢測構建為一個回歸問題,利用深度神經網絡預測目標的位置和置信度分數,進行有效的目標檢測[7] [8]。利用文獻[7]采用的方法進行環境感知,實驗結果如下:

4 基于多源信息融合智能汽車環境感知算法分析研究

多源信息融合的環境感知算法能有效彌補單個傳感器或者基于視覺感知算法對環境感知的不足,有效的對環境中目標進行檢測識別。這主要是因為常見的傳感器相機雖然能夠獲得豐富的顏色和紋理信息,但對于光照和陰影變化非常敏感[9],這對系統魯棒性要求極其高的自主車感知系統并不適用。因此如何融合多源信息,充分挖掘不同傳感器優勢并實現更為魯棒的目標檢測效果成為許多研究人員的關注熱點。

激光雷達因為具有極高的工作穩定性和提供精確的物體信息,近年來得到廣泛應用。相機與雷達等多源信息融合是目前研究的主要熱點之一。在行人檢測方面,汪軍[9]提出融合雷達與相機并進行行人檢測的方法。將雷達分割作為弱分類器,將基于視覺的行人分類器作為強分類器,結合雷達前后幀關聯結果整合多幀檢測信息,將多幀多傳感器檢測結果以投票策略的方式共同給出。在動態目標檢測方面,曾湘峰[11]研究激光雷達深度信息和高分辨率圖像生成致密深度圖的相關方法,并根據致密深度圖的深度信息及可見光相機的顏色等信息,在RGB圖像及致密深度圖下采用稀疏三維場景流的模型實現檢測和跟蹤動態目標。閆光[12]基于毫米波雷達提供的帶有高誤檢率的動態目標信息、INS/GPS提供的位姿信息和點云提取到的可通行區域等信息,提出一種基于可通行區域歷史信息、全局運動補償、混合高斯模型的動態目標檢測方法,有效的融合多源信息進行目標檢測。融合多源信息的環境感知算法能有效彌補單傳感器環境感知存在的不足。在多傳感器聯合標定基礎上的信息信息融合感知算法實驗結果如下:

基于多源信息融合的環境感知技術是智能汽車關鍵核心技術之一,進行多源信息融合有利于增加環境感知技術的準確性、穩定性等,彌補單個傳感器環境感知技術的不足,對突破環境感知技術發展的瓶頸具有重要意義。

5 環境感知算法的測試評價分析研究

環境感知算法的測試評價研究主要包括兩方面:基于數據集的感知算法性能測試評價和基于測評系統的感知算法測試評價。

5.1 基于離線場景數據驅動的感知算法測試評價

張兵,董臻等人[11]提出基于極化目標檢測算法, 進行極化檢測算法漏警率和檢測概率的性能分析評價。王湘暉,曾明等人[13]提出了一種新的圖像增強質量客觀評價算法,算法綜合考慮圖像局部區域的背景平均亮度和空間復雜度對視覺分辨力的影響。張學顯,劉偉等人[14]針對智能車輛目標檢測能力測評存在的指標體系不完整、量化程度和測評實時性低等問題,進行目標分類和識別測試評價,并用TOPSIS方法進行綜合的評價。

5.2 基于測評系統的感知算法測試評價

Zhu W,Miao J等人[15]基于駕駛模擬器,在虛擬場景進行下車輛檢測,并以SVM與BP網絡作為基準,利用ELM對車輛和道路檢測的實時性與精確性方面進行測試評價。通過構建虛擬場景和駕駛模擬的集成平臺,能有效搭建不同的交通場景,對車輛感知性能進行測試評價[16][17]。

7 結束語

環境感知算法作為智能汽車關鍵和共性技術之一,單傳感器信息環境感知發展受傳感器受其物理條件限制具有局限性,多源信息融合能有效彌補單傳感器環境感知時存在的不足,并通過場景數據驅動測試與環境感知算法測評系統測試,更好的驗證算法性能。未來以多源傳感器時間同步和空間配準為基礎,信息融合環境感知趨向從數據融合到特征融合發展。算法測試評價方法趨向從場景數據到測評系統發展。

參考文獻:

[1]Zhou L ,Deng Z . Extrinsic calibration of a camera and a lidar based on decoupling the rotation from the translation[C]// Intelligent Vehicles Symposium. IEEE,2012.

[2]Gong X,Lin Y,Liu J . 3D LIDAR-Camera Extrinsic Calibration Using an ArbitraryTrihedron[J]. Sensors, 2013, 13(2):1902-1918.

[3]Ren,S.,He,K., Girshick,R.,& Sun, J.Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015,39(6), 1137-1149.

[4]Cai Z ,Vasconcelos N . Cascade R-CNN: Delving into High Quality Object Detection[J]. 2017.

[5] Hui Z ,Kunfeng W,Yonglin T , et al. MFR-CNN:Incorporating? Multi-Scale Features? and? Global Information for Traffic Object Detection[J]. IEEE Transactions on Vehicular Technology,2018:1-1.

[6] Habibi Aghdam H ,Jahani Heravi E , Puig D . A practical approach for detection and classification of traffic signs using Convolutional Neural Networks[J]. Robotics and Autonomous Systems, 2016, 84:97-112.

[7]Redmon J,Farhadi A.YOLO9000: Better, Faster, Stronger[C]// IEEE Conference on Computer Vision & Pattern Recognition. IEEE, 2017:6517-6525.

[8]Liu W , Anguelov D , Erhan D , et al. SSD:Single Shot MultiBox Detector[J]. 2015.

[9]Gavrila D M, Giebel J, Munder S. Vision-based pedestrian detection: The protector system [C]. In Intelligent Vehicles Symposium, 2004 IEEE. 2004: 13-18.

[10]汪君.融合相機和激光雷達的行人檢測與跟蹤算法研究[D].國防科學技術大學,2015.

[11]曾湘峰.車載多傳感器融合下的動態目標檢測與跟蹤[D].國防科學技術大學,2015.

[12]閆光.基于多傳感器信息融合的動態目標檢測與識別[D].北京理工大學,2015.

[13]張兵,董臻,梁甸農.極化目標檢測算法性能評價研究[J].系統工程與電子技術,2001(03):28-30.

[14]王湘暉,曾明.基于視覺感知的圖像增強質量客觀評價算法[J].光電子.激光,2008(02):258-262.

[15] 張學顯,劉偉,余彪,許鐵娟,周鵬飛.數據驅動的智能車輛目標檢測能力測試評價方法[J].計算機系統應用,2017,26(11):249-253.

[16] Zhu W , Miao J , Hu J , et al. Vehicle detection in driving simulation using extreme learning machine[J]. Neurocomputing, 2014, 128:160-165.

[17] Punzo, V., & Ciuffo, B. . Integration of Driving and Traffic Simulation: Issues and First Solutions. IEEE Transactions on Intelligent Transportation Systems,2011, 12(2),354-363.