通過風險預測獲取人工智能洞察

成功創造出高效的人工智能可能是人類文明史上最重大的事件,也可能是最糟糕的事件。除非我們知道如何準備應對和避免潛在風險,否則人工智能就可能成為人類文明史上最糟糕的發明。

因此,想要人工智能能夠與人類和諧共處,我們需要警惕危險的存在并找出危險,在實踐和管理方面盡可能做到最好,并事先做好充分準備,應對可能出現的任何結果。

一、將“信任設計”注入人工智能

安永與微軟歐洲近期聯合開展的一項調查顯示,71%%的受訪者將人工智能視為高管的一項重要考慮事項,而只有4%的受訪者在多個流程中用到了人工智能并執行高級任務。

“信任設計”(Trust by Design)能幫助企業將風險優化的思維嵌入人工智能的整個生命周期,通過將風險職能從被動的風險應對升級為強大的、動態的、面向未來的工具來建立信任。如果企業從一開始就將“信任設計”理念注入人工智能系統,就能利用風險預測加速獲取人工智能洞察。

二、建立用戶對人工智能的信任

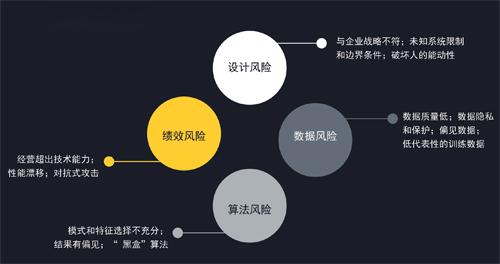

人工智能給技術、道德和社會領域帶來了風險和影響,已超出人工決策范疇,涉及技術發展。我們需要建立新的框架來識別、計量和應對人工智能風險——該框架需以現有的治理和控制結構為基礎,同時加入新的機制以應對人工智能特有風險。

三、量化人工智能風險

欲使人工智能充分發揮潛力,企業需要有能力預測和衡量會放大風險和破壞信任的情況。如:

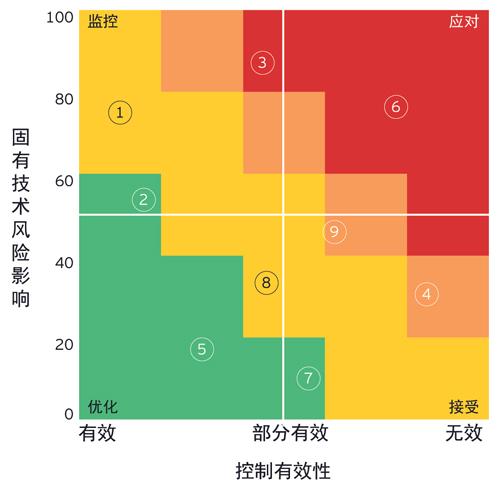

技術風險——評估基礎技術、技術操作環境和自主性水平;

利益相關方影響——考慮人工智能代理的目標和目的,以及對外部和內部用戶經濟、情感和物理方面的影響,以及聲譽、監管和法律風險;

控制有效性——考慮是否存在降低人工智能風險的控制及其運行有效性。

圖1 人工智能四大關鍵風險

圖2 人工智能代理剩余風險

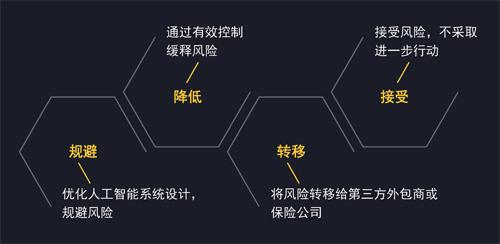

圖3 人工智能風險應對策略

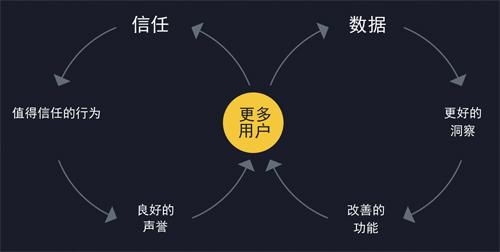

圖4 人工智能可信任性來吸引更多用戶

憑借這三類評分的組合,安永Trusted AI Platform可以計算出人工智能系統設計的剩余風險,計算公式如下:人工智能剩余風險=技術風險X利益相關方影響-控制有效性。

四、應對人工智能風險

應對人工智能的風險需要使用能夠跟上人工智能高速適應性學習能力的創新控制方法。在決定如何應對各項風險時,企業可以采用以下四種策略。這些策略可以單獨部署,也可以結合使用。

五、監控人工智能風險

為了有效地監控人工智能,需建立持續的監控機制以確定人工智能系統按預期運行。人工監督(如人在回路)是人工智能系統的一個重要的風險緩釋策略,人工操作最適合應對需要對少量分散信息進行高水平認知分析的短期事件。但人類不善于長時間保持注意力集中,特別是在事故發生率較低的情況下,并且人類可隨時處理的信息量有限。而自動化系統,特別是那些人工智能支持的系統,可以克服這些缺點。

六、將對人工智能的信任作為競爭優勢

人工智能已經開始顛覆我們的工作和生活方式。欲在人工智能時代脫穎而出,企業必須優化數據和信任反饋閉環以吸引更多用戶并加速人工智能部署。