基于多流對極卷積神經網絡的光場圖像深度估計

王 碩 王亞飛

(北京信息科技大學信息與通信工程學院 北京 100101)

0 引 言

光場相機使用一個微透鏡陣列來捕獲場景,得到一個陣列的子孔徑圖像,可使用這些圖像進行圖像深度信息的恢復[1]。其中最有代表性的是使用從圖像陣列中提取的極線平面圖像EPI來提取深度信息。EPI由各種斜率的線組成,使得在深度估計上的圖像處理和優化變得容易處理。目前光場圖像深度估計相關工作可分為兩類:基于優化的方法和基于學習的方法。

基于優化的方法有:Wanner等[4]使用結構張量來計算EPI的斜率,并使用快速全變差去噪濾波器來細化初始視差圖。Zhang等[5]使用EPI找到匹配線,并提出旋轉平行四邊形算子來重新移動遮擋對深度估計的影響。文獻[6-7]提出增加正則化項的參數來保證噪聲遮擋區域的魯棒性。文獻[8-9]利用重聚焦線索,在處理重復紋理和對抗噪聲方面的性能有所提升。Anisimov等[10]提出了一種結合立體匹配和直線擬合的算法,對物體邊界信息的估計進行改善。這些傳統的基于優化的方法在計算時間和性能之間有不可避免的權衡。

近年來有學者提出使用深度學習的方法來進行光場圖像深度估計。Johannsen等[11]將基于方向的深度重建與基于生成深度字典的稀疏光場編碼進行聯合,在多層視差估計場景中取得了較好的效果。文獻[12-13]提出了一個由編碼和解碼部分組成的端到端深度網絡體系結構,提升了計算效率。文獻[14]采用EPI patch作為神經網絡的輸入,以分類代替回歸的方式得到初始深度值,但是該方法執行一次運算只能得到一個像素的深度信息,大大增加了算法耗時。

針對現有方法存在的估計精度低、計算耗時長的問題,本文提出多流對極卷積神經網絡(Multi Stream Epipolar Convolutional Neural Network,MS-EPINET)進行光場深度估計。該方法使用四個方向的EPI信息作為網絡輸入,在經過低階特征提取后,使用直接拼接和方差融合的兩種方式對低階特征進行融合,再對不同方式融合后的特征分別進行高階特征提取,分別轉化為初始深度圖。為進一步提高估計精度,將兩幅深度圖拼接進行卷積操作,得到優化深度圖。該方法實現端到端的深度估計操作,一次計算即可得到整幅深度圖。同時,為克服數據集小導致模型過擬合的問題,提出針對光場圖像的數據增強技術,提高模型泛化能力。實驗結果表明,該算法在計算精度和執行效率方面都取得較好結果。

1 基于EPI圖像結構的深度估計

1.1 光場EPI結構

4D光場圖片可以表示為L(x,y,u,v),其中(x,y)代表空間坐標,(u,v)代表視角坐標。Nx×Ny是圖片空間分辨率,Nu×Nv是視角分辨率。中心視點圖像由穿過主透鏡光學中心的光線形成。中心視點和其他視點光場圖像的關系為:

L(x,y,0,0)=L(x+d(x,y)×u,y+d(x,y)×v,u,v)

(1)

式中:d(x,y)是中心視點像素(x,y)與其相鄰視點中相應像素的視差。

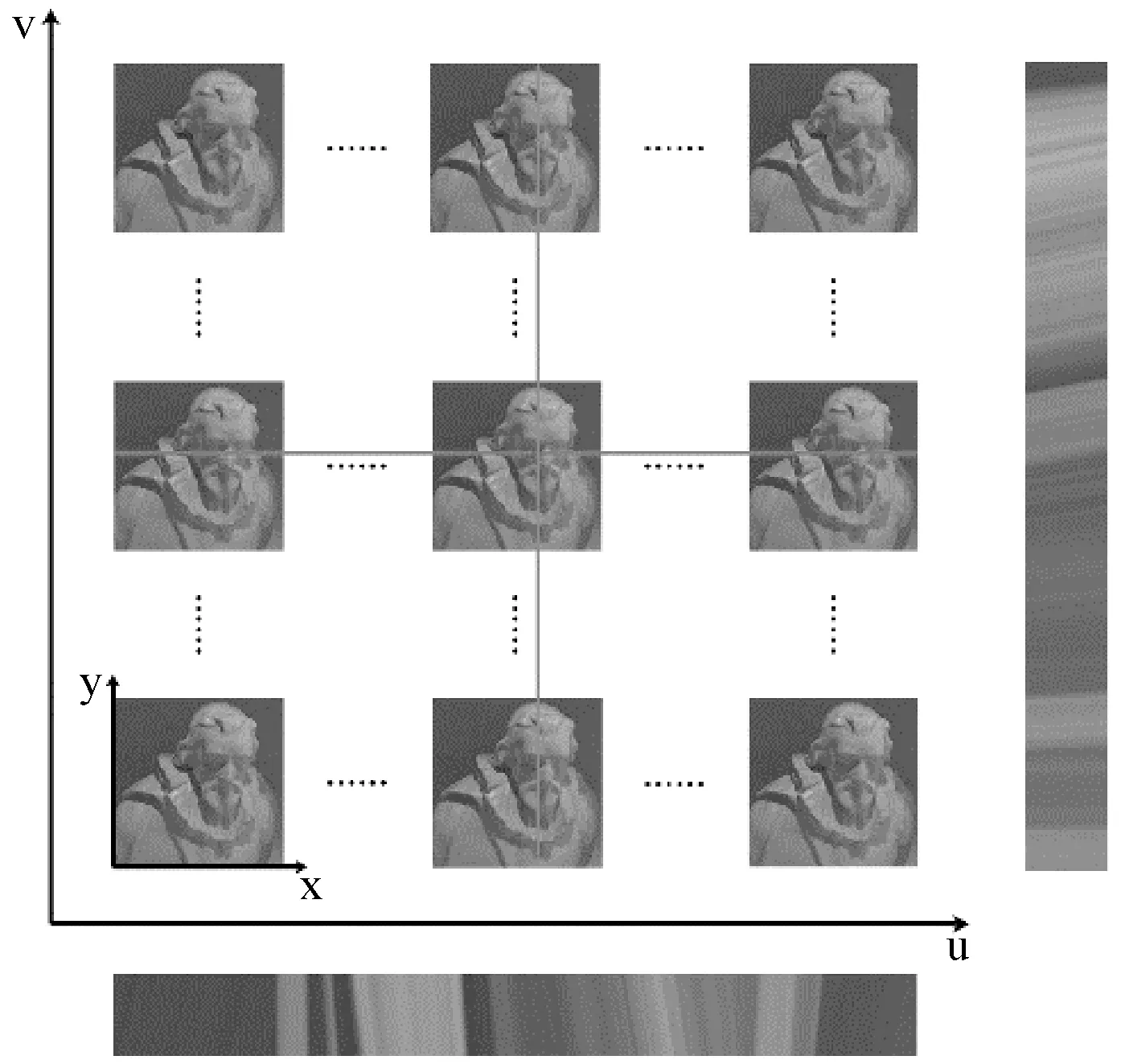

圖1展示了一個9×9×512×512的光場數據,對于中心視點中的像素p(xi,yi),其水平EPI是將視角坐標v和空間坐標y固定,將9幅在同一水平線上圖片位于橫線位置處的像素拼接而成,大小為9×512,如圖1下方圖像所示。對于此光場圖像來說,中心視點的圖像一共可以生成512幅水平EPI圖像。同理可得中心視角垂直EPI圖像,其中xi位置的垂直EPI圖由圖片中垂線位置處像素拼接而成,如圖1右側所示。

圖1 光場EPI結構

1.2 深度估計

文獻[13]設計了適用于光場圖像的卷積神經網絡模型(EPN),使用深度學習的方法計算光場圖像中場景的深度。該方法在選取的像素點位置截取相應的水平和垂直方向的EPI Patch作為網絡輸入,兩個子網絡分別接收水平和垂直EPI塊,經過7個卷積層進行特征提取。使用全連接層將兩個網絡的結果進行合并,最后使用Softmax分類器將1×229的向量作為結果輸出,如圖2所示。

圖2 EPN神經網絡結構示意圖

該方法是將深度計算問題轉化為分類問題,每一類對應一個深度值,輸出的深度值只能在這些離散的數值上。對圖像所有像素點執行以上計算過程,即得到該圖像完整的深度圖。然而該方法只能預測得到離散的深度值,且數值不夠精確;由于全連接層的存在,大大增加了網絡參數量和網絡運行時間;由于每次網絡運行只能得到一個像素點的深度值,要完成512×512分辨率圖像的深度值預測,一共要進行262 144次循環,嚴重影響計算效率。

本文提出MS-EPINET進行深度信息估計,一次前向傳播計算即可得到整幅深度圖數據,顯著提高計算效率。由于構建水平和垂直方向的EPI僅使用了少量光場圖像數據,為了能夠利用更多光場圖像數據用于深度估計,本文將斜線方向的光場數據也用于構建相應的EPI圖像,并使用兩種特征融合的方式,將不同方向的EPI特征進行融合,進一步提升估計精度。

2 MS-EPINET

2.1 網絡結構

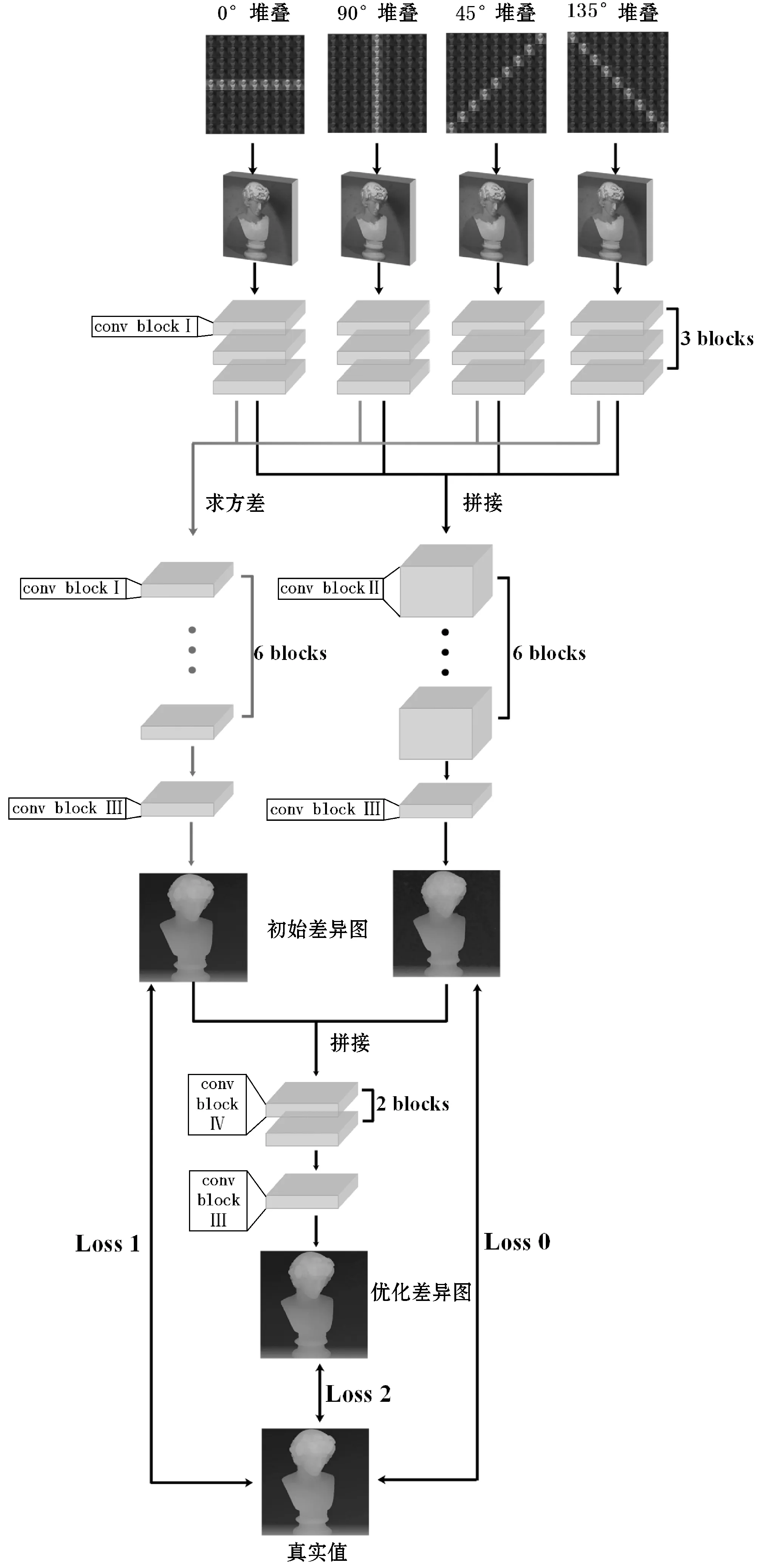

本文提出MS-EPINET用于估計中心視角的視差圖。該網絡以4個具有一致基線視點的EPI結構作為輸入,4個視點分別為水平、垂直和左右對角線方向。將4個EPI結構輸入到網絡的初始4條分支中,完成對圖像低階特征的提取;將提取的特征進行特征融合,融合時分為兩種方法,分為直接拼接法和方差融合法;將兩種融合后的特征分別經由不同的卷積網絡結構進行高階特征的提取,并轉化為中心視角的初始差異圖。為進一步提高合成的差異圖的精度,將兩條支路上預測的初始差異圖按通道拼接后,再經過卷積操作后得到最終優化后的差異圖。網絡完整結構如圖3所示。

圖3 MS-EPINET結構

2.1.1 EPI圖像輸入

中心視點和其他視點光場圖像的關系表示如下:

L(x,y,0,0)=L(x+d(x,y)×u,y+d(x,y)×v,u,v)

(2)

添加斜線方向EPI特征后,對于角度方向θ(tanθ=v/u),中心視點和其他視點光場圖像的關系表示可以將式(2)重新描述為:

L(x,y,0,0)=L(x+d(x,y)×u,y+

d(x,y)×utanθ,u,utanθ)

(3)

然而,視點的索引均為整數,當tanθ是非整數時沒有對應的視點。因此,假設光場圖像具有(2N+1)×(2N+1)角分辨率,僅在4個視角θ:0°、45°、90°和135°的方向上選擇圖像。4個方向的圖像經過圖像預處理后,在各自方向上進行圖像堆疊,得到網絡的EPI圖像輸入數據。

2.1.2 低階特征提取

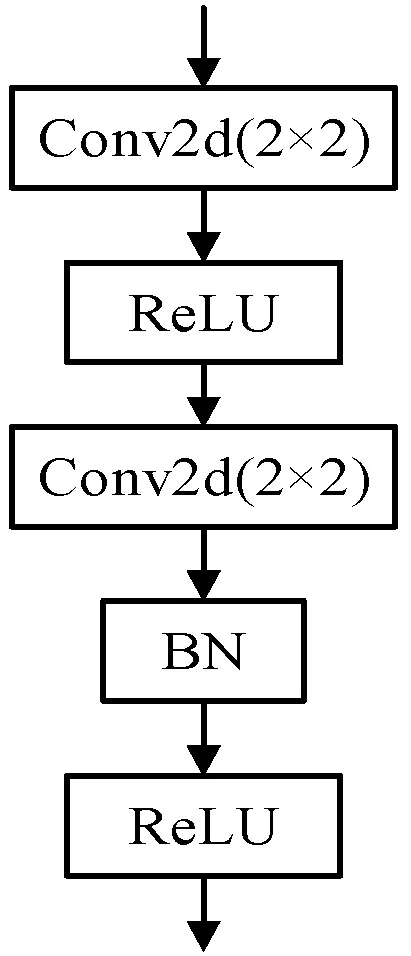

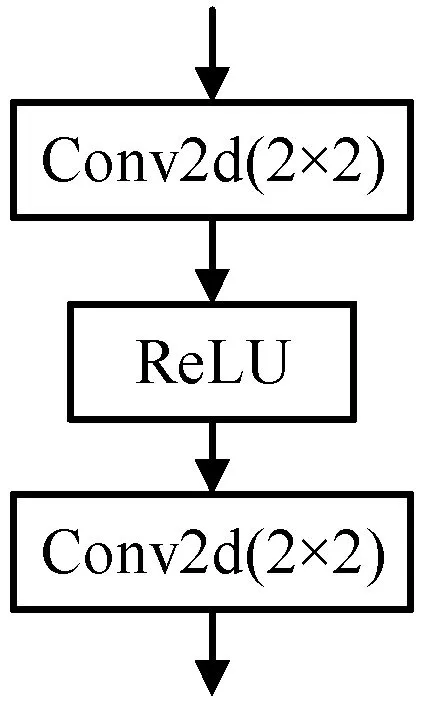

網絡的初始部分由4條支路分別接收4個方向堆疊的EPI圖像,經過3個卷積塊(conv block Ⅰ)進行低階特征提取。卷積塊“conv blockⅠ”的結構如圖4所示。

圖4 Conv blockⅠ結構圖

卷積層部分使用步長為1,大小為2×2的卷積核做卷積操作,卷積核的數量為70個。將卷積核大小由常規的3×3改為2×2是因為光場數據集圖像的基線短,使用小的卷積核能較好地捕捉圖像間的差異信息。一次卷積可以計算±4的視差。

卷積塊中使用ReLU作為激活函數:

f(x)=max(0,x)

(4)

選擇ReLU作為激活函數的原因如下:速度快,相比sigmoid、tanh等需要計算指數和倒數的激活函數,ReLU的計算代價小很多;可以減輕梯度消失的問題,計算梯度的公式如下:

▽=σ′δx

(5)

式中:δx代表自變量的極小量;σ′為激活函數的導數,以sigmoid為例,其導數范圍為(0,1)。根據鏈式求導法則,多次連乘之后就會導致梯度越來越小,造成梯度消失的問題。而使用ReLU作為激活函數可以避免這個問題,在其激活狀態下,導數恒為1,因此不會出現由于網絡層的增加而導致梯度消失的問題。

BN表示批規范化層(batch normalization),使用批規范化層是為了克服深度神經網絡難以訓練的問題,可以減輕網絡對參數初始化的依賴,使網絡訓練更快,使用更高的學習率以及在一定程度上增加模型的泛化能力。

2.1.3 特征融合

在對提取到的不同EPI方向的特征進行合并的時候,本文提出兩種思想:(1) 直接將四種EPI特征在通道方向上進行拼接,即原各支路通道數為70,拼接后為280,目的是想讓卷積神經網絡自動將各個方向EPI特征進行融合;(2) 通過一些數學方法融合不同通道間的特征。文獻[15]使用求均值的方法在不同支路間融合特征,然而這種方法損失了不同特征間的差異信息。針對這個缺陷,本文提出使用方差操作來融合不同的EPI特征,特征融合后的通道數與原各支路通道數相同,仍為70。相比求均值的方法,本文提出的求方差的方法能更好地保留特征間的差異信息。其計算方式如下:

(6)

(7)

(8)

式中:Fvar表示以方差形式融合的特征矩陣。

2.1.4 初始差異圖生成

將直接拼接融合的特征通過6個第二種卷積塊(conv block Ⅱ)進行高階特征提取,如圖3網絡結構中間部分的上層支路所示。卷積塊“conv block Ⅱ”的結構與卷積塊“conv block Ⅰ”的結構相同,僅將卷積核的數量由70增加到280。經過第三種卷積塊(conv block Ⅲ)的計算即可得到初始的差異圖。卷積塊“conv block Ⅲ”的結構如圖5所示。

圖5 Conv block Ⅲ結構圖

卷積層仍使用2×2大小的卷積核,第一層卷積核數量為70,最后一層卷積核數量為1。同理,將通過方差融合的特征通過6個第二種卷積塊(conv block Ⅱ)進行高階特征提取,如圖3網絡結構中間部分的下層支路所示,可得到另外一幅初始的差異圖。

2.1.5 差異圖優化

為了進一步提高生成的差異圖的精度,將得到的兩個初始差異圖在通道方向上進行拼接。通過2個第四種卷積塊(conv block Ⅳ)和1個第三種卷積塊(conv block Ⅲ),對拼接的差異圖進行進一步的特征融合,保留兩者中好的部分,將差異圖的精度提升。其中卷積塊“conv block Ⅳ”的結構如圖6所示,卷積層中卷積核的數量為32。

圖6 conv block Ⅳ結構圖

2.1.6 深度值的計算

根據光場相機成像原理,可通過映射關系將視差值轉換為深度值:

(9)

式中:f為相機焦距;Z為P點的深度值;Δx表示P點在不同視角下的位移量(視差);Δu為相機鏡頭陣列的基線長度。

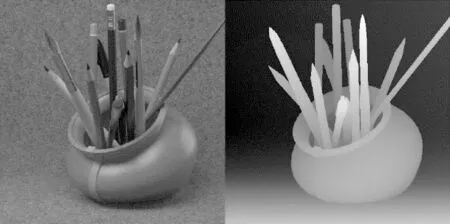

2.2 輸入數據預處理

本文使用的是HCI 4D標準光場數據集[16],提供20個精心設計合成、密集采樣的4D光場數據。每一個場景包括9×9視角的RGB圖像和中心視角的精確視差圖,每幅圖像的分辨率均為512×512,其中一個場景的中心視角圖像和對應的視差圖如圖7所示。

(a) 中心視角RGB圖(b) 中心視角差異圖圖7 HCI 4D光場數據集

與文獻[13]使用RGB彩色EPI-patch作為輸入不同,對于通過EPI特征求解視差來說,視差信息隱藏在EPI特征圖像極線的斜率當中。因此為減少網絡參數數量和計算規模,本文將彩色圖像進行灰度化處理,計算公式如下:

Gray(i,j)=R(i,j)×0.299+G(i,j)×0.587+

B(i,j)×0.114

(10)

式中:Gray(i,j)、R(i,j)、G(i,j)、B(i,j)分別代表在(i,j)像素點處灰度值、紅色通道分量值、綠色分量值和藍色分量值。

為提升模型收斂速度、提升模型精度和減少光照不均勻對網絡造成的影響,對灰度化后的圖像進行歸一化處理,將所有像素值壓縮到[0,1]之間。由于像素值最大為255,故歸一化時直接將像素值除255即得到歸一化后的像素值P′:

(11)

然后將經過灰度化和歸一化處理后的圖像在水平方向上進行堆疊,得到水平方向的EPI patch,表示9幅分辨率為512×512灰度圖像的疊加,將其作為網絡的0°堆疊方向的輸入。同理,將圖像按垂直、主對角線和副對角線進行堆疊,可得到90°、45°、135°的輸入。

2.3 數據增強

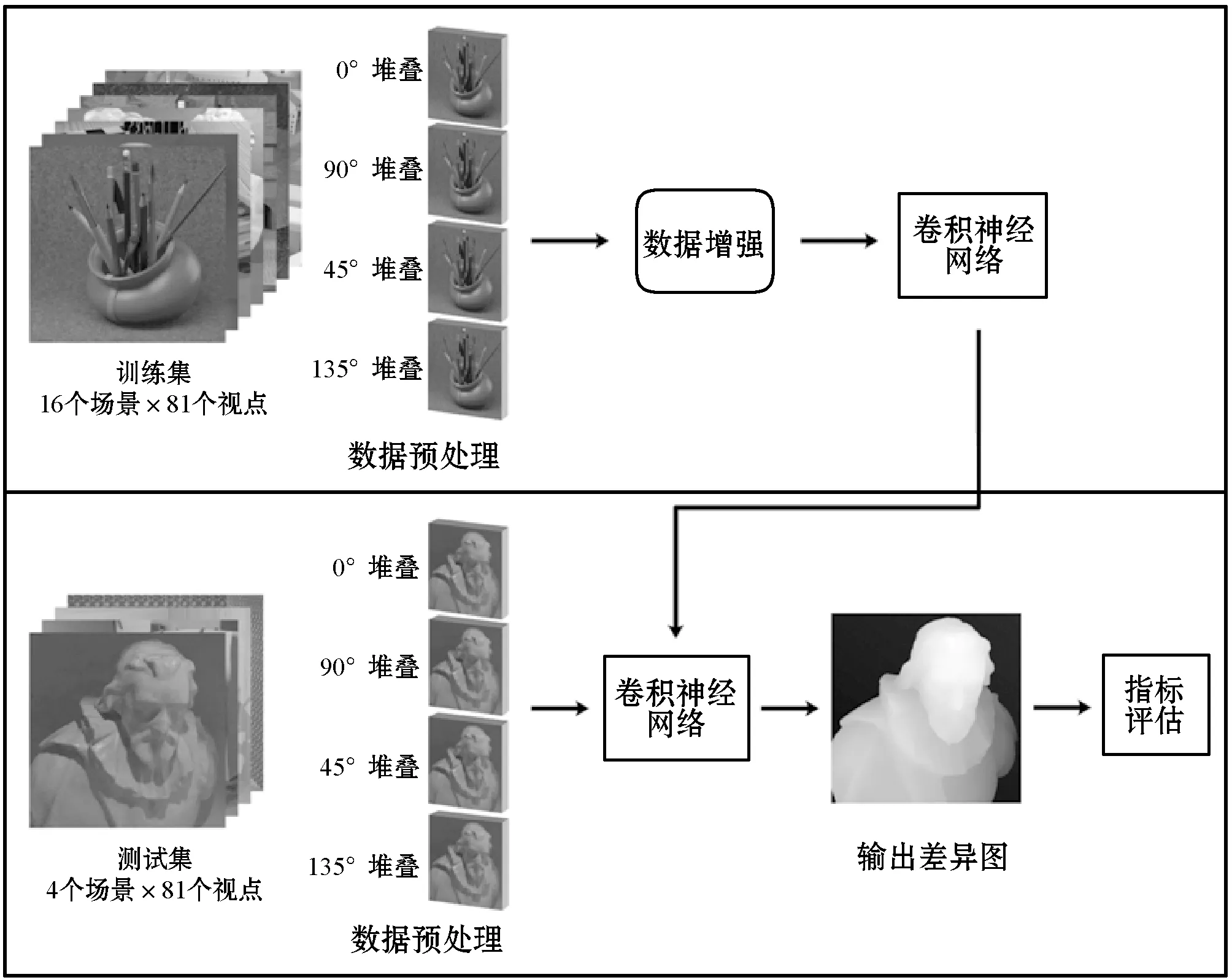

本文使用了HCI 4D光場數據集提供的20幅包含各種紋理、材料、物體的光場合成圖像,其中16幅作為訓練集。然而,16個光場圖像遠遠難以達到訓練深度卷積神經網絡的目的。為了防止過擬合問題,數據增強處理至關重要。因此,本文提出了適用于光場圖像的數據增強技術,該技術保留了子孔徑圖像之間的幾何關系。

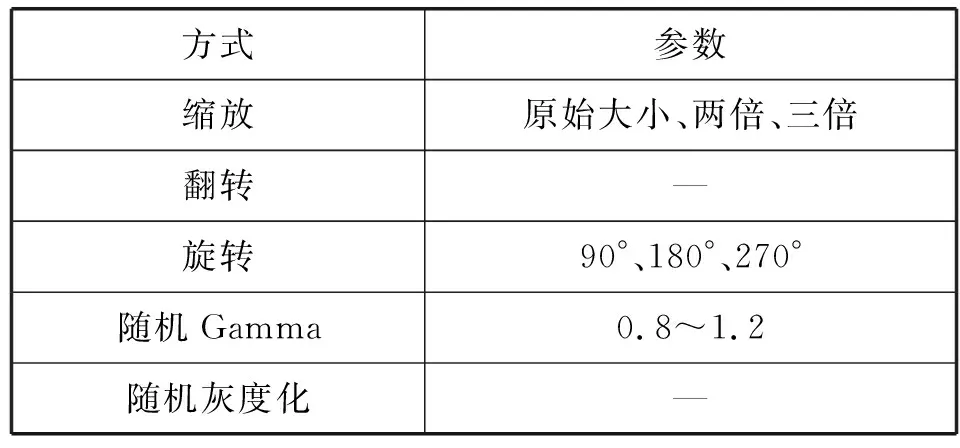

所使用的數據增強方式包括圖像縮放、翻轉、旋轉、隨機Gamma值和隨機灰度化。具體的數據增強方式及參數如表1所示。

表1 數據增強方式

使用圖像旋轉數據增強技術時,應考慮光場圖像的方向特性。為了保持這種光場特征,在圖像旋轉后,各個方向上的堆疊順序也要相應的改變。例如:圖像旋轉90°后,將豎直方向上的圖像堆疊后輸入到網絡的水平輸入流中;圖像旋轉180°后,豎直方向的圖像仍輸入到網絡的豎直輸入流中,但由于旋轉后圖像中物體的移動方向相反,因此圖片的堆疊順序也應反向。如圖8所示。

圖8 圖像旋轉數據增強

2.4 訓練細節

由于批量(batch)梯度下降法使用整個數據集去計算代價函數的梯度,批量梯度下降法會很慢,并且需要很大的顯卡顯存。本文訓練時使用小批量(mini batch)隨機梯度下降,批次大小(batch size)設為16,其擁有更快的更新頻率,有利于更魯棒地收斂,避免局部最優,且不需要把所有數據放入顯存中,減少了對顯存的需求。但由于顯存的限制,仍然無法直接將512×512分辨率的圖像輸入到網絡中進行計算,因此將圖像進行50×50的隨機裁剪輸入到網絡中進行訓練,再用512×512的圖像進行驗證。優化器(optimizer)采用RMSprop,初始學習率為10-4。

網絡的損失函數考慮了兩個初始差異圖和一個優化差異圖的誤差,由三部分組成。使用真實深度圖和估計深度圖之間的平均絕對誤差(Mean Absolute Error,MAE)作為訓練損失:

(12)

實驗在一臺配有E5-2650 v4處理器、NVIDIA TITAN V顯卡和64 GB內存的服務器上完成,使用pycharm作為軟件環境,采用Tensorflow框架作為訓練后端,Keras庫搭建網絡,訓練150個epoch,大約1天即可使網絡收斂,得到較好的結果。

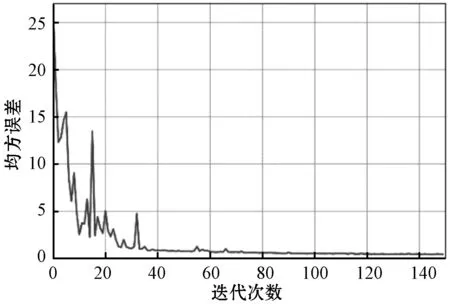

每完整訓練1遍訓練集中的樣本(1個epoch),就是用512×512分辨率的圖像作為驗證集(validation set)對網絡的性能進行評估,根據評估的結果調整學習速率和判斷是否停止迭代。使用均方誤差(Mean Square Error,MSE)和不良像素率(bad pixel ratio)作為評價標準,均方誤差的計算如下:

(13)

不良像素率為不良像素的數量占總像素數的比例。不良像素率用于描述估計結果的準確度,當一個像素點估計出的值與真實值的差異大于一定閾值時,該點被判定為不良像素點。不良像素率的計算公式為:

(14)

式中:t表示不良像素差異的閾值,這里t=0.07。

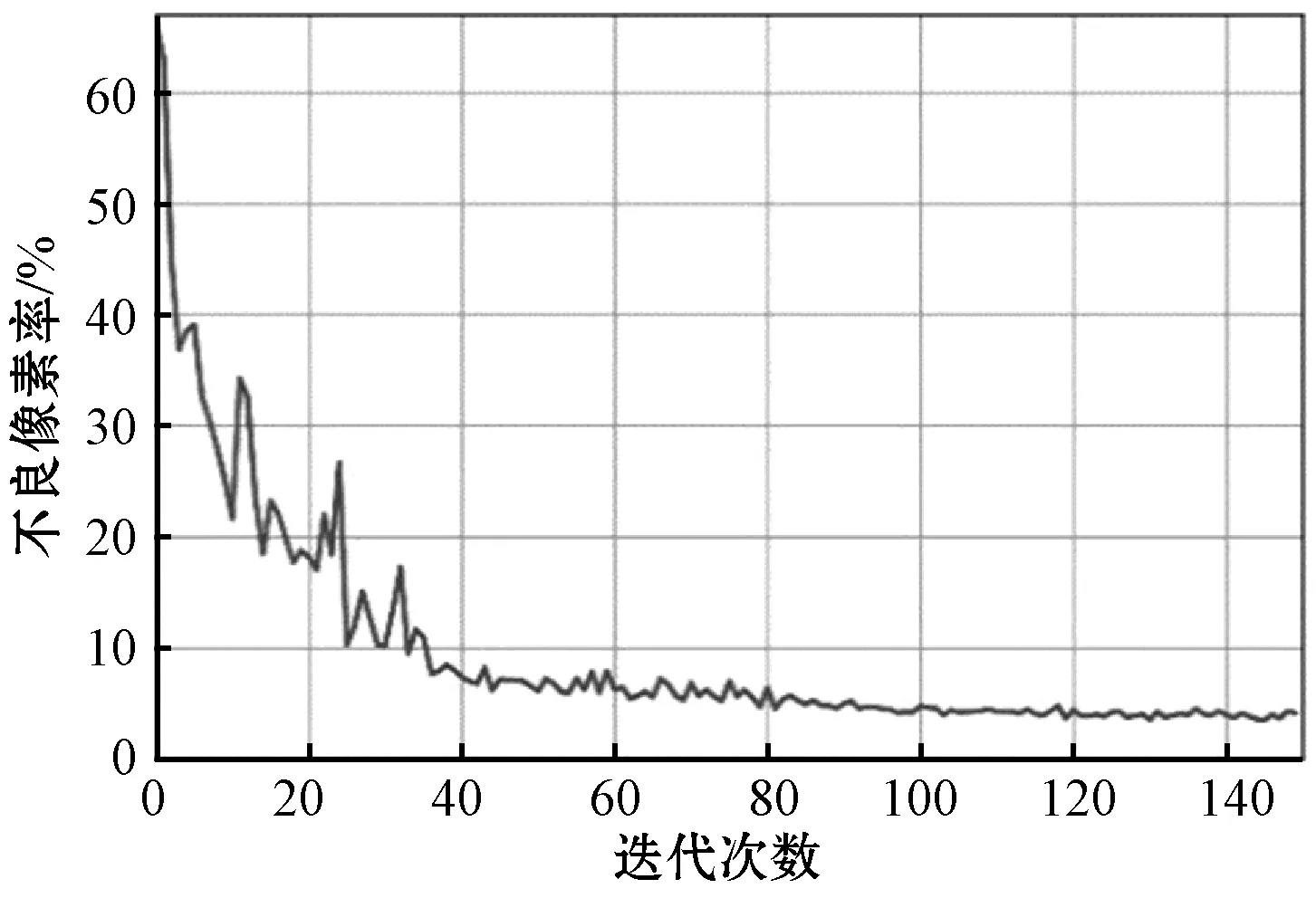

均方誤差和不良像素率隨迭代變化的過程如圖9和圖10所示。隨著網絡訓練次數的增加,均方誤差和不良像素率在不斷下降且最終收斂,說明本文提出的MS-EPINET 的網絡結構較好,能夠收斂,且精度較高。

圖9 MSE曲線

圖10 Bad Pixel曲線

綜上所述,本文總體算法流程圖如圖11所示。

圖11 總體算法流程圖

3 實驗結果與分析

3.1 算法結果

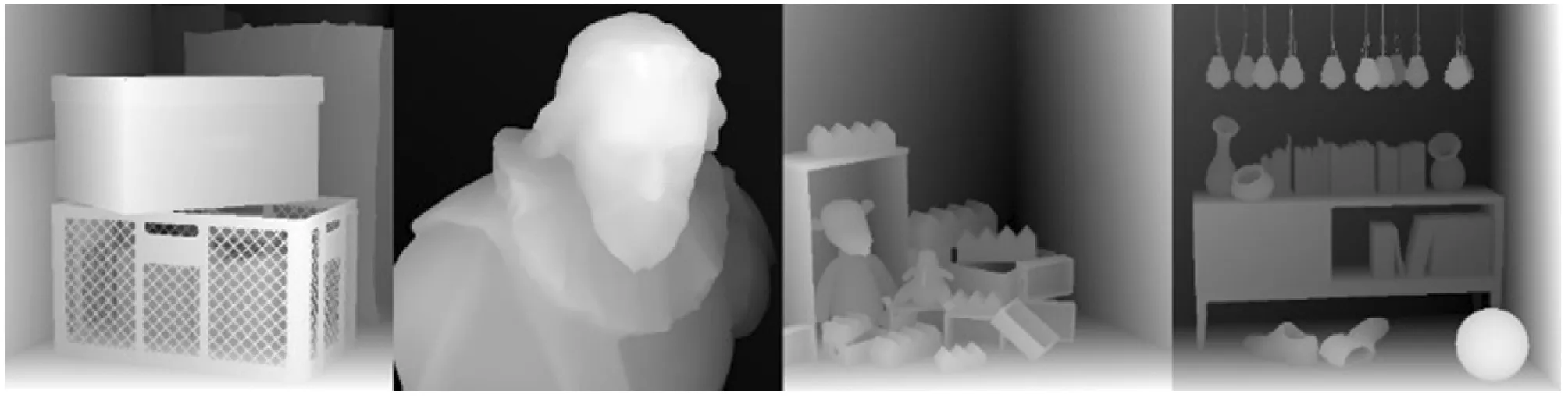

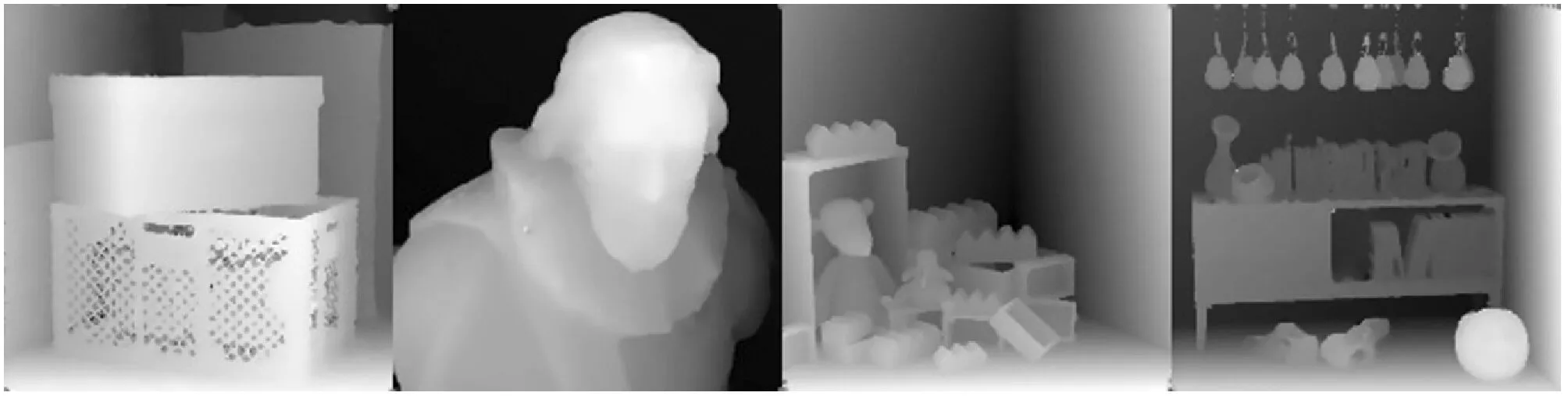

HCI 4D標準光場數據集中,提供20組不同場景的光場圖像,光場圖像的空間分辨率為512×512,視角分辨率為9×9,并提供了中心視角差異圖的真實值。其中16個場景用于訓練集,4個場景用于測試集。4個測試集的場景分別命名為Boxes、Cotton、Dino和Sideboard,中心視角的RGB圖像如圖12所示。

圖12 測試集中心視角圖像

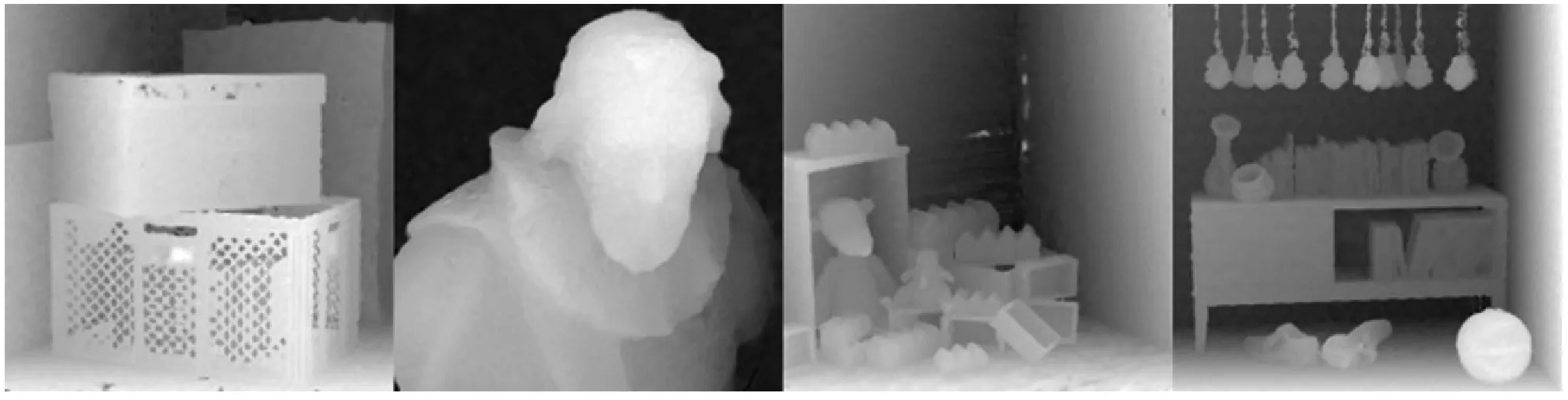

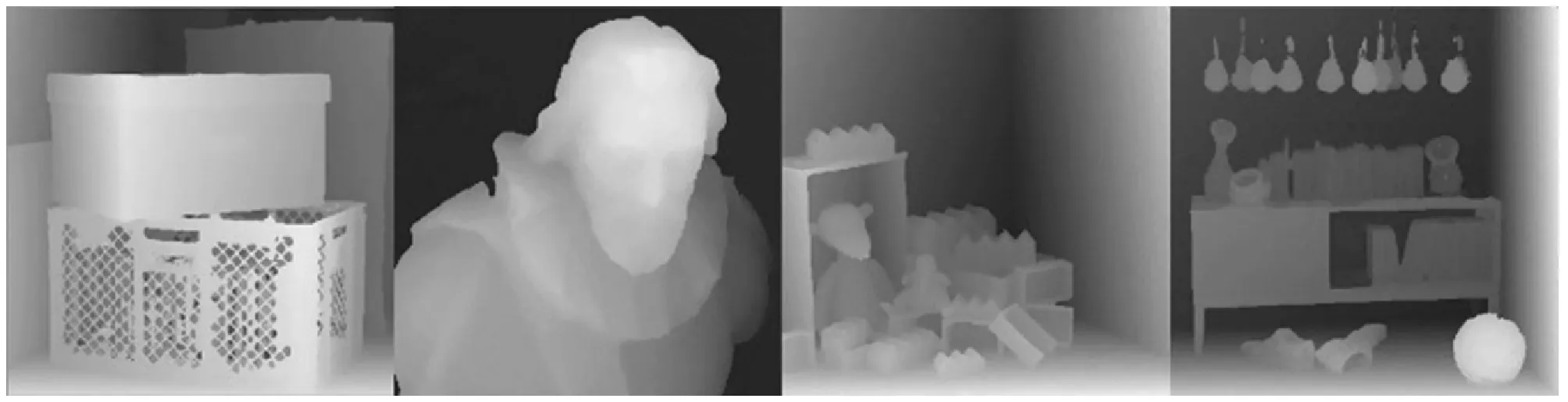

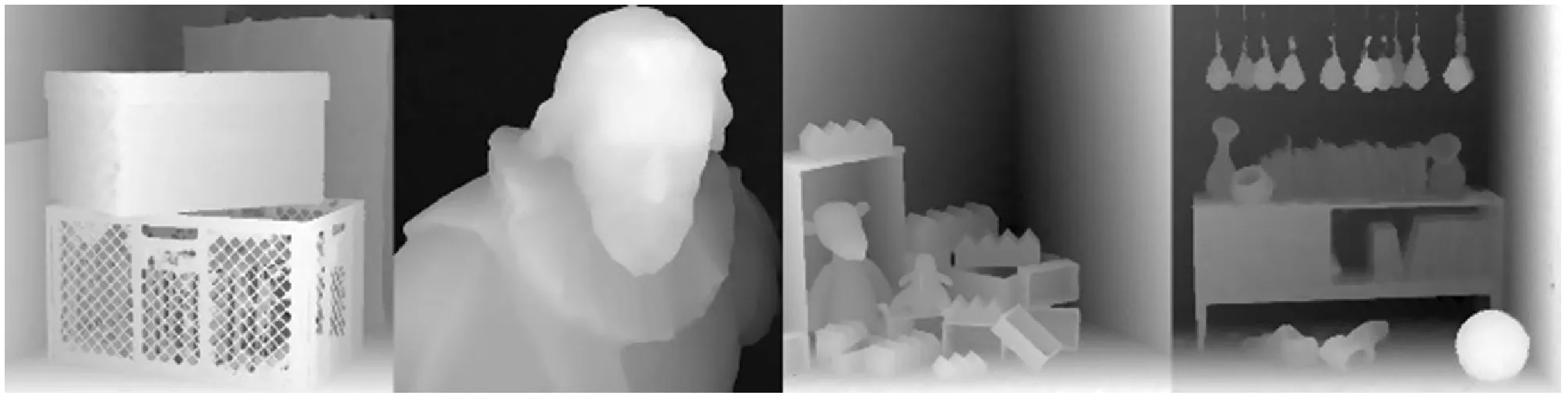

使用2.2節所述的圖像預處理方法對測試集輸入圖像進行處理后,輸入到已經訓練收斂的MS-EPINET中,得到預測的視差圖。將本文MS-EPINET預測結果與其他文獻預測結果進行對比,對比結果如圖13所示。

(a) 真實值

(b) LF_OCC[7]

(c) OFSY[9]

(d) BSL[10]

(e) EPI1[11]

(f) EPN[14]

(g) MS-EPINET本文算法圖13 實驗結果對比

可以看出,在中間兩個場景Cotton和Dino中,本文算法MS-EPINET估計結果準確,物體的邊緣也較為清晰,且未出現EPI1[11]在Dino場景墻壁上出現的孔洞問題。對于復雜場景Boxes和Sideboard中,雖然仍有估計不準確的地方,但與其他文獻算法相比邊緣更加清晰、差異值過渡更加平滑,且在Boxes場景中下方箱子的深度估計明顯優于其他算法。

3.2 算法性能分析

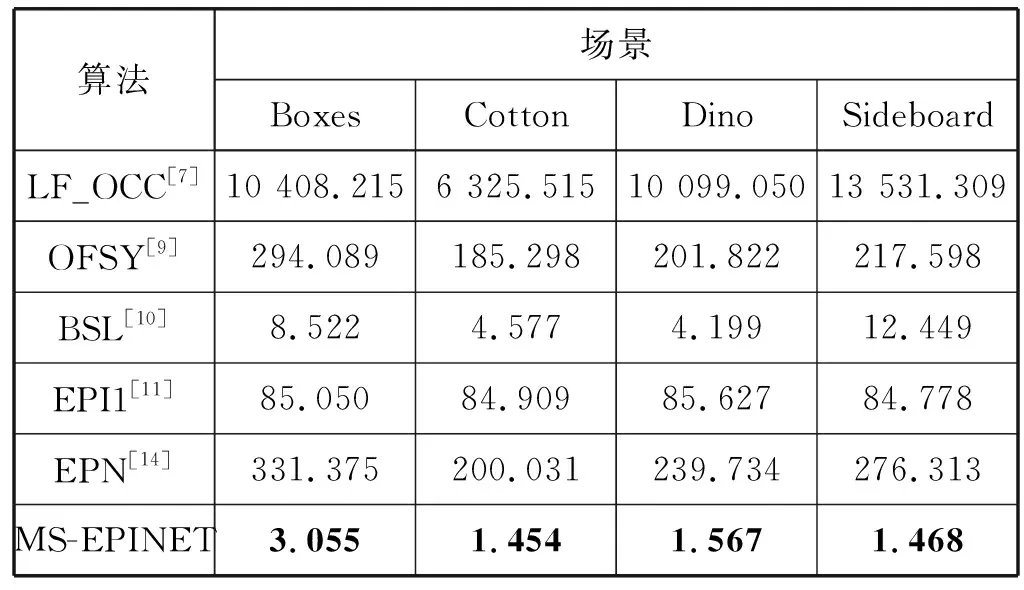

將MS-EPINET與其他現有文獻算法進行性能比較,實驗根據均方誤差(MSE)和不良像素率(Bad Pixel)兩個評價指標,對算法的估計圖像平滑度和估計精度進行對比,兩個指標的值越小說明算法性能越好,算法比較結果如表2所示。

表2 算法性能對比

可以看出,本文算法的均方誤差(MSE)和不良像素率(Bad Pixel)在四個場景中均低于其他算法。與其中結果最好的EPN[14]算法相比,四個場景下平均的MSE值和Bad Pixel值分別提升約28.4%和37.3%,說明本文提出的MS-EPINET算法具有更強的特征學習和轉化能力,并且準確度較高。在計算時間上,由于匹配算法需要對每一個點或一個小區域進行單獨的計算,多次循環遍歷才能得到整幅圖像的深度圖,且大多還需要進行優化后處理操作,導致計算時間顯著增加;而本文提出的MS-EPINET算法只需進行一次前向傳播計算即可得到完整的視差圖,再經過簡單計算即可得到對應的深度圖,大大減少了計算耗時,具體計算耗時對比如表3所示。

表3 算法時間對比 s

可以看出,在4個場景下,MS-EPINET計算耗時顯著低于其他算法。綜上所述,MS-EPINET在精度提升的同時,降低了配準耗時,在計算精度和計算耗時之間保持了良好的平衡。因此,本文算法是有效和快速的。

4 結 語

本文提出了一種多流對極卷積神經網絡進行光場深度信息估計。該網絡設計考慮了光場極線幾何,使用多流網絡和合并網絡的組合來學習視角和空間信息,并提出使用兩種特征融合的方式,形成兩條支路分別得到初始深度圖,再對深度圖融合優化,進一步提高結果的精確性。此外,還通過使用光場圖像的數據增強技術,克服數據不足的問題,避免模型對訓練集過擬合。實驗結果表明,與現有文獻算法相比,本文算法的估計精度和執行效率有明顯提高。