基于FCN和互信息的醫學圖像配準技術研究

曾 安,王烈基 ,潘 丹,黃 殷

1.廣東工業大學 計算機學院,廣州 510006

2.廣東大數據分析與處理重點實驗室,廣州 510006

3.廣東建設職業技術學院 現代教育技術中心,廣州 510440

1 引言

隨著計算機技術和生物醫學工程技術的快速發展,利用電子計算機斷層掃描、核磁共振等成像設備可以獲取多種模態的醫學圖像。由于不同模態的醫學圖像在像素間距、圖像信息上存在較大差異,通常需要結合配準技術進行多模態醫學圖像分析。醫學圖像配準尋找一種最優空間變換,使兩幅醫學影像的對應點在給定相似性度量下達到空間位置和解剖位置的一致[1]。通過多模態醫學圖像配準技術,在臨床上可以為醫療工作者提供更多的病理診斷信息。

目前,傳統醫學圖像配準方法多為基于灰度的配準方法,它利用兩幅圖像的灰度信息計算相似性度量,通過搜索策略尋找最大相似性度量的變換參數來完成配準任務。互信息法[2]是最常見的基于灰度配準方法之一,由于它配準精度較高、魯棒性強,因此在圖像配準領域得到廣泛應用。在互信息圖像配準中,使用較多的優化算法有:遺傳算法(Genetic Algorithm,GA)[3]、蟻群算法(Ant Colony Optimization,ACO)[4]、Powell 法[5-6]、隨機梯度下降法(Stochastic Gradient Descent,SGD)等。這些優化算法各有優點和不足之處,前兩種算法具備良好的全局搜索能力,但計算形式過于復雜,配準速度較慢。Powell 法計算簡單,但在進行高維、復雜圖像配準時,容易出現陷入局部極值的情況。

近年來,深度學習作為新興研究領域發展迅速,其旨在研究通過深層網絡結構學習樣本數據的內在規律和層次特征表示。目前,常見的深度學習模型有:棧式自編碼器[7(]Stacked Autoencoder,SAE)、深度置信網絡[8](Deep Belief Network,DBN)、卷積神經網絡[9](Convolutional Neural Network,CNN)等。其中CNN仿照生物視知覺構建,可以對圖像進行整體處理,因此廣泛應用于圖像識別[10]、圖像分割[11]、圖像分類[12]等領域。相比于傳統方法只能對圖像中低級別的邊緣信息進行提取和表征;CNN采用一系列非線性變換,通過組合低層特征形成更加抽象的高層表示(屬性類別或特征),因此能夠更加出色和快速的完成圖像應用領域的各類任務目標[13]。

針對傳統互信息法配準速度慢、容易陷入極值的問題,本文將CNN引入到三維圖像配準任務中,提出一種基于FCN和互信息的多模態醫學圖像配準方法。通過FCN 模型提取圖像顯著性區域特征,從而進行粗配準,為互信息算法提供可靠的全局搜索初始點;再結合互信息算法進行全局搜索優化并定位最優三維配準參數。實驗表明,本文方法能夠快速、準確地得到圖像配準參數。

2 相關工作

2.1 卷積神經網絡

卷積神經網絡是一種以卷積操作為基本架構的深層神經網絡,通過網絡特有的平移不變形、卷積運算以及池化下采樣操作來實現對圖像深層信息的提取和利用。

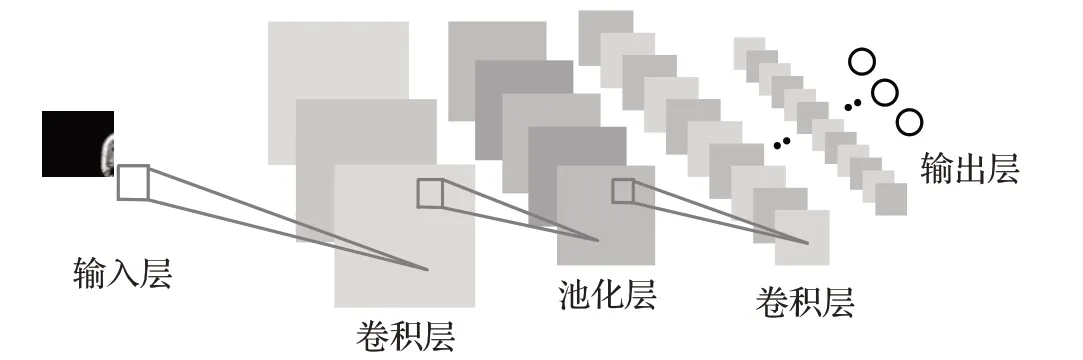

典型的CNN 主要由輸入層、卷積層、池化層、全連接層和輸出層構成。卷積層包含若干個卷積核,通過與圖像進行卷積操作提取圖像局部特征,得到該層的特征圖。不同的卷積核可以提取不同的圖像特征,從而增加提取特征的多樣性。池化層通過對特征圖進行局部區域最大值提取來降低圖像維度,減少后續計算。一般地,CNN 包含了若干個由卷積層和下采樣層構成的特征提取器,通過組合低層的圖像特征形成高層的抽象特征,提取圖像的隱式特征。全連接層的作用主要是將學習的圖像特征通過線性變換映射到樣本的標簽空間,從而得到最終的結果。

2.2 全卷積神經網絡

CNN的強大之處在于它的多層網絡結構可以自動學習特征,淺層的卷積層可以提取豐富的局部特征,而深層的卷積層將這些局部特征進行結合,可以學習到更加抽象的特征[14]。但是,CNN在學習的過程中可能會丟失一些物體輪廓和空間位置信息,無法對復雜圖像特征進行精確描述。

針對CNN的缺陷,UC Berkeley的Long[15]提出了一種端到端的網絡結構,即全卷積神經網絡(Fully Convolutional Networks,FCN)。FCN 是在 CNN 上的發展和延伸,兩者最大的區別是FCN 將卷積層替代了全連接層(如圖1 所示),正是這種差異,使得FCN 能夠避免全連接層線性變換導致圖像空間位置信息丟失,進一步豐富特征的學習。同時,由于卷積層權值共享的特性,FCN有效減少了網絡訓練參數的數目,能夠提升模型訓練的速度。

圖1 FCN結構

2.3 互信息配準算法

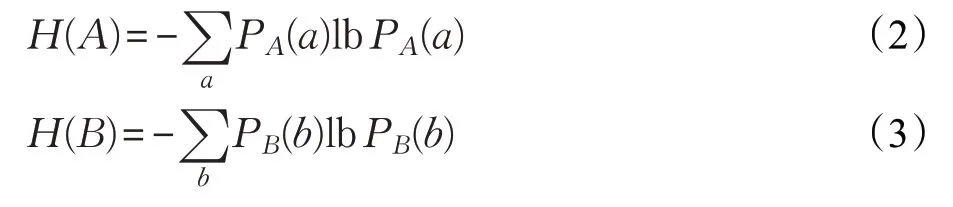

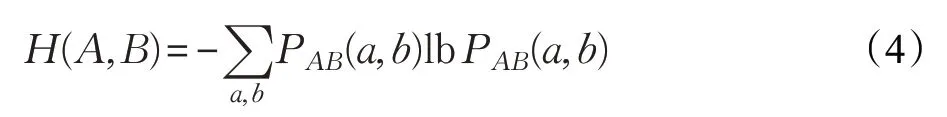

在圖像配準中,互信息一般作為浮動圖像和參考圖像之間的相似性度量,用來測量兩者之間的相關度。互信息越大,表示圖像之間的相關程度越高,配準效果越好。互信息計算公式如式(1)所示:

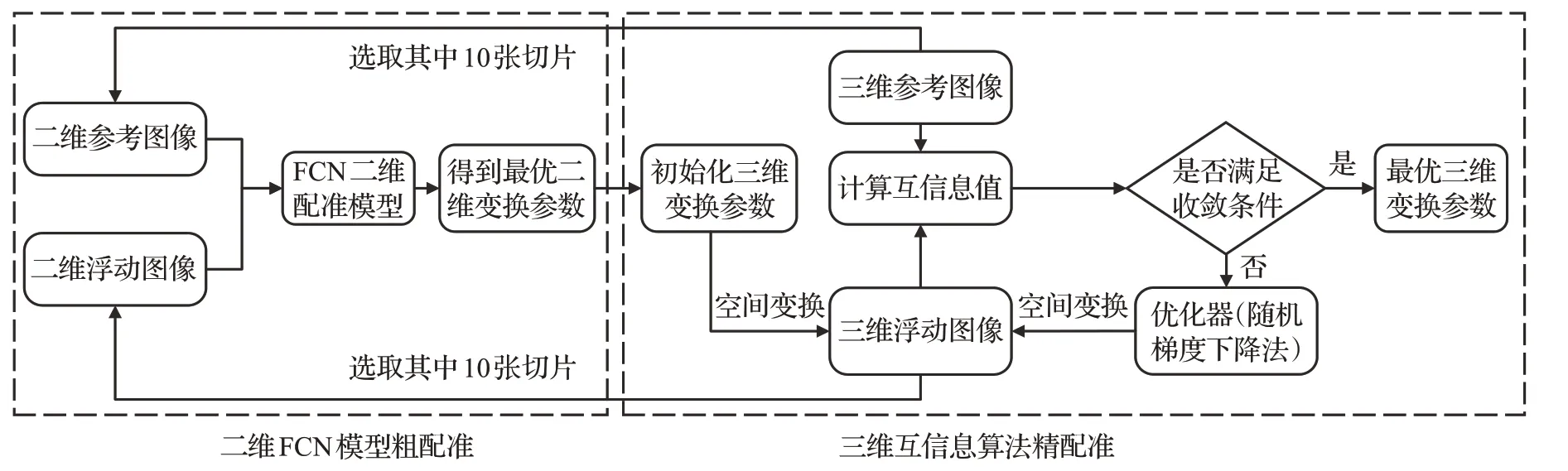

式中,H(A)和H(B)分別表示參考圖像和浮動圖像的信息熵,H(A,B)是兩幅圖像之間的聯合熵,其具體計算公式為:

圖2 基于FCN和互信息的三維圖像配準流程

式中,a∈A,b∈B,PA、PB、PAB(a,b)分別表示參考圖像和浮動圖像各自灰度值的概率分布以及兩者聯合灰度值的概率分布。而基于互信息的配準過程就是以互信息作為圖像配準的相似性度量,通過搜索優化尋找一個最優空間變換,使得參考圖像u(x)和映射后的浮動圖像v(Tθ(x))之間的互信息值I最大:

其中,Tθ是將浮動圖像v(x)配準到參考圖像u(x)上的空間變換,θ為變換參數。

3 基于FCN和互信息的配準方法

3.1 算法流程

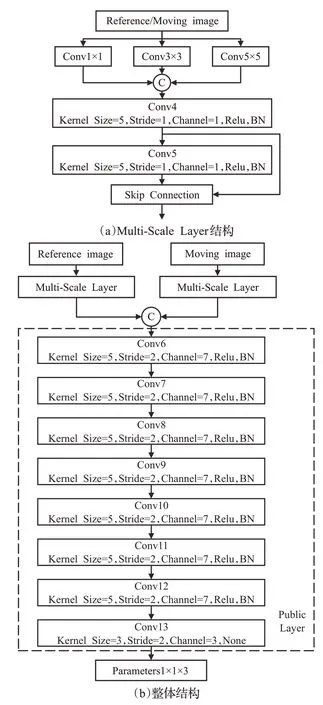

本文采用FCN和互信息的混合優化算法實現三維圖像配準任務。利用FCN獲得的配準結果作為互信息搜索算法的起始點,通過進一步搜索優化,得到更高精度的配準參數,整個配準流程如圖2所示。

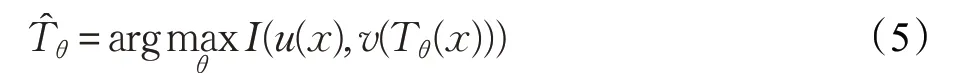

步驟1從預處理后的三維參考圖像和三維浮動圖像選取相同層數的10 對二維切片,輸入到訓練后的FCN模型中進行特征提取并完成配準,選取配準效果最好的那組參數作為最優二維變換參數P2D(tx,ty,θxy)。其中tx、ty分別是浮動圖像沿x和y軸的平移量,θxy為繞xy平面圖像中心點的順時針旋轉角度。本文以軸向面為xy平面,矢狀面為yz平面,冠狀面為xz平面,具體實例如圖3所示。

圖3 三維圖像斷面

步驟2將得到的變換參數P2D(tx,ty,θxy)初始化為三維變換參數P3D(tx,ty,tz,θxy,θyz,θxz),其中tz為浮動圖像沿z軸的平移量,θyz,θxz為繞yz和xz平面中心點的順時針旋轉角度。其中未得到的參數設置為0,并作為互信息搜索算法的初始值P3D(tx,ty,0,θxy,0,0)。

步驟3將三維浮動圖像按照初始值進行空間變換,通過最近鄰插值后,計算與三維參考圖像的互信息值。當滿足收斂條件時,優化結束,得到最終的三維變換參數P3D′(tx′,ty′,tz′,θxy′,θyz′,θxz′)。否則繼續通過隨機梯度下降法對三維變換參數進行優化。

3.2 FCN配準模型的構建

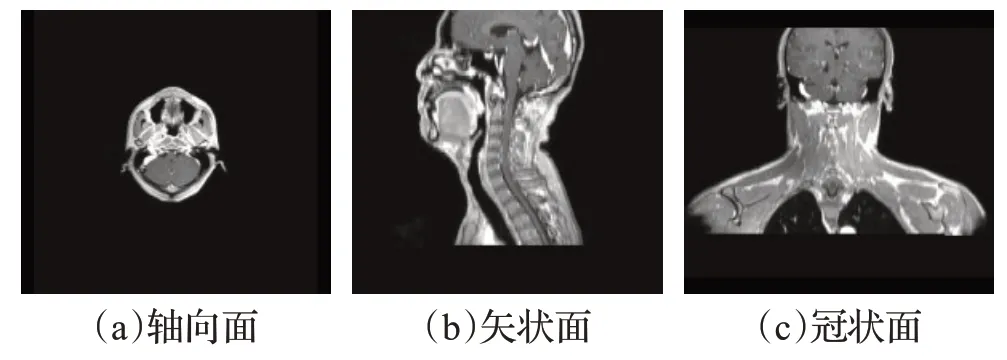

圖4 展現了本文所構建的FCN 二維圖像配準模型。整個模型由兩部分組成,即參考圖像和浮動圖像各自的多尺度特征提取器Multi-Scale Layer,以及通過Concatenate 級聯合并[16(]圖中為字母C 表示)后的公共特征提取器Public Layer。

在Multi-Scale Layer 中,借鑒Inception網絡多尺度模型結構[17],采用三種不同卷積尺寸的卷積層(1×1、3×3、5×5)來獲取原始圖像多個尺度的信息,通過Concatenate級聯合并得到更豐富的初始淺層圖像特征;再使用兩層卷積對特征進一步提取,并參考ResNet 中跳躍式連接(Skip Connection)[18]對Conv4 得到的特征圖像重復利用,提升模型訓練效率。

通過Concatenate 級聯對浮動圖像和參考圖像各自特征進行合并后,再利用7 個步長為2 的5×5 卷積核獲取共同特征中尺度較大的深層、抽象特征,最后采用3×3卷積核對圖像特征綜合分析,得到二維配準空間變換參數(X方向的平移量、Y方法平移量以及XY平面的旋轉角度)。除了最后一層,每層卷積層后緊跟一個批規范處理(Batch Normalization,BN)以及Relu非線性激活函數[19]用于提升網絡的學習擬合能力。整個模型使用均方誤差作為損失函數,并使用L2 正則化防止模型過擬合。

4 實驗設計與分析

4.1 實驗數據集及預處理

實驗數據來源于中山大學附屬腫瘤醫院的鼻咽癌診斷臨床數據集,共80 份三維頭-頸部計算機斷層圖像(CT)、核磁共振圖像(MR)以及相應的三維配準參數標簽。其中MR 數據的尺寸為720×720×100,像素間距為0.69 mm×0.69 mm×3 mm;CT 數據的尺寸為512×512×100,像素間距為0.97 mm×0.97 mm×3 mm。本文將CT作為參考圖像,MR作為浮動圖像,通過三維配準將MR圖像映射到CT 圖像上。在實驗過程中,首先隨機選取75組三維數據,每組數據提取第20張至第80張特征明顯的二維軸向面切片用于FCN模型的訓練,剩下的5組數據用于測試。

圖4 FCN二維配準模型結構

為了提高配準精度,提升模型的魯棒性。本文在FCN模型訓練前對圖像進行了以下預處理操作:

(1)下采樣。醫學圖像尺寸較大,模型訓練時間較長,為了盡可能不損失圖像信息的同時又能減少模型訓練時間,分別對CT 和MR 圖像的每一份軸向面切片進行二倍下采樣操作。采樣后的MR和CT圖像大小分別為360×360×100、256×256×100。

(2)高斯去噪。通過高斯去噪來消除圖像中的噪聲像素,保證圖像中的有效信息不受影響。

(3)數值歸一化。為了消除奇異像素點所導致的不良影響以及加速模型收斂,分別將CT、MR 圖像的像素值進行歸一化操作,公式如下:

其中,xnorm為歸一化后的像素值,x為原始像素值,xmin和xmax分別為原始圖像中的像素最小值和像素最大值。

(4)重采樣。為了使CT、MR 圖像具有相同的像素間距以及像素尺寸,便于配準操作,需要對MR 圖像進行重采樣操作。重采樣操作是對MR 圖像的灰度信息按照CT 圖像的像素間距以及尺寸大小重新采樣插值,構成新圖像。經過重采樣操作后,MR圖像的尺寸以及像素間距與CT圖像相同。

(5)數據增強。本文對MR圖像的軸向面切片進行隨機的旋轉、平移變換操作,從而產生新的二維切片,擴充數據樣本,提升模型的泛化能力。其中Y方向的平移變換范圍為[-40,40]像素點,X方向的平移變換范圍為[-40,40]像素點,旋轉的角度變換范圍為[-15,15]。經過8 次數據增強操作后,訓練樣本由原來的4 500 份增加到36 000份。

4.2 參數設置及評價指標

本文的實驗硬件環境為CentOS 7.4,64 位操作系統,92 GB內存,CPU為E5-2640 2.00 GH。在進行FCN模型訓練時,使用glorot正態分布方法對網絡權重進行初始化,使用Adam 算法[20]對FCN 進行參數優化,學習率為1.0,每批次輸入切片張數(batch size)為64,訓練次數為10 000,L2 正則化系數為0.1。在進行互信息配準時,搜索迭代次數最大值為800,變換參數振幅為0.01,允許誤差為0.001。

為了定量評估算法性能,本文選用了相似性系數(Dice similarity Coefficient,DSC)、互信息(Mutual Information,MI)、相關系數(Correlation Coefficient,CC)以及配準時間作為CT、MRI 多模態配準結果的評價指標。其中相似性系數用于度量實際配準結果與理論配準結果的重合度:

A和B分別表示通過本文方法配準后的浮動圖像以及通過標簽參數配準后的浮動圖像。

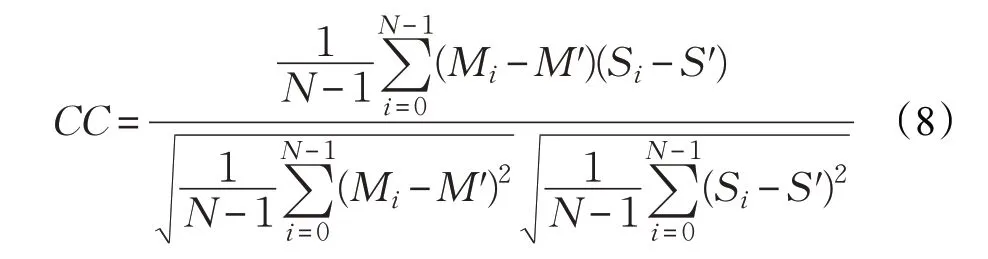

相關系數數學計算公式如下所示:

其中,N代表圖像中像素點的個數,Mi表示浮動圖像的灰度值,Si表示參考圖像的灰度值,M′、S′分別表示浮動圖像和參考圖像的平均灰度值。DSC、MI 以及CC指標都是值越高代表配準效果越好。

為了更加客觀地反映本文算法的有效性,選擇以下五種算法作為對比算法,與本文方法進行比較:

(1)文獻[2]中基于互信息的配準算法。

(2)文獻[6]中基于Powell優化的配準算法。

(3)文獻[21]中基于脈沖耦合神經網絡(PCNN)和互信息結合的配準算法,該方法使用PCNN進行粗配準再結合互信息算法精配準從而得到最終結果。

(4)文獻[22]中基于頭腦風暴(MBSO)和Powell 結合的配準算法,該方法采用MBSO 算法粗配準再結合Powell算法精配準來完成配準任務。

(5)文獻[23]中基于AIR-net模型的配準方法,AIR-net使用生成對抗網絡來構建配準模型。

4.3 二維圖像配準

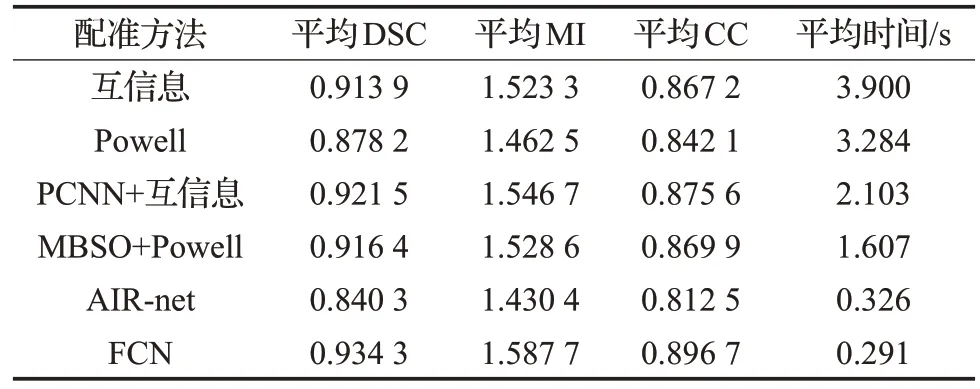

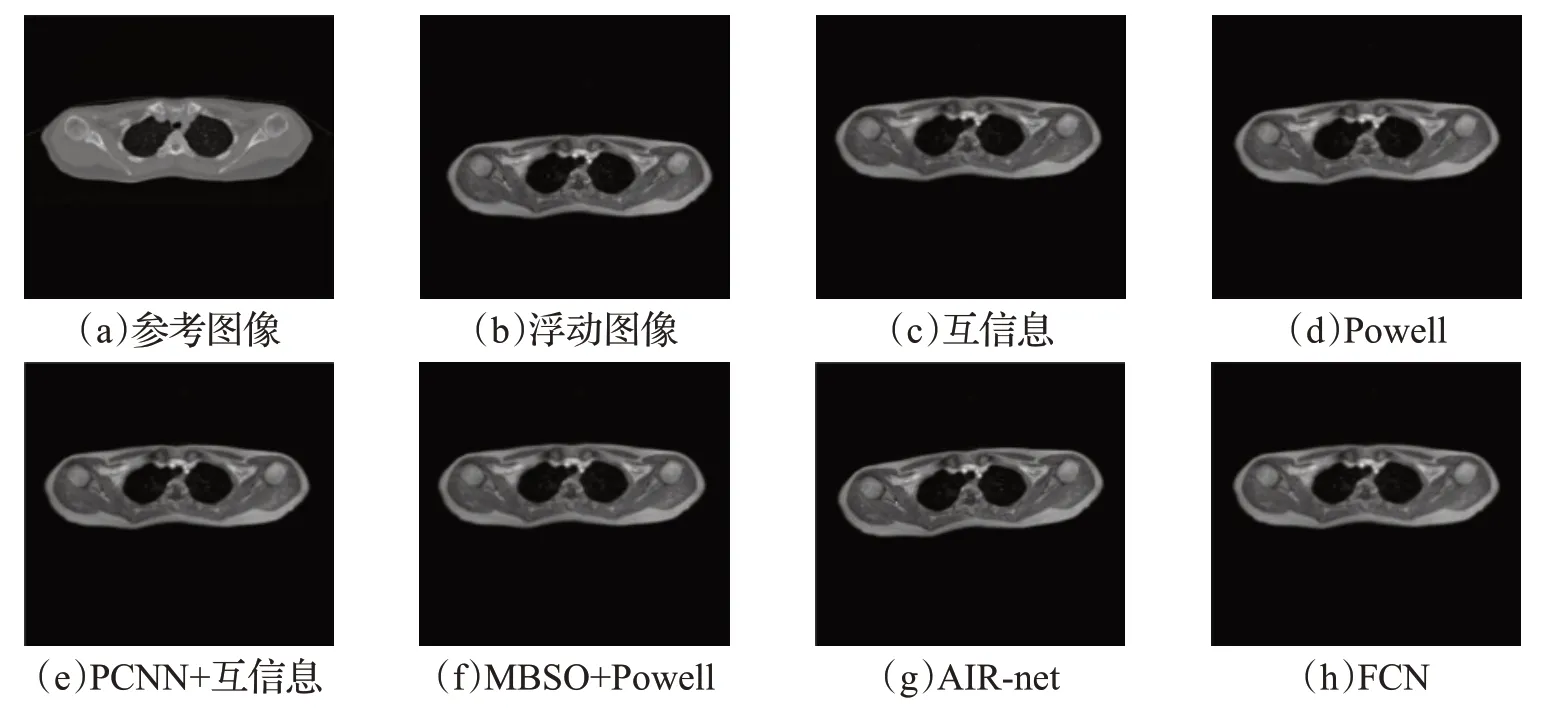

首先驗證FCN 模型在二維圖像上的配準效果,在FCN 模型訓練結束后,隨機抽取50 例二維測試樣本進行測試,并與文獻[2]、[6]以及文獻[21]、[22]、[23]中的配準方法進行比較。其中一例的配準結果如圖5 所示,圖5(a)為CT參考圖像,圖5(b)為MR浮動圖像,圖5(c)~(h)分別為互信息算法、Powell 算法、PCNN+互信息算法、MBSO+Powell 算法、AIR-net 模型以及本文 FCN 模型的配準結果。

表1 列出了50 次實驗中FCN 模型與對比算法在DSC、MI、CC 以及配準時間指標上的平均值。結果顯示,FCN模型在配準精度各項指標的表現都要優于其他算法,取得了更精確的配準效果。在配準速度上,FCN模型有量級的提升,平均配準時間相比于互信息算法、Powell 算法、PCNN+互信息算法以及 MBSO+Powell 算法分別縮短了92.53%、91.13%、86.16%、81.89%。這是因為以上四種對比算法都是通過多次迭代優化來尋找最優配準參數,所以配準時間較長,而FCN通過大量樣本訓練已經具備極強的特征提取和表征能力,從而能夠快速、準確地從圖像特征分布中得到配準參數,因此配準速度有大幅度的提升;雖然AIR-net配準速度也很快,但是該網絡是基于生成對抗網絡構建的,存在訓練不穩定的問題,無法較好地學習圖像特征,因此配準性能差于本文構建的FCN 配準模型。在多次實驗的前提下,充分證明了FCN 模型具有很強的魯棒性,可以為三維互信息算法提供可靠的初始點。

表1 二維圖像配準結果對比

4.4 三維圖像配準

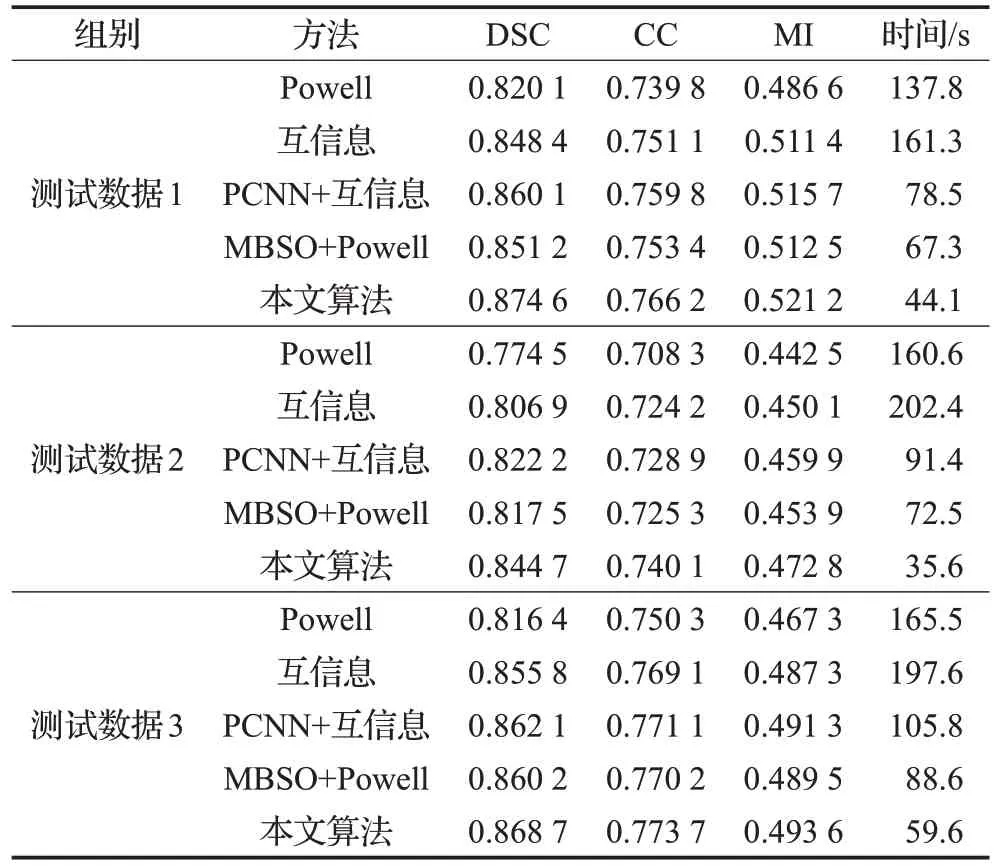

在FCN 配準的基礎上,繼續驗證本文提出的基于FCN和互信息的方法在三維圖像上的配準性能,并與文獻[2]、[6]、[21]、[22]的配準方法進行對比。實驗選取3份待配準的三維CT、MR 圖像進行測試,首先從三維CT、MR 數據中隨機抽取10 份相對應的二維切片輸入到FCN 模型進行配準,并選取DSC 值最高的那組二維配準參數作為互信息搜索算法的初始值,再通過互信息算法進一步搜索優化得到最終三維配準結果。圖6 為其中一份數據的配準結果,圖6(a)和圖6(b)分別為三維CT 參考圖像、MR 浮動圖像的軸向面、矢狀面、冠狀面,圖6(c)為配準前CT和MR圖像的融合結果,圖6(d)為通過本文方法配準后的融合結果。表2 為本文算法與對比算法在多項性能指標的評估度量值。

從圖6 可以看出,通過本文方法配準后,浮動圖像和參考圖像的空間位置和解剖位置基本一致,能夠得到理想的配準結果。從表2多組實驗中可以看出,本文方法在相似度量值DSC,互信息值MI,相關系數值CC 均取得最大值,同時在配準速度上有非常顯著的提升,平均配準時間相比于Powell算法、互信息算法、PCNN+互信息算法以及MBSO+Powell 算法分別縮短了69.93%、74.96%、49.51%、39.36%。這是因為傳統互信息法以及Powell 法在進行三維圖像配準時受到了局部極值的干擾,沒有獲得更優的全局解;而本文方法經過FCN二維精確配準后的結果已經較為接近最優解,再使用互信息算法進行搜索優化時,既能縮小全局最優解的搜索范圍,提升配準速度;又能避免局部極值的干擾,獲得更高的配準精度。

圖5 二維圖像配準融合結果

圖6 三維圖像配準融合結果

表2 三維圖像配準結果對比

與PCNN以及MBSO相比,FCN能夠得到更接近最優解的初始值,因此再結合搜索算法進行精配準時,本文算法比PCNN+互信息算法以及MBSO+Powell 算法具有更快的配準速度和更高的準確性。

從二維、三維配準結果得出,本文構建的FCN模型具有極強的圖像特征提取能力,可以快速、精確地實現二維配準,并能為三維配準的互信息搜索算法提供可靠初始參數,再使用互信息算法進一步搜索優化時,能夠避免局部極值的干擾并大幅度提提升配準速度。本文方法在二維、三維圖像上的配準結果均優于其他算法的配準結果,能夠高效、準確地完成多模態圖像配準任務。

5 結束語

針對現有醫學圖像配準算法收斂速度慢以及易陷入局部極值的問題,本文提出了一種基于FCN 和互信息的配準方法,通過FCN提取圖像特征進行二維配準,再結合互信息算法進一步搜索優化實現三維配準。實驗表明,在二維和三維多模態圖像配準中,本文構建的FCN配準模型以及FCN和互信息算法都能取得不錯的配準結果,具有較強的魯棒性。與傳統配準算法相比,本文提出的算法在配準速度和配準精度方面均有不同程度的提高,對臨床應用中的醫學圖像配準具有一定的使用價值和借鑒性。但由于互信息法需要計算高維聯合分布,所以在一定程度上降低了配準效率,如何進一步挖掘深度學習的價值,在訓練樣本不足的情況下訓練出魯棒性較強的三維配準模型將會是下一步研究的重點。