基于復雜度聚類的自適應遙感場景分類

梁文韜,康 雁,李 浩,李晉源,寧浩宇

(云南大學 軟件學院,昆明 650500)

0 概述

隨著遙感圖像獲取技術的不斷發展,人們可從遙感圖像中獲取更多有用信息。遙感場景分類是根據遙感圖像中所提取的特征對遙感場景進行分類和識別。由于提升場景分類準確率可提高目標檢測效果,更好地完成土地資源問題的覆蓋率與利用率分析以及土地規劃建設等任務[1],因此遙感場景分類作為遙感圖像應用過程不可或缺的一環非常重要。遙感場景圖像除了具有顏色、紋理、空間與光譜信息等特征以及包括多特征融合的描述子在內的淺層次信息[2-4],還含有較多深層次信息,增加了提升其分類準確率的難度。

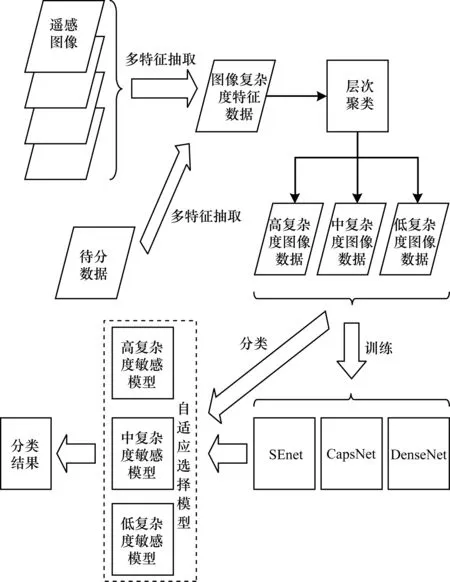

本文提出一種基于復雜度適配的自適應遙感場景分類模型。充分利用遙感圖像各層特征,構建具有多重特征的遙感圖像復雜度評價矩陣,對圖像復雜度進行層次聚類劃分,并根據DenseNet、CapsNet和SENet神經網絡對復雜度特征敏感度的不同,分別將其與不同復雜度圖像子集匹配,最終得到遙感圖像場景分類結果。

1 相關工作

1.1 基于模式識別的遙感場景分類

在遙感場景分類任務中,最小距離法、平行六面體法、最大似然法、等混合距離法、循環集群法等監督與非監督的傳統識別分類方法應用較多,但是這些方法魯棒性較弱且泛化能力不強,難以廣泛應用,且分類準確率也很難提高。

1.2 基于神經網絡的遙感場景分類

近年來,隨著深度學習技術在計算機視覺領域的不斷發展,其在遙感場景分類任務上取得眾多成果,特別是卷積神經網絡(Convolutional Neural Networks,CNN)模型在遙感場景分類任務中取得比傳統方法更好的分類效果。在模型結構方面,文獻[2]使用AlexNet、VGGNet-16和GoogLeNet網絡獲得遠高于傳統低層特征提取方法的分類效果。文獻[5]利用PMS架構的DCNN模型獲得比CNN模型更佳的分類效果。文獻[6]建立卷積神經網絡模型,降低圖像變形引起的誤差,從而獲得優于傳統方法的分類效果。在模型特征利用率方面,文獻[7]利用深度學習模型-堆棧自動編碼機提高對圖像的特征利用。文獻[8]使用局部二值模式(Local Binary Pattern,LBP)提高對圖像的特征利用。文獻[9]使用視覺注意機制提高紋理特征利用率。與傳統分類方法相比,使用CNN進行遙感分類不僅可大幅提升準確性,還能獲得更強的泛化性能。但目前相關研究主要采用卷積和池化操作獲取圖像全局特征,對遙感圖像的特征利用率不高。

2 自適應網絡場景分類模型

對于遙感場景分類任務而言,由于遙感場景圖像信息量通常與場景種類和特征分布緊密關聯,例如,沙漠、草地的圖像信息量遠少于商業區、港口的圖像信息量。在場景特征分布方面,信息量較少的圖像類別由淺層特征決定,信息量較大的圖像類別由深層特征決定。因此,本文提出一種1×15維的特征屬性描述矩陣劃分不同特征分布的遙感圖像,并對圖像的復雜度進行描述。對遙感圖像劃分類別進行分析發現,圖像按照復雜度分為3類時各類別的平均相似性最大,因此根據復雜度聚類獲得低、中、高復雜度的3類圖像。文獻[10]指出不同結構的CNN與不同特征分布的遙感圖像敏感度有差異,使用對應的CNN結構處理敏感度較高的遙感圖像可充分發揮CNN固有特性,從而提高分類精度。僅加深和加寬網絡模型雖然可提高圖像分類任務的正確率[11-12],但會給算法效率、硬件條件帶來更大壓力,造成神經網絡梯度不穩定與網絡退化等問題,導致算法性能下降[13]。因此,針對不同特征分布的圖像改進模型結構可獲得更高的分類準確率和算法效率,并能適應更多的硬件條件[14-15]。各類神經網絡中DenseNet、CapsNet和SENet結構分別對低、中、高復雜度圖像敏感度最高。

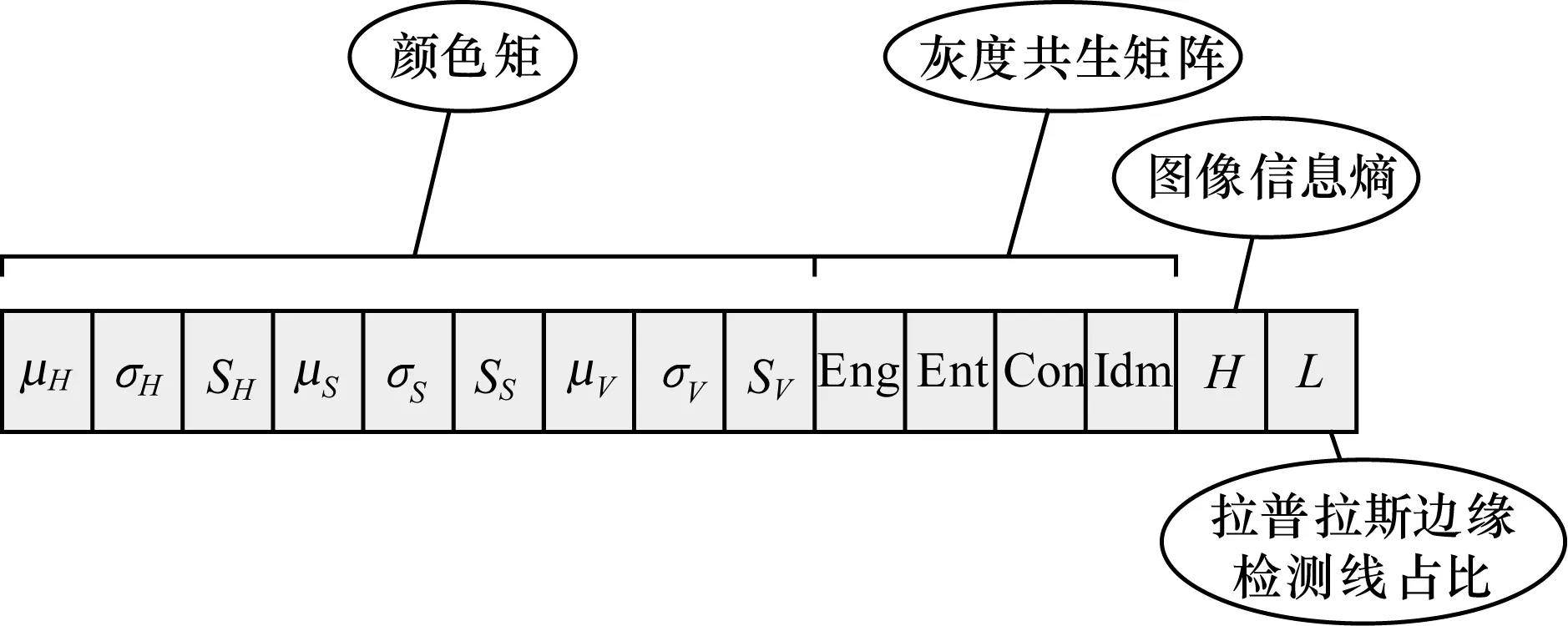

本文針對上述情況提出與遙感圖像特征復雜度分布相匹配的多維自適應模型。在對遙感場景圖像進行分類處理時,先計算輸入圖像的復雜度描述矩陣(由顏色矩、灰度共生矩陣、信息熵、信息增益以及線占比等多重特征組成的1×15維矩陣),再根據上述特征采用層次聚類方式獲得3種復雜度子集,最后分別使用DenseNet、CapsNet、SENet訓練與其相適應的圖像,以獲得復雜度與神經網絡自適應的模型。

2.1 圖像復雜度矩陣

評價圖像復雜度的方法較多,包括基于圖像紋理、模糊數學理論、多特征集成的圖像復雜度評價方法,以及基于信息論衡量的圖像復雜度評價方法等[16-18]。由于遙感圖像的顏色特征、輪廓、紋理特征較突出,因此本文基于前人研究工作[19-21]提出一種1×15維的特征描述矩陣,其中包括顏色特征、紋理特征、空間特征、信息熵特征、拉普拉斯邊緣檢測線占比等特征。雖然同類別地表類型圖像在不同分辨率與成像方式下具有不同的深層次特征,但從中獲得復雜度評價矩陣特征分布的方法類似,因此不同類別遙感場景在復雜度評價矩陣中的區別較明顯。

1)顏色矩

顏色矩[21]是一種顏色特征評價方式,用矩表示圖像顏色分布情況,其計算參數較少。為獲得更佳的復雜度評價效果,通常采用一階矩、二階矩、三階矩表示圖像的顏色特征。顏色矩的計算公式如下:

(1)

(2)

(3)

其中,pi,j表示彩色圖像第j個像素的第i個顏色分量,ui表示所有像素第i個顏色分量的平均值,N表示像素個數。圖像的三階顏色矩組成1個9維向量表示顏色特征,表達式為:

Fcolor=[μH,σH,sH,μs,σs,ss,μv,σv,sv]

(4)

2)灰度共生矩陣

灰度共生矩陣[22]是當圖像中灰度級值為m的像素以及與其距離為δ(Δx,Δy)且灰度級值為n的像素都出現時,2個像素灰度級同時發生的概率將空間坐標映射為灰度對所構成灰度共生矩陣。灰度共生矩陣用p(m,n,d,θ)(m,n=0,1,…,L-1)表示,其中m和n分別為2個像素點的灰度級值,L為圖像的灰度級,d和θ分別為2個像素點的距離關系和方位關系。從灰度共生矩陣中可獲得包含圖像紋理信息的子特征,因此本文從灰度共生矩陣中提取能量、熵、對比度以及倒數差分矩作為圖像復雜度的評價子。

定義1(能量) 能量是灰度共生矩陣各元素值的平方和,用于度量圖像紋理灰度變化穩定程度,反映圖像灰度均勻程度和紋理粗細度特征,其計算公式為:

(5)

定義2(熵) 熵是圖像包含信息量的隨機性度量,即圖像中紋理的信息量,反映圖像的紋理特征,其計算公式為:

(6)

定義3(對比度) 對比度用于度量灰度共生矩陣值的分布和圖像局部變化程度,反映圖像中紋理清晰程度特征,其計算公式為:

(7)

定義4(倒數差分矩) 倒數差分矩反映圖像紋理的同質性,即圖像紋理局部變化程度,其計算公式為:

(8)

上述灰度共生矩陣的4個特征描述子構成4維向量特征,表達式為:

FGray=[Eng,Ent,Con,Idm]

(9)

3)圖像信息熵

圖像信息熵用于統計特征數量,可表示圖像灰度分布的聚集特征,其計算公式為:

(10)

其中,a表示像素的灰度值且0≤a≤255,b表示鄰域灰度均值且0≤b≤255,pa,b表示灰度值為a、鄰域灰度均值為b的像素所占比例。

4)拉普拉斯邊緣檢測線占比

圖像通過拉普拉斯邊緣檢測可獲得圖像輪廓線條灰度圖,計算輪廓線數值與整體像素比值所得圖像線占比L用來表示圖像輪廓特征,即L=Lap/Img,Lap表示經拉普拉斯邊緣檢測后的像素矩陣,Img表示原像素矩陣。

將上述特征分量組合后得到圖像復雜度評價矩陣,即描述圖像復雜度所需的15維向量矩陣Ffeature=FGray+Fcolor+E+L,其結構如圖1所示。

圖1 圖像復雜度評價矩陣的結構Fig.1 Structure of image complexity evaluation matrix

2.2 針對圖像復雜度的層次聚類劃分

層次聚類是一種無監督聚類,通過迭代計算各類別數據點相似度可構建1棵有層次的嵌套聚類樹。本文采用自下而上的合并方法創建聚類樹,層次聚類的合并過程為:計算2類數據點的相似性,再組合所有數據點中相似度最高的2個數據點,然后反復迭代該過程。層次聚類使用歐式距離計算不同類別數據點的距離相似度(D),計算公式為:

(11)

采用圖像復雜度評價矩陣Ffeature計算各圖像之間的相似性得到不同復雜度[23],從而獲得不同復雜度的圖像子集并映射到原始圖像上,將原始圖像按此規律進行劃分,從而獲得不同復雜度的圖像子集(NWPU-RESISC45、UC Mered、WHU-RS)。本文使用Calinski-Harabaz分數評價類簇數不同時的聚類效果。Calinski-Harabaz分數是分離度與緊密度的比值,該值越大說明類自身越緊密、類與類之間越分散,即聚類結果更優,反之說明聚類效果不佳。Calinski-Harabaz分數的計算公式如下:

(12)

其中,m為圖像數據總量,k為簇數,Bk為簇間協方差矩陣,Wk為簇內協方差矩陣,tr為矩陣的跡(矩陣主對角線上元素總和)。

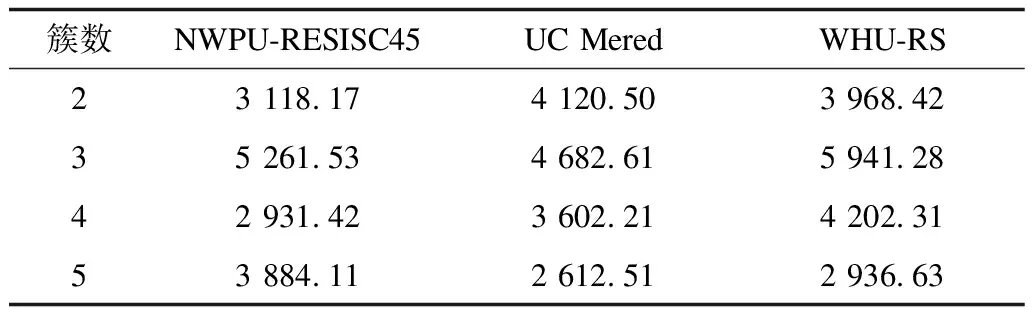

對3類遙感圖像子集復雜度矩陣進行簇數為2~5的聚類分析,得到Calinski-Harabaz分數如表1所示,可以看出當簇數為3時各類遙感圖像子集所得Calinski-Harabaz分數最高,因此在中等類別數量規模的遙感場景圖像中聚類劃分簇數為3較合適。

表1 3類遙感圖像子集所得Calinski-Harabaz分數Table 1 Calinski-Harabaz scores from three remotesensing image subsets

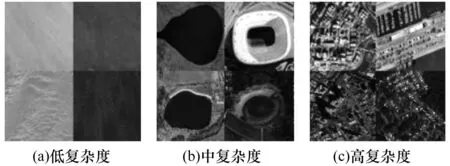

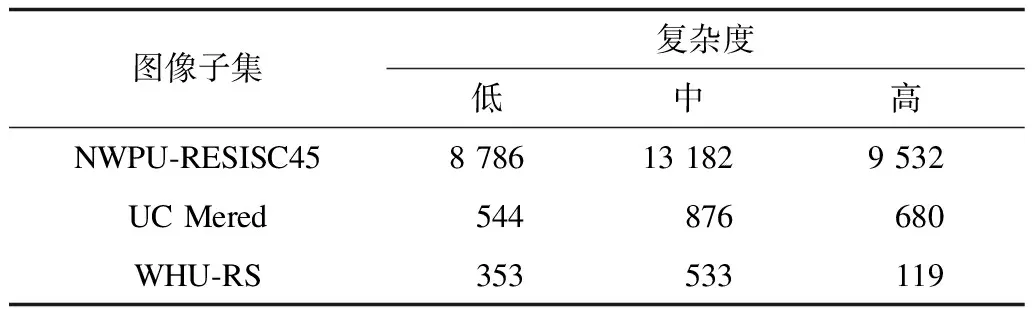

圖2為3類圖像子集圖例。可以看出:第1類圖像子集為草地、沙漠等,信息量較少;第2類圖像子集為湖泊、運動場等,信息量適中;第3類圖像子集為商業區、港口等,信息量較大。因此,上述3類圖像子集分別標定為低復雜度、中復雜度和高復雜度,各圖像子集在不同復雜度下的數據量如表2所示。

圖2 3類圖像子集圖例Fig.2 Legend of three image subsets

表2 3類圖像子集在不同復雜度下的數據量Table 2 Data quantity with different complexity ofthree image subsets

2.3 自適應復雜度子集的神經網絡

本文引入DenseNet、CapsNet、SENet 3種網絡作為自適應復雜度子集的神經網絡模型集成對象。

2.3.1 DenseNet

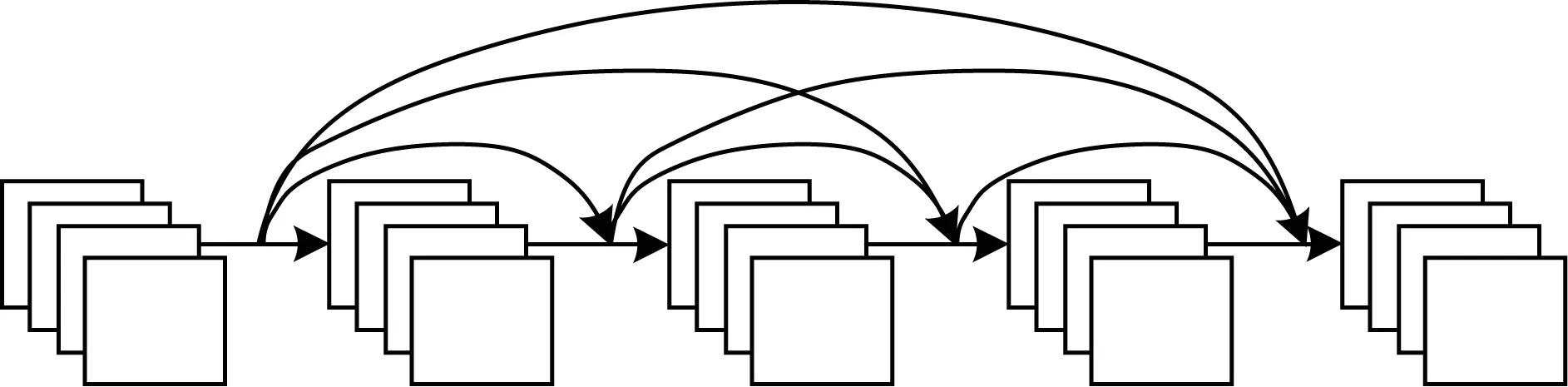

DenseNet[24]將卷積和池化層的輸出特征作為卷積層的特征輸入,其結構如圖3所示。

圖3 DenseNet結構Fig.3 DenseNet structure

在本文遙感場景分類任務的DenseNet中,每L層有L(L+1)/2個連接,即L層的輸出為xl,表示為:

xl=F(xx-1)+xl-1+xl-2+Lx1

(13)

DenseNet能很好地保留與利用模型中卷積層所得的圖像低維特征[25],而沙漠、草地等低復雜度圖像的內容和高維特征較少。DenseNet既可充分利用低維特征也能避免高維特征干擾,因此其對于復雜度較低圖像的敏感度較其他復雜度的圖像更強,通常用DenseNet訓練低復雜度遙感場景圖像。

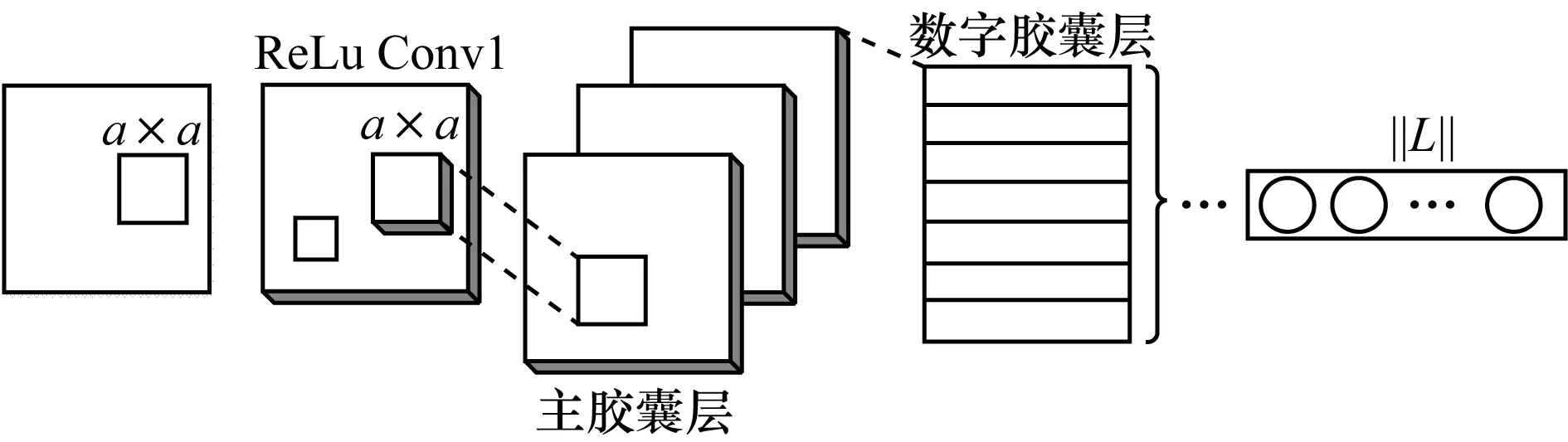

2.3.2 CapsNet

與傳統卷積神經網絡相比,膠囊網絡(Capsule Network,CapsNet)[26]用向量信息取代標量信息,即在傳統神經網絡的輸入線性求和階段增加耦合系數cij,其輸入Sj的計算公式為:

(14)

其中,μi為上一層CapsNet的輸出,Wij為每個輸出的權值,上一層每個膠囊神經元以不同強弱的連接輸出到下一層某個神經元。耦合系數cij的計算公式為:

(15)

其中,b初始值為0,由更新bij←bij+Wijμivj獲得。在前向傳播求Si的過程中,Wij為隨機值,b初始化為0可得到cij,μi為上一層CapsNet的輸出,通過Cij、Wij、μi的值可得到下一層輸入,CapsNet就能更好地保存圖像的位置與方向信息,CapsNet結構如圖4所示。對于遙感圖像而言,拍攝角度變換、距離不同會造成神經網絡的誤判,而CapsNet能很好地解決上述問題,從而獲得更高的分類準確率[27]。由于中復雜度圖像通常目標較完整,比低復雜度圖像具有更多深層次特征,且不像高復雜度圖像分布復雜與特征繁多,因此對于中復雜度圖像,CapsNet不會遺漏其整體位置、方向等重要特征,也不會受更高維特征的干擾,較其他網絡敏感度更強。而低復雜度圖像具有的特征更少,其位置分布和輪廓特征不明顯,CapsNet分類效果不如DenseNet,因此通常用CapsNet訓練中復雜度遙感場景圖像。

圖4 CapsNet結構Fig.4 CapsNet structure

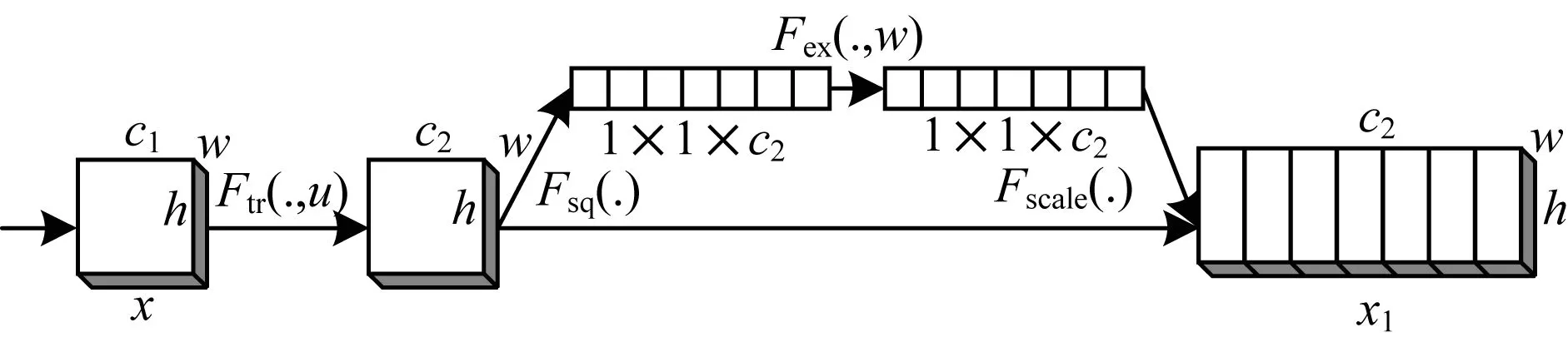

2.3.3 SENet

SENet[28]采用特征重標定策略,先通過Squeeze操作壓縮特征,用1個實數表示各二維特征通道,該實數有一定的全局感受野,輸出的維度和輸入的特征通道數相匹配,Squeeze操作的計算公式如下:

(16)

然后進行Excitation操作,通過學習更新參數w進行特征通道之間相關性建模,再進行Reweight操作,即選擇Excitation輸出表示特征后,每個特征通道的重要性權重與原始特征矩陣進行相乘加權,從而完成在各通道上對原始特征的重標定。SENet能對復雜圖像的多維特征進行排序篩選,以避免冗余特征干擾,達到更好的分類效果[29],其結構如圖5所示。高復雜度圖像通常包含龐大的信息量,在位置關系、輪廓特征、顏色特征等方面更復雜,從中提取的有用特征較其他復雜度圖像更多。如果不考慮上述特征則會降低最終的分類效果,而SENet能全面考慮與有效利用各特征,對高復雜度圖像而言,SENet較其他網絡敏感度更強。因此,通常用SENet訓練高復雜度遙感場景圖像。

圖5 SENet結構Fig.5 SENet structure

2.4 本文自適應算法

對于遙感場景分類任務中的遙感圖像,先使用復雜度評價矩陣抽取遙感圖像的復雜度特征,再使用2.2節中的聚類方式對該復雜度評價矩陣進行聚類,從而獲得3種復雜度的圖像子集,分析其中的圖像并進行高、中、低復雜度標定,然后分別用2.3節中的3種神經網絡進行訓練,最終獲得復雜度聚類模型和與對應復雜度敏感的神經網絡模型。用復雜度聚類模型對測試數據進行復雜度劃分,再將對應的復雜度敏感模型進行分類,從而獲得更精準的分類結果。在對各復雜度敏感的神經網絡模型訓練過程中,為獲得更全面的特征分布,對不同復雜度的圖像數據進行增強[30]處理,使其擴充為原來的5倍,算法的具體流程如圖6所示。

圖6 本文自適應算法流程Fig.6 Procedure of the proposed adaptive algorithm

該算法具體步驟如下:

輸入有標簽的訓練集train,無標簽的測試集test

輸出測試遙感圖像的類別

1)對訓練集train進行多特征抽取,獲得包含顏色矩、灰度共生矩陣、信息熵、信息增益、線占比多重特征的1×15維復雜度描述矩陣。

2)根據復雜度描述矩陣使用層次聚類方法將訓練集train中圖像劃分低、中、高3個復雜度,獲得trainL(低復雜度)、trainM(中復雜度)、trainH(高復雜度)和復雜度聚類模型M0。

3)采用數據增強方法將trainL、trainM、trainH分別擴充為原來的5倍,再使用DenseNet、CapsNet、SENet分別訓練復雜度低、中、高的數據集,獲得與對應復雜度敏感的神經網絡模型M1、M2、M3。

4)測試集test通過復雜度聚類模型M0劃分屬于低、中、高3個復雜度的測試圖像testL、testM、testH,再將其分別通過對其復雜度敏感的模型M1、M2、M3,所得結果即為測試集圖像的類別。

3 實驗與結果分析

本文分別在NWPU-RESISC45數據集、UC Mered數據集、WHU-RS數據集3個數據集上驗證所提模型的有效性。NWPU-RESISC45數據集具有45個遙感場景類別,其中每類有700張尺寸為256像素×256像素的圖像。UC Merced數據集來自美國地質勘探局國家城市地圖,共有21個遙感場景類別,其中每類有100張尺寸為256像素×256像素的圖像。WHU-RS數據集來自武漢大學由Google Earth截取的衛星遙感圖像,共有19個遙感場景類別,其中每類有50張尺寸為600像素×600像素的圖像。為確保實驗的有效性,對訓練模型的數據集進行旋轉、平移、縮放與對比度拉伸變換等數據增強[30]處理,將其擴大5倍。

3.1 實驗設置

本文實驗環境為GTX 1080Ti 12核32 GB機器,采用GPU訓練。訓練階段,使用Shuffle方式訓練,Batch設定為16。為保證訓練效率,圖像尺寸統一縮放為64像素×64像素,網絡輸入是Batch_size為16×64×64×3的4維張量。為使各模型訓練收斂后作為最終模型,各模型的epoch設置為100。在訓練神經網絡過程中,DenseNet和SENet模型使用Binary_crossentropy作為損失函數,CapsNet模型使用Margin_loss作為損失函數,SENet模型使用SGD算法作為優化器,DenseNet和CapsNet模型使用Adam算法作為優化器。以準確率(A)作為最終分類效果的評價指標。

(17)

其中:TP表示實際與預測都為正的樣本數;FN表示實際為正而預測為負的樣本數;TN表示實際與預測都為負的樣本數;FP表示實際為負而預測為正的樣本數。

3.2 實驗結果

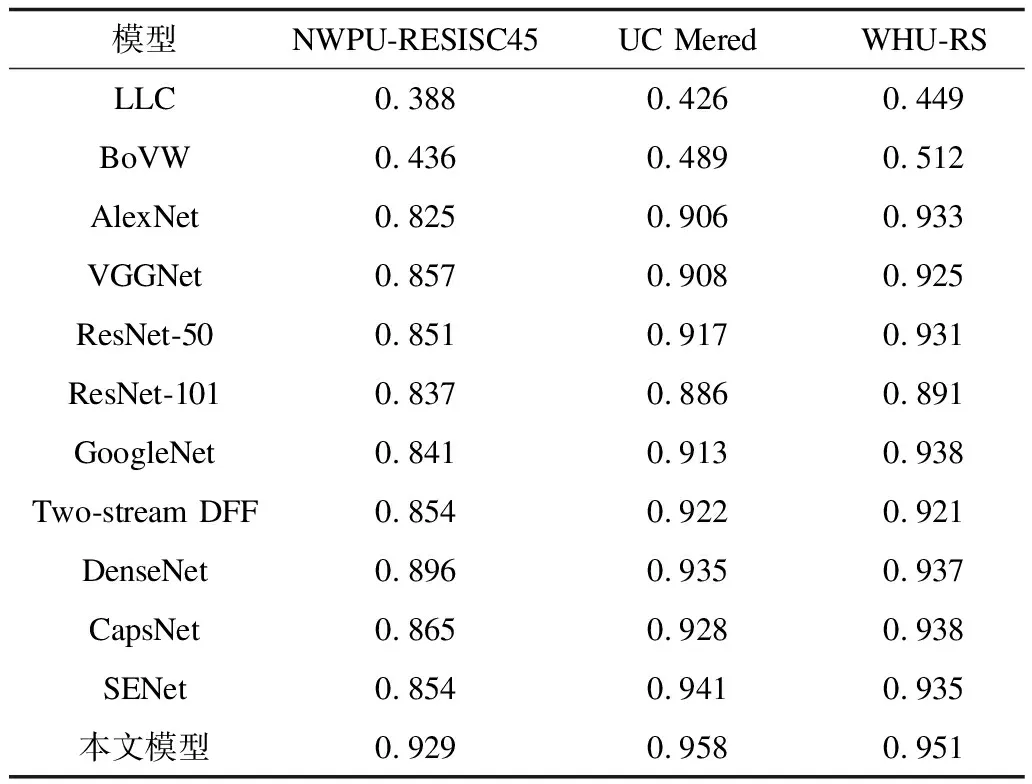

本文實驗與近期遙感場景分類任務進行對比分析,結果如表3所示[2,30-31]。可以看出:在NWPU-RESISC45、UC Mered、WHU-RS數據集上,基于LLC、BoVW的傳統模型準確率較低,約為0.5;AlexNet、VGGNet等神經網絡模型準確率較高,在0.8以上;而本文所選DenseNet、CapsNet、SENet等單一模型的準確率明顯優于其他模型,表明該類模型對遙感場景數據有更好的適應性;本文自適應模型在3個數據集上的準確率較單一模型平均提高3個百分點,分類效果提升明顯。

表3 不同模型在3種數據集上的準確率Table 3 Accuracy of different models onthree datasets

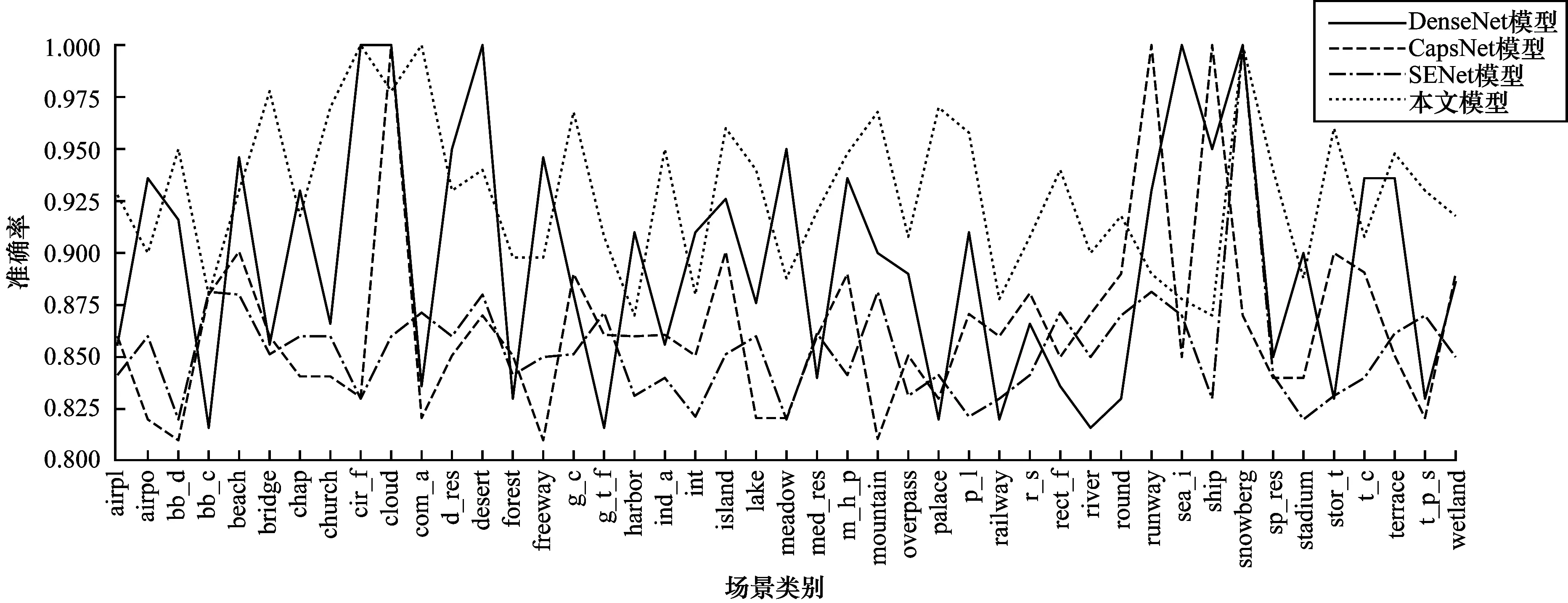

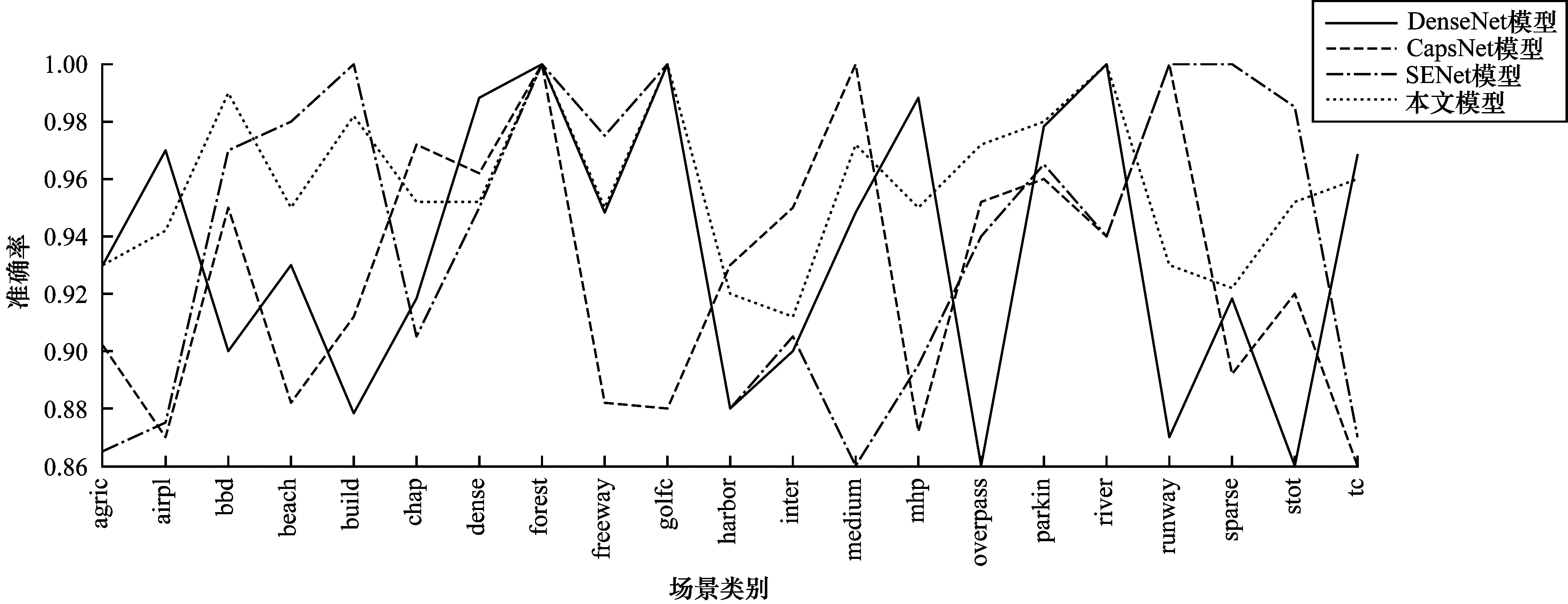

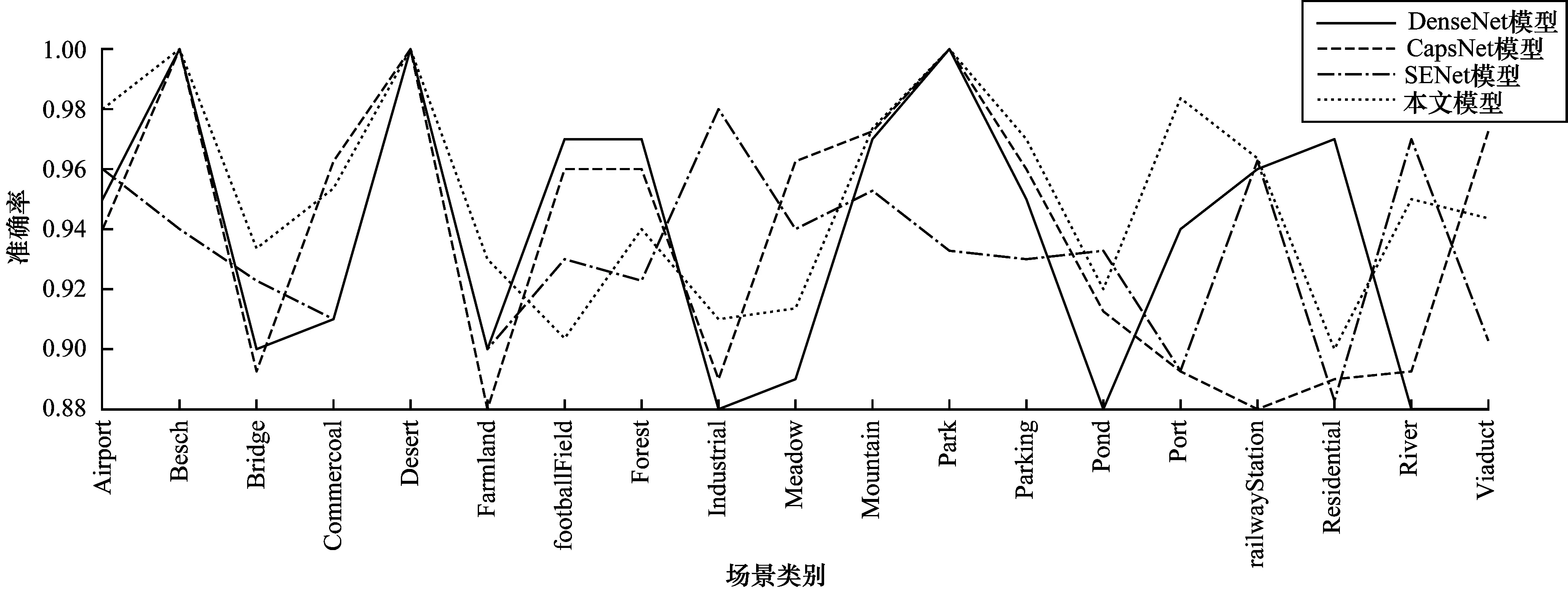

圖7~圖9分別為DenseNet、CapsNet、SENet和本文自適應模型分別在NWPU-RESISC45數據集、UC Mered數據集、WHU-RS數據集上得到的各類別準確率。可以看出:對低復雜度的草地、沙漠等類別,DenseNet準確率較高;對高復雜度的商業區、港口等類別,SENet準確率較高;對中復雜度的運動場、機場等類別,CapsNet準確率較高。本文自適應模型在3個數據集上的整體準確率均高于其他模型。

上述實驗表明,本文提出的自適應模型對遙感場景分類準確率提升效果明顯,既可有針對性提取與利用不同復雜度遙感圖像的特征,又能綜合各神經網絡模型優勢,實現遙感圖像分類的高準確率。

圖7 4種模型在NWPU-RESISC45數據集上各場景類別的準確率Fig.7 Accuracy of each sence category of four models on NWPU-RESISC45 dataset

圖8 4種模型在UC Mered數據集上各場景類別的準確率Fig.8 Accuracy of each sence category of four models on UC Mered dataset

圖9 4種模型在WHU-RS數據集上各場景類別的準確率Fig.9 Accuracy of each sence category of four models on WHU-RS dataset

4 結束語

針對遙感圖像復雜度與神經網絡結構存在適應性關系的情況,本文提出一種自適應神經網絡分類模型。建立遙感圖像復雜度評價矩陣,計算獲得不同復雜度的圖像子集,并對圖像復雜度進行層次聚類分級,得到與遙感圖像復雜度匹配的多維自適應神經網絡模型。實驗結果表明,與DenseNet、CapsNet、SENet等模型相比,該模型具有更高的遙感場景分類準確率。下一步將在評價矩陣中引入肯德爾等級、可決系數等指標,使模型對大規模數據具有更好的普適性。